视觉自回归建模(VAR):通过下一尺度预测实现可扩展的图像生成(NIPS2024best) 原创 精华

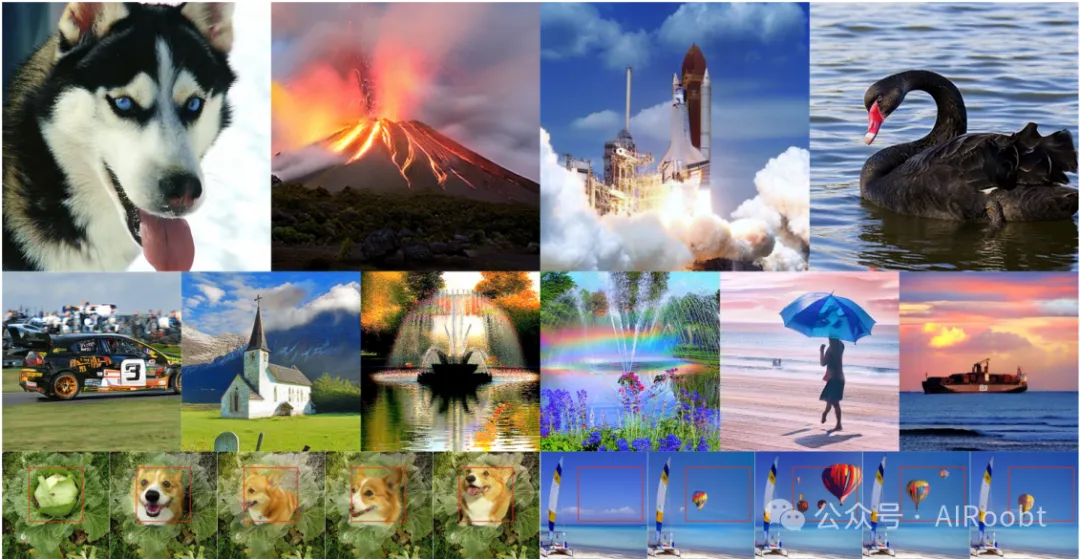

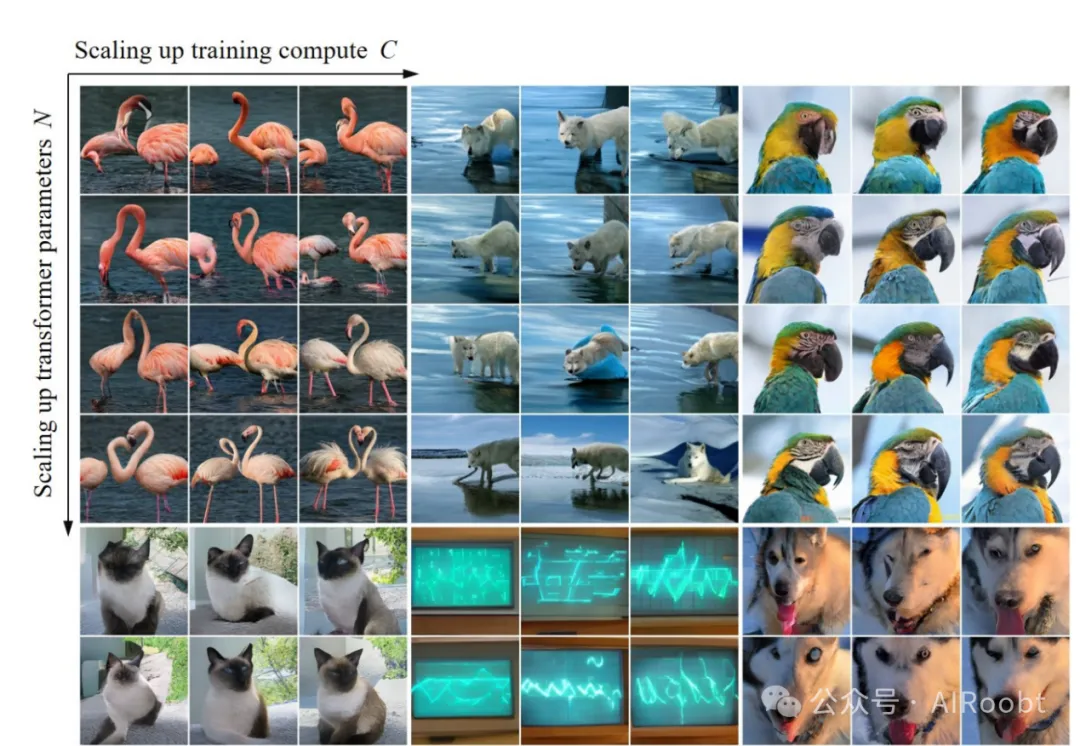

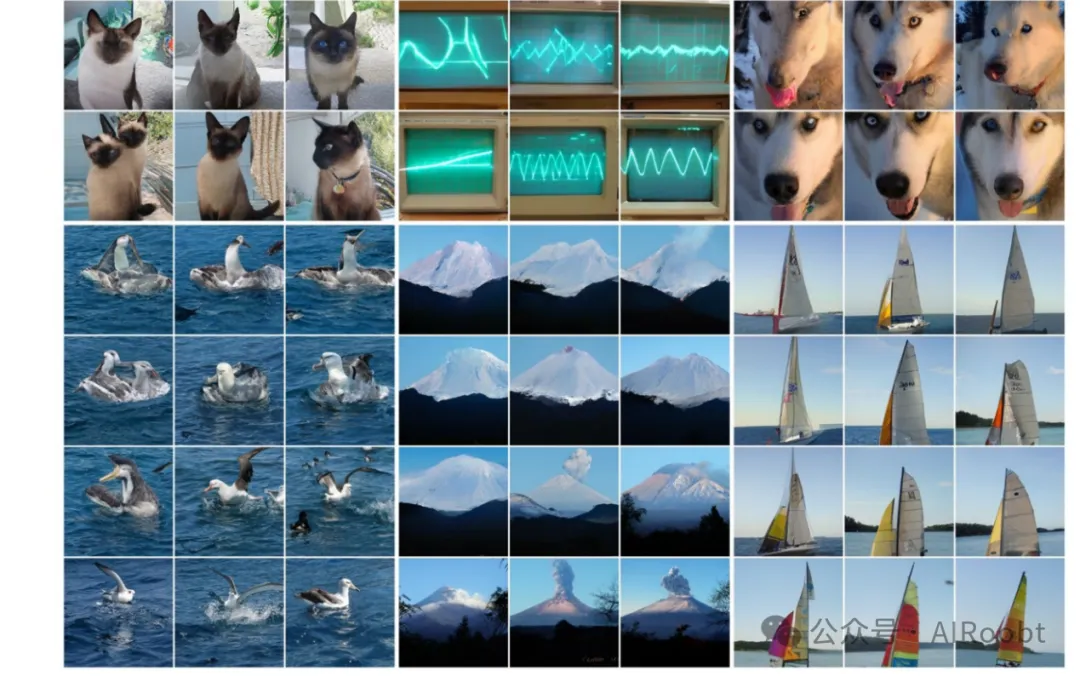

图 1:从在 ImageNet 上训练的视觉自回归 (VAR) Transformer 生成的样本。展示了 512×512 的生成样本(顶部)、256×256 的生成样本(中部)以及零样本图像编辑结果(底部)。

摘要: 我们提出了一种新的生成范式——视觉自回归建模(VAR),将图像上的自回归学习重新定义为从粗到精的“下一尺度预测”或“下一分辨率预测”,区别于传统的光栅扫描式“下一个标记预测”。这种简单直观的方法使自回归(AR)Transformer能够更快地学习视觉分布并表现出良好的泛化能力:VAR首次使得类似GPT的AR模型在图像生成方面超越了扩散Transformer。在ImageNet 256×256基准测试中,VAR显著提升了AR基线,Fréchet嵌入距离(FID)从18.65降至1.73,嵌入分数(IS)从80.4提升到350.2,同时推理速度提升了20倍。实验表明,VAR在图像质量、推理速度、数据效率和可扩展性等多个维度上优于扩散Transformer(DiT)。扩展后的VAR模型表现出类似大型语言模型(LLMs)的清晰幂律扩展规律,相关性系数接近-0.998,提供了有力的实验证据。此外,VAR在图像修补、外延和编辑等下游任务中展示了零样本泛化能力。这些结果表明,VAR初步实现了LLMs的两个关键属性:扩展规律和零样本泛化能力。我们已公开所有模型和代码,以促进AR/VAR模型在视觉生成与统一学习中的探索。

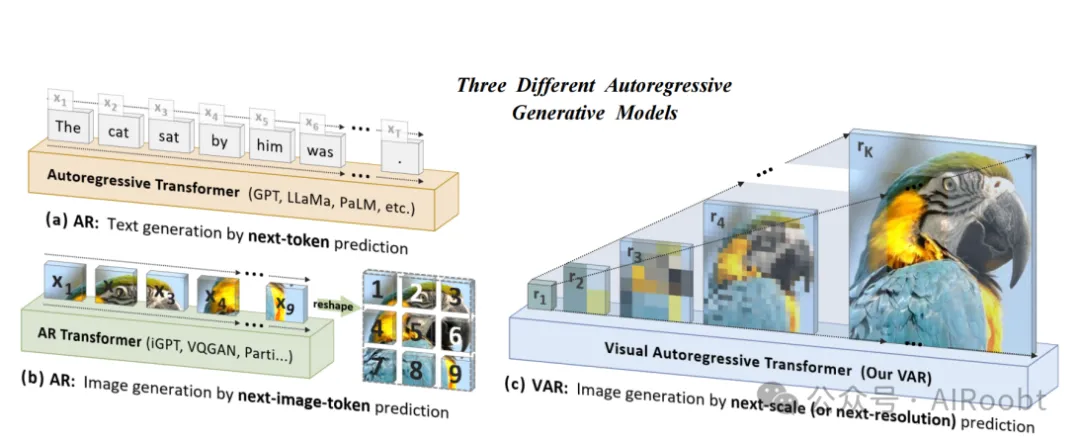

图 2:标准自回归建模(AR)与我们提出的视觉自回归建模(VAR)的对比。

(a) AR 应用于语言:按从左到右逐字生成文本标记;

(b) AR 应用于图像:按光栅扫描顺序(从左到右、从上到下)逐步生成视觉标记;

(c) VAR 应用于图像:通过多尺度标记映射,从粗到精(低分辨率到高分辨率)自回归生成标记,各尺度内并行生成标记。VAR 需要多尺度 VQVAE 支持。

1、引言

GPT 系列模型的出现以及更多自回归 (AR) 大型语言模型 (LLMs) 的发展(如 [65, 66, 15, 62, 1])标志着人工智能领域进入了一个新纪元。这些模型展示了广泛的智能性和多功能性,尽管存在幻觉等问题 [39],仍被认为是迈向通用人工智能 (AGI) 的坚实一步。这些模型的核心是一种自监督学习策略——预测序列中的下一个标记,这是一种简单却深刻的方法。关于这些大型 AR 模型成功的研究强调了它们的两个关键属性:可扩展性和泛化性。前者(如通过扩展规律 [43, 35])使我们能够通过小型模型预测大型模型的性能,从而指导更好的资源分配;而后者(如通过零样本和小样本学习 [66, 15])展示了通过无监督训练模型适应多样化、未见任务的能力。这些属性表明,AR 模型具有从海量未标注数据中学习的潜力,体现了 AGI 的本质。

与此同时,计算机视觉领域也在努力开发大型自回归模型或世界模型 [58, 57, 6],试图模仿其令人印象深刻的可扩展性和泛化性。先锋性的工作如 VQGAN 和 DALL-E [30, 67] 及其后续研究 [68, 92, 50, 99] 展示了 AR 模型在图像生成中的潜力。这些模型使用视觉标记器将连续图像离散化为二维标记网格,然后将其展平为一维序列以进行 AR 学习(如图 2b 所示),模仿顺序语言建模的过程(如图 2a 所示)。然而,这些模型的扩展规律仍未被充分探索,更令人沮丧的是,它们的性能明显落后于扩散模型 [63, 3, 51],如图 3 所示。与 LLM 的显著成就相比,自回归模型在计算机视觉中的潜力似乎仍未被完全释放。

定义数据的生成顺序是自回归建模的必要环节。我们的研究重新思考了如何为图像定义“顺序”:人类通常以一种分层的方式感知或创建图像,先捕捉整体结构,然后是局部细节。这种多尺度、从粗到精的特性为图像提供了一种自然的“顺序”。此外,受广泛多尺度设计的启发 [54, 52, 81, 44],我们将图像的自回归学习定义为图 2c 所示的“下一尺度预测”,从而摆脱传统的“下一个标记预测”(如图 2b 所示)。我们的方法首先将图像编码为多尺度标记映射。然后,从 1×1 标记图开始自回归过程,并逐步扩展分辨率:在每一步中,Transformer 在所有之前生成的基础上预测下一个更高分辨率的标记图。我们将这种方法称为视觉自回归 (VAR) 建模。

VAR 直接利用类似 GPT-2 的 Transformer 架构 [66] 来进行视觉自回归学习。在 ImageNet 256×256 基准测试中,VAR 显著提升了自回归 (AR) 基线的性能,Fréchet 嵌入距离 (FID) 达到 1.73,嵌入分数 (IS) 达到 350.2,同时推理速度提升了 20 倍(详细信息见第 7 节)。值得注意的是,VAR 在 FID/IS、数据效率、推理速度和可扩展性方面超越了扩散 Transformer (DiT)——这是如 Stable Diffusion 3.0 和 SORA [29, 14] 等领先扩散系统的基础。VAR 模型还展示了类似于大型语言模型 (LLMs) 的扩展规律。此外,我们展示了 VAR 在图像修补、扩展和编辑等任务中的零样本泛化能力。

总结而言,我们对社区的贡献包括:

1. 提出了一种基于多尺度自回归范式和下一尺度预测的新型视觉生成框架,为计算机视觉中的自回归算法设计提供了新的见解。

2. 对 VAR 模型的扩展规律和零样本泛化潜力进行了实证验证,这初步再现了大型语言模型 (LLMs) 的吸引力特性。

3. 在视觉自回归模型性能上实现了突破,使基于 GPT 风格的自回归方法首次在图像合成方面超越强大的扩散模型。

4. 提供了一个全面的开源代码套件,包括 VQ 标记器和自回归模型训练管道,以推动视觉自回归学习的发展。

2、相关工作

2.1 大型自回归语言模型的属性

扩展规律

在自回归语言模型中发现并研究了扩展规律 [43, 35],这些规律描述了模型规模(或数据集、计算量等)与测试集上的交叉熵损失值之间的幂律关系。扩展规律使我们能够直接从较小模型预测较大模型的性能 [1],从而优化资源分配。更令人欣慰的是,扩展规律表明,随着模型规模、数据量和计算量的增长,LLMs 的性能可以很好地扩展并且不会饱和,这被认为是其成功的关键因素 [15, 82, 83, 98, 90, 38]。扩展规律的成功也激励了视觉领域去探索更多类似的方法,用于多模态理解和生成 [53, 2, 88, 27, 96, 77, 21, 23, 41, 31, 32, 80, 87]。

零样本泛化

零样本泛化 [72] 指的是一种模型(特别是大型语言模型)的能力,即无需专门训练即可完成未见任务。在计算机视觉领域,基础模型的零样本和上下文学习能力引起了广泛关注,例如 CLIP [64]、SAM [48] 和 Dinov2 [61]。类似 Painter [89] 和 LVM [6] 的创新工作将视觉提示器 [40, 11] 扩展到了上下文学习领域,以实现视觉领域的上下文学习。

2.2 视觉生成

光栅扫描自回归模型

用于视觉生成的光栅扫描自回归模型需要将二维图像编码为一维标记序列。早期研究 [20, 84] 显示了能够以标准逐行、光栅扫描方式生成 RGB(或分组)像素的能力。[69] 在 [84] 的基础上,通过多次使用独立的可训练网络实现超分辨率生成。VQGAN [30] 在 [20, 84] 的基础上进一步发展,通过在 VQVAE 的潜在空间中进行自回归学习实现了更高效的生成。它采用了类似 GPT-2 的解码器 Transformer,在光栅扫描顺序中生成标记,类似于 ViT [28] 将二维图像序列化为一维块。VQVAE-2 [68] 和 RQ-Transformer [50] 也遵循这种光栅扫描方式,但使用了额外的尺度或堆叠的代码。基于 ViT-VQGAN 架构的 Parti [93] 将 Transformer 扩展到 200 亿参数,并在文本到图像生成中表现出色。

掩码预测模型

MaskGIT [17] 采用了一个 VQ 自动编码器和一个类似于 BERT [25, 10, 34] 的掩码预测 Transformer,通过贪心算法生成 VQ 标记。MagViT [94] 将此方法应用于视频,MagViT-2 [95] 则通过改进的 VQVAE 对图像和视频进行了进一步优化。MUSE [16] 将 MaskGIT 的规模扩展到 30 亿参数。

扩散模型

扩散模型的研究集中于改进学习或采样方法 [76, 75, 55, 56, 7]、指导 [37, 60]、潜在空间学习 [70] 和架构设计 [36, 63, 71, 91]。DiT 和 U-ViT [63, 8] 用 Transformer 替代或集成了 U-Net,并启发了近期的图像 [19, 18] 或视频生成系统 [12, 33],包括 Stable Diffusion 3.0 [29]、SORA [14] 和 Vidu [9]。

备注

另一个相关工作 [95] 名为“语言模型胜过扩散模型”,属于基于 BERT 风格掩码预测的模型。

3、方法

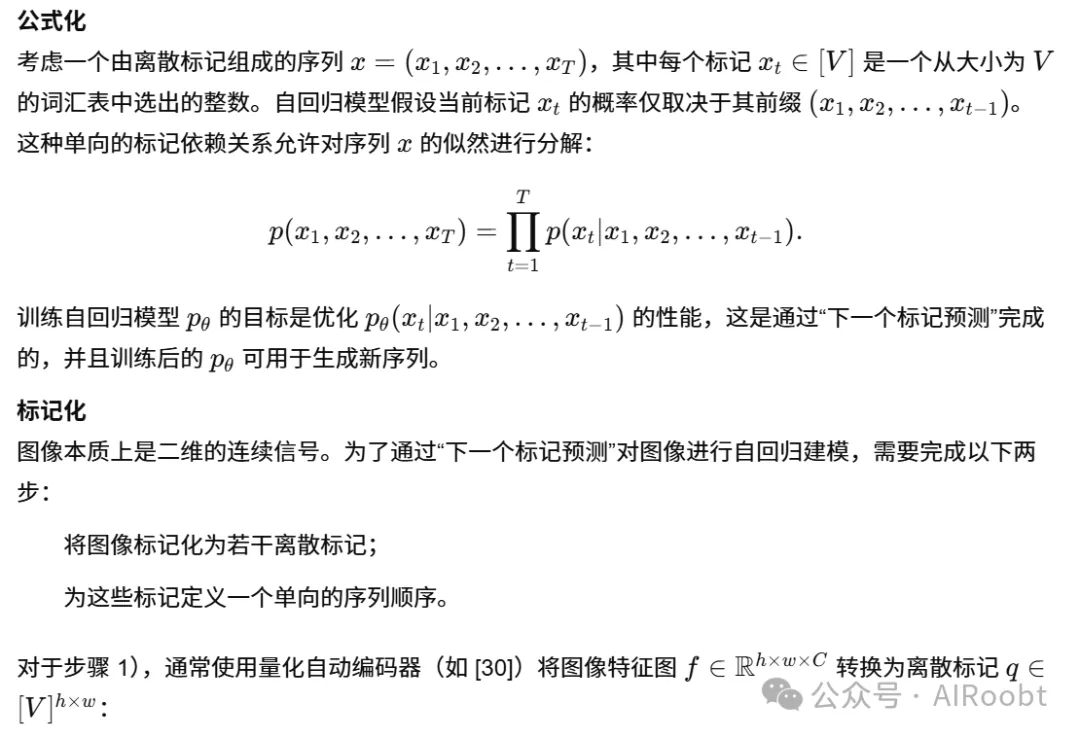

3.1 自回归建模的基础:通过“下一个标记预测”进行建模

3.2 通过“下一尺度预测”实现视觉自回归建模

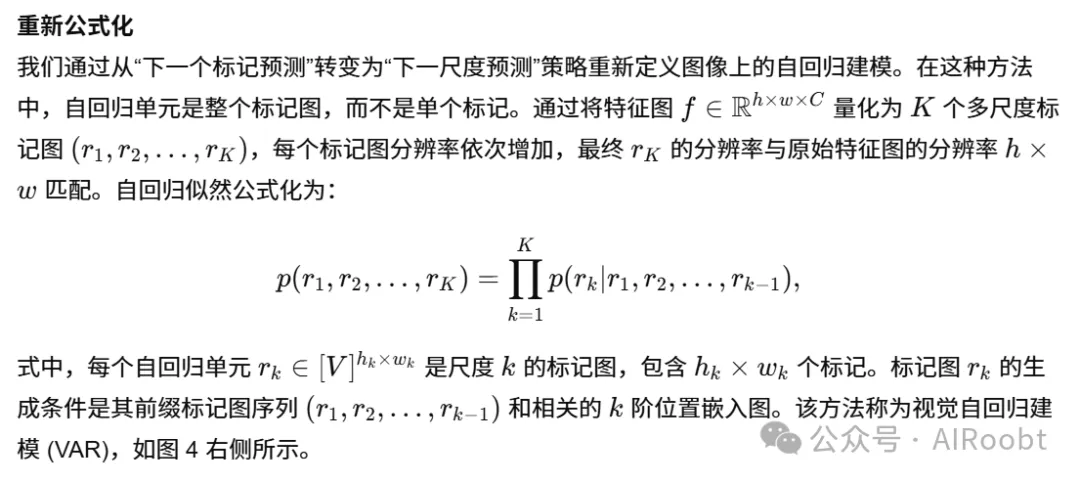

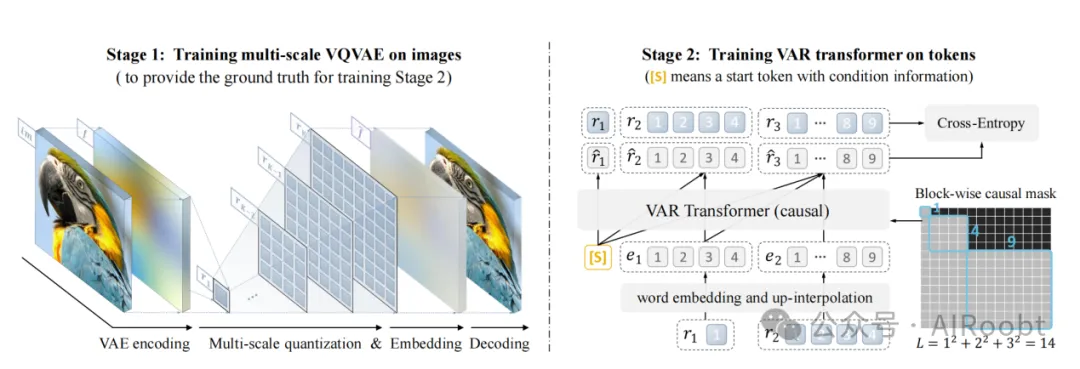

图 4:VAR 包括两个独立的训练阶段。

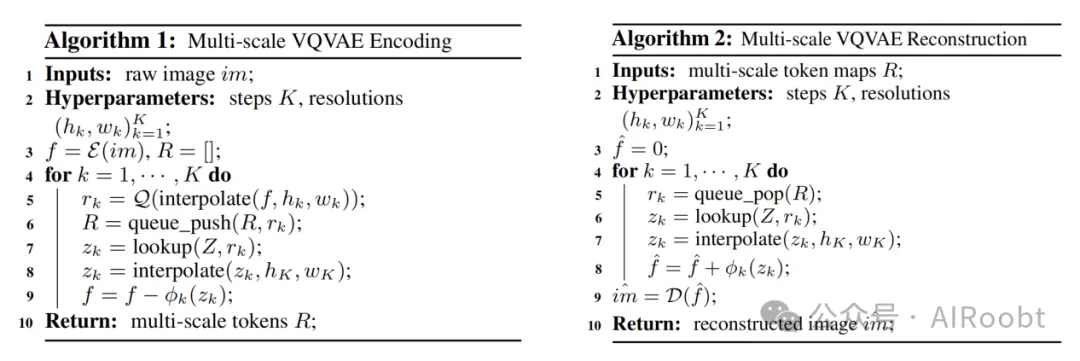

阶段 1:一个多尺度 VQ 自动编码器将图像编码为 K 个标记图 R=(r1,r2,…,rK),并通过复合损失函数 (5) 进行训练。关于“多尺度量化”和“嵌入”的详细信息,请参考算法 1 和算法 2。

阶段 2:通过“下一尺度预测” (6) 训练 VAR Transformer:它将 ([s],r1,r2,…,rK−1)作为输入,以预测 (r1,r2,r3,…,rK)。在训练中使用注意力掩码,以确保每个 rk 只能访问其前缀 r≤k。训练中使用标准的交叉熵损失函数。

讨论

VAR 解决了之前提到的三大问题:

(1)如果我们约束每个 rk 仅依赖其前缀 r≤k,即生成 rk 的过程完全基于 r≤k,那么数学前提便得以满足。这种约束是合理的,因为它符合自然的从粗到精的渐进特性,例如人类的视觉感知和艺术创作(如第 1 节所讨论)。有关更多细节,请参阅下面的“标记化”部分。

(2)空间局部性得以保留,因为 (i) VAR 中没有展平操作;(ii) 每个 rk 中的标记是完全相关的。此外,多尺度设计进一步强化了空间结构。

(3)对于一个分辨率为 n×n的潜在图像,生成过程的复杂性显著降低至 O(n4)(证明见附录)。这种效率提升源于每个 rk 内标记的并行生成。

标记化

我们开发了一种新的多尺度量化自动编码器,将图像编码为 K 个多尺度离散标记图 R=(r1,r2,…,rK),以支持 VAR 的学习(如公式 (6) 所示)。我们采用与 VQGAN [30] 相同的架构,但对多尺度量化层进行了修改。编码和解码过程使用了残差设计,针对特征图 f 或f^ 的操作详见算法 1 和算法 2。实验表明,这种类似于 [50] 的残差式设计在性能上优于独立插值方法。算法 1 证明了每个 rk仅依赖其前缀 (r1,r2,…,rk−1)。

需要注意的是,在所有尺度上使用了共享代码本 Z,确保每个 rk 的标记来自相同的词汇表 [V]。为了解决将 zk 放大到分辨率 hK×wK 时的信息丢失问题,我们使用了 K个额外的卷积层  。在将 f 下采样到分辨率 hk×wk 后,未使用额外的卷积操作。

。在将 f 下采样到分辨率 hk×wk 后,未使用额外的卷积操作。

4、实现细节

VAR 标记器

如前所述,我们使用了标准的 VQVAE 架构【30】,并结合了一种多尺度量化方案,增加了 K 个额外的卷积层(增加了约 0.03M 参数)。我们在所有尺度上共享一个代码本,代码表大小为 V=4096。按照基线方法【30】,我们的标记器也在 OpenImages 数据集【49】上,通过复合损失函数 (5) 进行训练,并采用了 16 倍的空间下采样率。

VAR Transformer

我们的主要研究集中在 VAR 算法,因此模型架构设计保持简单。我们采用了类似于 GPT-2 和 VQGAN【66, 30】的标准仅解码 Transformer 架构,结合自适应归一化 (AdaLN)。这种架构已被广泛用于许多视觉生成模型中,且证明了其有效性【46, 47, 45, 74, 73, 42, 63, 19】。

对于基于类别条件的图像生成,我们使用类别嵌入作为起始标记 [s],并作为 AdaLN 的条件输入。我们发现,在注意力计算前将查询和键归一化为单位向量,可以稳定训练过程。

我们没有使用大规模语言模型中的一些高级技术,例如旋转位置嵌入 (RoPE)、SwiGLU 多层感知机 (MLP)、或 RMS Norm【82, 83】。

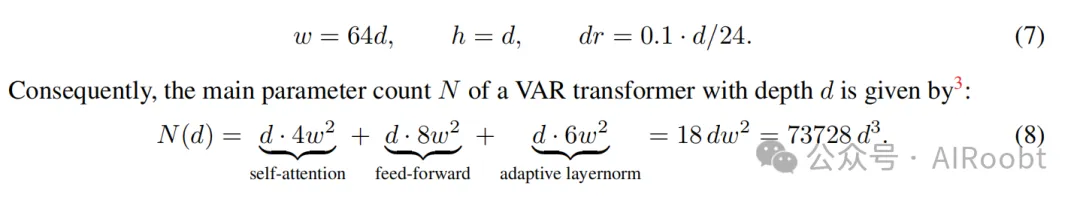

我们的模型形状遵循一个简单规则【43】:宽度 w、头数 h、和丢弃率 dr 随深度 d 线性扩展:

w=64d,h=d,dr=0.1⋅d/24

参数计算

一个深度为 d 的 VAR Transformer 的主要参数总数 N 由以下公式给出:

训练设置

所有模型在相似的设置下进行训练:

·基础学习率:10−4(每 256 的批量大小)。

·优化器:AdamW,超参数 β1=0.9,β2=0.95,权重衰减 0.05。

·批量大小:从 768 到 1024。

·训练轮数:200 至 350(取决于模型规模)。

在第 5 节的评估表明,这种简单的模型设计具有良好的可扩展性和泛化能力。

广告

请在微信客户端打开

抓大鹅

小游戏 益智

玩游戏

5、实验结果

本节首先在 5.1 中将 VAR 与其他图像生成模型类别进行比较。关于 VAR 模型的扩展性和泛化能力的评估展示在 5.2 和附录 6 中。有关实现细节和消融研究,请参阅附录 4 和 7。

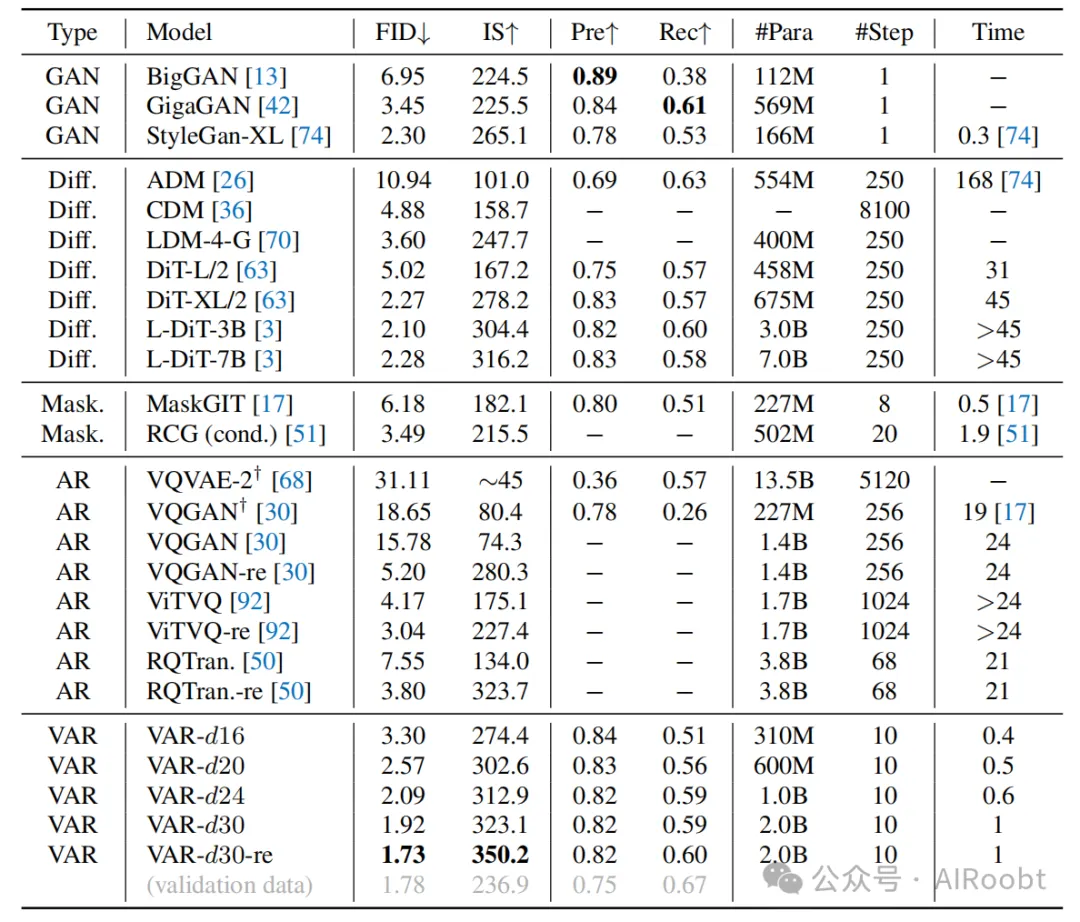

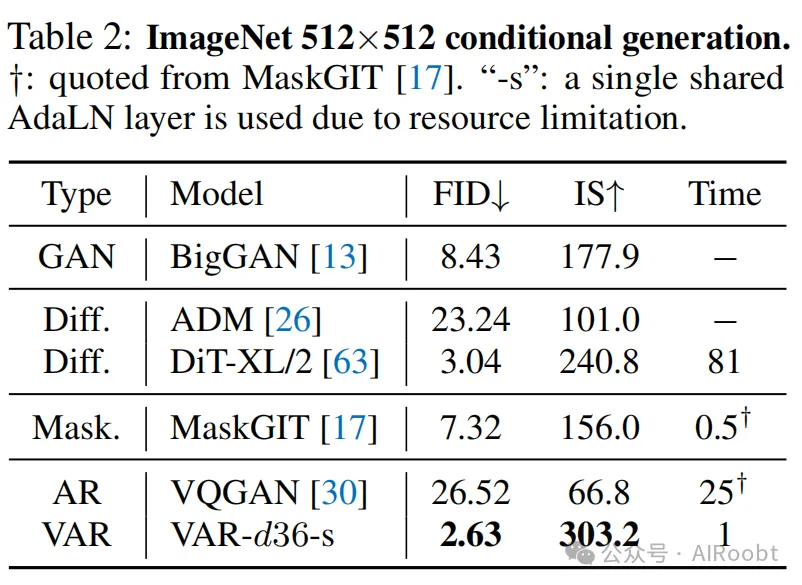

5.1 最先进的图像生成

设置我们在 ImageNet 数据集的 256×256 和 512×512 条件生成基准上测试了深度分别为 16、20、24 和 30 的 VAR 模型,并将其与现有最先进的图像生成模型进行比较。在所有基于 VQVAE 的 AR 或 VAR 模型中,VQGAN【30】和我们的模型使用相同的 VQVAE 架构(CNN)和训练数据(OpenImages【49】),而 ViT-VQGAN【92】使用的是 ViT 自动编码器,并且与 RQTransformer【50】一样直接在 ImageNet 上训练了 VQVAE。结果总结见表 1 和表 2。

整体比较与现有的生成方法(包括生成对抗网络 GAN、扩散模型 Diffusion、基于 BERT 的掩码预测模型 Masking,以及基于 GPT 的自回归模型 AR)相比,我们的视觉自回归(VAR)模型确立了一种新的模型类别。如表 1 所示,VAR 不仅在 FID 和 IS 指标上表现最佳,而且在图像生成速度上也具有显著优势。此外,VAR 在精度和召回率上也保持了较高的一致性,证实了其语义一致性。这些优势在 512×512 合成基准上同样成立(详见表 2)。值得注意的是,VAR 显著提高了传统 AR 的能力。据我们所知,这是自回归模型首次在图像质量和多样性上超越扩散 Transformer,这一里程碑得益于 VAR 在第 3 节中讨论的对 AR 局限性的解决方案。

表 1:生成模型家族在类别条件的 ImageNet 256×256 上的比较。“↓” 或 “↑” 表示数值越低或越高越好。评估指标包括 Fréchet 嵌入距离 (FID)、嵌入分数 (IS)、精度 (Pre) 和召回率 (rec)。“#Step” 表示生成一张图像所需的模型运行次数。推理时间以相对于 VAR 的实测时间表示。带有后缀 “-re” 的模型使用了拒绝采样。†:数据来源于 MaskGIT【17】。

效率比较

传统自回归 (AR) 模型【30, 68, 92, 50】由于图像标记的数量与图像分辨率呈平方关系,计算成本非常高。完整的自回归生成 n2 个标记需要 O(n2) 次解码迭代和 O(n6) 的总计算量。相比之下,VAR 仅需要 O(log(n)) 次迭代和 O(n4) 的总计算量。表 1 中报告的实测时间也提供了经验性证据,表明即使 VAR 的模型参数更多,其速度仍比 VQGAN 和 ViT-VQGAN 快约 20 倍,达到高效 GAN 模型的速度(仅需 1 步即可生成一张图像)。

与流行的扩散 Transformer 的比较

VAR 模型在多个维度上超越了最近流行的扩散模型 Diffusion Transformer (DiT),后者是最新的 Stable Diffusion 3【29】和 SORA【14】的前身:

(1)图像生成的多样性和质量:在 FID 和 IS 指标上,具有 20 亿参数的 VAR 始终优于 DiT-XL/2【63】、L-DiT-3B 和 L-DiT-7B【3】。同时,VAR 在精度和召回率上保持了可比水平。

(2)推理速度:DiT-XL/2 的推理时间是 VAR 的 45 倍,而 3B 和 7B 模型的推理成本则远高于此。

(3)数据效率:VAR 仅需 350 个训练 epoch,而 DiT-XL/2 需要 1400 个训练 epoch。

(4)可扩展性:如图 3 和表 1 所示,DiT 在参数超过 6.75 亿时仅获得了微小甚至负向的增益。而 VAR 的 FID 和 IS 指标持续提升,与第 5.2 节中的扩展规律研究一致。

这些结果表明,VAR 可能是一种比 DiT 等模型更高效且更具可扩展性的图像生成模型。

5.2 幂律扩展规律

背景先前的研究【43, 35, 38, 1】表明,扩大自回归大语言模型(LLMs)的规模会导致测试损失 L的可预测下降。这种趋势与参数数量 N、训练标记数量 T 和最佳训练计算量 Cmin 呈幂律关系:

L=(β⋅X)α

其中 X 可以是 N、T 或 Cmin。指数 α反映了幂律的平滑程度,LL表示归一化后的可减少损失,标准化为不可减少损失 L∞。通过对数变换,L和 X 的对数之间表现出线性关系:

log(L)=αlog(X)+αlogβ

这些扩展规律不仅验证了 LLM 的扩展性,还可用于预测更大模型的性能,从而通过小模型性能预测优化资源使用。将这些规律扩展到计算机视觉领域具有重要意义。

VAR 模型的扩展设置

我们按照【43, 35, 38, 1】的协议,验证 VAR 模型是否符合类似的扩展规律。在 ImageNet 训练集(包含 1.28M 图像)上训练了 12 种不同规模的模型,参数范围从 18M 到 2B。训练跨度为 200 至 350 轮,每轮最多处理 3050 亿个标记。以下我们重点讨论模型参数 N 和在足够标记数量 T 条件下的最佳训练计算量 Cmin 所遵循的扩展规律。

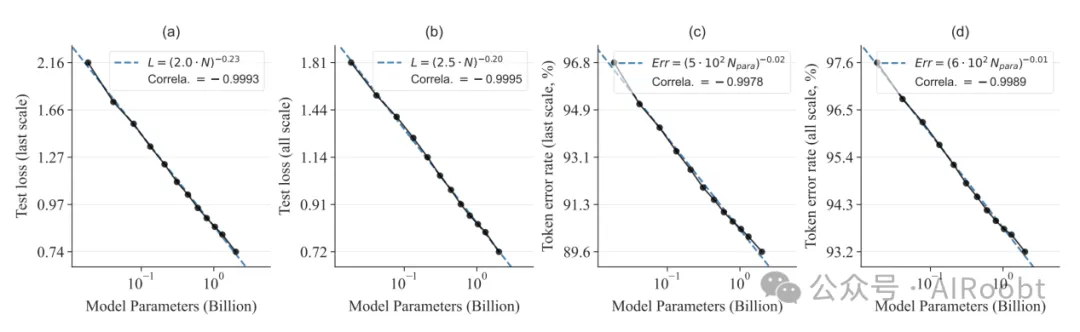

模型参数 N 的扩展规律

我们首先研究了随着 VAR 模型规模增长,测试损失的变化趋势。对于深度为 d 的 VAR Transformer,其参数数量为 N(d)=73728d3,公式见 (8)。我们将深度 d 从 6 调整到 30,生成了 12 个模型,参数规模从 18.5M 到 2.0B 不等。

图 5:VAR Transformer 参数规模 N 的扩展规律,包含幂律拟合曲线(虚线)和对应公式(图例中)。

接近零的幂指数 α 表明,当扩大 VAR Transformer 的规模时,测试损失 L 和标记错误率 Err都呈现平滑下降趋势。坐标轴均为对数刻度。接近 −0.998 的皮尔逊相关系数表明 log(N) 与log(L) 或 log(Err) 之间具有强线性关系。

我们在 ImageNet 验证集(50,000 张图像)【24】上评估了最终的测试交叉熵损失 L 和标记预测错误率 Err。我们计算了最后一尺度(最后一次“下一尺度自回归”步骤)下的 L 和 Err,以及全局平均值。结果如图 5 所示,我们观察到 L 作为 N 的函数呈现出明显的幂律扩展趋势,与文献【43, 35, 38, 1】的结论一致。

幂律扩展规律可表示为:

Llast=(2.0⋅N)−0.23,Lavg=(2.5⋅N)−0.20.(11)

尽管扩展规律主要在测试损失 LL上研究,我们通过实验发现标记错误率 Err 也表现出类似的幂律趋势:

Errlast=(4.9⋅102N)−0.016,Erravg=(6.5⋅102N)−0.010.

这些结果验证了 VAR 的强扩展性,即通过增加 VAR Transformer 的规模,模型的测试性能可以持续改进。

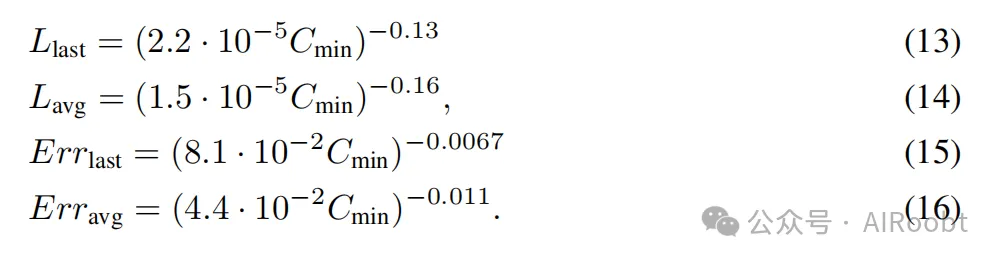

最优训练计算量 Cmin的扩展规律

我们进一步研究了增加训练计算量 C 时 VAR Transformer 的扩展行为。对于每个模型(共 12 个),我们跟踪了训练过程中测试损失 L 和标记错误率 Err 随 C 的变化,计算量以 PFlops(1015 浮点运算每秒)为单位。结果绘制在图 6 中,我们描绘了 L 和 Err 的帕累托前沿,以突出达到某一损失或错误值所需的最优训练计算量 Cmin。拟合的幂律扩展规律如下:

拟合的 L 和 Err关于 Cmin 的幂律扩展规律如下:

这些关系(公式 14 和 16)在 Cmin范围内跨越了 6 个数量级,并且我们的发现与文献【43, 35】一致:在数据充足的情况下,更大的 VAR Transformer 具有更高的计算效率,因为它们可以用更少的计算量达到相同的性能水平。

图 6:最优训练计算量 Cmin的扩展规律。线条颜色表示不同的模型规模。红色虚线为幂律拟合曲线,图例中标出了对应的公式。坐标轴均为对数刻度。接近 -0.99 的皮尔逊相关系数表明 log(Cmin) 与 log(L) 或 log(Err) 之间存在强线性关系。

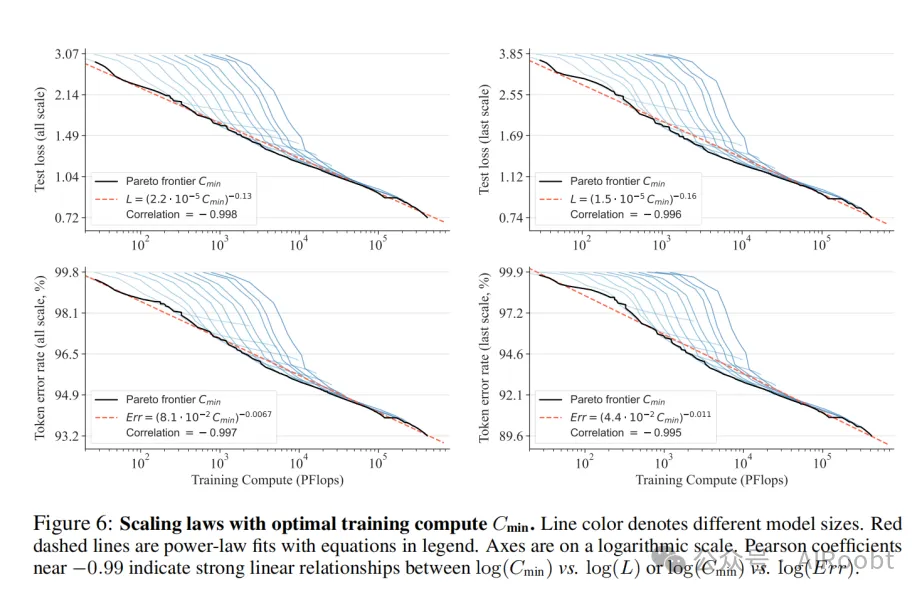

5.3 扩展效果的可视化

为了更好地理解 VAR 模型在扩展时的学习过程,我们在图 7 中比较了 4 种不同规模(深度为 6、16、26、30)的 VAR 模型在 256×256 分辨率上的生成样本。这些样本在训练进度的 20%、60% 和 100% 阶段采样。为确保内容一致性,使用相同的随机种子和初始标记进行训练。实验结果表明,随着模型规模的扩大,生成图像的视觉保真度和质量显著提高,这与幂律规律一致。

图 7:增加模型规模 NN 和训练计算量 CC 提高了视觉保真度和一致性。放大可获得更清晰的视图。样本来自 4 种不同规模的 VAR 模型和 3 个不同训练阶段。9 个类别标签(从左到右,从上到下)分别是:火烈鸟 130、北极狼 270、金刚鹦鹉 88、暹罗猫 284、示波器 688、哈士奇 250、信天翁 146、火山 980 和双体船 484。

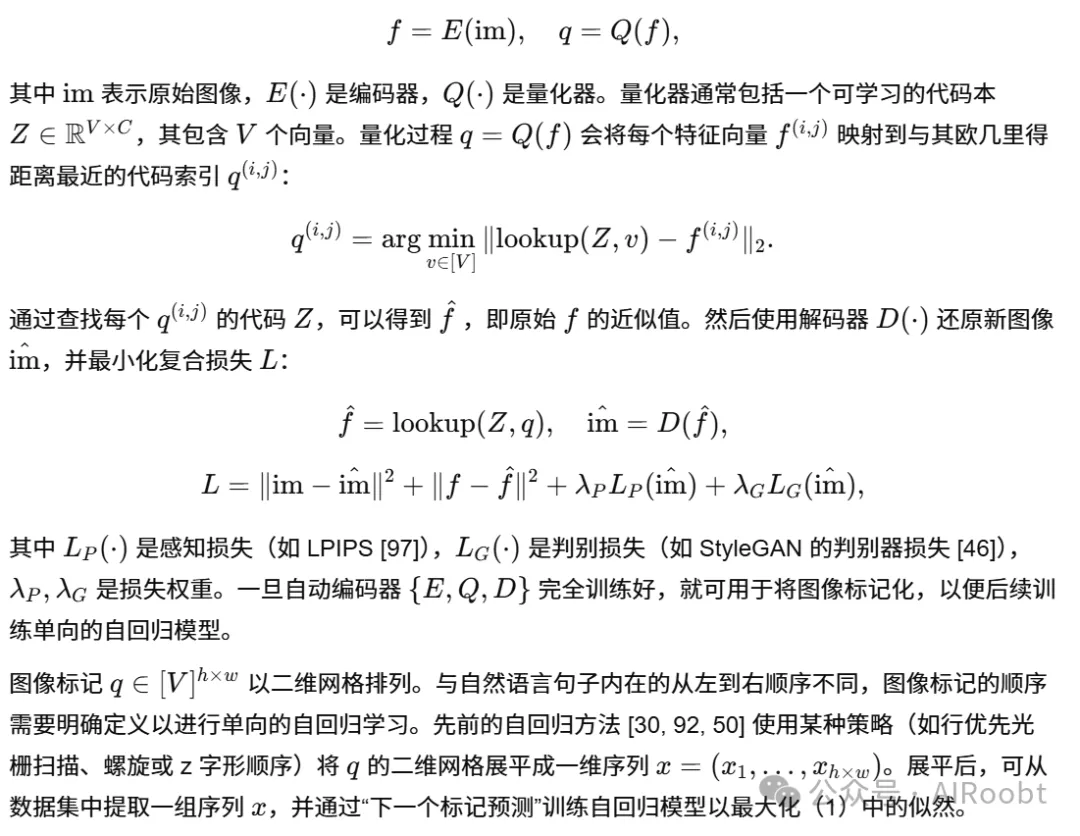

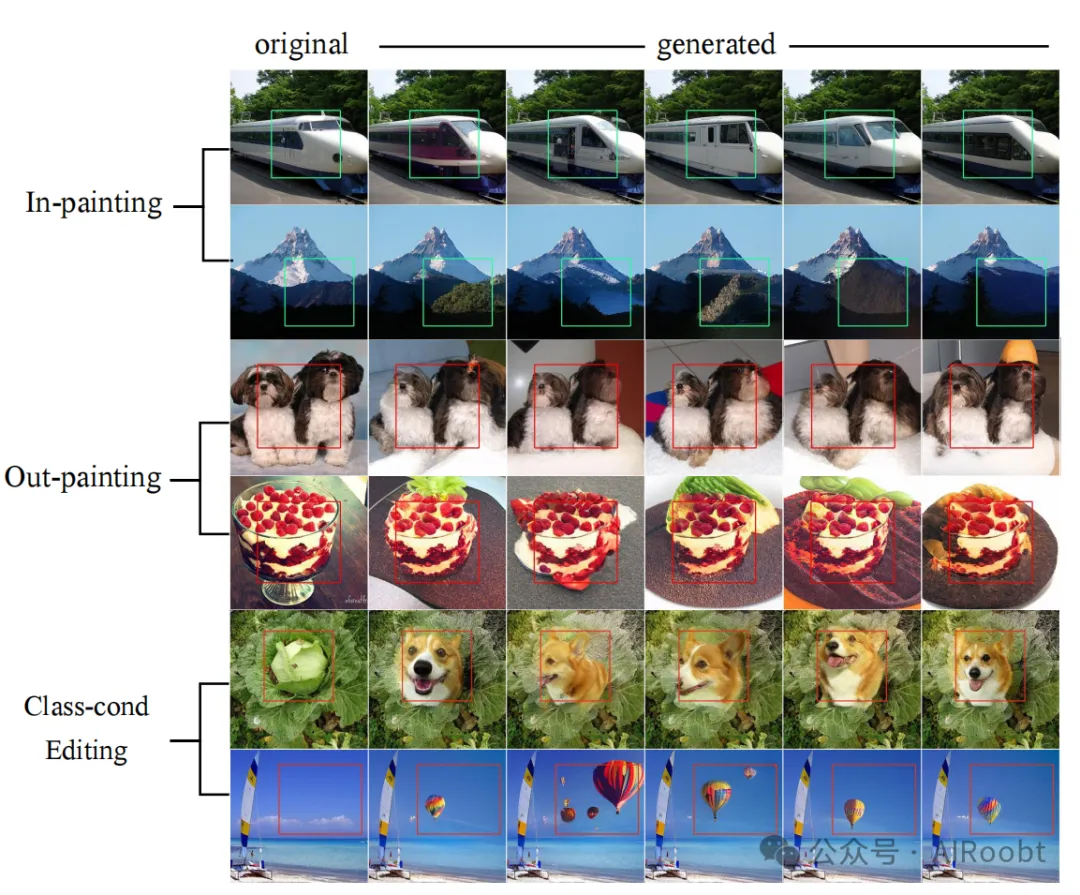

6、零样本任务泛化

图像修补和外延我们在 VAR-d30 上进行了测试。在图像修补和外延任务中,我们使用教师强制(teacher-forcing)的方法,在掩码外的区域提供真实标记,仅让模型生成掩码内的标记。模型中未注入类别标签信息。结果如图 8 所示。无需修改网络架构或调整参数,VAR 在这些下游任务中取得了较好的效果,验证了 VAR 的泛化能力。

基于类别条件的图像编辑

参考 MaskGIT【17】,我们同样测试了 VAR 在基于类别条件的图像编辑任务中的表现。与修补任务类似,模型在边界框内仅生成条件于某类别标签的标记。图 8 显示,模型能够生成与周围上下文自然融合的合理内容,再次验证了 VAR 的通用性。

图 8:在修补、外延和基于类别条件的编辑等下游任务中进行零样本评估。结果表明,VAR 能够在无需特殊设计和微调的情况下泛化到新的下游任务。放大可获得更清晰的视图。

7、消融研究

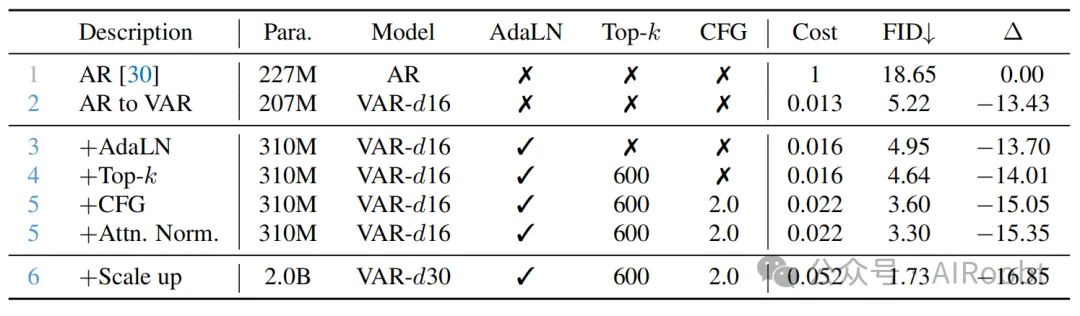

在本研究中,我们旨在验证所提出的 VAR 框架的有效性和效率。结果见表 3。

VAR 的有效性和效率

从由【17】实现的标准自回归(AR)Transformer 基线开始,我们将其方法替换为我们的 VAR,并保持其他设置不变,得到第 2 行结果。VAR 在推理时钟时间仅为 AR 模型的 0.013 倍的情况下,将 FID 从 18.65 大幅改善到 5.22,这证明了视觉自回归模型在性能和效率上的显著飞跃。

表 3:VAR 的消融研究。前两行比较了在 AR 和 VAR 算法下训练的 GPT-2 风格 Transformer(未使用任何附加优化)。后续几行展示了 VAR 增强组件的影响。

“AdaLN”:自适应层归一化。

“CFG”:无分类器引导。

“Attn. Norm.”:在注意力机制中将 qq 和 kk 归一化为单位向量。

“Cost”:相对于基线的推理成本。

“∆”:与基线相比的 FID 降低量。

组件消融

我们进一步测试了 VAR 中一些关键组件的影响:

·将标准层归一化(Layer Normalization, LN)替换为自适应层归一化(Adaptive Layer Normalization, AdaLN),VAR 的 FID 开始超过基线。

·通过使用与基线相似的 top-k 采样,VAR 的 FID 进一步改善。

·使用无分类器引导(Classifier-Free Guidance, CFG)并将比率设为 2.0,同时在注意力机制前将 qq 和 kk 归一化为单位向量,我们达到了 3.30 的 FID,比基线低了 15.35,同时推理速度仍然快 45 倍。

·最后,将 VAR 的规模扩展到 20 亿参数后,我们实现了 1.73 的 FID,比基线的 FID 提高了 16.85。

8、局限性与未来工作

在本研究中,我们主要专注于学习范式的设计,保持了 VQVAE 的架构和训练方式与基线【30】一致,以更好地验证 VAR 框架的有效性。我们认为改进 VQVAE 标记器【99, 59, 95】是增强自回归生成模型的另一种有前景的方法,这与我们的工作是正交的。我们相信,通过结合最新研究中的先进标记器或采样技术,VAR 的性能或速度可以进一步提升。

文本提示生成是我们正在进行的研究方向。由于我们的模型在本质上与现代大型语言模型 (LLMs) 相似,因此可以轻松与它们结合,通过编码器-解码器架构或上下文方式执行文本到图像的生成。这是我们当前优先探索的重点方向之一。

视频生成 在本研究中尚未实现,但它可以自然地进行扩展。通过将多尺度视频特征视为 3D 金字塔,我们可以提出类似的“3D 下一尺度预测”策略,通过 VAR 生成视频。与基于扩散的方法(如 SORA【14】)相比,我们的方法在时间一致性或与 LLM 集成方面具有内在优势,因此有潜力处理更长的时间依赖。这使得 VAR 在视频生成领域具有竞争力,因为传统的自回归模型由于极高的计算复杂性和推理速度慢,在视频生成中效率极低,生成高分辨率视频的代价过于昂贵。而 VAR 有能力解决这一问题。因此,我们预见 VAR 模型在视频生成领域将具有广阔的发展前景。

9、结论

我们提出了一种新的视觉生成框架,称为视觉自回归建模 (VAR),该框架:

1)从理论上解决了标准图像自回归 (AR) 模型中固有的一些问题;

2)使基于语言模型的自回归模型首次在图像质量、多样性、数据效率和推理速度方面超越了强大的扩散模型。

当我们将 VAR 扩展到 20 亿参数时,观察到测试性能与模型参数或训练计算量之间存在明显的幂律关系,皮尔逊相关系数接近 -0.998,表明这是一个稳健的性能预测框架。这些扩展规律以及零样本任务泛化的可能性,作为大型语言模型 (LLMs) 的标志性特征,已在我们的 VAR Transformer 模型中得到了初步验证。

我们希望我们的发现以及开源成果能够促进自然语言处理领域的重大成功更顺畅地整合到计算机视觉中,最终推动强大的多模态智能的发展。

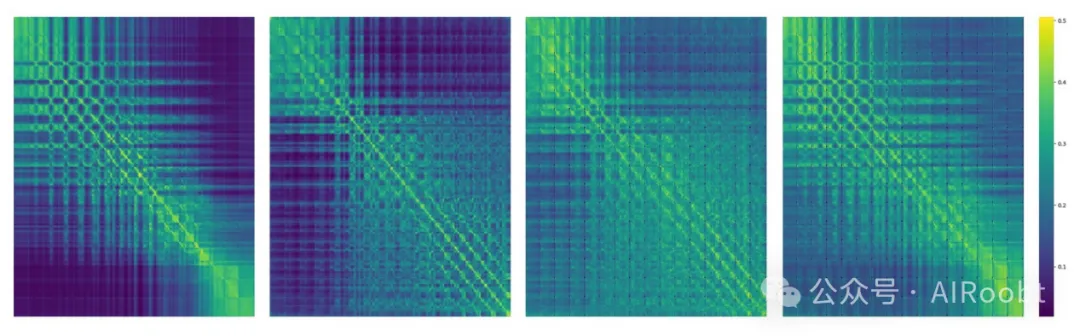

图 9:标记依赖性可视化。展示了 VQGAN 编码器最后一个自注意力层中的归一化注意力分数热力图。使用了来自 ImageNet 验证集的 4 张随机 256×256 图像。

本文转载自公众号AIRoobt ,作者:AIRoobt