图上的推理:忠实且可解释的大型语言模型推理(ICLR2024) 原创

摘要:大型语言模型(LLMs)在复杂任务中展示了令人印象深刻的推理能力。然而,它们缺乏最新的知识,并在推理过程中出现幻觉,这可能导致不正确的推理过程,从而降低其性能和可信度。知识图谱(KGs)以结构化格式捕捉大量事实,为推理提供了可靠的知识来源。然而,现有的基于KG的LLM推理方法仅将KG视为事实知识库,忽视了其结构信息在推理中的重要性。在本文中,我们提出了一种新方法,称为图上推理(RoG),它将LLMs与KGs协同作用,以实现忠实且可解释的推理。具体而言,我们提出了一个规划-检索-推理框架,其中RoG首先生成由KGs支撑的关系路径作为忠实的计划。这些计划随后用于从KGs检索有效的推理路径,以便LLMs进行忠实的推理。此外,RoG不仅通过训练从KGs中提炼知识以提高LLMs的推理能力,还允许在推理过程中与任何任意的LLMs无缝集成。在两个基准KGQA数据集上的广泛实验表明,RoG在KG推理任务上达到了最先进的性能,并生成了忠实且可解释的推理结果。

1、引言

大型语言模型(LLMs)在许多自然语言处理(NLP)任务中表现出色(Brown et al., 2020; Bang et al., 2023)。尤其引人注目的是它们通过推理处理复杂任务的能力(Wei et al., 2022; Huang & Chang, 2023)。为了进一步释放LLMs的推理能力,提出了计划-解决范式(Wang et al., 2023c),其中LLMs被提示生成一个计划并执行每个推理步骤。通过这种方式,LLMs将复杂的推理任务分解为一系列子任务并逐步解决(Khot et al., 2022)。

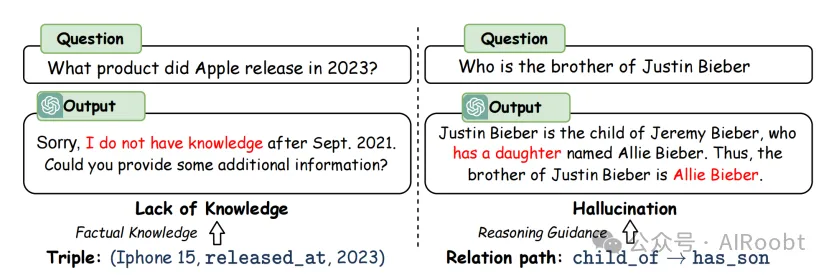

尽管取得了成功,LLMs仍然受到知识缺乏的限制,并在推理过程中容易出现幻觉,这可能导致推理过程中的错误(Hong et al., 2023; Wang et al., 2023b)。例如,如图1所示,LLMs没有最新的知识并且幻觉出一个错误的推理步骤:“有一个女儿”。这些问题在高风险场景(例如法律判断和医疗诊断)中大大降低了LLMs的性能和可信度。

图1:大型语言模型(LLMs)推理中知识缺乏和幻觉的问题,以及如何通过知识图谱(KGs)中的三元组和关系路径来解决这些问题。

为了解决这些问题,知识图谱(KGs)被引入以提高LLMs的推理能力(Pan et al., 2024; Luo et al., 2023a)。KGs以结构化格式捕获丰富的事实知识,为推理提供可信的知识源。作为典型的推理任务,知识图谱问答(KGQA)旨在根据KG中的知识获取答案(Sun et al., 2019)。先前将KGs与LLMs联合用于KGQA推理的工作大致可以分为两类:1)语义解析方法(Lan & Jiang, 2020; Ye et al., 2022),这些方法使用LLMs将问题转换为在KG上执行的逻辑查询以获取答案;2)检索增强方法(Li et al., 2023; Jiang et al., 2023),这些方法从KGs中检索三元组作为知识上下文,并使用LLMs获得最终答案。

尽管语义解析方法通过利用KGs进行推理可以生成更准确和可解释的结果,但生成的逻辑查询通常不可执行,且由于语法和语义限制而得不到答案(Yu et al., 2022a)。检索增强方法更加灵活,并利用LLMs的推理能力。然而,它们仅将KGs视为事实知识库,忽视了其结构信息在推理中的重要性(Jiang et al., 2022)。例如,如图1所示,一个关系路径,即关系序列“子女→有儿子”,可以用来回答“贾斯丁·比伯的兄弟是谁?”这个问题。因此,使LLMs能够直接在KGs上推理是实现忠实和可解释推理的关键。

在本文中,我们提出了一种新方法,称为图上推理(RoG),它将LLMs与KGs协同作用,以进行忠实和可解释的推理。为了解决幻觉和知识缺乏的问题,我们提出了一种规划-检索-推理框架,其中RoG首先通过规划模块生成由KGs支撑的关系路径作为忠实的计划。这些计划随后被用于通过检索-推理模块从KGs中检索有效的推理路径,以进行忠实推理。通过这种方式,我们不仅从KGs中检索最新的知识,还考虑了KG结构对推理和解释的指导。此外,RoG的规划模块可以在推理期间与不同的LLMs进行即插即用的集成,以提高它们的性能。基于该框架,RoG通过两个任务进行优化:1)规划优化,我们从KGs中提炼知识以生成忠实的关系路径作为计划;2)检索-推理优化,我们使LLMs能够基于检索到的路径进行忠实推理,并生成可解释的结果。我们在两个基准KGQA数据集上进行了广泛实验,结果表明,RoG在KG推理任务上达到了最先进的性能,并生成了忠实和可解释的推理结果。

2、相关工作

LLM推理提示。许多研究提出了通过提示利用LLMs的推理能力来处理复杂任务(Wei et al., 2022; Wang et al., 2022; Yao et al., 2023; Besta et al., 2023)。计划-解决(Wang et al., 2023c)提示LLMs生成一个计划并根据其执行推理。DecomP(He et al., 2021)提示LLMs将推理任务分解为一系列子任务并逐步解决。然而,幻觉和知识缺乏的问题影响了LLMs推理的可信度。ReACT(Yao et al., 2022)将LLMs视为代理,与环境互动以获取最新的推理知识。为了探索忠实推理,FAME(Hong et al., 2023)引入蒙特卡洛规划来生成忠实的推理步骤。RR(He et al., 2022)和KD-CoT(Wang et al., 2023b)进一步从KGs中检索相关知识,以为LLMs生成忠实的推理计划。

知识图谱问答(KGQA)。传统的基于嵌入的方法在嵌入空间中表示实体和关系,并设计特殊的模型架构(例如,关键值记忆网络、序列模型和图神经网络)来推理答案(Miller et al., 2016; He et al., 2021; Yasunaga et al., 2021)。为了将LLMs与KGQA结合,检索增强方法旨在从KGs中检索相关事实,以提高推理性能(Li et al., 2023; Karpukhin et al., 2020)。最近,UniKGQA(Jiang et al., 2022)将图检索和推理过程统一为一个与LLMs的单一模型,达到了KGQA任务的最佳性能。语义解析方法通过LLMs将问题转换为结构查询(例如SPARQL),这些查询可以由查询引擎执行以在KG上推理答案(Sun et al., 2020; Lan & Jiang, 2020)。然而,这些方法在很大程度上依赖于生成查询的质量。如果查询不可执行,则不会生成答案。DECAF(Yu et al., 2022a)结合语义解析和LLMs推理以联合生成答案,在KGQA任务中也取得了显著性能。

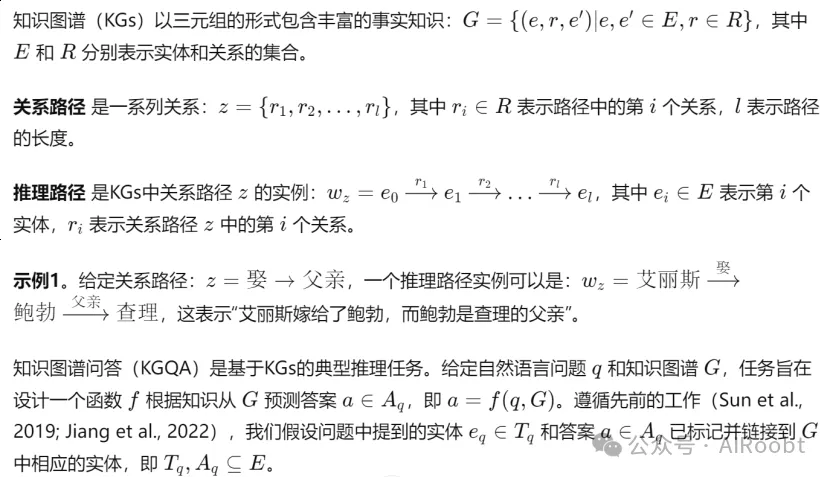

3、初步概念

4、方法

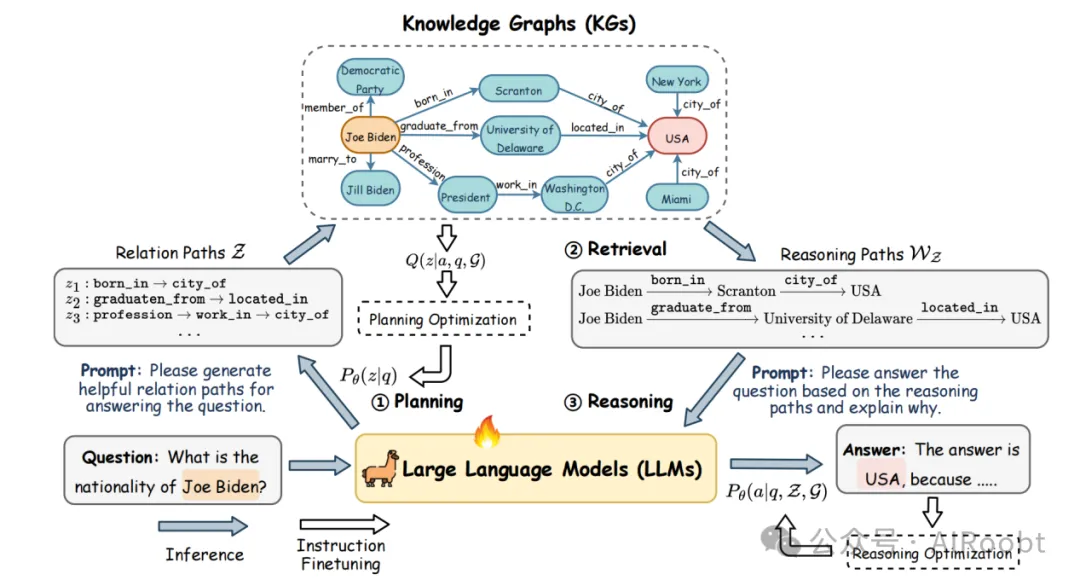

在这一部分,我们介绍我们的方法:图上推理(RoG),它包含两个组件:1)一个生成基于KGs的忠实关系路径作为问题回答计划的规划模块;2)一个检索-推理模块,首先根据计划从KGs中检索有效的推理路径,然后根据检索到的推理路径进行忠实推理并生成可解释的答案。RoG的整体框架如图2所示。

图2:图上推理(RoG)的整体框架。1)给定一个问题,我们首先提示大型语言模型(LLMs)生成几个以知识图谱(KGs)为基础的关系路径作为计划。2)然后,我们使用这些计划从KGs中检索推理路径。3)最后,我们基于检索到的推理路径进行忠实推理,并生成带有可解释解释的答案。橙色和红色矩形分别表示问题和答案中提到的实体。

4.1 图上推理:规划-检索-推理

最近,许多技术被探索以通过规划提高LLMs的推理能力,首先提示LLMs生成推理计划,然后根据该计划进行推理(Wang et al., 2023c)。然而,LLMs已知存在幻觉问题,容易生成不正确的计划并导致错误答案(Ji et al., 2023)。为了解决这个问题,我们提出了一种新颖的规划-检索-推理框架,使推理计划基于KGs,从而检索出忠实的推理路径供LLMs进行推理。

关系路径捕获了实体之间的语义关系,已在许多KG上的推理任务中得到应用(Wang et al., 2021; Xu et al., 2022)。此外,与动态更新的实体相比,KG中的关系更稳定(Wang et al., 2023a)。通过使用关系路径,我们始终可以从KGs中检索到最新的知识进行推理。因此,关系路径可以作为回答KGQA任务的忠实计划。

示例2。给定问题“艾丽斯的孩子是谁?”,我们可以生成一个关系路径作为计划:z = 嫁→父亲。这个关系路径表达了计划:1)找到“艾丽斯”所嫁的人;2)找到该人的孩子。我们可以通过从KGs检索推理路径来执行该计划(关系路径):wz = 艾丽斯嫁→鲍勃父亲→查理。最后,我们可以根据推理路径回答问题,答案是“查理”。

通过将关系路径视为计划,我们可以确保这些计划基于KGs,从而使LLMs能够在图上进行忠实和可解释的推理。简而言之,我们将RoG表述为一个优化问题,旨在通过生成关系路径z作为计划,最大化从知识图谱G推理答案的概率:

其中 θ表示大型语言模型(LLMs)的参数,z 表示LLMs生成的关系路径(计划),而 Z 表示可能关系路径的集合。后一个项 Pθ(z∣q) 是在给定问题 q 的情况下生成基于知识图谱(KG)的忠实关系路径 z 的概率,这由规划模块实现。前一个项Pθ(a∣q,z,G) 是在给定问题 q、关系路径 z和知识图谱 G的情况下推理答案 a的概率,这由检索-推理模块计算得出。

4.2 优化框架

尽管生成关系路径作为计划具有优势,但LLMs对KGs中包含的关系几乎没有知识。因此,LLMs无法直接生成基于KGs的忠实计划的关系路径。此外,LLMs可能无法正确理解推理路径并基于它们进行推理。为了解决这些问题,我们设计了两个指令调优任务:

1)规划优化,旨在将KG中的知识提炼到LLMs中,以生成忠实的关系路径作为计划;

2)检索-推理优化,旨在使LLMs能够基于检索到的推理路径进行推理。

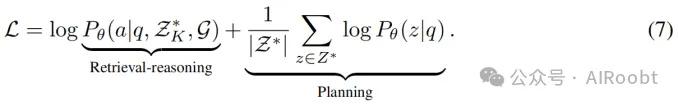

公式(1)中的目标函数可以通过最大化证据下界(ELBO)进行优化(Jordan et al., 1999),其形式为:

其中 Q(z) 表示基于KGs的忠实关系路径的后验分布。后一个项最小化后验分布与先验分布之间的KL散度,这鼓励LLMs生成忠实的关系路径(规划优化)。前一个项最大化期望,即检索-推理模块基于关系路径和KGs生成正确答案的概率(检索-推理优化)。

规划优化。在规划优化中,我们的目标是将KG中的知识提炼到LLMs中,以生成忠实的关系路径作为计划。这可以通过最小化与KGs中的忠实关系路径的后验分布 Q(z) 的KL散度来实现。

给定问题q和答案a ,我们可以在KG中找到路径实例

连接 eq 和 ea 。相应的关系路径z={r1,r2,…,rl}可以被视为有效的,并作为回答问题 q 的忠实计划。后验分布 Q(z) 可以形式化地近似为:

其中我们假设在所有有效关系路径 Z 上均匀分布,且 ∃wz(eq, ea) ∈ G 表示连接问题 e_q 和答案 e_a 的路径实例在 G 中存在。因此,KL散度可以计算为:

其中我们使用KGs中 e_q 和 e_a 之间的最短路径 Z ⊆Z 作为监督信号(Zhang et al., 2022)。详细推导可以在附录A.1中找到。通过优化公式(4),我们最大化LLMs生成忠实关系路径的概率,同时从KG中提炼知识。

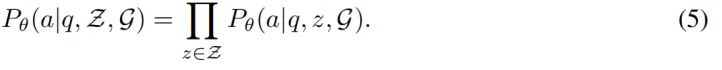

检索-推理优化。在检索-推理优化中,我们的目标是使LLMs能够基于检索到的推理路径进行推理。对于检索-推理模块,我们遵循FiD框架(Izacard & Grave, 2021; Singh et al., 2021),该框架允许在多个检索到的推理路径上进行推理,形式化为:

通过用采样的 K 个计划 ZK ⊆Z 近似期望,推理优化的目标函数可以写为:

这最大化LLMs基于检索到的推理路径生成正确答案的概率。

RoG的最终目标函数是规划优化和检索-推理优化的组合,可以形式化为:

从公式(7)可以看出,我们对规划和推理使用相同的LLM,这两个任务(规划和检索-推理)在共同训练。我们将在接下来的子部分讨论这两个任务的实现细节。

4.3 规划模块

规划模块旨在生成忠实的关系路径,作为回答问题的计划。为了利用大型语言模型(LLMs)的指令跟随能力(Wei et al., 2021),我们设计了一个简单的指令模板,提示LLMs生成关系路径:

请生成一个有效的关系路径,以帮助回答以下问题:<Question>

其中 <Question> 表示问题q。问题和指令模板一起输入LLMs,以生成关系路径,这些路径结构化格式化为一个句子:

z = <PATH> r1 <SEP> r2 <SEP> . . . <SEP> rl </PATH>

其中 <PATH>、<SEP> 和 </PATH> 是特殊标记,分别表示关系路径的开始、分隔符和结束。

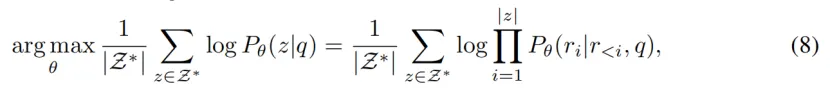

因此,规划的优化可以表示为:

其中 Pθ(z|q) 表示生成忠实关系路径z的先验分布,Pθ(ri|r<i, q) 表示LLMs生成路径 z 中每个标记的概率。

4.4 检索-推理模块

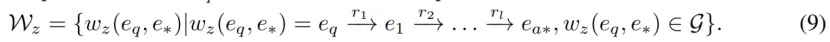

检索。给定问题q和作为计划的关系路径z,检索模块旨在从知识图谱G中检索推理路径Wz。检索过程可以通过找到在 G 中从问题实体 eq开始并遵循关系路径 z的路径来进行,公式化为:

我们采用受限的广度优先搜索从知识图谱中检索推理路径 wz 。在实验中,所有检索到的路径都用于推理。详细的检索算法可以在附录 A.3 中找到。

尽管我们可以利用检索到的推理路径并通过多数投票直接获得答案,但检索到的推理路径可能是噪声且与问题无关,这会导致错误答案(He et al., 2021;Zhang et al., 2022)。因此,我们提出了一个推理模块,以探索大型语言模型(LLMs)识别重要推理路径的能力,并基于这些路径回答问题。

推理。推理模块接受问题 q 和一组推理路径 Wz 来生成答案 a 。类似地,我们设计了一个推理指令提示,引导LLMs基于检索到的推理路径 Wz 进行推理。 Wz 也格式化为一系列结构化句子。详细的提示可以在附录 A.10 中找到。

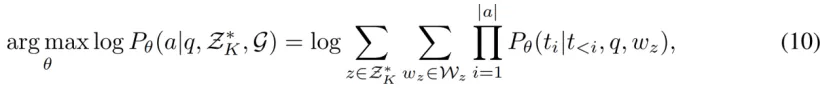

推理的优化可以写为:

其中Pθ(a|q, ZK, G) 表示基于K条关系路径ZK 推理正确答案a的概率,t表示答案a的标记。

5、实验

在我们的实验中,我们旨在回答以下研究问题:RQ1:RoG能否在KGQA任务中实现最先进的性能?RQ2:RoG的规划模块能否与其他大型语言模型(LLMs)集成以提高它们的性能?RQ3:RoG能否进行忠实推理并生成可解释的推理结果?

5.1 实验设置

数据集。我们在两个基准知识图谱问答(KGQA)数据集上评估RoG的推理能力:WebQuestionSP(WebQSP)(Yih et al., 2016)和复杂网页问答(CWQ)(Talmor & Berant, 2018),这两个数据集包含最多4跳的问题。Freebase(Bollacker et al., 2008)是这两个数据集的背景知识图谱,包含大约8800万个实体、2万个关系和1.26亿个三元组。数据集的详细信息在附录A.4中描述。

基线。我们将RoG与21个基线进行比较,这些基线分为5类:1)基于嵌入的方法,2)检索增强的方法,3)语义解析的方法,4)大型语言模型(LLMs),以及5)LLMs+KGs的方法。每个基线的详细信息在附录A.5中描述。

评估指标。根据先前的研究,我们使用Hits@1和F1作为评估指标。Hits@1衡量的是预测答案的前1个正确的问答比例。由于一个问题可能对应多个答案,F1考虑了所有答案的覆盖率,从而平衡了预测答案的精准度和召回率。

实现。对于RoG,我们使用LLaMA2-Chat-7B(Touvron et al., 2023)作为大型语言模型的基础,该模型在WebQSP和CWQ的训练集以及Freebase上进行了3个周期的指令微调。我们为每个问题生成前3个关系路径,使用的是束搜索算法。由于UniKGQA(Jiang et al., 2022)和DECAF(Yu et al., 2022a)是最先进的方法,我们直接引用它们的结果以及其他基线在其论文中报告的结果进行比较。对于LLMs,我们使用0-shot提示进行KGQA。详细设置在附录A.6中描述。

5.2 RQ1: KGQA性能比较

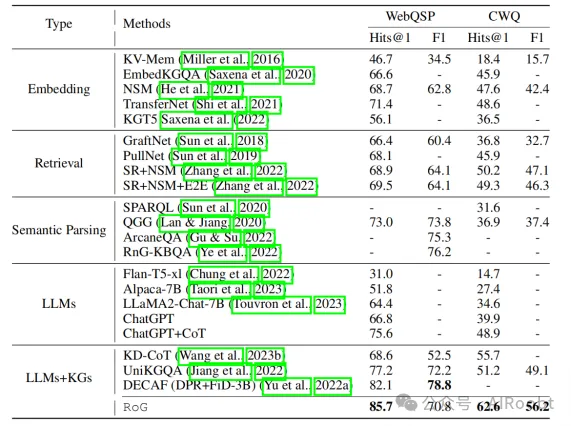

主要结果。在本节中,我们比较RoG与其他基线在KGQA任务上的表现。结果如表1所示。我们的方法在两个数据集上大多数指标上都达到了最佳性能。具体来说,与最先进的方法DECAF(Yu et al., 2022a)在WebQSP上的比较,我们的方法将Hits@1提高了4.4%。在CWQ数据集中,由于多跳问题的挑战,我们的方法在Hits@1和F1上分别提高了22.3%和14.4%,相比于最先进模型UniKGQA(Jiang et al., 2022)。这些结果展示了我们方法在KGQA中的卓越推理能力。

表1:RoG与基线方法的性能比较

在其他方法中,检索增强方法通过从KGs中检索相关子图,超越了传统的基于嵌入的方法,从而降低了推理复杂性。此外,SR+NSM和SR+NSM+E2E采用基于关系路径的检索,取得了更好的性能,强调了关系路径的重要性。语义解析方法在WebQSP上的表现优于检索方法,但在CWQ上表现较差,这是由于CWQ中复杂问题的逻辑查询生成的复杂性。尽管基于LLMs的方法表现可比,但如第5.4节所示,它们受到幻觉和知识缺乏的限制。LLMs+KGs的方法取得了第二好的性能,这证明了统一KGs和LLMs进行推理的有效性。

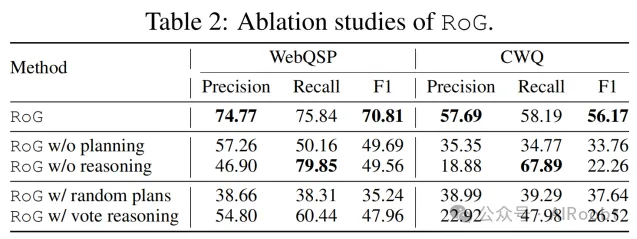

消融研究。我们进行了一项消融研究,以分析我们的方法(RoG)中规划模块和推理模块的有效性。我们比较了四个变体:1)不使用规划(w/o planning),在此情况下,我们移除规划模块,进行没有检索推理路径的推理;2)不使用推理(w/o reasoning),在此情况下,我们移除推理模块,使用从检索推理路径中获得的所有答案作为结果;3)使用随机计划(w/ random plans),在此情况下,我们随机从KGs中检索推理路径并将其输入到推理模块;4)使用投票推理(w/ vote reasoning),在此情况下,我们采用多数投票从检索的推理路径中选择前5个答案。结果如表2所示。从结果中明显可以看出,没有规划模块,我们的方法退化为仅依赖问题作为输入的传统LLMs,遭受知识缺乏的问题。虽然移除推理模块会导致由于答案数量增加而回忆率较高,但由于检索路径中的噪声,精准度显著下降。这证明了推理模块在识别重要推理路径和过滤噪声方面的有效性。此外,使用随机计划的性能还不如移除规划模块,强调了规划模块生成忠实推理计划的重要性。使用简单的多数投票推理可以改善结果,这也证明了推理模块的必要性。

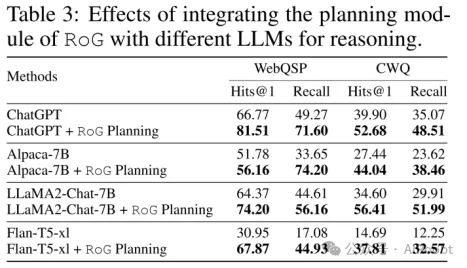

5.3 RQ2: 即插即用的RoG规划模块

在本节中,我们评估将RoG的规划模块与不同的LLMs集成以提高其性能的有效性。具体而言,我们首先采用RoG的规划模块生成关系路径,并将检索到的推理路径作为上下文输入到不同的LLMs中进行推理。结果如表3所示。

考虑到从LLMs的输出中提取答案数量的困难,我们仅报告Hits@1和召回率指标。从结果中,我们可以注意到,所有LLMs的性能在集成RoG的规划模块后都有显著改善。具体而言,ChatGPT、Alpaca、LLaMA2和Flan-T5的Hits@1分别提高了8.5%、15.3%和119.3%。这证明了RoG的规划模块可以与其他LLMs无缝集成,以提高其性能,而无需重新训练。

5.4 RQ3: 忠实推理和可解释结果

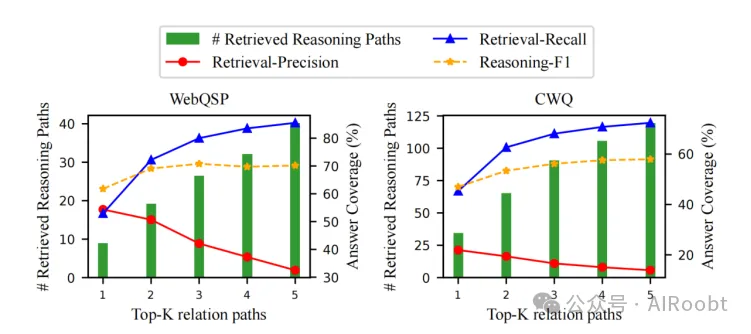

定量结果。为了评估关系路径的忠实性,我们在图3中展示了定量结果。在实验中,我们调整了RoG生成的前K个关系路径的数量。从结果中可以看出,检索到的推理路径的数量随着K的增加而增加,这也导致覆盖更多答案(召回)。这证明了通过检索答案实现关系路径的忠实性。然而,更多的检索推理路径也会导致更多的噪声和检索时间(如附录A.7.4所示),这降低了精确度,并对最终结果(推理-F1)贡献甚微。因此,我们在实验中设置K=3。

图3:前K个生成关系路径的忠实性。绿色条形表示检索到的推理路径的平均数量,实线表示检索路径的答案覆盖率,虚线表示基于检索到的推理路径的推理模块的答案覆盖率。

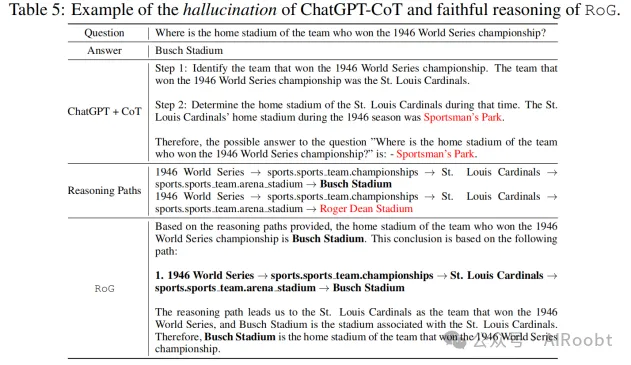

案例研究。我们还在表4和表5中展示了两个案例研究。在表4中,我们发现ChatGPT+CoT遭遇了知识缺乏的问题,无法回答问题。相反,RoG能够生成忠实的关系路径,并从KGs中检索有效的推理路径进行推理。此外,RoG可以基于推理路径提供可解释的解释。在表5中,我们看到ChatGPT+CoT受到幻觉的影响,生成了错误的答案。相比之下,尽管检索到的推理路径包含噪声,推理模块仍能够识别出正确的推理路径并进行忠实推理。这些结果证明了RoG在进行忠实推理和生成可解释结果方面的有效性。更多案例可以在附录A.8和A.9中找到。

5.4 讨论

RoG的实验结果显示,通过规划和检索结合的方式,可以显著提升LLMs在KGQA任务中的推理性能。生成的关系路径为推理提供了结构支持,从而降低了幻觉的可能性。

6、结论

在本文中,我们提出了图上推理(RoG)框架,结合了规划和检索-推理模块,利用知识图谱提升LLMs的推理能力。我们的实验结果表明,RoG在多个KGQA任务上达到了最先进的性能,并生成了可解释的推理结果。未来的工作将致力于扩展RoG框架,以支持更多类型的推理任务,并进一步提高推理的准确性和解释性。

本文转载自公众号AIRoobt ,作者:AIRoobt