视觉模型进入MoE时代!DeepSeek开源全新视觉模型VL2,逆向由图生成代码、梗图解析、几张图生成一篇童话! 原创

编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

12月13日晚,国内开源模型玩家深度求索发布了视觉模型 DeepSeek-VL2。这次DeepSeek视觉模型给这一领域带来了不少看新看点:

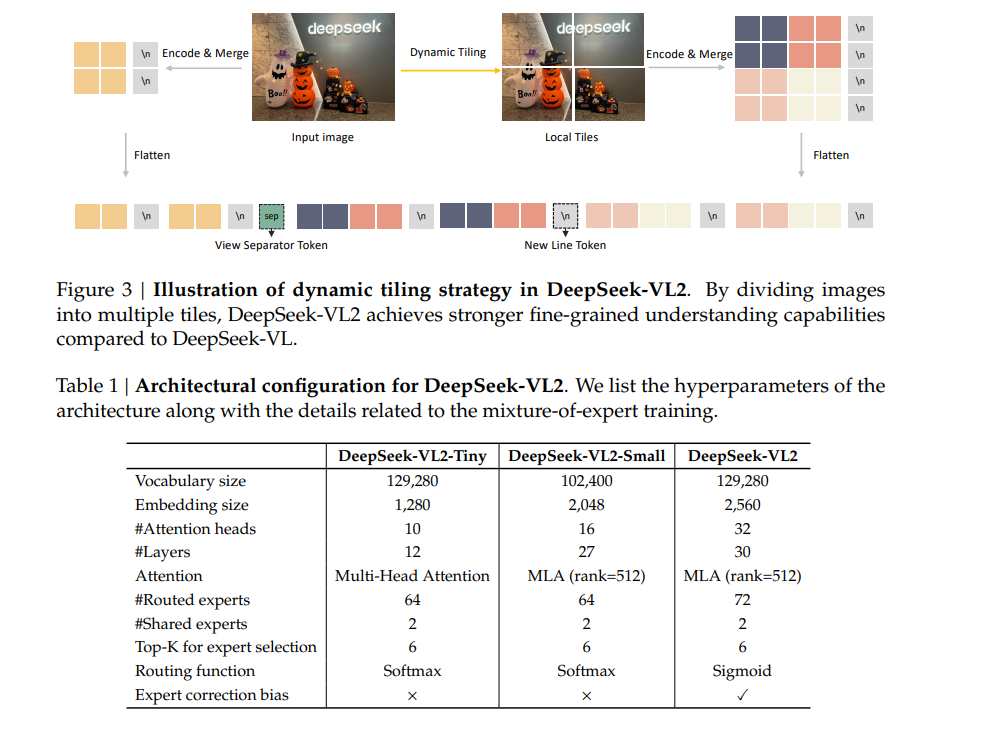

1、模型层面,视觉模型也可以使用 MoE 架构,而且可以配合动态切图

2、新增了不少生成玩法,如:视觉定位,模型可以根据提示识别出物体的边界范围,再比如梗图理解和解析。

3、图表理解:可以根据plot图逆向生成代码。

4、从OCR到故事生成:可以N张图一期喂给模型,模型直接生成强相关的故事。

先上一张图,让大家品一品,一句提示,让大模型明白图中的人物:谁是淡定姐。

图片

图片

当然,DeepSeek-VL2 肯定是开源的了,具体型号有3B、16B 、 27B。模型和论文均已发布:

模型下载:https://huggingface.co/deepseek-ai

GitHub主页:https://github.com/deepseek-ai/DeepSeek-VL2

1.模型新升级

首先看数据方面,VL2 比上一代 DeepSeek-VL 多一倍优质训练数据,引入梗图理解、视觉定位、视觉故事生成等新能力。

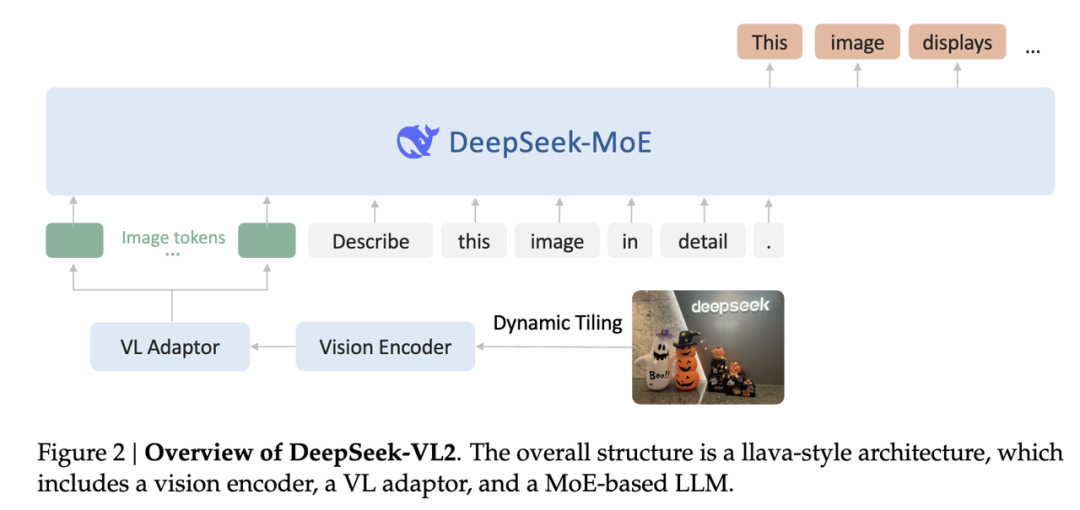

在模型架构上,视觉部分使用切图策略支持动态分辨率图像,语言部分采用 MoE 架构低成本高性能。

图片

图片

在训练方法上,继承 DeepSeek-VL 的三阶段训练流程,同时通过负载均衡适配图像切片数量不定的困难,对图像和文本数据使用不同流水并行策略,对 MoE 语言模型引入专家并行,实现高效训练。

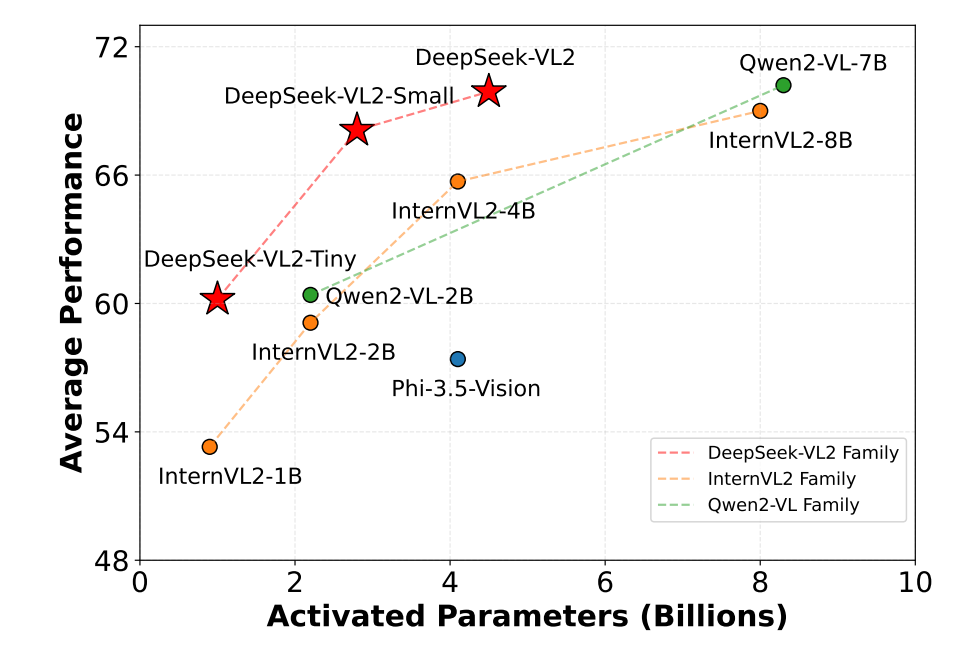

在不少视觉理解测试中,评分结果跟GPT4o、Qwen打平,甚至更好,关键是VL2可以用更少的参数量就能达到极好的效果。DeepSeek-VL2 模型展现出了强大能力,在各项评测指标上均取得了极具优势的成绩:

图片

图片

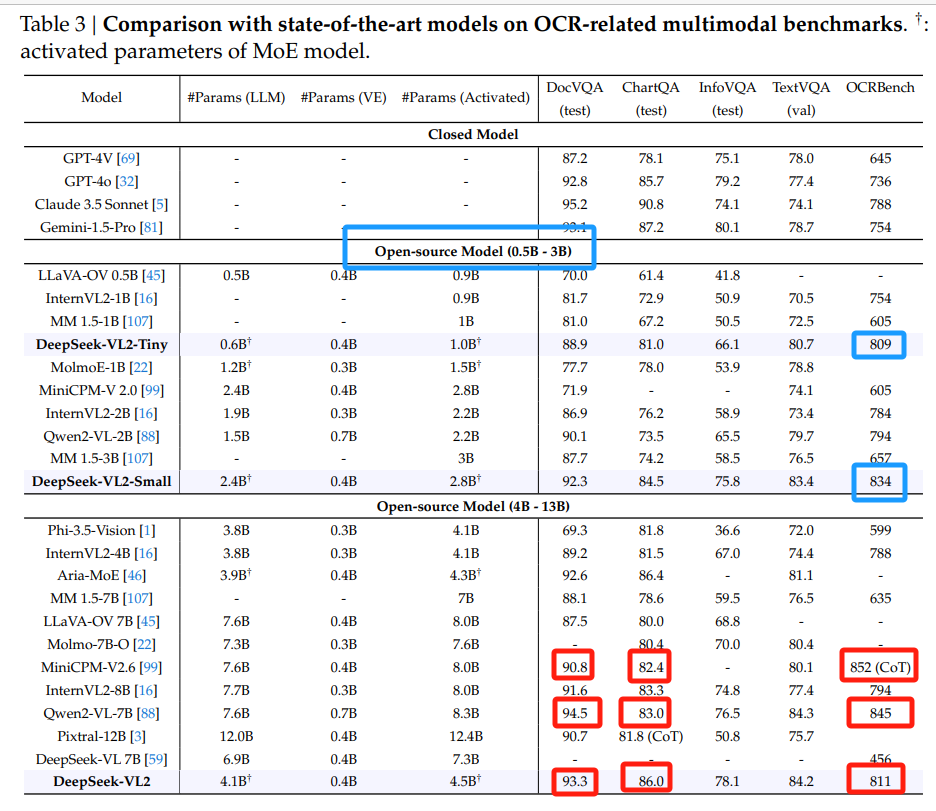

具体的测评结果如下:

图片

图片

2.动态分辨率支持

据介绍,DeepSeek-VL2 仅使用一个 SigLIP-SO400M 作为图像编码器,通过将图像切分为多张子图和一张全局缩略图来实现动态分辨率图像支持。这一策略使得 DeepSeek-VL2 最多支持 1152x1152 的分辨率和 1:9 或 9:1 的极端长宽比,这样就可以适配更多应用场景。

图片

图片

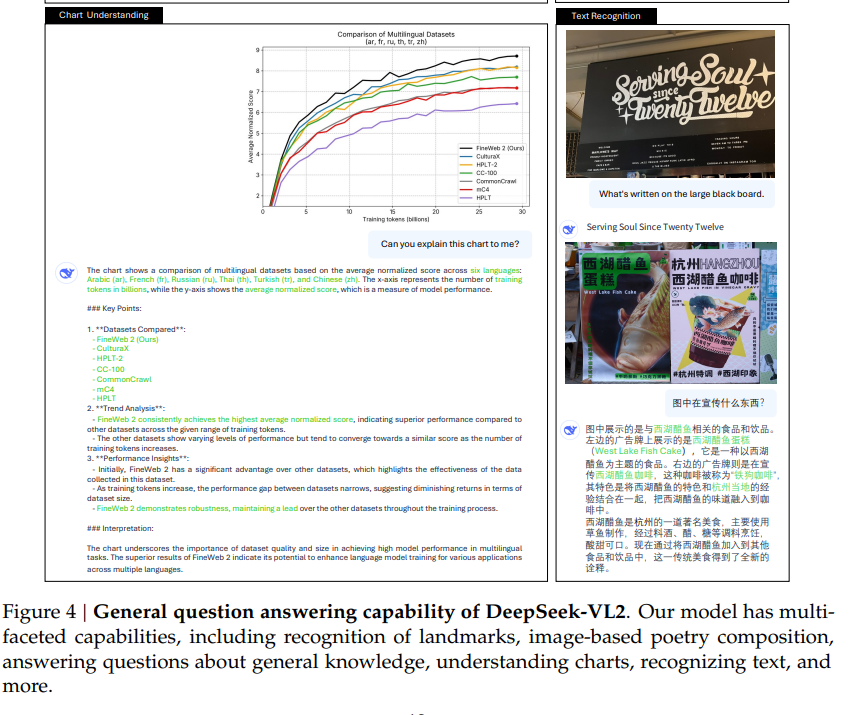

3.图表理解

更多科研文档数据的学习使得 DeepSeek-VL2 可以轻易理解各种科研图表。

图片

图片

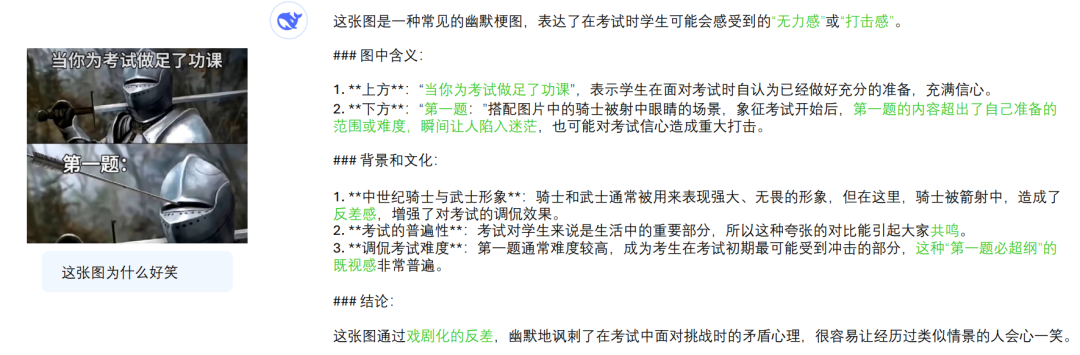

甚至连内涵的梗图大模型也可以理解到位,由于DeeSeek-VL2用了更大规模的优质数据,使得模型可以解析各种迷之能力,内涵什么的,大模型简直小菜一碟。

一道调侃考试难度的梗图,让他解释下为什么好笑——

图片

图片

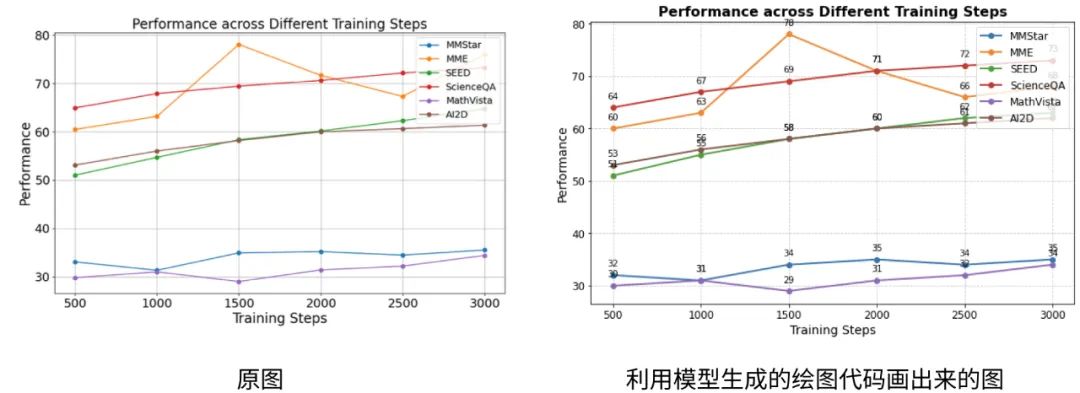

4.Plot2Code(逆向:图生代码)

DeepSeek-VL2 同时具备图像理解和代码生成的功能,可以作为你逆向画图的好帮手。

图片

图片

Prompt: Draw a plot similar to the image in Python.

5.视觉定位:视觉感知+语言推理

DS-VL2这次的一大看点就是视觉定位。用户可以用一句话描述下物体,然后让 DeepSeek-VL2 帮在图像里找到符合描述的部分(注:模型本身只是输出相应物体的边界框)。

图片

图片

有了这项功能,就可以让大模型做很多事情,比如higlight一下孙猴子、葫芦娃什么的,甚至有几个葫芦娃也都可以标出来!

图片

图片

此外,视觉感知+语言推理,强强联手还可以让模型具备视觉语义的对话能力。

这就是我们之前在GPT-4o发布视觉对话中的功能,你跟模型视频,问他哪款甜品适合自己,他能很懂你的需求做出推荐。

图片

图片

6.故事生成

你也可以输入多张图像,让模型把它们串联起来,小老鼠、话多、魔法师、发光树,四张图片一上传,让VL2用这些图片讲一个故事,它也不会怵,秒懂图里的角色,快速讲出一篇《雪夜的奇遇》的童话来。

图片

图片

童话出版物机构可以用上一用!

7.写在最后:如何理解和用好多模态?

多模态可以说是今年以来大模型向前演进的一个趋势,从语言到视觉、听觉等深入研究,既可以进一步解锁大模型的通用能力,同时也会让未来的AI应用更加繁荣和落地。

DeepSeek团队提到,视觉是人类获取外界信息的主要来源,占据所有信息量的约 80%。然而在大模型时代,视觉方面的进展却远远落后于语言模型。

“我们坚信,提升模型视觉能力的意义不仅在于支持更多的输入模态,更在于全方位提升模型的感知和认知能力。”

本文转载自51CTO技术栈,作者:言征