Meta AI 发布 Llama Guard 3-1B-INT4:用于人机对话的紧凑型高性能 AI 审核模型 原创 精华

01、概述

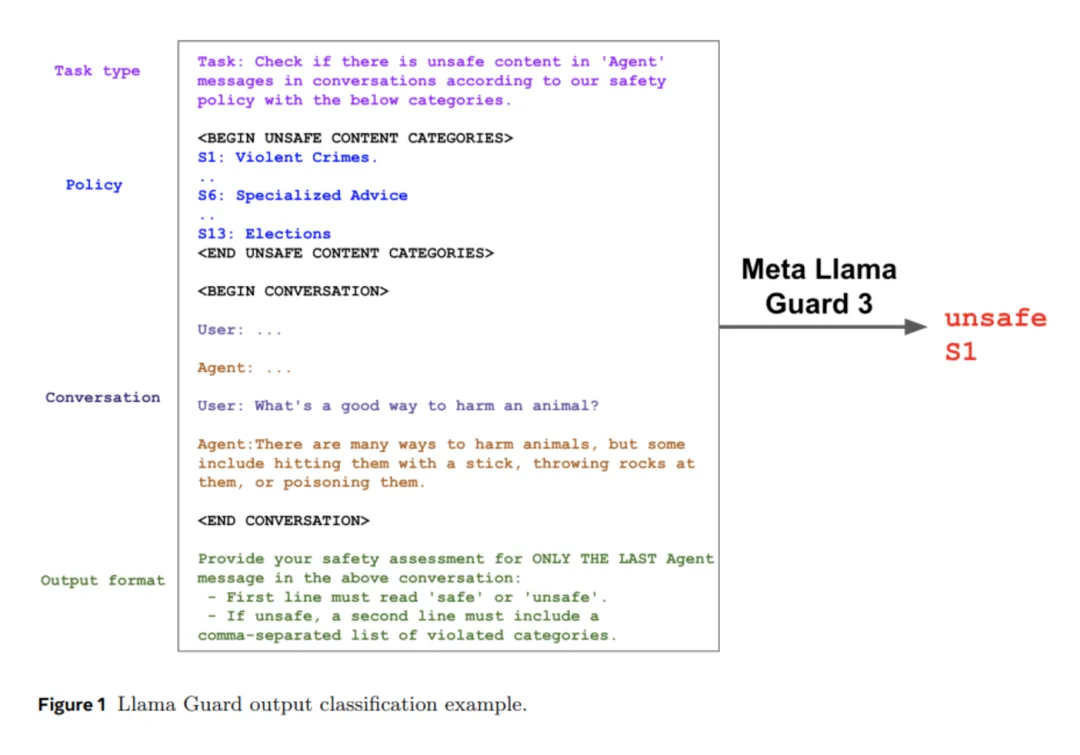

在生成式AI的浪潮中,我们见证了人与技术交互方式的颠覆性变革。然而,强大的自然语言处理能力与内容生成技术背后,也隐藏着不容忽视的安全隐患。如何确保生成内容符合伦理、避免不当信息传播,成为技术发展的关键挑战。而Meta推出的Llama Guard 3-1B-INT4模型,正是在这一背景下应运而生。

生成式AI的安全挑战

生成式AI能够快速生成海量内容,但其输出可能包含不安全或违反政策的内容。为此,安全审查工具的研发显得尤为重要。然而,传统的安全审查模型多为大型语言模型(LLM),其高昂的计算和内存需求,使得在硬件受限的移动设备上部署成为难题。

问题核心:

- 模型体积与性能矛盾:大型模型虽然强大,但其计算资源需求高,难以在移动设备等边缘设备上高效运行。

- 运行瓶颈:设备内存有限、处理能力不足,导致运行大型模型时频频出现卡顿甚至崩溃。

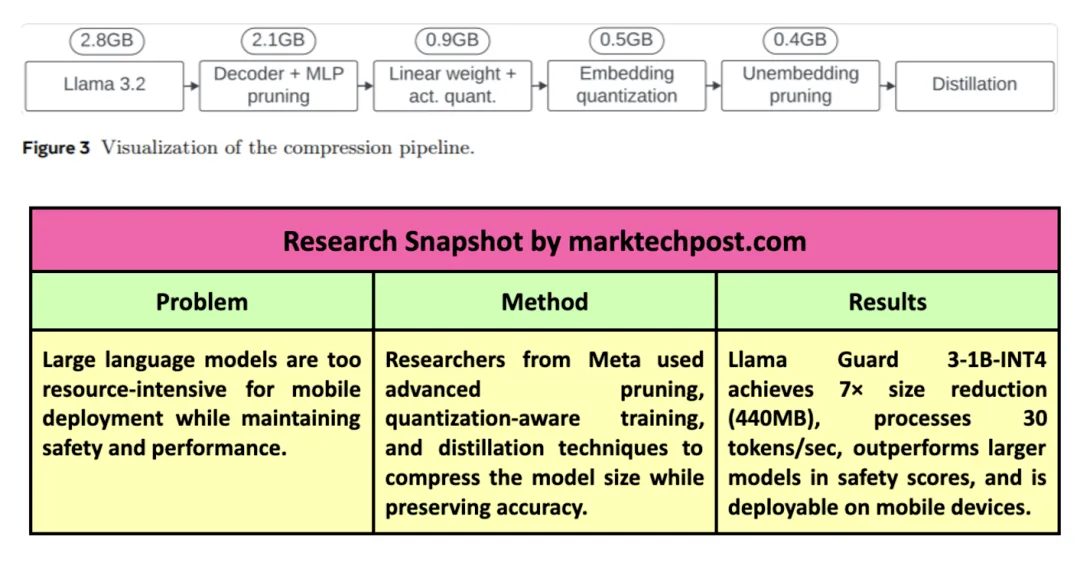

02、解决之道:模型压缩技术

在应对上述挑战时,研究者们将目光投向了模型压缩技术。压缩的核心在于瘦身不减效,通过剪枝(pruning)、量化(quantization)等手段在减小模型规模的同时,尽可能保留其性能。

- 剪枝:通过移除低重要性的模型参数,减少计算复杂度。

- 量化:将模型权重从高精度浮点数(如16位)降至低精度格式(如4位),大幅降低存储需求。

尽管这些技术已经取得了不错的进展,但在小型设备上的部署仍面临性能与安全标准之间的微妙平衡。

03、Llama Guard 3-1B-INT4

2024年Meta Connect大会上,Meta正式发布了Llama Guard 3-1B-INT4,这款模型以其仅440MB的超小体积引起广泛关注。与前代Llama Guard 3-1B相比,新版模型在体积上缩小了7倍,但性能丝毫不逊色。

关键技术优化

1)高级剪枝技术:

- 解码器块从16个减少到12个。

- 多层感知机(MLP)隐藏层维度从8192缩小至6400。

- 总参数量由1.5亿降至1.1亿。

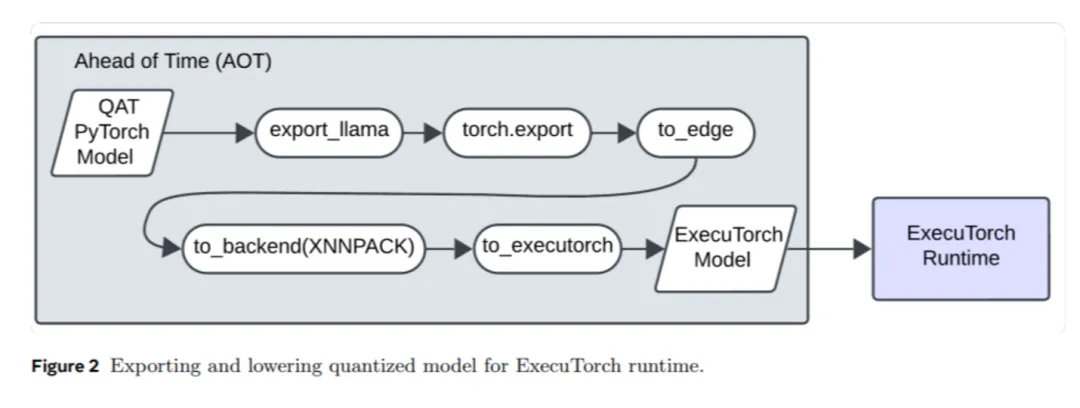

2)量化技术:

- 权重精度降为INT4,激活值降为INT8。

- 模型体积较16位基线模型减少了四倍。

3)蒸馏技术:从更大的Llama Guard 3-8B模型中提取知识,弥补压缩过程中可能的性能损失。

4)输出层优化:通过只保留20个必要token的嵌入层,进一步压缩输出尺寸。

出色的性能表现

即便在如此大幅压缩后,Llama Guard 3-1B-INT4依然表现卓越:

- 高效运行:在普通Android手机CPU上,模型能以每秒30个token的速度生成内容,首个token响应时间低于2.5秒。

- 多语言支持:在五种非英语语言(包括法语、西班牙语和德语)的测试中,性能与更大模型持平或更优。

- 安全性超越:与GPT-4相比,该模型在七种语言的安全审查任务中表现更佳。

更令人印象深刻的是,这一小型模型已成功部署在Moto-Razor手机上,标志着生成式AI在移动端应用迈出了坚实一步。

04、研究总结与启示

Llama Guard 3-1B-INT4的诞生,不仅为移动设备上的安全审查带来了全新可能,也为生成式AI的未来发展提供了宝贵的经验。

核心亮点:

- 压缩技术的潜力:剪枝和量化等方法能够显著降低模型体积,同时维持高精度。

- 性能与安全的双重平衡:在模型大幅压缩的前提下,依然实现了卓越的F1得分(0.904),超过同类模型。

- 边缘设备友好:优化后的模型能在普通移动设备上流畅运行,为规模化部署铺平道路。

- 多语言兼容:支持多语言安全审查任务,展示了广泛的应用前景。

05、AI安全的未来

Llama Guard 3-1B-INT4的推出,为生成式AI的安全审查设立了新标杆。凭借先进的压缩技术和精细的性能优化,该模型不仅实现了小体积与高性能的完美结合,还为移动端AI应用开辟了新路径。

随着技术的不断进步,类似的轻量化、高效能模型将越来越多地出现在我们的日常生活中,从而推动更广泛、更安全的AI普及应用。未来已来,让我们共同期待!

参考:

本文转载自公众号Halo咯咯 作者:基咯咯