关于大模型的幻觉问题,大模型有可能做到百分之百的准确率吗? 原创

“ 大模型的幻觉是一把双刃剑,并不是非黑即白 ”

大模型技术经过这几年的发展,已经可以算是小有成就;虽然大模型已经开始融入到部分企业应用场景中,但不得不说在应用中大模型还存在很多问题;特别是在一些要求比较严格的应用场景中,甚至都不太敢使用大模型;比如说医疗,自动驾驶等领域。

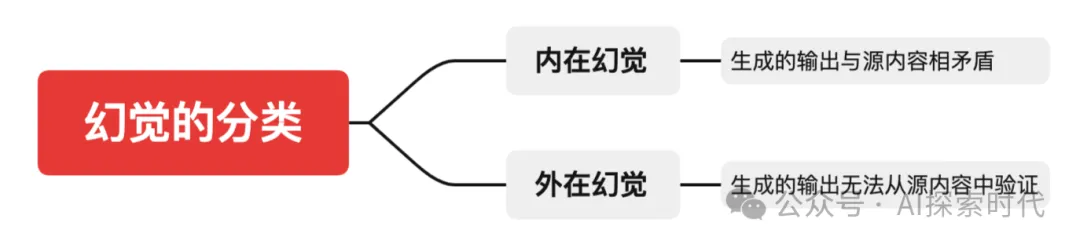

原因就在于大模型的不确定性,毕竟大模型的幻觉问题一直没有被解决;所以这就带来一个问题,大模型能彻底解决幻觉问题吗?也就是说大模型能做到百分之百的准确率吗?以及需要彻底解决大模型的幻觉问题吗?大模型的幻觉是否真的就是一种错误。

大模型的幻觉问题

目前来看大模型的幻觉问题来自于其自身原因,由于大模型的底层构造是建立在概率和统计的基础之上(虽然也不完全是概率);但由此带来的大模型幻觉问题,一直被很多人所诟病。

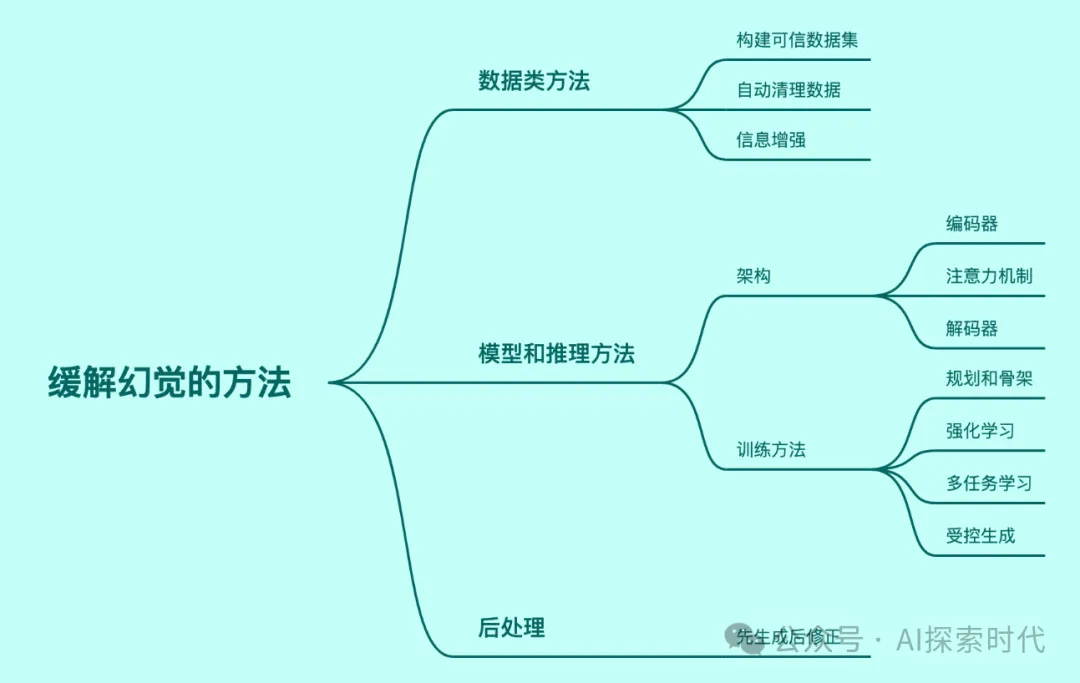

而且虽然大模型的幻觉问题目前还没有办法解决,但业内也在不断想办法来降低大模型的幻觉问题,减少幻觉发生的概率。

在很多应用场景中,采用微调和RAG技术大大降低了大模型幻觉发生的概率;而且即使有部分幻觉问题也是可以被忍受的,比如在智能客服领域,虽然有时候大模型会胡说八道,但这并不会对主要业务产生影响;而且也不会产生严重后果。

所以,从这个角度来说大模型的幻觉问题并没有大家想象中的那么严重;但在某些领域,大模型的幻觉问题就是不可接受的。

比如说医疗,精密制造和自动驾驶等领域;在这些领域,任何微小的失误都有可能带来巨大的风险与后果。因此,基于这种应用场景,就有人在思考怎么让大模型拥有百分之百的准确率?

但从目前的实践来看,单纯从技术的角度还无法彻底解决大模型的幻觉问题;唯一的办法就是用人力去兜底,也就是说大模型产生的内容在有歧义的情况下由人类来做最终的决定;或者就是说大模型幻觉问题不会带来严重后果的情况下,即使出点问题也不用管。

但不知道大家有没有想过这样一个问题,那就是为什么一定要解决大模型的幻觉问题,大模型幻觉的存在一定是错误的吗?

记得在前几天刷视频的时候看到了360老板周鸿祎的一个视频,他说大模型的创造能力正是来自于大模型的幻觉;如果大模型的幻觉问题被彻底解决,那么大模型就真正成为了一个无比精密的仪器,虽然它不会犯任何错误;但同样它也不会有任何创新。

就像人类自身一样,很多伟大的发明都是因为失误才成功的;人类技术的进步就是一个不断的实验——失败——再实验——再失败的过程。所以说,犯错也是一种创造力,没有了错误成功也将不复存在。

因此,从这个角度来看大模型的幻觉问题既应该被解决,又不应该被解决;更确切的说在某些领域应该想方设法来降低大模型的幻觉问题;而有些领域,应该想方设法来挖掘大模型幻觉的潜力。

所以,关于大模型的幻觉问题,最好的方式不是彻底解决它;也不是彻底放飞自我;而是要控制它,要让大模型的幻觉在可控范围之内;需要它幻觉的时候就幻觉,不需要它幻觉的时候就不要乱幻觉。

本文转载自公众号AI探索时代 作者:DFires

原文链接:https://mp.weixin.qq.com/s/tXzldeoFcOTkoeucFwEP1Q