革命性AI学习方法OptiDEL:用5%的数据超越全数据集性能!

引言:探索数据有效学习的新视角

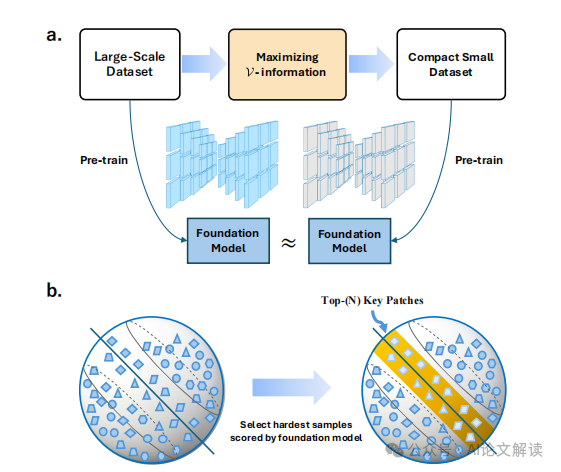

在人工智能领域,预训练大型基础模型已成为提升模型性能和泛化能力的标准做法。然而,随着研究的深入,传统观念受到质疑:更多的预训练数据是否总能带来更好的模型性能?为了探索这一问题,研究者们提出了数据有效学习(data-effective learning)的概念,旨在通过优化样本选择来提高模型性能,即使在样本数量较少的情况下也能取得出色的效果。

本文将重点介绍一种新的数据有效学习方法——最优化数据有效学习(OptiDEL),该方法通过最大化V信息(V-information)来指导样本选择,将样本选择问题转化为一个优化问题。OptiDEL方法通过生成难度较大的样本,即使使用远少于全数据集的预训练数据,也能达到甚至超过全数据集训练模型的性能。我们将详细探讨这种方法的理论基础、算法设计以及在不同数据集上的实验结果,以展示其在数据有效学习领域的优越性和实用性。

论文标题、机构、论文链接

论文标题:Maximizing V-information for Pre-training Superior Foundation Models

机构:Shanghai Key Laboratory of Intelligent Information Processing, School of Computer Science, Fudan University

论文链接:https://arxiv.org/pdf/2408.07107.pdf

V信息理论的介绍与应用

1. V信息理论的概念

V信息理论是一种基于信息论的框架,它专注于数据样本选择的优化问题。在这个理论中,样本选择被视为一个最大化条件熵的优化问题。V信息理论特别强调选择难样本(hard samples)的重要性,这些样本即使数量较少,也能够匹配甚至超越全数据集训练模型的性能。这一理论的核心在于,通过选择具有更高难度和更多样化信息的预训练样本,来逼近理想条件下基础模型的最优性能。

2. V信息理论的应用

在数据有效学习(data-effective learning)任务中,V信息理论的应用表明,通过最大化V信息,可以将样本选择转化为一个优化问题。这种方法不仅能够有效提升模型性能,而且还能在使用更少的样本的情况下实现这一目标。例如,在医学领域的数据有效学习基准研究中,通过最大化V信息来提高数据有效学习性能的重要性得到了验证。实验结果显示,即使只使用5%的预训练数据,基于V信息理论优化后的模型也能超越使用全数据集训练的模型。

OptiDEL方法的详细解析

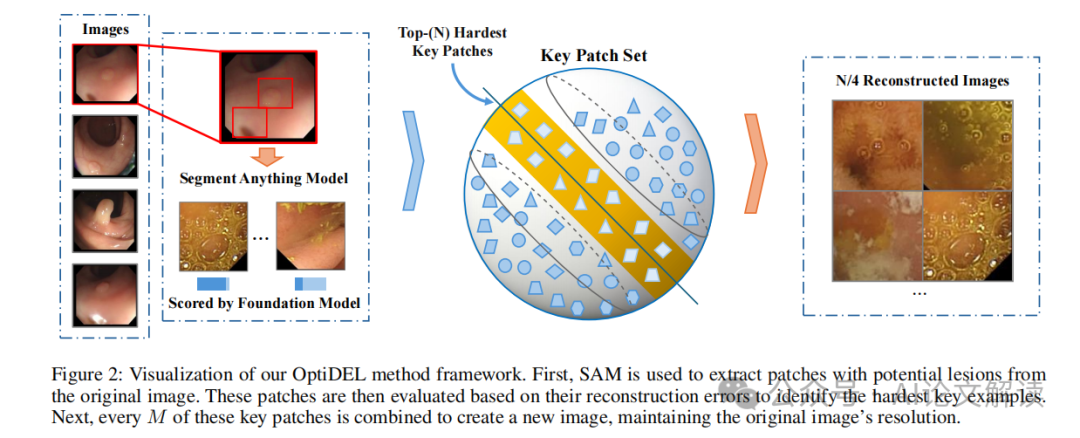

1. OptiDEL方法的概述

OptiDEL(optimal data-effective learning)方法是一种基于V信息理论的数据有效学习方法。该方法通过生成更难的预训练样本,并利用分割任何模型(SAM)提取关键信息,从而增强基础模型的性能。OptiDEL方法的关键概念是创建具有更大难度和更多样化信息的预训练样本,以逼近理想条件下基础模型的最优性能。

2. OptiDEL方法的操作步骤

OptiDEL算法的操作步骤如下:

- 使用SAM模型从原始数据中提取潜在病变的图像块(patches)。

- 根据这些图像块的重建误差来评估它们的难度,从而识别关键的难样本。

- 选择具有最大边际(margin)的图像块作为难样本,这些样本在预训练的观察模型中重建误差较大。

- 将选定的难样本合成为更大的图像,以保持原始图像的分辨率。

3. OptiDEL方法的实验验证

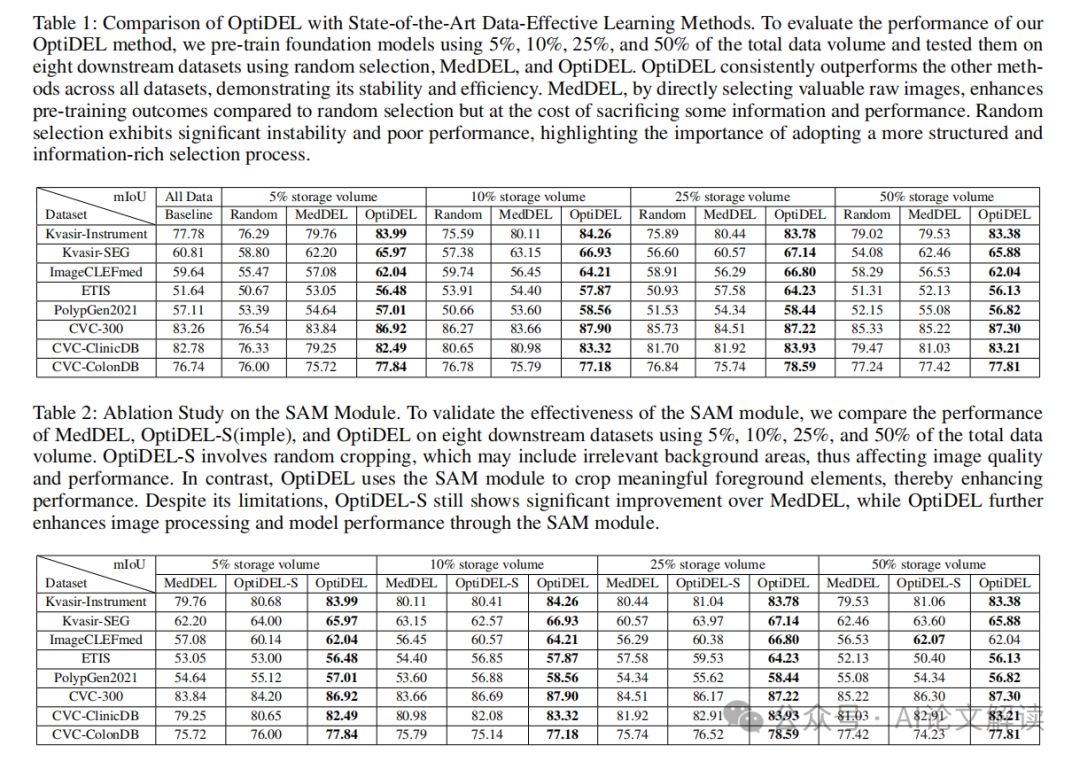

在实验部分,OptiDEL方法在八个下游数据集上的性能得到了验证。通过与现有的最先进方法(如MedDEL)进行比较,OptiDEL方法在所有数据集上均表现出色,证明了其稳定性和效率。此外,与随机选择方法相比,OptiDEL方法不仅提供了更丰富、更详细的数据集,而且还展示了更加可靠的性能模式,这强调了采用更加结构化和信息丰富的样本选择过程的重要性。

综上所述,OptiDEL方法通过最大化条件V信息熵,将数据有效学习任务转化为优化问题,并通过策略性样本选择来提升性能。这一方法不仅解释了基础模型训练中的非线性现象,还为设计更高效的数据有效学习方法提供了洞见,推动了该领域的发展。

实验设置与数据集介绍

1. 数据集

在本研究中,我们使用了两个大型未标记数据集进行预训练:LDPolypVideo和HyperKvasir,它们共包含2,857,772张图像。这些数据集的多样性和规模为模型提供了学习强大特征的机会。为了验证下游任务的效果,我们使用了DataDEL中概述的八个分割数据集,这些数据集涵盖了各种分割挑战。

2. 模型架构

对于下游任务,我们使用密集预测变换器(Dense Prediction Transformer,DPT)来验证我们方法的有效性。DPT是一种专为密集预测任务设计的网络,能够有效处理各种图像分割问题。

实验结果与分析

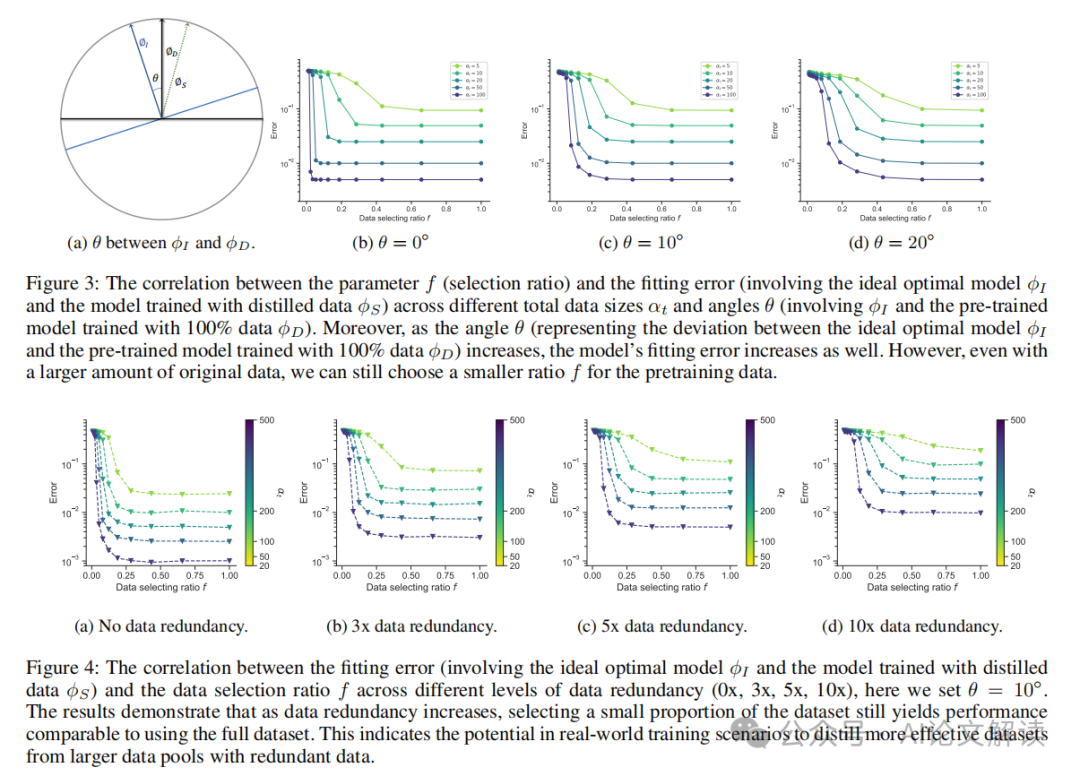

1. 预训练数据量与模型性能的关系分析

我们通过使用玩具数据修剪示例进行数值计算,探讨了拟合误差e与选择比例f在有限数据条件下的变化关系,以确定预训练数据的最佳比例。此外,我们还研究了拟合模型ϕD与理想模型ϕI之间的角度θ增加时,上述趋势的变化。结果表明,随着θ的增加,模型需要更多的数据来进行拟合。这意味着预训练一个更优秀的基础模型可以显著提高在实际任务中的蒸馏方法的有效性。

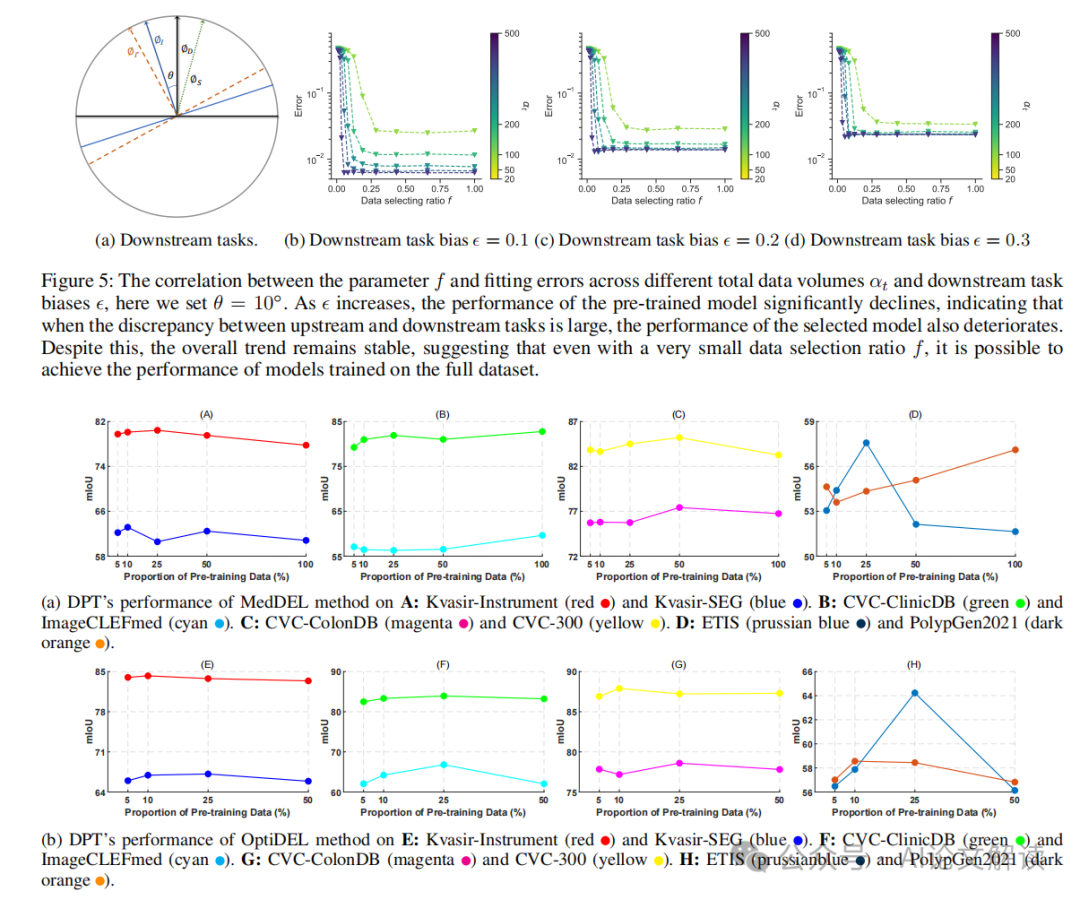

2. 选择困难样本的性能

我们进一步探索了选择困难样本在使用较少数据时能否达到与在大数据集上训练的基础模型相当的性能的健壮性。我们保持数据总量不变,通过在图4b、图4c和图4d中复制数据集3倍、5倍和10倍,然后在玩具示例中进行数值计算。结果显示,随着数据冗余的增加,基础模型的性能提升速度随着预训练数据量的增加而减慢。然而,即使在大量原始数据的情况下,通过选择较小比例的数据集,仍然可以实现更高的性能。这表明在实际的大数据集训练任务中,选择较小比例的数据进行训练仍然是可行的。

3. 与SOTA DEL方法的比较

为了进一步量化我们提出的OptiDEL方法的性能,我们使用5%、10%、25%和50%的总数据量预训练基础模型,并在八个下游数据集上测试随机选择、MedDEL和OptiDEL的性能。结果显示,OptiDEL方法在所有下游数据集上一致优于其他方法,突出了OptiDEL方法的稳定性和有效性。与随机选择方法相比,MedDEL通过直接选择有价值的原始图像确实提高了基础模型的预训练效果,但牺牲了一些信息和性能。相比之下,OptiDEL利用合成数据,为预训练过程提供了更丰富、更详细的数据集。

总结

本研究通过最大化V-信息,将数据高效学习任务转化为一个优化问题,并提出了OptiDEL方法,该方法通过生成难样本来提升模型性能。我们的实验结果表明,即使在使用远少于全数据集的情况下,OptiDEL方法也能够实现甚至超越全数据集训练模型的性能。此外,我们的方法在不同数据集上的一致性表现,进一步证明了其稳定性和效率。

我们的研究不仅解释了基础模型训练中的非线性现象,而且为设计更高效的数据高效学习方法提供了洞见,推动了该领域的发展。未来的研究将继续探索在不同领域和任务中应用和优化我们的方法,以实现更广泛的实际应用和技术进步。