艾伦人工智能研究所 (AI2) 发布 OLMo 2:在多达 5T 代币上训练的新系列开源 7B 和 13B 语言模型 原创 精华

01、概述

在人工智能的世界里,语言模型的发展无疑是最令人瞩目的领域之一。这些模型不仅在机器翻译、内容生成和对话式AI应用中扮演着关键角色,而且它们的发展速度和影响力正以前所未有的速度增长。今天,我们就来聊聊这个领域最新的突破——OLMo 2,一个由艾伦人工智能研究所(Allen Institute for AI)推出的开源语言模型家族,它们正在重新定义开源AI的边界。

02、语言模型的挑战与开源的重要性

语言模型的发展一直面临着一个难题:专有模型的主导地位。这些模型通常因为拥有丰富的资源和优化的训练流程而表现优于开源系统。它们利用庞大的数据集、计算能力和先进的专有方法,形成了一个性能差距,这个差距限制了AI技术的普及和创新,因为只有资金雄厚的组织才能负担得起开发这类尖端技术。

然而,开源社区的努力不容忽视。尽管目前的开源方法在可扩展性、训练稳定性和模型性能方面仍需改进,但最近的进展表明,我们正在迎来一个全新的、性能上能与专有模型竞争的开源模型时代。

03、OLMo 2

艾伦人工智能研究所的研究团队推出了OLMo 2,这是一个具有里程碑意义的开源语言模型家族。这些模型提供了7亿(7B)和13亿(13B)参数配置,训练时使用了高达5万亿个token,采用了最先进的技术。通过改进训练稳定性、采用分阶段训练流程和整合多样化的数据集,研究人员缩小了与专有系统(如Llama 3.1)的性能差距。OLMo 2在层归一化、旋转位置嵌入和Z-loss正则化等方面进行了改进,增强了模型的鲁棒性。

训练过程:分阶段的创新

OLMo 2的训练采用了分两个阶段的课程方法。在第一阶段,占预训练预算的90%,模型在包含3.9万亿个token的OLMo-Mix-1124数据集上进行训练,这些token来自DCLM和Starcoder等高质量的数据仓库。第二阶段则涉及对Dolmino-Mix-1124数据集进行微调,这是一个精选的843亿个token的数据集,包含了基于网络和特定领域的内容。模型融合(model souping)等技术,通过合并检查点来优化性能,在实现7B和13B模型的最终版本中发挥了关键作用。

04、性能评估:OLMo 2的新基准

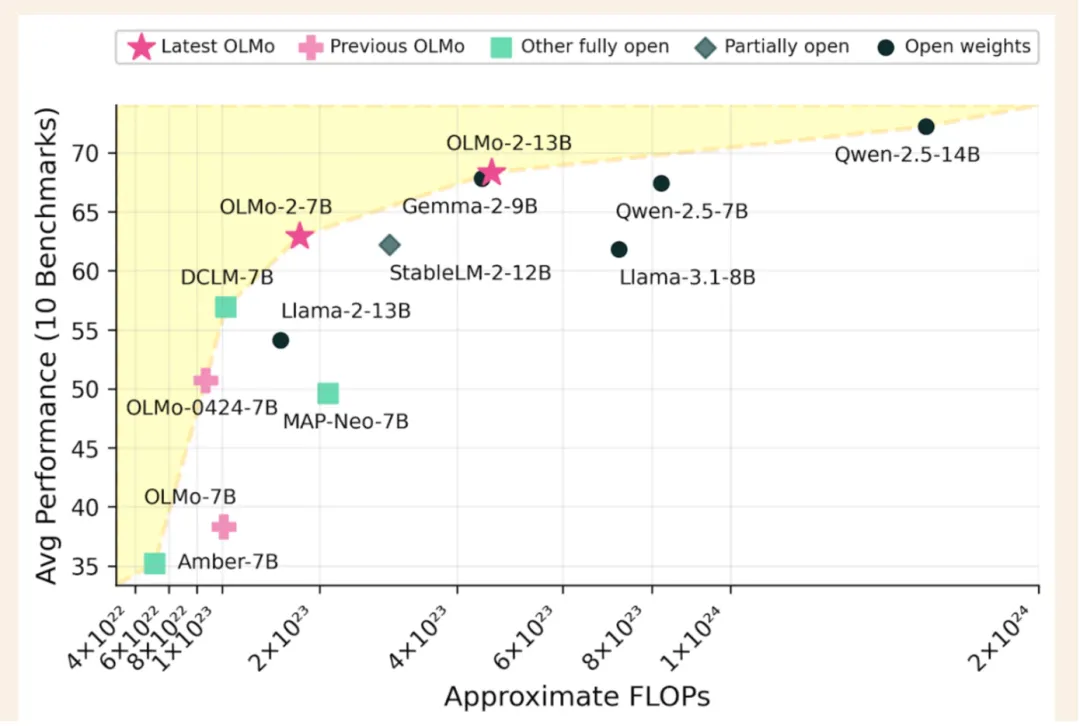

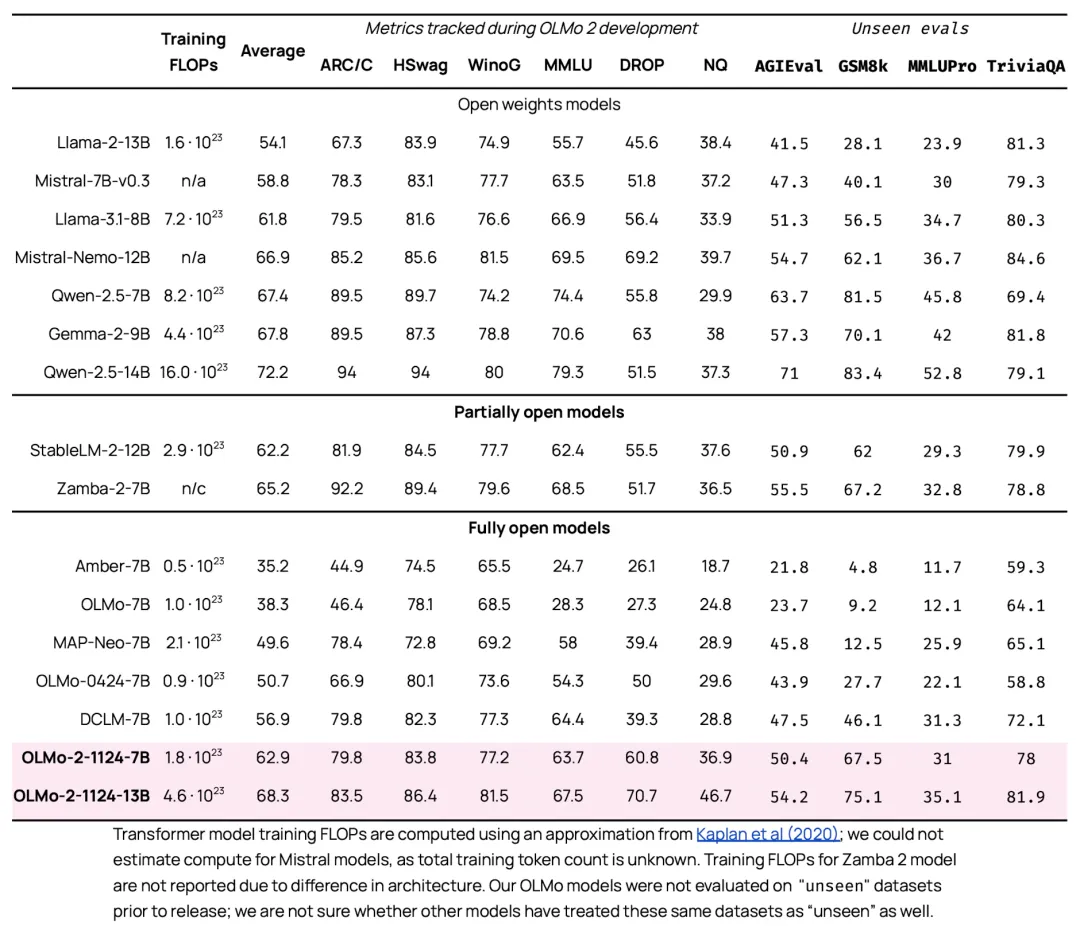

OLMo 2的性能在开源语言模型领域树立了新的基准。与其前身OLMo-0424相比,OLMo 2在所有评估任务中都显示出显著的提升。值得注意的是,OLMo 2 7B的性能超过了Llama-3.1 8B,而OLMo 2 13B则超越了Qwen 2.5 7B,尽管它们的训练FLOPs更少。使用Open Language Modeling Evaluation System(OLMES)进行的评估,这是一个包含20个基准的套件,证实了这些增益,并突出了在知识回忆、推理和通用语言能力方面的优势。

05、研究的关键收获

研究的关键收获包括以下几点:

- 训练稳定性的改进:RMSNorm和学习率退火等技术减少了预训练期间的损失峰值,确保了模型性能的一致性。

- 创新的分阶段训练:后期预训练干预,包括数据课程调整,允许针对性地增强模型能力。

- 可操作的评估框架:OLMES的引入为模型开发提供了结构化的基准,并有效地跟踪进展。

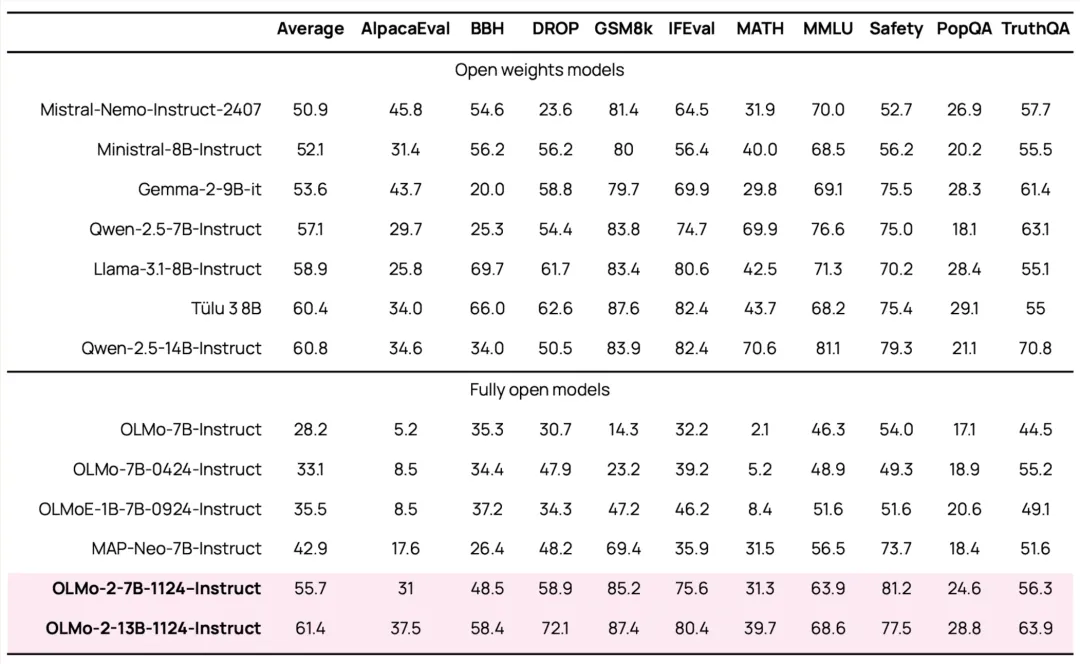

- 后训练方法:监督微调、偏好调整和可验证奖励的强化学习增强了模型遵循指令的能力。

- 数据集的多样性和质量:在Dolmino-Mix-1124等数据集上进行预训练,确保了模型能够跨多个领域泛化。

06、结语

总之,OLMo 2的成就标志着语言模型领域的转变。通过解决训练稳定性和评估透明度等挑战,研究人员为开源AI树立了新的标准。这些模型不仅缩小了与专有系统的差距,还展示了协作创新在推进人工智能方面的潜力。OLMo 2的倡议强调了开放获取高性能AI模型的变革力量,为更公平的技术进步铺平了道路。

在这个快速发展的领域,OLMo 2的出现无疑是一个振奋人心的消息。它不仅为研究人员和开发者提供了强大的工具,也为那些渴望在AI领域取得突破的创新者提供了新的可能性。随着开源AI的不断进步,我们有理由相信,未来将有更多的突破等待着我们去发现和实现。

参考:

- https://huggingface.co/collections/allenai/olmo-2-674117b93ab84e98afc72edc

- https://allenai.org/blog/olmo2

本文转载自公众号Halo咯咯 作者:基咯咯