GPT-4 Turbo更新:视觉能力+无限制使用

在最近的技术更新中,OpenAI引入了GPT-4 Turbo版本,带来了一系列引人注目的变化和提升。这次更新不仅增强了GPT-4的能力,还对其使用限制进行了调整,这些变化可能对开发者和用户产生深远影响。下面就让我来带大家看看今天ChatGPT都发生了什么吧~

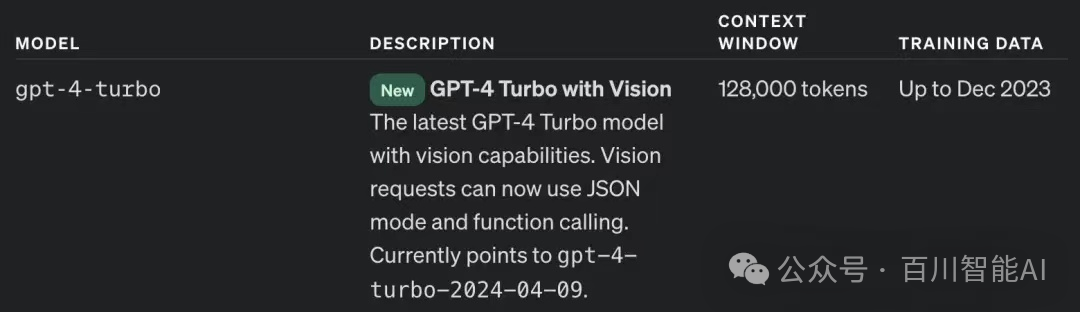

首先,GPT-4 Turbo的引入为OpenAI的技术堆栈增添了新的维度。这个新版本不仅具备了视觉功能,还扩大了上下文处理能力至128k,显著提升了模型的应用范围和效率。通过这项升级,开发者现在能够在更大的上下文中使用GPT,这对于复杂的交互和深度任务至关重要。

此外,新模型在视觉处理方面的能力也令人瞩目。开发者可以利用GPT-4 Turbo with Vision来执行诸如图像识别、图像到文本的转换等多种任务,为应用程序开发提供了新的可能性。例如,Healthifyme团队开发的应用Snap,就能够对美食图片进行分析,提供营养信息,展示了视觉功能在实际应用中的潜力。

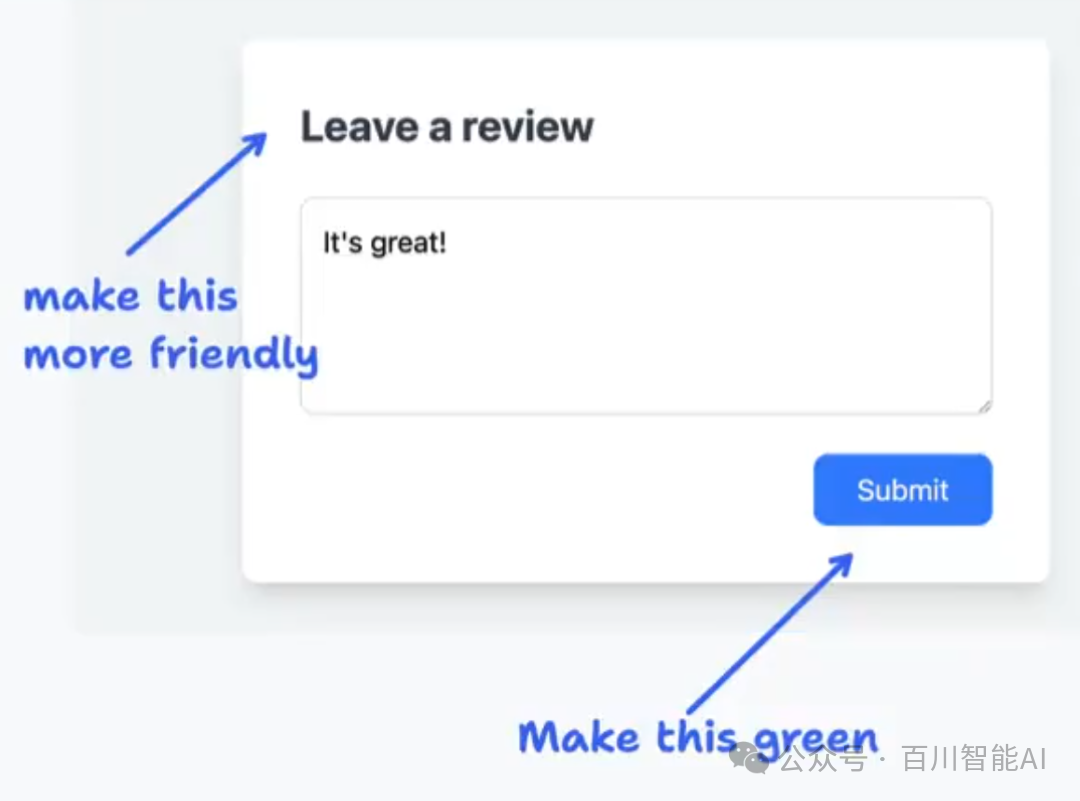

由tldraw开发的 Make Real 让用户可以在白板上绘制 UI,并使用带有 Vision 的 GPT-4 Turbo 直接生成代码设计网站。

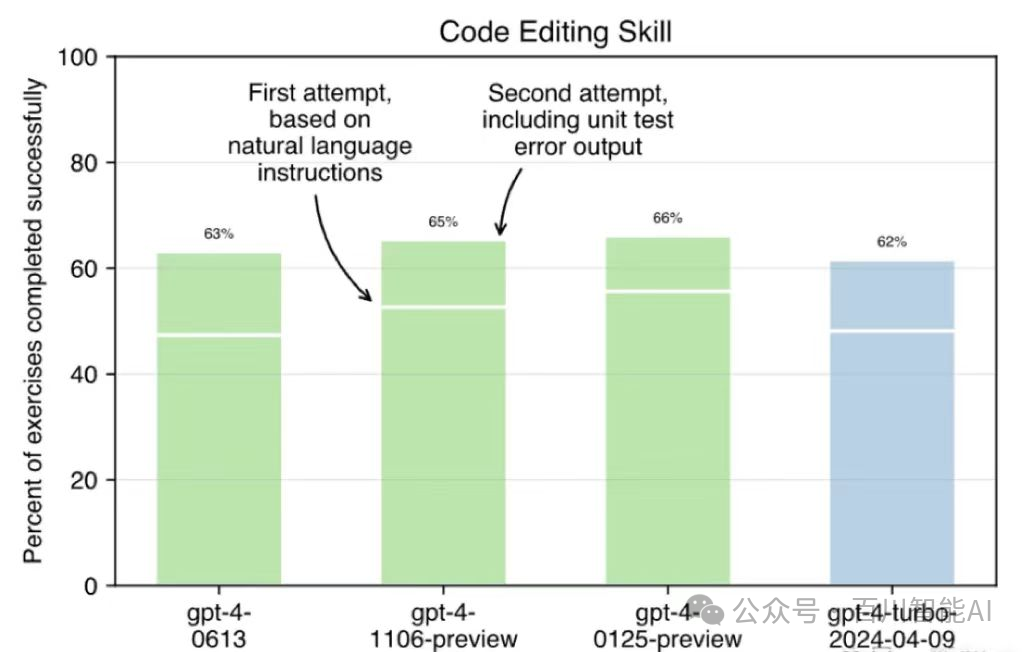

然而,新模型在代码编写能力方面似乎有所下降。根据AIDER的评估,GPT-4 Turbo with Vision在代码编辑基准测试中的得分相对较低,显示出在某些编程任务上可能不如预期那样高效。这对于那些依赖GPT进行代码生成和编辑的开发者来说,可能是一个需要注意的问题。

值得一提的是,GPT-4的使用限制也经历了调整。OpenAI取消了每3小时40条消息的限制,转而采用根据系统负载动态调整的方法。这种调整旨在为用户提供更灵活的使用体验,特别是在高需求时段。尽管这意味着在某些情况下用户可能会遇到限制,但它也使得资源分配更加高效,有助于优化用户体验。

综上所述,GPT-4 Turbo的更新带来了多方面的改进和新的挑战。视觉功能的加入开辟了新的应用领域,而上下文处理能力的提升则加强了模型的复杂交互能力。同时,用户需要适应新的使用限制模式,这可能会影响到某些高频使用场景。总体而言,这次更新是OpenAI在持续推动AI技术发展和应用的一部分,值得业界密切关注和深入探讨。