明白了!机器学习四大范式:监督学习、无监督学习、半监督学习和自监督学习

1、监督学习

今天我们来聊聊机器学习中的那些“监督”的事儿。你知道吗?在机器学习的江湖里,有那么几种学习方式,它们各自有着不同的门派和绝学。咱们今天就先从“监督学习”开始说起。

1.1 来源与定义

监督学习,这个名字听起来是不是有点像咱们上学时老师手把手教我们做题的感觉?其实,它的原理还真有点儿类似。在机器学习中,监督学习是一种需要“老师”(也就是我们人类)提供标准答案来训练模型的方法。这种学习方式最早可以追溯到20世纪50年代,随着计算机科学的发展,它逐渐成为机器学习的一个重要分支。

简单来说,监督学习就是通过已知的输入和输出数据来训练模型,让模型学会如何根据新的输入数据预测输出结果。这里的“监督”就是指我们给模型提供的那些带标签的训练数据。

1.2 优势

那咱们为啥要用监督学习呢?首先,它的优势在于能够提供精确的训练数据,这意味着我们可以得到非常准确的结果。就像老师告诉我们每个数学题的答案一样,模型也能通过这些“答案”学会如何解决类似问题。

另一个优势是,监督学习相对其他学习方式,所需要的数据量较小,更加高效。因为模型知道正确的答案,所以它不需要像无监督学习那样去大海捞针般地找规律。

1.3 劣势

但是,监督学习也有它的短板。首先,它需要大量的标签数据,而标注数据通常需要专业人员,耗费时间和人力成本较高。这就好比我们学习时,如果每道题都需要老师给出详细解答,那老师得多累啊。

其次,监督学习对数据的要求高,错误的数据会导致模型学习不准确而获取错误的结果。这就像老师如果教错了,学生也就跟着学错了。

1.4 用途

那么,监督学习都能用在哪儿呢?它的应用范围非常广泛,可以应用于图像识别、语音识别、自然语言处理等多个领域。比如,我们用监督学习来训练一个识别照片中是不是有猫的模型,就需要先给它一大堆标记好的“有猫”和“没猫”的照片。

1.5 经典算法

- 线性回归:用于连续数值预测的问题,如房价预测。

- 逻辑回归:用于二分类问题,如垃圾邮件检测。

- 决策树:用于分类和回归问题,通过学习决策规则进行预测。

- 支持向量机(SVM):适用于高维空间的分类问题,通过寻找最优超平面进行分类。

- 随机森林:集成多个决策树,提高模型的稳定性和准确性。

- 神经网络:通过模拟人脑神经元网络处理复杂非线性问题。

2、无监督学习

上面我们聊了监督学习,接下来咱们来聊聊无监督学习,这个在机器学习江湖中同样重要的门派。

2.1 来源与定义

无监督学习,这个名字听起来是不是有点像自学成才的感觉?其实,它的原理还真有点儿类似。在机器学习中,无监督学习是一种不需要“老师”提供标准答案来训练模型的方法。这种方法最早可以追溯到20世纪70年代,随着模式识别和人工智能的发展,它逐渐成为机器学习的一个重要分支。

简单来说,无监督学习就是通过未标记的数据来训练模型,让模型自己发现数据中的模式和结构。这里的“无监督”就是指我们没有给模型提供任何标签,全靠它自己去摸索。

2.2 优势

那咱们为啥要用无监督学习呢?首先,它的优势在于非常适合大型数据集。无监督学习可以从大量未标记的数据中发现模式、结构和特征,这对于大型数据集非常有用。

另一个优势是,无监督学习不需要标注数据,因此不会有因为提供错误标注数据而出现的问题,就减小了成本。这就好比我们学习时,如果不需要老师,自己也能通过阅读和实践来掌握知识,那得多省钱啊。

2.3 劣势

但是,无监督学习也有它的短板。首先,结果不够准确。由于数据没有标注,在预测时可能出现较大误差和缺陷,从而导致结果不够准确。这就像我们自学时,如果没有正确的指导,可能会走很多弯路。

其次,无监督学习对参数设置和算法选择较为灵敏,需要更多的技巧和经验,否则可能出现偏差。这就好比我们自学时,如果选错了学习方法,可能会事倍功半。

2.4 用途

那么,无监督学习都能用在哪儿呢?它的应用范围也很广泛,可以应用于聚类分析、异常检测、降维和数据压缩等多个领域。比如,我们用无监督学习来分析消费者的购物习惯,就可以将消费者分为不同的群体,从而进行更精准的营销。

2.5 经典算法

说到无监督学习,就不得不提几个经典算法了。比如K-means聚类算法,它通过将数据点分为K个簇,使得簇内的数据点尽可能相似,而簇间的数据点尽可能不同。还有主成分分析(PCA),它是一种常用的降维技术,通过提取数据中最重要的特征来减少数据的维度。这些算法都是无监督学习中的佼佼者,各有千秋,适用于不同的场景和问题。

3、半监督学习

下面来聊聊机器学习中的另一种学习方式——半监督学习。这可是个实用主义者,它结合了监督学习和无监督学习的优点,让我们一起来探个究竟。

3.1 来源与定义

半监督学习,这个名字听起来是不是有点像我们在学校里既听老师讲课,又自己摸索的感觉?其实,它的原理还真有点儿类似。在机器学习中,半监督学习是一种结合了少量有标签数据和大量无标签数据进行训练的方法。这种方法最早可以追溯到20世纪90年代,随着数据挖掘技术的发展,它逐渐成为机器学习的一个重要分支。

简单来说,半监督学习就是通过已知的少量输入和输出数据(有标签数据)以及未知的大量输入数据(无标签数据)来训练模型,让模型学会如何根据新的输入数据预测输出结果。这里的“半监督”就是指我们给模型提供了一部分标签,另一部分则需要模型自己去摸索。

3.2 优势

那咱们为啥要用半监督学习呢?首先,它的优势在于可以在有限的标签数据下,利用大量的无标签数据进行学习,从而提高模型的泛化能力。这就像我们在学习时,老师给了我们一些例题,然后我们通过大量的练习题来提高解题能力。

另一个优势是,在有些领域,收集标签数据非常困难或者昂贵,如医学图像分析、金融风险评估等。半监督学习可以在这些场景下提供有效的解决方案,减少对大量标签数据的依赖。

3.3 劣势

但是,半监督学习也有它的短板。首先,它需要大量的无标签数据,但是收集无标签数据的成本也很高。这就好比我们学习时,虽然不需要老师提供所有答案,但是自己去找大量的练习题也是需要时间和精力的。

其次,半监督学习的效果受到无标签数据的质量和数量的影响,如果无标签数据质量不高或者数量不足,可能会导致模型性能下降。这就像我们自学时,如果练习题的质量不高,可能会影响我们的学习效果。

3.4 用途

那么,半监督学习都能用在哪儿呢?它的应用范围也很广泛,可以应用于文本分类、图像识别、推荐系统等多个领域。比如,我们用半监督学习来提高垃圾邮件过滤的准确性,就可以利用少量的已标记邮件和大量的未标记邮件来训练模型。

3.5 经典算法

说到半监督学习,就不得不提几个经典算法了。比如自适应boosting(AdaBoost)算法,它通过结合多个弱分类器来提高分类性能。还有图半监督学习算法,它通过构建数据点之间的图结构,利用图上的连接关系来传播标签信息。这些算法都是半监督学习中的佼佼者,各有千秋,适用于不同的场景和问题。

- 自训练(Self-training):通过使用模型的初始预测结果来标记未标记的数据,自训练逐步扩展训练集,使用模型自信的预测结果作为新的训练数据进行迭代训练。

- 协同训练(Co-training):通过在两个或多个不同特征视图上训练独立的分类器,协同训练在每一轮中使用一个分类器的高置信度预测结果为另一个分类器提供标记数据,互相提升学习效果。

- 标签传播(Label Propagation):通过构建一个图,节点表示数据点,边的权重表示相似度,标签传播算法逐步在图中传播已标记点的标签信息到未标记点,直到达到收敛。

- 伪标签(Pseudo-Labeling):首先使用少量标记数据训练模型,然后用模型为未标记数据生成预测标签,这些伪标签随后被用来进一步训练模型。

4、自监督学习

最后,来聊聊机器学习中的一个新兴门派——自监督学习。这可是个特立独行的家伙,它不需要外部的标签,全靠自己给自己出题和打分。让我们一起来探个究竟。

4.1 来源与定义

自监督学习,这个名字听起来是不是有点像我们自己给自己布置作业的感觉?其实,它的原理还真有点儿类似。在机器学习中,自监督学习是一种通过设计辅助任务,让模型从未标记的数据中学习有用特征的方法。这种方法最早可以追溯到21世纪初,随着深度学习技术的发展,它逐渐成为机器学习的一个重要分支。

简单来说,自监督学习就是通过模型自己生成的标签来训练自己,让模型学会如何根据输入数据预测输出结果。这里的“自监督”就是指我们不给模型提供任何外部标签,全靠模型自己去创造标签。

4.2 优势

那咱们为啥要用自监督学习呢?首先,它的优势在于能够利用大量未标记的数据。自监督学习可以从这些数据中提取有用的信息,这对于数据量巨大的场景非常有用。

另一个优势是,自监督学习减少了对人工标注的依赖,降低了成本。这就好比我们学习时,不需要老师,自己也能通过阅读和实践来掌握知识,那得多省钱啊。

4.3 劣势

但是,自监督学习也有它的短板。首先,它的效果受限于辅助任务的设计。如果辅助任务设计得不好,模型可能学不到有用的特征,导致性能下降。这就像我们自学时,如果选错了学习方法,可能会事倍功半。

其次,自监督学习的训练过程可能需要更多的计算资源。因为模型需要在大量的数据上进行训练,以确保能够捕捉到数据中的细微差别。

4.4 用途

那么,自监督学习都能用在哪儿呢?它的应用范围也很广泛,可以应用于自然语言处理、计算机视觉等多个领域。比如,我们用自监督学习来训练一个理解语言的模型,就可以让模型通过预测句子中缺失的单词来学习语言的内在结构。

4.5 经典算法

- BERT (Bidirectional Encoder Representations from Transformers):通过Masked Language Model(MLM)任务,BERT能够从上下文中预测被遮盖的词,从而学习到丰富的语言表示。

- SimCLR (Simple Contrastive Learning of Visual Representations):通过对比学习,SimCLR方法展示了自监督学习在图像分类任务上的有效性,能够在较少的标签数据上实现竞争性的性能。

- BYOL (Bootstrap Your Own Latent):BYOL算法通过对比学习框架,不需要负样本,而是通过优化一个动态的潜在空间来学习有效的视觉表示。

- MoCo (Momentum Contrast):MoCo算法通过维护一个动态的图像队列,并使用动量更新的编码器来增强自监督学习的特征表示。

- DINO (Distributed and Invariant Neural Networks):DINO算法通过自监督学习框架,利用知识蒸馏技术,使得模型能够在不同的数据分布上学习到鲁棒的特征表示。

5、总结

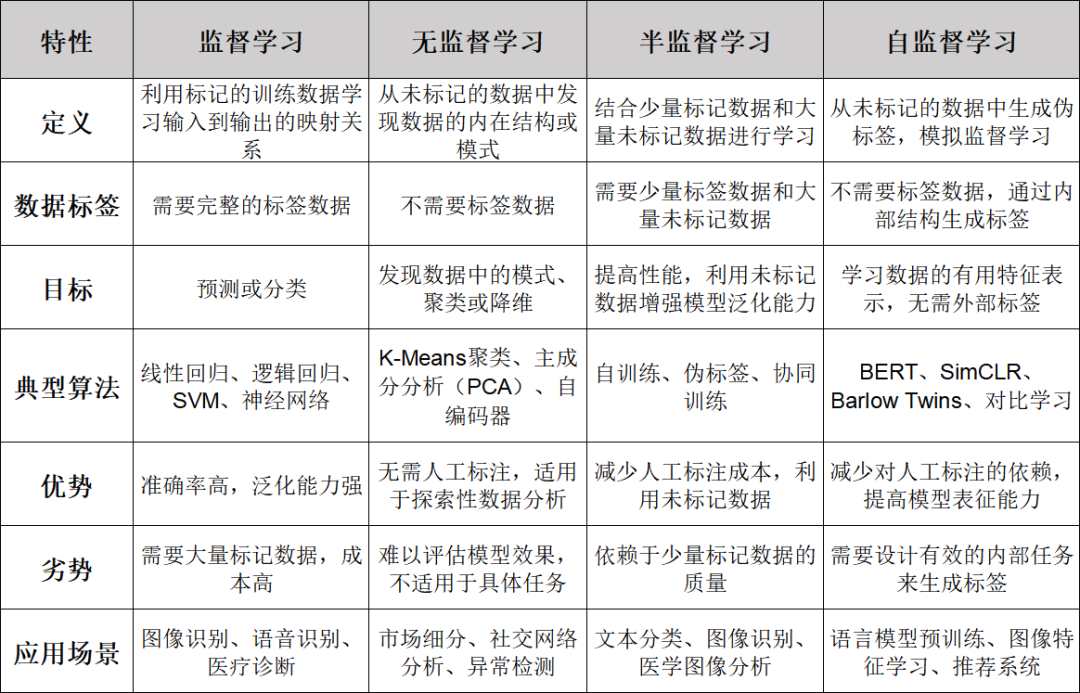

今天我们把监督学习、无监督学习、半监督学习和自监督学习这四种机器学习的方法都聊了一遍。每一种学习方法都有它们独特的来源、定义、优势、劣势和用途,当然还有那些经典的算法。下面,咱们就来总结一下。

首先,监督学习就像有个老师在旁边指导你,通过已知的答案来训练模型。它的优势在于结果准确,效率也高。但是,它的缺点是需要大量的标签数据,对数据的要求也高。在图像识别、语音识别等领域,监督学习大显身手。线性回归、逻辑回归和SVM都是它的经典算法。

接着是无监督学习,它更像是自学成才的过程。无监督学习的优势在于能够处理大型数据集,而且不需要标注数据。但是,结果的准确性可能不够高,对参数和算法的选择也比较敏感。在聚类分析、异常检测等领域,无监督学习发挥着重要作用。K-means和PCA就是其中的代表算法。

然后是半监督学习,它结合了监督学习和无监督学习的优点。半监督学习可以在有限的标签数据下,利用大量的无标签数据进行学习,提高模型的泛化能力。但是,它需要大量的无标签数据,而且效果受到无标签数据的质量和数量的影响。在文本分类、图像识别等领域,半监督学习有着广泛的应用。AdaBoost和图半监督学习算法是这个领域的经典。

最后是自监督学习,它通过自己给自己出题和打分来学习。自监督学习的优势在于能够利用大量未标记的数据,减少对人工标注的依赖。但是,它的效果受限于辅助任务的设计,而且训练过程可能需要更多的计算资源。在自然语言处理、计算机视觉等领域,自监督学习有着广泛的应用。BERT和SimCLR就是这个领域的明星算法。

总的来说,这四种学习方法各有千秋,适用于不同的场景和问题。选择合适的学习方法,就能在机器学习的江湖中游刃有余。希望今天的分享能让你们对这些学习方法有了更深的理解。

本文转载自智驻未来,作者: 小智