最新开源Auto-RAG:最低成本解决多跳问题

1.引言

1.1 RAG 的局限与迭代检索的提出

在知识密集型任务中,大语言模型(LLMs)的检索增强生成(RAG)虽应用广泛,能提升输出质量、减少幻觉,但仍存缺陷。比如,检索内容常含噪声,这会致使 RAG 系统性能下滑。复杂查询时,单次检索难以获取充足知识,进而阻碍 RAG 系统的广泛应用。

为攻克这些难题,迭代检索应运而生,其持续更新检索结果,以契合生成进程里动态变化的信息需求。可现有的迭代检索方法多依赖少样本提示或手动构建规则。这类方式需大量人力,推理时计算成本颇高。更为关键的是,它们忽视了 LLMs 强大的推理与决策能力,未能充分挖掘模型在判定检索时机与内容上的潜力,造成资源浪费。

1.2 Auto-RAG 的创新点与优势

鉴于现有方法的不足,我们设计了 Auto-RAG,这一以 LLMs 强大决策能力为核心的自主迭代检索模型。它借助多轮对话与检索器交互,精心规划检索流程、优化查询语句,直至采集到充足外部知识,最终为用户输出精准结果。

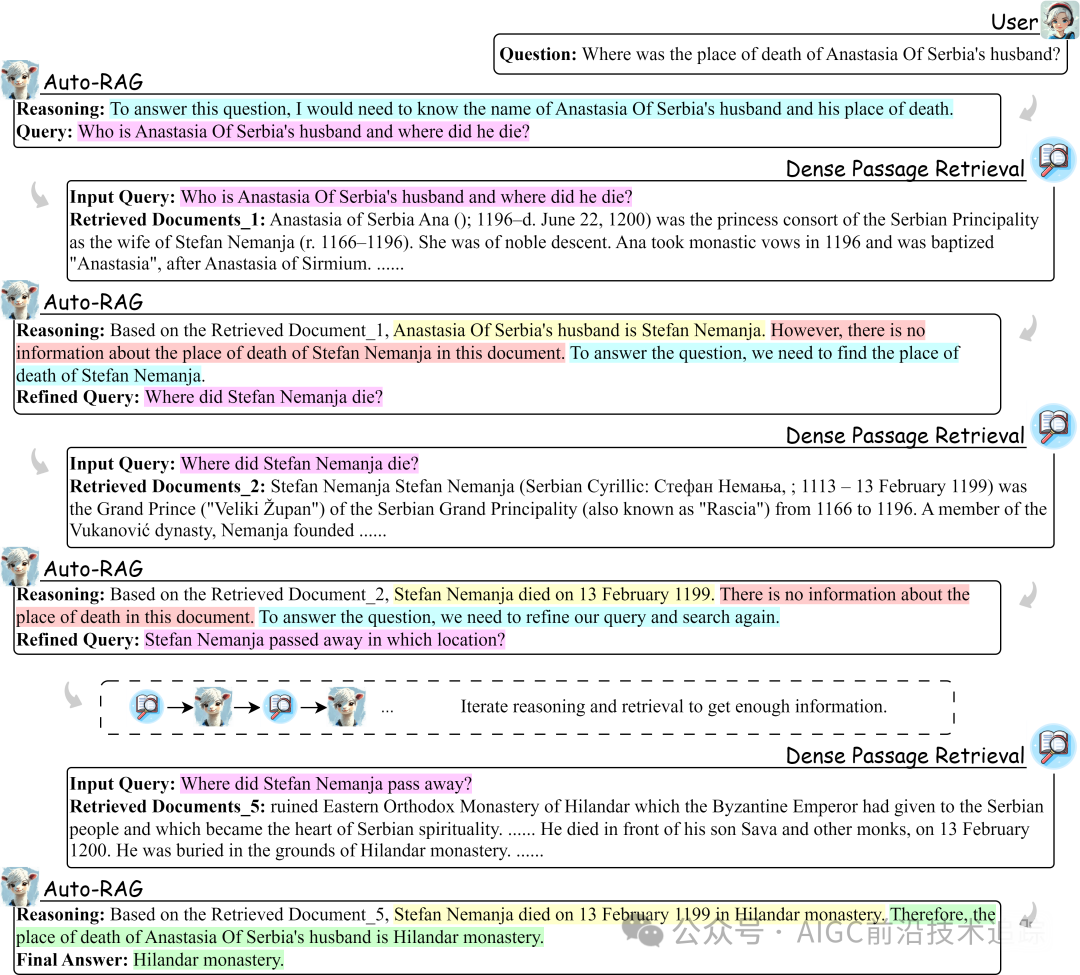

为赋予 LLMs 迭代检索中的自主决策本领,我们构建了自动合成基于推理的决策指令框架,并对最新开源 LLMs 进行微调。经在六个具代表性基准测试的验证,即便训练数据有限,Auto-RAG 也表现卓越。其能依问题难度与检索知识的效用,自动调整迭代次数,无需人工干预。而且,它以自然语言呈现迭代检索过程,提升可解释性,赋予用户更直观体验。例如在处理复杂多跳问题时,Auto-RAG 可通过迭代推理,从检索到的众多文档中精准提取关键知识,逐步逼近正确答案,过程清晰透明,结果准确可靠。

2.相关工作

2.1 检索增强生成(RAG)

RAG 的诞生,旨在应对模型参数中知识过时以及 LLMs 对长尾知识保留不佳的困境。常见的 RAG 方法遵循检索-读取框架,即将检索文档与用户输入拼接,为 LLMs 补充外部知识。然而,检索器并非完美无缺,检索内容的噪声问题,已被众多研究证实会损害 RAG 系统性能。

为此,学界展开多方面探索。在查询表述优化上,通过改进查询构建方式,提升检索精准度;检索器增强方面,采取优化检索器架构与算法,提高检索效率与质量;生成器改进方向,着力优化生成模型,增强其基于检索知识生成高质量文本的能力;检索文档后处理优化领域,通过对检索文档的筛选、整合与提炼,提升知识可用性。但随着任务复杂度攀升,单次检索获取足量知识愈发困难,这些方法仍未彻底解决问题。

2.2 迭代检索

迭代检索是为处理复杂问题求解时动态变化的知识需求而设,关键在于精准判定检索时机与内容。诸如 ITER-RETGEN 将输入问题与前次迭代生成的输出拼接成新查询,虽取得一定成果,但仅反映既有知识,未明确揭示 LLMs 的信息需求。以生成的下一句为查询,并依检索结果优化前一句,虽更精准定位信息需求,却高度依赖精心设计的少样本提示,需持续检索与优化,人力成本与推理成本居高不下。Self-RAG 训练 LLMs 反思检索与生成内容,但学习过程机械,未有效培育推理能力,限制了模型表现。

与上述方法相较,Auto-RAG 全面释放 LLMs 在迭代检索中的推理式自主决策潜能,凭借推理自主抉择检索时机与内容,性能更优、效率更高,为迭代检索开辟新路径。

3.方法

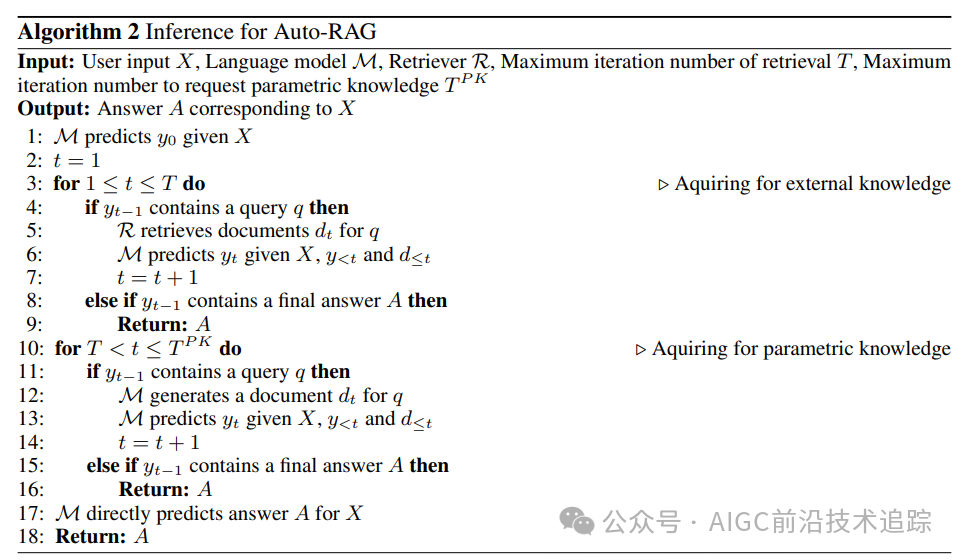

3.1 基于推理的迭代检索

我们将迭代检索视作 LLM 与检索器的多轮交互流程。用户查询触发交互,持续至获取充足知识形成最终答案。每次迭代中,Auto-RAG 依当前状态深度推理,判断是否需额外检索及确定所需信息,待知识完备则停止查询并作答。

3.1.1 基于推理的规划与查询优化

为优化迭代效率与连贯性,我们构建契合人类认知的推理范式,涵盖检索规划、信息提取、答案推断三个核心环节:

检索规划:接收用户问题时,LLM 需精准明确解答所需知识,检索文档后评估是否需进一步检索及明确后续检索方向。此规划全程至关重要,如同导航系统,可提升检索效率、规避迷失方向风险(Wang 等人,2024a)。例如在历史知识问答中,面对“文艺复兴对欧洲科技发展的影响”问题,LLM 应迅速梳理出需检索文艺复兴时期科技成果、代表人物贡献、社会环境变革等知识要点,并依据首轮检索结果决定是否深入挖掘特定领域知识或拓展检索范畴。

信息提取:处理检索文档时,LLM 应高效提取关键信息,过滤无关内容。这一过程类似专业学者研读文献,提炼精华,增强处理外部知识的效率与准确性(Wei 等人,2023;Xu 等人,2024)。以医学研究文献检索为例,面对海量医学论文,LLM 需精准提取疾病病因、症状、治疗方案、实验数据等核心信息,摒弃无关的研究背景、实验设备介绍等冗余内容,为答案推断筑牢基础。

答案推断:集齐解答问题的全部知识后,LLM 运用推理生成准确答案,降低幻觉风险,确保回应可靠精准(Wei 等人,2023)。如在复杂物理问题求解中,综合各类物理定律、实验数据及现象描述后,LLM 经严谨推理得出符合物理原理与实际情况的答案,避免无根据的臆测与错误结论。

这三种推理共同构成迭代检索的思维链条。我们采用少样本提示法激发推理过程,依实际情境灵活调整步骤。初始接收问题时可省略后两步,检索信息全无关时跳过信息提取,确保模型依据情境精准判断,而非机械模仿与虚构答案。用于激发推理的提示示例见附录C.1,同时利用灵活提示策略生成多样查询,摆脱少样本提示的风格局限,提升检索灵活性与全面性。

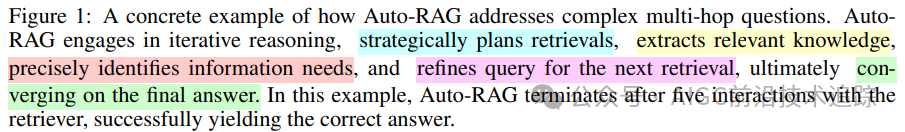

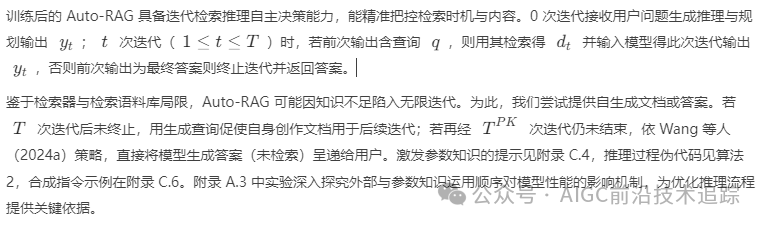

3.1.2 数据过滤与格式化

数据过滤:虽阐明迭代检索推理与查询优化方法,但仍可能产生推理瑕疵或不佳查询。我们通过对生成的推理与查询筛选。在含子答案的多跳问答数据集里,每次检索迭代多采样查询,保留检索文档含子答案的查询。同时,若最终答案与数据集参考答案吻合,则保留数据,确保迭代检索质量与答案连贯性。算法 1 清晰勾勒指令合成与过滤框架,从源头提升数据质量,为模型训练与性能优化奠定坚实基础。

数据格式化:将迭代检索视作多轮交互对话,各轮输入为用户问题或检索文档,输出是 LLM 的推理、检索规划或最终答案。

3.2 训练

为赋予任意 LLM 迭代检索自主决策能力,我们选用标准监督微调策略。依公式 :

计算交叉熵损失,通过反向传播优化模型参数,使模型学习到精准的决策模式与推理逻辑,提升在迭代检索任务中的性能表现。

3.3 推理

4.实验

4.1 实验设置

本研究聚焦 Auto-RAG 于问答(QA)任务应用,涵盖开放域 QA与多跳 QA领域。

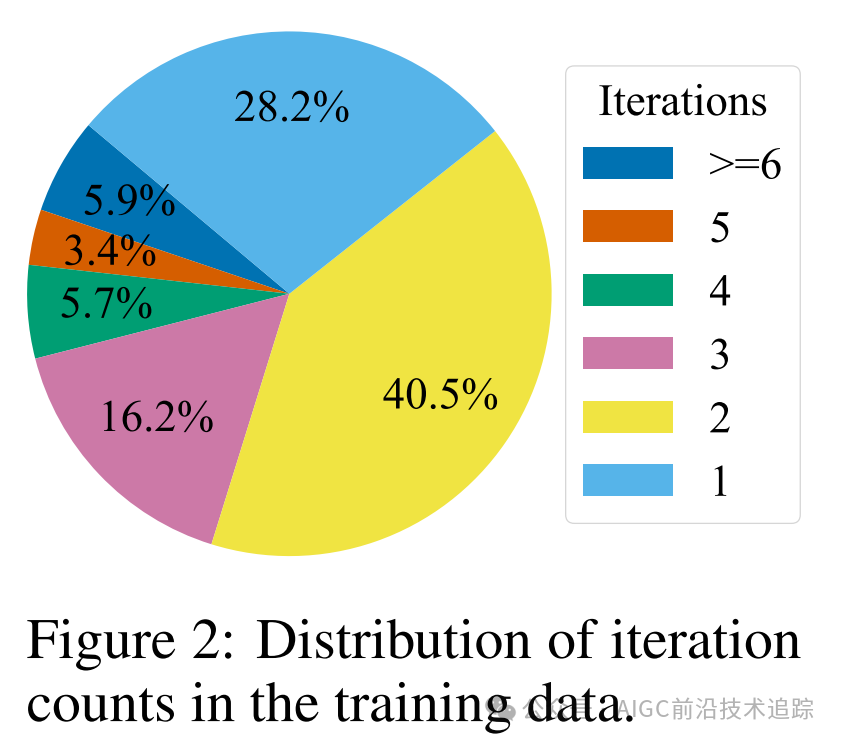

为训练 Auto-RAG,我们以 Natural Questions(NQ)和 2WikiMultihopQA(2Wiki)两个代表性数据集为蓝本,精心合成 10,000 条基于推理的指令。选用 Llama-3-8B-Instruct 塑造推理过程,Qwen1.5-32B-Chat 构建改写查询,随后用合成指令对 Llama-3-8B-Instruct 微调五轮,强化其迭代检索自主决策能力。训练数据迭代次数分布如图 2 所示,呈现出一定规律,为模型性能评估与优化提供数据洞察。

评估环节,我们横跨 NQ、2Wiki、TriviaQA(TQA)、PopQA(PQA)、HotpotQA(HQA)和 WebQuestions(WQ)六个数据集展开严格测试,采用 E5-base-v2 作检索器,以 2018 年 12 月 Wikipedia 数据转储为检索语料库,遵循标准报告结果与指标,NQ、TQA、WQ 用精确匹配(EM),2Wiki、PQA、HQA 用 F1 分数,各数据集超参数详情于附录 B 完整呈现,确保实验设置科学合理、结果可比可靠。

4.2 基线方法

基线设置全面涵盖无检索(Naive Gen)、单次检索与多次检索(迭代检索)方法:

无检索基线(Naive Gen):以 Llama-3-8B-Instruct 零样本设置评估性能,展现模型自身知识储备应对问答任务的水平,为对比检索增强策略效果提供基础参照。

单次检索基线:过程优势,多维度剖析单次检索性能边界与提升方向。对比 RECOMP-abstractive 和 Selective-Context 在上下文选择优化的成果、REPLUG 对生成器性能提升成效,以及 IRCoT阅读解释检索文档时思维链(CoT)

多次检索基线(迭代检索):将 Auto-RAG 与 FLARE、Iter-RetGen、Self-RAG 对比。前两者分别依赖手动定义检索内容与规则判定检索时机,Self-RAG 靠预测反思标记决定检索与评估结果质量,Auto-RAG 则凭借自主推理决策脱颖而出,凸显智能自主检索优势。

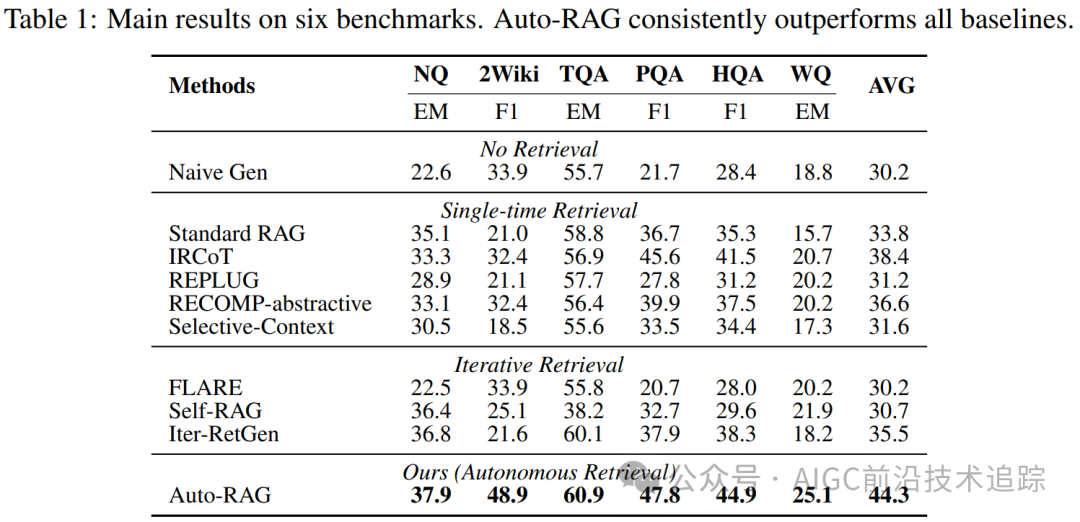

4.3 主要结果

表 1 展示六个基准测试结果,Auto-RAG 在各数据集表现优异,超越其他迭代检索方法。与 Iter-RetGen 相比,其摆脱手动定义检索内容与次数依赖;相对 FLARE,突破预定义规则限制,自主决策检索时机与内容,精准高效;相较于 Self-RAG,融入迭代推理机制,决策更精细合理,优化检索策略应对复杂任务,在六个基准测试中成绩斐然,有力证明其在问答任务中的卓越性能与领先地位,为知识检索与答案生成树立新标杆。

5.分析

5.1 对问题和检索器的强适应性

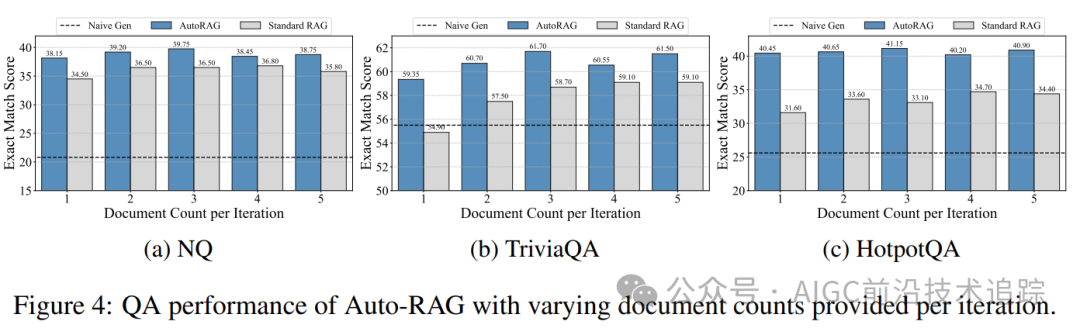

实际应用中,问题复杂度与检索文档长度差异显著,检验 Auto-RAG 适应性至关重要。分析多数据集不同检索文档数量下 Auto-RAG 迭代比例与性能:

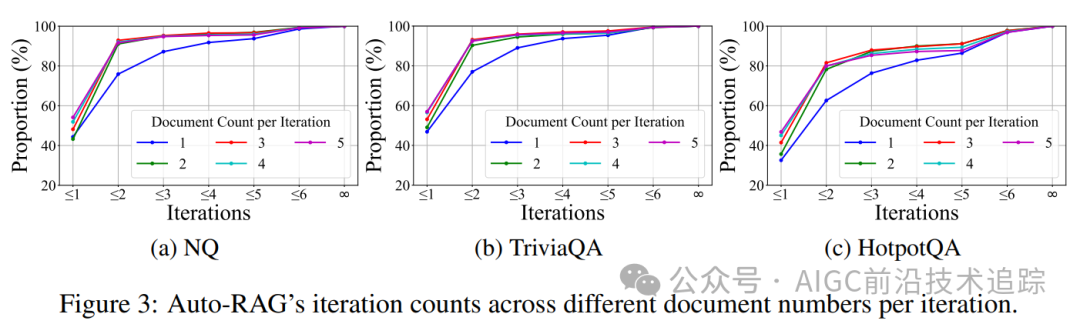

迭代次数自适应调整:如图 3,单跳 QA 任务 NQ 和 TriviaQA 首轮迭代终止比例高于多跳 QA 任务 HotpotQA,因单跳任务信息需求相对简单,模型能快速判定检索充分性。且随每轮检索文档增多,首轮迭代终止比例上升,表明模型依信息充足度灵活调控迭代次数,如信息充裕则速决,不足则持续检索,智能适配任务需求。

文档数量影响性能:图 4 显示不同文档数量影响 QA 性能,在三个任务中,每轮提供三篇文档时效果佳,揭示合适文档量对模型性能提升关键作用,为检索器设置与检索策略优化指引方向,确保模型输入信息质与量平衡。

对比无检索(Naive Gen)和 Standard RAG,Auto-RAG 性能卓越且波动小,稳健应对检索器差异,为复杂多变实际应用筑牢可靠性能根基。

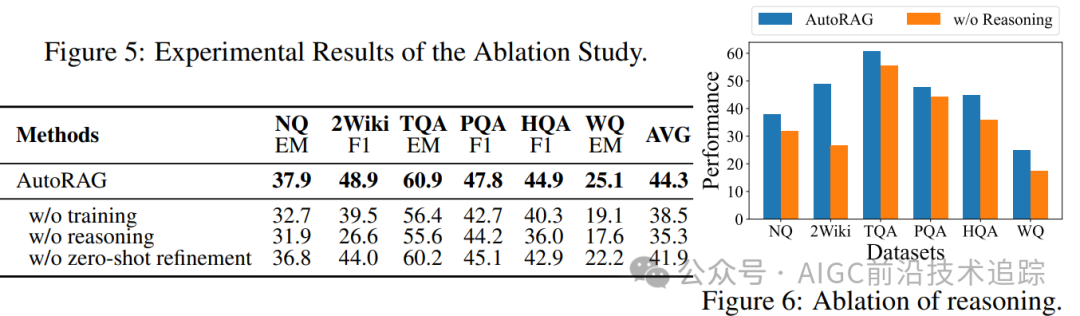

5.2 消融研究

通过消融实验深度验证 Auto-RAG 训练、迭代推理与数据构建环节关键作用:

训练成效显著:经训练的 Auto-RAG 相较以少样本提示合成数据引导的未训练模型优势尽显。未训练模型在问答任务中常陷入困境,因依赖少样本提示致使推理过程生硬、缺乏灵活性,额外推理开销巨大。而训练后的 Auto-RAG 凭借微调学习,精准捕捉数据深层特征与逻辑关联,将知识深度内化于模型架构,构建高效检索决策体系,有力消除少样本局限,在复杂问答情境下迅速定位关键知识,大幅提升答案准确性与完整性,彰显训练对模型迭代检索能力进阶的核心驱动价值。

迭代推理赋能:对比直接依检索文档生成答案的模型,融入迭代推理的 Auto-RAG 在解决复杂问题时效果提升显著。缺乏推理环节的模型面对多跳、逻辑嵌套问题时易迷失方向,误判信息关联,答案质量参差不齐。Auto-RAG 的迭代推理机制似智慧导航,逐轮剖析问题、精准甄别信息需求、动态优化检索策略。如在科学知识问答中,面对多因素交织难题,Auto-RAG 层层推理、抽丝剥茧,挖掘知识间微妙联系,直至构建完整逻辑链条解答问题,有力印证推理环节对提升模型复杂任务处理能力的关键意义,契合推理提升模型能力的理论预期。

数据构建优势:在数据合成环节,零样本查询改写方法远超少样本查询精炼。少样本查询精炼受样本数量与分布制约,易陷入局部最优陷阱,生成查询趋同、覆盖范围窄。零样本方法摆脱样本束缚,基于语义理解与知识泛化动态生成多元查询。如历史事件检索中,能从不同视角时段构建查询,大幅提升检索全面性精准度,为模型挖掘深层知识、优化答案创造丰富信息源,充分展现数据构建策略优化对提升 Auto-RAG 整体性能的深远影响。

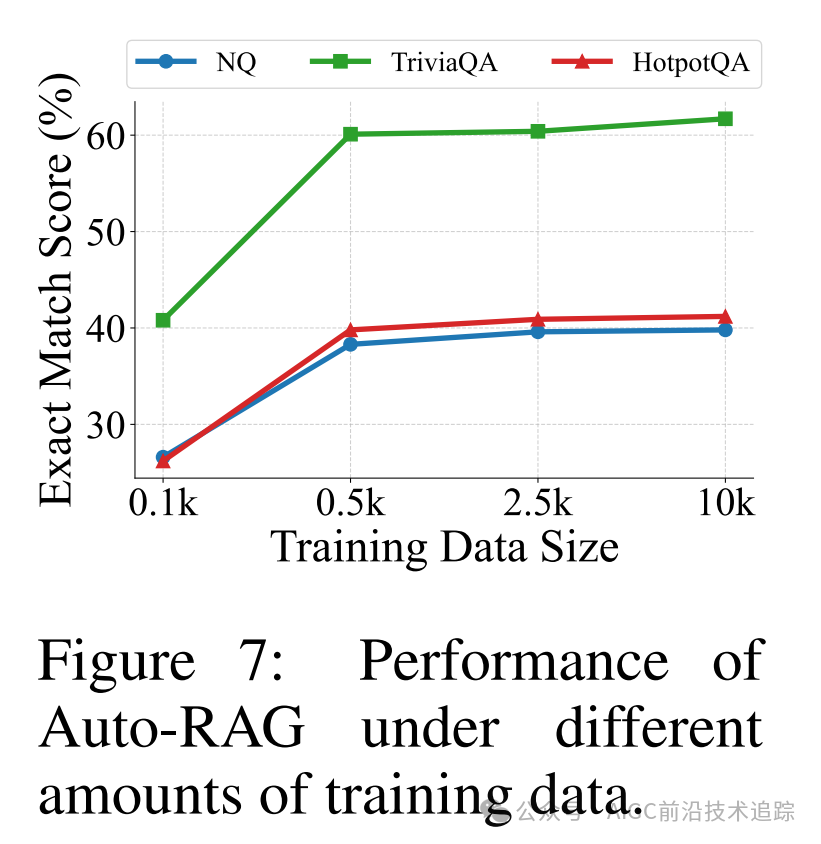

5.3 数据缩放

系统探究 Auto-RAG 在不同指令数量训练下性能演变规律,将训练数据量从 0.1k 精细拓展至 10k 并于问答任务评估。实验数据(图 7)清晰显示:约 0.5k 数据量时,模型初获自主检索能力萌芽,此阶段模型似懵懂学徒,依据有限指令初步构建知识检索框架,尝试探索信息海洋,虽检索决策稍显稚嫩,但已具备应对简单问答基础能力,开启智能检索征程第一步。随数据量稳步攀升,模型性能呈持续上扬态势。丰富数据为模型注入知识养分,助其深化语义理解、拓展知识视野、强化逻辑推理,精准洞察问答任务复杂模式与微妙语境差异。于海量历史文献问答中,大量数据使模型精准解析时代背景、人物关系及事件脉络,优化检索路径、精准筛选关键知识片段,大幅提升答案准确性与权威性,为模型性能与数据规模间紧密关联提供有力量化支撑,指引模型训练资源高效配置与性能深度优化方向。

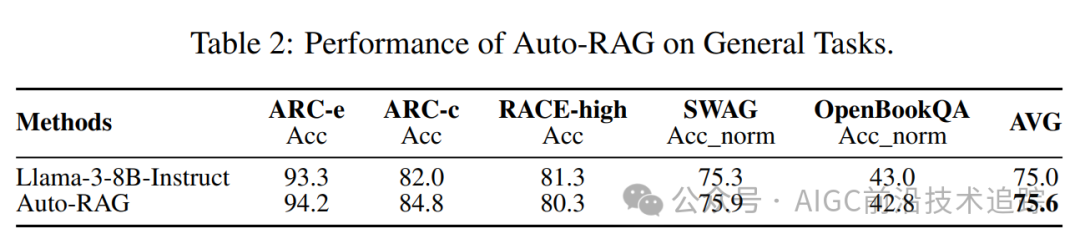

5.4 一般任务性能

为全面度量 Auto-RAG 通用任务处理实力,精心择取多领域权威基准测试,涵盖 AI2 推理挑战、考试阅读理解数据集、对抗生成场景及开放图书问答等。实验结果(表 2)表明,Auto-RAG 在 ARC 与 SWAG 任务中成绩耀眼、进步显著。经合成数据专项训练,LLMs 推理内核深度强化,赋予 Auto-RAG 应对对抗任务复杂挑战卓越智慧。于 ARC 任务逻辑迷宫里,面对环环相扣推理难题,Auto-RAG 运用知识检索锐眼捕捉关键线索,凭借严密逻辑思维熔炉锤炼答案,精准拆解迷惑陷阱、严密推导正确结论,展现强大逻辑推理与知识运用协同能力;在 SWAG 对抗战场,面对误导干扰,Auto-RAG 依深厚知识储备与灵动应变智慧,精准剖析语境语义、敏锐识破陷阱伪装,生成合理答案,凸显强大泛化能力与环境适应韧性,为处理跨领域复杂任务筑牢坚实能力根基,拓展人工智能技术应用边界。

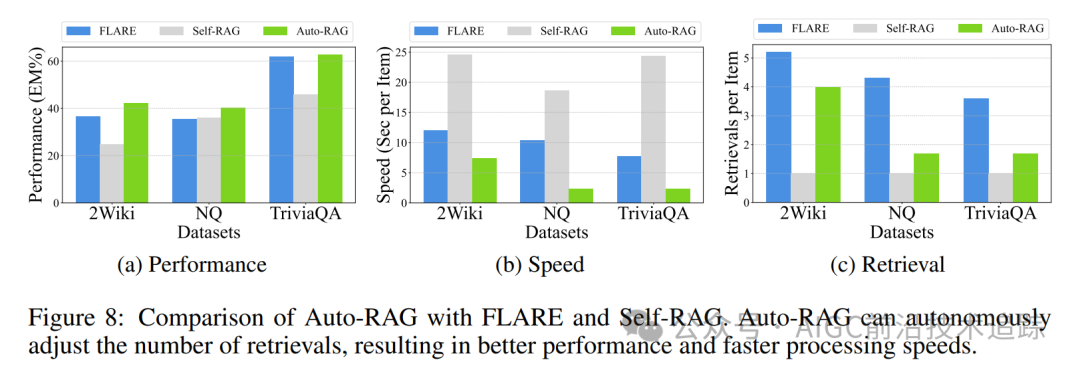

5.5 效率

对比 Auto-RAG 与 FLARE、Self-RAG 效率(图 8),FLARE 困于手动规则桎梏,检索修订流程机械、应变迟缓,检索低概率成分时资源消耗大、效率低迷;Auto-RAG 以自主智能决策为引擎,动态规划检索轨迹,性能卓越、检索次数精简、处理速度飙升。Self-RAG 处理短问答时逐个文档孤立生成答案与反思,忽视文档关联协同,检索次数盲目依赖输出长度,耗时费力且易陷入局部最优;Auto-RAG 依问题复杂度与知识关联度智能调配迭代节奏,如敏锐猎手精准捕获关键知识,高效生成优质答案,于各数据集性能与效率指标优势尽显(图 8),于实际问答场景中大幅提升用户信息获取时效,重塑智能问答效率典范。

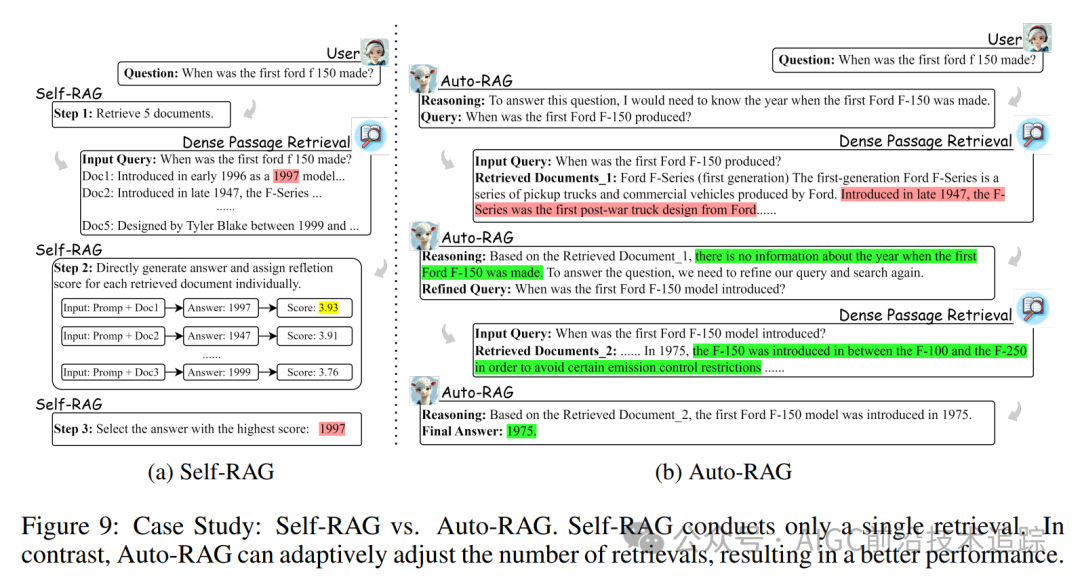

5.6 案例研究

深入对比 Auto-RAG 与 Self-RAG 案例(图 9),Self-RAG 对检索文档独立处理、孤立评估反思,选最高分答案策略弊端显著。处理复杂问题时,因未考量文档内在逻辑关联,易被无关信息误导,当文档皆无关时,无法主动拓展搜索纠错,致答案可靠性受损;Auto-RAG 以自主决策为智慧中枢,依知识价值动态导航检索路径,遇无关文档冷静筛选、持续探索,直至掘取关键知识点亮答案灯塔。且 Auto-RAG 以自然语言清晰阐释推理脉络,Self-RAG 反射令牌式反思晦涩难懂。如剖析文学作品深层寓意问答场景,Auto-RAG 以流畅自然语言引领用户漫步推理之路,Self-RAG 则令用户于符号迷宫中迷茫,Auto-RAG 大幅提升交互可解释性与用户体验,开启智能交互新纪元。

6.结论

在这篇论文中,我们介绍了 Auto-RAG,这是一个以大型语言模型强大的决策能力为核心的自主迭代检索模型。Auto-RAG 通过多轮对话与检索器进行交互,系统地规划检索并优化查询以获取有价值的知识,直到获得足够的外部信息,此时将结果呈现给用户。为此,我们开发了一种在迭代检索中自主合成基于推理的决策指令的方法,并对最新的开源大型语言模型进行了微调。分析结果表明,Auto-RAG 不仅实现了出色的性能,还保持了高度的可解释性,为用户提供了更直观的体验。

本文转载自 AIGC前沿技术追踪,作者: 喜欢学习的小仙女