LLM合集:港大利用GPT-4o生成QA对,打造大规模多模态视频思维链(COT)数据集

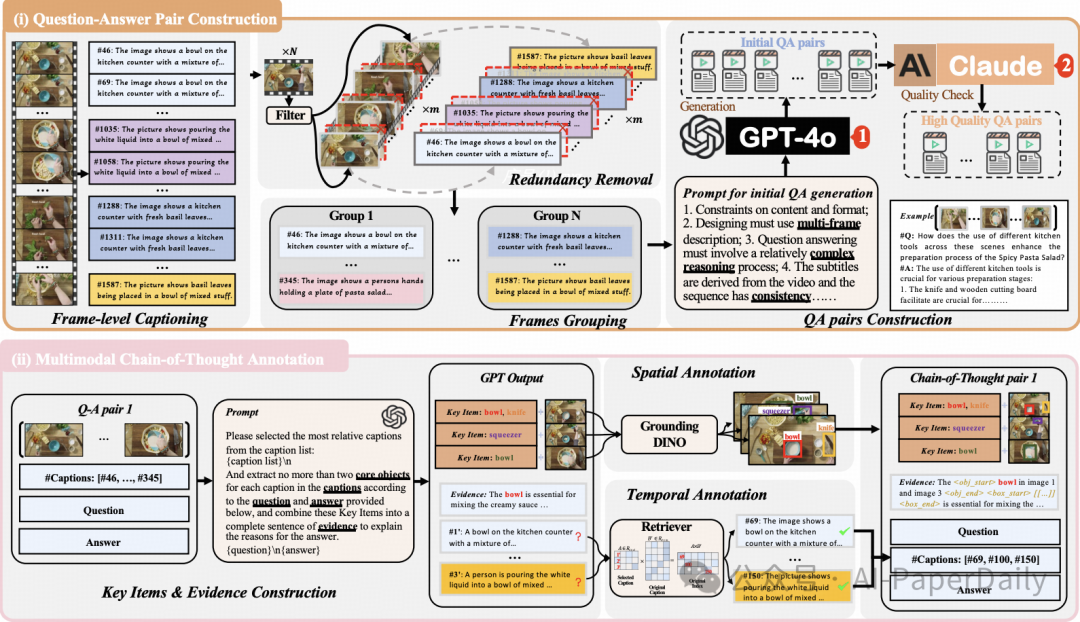

1. VideoEspresso: A Large-Scale Chain-of-Thought Dataset for Fine-Grained Video Reasoning via Core Frame Selection

大型视觉语言模型(LVLMs)的进步显著提升了多模态理解能力,但在视频推理任务中仍面临挑战,主要原因是高质量、大规模数据集的缺乏。现有的视频问答(VideoQA)数据集往往依赖于成本高昂且粒度不足的手动标注,或者使用会产生冗余帧分析的自动构建方法,这限制了它们在复杂推理任务中的可扩展性和有效性。为了解决这些挑战,我们提出了VideoEspresso,这是一个新的数据集,它包含保留了关键空间细节和时间连贯性的VideoQA对,以及中间推理步骤的多模态标注。我们的构建流程采用了一种语义感知的方法来减少冗余,并通过GPT-4o生成QA对。此外,我们开发了视频思维链(CoT)标注以丰富推理过程,指导GPT-4o从QA对和视频内容中提取逻辑关系。

为了充分利用高质量的VideoQA对,我们提出了一种混合LVLM协作框架,该框架包括一个帧选择器和一个两阶段指令微调推理LVLM。此框架能够自适应地选择核心帧,并利用多模态证据进行CoT推理。在我们提出的基准测试中,与9种流行的LVLM相比,在14项任务上,我们的方法在大多数任务上优于现有基线,展示了卓越的视频推理能力。

论文: https://arxiv.org/pdf/2411.14794

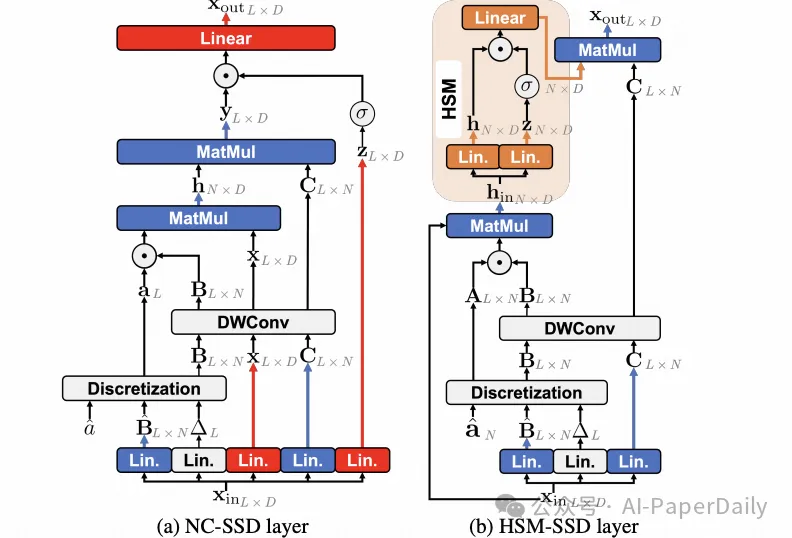

2. EfficientViM: Efficient Vision Mamba with Hidden State Mixer based State Space Duality

在资源受限环境中部署神经网络时,先前的工作构建了轻量级架构,分别使用卷积和注意力机制来捕捉局部和全局依赖关系。最近,状态空间模型(SSM)作为一种有效的全局token交互方式出现,其在token数量上的计算成本呈线性增长,具有明显优势。然而,基于SSM构建的高效视觉骨干网络研究较少。在本文中,我们提出了一种名为Efficient Vision Mamba (EfficientViM)的新架构,该架构基于隐藏状态混合器的状态空间二元性(HSM-SSD),能够以更低的计算成本高效地捕捉全局依赖关系。在HSM-SSD层中,我们重新设计了之前的SSD层,使得可以在隐藏状态内执行通道混合操作。此外,我们提出了多阶段隐藏状态融合方法,进一步增强隐藏状态的表示能力,并提供了一种缓解由内存限制操作引起瓶颈的设计。

结果表明,EfficientViM系列在ImageNet-1k上达到了新的速度-精度平衡,相比第二优秀的模型SHViT,性能提高了0.7%,同时运行速度更快。另外,在图像缩放或采用蒸馏训练时,与之前的工作相比,我们在吞吐量和准确率方面都观察到了显著提升。

论文: https://arxiv.org/pdf/2411.15241

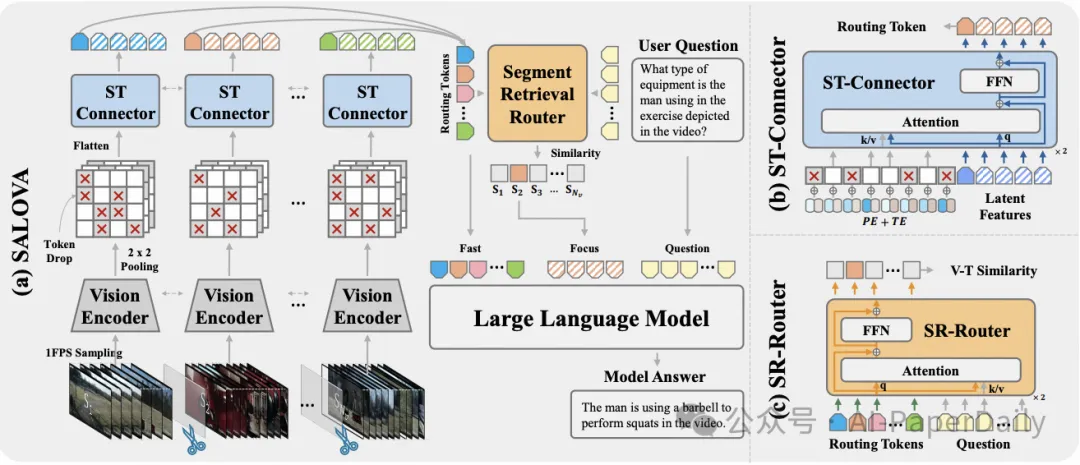

3. SALOVA: Segment-Augmented Long Video Assistant for Targeted Retrieval and Routing in Long-Form Video Analysis

尽管大型多模态模型取得了进展,但在处理长且未经剪辑的视频内容时仍面临挑战,主要原因是上下文长度的限制和巨大的内存开销。这些限制往往导致信息丢失严重,并降低了模型响应的相关性。随着网络平台上视频数据的指数级增长,理解长视频对于推进通用智能至关重要。在本文中,我们介绍了SALOVA(段增强长视频助手):一种新颖的视频-大语言模型框架,旨在通过有针对性的检索过程增强对长视频内容的理解。

为实现这一目标,我们解决了两个主要挑战:

我们发布了SceneWalk数据集,这是一个高质量的87,800个长视频集合,每个视频都在片段级别进行了密集标注,以使模型能够捕捉场景连续性并保持丰富的描述性上下文。

我们的框架通过允许精确识别和检索与查询相关的视频片段,从而缓解了当前视频-大语言模型的局限性,提高了生成响应的上下文相关性。通过广泛的实验,SALOVA展示了在处理复杂长视频方面的增强能力,显著提升了在长时间序列中保持上下文完整性的能力。

论文: https://arxiv.org/pdf/2411.16173

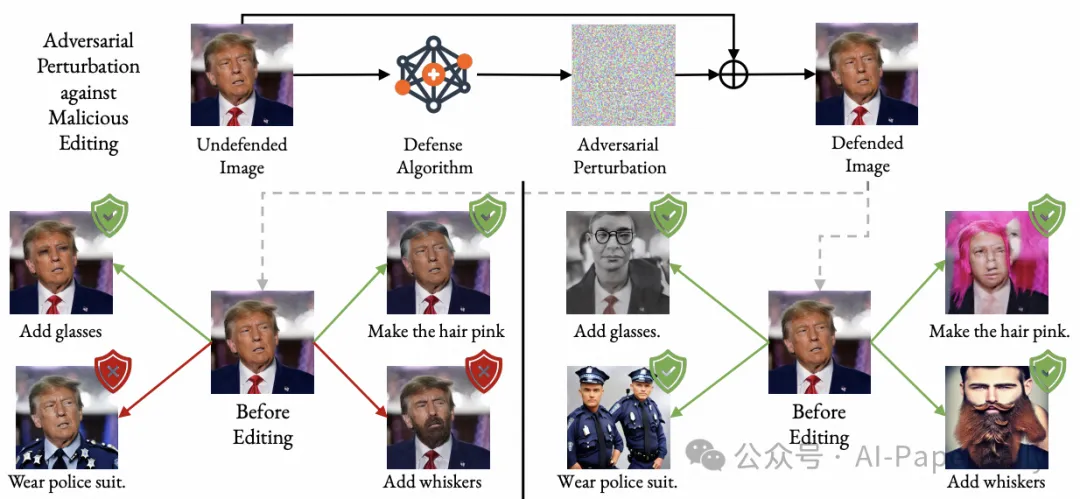

4. Edit Away and My Face Will not Stay: Personal Biometric Defense against\n Malicious Generative Editing

扩散模型的最新进展使得生成式图像编辑变得更加容易,这虽然促进了创意编辑,但也引发了伦理问题,尤其是在涉及恶意修改人像时,这些修改可能威胁到个人隐私和身份安全。现有的保护方法主要依赖于对抗性扰动来抵消编辑效果,但往往难以应对多样化的编辑请求。我们提出了一种名为FaceLock的新方法,通过优化对抗性扰动来破坏或显著改变生物特征信息,使编辑后的输出在生物特征上无法识别。FaceLock将面部识别和视觉感知集成到扰动优化过程中,以提供对各种编辑尝试的强健保护。

我们还指出了常用评估指标中的缺陷,并揭示了它们如何被操纵,强调了需要可靠的保护评估方法。实验表明,FaceLock在抵御恶意编辑方面优于基线方法,并且对净化技术具有鲁棒性。消融研究证实了其稳定性和在基于扩散的编辑算法中的广泛适用性。我们的工作推进了生物特征防御,并为图像编辑中的隐私保护实践奠定了基础。

论文: https://arxiv.org/pdf/2411.16832

本文转载自 AI-PaperDaily,作者: AI-PaperDaily