Apple 发布 AIMv2:最先进的开放集视觉编码器系列 原创

01、概述

在计算机视觉领域,我们见证了视觉模型的飞速发展。每一次技术的革新都在解决前一代模型的局限性。然而,如何在复杂性、泛化能力和可扩展性之间找到平衡点,一直是研究者们面临的挑战。当前的许多模型在处理多样化的视觉任务或适应新数据集时仍显吃力。传统的大规模预训练视觉编码器虽然取得了成功,但在扩展性和参数效率方面存在挑战。市场急需一种强大而多功能的模型,能够在不牺牲性能的情况下处理多种模态,如图像和文本,同时不需要大量的数据筛选。

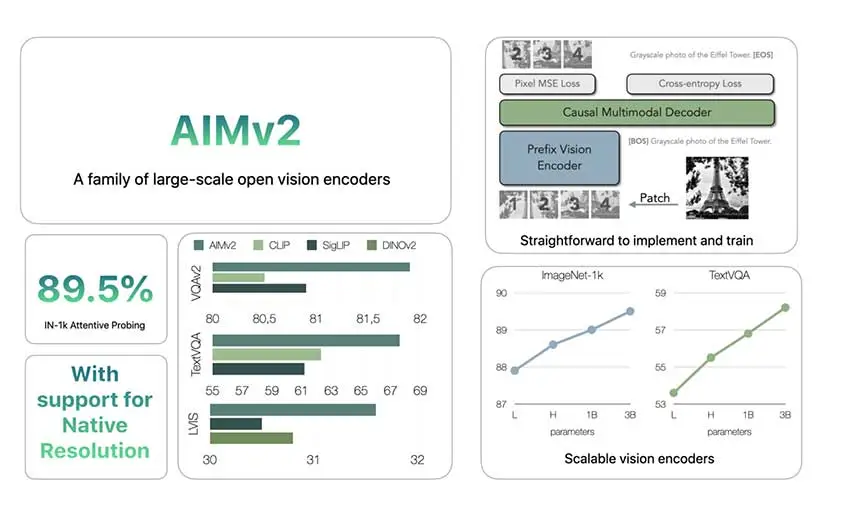

02、AIMv2:苹果的新解决方案

苹果公司通过发布AIMv2,迎接了这一挑战。AIMv2是一系列开放式视觉编码器,旨在提升现有模型在多模态理解和目标识别任务上的表现。受CLIP等模型的启发,AIMv2增加了自回归解码器,使其能够生成图像块和文本标记。AIMv2家族包含19个不同参数大小的模型——从300M到2.7B,支持224、336和448像素的分辨率。这种模型大小和分辨率的范围使得AIMv2适用于不同的应用场景,从小型应用到需要大型模型的任务。

03、技术概览

AIMv2采用了多模态自回归预训练框架,这一框架在传统对比学习方法的基础上进行了构建。AIMv2的关键特性是将视觉变换器(ViT)编码器与因果多模态解码器相结合。在预训练期间,编码器处理图像块,随后与相应的文本嵌入配对。因果解码器然后自回归地生成图像块和文本标记,重建原始的多模态输入。这种设置简化了训练过程,并促进了模型的扩展,而无需特殊的批次间通信或极大的批次大小。此外,多模态目标使AIMv2能够实现比其他方法更密集的监督,增强了其从图像和文本输入中学习的能力。

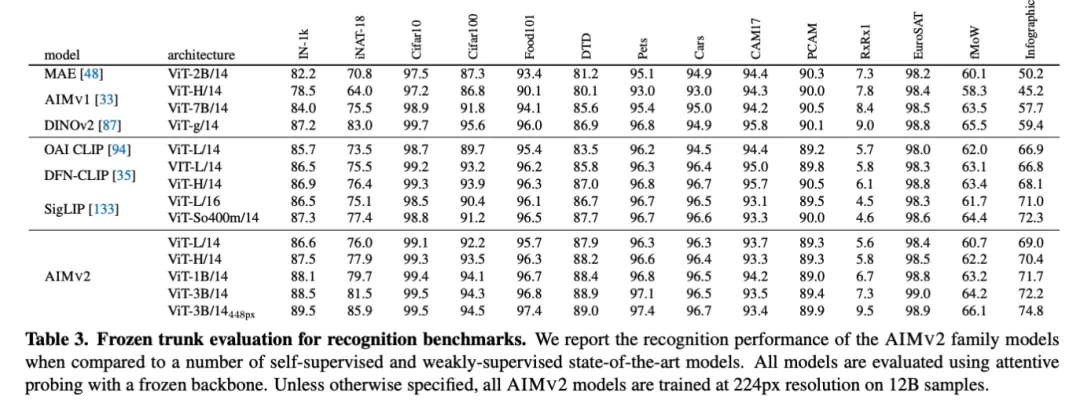

04、性能与可扩展性

AIMv2在大多数多模态理解基准测试中超越了OAI CLIP和SigLIP等主要现有模型。具体来说,AIMv2-3B在冻结树干的情况下,在ImageNet数据集上达到了89.5%的top-1准确率,显示出冻结编码器模型的显著鲁棒性。与DINOv2相比,AIMv2在开放词汇目标检测和指代表达理解方面也表现良好。此外,AIMv2的可扩展性显而易见,其性能随着数据和模型大小的增加而持续提高。模型的灵活性和与现代工具(如Hugging Face Transformers库)的集成,使其在各种应用中的实施变得实用且直接。

05、结论

AIMv2代表了视觉编码器发展的一个重要进步,强调了训练的简单性、有效的扩展性和多模态任务的多功能性。苹果发布AIMv2在多个基准测试上提供了比以往模型更好的改进,包括开放词汇识别和多模态任务。自回归技术的使用使AIMv2能够实现密集监督,从而获得强大而灵活的模型能力。AIMv2在Hugging Face等平台上的可用性,使得开发者和研究人员能够更容易地尝试先进的视觉模型。AIMv2为开放式视觉编码器树立了新的标准,能够应对现实世界多模态理解日益增加的复杂性。

参考:

- https://arxiv.org/abs/2411.14402

- https://huggingface.co/collections/apple/aimv2-6720fe1558d94c7805f7688c

本文转载自公众号Halo咯咯 作者:基咯咯