从频率到细节:ConsisID实现无缝身份一致的文本到视频生成

文章链接: https://arxiv.org/abs/2411.17440

项目链接: https://pku-yuangroup.github.io/ConsisID/

亮点直击

- 提出了ConsisID,一个基于 DiT 的免调优(tuning-free)身份保持 IPT2V 模型,通过频率分解的控制信号来保持视频主角的身份一致性。

- 提出了一种分层训练策略,包括粗到细的训练过程、动态Mask损失(dynamic mask loss)以及动态跨脸损失(dynamic cross-face loss),共同促进模型训练并有效提升泛化能力。

- 大量实验表明,受益于我们的频率感知身份保持 T2V DiT 控制方案,ConsisID 能够生成高质量、可编辑且身份一致性强的视频。

总结速览

解决的问题提出一种解决生成一致人物身份的视频问题(Identity-preserving text-to-video,IPT2V)的方法,重点解决当前生成模型存在的两个难题:

- 去除繁琐的逐个问题(case-by-case)进行微调(tuning-free)。

- 提供频率感知的身份一致性控制方案。

提出的方案

- ConsisID: 一个基于 Diffusion Transformer (DiT) 的可控 IPT2V 模型,通过频率域的身份控制信号保持生成视频中的人类身份一致性。

- 低频控制: 引入全局人脸特征提取器,将参考图像和人脸关键点编码为包含低频信息的特征,并集成到网络浅层以缓解训练难度。

- 高频控制: 设计局部人脸特征提取器,捕获高频细节并注入 Transformer 模块,增强模型对细粒度特征的保留能力。

- 提出分层训练策略,利用频率信息从预训练视频生成模型转化为IPT2V 模型。

应用的技术

- 频率分析的视觉/扩散 Transformer 理论,通过分解人脸特征为低频全局特征(如轮廓、比例)和高频内在特征(如身份tokens)。

- 结合全局和局部人脸特征提取器,将低频和高频特征注入网络。

- 分层训练策略,使模型能够灵活控制身份一致性。

达到的效果

- ConsisID 无需逐案例微调,实现了高效的控制能力。

- 生成高质量且身份一致性强的视频,在IPT2V任务中取得优异表现。

- 推动了身份一致性视频生成技术的进一步发展。

发现 1:浅层(例如,低级别、低频率)特征对于扩散模型中的像素级预测任务至关重要,因为它们有助于模型训练。U-Net 通过长跳跃连接将浅层特征聚合到解码器,从而促进模型的收敛,而 DiT 没有采用这种机制;发现 2:Transformer对于高频信息的感知能力有限,而高频信息对于保持面部特征非常重要。U-Net 的编码器-解码器架构天然具备多尺度特征(例如,丰富的高频信息),而 DiT 缺乏类似的结构。要开发基于 DiT 的控制模型,首先需要解决这些问题。

方法

ConsisID: 保持身份一致性

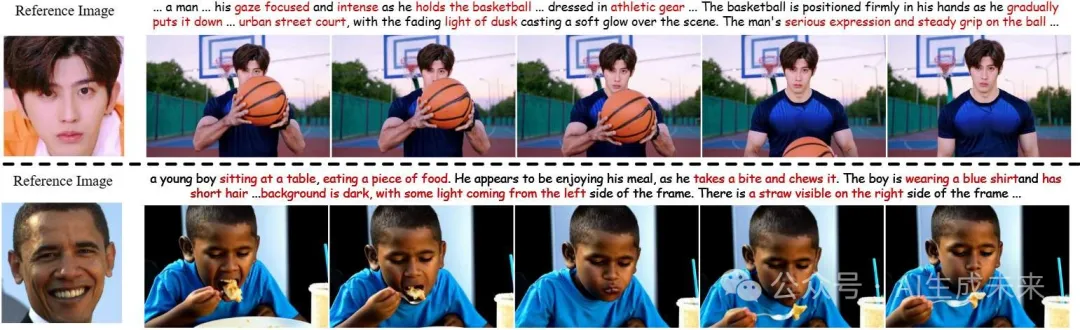

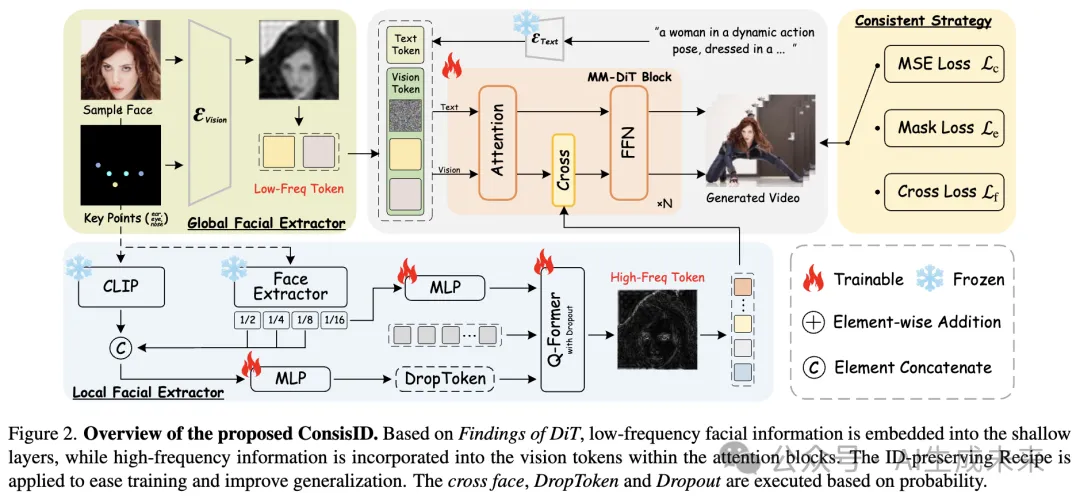

概述如下图 2 所示。给定参考图像,全局人脸特征提取器和局部人脸特征提取器将高频和低频的人脸信息注入模型,并在一致性训练策略的辅助下生成身份一致性视频。

低频视角:全局人脸特征提取器

基于发现 1,增强低层次(例如浅层、低频)特征能够加速模型收敛。为了让预训练模型更容易适应 IPT2V 任务,最直接的方法是将参考人脸与噪声输入的潜变量进行拼接。然而,参考人脸同时包含高频细节(如眼睛和嘴唇纹理)和低频信息(如面部比例和轮廓)。

根据发现 2,过早将高频信息注入 Transformer 不仅效率低下,还可能阻碍模型对低频信息的处理,因为 Transformer 主要关注低频特征。

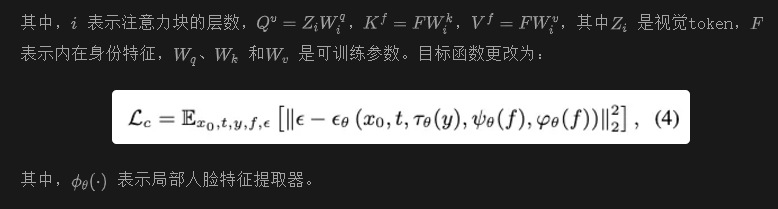

此外,直接将参考人脸输入模型可能引入诸如光照和阴影等无关噪声。为了解决这个问题,我们提取面部关键点,将其转换为 RGB 图像,然后将其与参考图像拼接,如图 2 所示。这一策略使模型的注意力集中在人脸的低频信号上,同时最大限度减少多余特征的影响。发现,当这一组件被移除时,模型会出现梯度爆炸。目标函数被修改为:

高频视角:局部人脸特征提取器

根据发现 2,认识到 Transformer 对高频信息的敏感度有限。因此,仅依赖全局人脸特征不足以满足 IPT2V 生成的需求,因为全局人脸特征主要由低频信息组成,缺乏编辑所需的内在特征。本任务不仅需要保持身份一致性,还需要具备编辑能力,例如生成具有相同身份但不同年龄或妆容的视频。

实现这一目标需要提取不受非身份属性(如表情、姿态和形状)影响的面部特征,因为年龄和妆容不会改变一个人的核心身份。我们将这些特征定义为内在身份特征(例如高频特征)。

先前的研究 [14–16] 使用 CLIP 图像编码器的局部特征作为内在特征以提升编辑能力。然而,由于 CLIP 未专门在面部数据集上训练,提取的特征包含有害的非面部信息。因此,选择使用人脸识别骨干网络提取内在身份特征。与直接使用骨干网络输出作为内在身份特征不同,我们使用其倒数第二层的输出,因为该层保留了更多与身份相关的空间信息。然而,这些特征仍然缺乏足够的语义信息,而语义信息对个性化视频生成至关重要。

为了解决这些问题,首先使用人脸识别骨干网络提取在内在身份表示方面具有优势的特征,并使用 CLIP 图像编码器捕获具有强语义的信息。然后,使用 Q-Former融合这两种特征,生成包含高频语义信息的内在身份特征。为减少 CLIP 中无关特征的影响,在输入 Q-Former 之前应用了 dropout。此外,通过插值将来自人脸识别骨干网络的浅层多尺度特征与 CLIP 特征拼接。这种方法确保模型有效捕获必要的内在身份特征,同时过滤掉与身份无关的外部噪声。

在提取内在身份特征后,通过交叉注意力与预训练模型每个注意力块生成的视觉标记交互,有效增强 DiT 中的高频信息。

一致性训练策略

在训练过程中,从训练帧中随机选择一帧,应用 Crop & Align提取面部区域作为参考图像,并将其与文本一起用作身份控制信号。

粗到细的训练相比于身份保持的图像生成,视频生成需要同时在空间和时间维度上保持一致性,确保高频和低频的人脸信息与参考图像匹配。为了降低训练的复杂性,本文提出了一种分层策略,让模型先学习全局信息,再局部细化。在粗粒度阶段(例如对应发现 1),使用全局人脸特征提取器,使模型优先关注低频特征,如面部轮廓和比例,从而确保能够快速从参考图像中获取身份信息并在视频序列中保持一致性。在细粒度阶段(例如对应发现 2),局部人脸特征提取器将模型的注意力转移到高频细节上,例如眼睛和嘴唇的纹理细节(如内在身份特征),以提高面部表情的逼真度和生成面部的整体相似性。

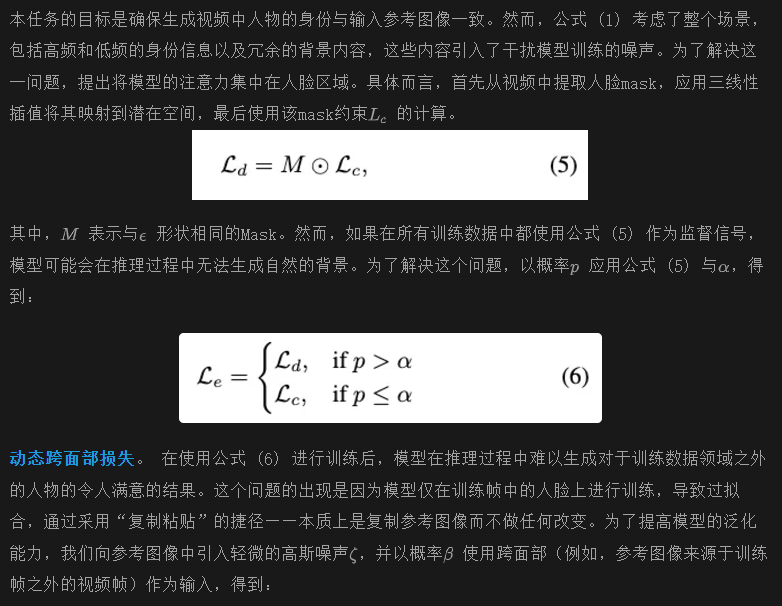

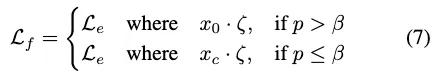

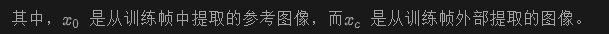

动态Mask损失

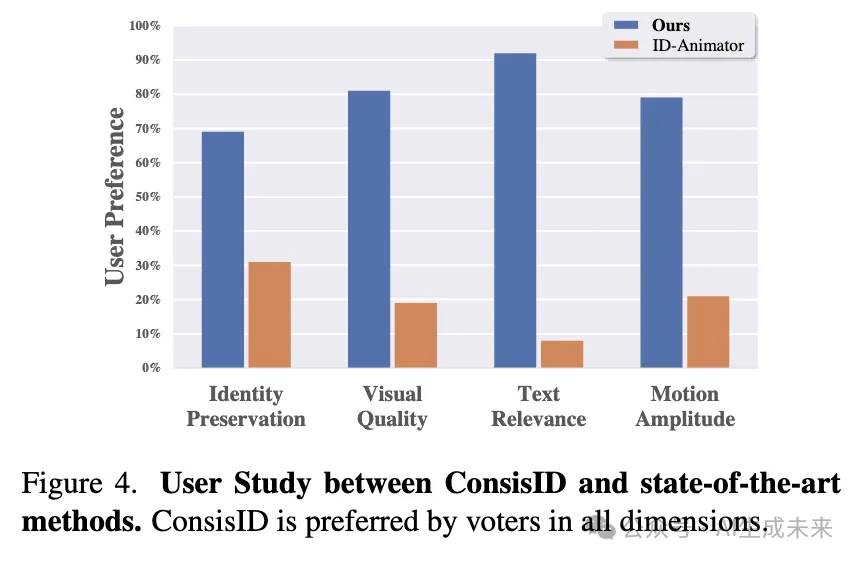

设置

实现细节

基准测试由于缺乏评估数据集,选择了 30 名未包含在训练数据中的人,并从互联网上为每个身份来源了五张高质量的图像。然后,设计了 90 个不同的提示,涵盖了各种表情、动作和背景进行评估。基于以往的研究 [15, 38],从四个维度进行评估:

(1).身份保持:使用 FaceSim-Arc 并引入 FaceSim-Cur,通过测量生成视频中面部区域与真实面部图像在 ArcFace 和 CurricularFace 特征空间中的特征差异来评估身份保持。(2).视觉质量:我们通过计算生成帧与真实面部图像在 InceptionV3 特征空间中的面部区域特征差异来使用 FID进行评估。(3).文本相关性:我们使用 CLIPScore 来测量生成的视频与输入提示之间的相似性。(4).运动幅度:由于缺乏可靠的度量标准,我们通过用户研究进行评估。

定性分析

本节将 ConsisID 与 ID-Animator(例如,唯一可用的开源模型)进行比较,以进行无需调优的 IPT2V 任务。我们随机选择了四个个体的图像和文本提示进行定性分析,这些个体均不包含在训练数据中。如下图 5 所示,ID-Animator 无法生成超出面部的人体部位,并且无法根据文本提示(例如,动作、属性、背景)生成复杂的动作或背景,这显著限制了其实际应用。此外,身份的保持也不足;例如,在案例 1 中,参考图像似乎经过了皮肤平滑处理。

在案例 2 中,引入了皱纹,降低了美学质量。在案例 3 和 4 中,由于缺乏低频信息,面部发生了扭曲,导致身份一致性受到损害。相比之下,提出的 ConsisID 始终生成高质量、逼真的视频,准确匹配参考身份并符合提示。

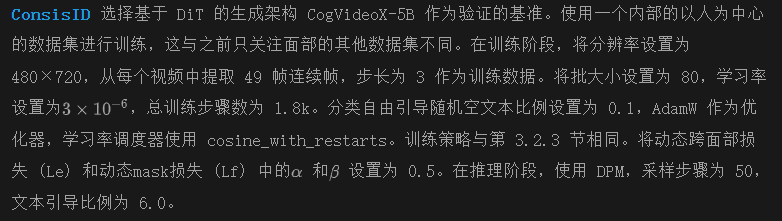

定量分析

本届展示了不同方法的全面定量评估,结果如下表 1 所示。

与上图 5 一致,本文的方法在五个指标上超过了现有的最先进方法。在身份保持方面,ConsisID 通过从频率角度为 DiT 设计适当的身份信号,取得了更高的分数。相比之下,ID-Animator 并未针对 IPT2V 进行优化,仅部分保留了面部特征,导致 FaceSim-Arc 和 FaceSim-Cur 的分数较低。在文本相关性方面,ConsisID 不仅通过提示控制表情,还调整动作和背景,取得了更高的 CLIPScore。关于视觉质量,FID 仅作为参考呈现,因为它与人类感知的对齐有限 。有关视觉质量的定性分析,请参见上图 5 和 下图4。

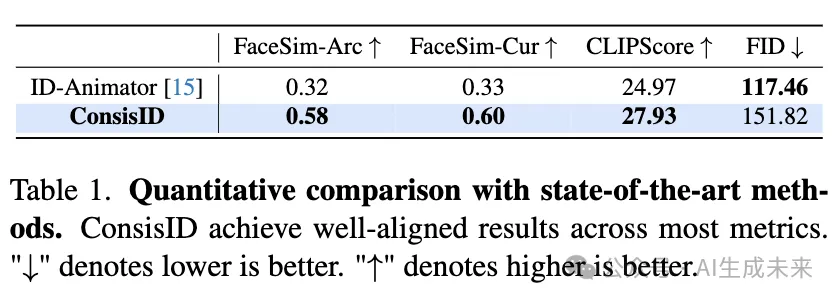

用户研究

基于之前的工作,使用二元投票策略进行人工评估,每份问卷包含80个问题。参与者需要观看40个视频片段,这一设置旨在提高参与度和问卷的有效性。对于 IPT2V 任务,每个问题要求参与者分别判断哪个选项在身份保持、视觉质量、文本对齐和运动幅度方面表现更好。这一组成确保了人工评估的准确性。由于此评估需要大量的参与者,我们成功收集了103份有效问卷。结果如上图4所示,证明本文的方法在多个方面显著优于 ID-Animator,验证了所设计的 DiT 在 IPT2V 生成中的有效性。

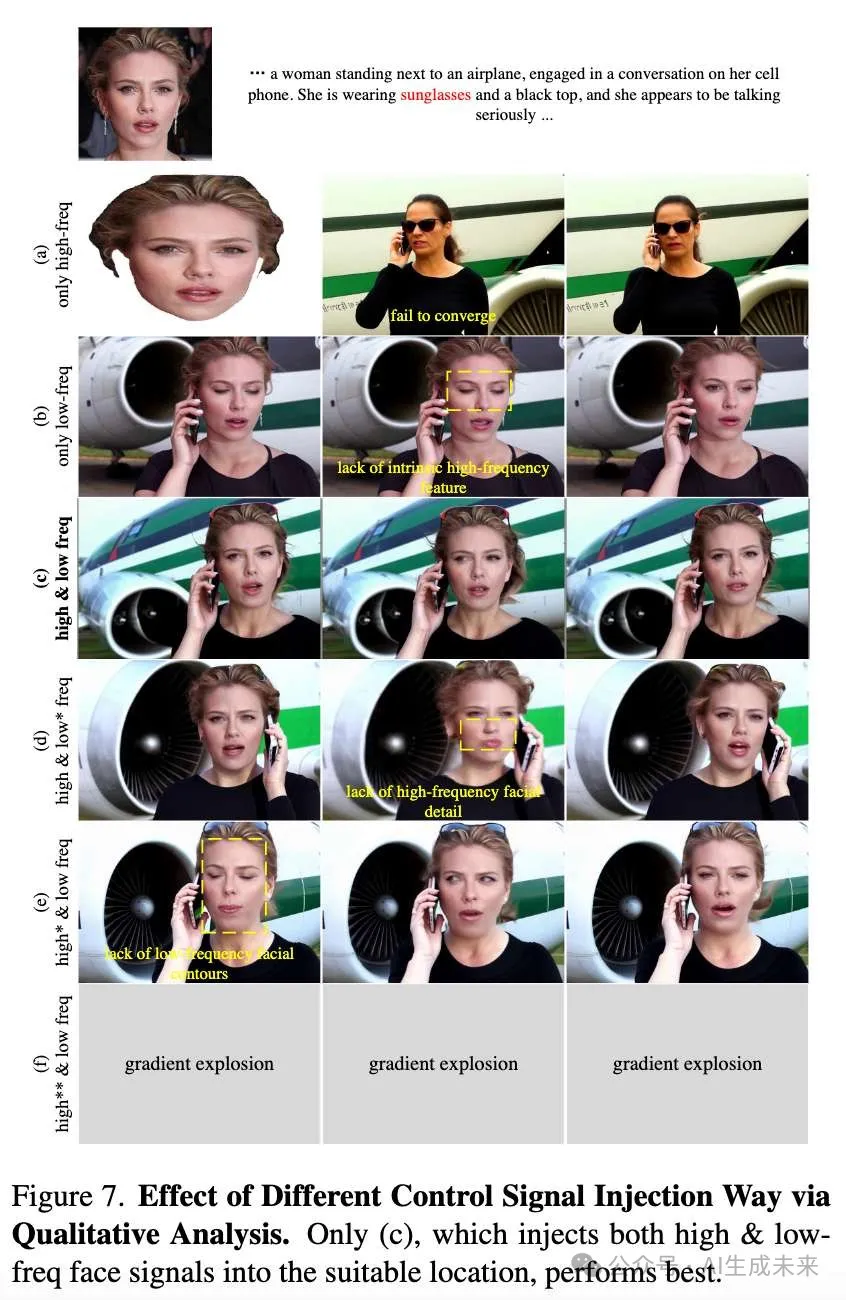

身份信号注入对 DiT 的影响

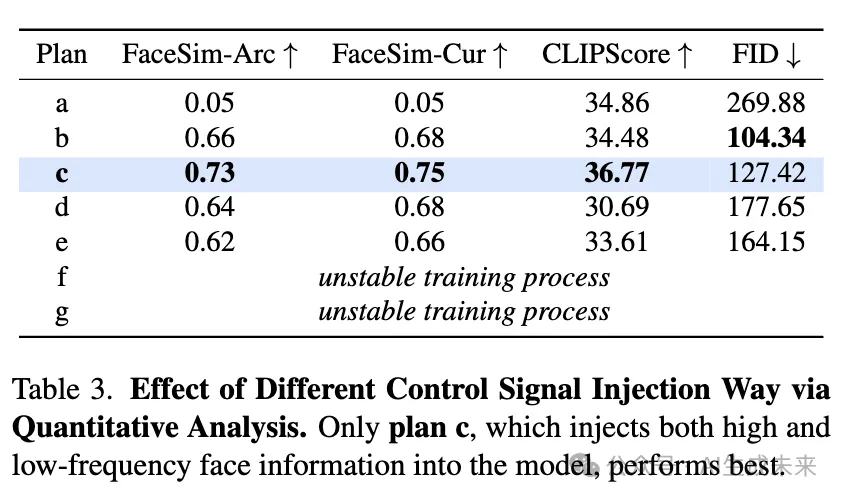

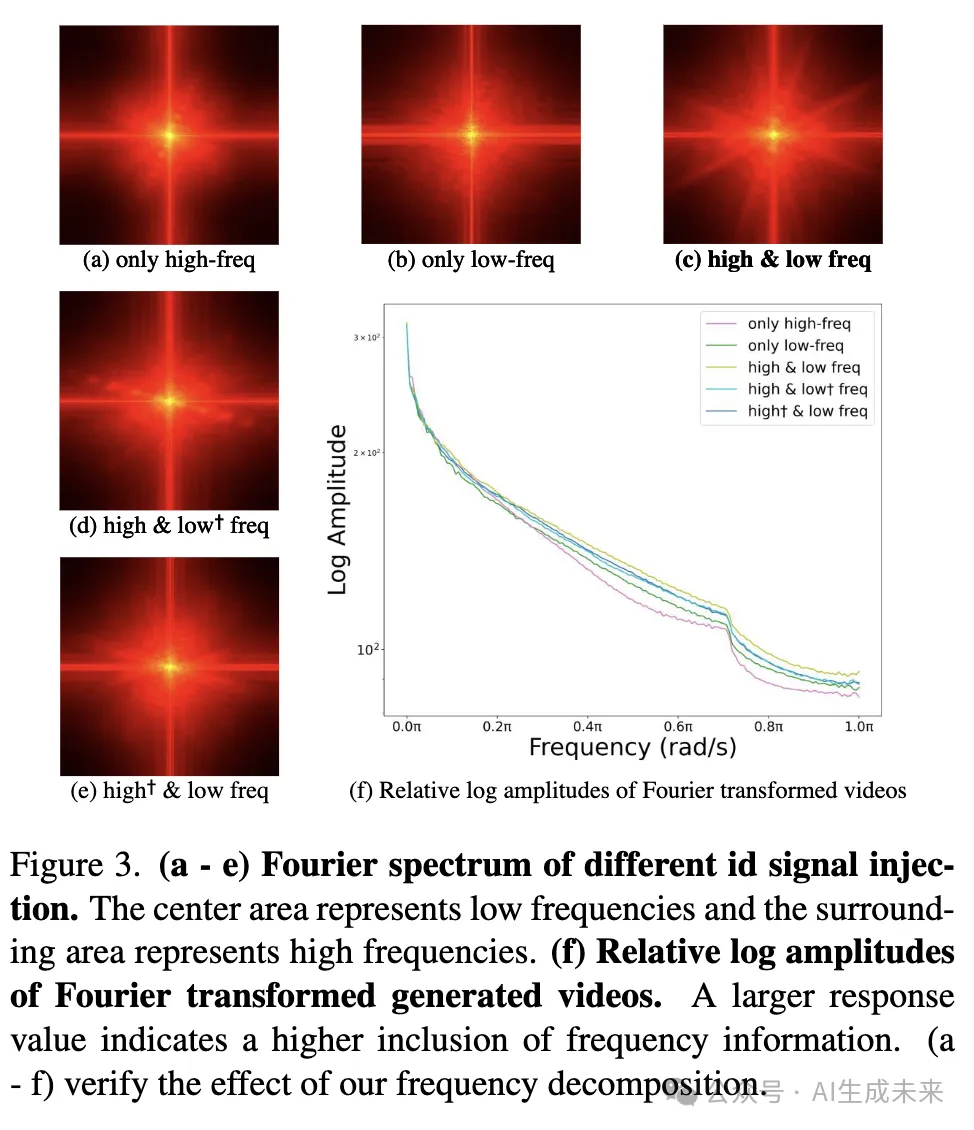

为了评估发现1和发现2的有效性,对不同的信号注入方法进行了消融实验。具体来说,这些实验包括:(a)仅将低频面部信息和关键点注入噪声潜在空间,(b)仅将高频面部信号注入注意力块,(c)结合(a)和(b),(d)基于(c),但低频面部信息不包含关键点,(e - f)基于(c),但高频信号注入到注意力块的输入或输出,(g)仅将高频面部信号注入注意力块之前。结果如下图7和表3所示。

对于发现1,观察到仅注入高频信号(a)会大大增加训练难度,导致模型由于缺乏低频信号注入而无法收敛。此外,加入面部关键点(d)使得模型能够更多地关注低频信息,从而促进训练并提高模型性能。

对于发现2,当仅注入低频信号(b)时,模型缺乏高频信息。这种对低频信号的依赖使得生成的视频中的面部直接复制参考图像,难以通过提示控制面部表情、动作和其他特征。此外,将身份信号注入到注意力块输入(f - g)会打乱 DiT 的频域分布,导致梯度爆炸。将控制信号嵌入到注意力块(c)中,比将其嵌入到输出(e)中更优,因为注意力块主要处理低频信息。通过内部嵌入高频信息,注意力块能够突出内在的面部特征,而将其注入输出仅仅是特征的拼接,无法引导关注,降低了 DiT 的建模能力。

此外,对生成的视频(仅面部区域)应用了傅里叶变换,以视觉比较不同组件对面部信息提取的影响。如下图3所示,傅里叶谱和傅里叶变换的对数幅度显示,注入高频或低频信号确实增强了生成面部的相应频率信息。此外,低频信号通过与面部关键点的匹配可以进一步增强,而将高频信号注入注意力块具有最高的特征利用率。本文的方法(c)展示了最强的高频和低频,进一步验证了发现1和发现2带来的效率提升。为了减少开销,我们对每个身份仅选择了2个参考图像进行评估。

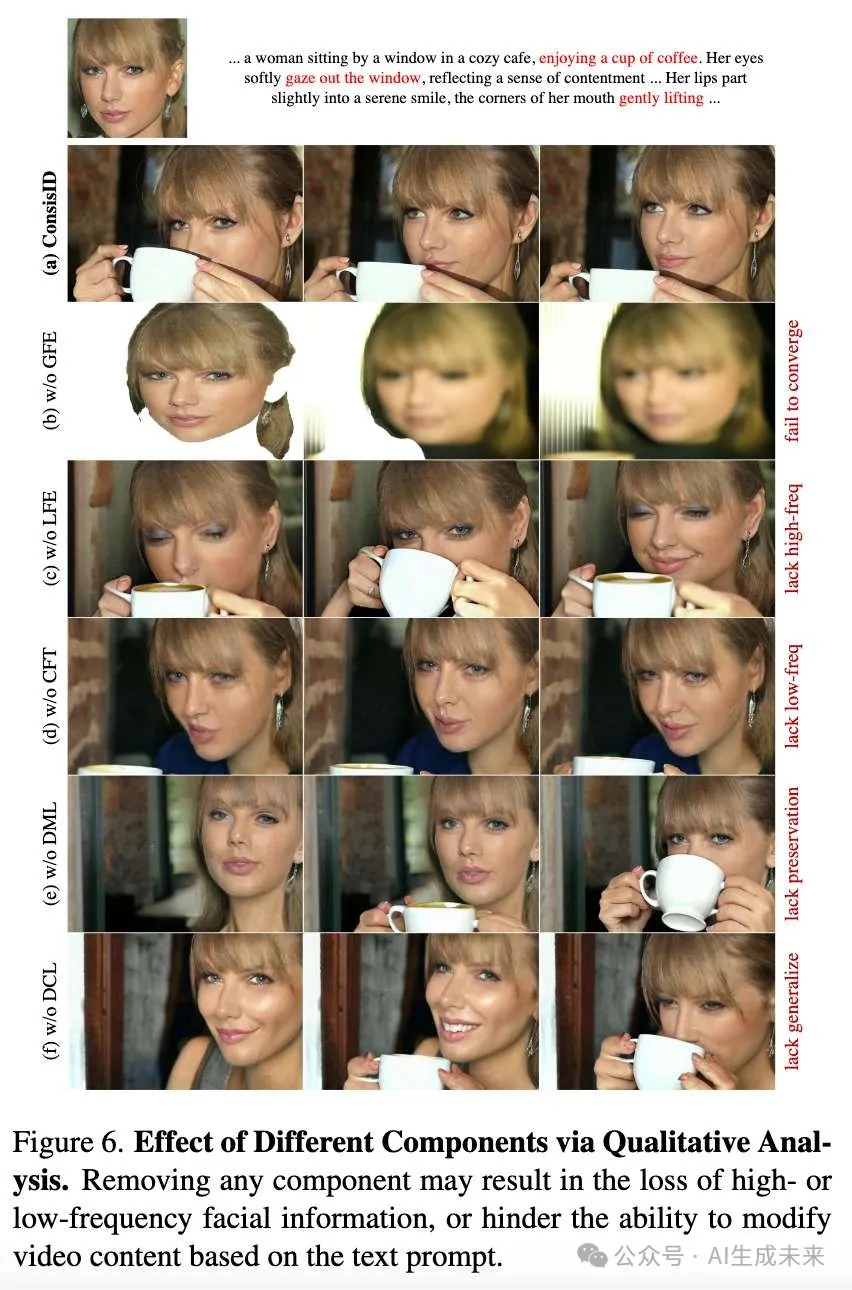

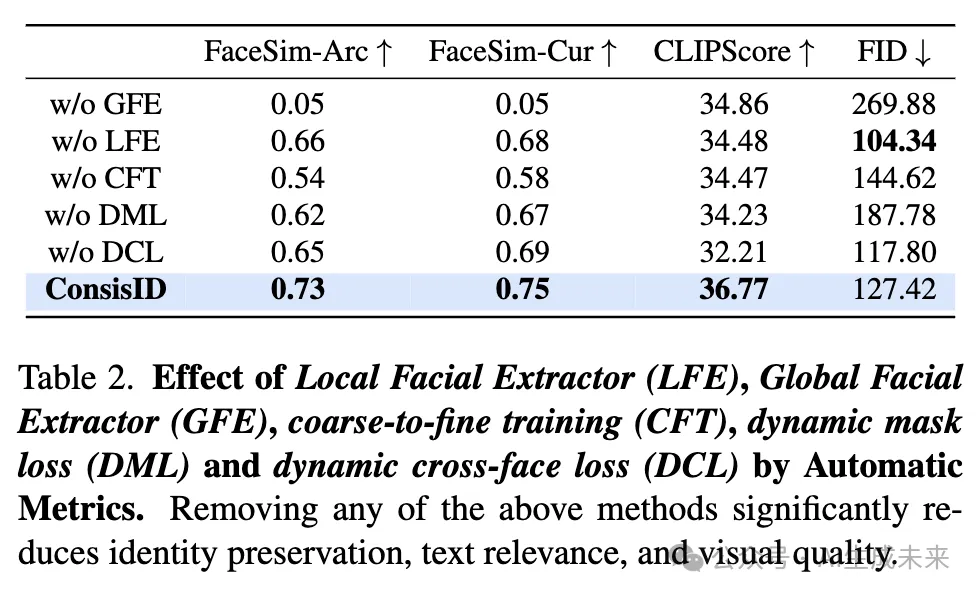

一致性训练策略的消融实验

为了减少开销,在以下实验中为每个身份仅选择2个参考图像。为了证明所提出的一致性训练策略的好处,对粗到精训练(CFT)、动态Mask损失(DML)和动态跨脸损失(DCL)进行了消融实验,结果如下图6和表2所示。去除CFT时,GFE和LFE表现出竞争行为,导致模型无法准确优先处理高频和低频信息,进而使得模型收敛到次优点。去除DML使得模型必须同时关注前景和背景元素,背景噪声对训练产生负面影响,降低了面部一致性。同样,去除DCL削弱了模型的泛化能力,降低了面部的忠实度,特别是对于训练集之外的人物,影响了生成符合身份保持的视频效果。

反转步数量的消融实验

为了评估反转步数量变化对模型性能的影响,在ConsisID的推理阶段进行了一项消融研究。鉴于计算资源的限制,从评估数据集中随机选择了60个提示。每个提示与一个唯一的参考图像配对,生成60个视频用于每种设置。通过固定的随机种子,在t值为25、50、75、100、125、150、175和200的范围内变化反转步骤参数。结果如图8和表4所示。尽管理论预期表明增加反转步骤数量会持续提升生成质量,但我们的研究表明,生成质量呈现非线性关系,质量在t = 50时达到峰值,之后下降。具体而言,在t = 25时,模型生成的面部轮廓不完整;在t = 75时,模型未能生成上身衣物;超过t = 125时,模型丧失了重要的低频面部信息,导致面部特征失真;超过t = 150时,视觉清晰度逐渐下降。推测去噪过程的初期阶段主要由低频信息主导,如生成面部轮廓,而后期阶段则专注于高频细节,如面部内在特征。t = 50是平衡这两个阶段的最佳设置。

结论

ConsisID,一个通过频率分解保持面部一致性的视频生成统一框架。它能够无缝集成到现有的基于DiT的文本到视频(T2V)模型中,用于生成高质量、可编辑、符合身份保持要求的视频。大量实验表明,ConsisID超越了当前最先进的身份保持T2V模型。研究结果表明,基于频率感知的DiT控制方案是IPT2V生成的最佳解决方案。

限制与未来工作

现有的度量标准无法准确衡量不同ID保持模型的能力。尽管ConsisID能够根据文本提示生成真实自然的视频,但诸如CLIPScore 和FID等度量标准与以前的方法差异不大。一个可行的方向是寻找一种与人类感知更匹配的度量标准。

本文转自AI生成未来 ,作者:AI生成未来

原文链接:https://mp.weixin.qq.com/s/HAoPAf2t1GHMGPKtJoaZ4Q