M3DocRAG:文档问答用哪个多模态大模型效果最好?

1. 文档视觉问答现状

文档视觉问答(DocVQA)是通过解读文档图像所含信息来回答文本问题的多模态任务。精准高效地回答众多冗长且布局繁杂的文档中的问题,会给金融、医疗保健和法律等诸多领域带来极大益处,在这些领域,文档AI助手能够简化大量文档的日常处理,提升生产力,助力更快、更明智的决策。

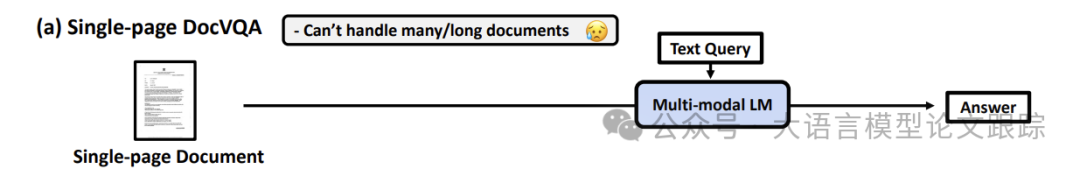

现有的DocVQA任务,主要有以下两种方案:

• 1.聚焦于单页文档的视觉问答,如下图。

图片

图片

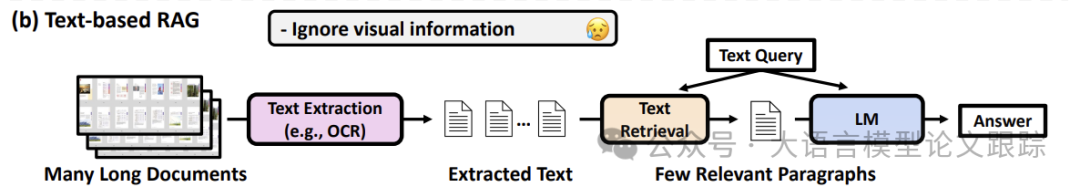

• 2.从文档中提取文本(比如OCR或PDF文本提取)并运用检索增强生成(RAG),即检索模型找出相关段落,语言模型依据段落回答问题(如下图)。

图片

图片

但是,这两类方案在真实文档理解场景中运用存在以下两方面问题:

• 问题往往需要跨越不同页面或文档的信息,现有的VQA方法难以处理众多长文档;

• 部分文档具有复杂的视觉格式,像表格、图表和混合布局,可诸如OCR这类的文本提取方法会忽略这些细微之处,致使文档解读不完整或不准确。

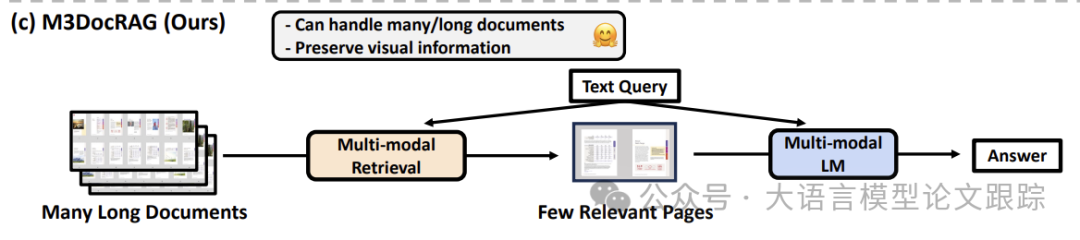

2. 什么是M3DOCRAG?

为了突破以上DocVQA方法的局限性,作者推出了M3DOCRAG(Multi-modal Multi-page Multi-DocumentVisual Question Answering,多模态多页多文档检索增强生成):一个新的多模态RAG框架,能够灵活适应各类文档情境(封闭域和开放域)、问题跳转(单跳和多跳)以及内容形式(文本、图表、图形等)。

图片

图片

如上图,M3DOCRAG框架借助多模态检索模型检索相关文档页面,并利用多模态语言模型(MLM)从检索到的页面生成问题答案。

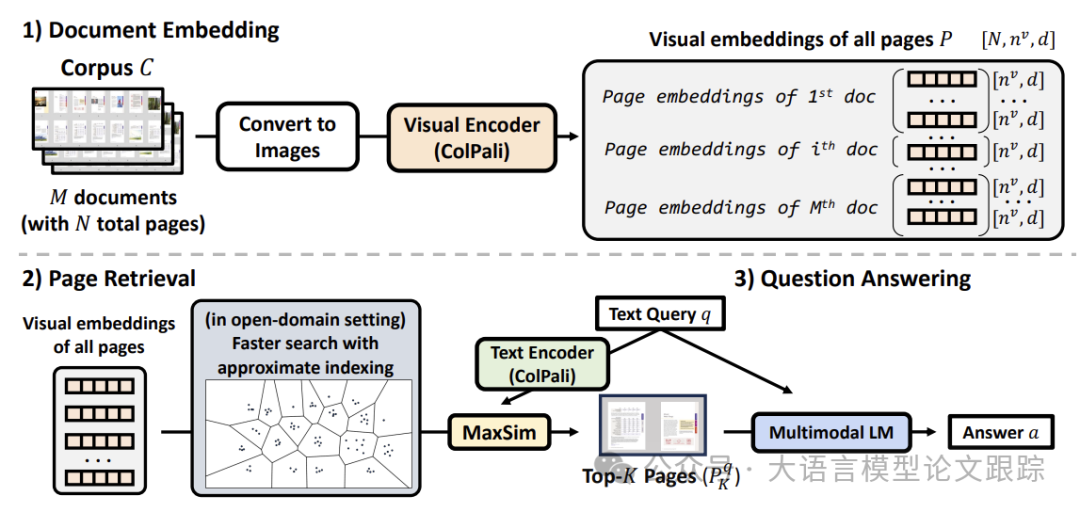

M3DOCRAG分三个阶段运作:

• 文档嵌入阶段:把所有文档页面转为RGB图像,并从页面图像中提取视觉嵌入(例如 ColPali)。

• 页面检索阶段:用文本查询检索相似度高的前K个页面。对于开放域设置,创建近似页面索引,比如倒排文件索引(IVF),以加快搜索速度。

• 问答阶段:使用MLM进行视觉问答以获取最终答案。也请参考图3了解框架的详细情况。M3DOCRAG能够灵活处理封闭域(单个文档)和开放域(大量文档的语料库)设置中的DocVQA。

图片

图片

2.1. 文档嵌入(Document Embedding)

在 M3DOCRAG 中,文本查询与页面图像通过 ColPali 投射至一个共享的多模态嵌入空间。将文本和图像输入编码为统一的向量表示,并检索出前 K 个最相关的图像。

为提升效率,对文档的每个页面进行独立处理。使得能够将文档语料库中的所有页面展平为一个单页级嵌入张量。

M3DOCRAG 能够灵活适应不同的检索设置,比如单页文档、含多个页面的单个文档以及大型多页文档语料库。

2.2. 页面检索(Page Retrieval)

查询Q与页面P之间的相关性通过 MaxSim 分数来计算。

开放域页面检索的近似索引:在大型文档语料库中搜索页面往往耗时且计算成本高。当期望更快的搜索速度时,基于 Faiss 离线创建页面索引,通过应用近似最近邻搜索。

封闭域页面检索:采用精确搜索,在开放域设置中使用倒排文件索引(IVF)(Faiss 中的 IVFFlat),在搜索 40K 个页面时,能将页面检索延迟从 20 秒/查询降低至不到 2 秒/查询。

2.3. 问答

将文本查询Q和检索到的页面图像P提供给多模态语言模型,以实现视觉问答并获取最终答案。

为此,运用多模态语言模型(比如 Qwen2-VL ),其包含视觉编码器和语言模型 LM 。

视觉编码器把检索到的K个页面图像当作输入,输出视觉嵌入(与 ColPali 编码器的输出有别)。语言模型把查询Q的视觉嵌入和文本嵌入当作输入,以自回归的方式输出最终答案。

3. 效果如何?

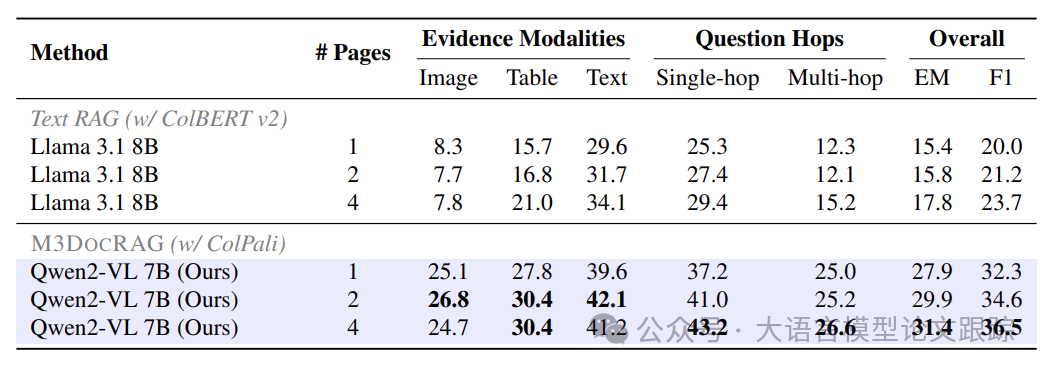

3.1 开放领域文档视觉问答

图片

图片

上图展示了M3DOCVQA的评估结果:多模态 RAG 比文本 RAG 表现更出色,尤其是在非文本证据来源方面。

M3DOC RAG(ColPauli + Qven2-VL 7B)在所有不同的证据模式/问题跳转/# 页面上,都大幅领先于文本 RAG(ColBERT v2 + Llama 3.1 8B)。

当证据包含图像时,性能差距尤为显著,表明 M3DOCRAG 解决了纯文本管道在处理非文本内容时的信息丢失问题。

为文本 RAG 和 M3DOC RAG 提供更多检索到的页面作为上下文,通常会提升其性能(使用前 4 页比前 1 页和 2 页的性能更高)。

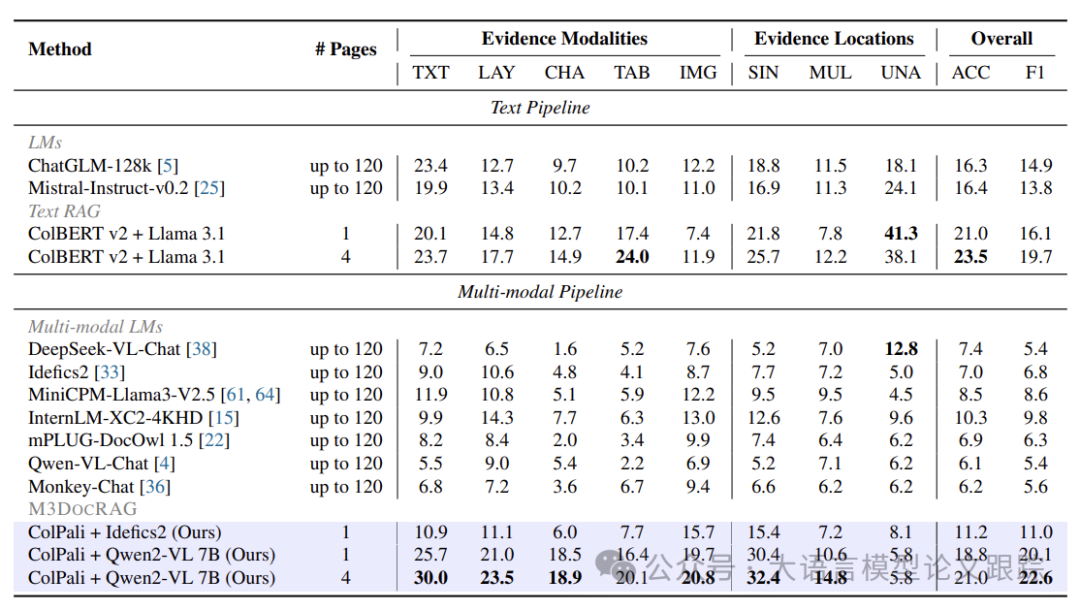

3.2. 封闭域文档视觉问答

图片

图片

上表展示了封闭域文档VQA的评估结果,涵盖五种证据源模态(文本(TXT)、布局(LAY)、图表(CHA)、表格(TAB)和图像(IMG))以及三种证据位置(单页(SIN)、跨页(MUL)和无法回答(UNA))的综合准确率(ACC)。

多模态 RAG 增强了 MLM 对长文档的理解能力。在 MM Long Bench-Doc 中,模型需处理每个问题所对应的长 PDF 文档(多达 120 页)。鉴于许多多模态 LM 的上下文长度有限,采用了一种拼接策略,将所有截图页面组合成 1 个或 5 个图像,并将这些拼接后的图像输入到多模态 LM 中。

结果表明:

• ColPali + Idefics2 超越了不含 RAG 的 Idefics2 以及之前所有的多模态条目。

• VolPauli + QWP2–VL 7B 在整体 F1 和大多数证据模态/页面设置中斩获最佳分数。多模态检索在处理多页时相较于通过拼接低分辨率图像更为有效。

• 为文本 RAG 和 M3DOC RAG 提供更多检索页面作为上下文通常会提升性能(使用前 4 页比前 1 页性能更优)。

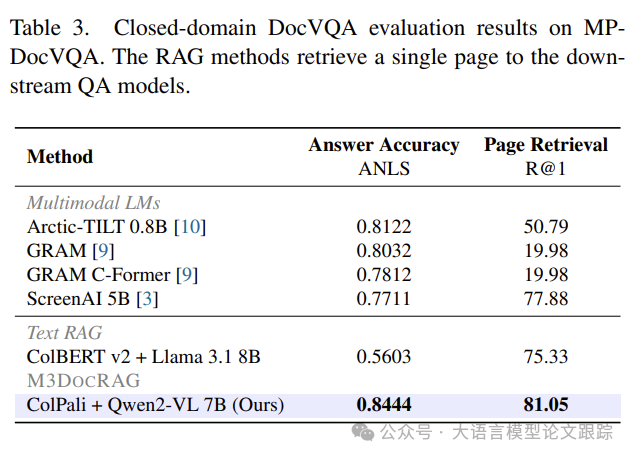

图片

图片

• M3DOC RAG 在 MP-DocVQA 中达到了顶尖水平。在 MP-DocVQA 中,模型必须针对每个问题处理多达 20 页的 PDF 文档。

• 虽然文本 RAG(ColBERT v2 + Llama 3.1)逊于现有方法,但所有多模态 RAG 管道均优于其基于文本的对应项。

• M3DOC RAG 管道(ColPali + Qwen2-VL 7B)在 MP-DocVQA 上取得了领先成果。

3.3. 额外分析

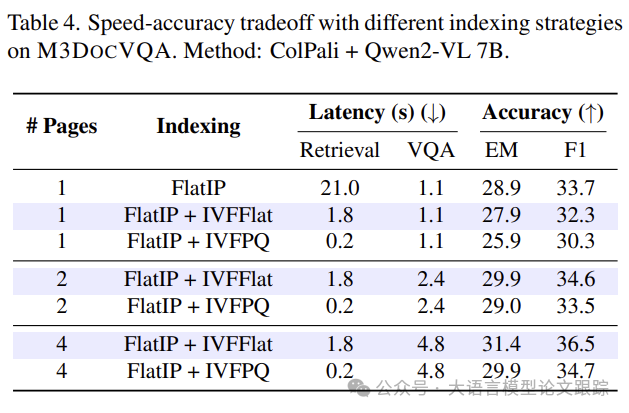

3.3.1 不同页面索引的速度与准确性

图片

图片

对 ColPali+Qwen2-VL 7B 管道采用不同文档嵌入索引方法时的速度和准确性进行了分析。

虽说采用精确搜索的朴素索引(FlatIP)速度较慢(每个查询 21 秒),但像倒排文件(IVFFlat)和乘积量化(IVFPQ)这类近似索引,既能保留大部分准确性,又能大幅提升搜索速度(每个查询<2 秒)。

M3DOCRAG 默认使用 FlatIP + IVFFlat 索引,用户可依据部署需求选择适宜的索引方法。

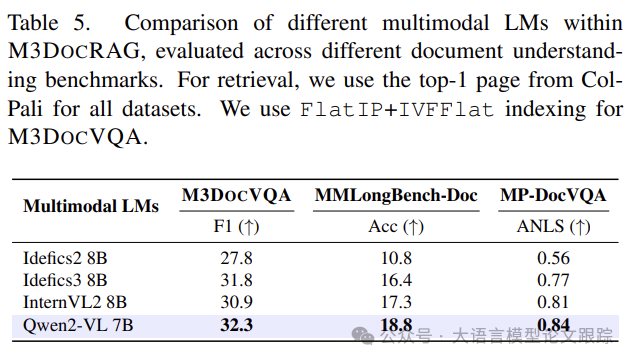

3.3.2 不同的多模态语言模型

图片

图片

对四种不同的多模态语言模型进行了比较,分别是 Idefics2 8B、Idefics3 8B、InternVL2 8B 和 Qwen2-VL 7B 。

Qwen2-VL 7B 模型在所有三项基准测试中均优于其他多模态语言模型。所以,将其作为默认的多模态语言模型组件。

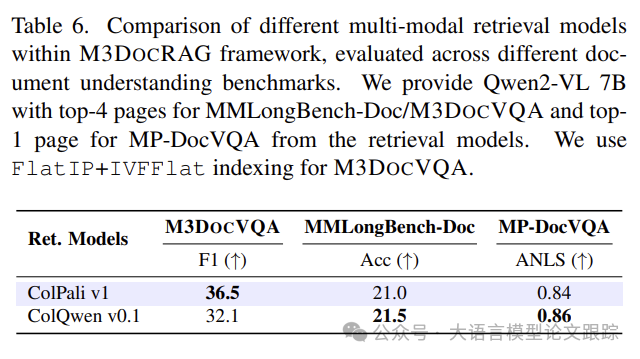

3.3.3 不同的多模态检索模型

图片

图片

对两种不同的多模态检索模型加以比较,即 ColPali v1 和 ColQwen v0.1。这两个模型均以相同的训练目标进行训练,但分别以不同的多模态语言模型架构进行初始化,即 PaliGemma 2B 和 Qwen2-VL 2B 。

ColPali 表现显著更优,而 ColQwen 在 MPDocVQA 和 MM Long Bench-Doc 中的表现略好。因此,将 ColPali 作为默认的检索模型。

本文转载自大语言模型论文跟踪,作者:HuggingAGI