腾讯发布全新混元大模型Hunyuan-Large:全球最大开源Transformer模型,助力AI发展新高度 原创

01、概述

近年来,大型语言模型(LLM)已成为许多人工智能系统的核心支撑,从自然语言处理(NLP)到计算机视觉,再到科学研究领域,LLM的应用无处不在。然而,伴随着AI需求的激增,LLM的规模和计算需求也迅速增加。这些庞大的模型在训练和推理时资源消耗极大,推动研究者们不断探索更高效的模型架构。在此背景下,**专家混合模型(Mixture of Experts, MoE)**成为了备受关注的解决方案,它通过选择性地激活不同的模型部分以提升性能。尽管MoE模型前景广阔,但真正大规模开源的MoE模型却寥寥无几,这在一定程度上限制了AI领域的创新和实际应用。

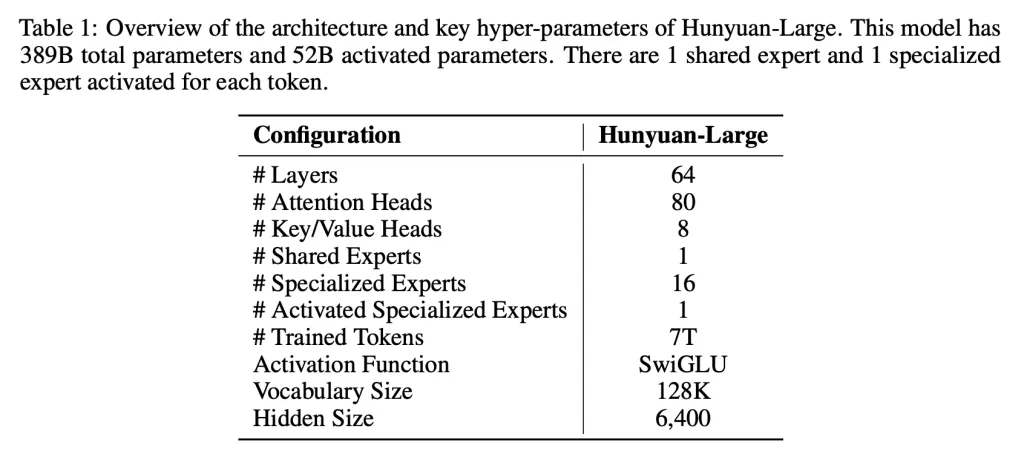

腾讯此次发布的Hunyuan-Large,是目前业界最大的开源Transformer架构MoE模型。其总参数量高达3890亿,其中活跃参数量为520亿。这款模型不仅支持长达256K个token的超大上下文处理,还在技术层面上实现了众多创新,能够在自然语言处理及通用AI任务上取得优异的表现,甚至在某些方面超越了业界领先的模型,如LLama3.1-70B和LLama3.1-405B。Hunyuan-Large的发布对于AI研究和应用领域而言意义重大,它不仅为开发者和研究者提供了强大的资源,还在AI性能与规模性之间取得了良好的平衡,为行业创新提供了新的可能。

02、技术突破:混元大模型的核心亮点

1. 海量数据预训练,适应多领域需求

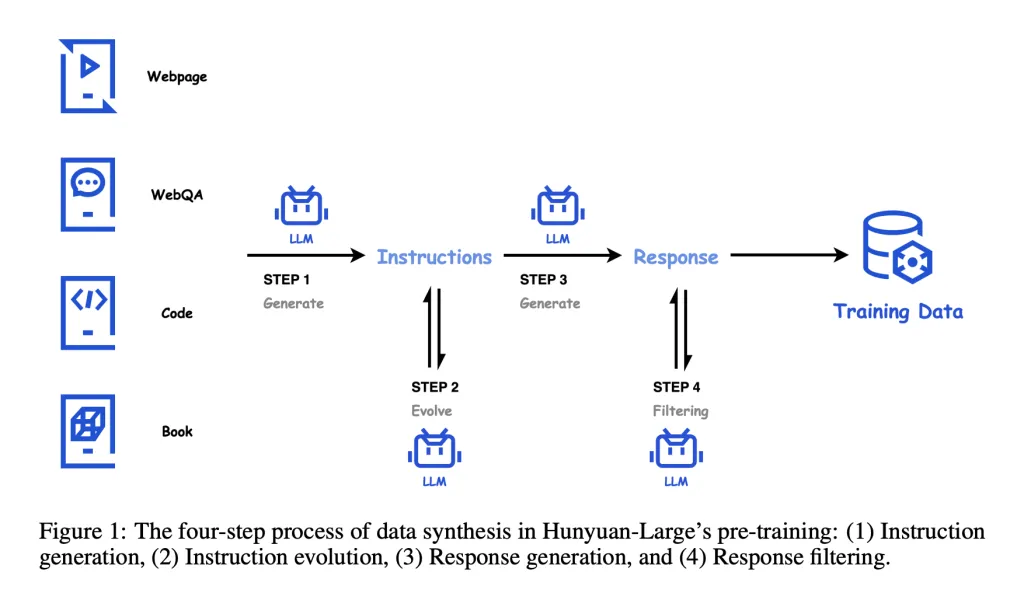

为了赋予模型广泛的通用性,Hunyuan-Large在预训练阶段采用了七万亿个token的数据,其中包含1.5万亿条合成数据,涵盖数学、编程、多语言等领域。这种多样化的数据大幅提升了模型的泛化能力,使其在不同领域的表现更加出色,尤其在与其他同规模模型的对比中展现了明显优势。

2. 专家路由策略优化:提升性能与效率

混元大模型在架构设计上引入了混合专家路由策略。这种方法根据任务需求智能选择激活的模型组件,避免不必要的资源消耗,从而提升计算效率。每个“专家”模块能够根据任务需求独立训练和优化,这种分布式学习策略显著增强了模型在处理不同任务时的精度和速度。

3. KV缓存压缩:降低内存负担

在模型推理过程中,内存开销常常是一个瓶颈。腾讯在Hunyuan-Large中创新性地采用了KV缓存压缩技术,有效降低了推理阶段的内存占用。这一技术使得模型能够在不牺牲响应质量的前提下显著提升扩展性,为超大规模LLM的高效部署奠定了基础。

4. 专家特定学习率:精细化的训练机制

Hunyuan-Large的另一个亮点在于引入了专家特定学习率的机制。此设计允许模型中的不同组件根据其任务难度和复杂度调整学习速率,使得共享组件与专家模块之间的负载分配更加均衡。这种精细化的训练策略不仅提高了模型的收敛效率,也进一步提升了Hunyuan-Large在处理复杂任务时的表现。

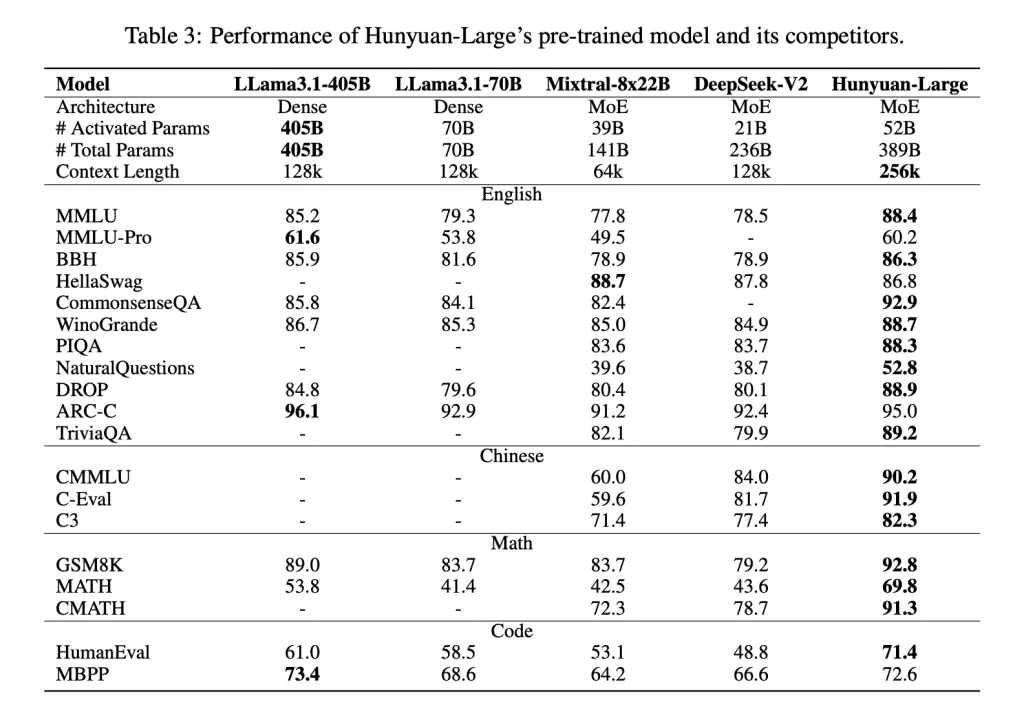

03、性能测试:领先的NLP任务表现

Hunyuan-Large的技术优势在多项NLP任务测试中得到了验证。根据多个基准测试结果,该模型在问答、逻辑推理、编程、阅读理解等任务上都表现优异。例如,在被广泛认可的MMLU(多任务语言理解)测试中,Hunyuan-Large取得了88.4分,明显超越了LLama3.1-405B的85.2分。这一结果显示了Hunyuan-Large不仅在活跃参数较少的情况下实现了高效训练,还在长文本处理能力上填补了现有LLM的不足。

Hunyuan-Large的优势尤为适合需要长上下文理解的应用场景,例如文档分析、法律文本理解、科学研究等领域。这些任务通常涉及大量信息的汇总和精确分析,混元大模型的长上下文处理能力为这些高需求应用提供了强大的技术支撑。

04、开放的研发平台:为AI社区注入新活力

与众多封闭的大模型不同,Hunyuan-Large的开源特性使其成为业界关注的焦点。腾讯提供了完整的开源代码库和预训练检查点,为开发者、研究者提供了灵活的研发资源,便于进一步探索和定制化应用。开源不仅是技术共享的表现,更是促进AI社区协同发展的重要一步。

通过开放的研发平台,Hunyuan-Large为AI从业者和科研人员提供了更多实验的可能性,尤其是在资源有限的小团队中,这一模型的高效架构和开源特性极具价值。研究人员可以在此基础上进一步优化或结合特定应用场景,开发出符合自身需求的AI工具,推动技术的多样化应用。

05、对AI未来发展的意义:Hunyuan-Large的创新价值

Hunyuan-Large的发布不仅展示了腾讯在AI技术领域的领先优势,也为全球AI创新树立了新的标杆。3890亿参数的规模和KV缓存压缩、专家特定学习率等技术创新,为解决大型模型计算资源需求过高的问题提供了切实可行的方案。这款模型的开源不仅是腾讯推动AI开放生态的重要一步,更是推动全球AI技术应用的重大贡献。

未来,随着Hunyuan-Large在各领域的实际应用,预计会涌现出更多基于该模型的创新应用,如智能客服、精准推荐、内容生成等。这些应用不仅能提升用户体验,也将进一步验证混元大模型的技术优势。作为新一代开源大型语言模型的代表,Hunyuan-Large无疑会引领AI技术进入更广泛、更高效的发展轨道。

06、结语

腾讯此次发布的Hunyuan-Large混元大模型,凭借其3890亿的庞大参数、精细的专家路由策略和KV缓存压缩等技术亮点,展现了顶尖的AI性能和扩展性。这款开源模型不仅为技术开发者和研究者提供了强大的工具,也为AI领域的创新发展注入了新的活力。在未来的AI生态系统中,Hunyuan-Large将成为推动技术进步的关键力量。

参考:

- https://github.com/Tencent/Tencent-Hunyuan-Large

- https://huggingface.co/tencent/Tencent-Hunyuan-Large

- https://arxiv.org/pdf/2411.02265

本文转载自公众号Halo咯咯 作者:基咯咯