清华团队提出精确学习新方法,提升AI泛化能力

引言:探索精确学习的重要性

在少样本学习领域,如何使模型从有限的数据中学习到精确且具有泛化能力的知识,是一个挑战也是研究的热点。传统的元学习方法,如模型无关的元学习(MAML)及其变体,虽然在快速适应新任务方面表现出色,但仍存在一些问题,如模型倾向于学习简单的、直接的特征(如颜色、背景等),这些特征在元训练阶段足以区分极少数的类别,但却不利于模型的泛化能力。

为了解决这一问题,本文提出了“精确学习”的概念,旨在使模型能够从数据中学习到精确的目标知识,减少噪声知识如背景和噪声的影响。通过这种方式,我们希望模型不仅能快速适应新任务,还能在面对各种变化和干扰时,保持稳定和高效的学习性能。

论文标题、机构、论文链接和项目地址

- 论文标题: Learn To Learn More Precisely

- 机构: Tsinghua Shenzhen International Graduate School, Tsinghua University; CUHK-Shenzhen; Fudan University; Guangdong Laboratory of Artificial Intelligence and Digital Economy (SZ)

- 论文链接: https://arxiv.org/pdf/2408.04590.pdf

精确学习的概念介绍

1. “学习更精确”概念的提出

在元学习领域中,尽管如模型无关元学习(MAML)及其变体在快速适应和小样本学习任务中取得了显著成效,但这些模型仍倾向于学习简单的特征(如颜色、背景等),这导致了泛化能力较差。为了解决这一问题,本文提出了“学习更精确”的概念,旨在使模型从数据中学习精确的目标知识,减少噪声知识(如背景和噪声)的影响。

2. 精确学习与传统元学习的区别

传统的元学习,如基于度量的元学习和基于优化的元学习,主要关注于快速适应和泛化能力的提升。然而,这些方法在元测试阶段往往不涉及微调,意味着模型学习的是更通用的特征而非如何学习。精确学习的提出,是为了使模型能够从训练数据中学习到更加精确和核心的知识,而不是简单或噪声的知识。

Meta Self-Distillation (MSD) 方法详解

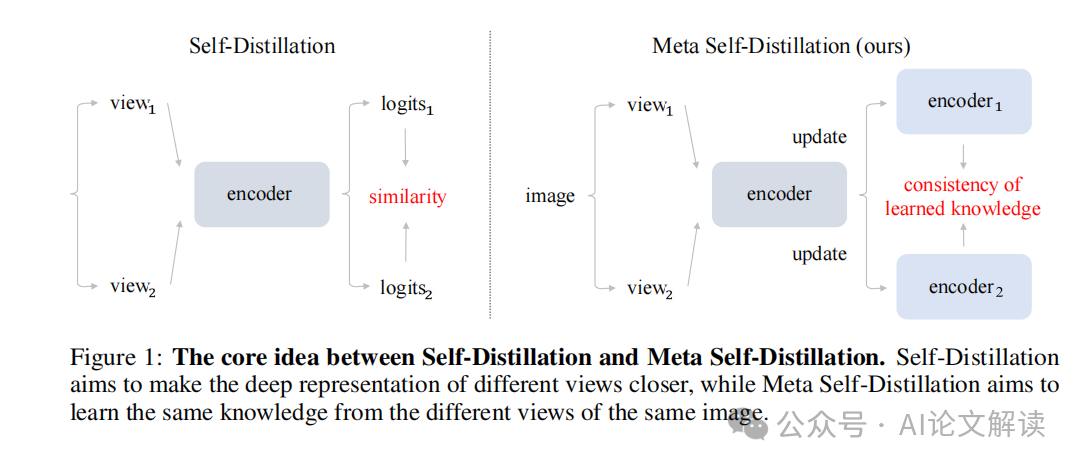

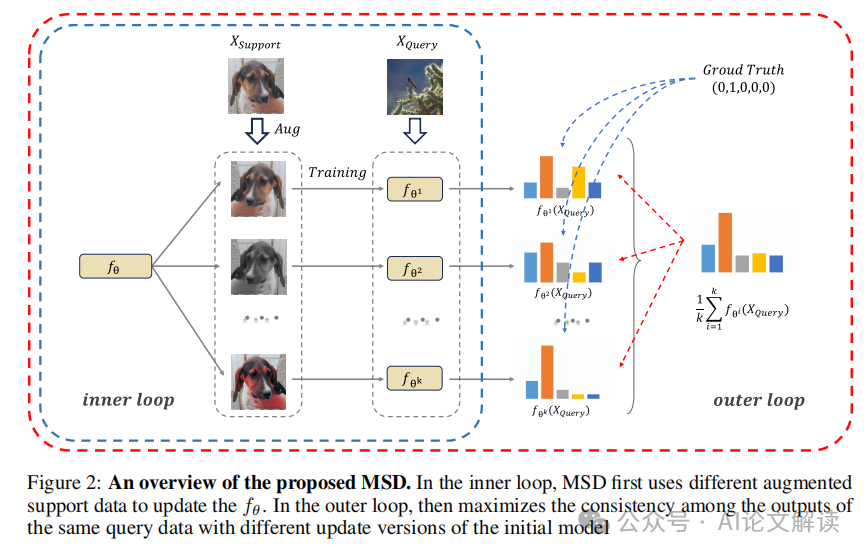

1. MSD的工作原理与流程

Meta Self-Distillation(MSD)是一种简单有效的元学习框架,通过最大化学习知识的一致性来增强模型学习精确目标知识的能力。在内循环中,MSD使用同一支持数据的不同增强视图分别更新模型。然后在外循环中,MSD使用相同的查询数据来优化学习知识的一致性,从而提升模型的精确学习能力。

2. 不同视角增强数据的一致性最大化

在MSD中,通过对同一支持数据应用不同的数据增强方法,生成不同的视角,然后在这些视角上训练得到不同的模型参数。在外循环中,使用相同的查询数据测试这些不同参数更新版本的模型,通过最大化这些输出的一致性,来确保从不同视角学到的知识是一致的。

3. 使用余弦相似度衡量学习的一致性

在MSD方法中,使用余弦相似度来衡量不同模型输出间的一致性。这种方法能有效地评估模型是否能从不同的数据视角中学习到相同的核心知识,从而提高学习的精确性。通过这种方式,MSD在多个小样本分类任务中显示出了卓越的性能,显著提高了模型学习知识的准确性和一致性。

实验设置与数据集介绍

1. 使用的基准数据集

在本研究中,我们主要评估了两个标准数据集:MiniImageNet 和 Tiered-ImageNet,这两个数据集广泛用于少样本学习的评估。MiniImageNet 数据集包含 100 个类别,每个类别有 600 个样本,这些样本是 84×84 像素的彩色图像。根据以往的研究,我们将这 100 个类别分为训练集、验证集和测试集,分别包含 64、16 和 20 个类别。Tiered-ImageNet 数据集包含 608 个类别,共 779,165 张图像。这些细粒度的类别被分为 34 个更高级别的类别。与以往的研究一致,我们将这些更高级别的类别分为训练集、验证集和测试集,分别包含 20、6 和 8 个更高级别的类别。Tiered-ImageNet 在划分数据集时考虑了类别间的相似性,确保训练和测试数据之间有显著的分布差异。

2. 模型架构与训练细节

在模型评估中,我们遵循了先前的研究,采用了 ResNet-12 架构,该架构以其更宽的宽度和 Dropblock 模块而闻名。此外,我们还遵循了原始的 MAML 方法,使用了一个 4 层卷积神经网络(Conv4)。根据最近的实践,模型的权重在整个元训练集上进行了预训练以初始化。

实验结果与分析

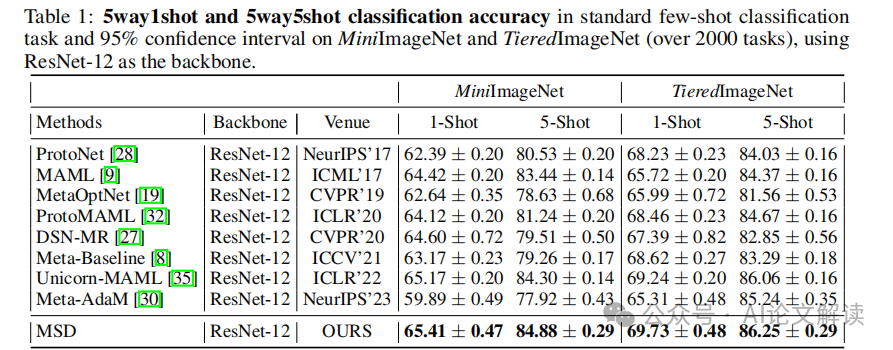

1. 标准少样本学习问题的表现

在 MiniImageNet 上,我们的方法在 5way1shot 和 5way5shot 任务中分别实现了 0.99% 和 1.44% 的准确率提升。在 Tiered ImageNet 上,5way1shot 和 5way5shot 任务的改进分别为 4.11% 和 1.61%。MSD 在少样本任务中表现出色,与最近的元学习算法和 MAML 的变体相比,性能更佳。

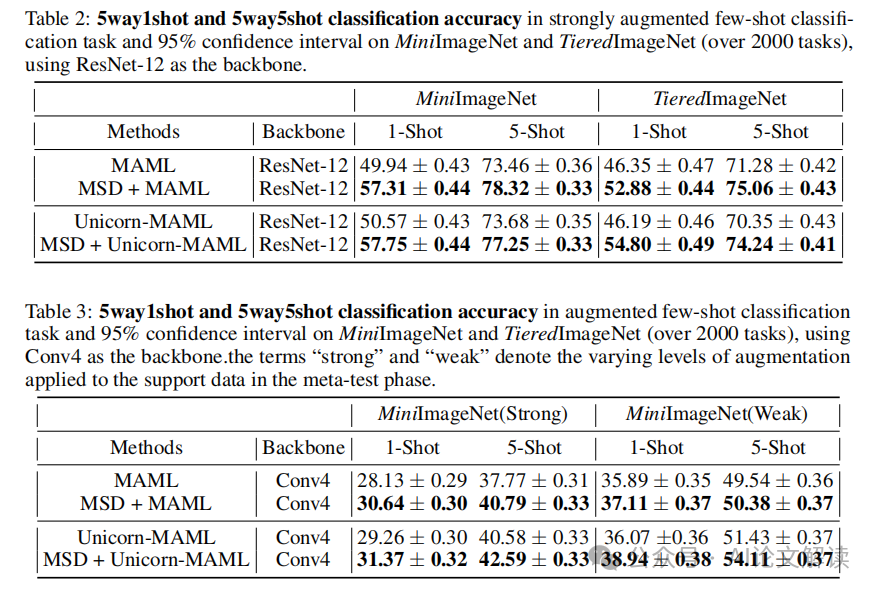

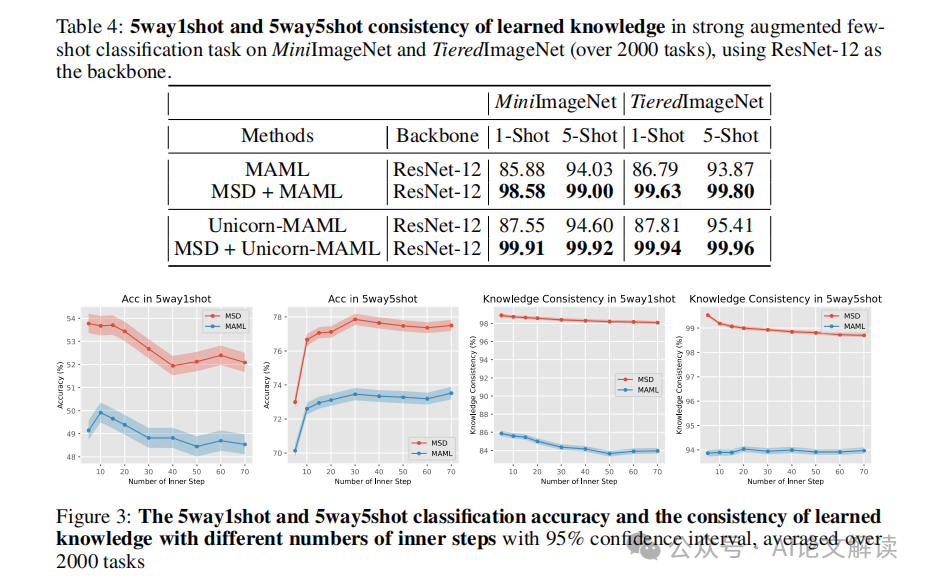

2. 增强少样本学习问题的表现

在增强任务中,我们通过增强支持数据来微调模型,然后使用更新的模型对查询数据进行分类。无论支持数据的扰动是弱还是强,MSD 都在分类准确率上大约提高了 2%。在使用 ResNet-12 的 MiniImageNet 和 Tiered ImageNet 数据集上,MSD 在 5way1shot 任务中大约提高了 7% 的准确率,在 5way5shot 任务中提高了约 4%。

3. 学习一致性的量化结果

我们通过计算不同模型版本对同一查询数据输出的余弦相似度来量化学习的一致性。结果显示,无论是 MAML 还是其变体 MAML-Unicorn,在 5way1shot 场景中都倾向于学习有偏见的知识,一致性大约为 86%。在 5way5shot 场景中,模型表现出较少的假设冗余,从而提高了学到的知识的一致性,大约为 94%。我们提出的 Meta Self-Distillation (MSD) 方法显著增强了模型提取精确知识的能力,在两个数据集的 5way1shot 和 5way5shot 问题中,知识的一致性约为 99%。

消融研究

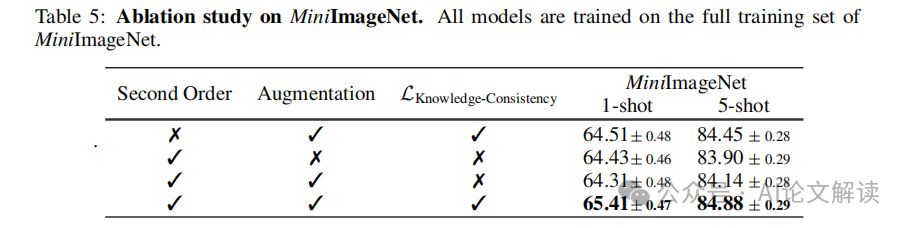

1. 各组件对模型性能的影响

在Meta Self-Distillation (MSD)的研究中,消融研究显示了不同组件对模型性能的具体影响。根据表5的数据,我们可以看到使用二阶导数、支持数据的数据增强以及MSD的知识一致性损失是三个主要因素。其中,知识一致性损失在支持数据经过数据增强后的效果显著,如果没有数据增强,这种损失的效果则会大打折扣。这表明MSD的性能提升主要来自于知识一致性损失的优化。

2. 不同内部步骤对精确学习能力的影响

MSD模型在不同内部步骤的设置下对模型的精确学习能力有显著影响。如图3所示,不同内部步骤数对5way1shot和5way5shot任务的分类准确率和知识一致性都有影响。结果显示,MSD在任何给定的内部步骤数下都能比MAML表现出更好的性能。特别是在知识一致性方面,MSD能够在较少的内部步骤下保持约99%的一致性,显著超过MAML模型。

可视化分析

1. 增强数据训练模型的可视化

在增强数据训练模型的可视化分析中,我们使用了Grad-CAM++技术来观察MSD和MAML模型在处理增强支持数据后的行为差异。如图4所示,MAML模型在训练时倾向于关注周围环境,可能会优先于分类对象,而MSD模型则更多地关注用于分类的对象。这种可视化分析帮助我们理解了MSD如何通过关注正确的特征来提高模型的精确学习能力。

2. MSD与MAML模型的对比

通过对比MSD和MAML模型在标准和增强的少样本学习任务中的表现,我们可以更直观地看到MSD在提高模型精确学习能力方面的优势。在增强的少样本场景中,MSD在5way1shot和5way5shot任务中分别提高了约7%和4%的准确率,这一结果在表2中有所体现。此外,从知识一致性的角度,MSD也展示了更高的一致性,达到了约99%,这一数据在表4中得到了证实。这些对比分析结果清楚地展示了MSD在处理复杂和变化的数据环境中,相较于MAML,能更有效地提升模型的学习精度和稳定性。

结论与未来展望

1. MSD方法的优势与应用潜力

Meta Self-Distillation (MSD) 方法在少样本学习领域表现出显著的优势。通过在内循环中使用同一支持数据的不同增强视图更新模型,以及在外循环中利用相同的查询数据优化学到的知识的一致性,MSD极大地提高了模型学习精确目标知识的能力。实验结果显示,MSD在标准和增强的少样本分类任务中均优于许多最新的少样本分类算法。在增强场景下,MSD在5way1shot和5way5shot问题中分别实现了7.42%和4.03%的平均改进。

此外,MSD通过最大化同一查询数据在不同更新模型中输出的一致性,提高了模型的精确学习能力。这种方法不仅提高了分类的准确性,还通过一致性度量(如余弦相似度)确保了学到的知识的质量,这在传统的元学习方法中是不常见的。

2. 对未来研究方向的建议

尽管MSD已经取得了令人瞩目的成果,但未来的研究可以在以下几个方向进行深入:

- 扩展到更大规模的模型和数据集:当前的MSD实验主要集中在小规模的网络和数据集上。未来的工作可以探索将MSD应用于更大的网络架构和更复杂的数据集,以验证其在更广泛应用中的效果。

- 探索自监督学习领域的应用:MSD的自我蒸馏特性使其有潜力在自监督学习任务中发挥作用。未来的研究可以探索如何将MSD集成到自监督学习框架中,以提高无标签数据的学习效率和效果。

- 增强模型的泛化能力:虽然MSD在提高模型的精确学习能力方面表现出色,但如何进一步增强模型对新领域和新任务的泛化能力仍是一个值得探索的问题。未来的研究可以通过引入新的正则化技术或优化策略来解决这一挑战。

- 优化计算效率:MSD方法涉及多个模型的更新和一致性检验,这可能会带来较高的计算成本。研究如何减少计算资源的消耗,同时保持模型性能,是实现MSD更广泛应用的关键。

通过以上建议的研究方向,我们可以进一步推动MSD方法的发展,使其在多个领域中发挥更大的影响力。

本文转载自 AI论文解读,作者:柏企