【深度探索】FlashAttention-3:深度学习注意力机制的再进化

一、引言

在深度学习技术的浪潮中,Transformer模型凭借其强大的自注意力机制,在自然语言处理、计算机视觉等多个领域取得了显著成效。然而,随着数据规模的增大和模型复杂度的提升,Transformer模型的计算效率和内存占用问题日益凸显。为了应对这一挑战,研究人员不断探索更加高效、精确的注意力机制。今天,我们将为大家介绍一项最新的研究成果——FlashAttention-3,它通过创新的算法设计和硬件加速技术,实现了深度学习注意力机制的再进化。

二、FlashAttention-3的背景与动机

在FlashAttention-3之前,已经有FlashAttention和FlashAttention-2两个版本的成果。它们通过减少GPU内存读写次数和优化计算流程,显著提升了Transformer模型的计算效率。然而,随着数据序列长度的不断增加,FlashAttention-2在处理超长序列时仍然面临一定的性能瓶颈。此外,现有的注意力机制在计算过程中往往没有充分利用GPU的硬件特性,如异步计算和低精度量化等,这进一步限制了模型性能的提升。

三、FlashAttention-3的核心技术

3.1 异步计算与warp专业化

FlashAttention-3通过引入异步计算和warp专业化技术,进一步提升了计算效率。它利用GPU的并行计算能力,将注意力计算过程中的不同步骤分配给不同的warp(GPU中的线程组),并通过异步通信实现数据交换和结果汇总。这种设计不仅减少了计算过程中的等待时间,还充分利用了GPU的计算资源,实现了更高的计算吞吐量。

3.2 低精度量化

为了降低内存占用和计算复杂度,FlashAttention-3采用了低精度量化技术。它通过对查询(Q)、键(K)和值(V)进行量化处理,将原始的浮点数表示转换为低精度表示(如FP8),从而在保证模型性能的同时显著降低了内存占用和计算量。此外,为了减小量化带来的误差,FlashAttention-3还采用了随机正交矩阵进行预处理,以“分散”异常值并减少量化误差。

3.3 硬件加速与指令优化

FlashAttention-3还充分利用了现代GPU的硬件加速能力和指令优化技术。它针对NVIDIA Hopper等最新一代GPU架构进行了深度优化,通过利用GPU的寄存器动态分配、矩阵乘法加速单元(如Tensor Core)等特性,实现了更高效的计算和更低的内存访问延迟。此外,FlashAttention-3还通过指令级优化和代码重构等技术手段,进一步提升了计算效率和代码可读性。

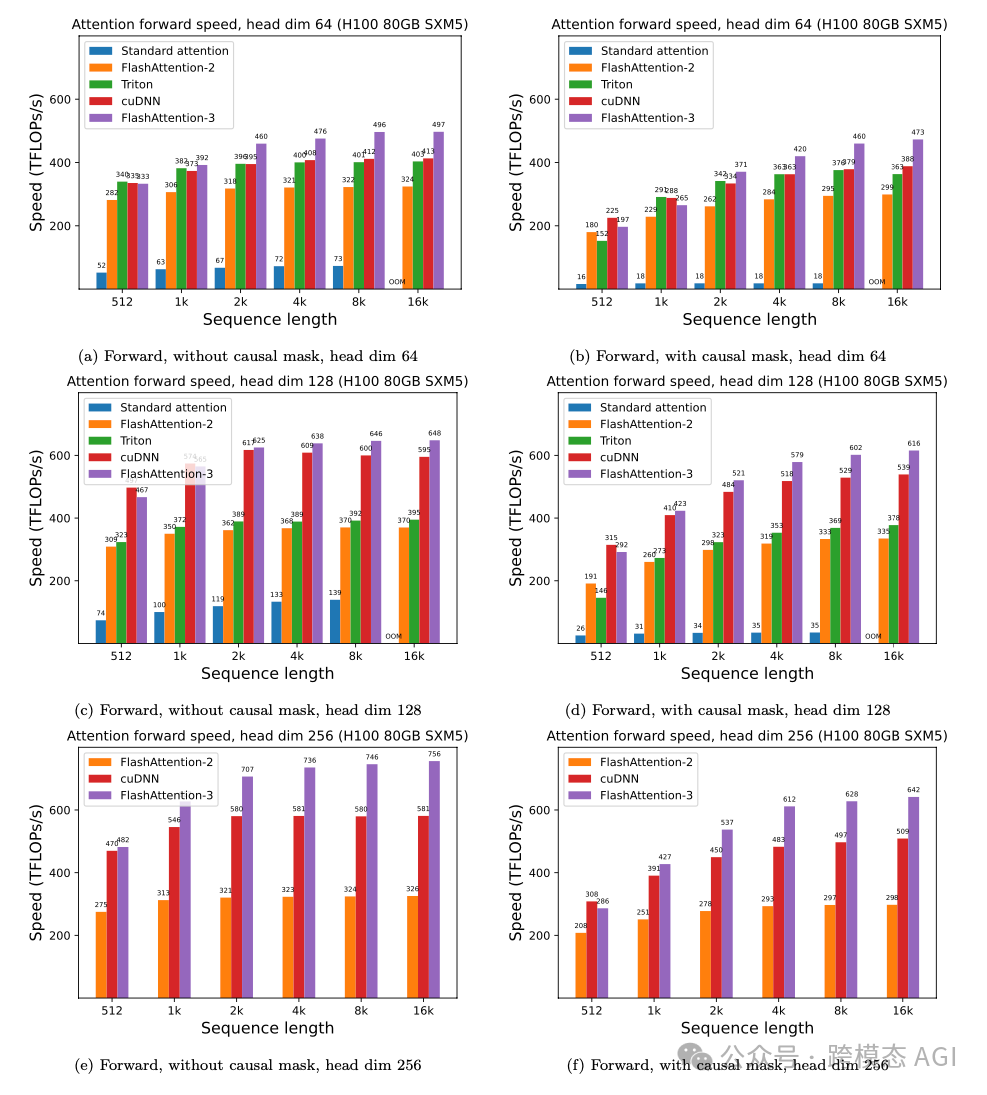

四、FlashAttention-3的实验验证与性能评估

为了验证FlashAttention-3的有效性和性能优势,研究人员进行了大量的实验验证和性能评估。实验结果表明,与标准的注意力实现相比,FlashAttention-3在保持模型精度不变的前提下,实现了显著的计算加速和内存占用降低。特别是在处理超长序列和大规模数据集时,FlashAttention-3的性能优势更加明显。此外,FlashAttention-3还与PyTorch和Hugging Face等主流深度学习框架进行了集成和适配,为广大研究人员和开发者提供了更加便捷、高效的使用体验。

五、总结与展望

FlashAttention-3作为深度学习注意力机制的一项最新研究成果,通过引入异步计算、低精度量化和硬件加速等创新技术,实现了计算效率和内存占用的双重优化。它不仅为Transformer模型的训练和推理提供了更加强大的支持,也为深度学习领域的发展注入了新的活力和动力。未来,随着技术的不断进步和应用场景的不断拓展,我们有理由相信FlashAttention-3将在更多领域发挥重要作用,推动深度学习技术的持续发展和创新。

本文转载自 跨模态 AGI,作者: clip