INTELLECT-1:全球首个去中心化训练的 10B 参数大模型

近日,Prime Intellect 团队发布了全球首个由全球协作训练的 10B 参数语言模型——INTELLECT-1 。这一突破性成果不仅标志着大规模模型训练不再局限于大型企业,而是可以通过分布式、社区驱动的方式实现,为未来的 AI 发展开辟了新的道路。

项目亮点

INTELLECT-1 的成功训练涉及五大洲、五个国家,同时使用了 112 台H100 GPU,由全球 30 位贡献者共同完成。这一壮举不仅展示了分布式训练的巨大潜力,还实现了高计算利用率:在美国境内达到 96%,跨洋训练也有 83%的效率,整个训练过程仅耗时 42 天。

技术细节

INTELLECT-1 基于 Llama-3 架构,拥有 42 层、 4,096 个隐藏维度、 32 个注意力头和 8,192 的序列长度。模型训练使用了 1万亿个 token 的数据集,包括 FineWeb-Edu 、Stack v2 等多种数据源。

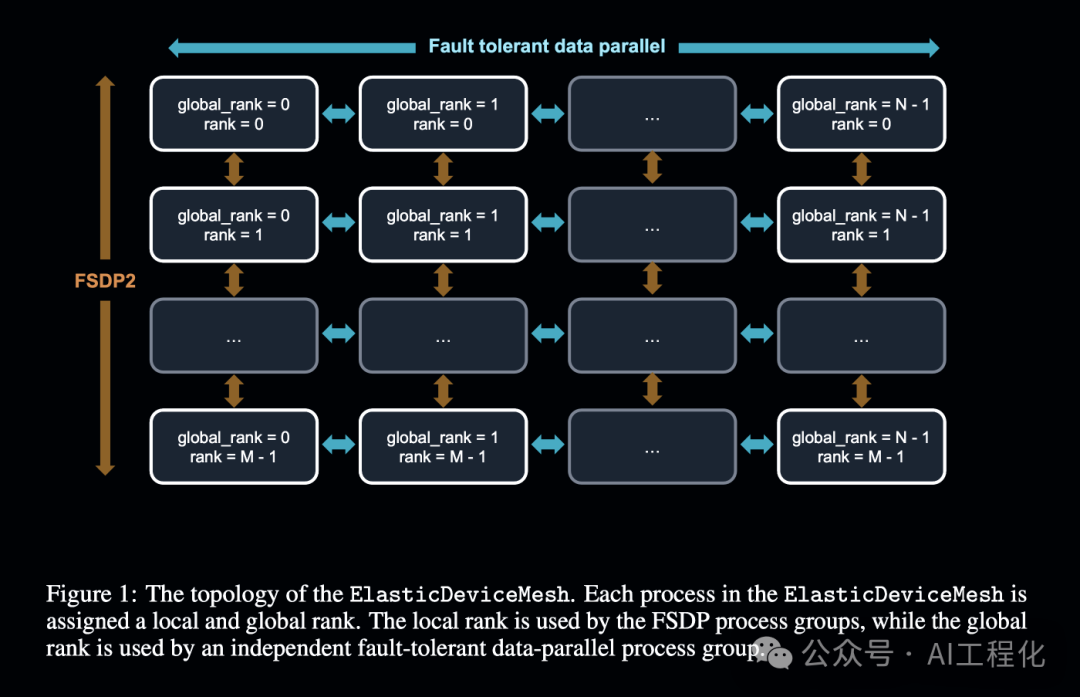

Prime Intellect 团队开发的 PRIME 框架是这一项目的核心。该框架包括ElasticDeviceMesh,用于动态管理全球和本地进程组,确保通信的容错性;还实现了 live checkpoint recovery 和hybrid DiLoCo-FSDP2,大幅降低了通信带宽需求。

同时,Prime Intellect 慷慨的开源了所有相关资源:

- 详细技术报告:https://github.com/PrimeIntellect-ai/prime/blob/main/INTELLECT_1_Technical_Report.pdf

- INTELLECT-1 基础模型、检查点和后训练模型:https://huggingface.co/PrimeIntellect/INTELLECT-1-Instruct

在线聊天体验:https://chat.primeintellect.ai/,

- 预训练数据集:https://huggingface.co/collections/PrimeIntellect/intellect-1-dataset-6704f3d3a9dee8678da3d407

- 后训练数据集:https://huggingface.co/datasets/arcee-ai/EvolKit-75K

- PRIME 框架:https://github.com/PrimeIntellect-ai/prime

小结

开放、去中心是模型民主化的最重要的一步,INTELLECT-1 已经做到了。我们期待Prime Intellect 能够进一步优化分布式训练架构,跟上主流模型的模型性能表现,更早落地应用。

本文转载自AI工程化,作者: ully