一文彻底搞懂机器学习 - 分类(Classification) 原创

分类(Classification)是机器学习中的一种有监督学习任务,其目标是根据输入数据的特征将数据点分配到预定义的类别中。

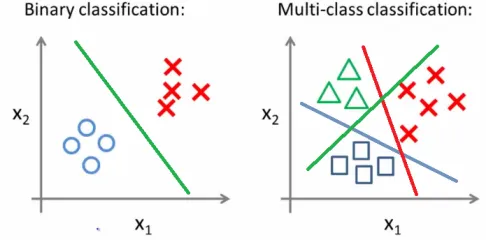

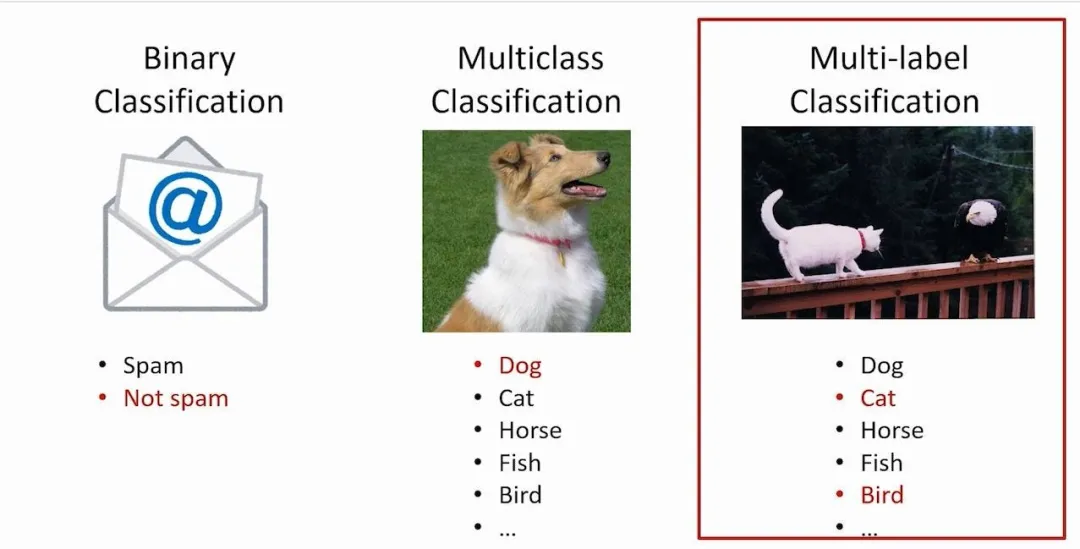

二分类、多类分类、多标签分类和多输出分类是机器学习中的四种重要分类问题。其中二分类区分两个类别,多类分类选择多个类别中的一个,多标签分类允许一个样本拥有多个标签,而多输出分类则为每个类别提供独立的输出值或概率。

Classification

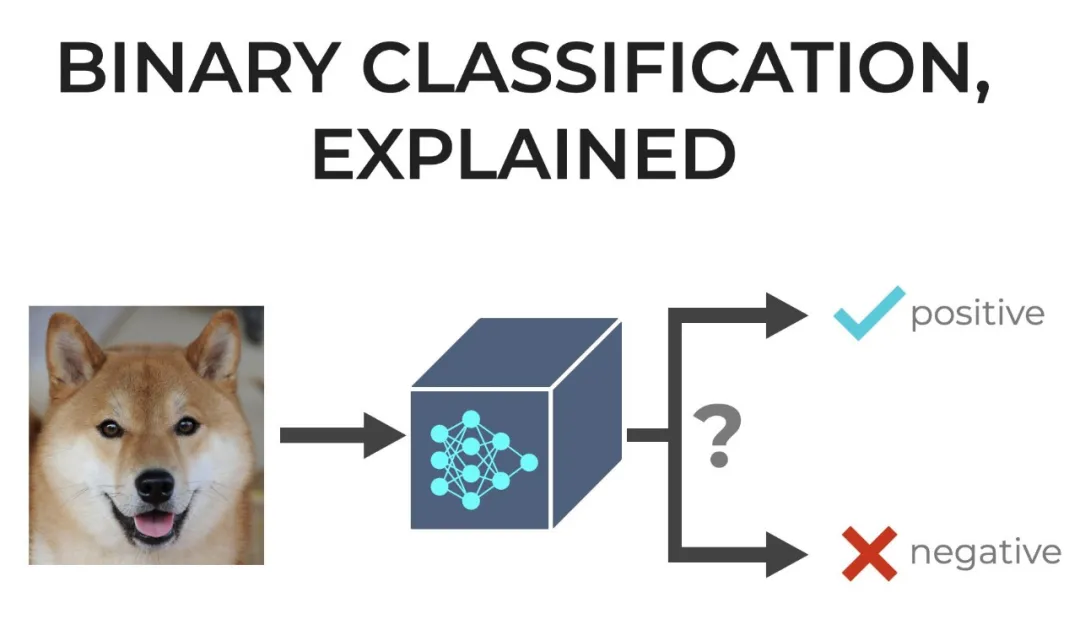

一、二分类

二分类(Binary Classification)是什么?二分类是机器学习中最基本的分类问题之一,它将数据集中的样本划分为两个互斥的类别。二分类任务的目标是预测一个样本属于两个类别中的哪一个。

二分类应用场景有哪些?垃圾邮件检测(邮件是垃圾邮件还是非垃圾邮件)、疾病诊断(患者是否患病)、信用评分(个人信用是否达标)等。

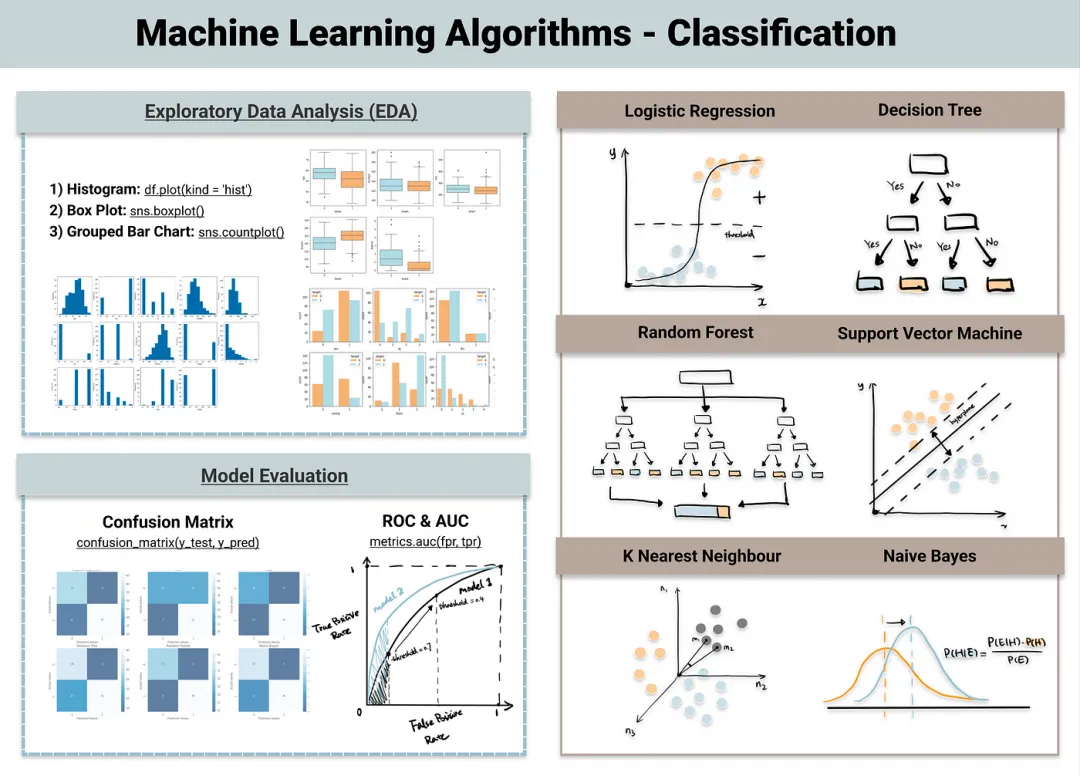

二分类常见算法有哪些?逻辑回归、支持向量机(SVM)等。

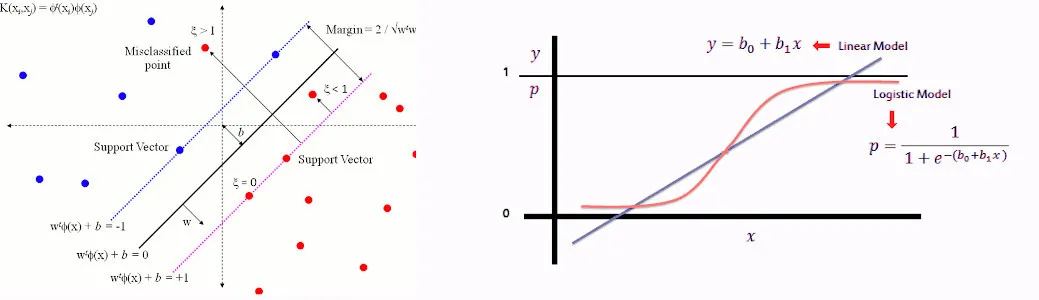

逻辑回归用阈值判断实现二分类,适合线性和非线性数据;支持向量机找最优超平面分类,对线性不可分数据用核函数处理,泛化能力强。

- 逻辑回归(Logistic Regression):将线性模型的输出映射到0和1之间,通过阈值判断来进行二分类。

- 支持向量机(Support Vector Machine, SVM):在特征空间中找到一个最优的超平面来实现分类。对于线性不可分的数据,可以通过核函数将其映射到高维空间,从而变得线性可分。

二、多类分类

多类分类(Multi-class Classification)是什么?多类分类问题是指数据集中的样本可以被划分为多个类别,并且每个样本只能属于一个类别。多类分类任务的目标是预测一个样本属于多个类别中的某一个。

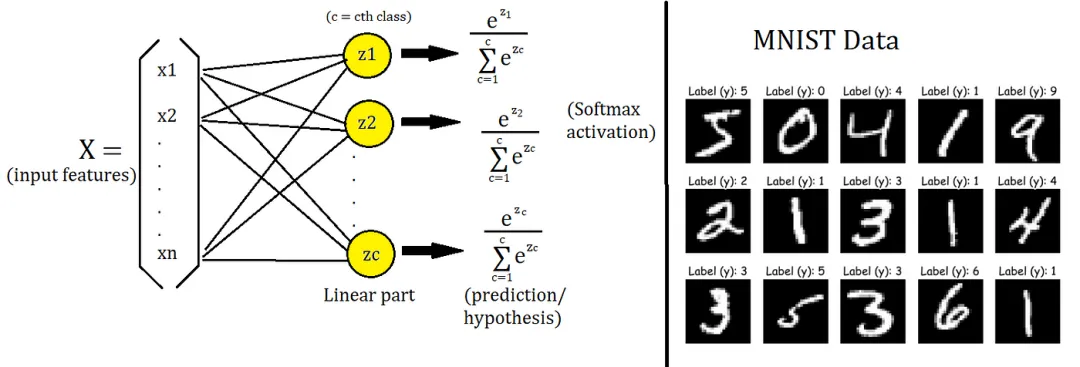

多类分类应用场景有哪些?手写数字识别(0-9的数字)、物体识别(猫、狗、兔等)、文本分类(新闻、体育、科技等)等。

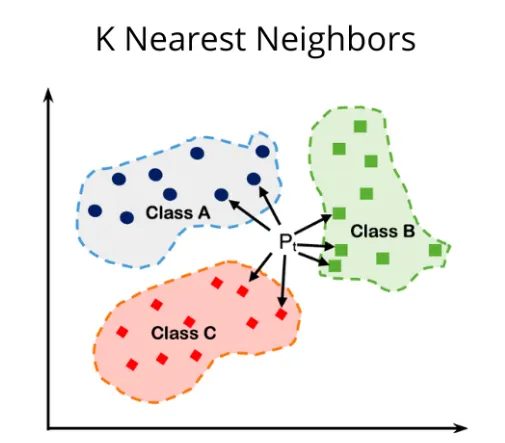

多类分类常见算法有哪些?Softmax回归、k-近邻(k-NN)等。

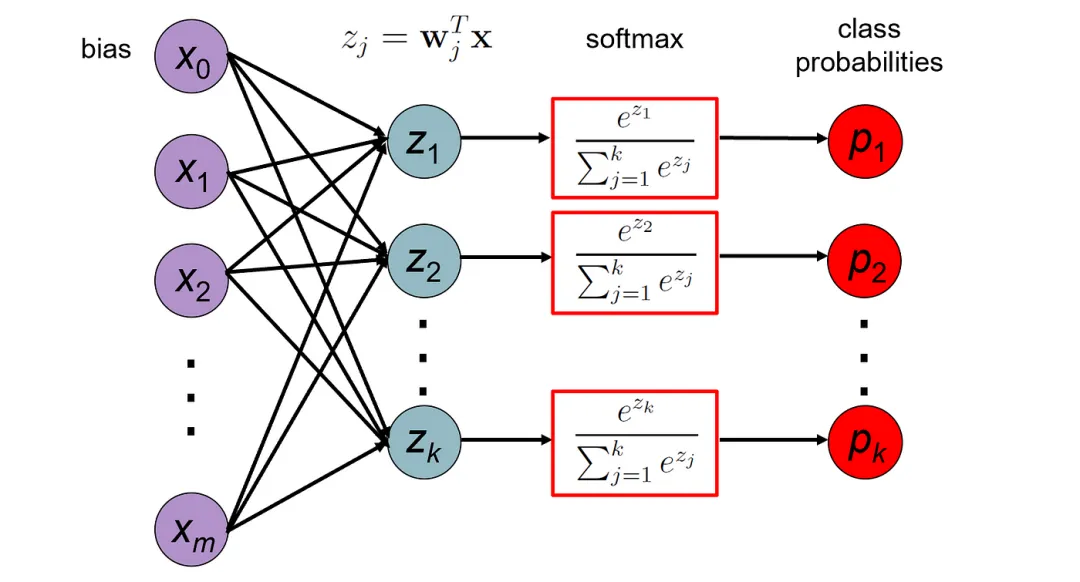

Softmax回归通过映射线性模型输出到概率分布实现多类分类,而k-近邻(k-NN)则基于距离度量与已知样本的相似性来进行多类分类。

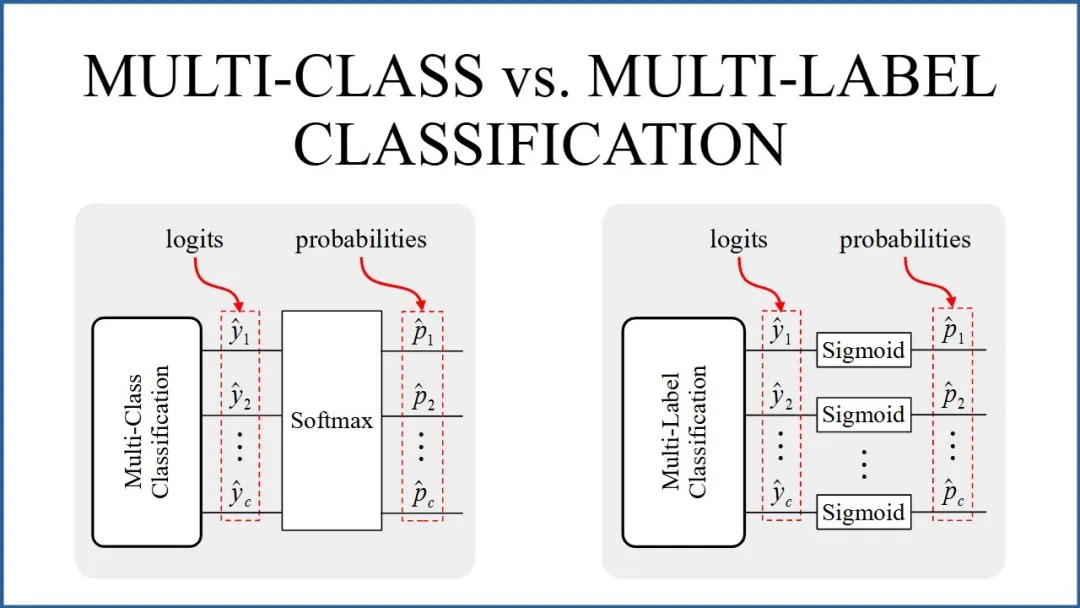

- Softmax回归:将线性模型的输出映射到多个类别上的概率分布,通过比较不同类别的概率来进行多分类。具体来说,Softmax函数会将线性模型的输出(也称为logits)转换为概率分布,每个类别的概率值都在0和1之间,且所有类别的概率值之和为1。

- k-近邻(k-Nearest Neighbors, k-NN):基于实例的学习方法,通过比较待分类样本与已知类别样本之间的距离来进行分类。在多类分类问题中,k-NN算法会选择距离待分类样本最近的k个已知样本,并根据这些样本的类别进行投票,选择出现次数最多的类别作为待分类样本的类别。

三、多标签分类

多标签分类(Multi-label Classification)是什么?多标签分类问题是指一个样本可以同时被赋予多个标签,这些标签之间不是互斥的。多标签分类任务的目标是预测一个样本同时属于哪些标签集合中的标签。

多标签分类应用场景有哪些?文本主题标注(一篇文章可能同时涉及政治、经济、文化等多个主题)、图像标注(一张图片可能包含多个对象或场景)等。

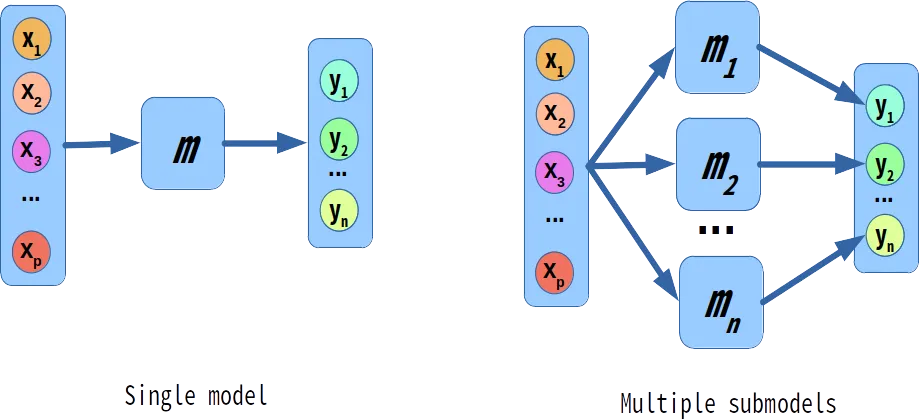

多标签分类常见方法是什么?将多标签分类问题转化为多个二分类问题来解决,或者利用上一个输出的标签作为下一个标签分类器的输入。

四、多输出分类

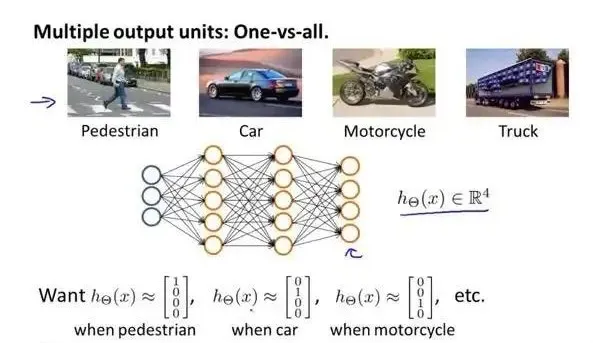

多输出分类(Multi-output Classification)是什么?多输出分类问题是指每个样本可以属于多个类别,并且每个类别可能有不同的输出值或概率。多输出分类任务的目标是预测一个样本在每个类别上的输出值或概率。

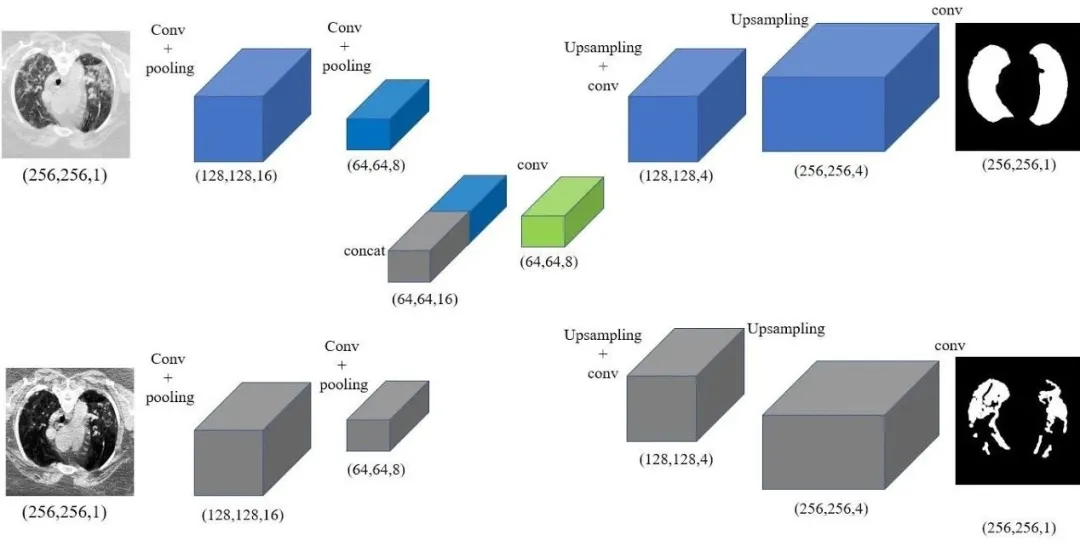

多输出分类应用场景有哪些?医学诊断(一个患者可能同时患有多种疾病,每种疾病需要独立的预测结果)、图像分割(每个像素点可能属于多个类别)等。

多输出分类常见方法是什么?多输出神经网络、多输出支持向量机等。这些方法通常需要对每个类别构建独立的输出层,并使用适当的损失函数进行训练。

本文转载自公众号架构师带你玩转AI 作者:AllenTang