理化诺奖、人工智能与知识领域的融合

引言

近期的发展标志着人工智能领域的一个激动人心的时期。2024年诺贝尔物理学奖授予了约翰·霍普菲尔德(John Hopfield)和杰弗里·辛顿(Geoffrey Hinton),以表彰他们在人工智能领域的奠基性工作;而化学奖则颁给了大卫·贝克(David Baker)、德米斯·哈萨比斯(Demis Hassabis)和约翰·琼珀(John Jumper),以表彰他们利用人工智能解决蛋白质折叠问题的成就——这是科学界长达50年的重大挑战。

随着人工智能在物理学和化学中的应用获得认可,机器学习从业者可能会好奇这些科学领域与人工智能的关系,以及这些奖项可能对他们的工作产生怎样的影响。

神经网络的历史发展

通过审视人工智能发展的历史,我们可以更好地理解计算机科学、理论化学、理论物理学和应用数学之间的相互联系。从历史视角来看,这些学科中的基础性发现和发明共同推动了现代人工神经网络机器学习的发展。

神经网络领域的最早工作可追溯至麦卡洛克(McCulloch)和皮茨(Pitts),他们在1943年提出了一个使用简单二值逻辑表示神经元的模型。他们的研究表明,神经元能够实现诸如AND、OR和NOT等基本逻辑运算,为现代神经网络奠定了基础。然而,他们并未解决生物神经元网络中学习或存储长期记忆的机制问题。许多计算机科学家熟悉这些早期的逻辑模型,这些模型为今天复杂的神经决策过程提供了概念基础。

1949年,唐纳德·赫布(Donald Hebb)提出了“赫布学习”的原理,即神经元如果在时间上反复或接近地共同激发,其连接会得到增强。20世纪50年代末,弗兰克·罗森布拉特(Frank Rosenblatt)在神经网络研究中取得了重大进展,他提出了“感知机”这一术语,并开发了理论模型和硬件实现。罗森布拉特的感知机引入了非二值输入和可训练的神经元权重,大大增加了神经网络设计的灵活性。

然而,1969年,马文·明斯基(Marvin Minsky)和西摩·帕珀特(Seymour Papert)在其影响深远的著作《感知机》中指出了一个关键的局限性:没有可训练隐藏单元的网络无法解决非线性可分问题,例如异或(XOR)函数或检测卫星图像中的螺旋结构。尽管这一发现最初令人沮丧,但最终激励了人工智能界集中解决训练含隐藏单元网络的挑战,进而发展出了反向传播算法,其中包括杰弗里·辛顿等人的重要贡献。同时,理论物理学、化学和应用数学领域的研究者也在探索神经网络对现实现象(包括脉冲生物神经元行为)的建模,进一步丰富了这一领域的跨学科特性。

我们可以将早期对现实神经元建模的努力追溯到杰克·科万(Jack Cowan)和天利·甘(Shun’ichi Amari),他们的研究将原本用于动物种群动态的Volterra捕食-猎物方程推广并应用于脉冲神经元的建模。几十年来,科万在神经元的统计力学领域不断取得进展,而甘的神经网络动力学和学习算法的开创性工作至今仍然对现代机器学习产生深远影响。

关键突破与挑战

约翰·霍普菲尔德(John Hopfield)的研究带来了一个概念性突破,他提出了一个简化的神经元模型,并将其与理论物理学和化学中的伊辛模型(Ising model)联系起来【译者注:请见物理诺奖、统计力学与大模型】。

霍普菲尔德在1982年发表的经典论文中提出了霍普菲尔德联想记忆模型(Hopfield associative memory model),这一模型成为神经网络研究的基石。该模型展示了神经元网络如何通过能量最小化来存储和检索模式,其动态由能量函数控制。这种与能量的联系使模型能够稳定地收敛到与存储记忆对应的稳定状态,从而成为神经网络理论与理论物理学中自旋玻璃理论之间的关键纽带。

熟悉自旋玻璃理论的理论物理学家发展出新的学习理论,与计算机科学中更为人熟知的统计学习理论形成了竞争性的视角【译者注:请见Spin-Transformer数据雕刻自旋玻璃】。这些理论为当代问题提供了重要见解,并对理解诸如大语言模型(LLMs)和扩散模型等具有广泛意义。例如,深度神经网络(DNNs)中的“双降现象”(double descent)首次在理论物理学文献中通过感知机学习模型的研究被发现。

霍普菲尔德的联想记忆模型展示了一种类似于神经网络“幻觉”的现象。在神经科学中,这一模型甚至被用于研究视觉幻觉。霍普菲尔德与泰伦斯·塞伊诺夫斯基(Terrence Sejnowski)结合模拟退火(simulated annealing)与自旋玻璃模型的思想,提出了玻尔兹曼机(Boltzmann machine)。这一方法使得无监督学习成为可能,通过训练数据中的规律创建内部模型,而无需输入输出对。这一工作更加深入地借鉴了物理学和热力学系统的类比【译者注:请见降低大模型幻觉的必由之路】。

在监督学习领域,为克服明斯基与帕珀特的批评,辛顿及许多研究者继续致力于多层神经网络及隐藏单元的研究。1986年,大卫·鲁梅尔哈特(David Rumelhart)和詹姆斯·麦克莱兰德(James McClelland)编辑出版的两卷本《并行分布式处理》(Parallel Distributed Processing)成为探索神经网络领域的青年研究者和学生的必读经典,为联结主义研究奠定了重要参考基础。辛顿与鲁梅尔哈特及罗纳德·威廉姆斯(Ronald Williams)在20世纪80年代共同推动了反向传播法在人工智能界的普及。尽管许多人因其仅适用于“玩具问题”而放弃了这条研究路线,辛顿始终坚持不懈,最终随着计算能力的爆炸性增长和新算法变体的开发,得到了验证。

当然,今天的神经网络远比最初的霍普菲尔德联想记忆模型或20世纪80年代基于反向传播的模型复杂得多。尽管深度学习在解决许多过去难以攻克的机器学习和人工智能问题方面取得了巨大进步,我们依然缺乏基本理论来解释其为何有效。在实际应用中,大语言模型的不稳定性和不可预测性仍是从业者面临的一大难题。然而,通过重新审视统计物理学中的旧模型,人们取得了一些进展。例如,马丁(Martin)【译者注:作者本人】和马霍尼(Mahoney)在2021年提出的重尾自正则化(HTSR)理论,可以在无需检查训练或测试数据的情况下检测神经网络各层是否已收敛。

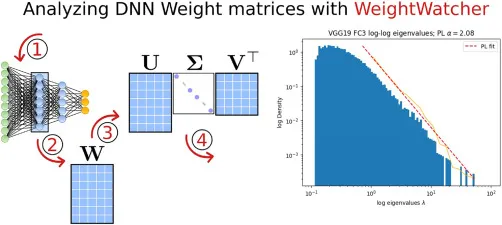

HTSR理论被实现为开源的、无需数据的诊断工具WeightWatcher。通过WeightWatcher,我们可以深入观察现代深度神经网络,发现表现最好的模型显示出一种惊人的普适性,这与HTSR理论的预测一致:层权重矩阵特征值的经验分布尾部收敛到幂律(PL)分布,其幂律指数α约为2。在上图中,我们展示了VGG19最后一层权重矩阵的特征值在对数-对数坐标下的直方图,以及与幂律分布的拟合。【译者注:近期类似的研究可以参考推演大模型局限与发展脉络第三部分】

这种普遍行为表明,可能存在一种尚未发现的、更为基础的普适计算过程支配着深度神经网络(DNN)的训练。虽然我们尚不理解这一看似普遍现象的起源,但其观察结果暗示,可能存在一种新的物理学理论有待发现,它或许包含统计力学的某些元素,但以一种全新的方式进行整合。

工程先于科学

工程的发展往往先于科学理解。例如,蒸汽机、汽车、船舶和火车的研发远早于我们对其底层动力学的深入理解。早期的蒸汽机容易爆炸,引发火灾,甚至导致船只沉没。直到热力学的出现,我们才真正理解如何控制和优化这些复杂机器。这一科学基础最终促使内燃机的改进,并为当今如SpaceX火箭的先进技术铺平了道路。

加密货币的快速发展和广泛应用进一步说明了工程如何能够超越科学理解。这些数字资产彻底改变了金融交易并引发了全球现象,而这一切都发生在其行为和影响的全面理论框架确立之前。

另一个近期的诺贝尔奖——化学奖——则表明,即使在缺乏完整理论理解的情况下,人工智能也能帮助解决一些最具挑战性的科学问题。通过破解蛋白质折叠问题,约翰·琼珀(John Jumper)和德米斯·哈萨比斯(Demis Hassabis)为生物学和医学领域的突破性发现铺平了道路。他们与AlphaFold的工作展示了AI的变革潜力,不仅能够解决复杂难题,还能加速多个科学领域的进步。

乍一看,AlphaFold似乎凭空而来,但事实上,蛋白质折叠问题的研究与理论物理学、化学和人工智能有着深厚的渊源。实际上,琼珀的博士论文是一个结合物理学与人工智能的混合模型(使用辛顿提出的有限玻尔兹曼机对比散度算法训练),能够处理蛋白质折叠和动态问题。早期的统计力学方法结合了AI的经验数据,通过对快速侧链运动进行平均来实现。这是通过使用类似于限制玻尔兹曼机的算法拟合蛋白质数据银行(PDB)的参数来完成的。然而,这些计算极其耗费资源,需要使用世界上最大的超级计算机。通过结合理论、实验数据与人工智能,琼珀的早期工作为最终在AlphaFold中取得的惊人成果奠定了重要基础。

神经网络的早期研究者们认识到了计算模型中大规模并行性的潜力。然而,由于当时技术的限制,这一概念的全面实现一直难以达成。当时的计算硬件,由于CPU的速度较慢且缺乏GPU等专用处理器,在大规模实现并行架构方面面临巨大限制。尽管如此,这一领域在理论基础方面取得了关键进展。分布式编码的引入标志着范式的转变,从局部化表示转向更为鲁棒和灵活的分布式激活模式。这种方法允许神经网络进行更为细腻和语境敏感的信息处理。同样具有变革意义的是反向传播算法的发展,它使网络能够基于预测与实际输出之间的差异调整内部参数。尽管这一算法计算密集,却为训练多层网络提供了强有力的机制,为硬件能力赶上理论愿景的深度学习革命铺平了道路。

当我们回顾神经网络领域的历史挑战与突破时,思考这些进步如何塑造了我们对周围世界的理解至关重要。这种计算思维的演变促使我们重新审视宇宙的基石,将我们的视野拓展到传统科学边界之外。这种扩展视野促使我们探索一种新的概念方式,将当代的基本构成块与我们对自然的理解交汇起来。

自然基石的演变

我们可以将世界的基本架构概念化为由三种主要基石或基础“ABC”组成的三位一体:“原子”,即物质的基本单元;“比特”,即信息的最小不可分单元;以及“细胞”,生命的基本元素。人类对自然核心组成部分的探索经历了重要演变,从原子这一有形领域和细胞的生物学范畴,逐步过渡到比特这一抽象但无所不在的领域。这一转变标志着科学研究范式的转型,信息作为一个核心焦点逐渐凸显,并与我们对物质和生命的理解相辅相成、相互交融。

将比特作为信息的基本单位的引入,催生了一个崭新的跨学科研究和探索的时代,有效地削弱了传统科学学科之间的界限。这场数字革命为解决各领域长期存在的问题提供了创新的方法。例如,生物信息学结合了计算机科学与分子生物学,用于分析人类基因组;计算语言学运用统计模型来解读人类语言的复杂性。在气候科学领域,大数据分析和机器学习算法处理大量环境信息数据集,从而提升预测精度并深入理解全球气候现象。

此外,许多当代案例进一步说明了比特这一概念如何作为统一原则连接不同学科,并加速针对复杂、多维挑战的创新解决方案。比特的引入不仅改变了科学的运作方式,还推动了跨领域合作和解决问题的新思维方式,使我们能够以前所未有的速度和深度探索自然界的奥秘。

诗人和理工科精英的融合

人文学科、文科与传统上定量化的领域(如STEM)在教育与实践中往往是彼此分离的。尽管这些领域之间一直存在某种程度的互动,但由于语言模型和聊天机器人等技术的推动,我们正在见证更深层次的融合。这些工具能够将复杂技术文本简化为更易理解的版本,同时还支持对人文学科中的定性数据进行分析和可视化。这种融合鼓励来自全球各地的多样化团队通过真实体验和问题解决来学习,例如,本文作者之一(G.M.)教授的许多以AI和数据为主题的项目式课程,就以体验式学习为核心。

诸如谷歌的NotebookLM之类的工具使得复杂文档的摘要生成变得极为简单,仅需轻轻一点,即可快速获取信息。它们甚至能以播客的形式呈现内容,为用户提供简明的概览,使人们能够更加高效地理解和利用信息。

行动呼吁

在前行的道路上,必须认识到不同方法的融合对现代生成式AI系统发展的重要性,例如基于反向传播的深度学习和受物理学启发的玻尔兹曼机的结合。

这种跨学科的方法不仅有益,而且在应对未来许多复杂挑战时至关重要。我们需要在保持务实态度的同时,充分利用当前技术进步的动力。AI在多个领域的快速发展带来了前所未有的机遇,同时也带来了重大的挑战。要弥合技术炒作与实际成果之间的差距,我们必须培养新一代的跨学科思考者,即当代的AI通才。

这些现代版的达·芬奇将在开发工程师可直接应用的实用学习理论方面发挥关键作用,推动我们向人工通用智能(AGI)的宏伟目标迈进。这要求我们在科学探索和问题解决的方法上进行范式转变,拥抱整体性、跨学科的协作,并从自然中学习以理解自然。【译者注:回归老子,道法自然】通过打破学科间的壁垒,培育一种跨领域的知识好奇文化,我们能够为应对诸如气候变化等复杂的全球性挑战解锁创新的解决方案。正是通过多元知识和视角的融合,在AI的催化作用下,我们才能开辟通往有意义进步的道路,并充分实现技术愿景的潜力。

随着AI的不断发展,意识的前沿成为一个令人着迷的挑战。这引发了关于意识是否可以完全通过原子、比特和细胞的交互作用来解释,或者是否需要一个尚未发现的新元素的疑问。布鲁姆等人的最新研究提出了一种全新的“有意识图灵机”模型,这一模型表明,意识可能通过计算过程被理解并可能被复制,从而弥合传统AI与自我意识之间的鸿沟。这一前沿展示了我们倡导的跨学科方法的必要性,将计算机科学、神经科学、哲学、物理学和化学的洞见结合起来,共同探索AI和人类理解中最深刻的问题之一。

译者注:

正如译者在物理诺奖、统计力学与大模型 中总结的:理化诺奖都颁给AI学者,预示着学科的前沿边界已经非常模糊了。AI融汇了统计力学的思想,可以用来拓展人类的高维认知。这与Charles H. Martin博士的观点高度吻合。

今天跟同事学到一句话:执一不失,能君万物,即对事物本质的道理执著地坚持,如是才能让万物为我所用。

原文:The recent Physics and Chemistry Nobel Prizes, AI, and the convergence of knowledge fields: Patterns https://www.cell.com/patterns/fulltext/S2666-3899(24)00271-X