LLM合集:谷歌推出逆向思维RevThink框架,大模型零样本性能提升13.53%

1. Reverse Thinking Makes LLMs Stronger Reasoners

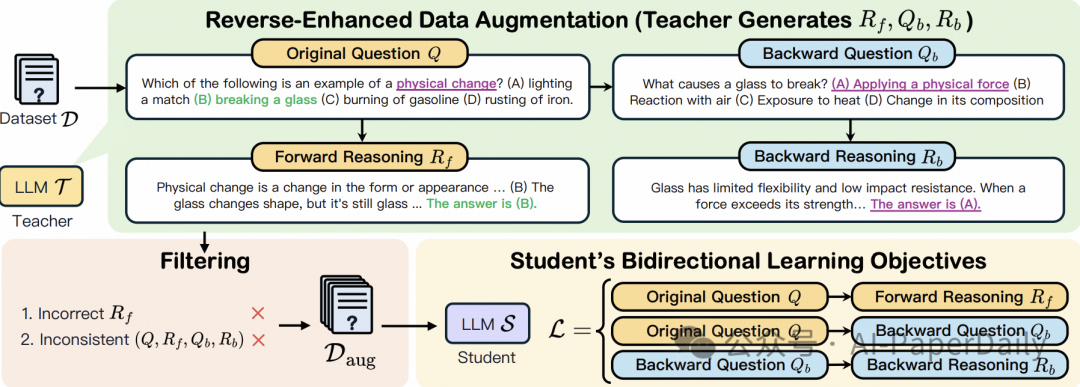

逆向思维在人类推理中扮演着至关重要的角色。人们不仅可以从问题推导出解决方案,还可以反过来从解决方案推导出问题。这种双向思考方式往往能提高整体的推理性能,因为它允许前后思维之间的一致性检查。为了使大型语言模型(LLM)具备逆向思维能力,我们引入了逆向增强思维(RevThink)框架,该框架由数据增强和学习目标组成。

在RevThink中,我们通过收集教师模型提供的结构化正向-反向推理来扩充数据集,具体包括:(1) 原始问题;(2) 正向推理;(3) 反向问题;以及 (4) 反向推理。然后,我们采用三种目标以多任务学习的方式训练一个小的学生模型:(a) 从问题生成正向推理;(b) 从问题生成反向问题;(c) 从反向问题生成反向推理。

在涵盖常识、数学和逻辑推理的12个数据集上的实验表明,RevThink相比学生模型的零样本性能平均提升了13.53%,比最强的知识蒸馏基线方法提升了6.84%。此外,我们的方法展示了良好的样本效率——仅使用训练数据中10%的正确正向推理,就优于在一个包含10倍更多正向推理的标准微调方法。RevThink还表现出较强的泛化能力,能够很好地处理分布外的数据集。

论文: https://arxiv.org/pdf/2411.19865

2. LLM Teacher-Student Framework for Text Classification With No Manually Annotated Data: A Case Study in IPTC News Topic Classification

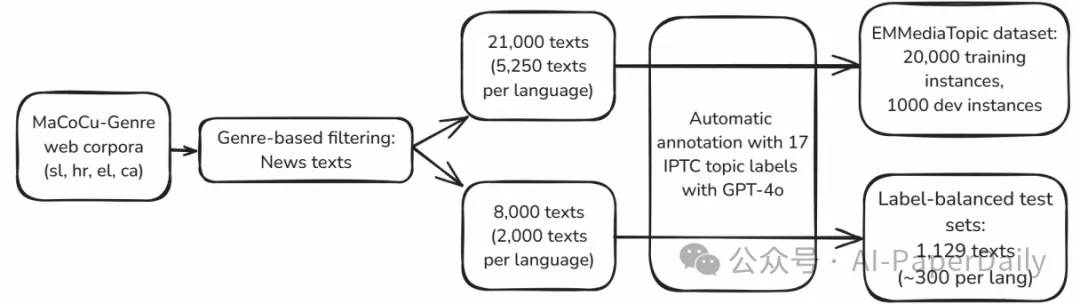

随着在线新闻报道数量的不断增加,按照主题对新闻进行分类变得越来越重要。为了应对这一挑战,我们提出了一种基于大语言模型(LLM)的蒸馏框架,用于开发不需要人工数据标注的多语言新闻分类模型。该框架利用生成式预训练transformer(GPT)模型作为教师模型,通过自动标注斯洛文尼亚语、克罗地亚语、希腊语和加泰罗尼亚语的新闻文章来构建IPTC媒体主题训练数据集。教师模型在这四种语言上表现出色,在零样本任务上的性能很高,并且其标注结果与人类标注者的一致程度与人类标注者之间的相当。

为了解决处理数百万文本所需的计算限制,我们对较小的BERT类学生模型进行了微调,这些模型在GPT标注的数据集上进行了训练。这些学生模型实现了与教师模型相当的高性能。此外,我们研究了训练数据量对学生模型性能的影响,并调查了它们的单语言、多语言和零样本跨语言能力。研究发现,学生模型可以在相对较少的训练实例下达到高性能,并展示了强大的零样本跨语言能力。最后,我们发布了表现最佳的新闻主题分类器,支持使用IPTC媒体主题架构的多语言分类。

论文: https://arxiv.org/pdf/2411.19638

3. On Domain-Specific Post-Training for Multimodal Large Language Models

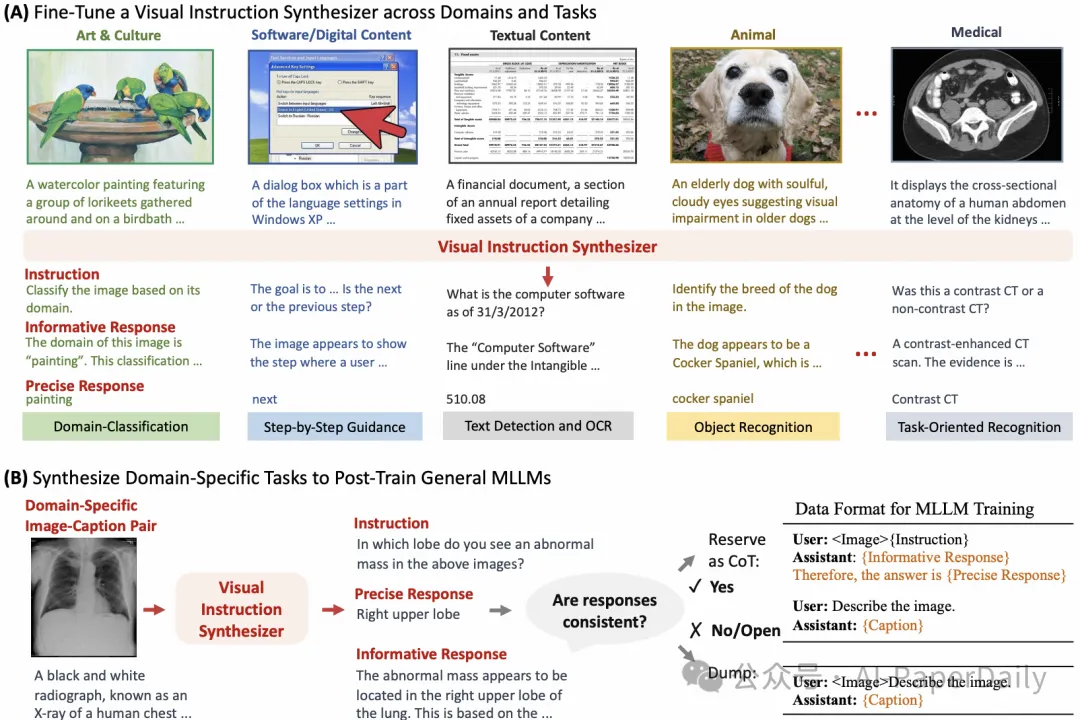

近年来,通用多模态大语言模型(MLLMs)得到了快速发展。然而,将这些通用的MLLMs适应特定领域(如科学领域和工业应用)的研究仍然相对较少。本文系统地研究了通过后训练进行MLLMs的领域适应性,重点关注数据合成、训练流程和任务评估。

数据合成:我们使用开源模型开发了一个视觉指令合成器,能够有效地从特定领域的图像-标题对生成多样化的视觉指令任务。我们的合成任务在提升MLLMs的领域特定性能方面优于手动规则、GPT-4和GPT-4V生成的任务。

训练流程:虽然两阶段训练(最初在图像-标题对上训练,然后在视觉指令任务上训练)是开发通用MLLMs的常见方法,但我们采用单阶段训练流程来增强领域特定后训练中的任务多样性。

任务评估:我们在两个领域(生物医学和食品)进行了实验,通过对不同来源和规模的MLLMs(例如Qwen2-VL-2B、LLaVA-v1.6-8B、Llama-3.2-11B)进行后训练,并评估其在各种领域特定任务上的性能。

这种方法不仅提升了MLLMs在特定领域的性能,还增强了其在多样化任务中的适应性和灵活性,为其在实际应用中的广泛应用奠定了基础。

论文: https://arxiv.org/pdf/2411.19930

4. Scaling Transformers for Low-Bitrate High-Quality Speech Coding

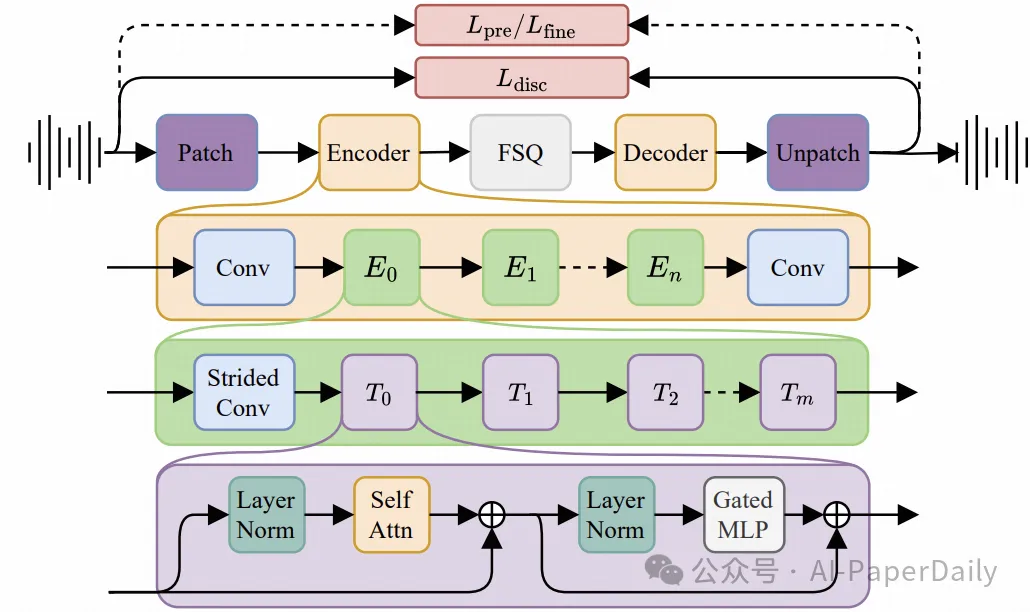

使用神经音频编解码模型对语音进行分词是现代AI pipeline中生成或理解语音(单独或在多模态背景下)的关键部分。传统上,这些分词模型主要集中在具有强归纳偏置的低参数量架构上。本文研究表明,通过将大规模参数的Transformer架构应用于这个问题,并结合灵活的有限标量量化(FSQ)瓶颈层,可以在极低比特率(400或700位每秒)下达到最先进的语音质量。训练后的模型在客观和主观测试中均显著优于现有的基线方法。

这种方法不仅提升了语音处理的质量,还在资源受限的情况下实现了高效的性能,适用于多种应用场景。

论文: https://arxiv.org/pdf/2411.19842

本文转载自 AI-PaperDaily,作者: AI-PaperDaily