回复

大模型技术的重点与难点,以及在实际操作中需要注意的事项 原创

大模型(Large Model, 如GPT、PaLM、LLaMA等)的重点与难点在于它们的构建、训练、应用以及部署过程中涉及到的多方面挑战。以下从技术、资源、应用等角度详细说明其重点与难点。

1. 大模型的重点

(1) 规模与性能

- 参数规模:大模型的核心是参数量通常达到数十亿甚至万亿级别,参数的规模直接影响模型的表达能力和推理能力。

- 多模态扩展:部分大模型支持跨模态输入(如文本、图像、音频等),需要对不同模态的数据进行融合建模。

- 通用性:大模型被设计为在多任务上表现出色,具备较强的通用性,减少了针对特定任务的重新训练需求。

- 零样本学习(Zero-shot Learning)与小样本学习(Few-shot Learning):通过少量上下文信息或提示,就能在新的任务中表现良好。

(2) 训练方法与优化

- 预训练:利用大规模无监督数据进行预训练,获取通用特征。

- 微调(Fine-tuning):在特定任务上进行微调以优化性能。

- 提示工程(Prompt Engineering):通过设计输入提示(Prompt)提高模型的表现。

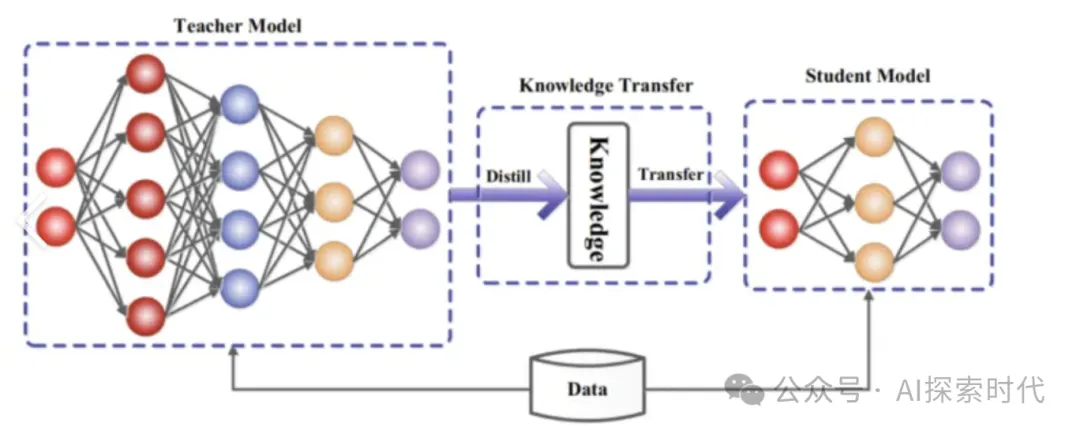

- 蒸馏与剪枝:减少模型的计算复杂度,同时保留性能。

(3) 数据质量与多样性

- 数据收集与清洗:大模型需要多模态、多语言、大规模的数据作为训练语料,数据的质量和多样性直接影响模型性能。

- 数据标注:高质量的标注数据能显著提升微调任务中的表现。

- 长尾数据处理:解决低频或边缘案例的表现问题。

(4) 推理与部署

- 推理速度:大模型需要高效的推理能力,以适应实时应用的需求。

- 可扩展性:支持分布式计算和大规模并发用户访问。

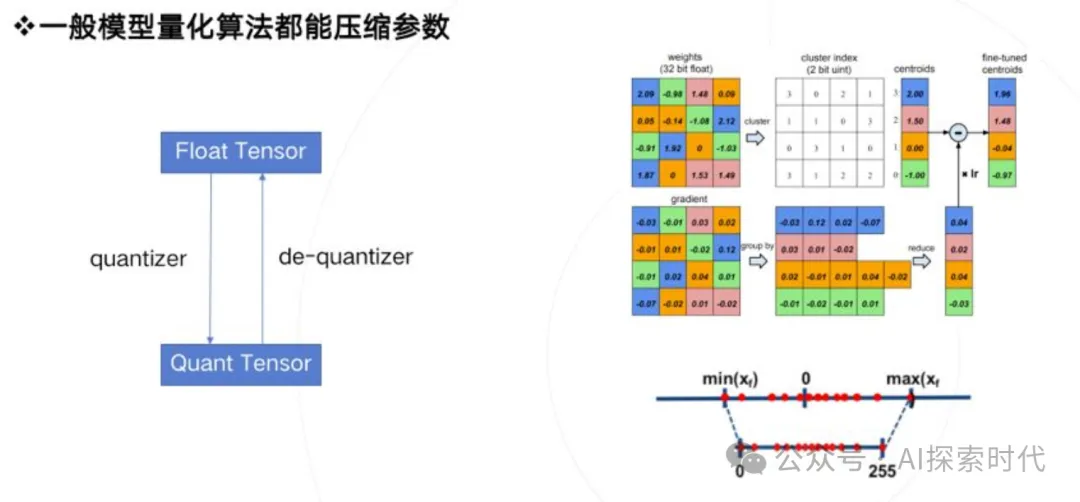

- 节能优化:通过模型压缩、剪枝、蒸馏等手段,降低能耗和部署成本。

2. 大模型的难点

(1) 计算资源消耗

- 计算需求高:训练大模型需要大规模的 GPU/TPU 集群和高效的分布式训练框架。

- 能耗问题:大规模训练和推理的能耗非常高,不仅增加成本,也带来环保问题。

- 显存和内存限制:大模型需要巨大的显存支持,在推理时尤其需要高效的显存管理。

(2) 数据挑战

- 数据量需求大:大模型需要 TB 级甚至 PB 级的数据来训练。

- 数据质量控制:噪声数据、偏差数据可能会影响模型性能和公平性。

- 隐私与合规问题:使用公共或私人数据训练模型时,需要遵守相关法律法规(如 GDPR)。

(3) 训练与优化难题

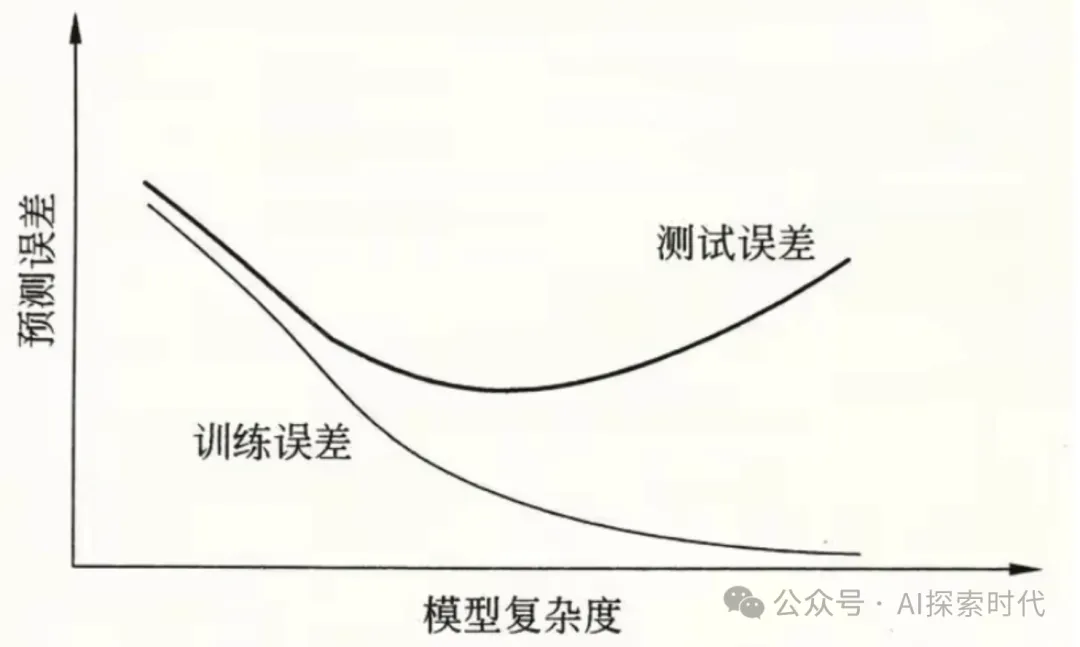

- 训练稳定性:大规模模型容易在训练中出现梯度爆炸、梯度消失等问题。

- 模型收敛难:模型规模越大,训练时间越长,超参数调优的难度也成倍增加。

- 优化难度高:需要结合分布式优化器、混合精度训练等技术才能完成高效训练。

(4) 推理效率与延迟

- 实时推理挑战:大模型推理速度较慢,无法直接用于低延迟场景。

- 硬件依赖强:需要高性能硬件支持(如 A100、H100 GPU),普通设备难以运行。

- 模型压缩难度:在保证模型性能的同时进行压缩非常具有挑战性。

(5) 安全性与可靠性

- 输出不可控:大模型可能生成错误、有害或不适当的内容。

- 鲁棒性不足:对对抗样本、噪声数据的敏感性较高,容易出错。

- 公平性与偏见:大模型可能继承或放大训练数据中的偏见和歧视,带来伦理问题。

(6) 多语言与多模态挑战

- 语言偏向:对于低资源语言(如小语种),模型性能往往较差。

- 跨模态融合:在多模态任务中,如何让模型有效理解和关联不同模态的信息是难点。

- 迁移学习难度:多模态数据的特性差异大,如何跨模态迁移知识尚存技术壁垒。

(7) 应用部署难题

- 实时性与并发:如何在高并发下保证低延迟推理是大规模应用的一大挑战。

- 动态负载:在流量激增的情况下,如何动态分配计算资源。

- 跨平台支持:需要适配不同设备(如移动端、服务器、嵌入式设备)。

3. 应对重点与难点的技术方向

(1) 计算与优化技术

- 分布式计算:利用分布式框架(如 PyTorch Distributed、DeepSpeed)提升训练效率。

- 量化与蒸馏:通过混合精度训练、量化和知识蒸馏降低计算需求。

- 分片并行与流水线并行:通过切分模型参数、流水线并行训练提升训练效率。

(2) 数据技术

- 高质量数据构建:构建多样化、高质量的训练数据集,减少偏差和噪声。

- 主动学习与自监督学习:降低对人工标注数据的依赖,提升数据效率。

(3) 模型架构优化

- 轻量化模型:设计高效的模型架构(如 MobileBERT、DistilGPT)。

- 新型模型设计:探索如混合专家模型(Mixture of Experts, MoE)等动态架构。

(4) 安全与伦理

- 内容过滤:建立生成内容的监控与过滤机制,避免有害信息传播。

- 去偏与公平性优化:在训练数据和模型设计上减少对特定人群的偏见。

4. 实例举例

重点:GPT-4 的通用性

- GPT-4 在文本生成、代码编写、多语言支持等方面表现优异,主要得益于其大规模的预训练数据和优化的训练架构。

- 它通过提示工程实现了小样本学习能力,使得用户无需微调即可在特定任务中使用模型。

难点:PaLM 的资源需求

- Google 的 PaLM 模型(540B 参数)训练时使用了 6144 个 TPU v4,耗费了数周时间,展示了大模型在训练资源上的高需求。

- 为提升推理效率,团队使用了模型剪枝和蒸馏等技术。

总结

重点:

- 模型规模化和通用性

- 高质量数据与优化技术

难点 :

- 计算资源和能耗的限制

- 推理效率与实时性挑战

- 数据安全、伦理与公平性问题

在大模型技术的推进过程中,计算、数据、优化、应用场景四个方面始终是关键,同时需要平衡技术性能与实际可用性之间的矛盾。

本文转载自公众号AI探索时代 作者:DFires

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

赞

收藏

回复

相关推荐