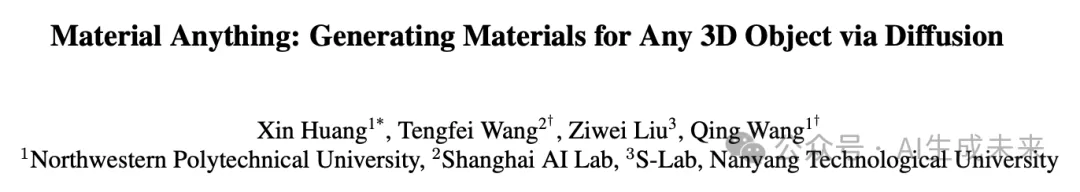

革新3D材质生成!Material Anything:端到端打造任意3D物体的高质量材质!

论文链接: https://arxiv.org/pdf/2411.15138

亮点直击

- 提出了一种完全自动化、稳定且通用的模型,用于为多种3D对象生成物理材料,并达到了最先进性能水平。

- 提出了一种具有光照置信度的材料扩散模型,以便用一个模型处理各种光照条件。

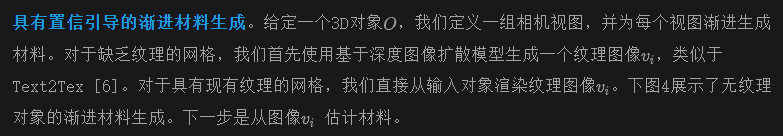

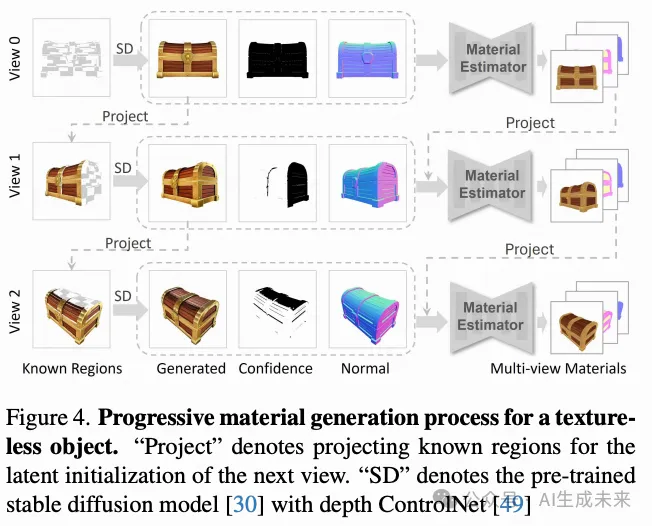

- 提出了一种由置信度 mask 引导的渐进材料生成方案,以及一种UV空间材料扩散模型,以生成一致且UV就绪的材料。

总结速览

解决的问题

现有的3D对象材料生成方法通常依赖复杂的流程或特定案例的优化,难以在各种光照条件下稳定工作。需要一种能够自动生成基于物理的材料,并在不同光照条件下表现优异的解决方案。

提出的方案

提出了Material Anything,这是一种全自动的统一扩散框架,能够为3D对象生成基于物理的材料。该框架通过三头架构和渲染损失来增强稳定性和材料质量,并引入置信度 mask 作为动态切换器,以处理不同光照条件下的有纹理和无纹理对象。

应用的技术

- 预训练的图像扩散模型

- 三头架构与渲染损失

- 置信度 mask 作为动态切换器

- 由置信度 mask 引导的渐进材料生成策略

- UV空间材料精炼器

达到的效果

Material Anything 提供了一种稳定、通用的端到端解决方案,能够在各种光照条件下生成高质量的物理材料。大量实验表明,该方法在广泛的对象类别和光照条件下优于现有方法,确保了输出材料的一致性和UV就绪性。

方法

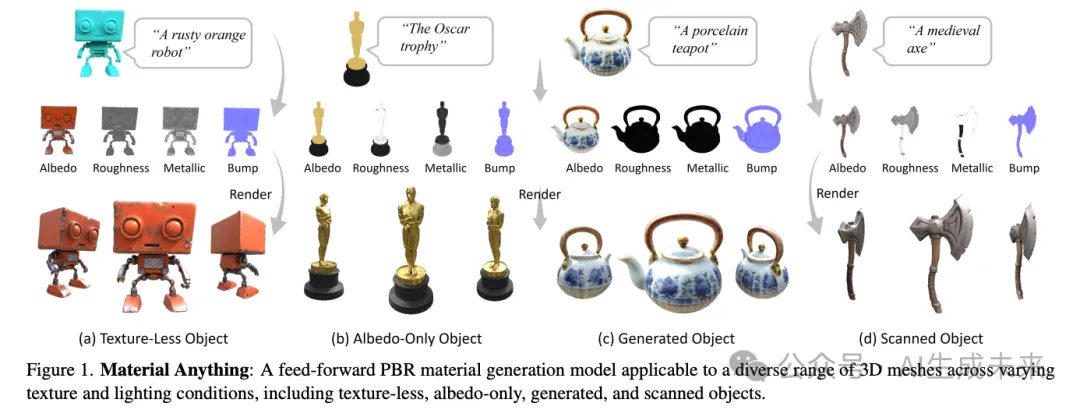

Material Anything,如下图2所示,是一个为3D对象生成高质量物理材料的统一框架,能够适应各种光照和纹理场景。它有效地处理以下情况:(1) 无纹理对象,(2) 仅有反照率的对象(无光照效果),(3) 扫描对象(真实光照),以及 (4) 生成对象(非真实光照)。与现有方法将这些场景视为独立任务不同,我们的方法将它们统一在一个框架下。为此,我们将3D材料生成重新表述为基于图像的材料估计任务,从而能够使用预训练的图像扩散模型并简化整体流程。

我们的框架围绕两个核心组件展开。首先,我们采用一个基于扩散的材料估计器,配备置信度 mask ,为输入对象的每个视图生成材料。接下来,我们引入了一种渐进材料生成策略,利用置信度 mask 确保生成材料在各视图之间的一致性,并进一步集成了用于材料细化的UV空间扩散模型。最后,我们提供了Material3D数据集的构建细节。

基于图像的材料扩散

- 通道差距:图像扩散模型通常在三个通道(RGB)上运行,而PBR材料需要超过三个通道(在我们的方法中为八个通道)。这种差异可能导致材料表示不准确,因为模型必须适应生成更复杂的输出集。

- 域差距:PBR材料贴图与自然图像不同。这种显著差异导致训练不稳定和性能次优。

- 多样化光照:最后,我们的材料估计器必须在具有不同光照条件的图像中保持稳健,以确保一致的性能。

为了解决这些挑战,我们引入了几个关键组件。

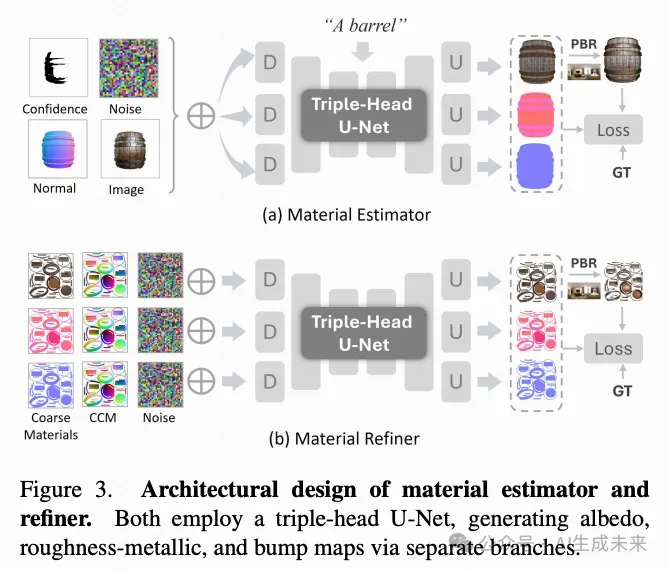

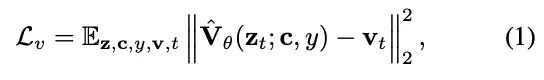

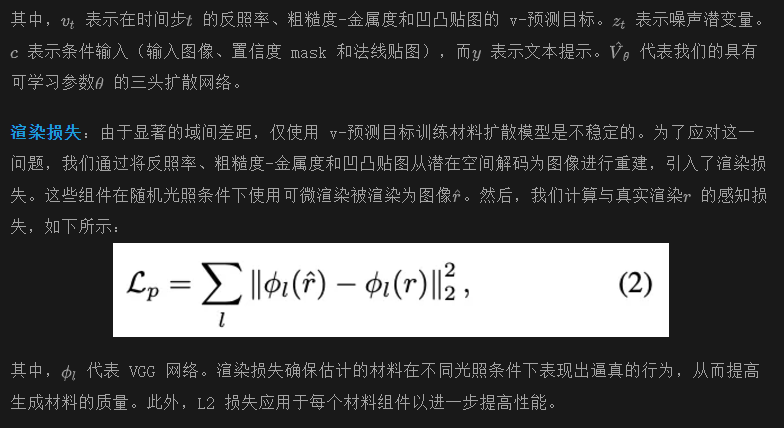

三头扩散:为了使三通道扩散模型能够处理多种材料特定通道,一种解决方案是训练一个材料VAE。然而,这种方法可能会丢弃扩散模型的预训练先验,并且在我们有限的PBR数据上训练定制的材料VAE具有挑战性。受之前工作的启发,我们设计了一个三头U-Net架构,如下图3(a)所示。U-Net架构包括初始卷积层和第一个下采样块的三个不同分支,随后是共享的中间层,支持材料模态的并行去噪。最终的上采样块和输出卷积层也分成三个分支。每个输出头生成一个特定的材料贴图:一个反照率贴图,一个组合的粗糙度-金属度贴图(R通道设为1,G为粗糙度,B为金属度),以及一个凹凸贴图。与将所有材料合并为一个输出不同,这种三头结构确保每个材料贴图在生成时不相互干扰,同时保持它们之间的一致性。

置信度自适应生成:为了管理具有各种光照条件的输入,我们将这些条件分为两大类:高置信度(例如,扫描对象)和低置信度(例如,无光照和生成光照)。为了指导模型,我们引入了一个表示光照置信度的确定性 mask 。对于具有真实光照的输入,置信度值设为1,鼓励扩散模型利用光照线索进行材料估计。相反,对于缺乏光照或具有生成光照的输入,置信度设为0,引导模型专注于材料生成而非估计。需要注意的是,对于具有生成光照的图像, mask 可以在已知材料区域选择性地分配值1,而在其他地方分配0,以增强多视图材料一致性,如逐步材料生成中详细说明的。置信度 mask 使扩散模型能够在材料估计和生成之间无缝过渡,有效管理真实和合成光照场景。学习目标是v-预测。

3D 对象的材料生成

虽然我们已经成功地为图像估计了材料,但将材料估计器应用于3D对象的多个视图会导致明显的不一致。一个解决方案是训练一个材料估计器,以同时预测多个视图的材料,类似于多视图扩散。然而,增加的视图和通道数量对生成高分辨率材料构成了挑战。为了使我们的2D材料估计器适应3D对象,我们提出了一种渐进生成策略,该策略基于前面提到的置信蒙版动态估计不同视点的材料。我们进一步将多视图材料投影到UV空间,并应用一个细化扩散模型,该模型完成被遮挡区域并细化材料,确保无缝且一致的材料贴图。

Material3D 数据集

为了训练Material Anything模型,我们构建了一个名为Material3D的数据集,该数据集由从Objaverse 精选的80,000个高质量3D对象组成。数据集构建的详细信息在补充材料中提供。对于每个模型,我们从10个固定的相机位置渲染了多视角材料图像(反照率、粗糙度、金属度、凸起)和法线贴图。此外,还渲染了UV材料图和CCM,以便于材料精炼器的训练。为了使模型能够处理多样的光照场景,我们在渲染输入图像时加入了多种光照条件,包括点光源、区域光源、环境光照和无光照。此外,我们设计了一种策略来模拟推理过程中常见的不完善和不一致的光照条件。

模拟不一致的光照:我们随机选择在不同光照条件下拍摄的两张图像,用于一个相机视角,并在训练过程中将每张图像的一部分拼接成一个复合图像。这使得单张图像能够展示两种不同的光照类型,模拟多视角材料中的不一致性。此外,我们对其中一张图像引入了降质效果,应用诸如模糊和色彩偏移等效果。使用信心 mask 来划定降质区域。材料估计器的最终输入包括拼接图像、信心 mask 和法线贴图。为了训练材料精炼器,我们随机遮盖UV材料图的某些区域,并将这些被遮盖的材料图作为输入。CCM是从3D点坐标的UV映射中导出的,也包含在内。这些图帮助指导需要修复的区域,并在扩散过程中促进3D邻接信息的整合。

实验

我们将我们的方法与纹理生成方法进行比较,包括 Text2Tex、SyncMVD 和 Paint3D 。此外,我们还将我们的方法与基于优化的材料生成方法进行评估,如 NvDiffRec 和 DreamMat ,以及一种基于检索的方法 Make-it-Real 。最后,我们也包括与闭源方法 Rodin Gen-1 和 Tripo3D 的比较。

定性评估

与纹理生成方法的比较。 我们在下图5中将Material Anything与各种纹理生成方法进行了比较。这些方法采用相似的策略,使用预训练的图像扩散模型为无纹理的网格上色。然而,扩散模型生成的光照信息通常导致纹理中出现显著的伪影,因为它们受到多个生成图像中复杂光照条件的影响。相比之下,我们的方法生成的纹理更加清晰,并且固有地包含材料属性,从而为下游应用提供了强有力的支持。

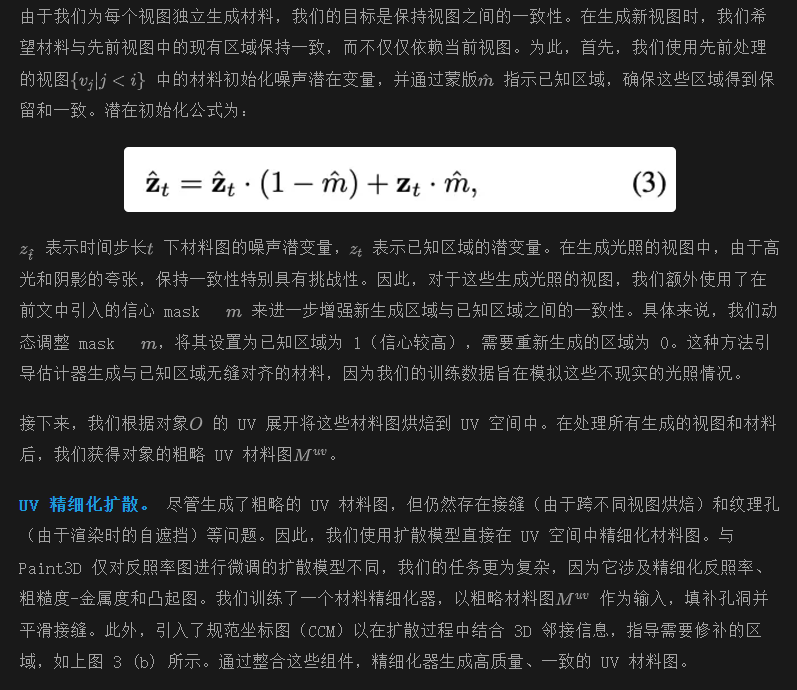

与优化方法的比较。 我们在下图6中将我们的方法与优化方法进行了比较。这些方法需要为每个对象进行大量的优化时间,并且难以准确识别对象的材料。相比之下,我们的方法能够有效地区分材料,如在桶的示例中,它准确地表示了金属箍和木板。这一能力突显了我们的方法在生成逼真且多样的材料图方面的优越性。

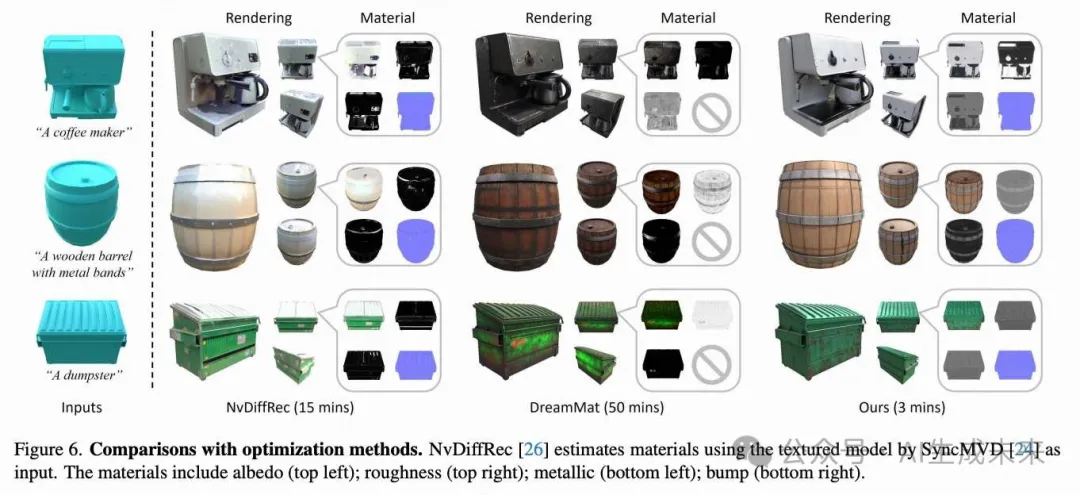

与检索方法的比较。 对于已有纹理的输入对象,我们与检索方法Make-it-Real进行了比较,如下图7所示。Make-it-Real基于初始纹理的分割来检索材料,这存在若干局限性。首先,分割过程难以准确捕捉小区域,例如消防栓上的剥落油漆。此外,它在去除初始纹理中的阴影时遇到困难,如雕塑示例中阴影反照率所示。相比之下,我们的方法生成的材料更为准确,更好地保留了细节,并去除了诸如阴影之类的伪影。

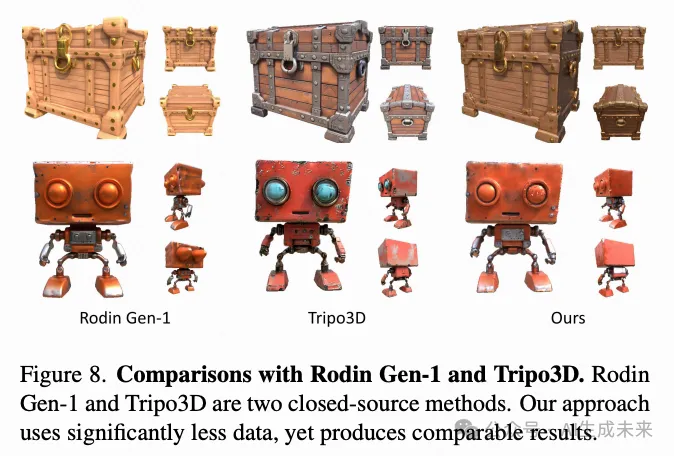

与Tripo3D和Rodin Gen-1的比较。 我们在下图8中将我们的方法与两个闭源方法Tripo3D和Rodin Gen-1进行了比较。我们使用Tripo3D生成的无纹理网格作为材质生成的输入。此外,我们通过图像扩散模型为Rodin Gen-1提供正视图图像,以确保生成相同的3D对象。尽管Tripo3D和Rodin Gen-1利用了显著更大规模的训练数据集,我们的方法仍能产生可比的结果。

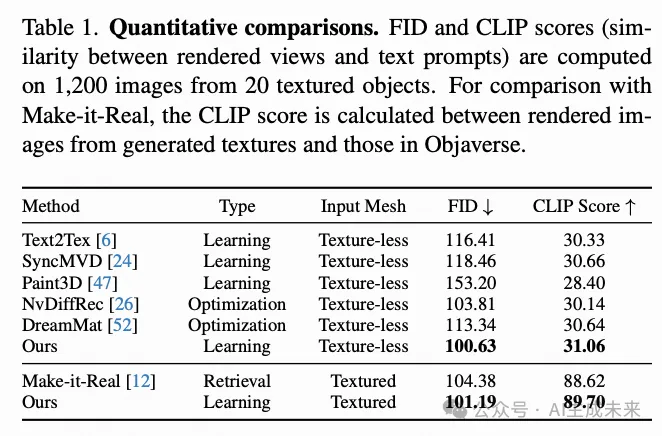

定量评估

我们的方法的定量评估结果如下表1所示。正如所示,我们的方法实现了更低的FID分数,这表明我们生成的纹理在分布上更接近Objaverse中的纹理。此外,我们方法的更高CLIP分数显示了其生成纹理与提示更准确对齐的能力。

消融研究

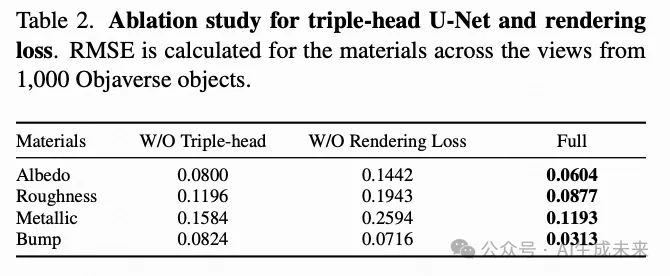

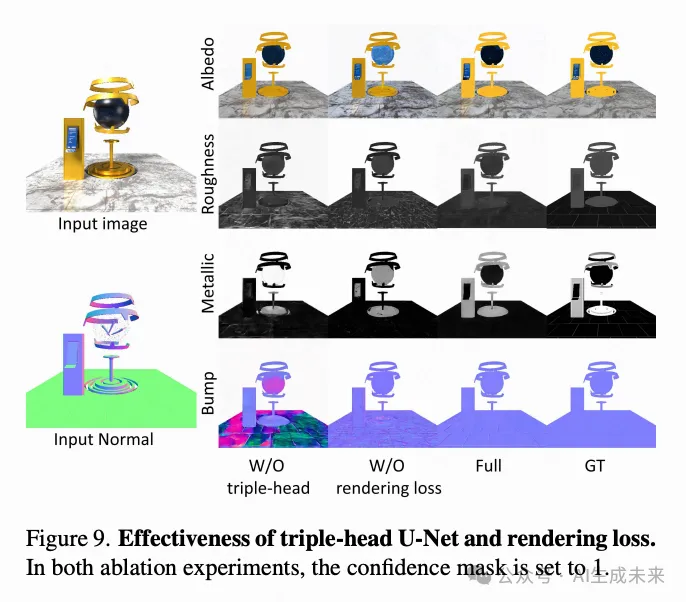

三头U-Net的有效性。 我们评估了使用普通U-Net架构的方法性能,该架构直接生成所有材料作为12通道潜变量,而不是使用三头U-Net。如下表2所示,由于在输出单个12通道潜变量时材料之间的耦合效应,性能下降。在下图9中,这种耦合效应很明显,凸起由于反射率的干扰被错误上色。相比之下,三头U-Net有效地解耦了材料。此外,三个头共享的主干网络确保了不同材料图之间的一致性。

渲染损失的有效性。 在上表2中,我们展示了在没有渲染损失的情况下训练的方法的定量结果。值得注意的是,与包含渲染损失的变体相比,此消融实验中的性能更差。如上图9所示,没有渲染损失的版本表现出明显的细节退化,材料视图中出现可见的伪影。渲染损失作为图像空间中的附加约束,确保了在不同光照条件下的一致性,提高了训练的稳定性,并有助于捕捉更细微的材料特性。结果突显了渲染损失在增强材料估计器的保真度和稳定性方面的关键作用。

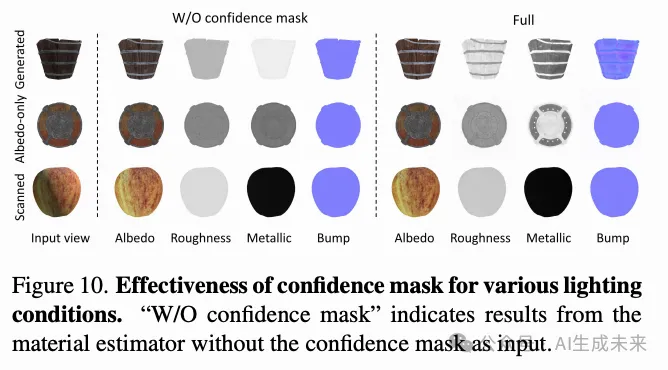

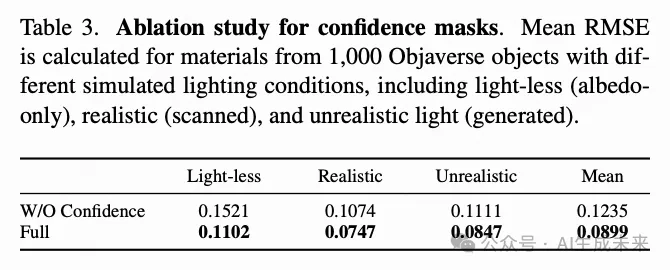

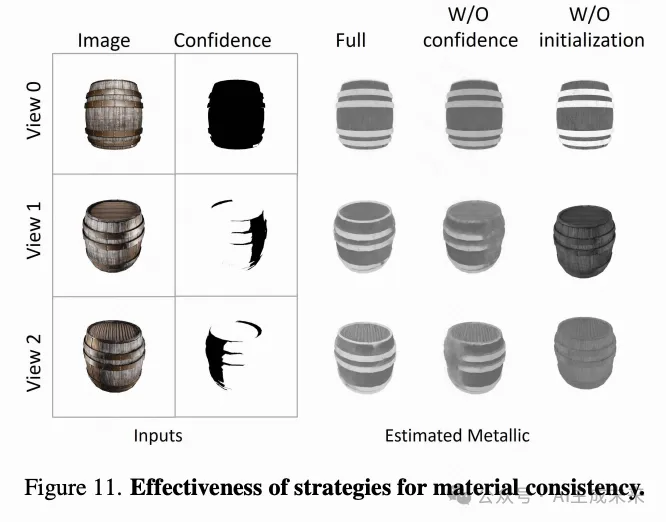

信心 mask 的有效性。 如下图10所示,没有信心 mask 的材料估计器在不同光照条件下难以生成高质量的材料。相反,在信心 mask 的指导下,模型能够很好地适应这些输入变化。下表3展示了在不同光照条件下,模型在Objaverse对象上没有信心 mask 的定量结果,揭示了材料准确度的显著下降。此外,对于具有生成光照的对象,缺乏信心 mask 的渐进生成也在材料图中显示出明显的不一致,如下图11所示。相反,使用信心 mask 后,模型能够区分用于估计和生成的区域。通过引导训练过程专注于相关区域,我们的方法实现了更加一致、无伪影的材料。这些结果表明,信心 mask 改善了材料的一致性,并解决了光照变化问题。

已知材料初始化的有效性。 上图11展示了未使用其他视图的已知材料进行初始化的方法结果。如图所示,预测的金属特性在不同视图中显示出明显的变化。相比之下,通过基于已知材料的渐进生成,我们的方法在多个视图中生成了更一致的材料。

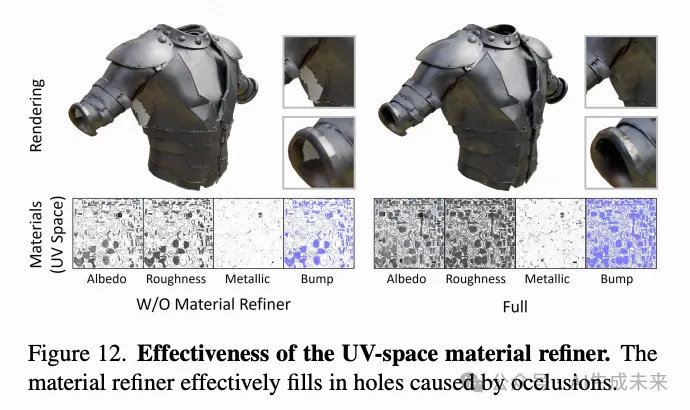

UV空间材料精细化器的有效性。 在下图12中,展示了没有UV精细化的结果。如图所示,由于自遮挡,预测的材料中出现了几个孔洞,导致材料图不完整。在应用我们的材料精细化器后,这些孔洞被有效填补,结果是更加无缝和完整的材料表示。我们的材料精细化器能够处理遮挡并提高整体材料生成质量。

结论

Material Anything,这是一个统一的框架,用于生成各种3D对象的PBR材质,包括无纹理、仅反照率、生成的和扫描的网格。通过利用精心设计的材质扩散模型,方法可以以前馈的方式生成高保真材质。为了解决复杂光照条件下的各种输入对象的统一性,引入了一种 mask 来指示不同光照的置信水平,这也增强了多视角材质的一致性。大量实验表明,我们的方法可以为各种对象生成高质量的PBR材料,并且明显优于现有方法。

本文转自AI生成未来 ,作者:AI生成未来