LightRAG:提升检索增强生成的效率与准确性 原创

01、概述

在快速发展的人工智能领域,如何让语言模型更高效、更准确地生成上下文相关的答案,一直是研究者们的热门课题。最近,来自香港大学和北京邮电大学的研究团队推出了LightRAG,一种轻量级、高效的检索增强生成(RAG)方法,标志着这一领域的新进展。与以往的RAG模型相比,LightRAG在生成速度和上下文相关性方面表现更佳,为开发者提供了更强大的工具。

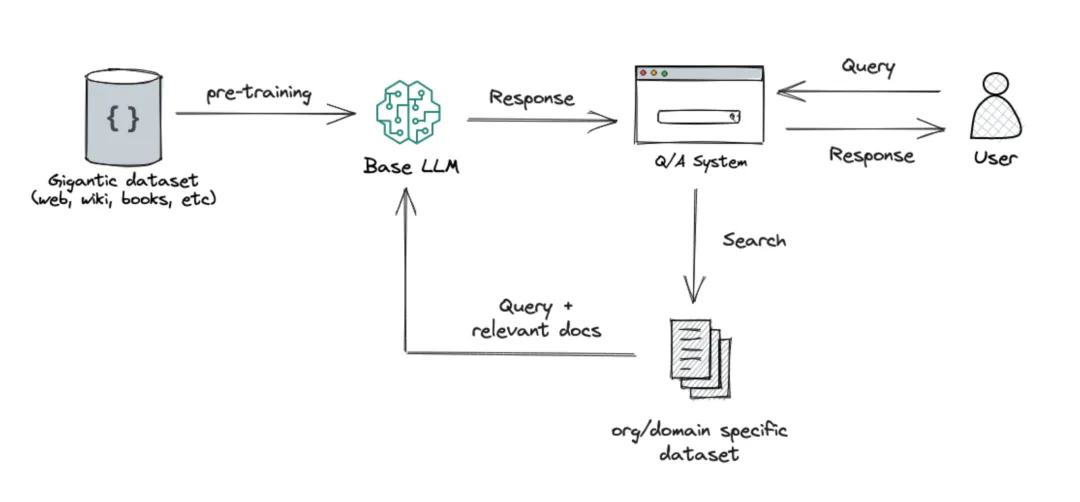

02、什么是RAG?

检索增强生成(Retrieval-Augmented Generation, RAG)是一种通过接入外部数据源来提升大语言模型(LLMs)准确性的技术。这一方法结合了两个主要过程:检索和生成。用户提交查询时,系统会搜索一个广泛的知识数据库,检索到相关文档或信息后,再传递给生成模块,以创建一个符合上下文的回应。

然而,传统的RAG系统常常依赖于平面的数据结构,这意味着信息被孤立地存储,导致模型在生成答案时无法充分利用上下文,最终产生零散的回复。LightRAG通过改善RAG中的检索和生成阶段,克服了这些限制,使得生成的回答更加详细且更具连贯性。

03、为什么选择LightRAG?

LightRAG在信息之间保持关系,能产生更优质的答案,同时其计算效率也更高。与之前的RAG模型相比,LightRAG引入了多项创新功能:

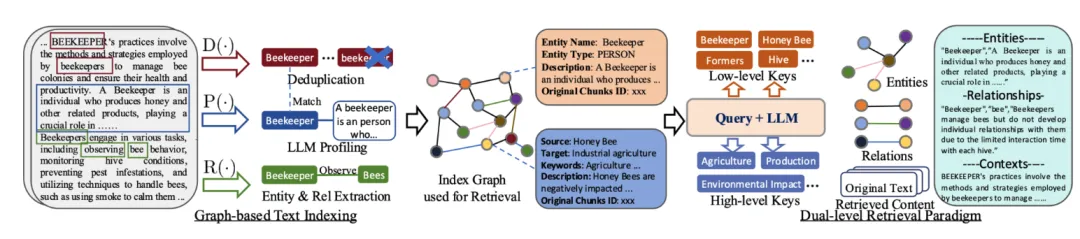

- 图增强文本索引:通过将图结构纳入文本索引,LightRAG能够建立相关实体之间的复杂关系,从而提升系统的上下文理解能力。

- 双层检索系统:LightRAG采用双层检索机制,能够同时处理低层(具体细节)和高层(抽象概念)的查询。例如,它不仅可以回答“谁写了《傲慢与偏见》?”这样具体的问题,也能应对“人工智能如何影响现代教育?”这样抽象的问题。

- 增量更新算法:该模型使用增量更新算法,以便在不重建整个数据索引的情况下,快速整合最新信息。这种方法能够选择性地索引新或修改过的内容,尤其适用于动态环境,比如新闻或实时分析,数据变化频繁的场景。

LightRAG的轻量化特性使其能够快速处理大规模知识库并生成文本,减少了计算成本,适合更多开发者和小型企业使用。

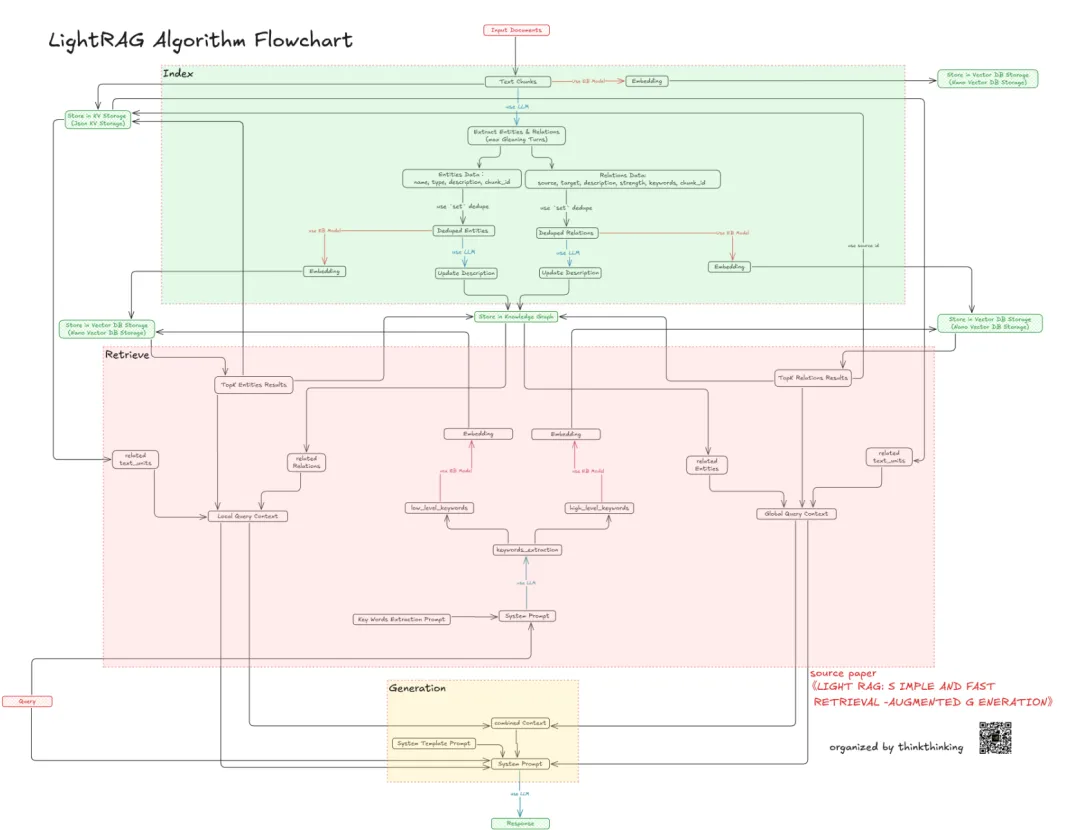

04、LightRAG的架构

LightRAG的架构主要分为两个部分:基于图的文本索引和双层检索。其工作流程可以总结如下:

- 图形文本索引:将原始文本文件分割成小块,便于高效检索。

- 知识图谱构建:利用大语言模型(LLM)进行实体和关系的提取,并生成文本的键值对(K, V)。

- 信息检索:通过生成的键值对进行检索,包括:

详细层面:关注于文档的具体小部分,允许精确的信息检索。

抽象层面:关注整体意义,帮助理解不同部分之间的广泛连接。

通过这两种检索方式,LightRAG能够在小文档部分中找到相关信息,并理解不同文档之间的更大、相互关联的概念。

05、评估与比较

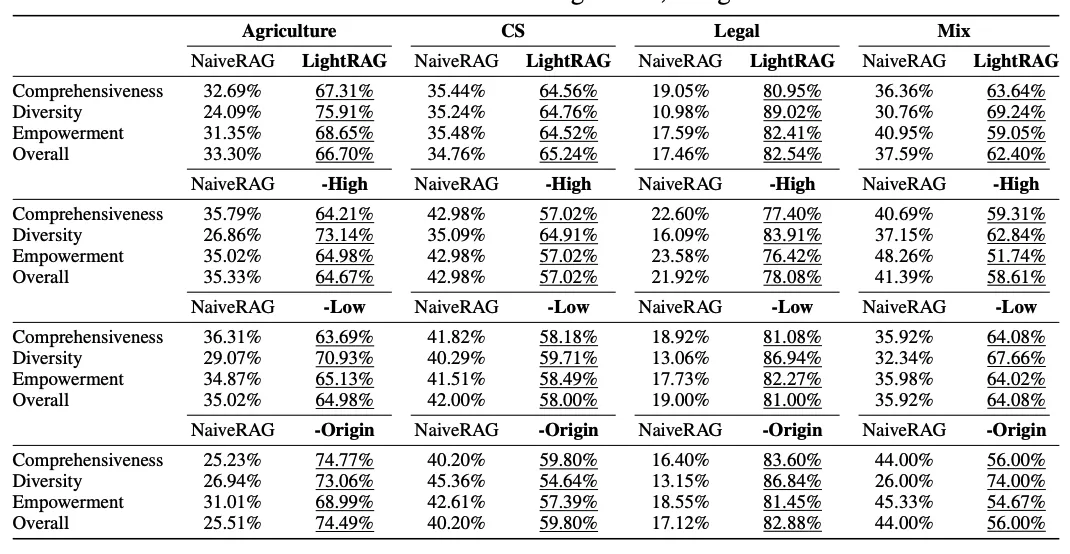

LightRAG的评估结果显示,其在检索准确性、模型可调节性、响应效率和适应新信息的能力等方面超越了其他相似的RAG模型,如NaiveRAG、RQ-RAG、HyDE和GraphRAG。具体的案例研究表明,虽然GraphRAG是微软开发的工具,也使用基于图的知识来提高文档检索和文本生成,但其运行所需资源更多,因此成本更高。

在综合比较中,LightRAG在全面性、多样性以及提供详细信息的能力上均表现出色。例如,在电影推荐系统的关键指标评估中,LightRAG在准确性、用户参与度等多个维度均胜出。

06、如何使用LightRAG

LightRAG是开源的,用户可以按照以下步骤在本地机器上设置:

- 安装LightRAG:可以直接从源代码或通过PyPI安装。

- 环境设置:如果使用OpenAI模型,需要在环境中设置API密钥。

- 数据准备:收集要使用的数据,比如文本文件、PDF或其他格式,确保这些文件以可用的文本格式存储。

- 初始化LightRAG:在环境和数据准备好后,初始化LightRAG,配置以与不同的模型(如Hugging Face或Ollama)兼容。

- 执行查询:现在可以对文档进行查询,LightRAG支持批量插入或分块处理,以提高效率。

07、结语

LightRAG作为一种新型的开源模型,建立在传统RAG架构的基础上,但在效率和轻量化方面做出了重要改进。它通过引入图形化方法,能够更好地处理文档之间的复杂依赖关系,同时采用双层检索机制,以同时处理详细和抽象层面的查询。

这些特性使LightRAG能够比传统RAG模型更快速、更准确地检索和处理信息。随着开源技术的发展,LightRAG为研究者和开发者提供了一个强大而灵活的工具,助力他们在复杂的语言上下文中找到合适的解决方案。未来,LightRAG有望成为更多AI应用中的关键组成部分。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯