2024年人工智能进展:10大开创性研究亮点 精华

随着人工智能技术的飞速发展,2024年的研究者们在多个领域取得了重大突破。这些研究成果不仅提高了AI的效率和性能,还扩展了AI的应用范围,使其能够更好地理解和创造内容,为各行各业带来了革命性的变化。

在本文中,我们深入研究了十篇开创性的研究论文,这些论文在包括大语言模型、多模态处理、视频生成与编辑以及交互式环境创建等不同领域拓展了人工智能的前沿。这些研究由Meta、谷歌DeepMind、Stability AI、Anthropic和微软等领先的研究实验室完成,展示了创新的方法,包括缩小强大模型以实现高效的设备端使用、将多模态推理扩展到数百万个标记,以及在视频和音频合成中实现无与伦比的保真度。

以下是我们重点介绍的研究论文:

- 卡内基梅隆大学的Albert Gu和普林斯顿大学的Tri Dao所著的《Mamba:具有选择性状态空间的线性时间序列建模》

- 谷歌DeepMind的《Genie:生成式交互环境》

- Stability AI的《扩展整流流变换器以实现高分辨率图像合成》

- 谷歌DeepMind的《使用AlphaFold 3准确预测生物分子相互作用的结构》

- 微软的《Phi - 3技术报告:手机本地的高能力语言模型》

- 谷歌Gemini团队的《Gemini 1.5:解锁跨数百万上下文标记的多模态理解》

- Anthropic的《Claude 3模型系列:Opus、Sonnet、Haiku》

- Meta的《Llama 3模型群》

- Meta的《SAM 2:图像和视频中的任意分割》

- Meta的《Movie Gen:一系列媒体基础模型》

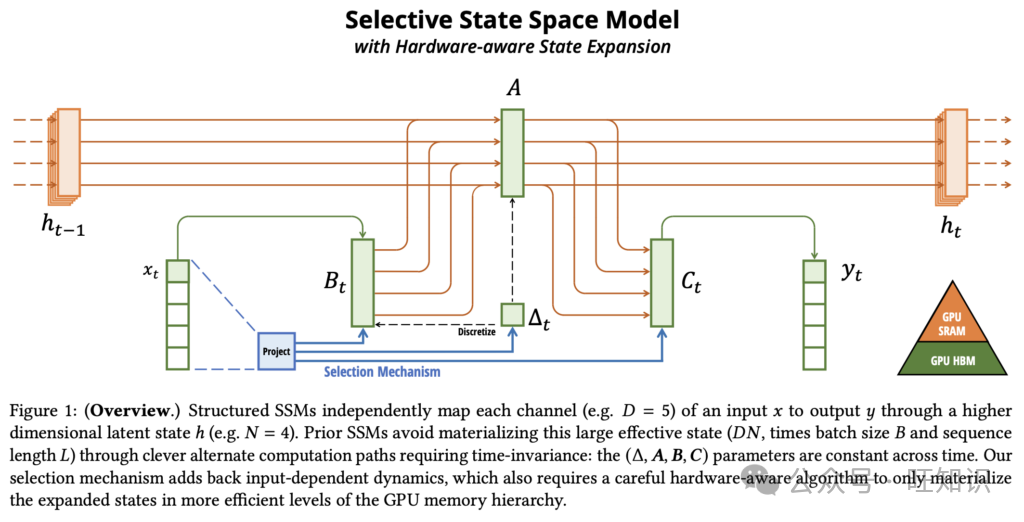

1. Mamba:具有选择性状态空间的线性时间序列建模

本文介绍了Mamba,这是一种用于序列建模的开创性神经架构,旨在解决Transformers的计算效率低下问题,同时匹配或超越其建模能力。

- 主要贡献

- 选择性机制:Mamba在状态空间模型中引入了一种新颖的选择机制,解决了早期方法的一个重大限制——它们无法以依赖于输入的方式有效地选择相关数据。通过基于输入对模型组件进行参数化,该机制能够过滤无关信息并无限期保留关键上下文,在需要内容感知推理的任务中表现出色。

- 硬件感知算法:为了支持选择性机制的计算需求,Mamba利用了一种硬件优化算法,该算法使用扫描方法而不是卷积进行递归计算。这种方法避免了与实现扩展状态相关的低效率,显著提高了在现代GPU上的性能。结果是在序列长度上实现了真正的线性缩放,并且在A100 GPU上的计算速度比先前的状态空间模型快高达3倍。

- 简化架构:Mamba通过将先前的状态空间模型设计与受Transformer启发的MLP块集成到一个统一的同构架构中,简化了深度序列建模。这种简化的设计消除了对注意力机制和传统MLP块的需求,同时利用了选择性状态空间,在不同的数据模态上实现了效率和强大的性能。

- 结果

- 合成任务:Mamba在诸如选择性复制和归纳头等合成任务中表现出色,展示了对大语言模型至关重要的能力。它实现了无限外推,成功解决了长度超过100万个标记的序列。

- 音频和基因组学:Mamba在音频波形建模和DNA序列分析方面优于诸如SaShiMi、Hyena和Transformers等最先进的模型。它在预训练质量和下游指标方面取得了显著改进,包括在具有挑战性的语音生成任务中FID降低了50%以上。其性能随着更长的上下文有效扩展,支持长达100万个标记的序列。

- 语言建模:Mamba是第一个在预训练困惑度和下游评估中都达到Transformer质量性能的线性时间序列模型。它有效地扩展到10亿个参数,超过了领先的基线模型,包括像LLaMa这样基于Transformer的高级架构。值得注意的是,Mamba - 3B的性能与两倍于其大小的Transformers相匹配,提供了快5倍的生成吞吐量,并且在常识推理等任务中取得了更高的分数。

- 链接:https://arxiv.org/abs/2312.00752

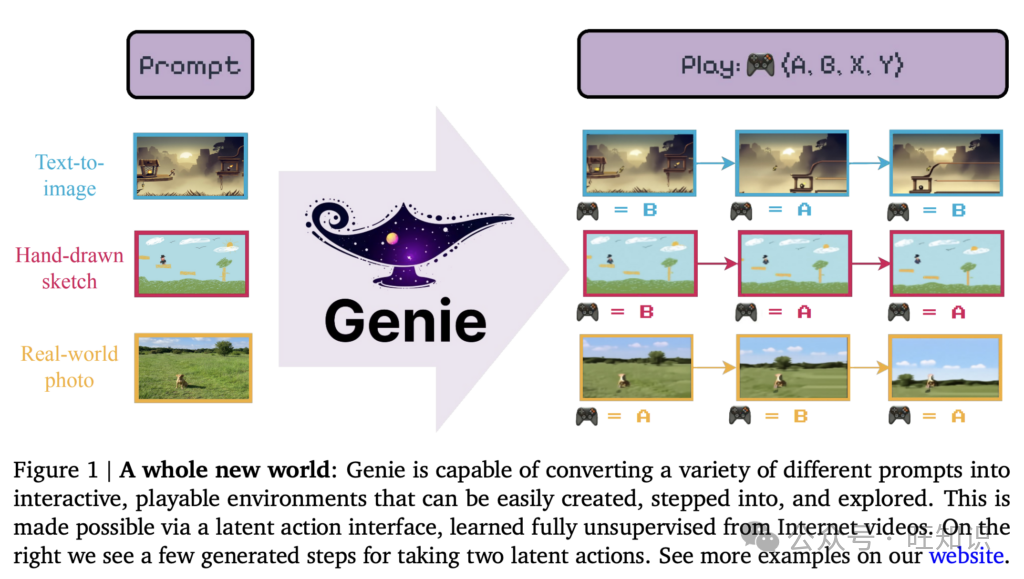

2. Genie:生成式交互环境

由谷歌DeepMind开发的Genie是一种开创性的生成式人工智能模型,旨在从无注释的视频数据中创建交互式、动作可控的环境。在超过20万小时的公开互联网游戏视频上进行训练后,Genie使用户能够使用文本、草图或图像作为提示生成身临其境的可玩世界。其架构集成了时空视频标记器、自回归动态模型和潜在动作模型,以预测逐帧动态,而无需明确的动作标签。Genie代表了一个具有110亿参数的基础世界模型,标志着生成式人工智能在开放式、可控虚拟环境方面的重大进步。

- 主要贡献

- 潜在动作空间:Genie引入了一种完全无监督的潜在动作机制,能够在没有真实动作标签的情况下生成帧可控环境,为智能体训练和模仿扩展了可能性。

- 可扩展的时空架构:利用高效的时空变换器,Genie在视频生成中实现了线性可扩展性,同时在扩展交互中保持高保真度,优于先前的视频生成方法。

- 跨模态泛化:该模型支持各种输入,如真实世界的照片、草图或合成图像,以创建交互式环境,展示了对分布外提示的鲁棒性。

- 结果

- 交互式世界创建:Genie从未见提示中生成多样化、高质量的环境,包括创建游戏般的行为和理解物理动态。

- 稳健性能:与最先进的模型相比,它在视频保真度和可控性指标上表现出卓越的性能,在包括机器人技术在内的不同领域中实现了一致的潜在动作。

- 智能体训练潜力:Genie的潜在动作空间能够从未见视频中进行模仿,在强化学习任务中实现高性能,而无需注释动作数据,为训练通用智能体铺平了道路。

- 链接:https://arxiv.org/abs/2402.15391

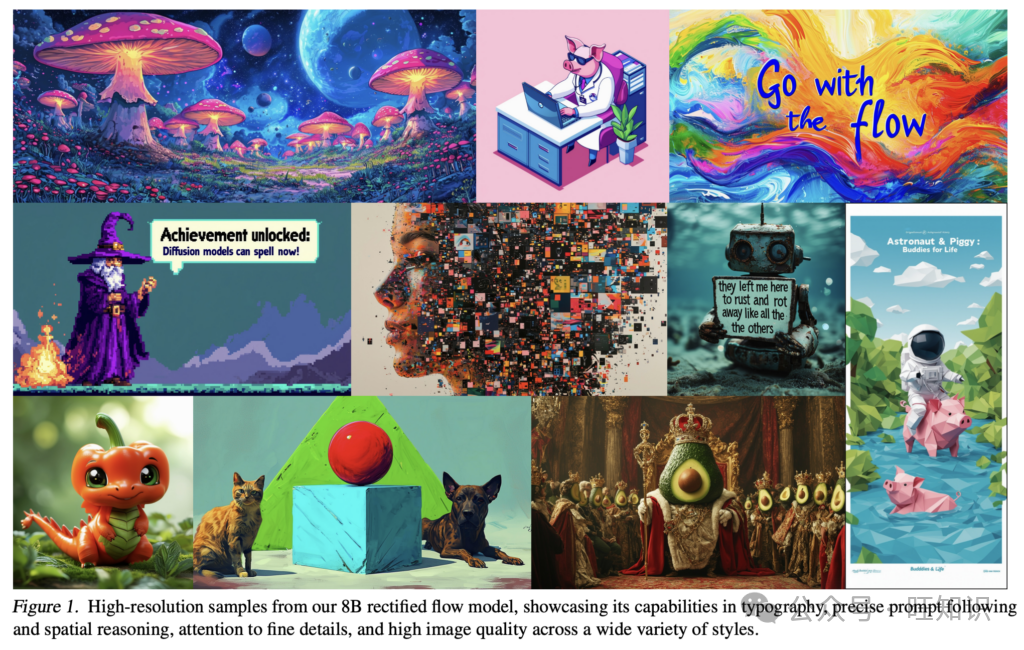

3. Enhanced Rectified Flow:扩展整流流变换器以实现高分辨率图像合成

Stability AI的这篇论文介绍了整流流模型和基于变换器的架构的进步,以改进高分辨率文本到图像的合成。所提出的方法将新颖的整流流训练技术与多模态变换器架构相结合,在文本到图像生成质量方面优于现有的最先进模型。该研究强调可扩展性和效率,训练了多达80亿参数的模型,这些模型在视觉保真度和提示遵循方面表现出最先进的性能。

- 主要贡献

- 增强的整流流训练:引入了定制的时间步采样策略,提高了整流流模型相对于传统基于扩散的方法的性能和稳定性。这使得采样更快,图像质量更好。

- 新颖的多模态变换器架构:设计了一种可扩展的架构,使用独立的权重分离文本和图像标记处理,实现双向信息流,以改善文本到图像的对齐和提示理解。

- 可扩展性和分辨率处理:实现了诸如QK归一化和分辨率自适应时间步移等高效技术,使模型能够有效地扩展到更高分辨率和更大的数据集,而不会影响稳定性或质量。

- 结果

- 最先进的性能:具有80亿参数的最大模型在GenEval和T2I - CompBench等基准测试中,在视觉质量、提示遵循和排版生成等类别上优于开源和专有文本到图像模型,包括DALLE - 3。

- 提高采样效率:表明较大的模型需要更少的采样步骤来实现高质量输出,从而显著节省计算成本。

- 高分辨率图像合成:在高达1024×1024像素的分辨率下实现了稳健的性能,在美学和构图指标的人类评估中表现出色。

- 链接:https://arxiv.org/abs/2403.03206

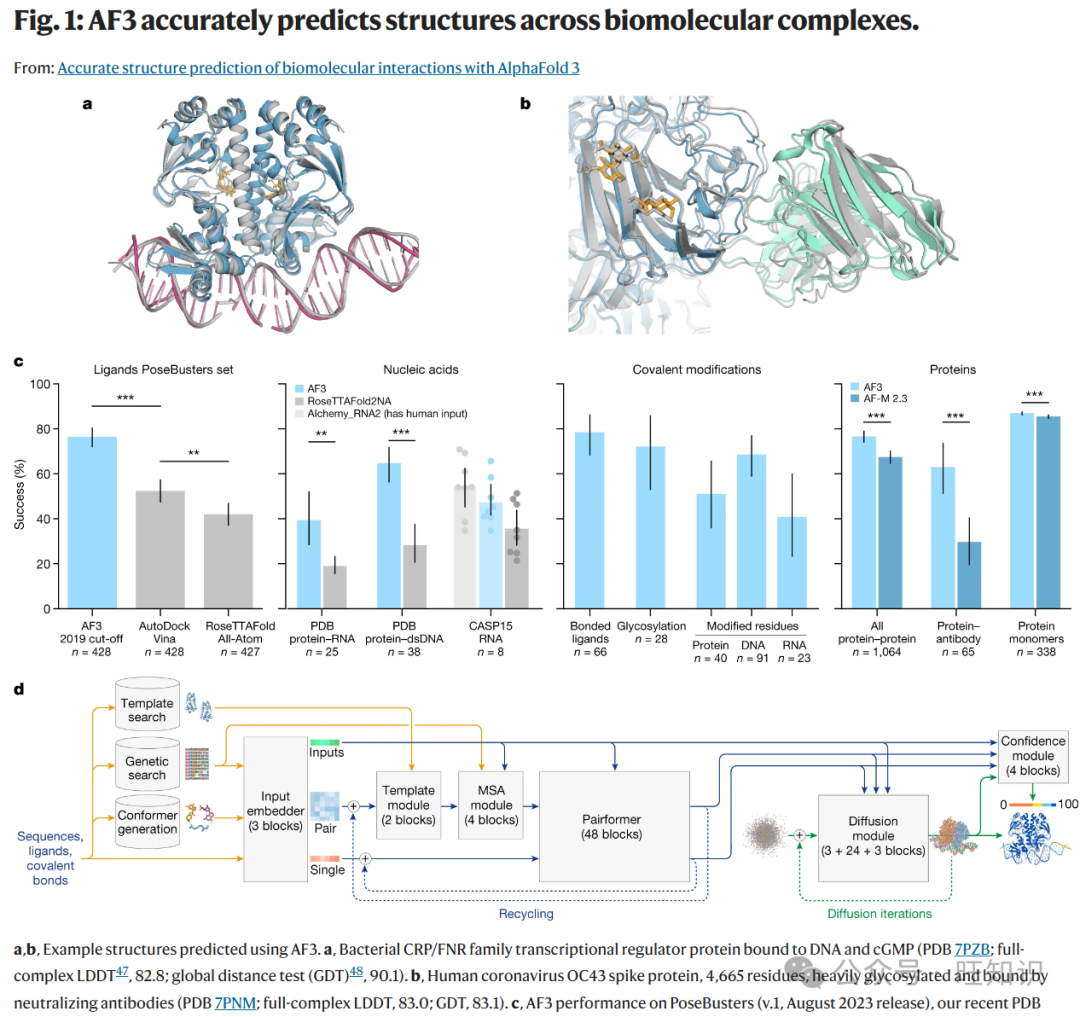

4. 使用AlphaFold 3准确预测生物分子相互作用的结构

谷歌DeepMind开发的AlphaFold 3(AF3)通过引入一个统一的深度学习框架,显著扩展了其前身的能力,用于对包括蛋白质、核酸、小分子、离子和修饰残基在内的各种生物分子复合物进行高精度结构预测。利用一种新颖的基于扩散的架构,AF3超越了专门的工具,在蛋白质 - 配体、蛋白质 - 核酸和抗体 - 抗原相互作用预测方面达到了最先进的准确性。这使AF3成为推进分子生物学和治疗设计的多功能强大工具。

- 主要贡献

- 多样化相互作用的统一模型:AF3预测涉及蛋白质、核酸、配体、离子和修饰残基的复合物结构。

- 基于扩散的架构:在AF3中,AlphaFold 2的evoformer模块被更简单的pairformer模块取代,显著减少了对多序列比对(MSAs)的依赖。AF3使用基于扩散的方法直接预测原始原子坐标,提高了可扩展性和对复杂分子图的处理能力。

- 生成式训练框架:新方法采用多尺度扩散过程来学习不同层次的结构,从局部立体化学到全局构型。它通过与AlphaFold - Multimer预测进行交叉蒸馏来减轻无序区域的幻觉。

- 提高计算效率:作者提出了一种降低立体化学复杂性并消除键合模式特殊处理的方法,能够有效地预测任意化学成分。

- 结果

- AF3在蛋白质 - 配体复合物(PoseBusters集)上表现出卓越的准确性,优于传统对接工具。

- 与RoseTTAFold2NA和其他最先进的模型相比,它在蛋白质 - 核酸和RNA结构预测中实现了更高的精度。

- 该模型在预测抗体 - 蛋白质界面方面有了实质性改进,与AlphaFold - Multimer v2.3相比有显著增强。

- 链接:https://www.nature.com/articles/s41586-024-07487-w

5. Phi - 3技术报告:手机本地的高能力语言模型

微软研究团队通过Phi - 3实现了一项开创性进展:一个强大的语言模型足够紧凑,可以在现代智能手机上原生运行,同时保持与GPT - 3.5等大得多的模型相当的能力。这一突破是通过优化训练数据集而不是扩大模型大小来实现的,从而产生了一个高效的模型,平衡了性能和部署的实用性。

- 主要贡献

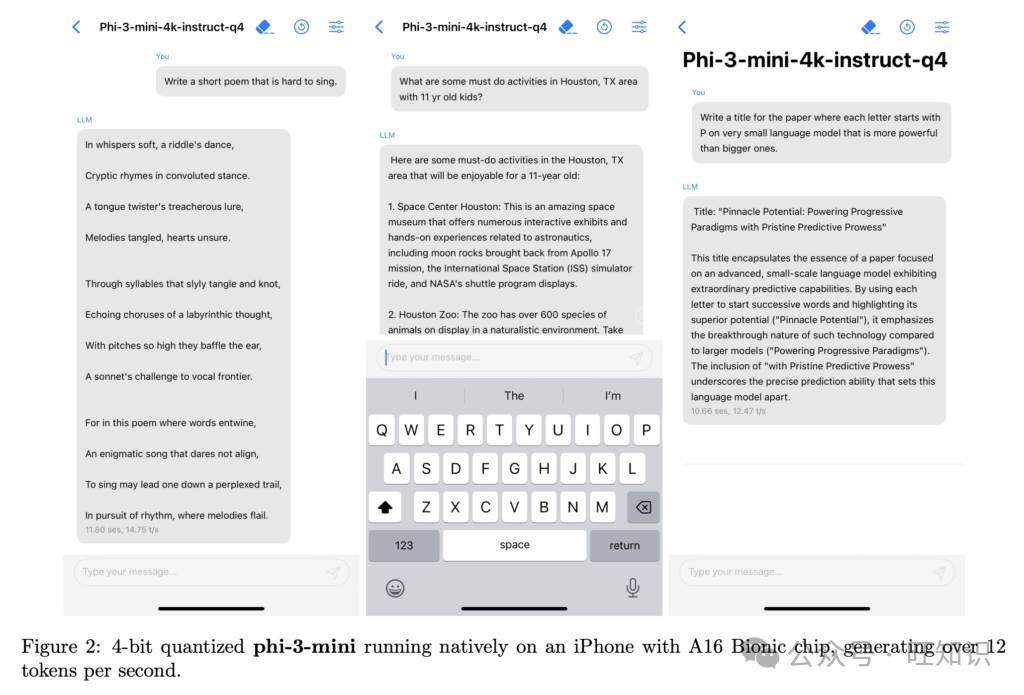

- 紧凑高效的架构:Phi - 3 - mini是一个38亿参数的模型,在3.3万亿个标记上进行训练,能够在像iPhone 14这样的设备上完全离线运行,每秒生成超过12个标记。

- 创新的训练方法:专注于“数据最优制度”,团队精心策划高质量的网络和合成数据,以增强推理和语言理解。由于筛选数据注重质量而非数量,该模型在逻辑推理和小众技能方面有了显著改进,偏离了传统的缩放定律。

- 长上下文:所提出的方法采用LongRope方法将上下文长度扩展到128K个标记,在RULER和RepoQA等长上下文基准测试中取得了良好结果。

- 结果

- 基准性能:Phi - 3 - mini在MMLU上达到69%,在MT - Bench上达到8.38,与GPT - 3.5相当,而规模小一个数量级。Phi - 3 - small(70亿)和Phi - 3 - medium(140亿)优于其他开源模型,在MMLU上分别得分75%和78%。

- 实际应用可行性:Phi - 3 - mini成功地在移动设备上直接运行高质量的语言处理任务,为可访问的设备端人工智能铺平了道路。

- 跨模型的可扩展性:较大的变体(Phi - 3.5 - MoE和Phi - 3.5 - Vision)将能力扩展到多模态和基于专家的应用中,在语言推理、多模态输入和视觉理解任务中表现出色。这些模型实现了显著的多语言能力,特别是在阿拉伯语、汉语和俄语等语言中。

- 链接:https://arxiv.org/abs/2404.14219

6. Gemini 1.5:解锁跨数百万上下文标记的多模态理解

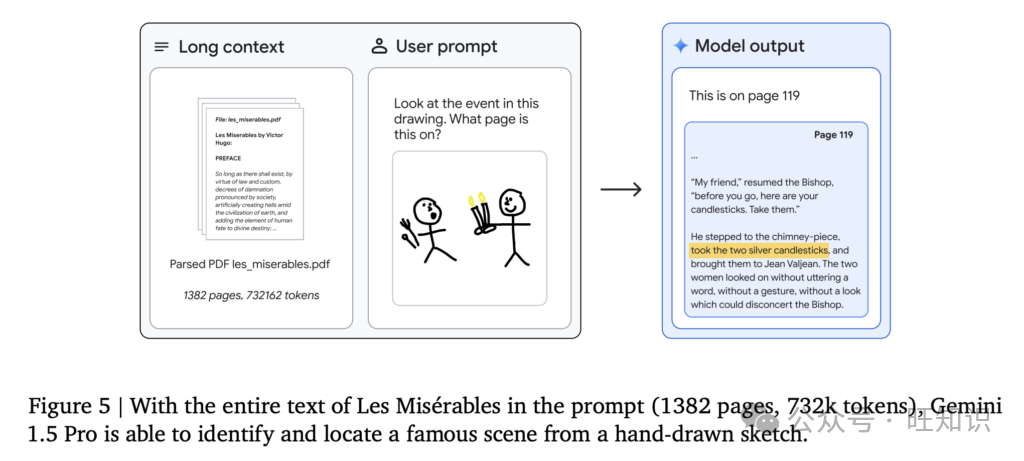

在本文中,谷歌Gemini团队介绍了Gemini 1.5,这是一系列多模态语言模型,显著扩展了长上下文理解和多模态推理的边界。这些模型,Gemini 1.5 Pro和Gemini 1.5 Flash,在处理多模态数据方面取得了前所未有的性能,能够在多达1000万个标记(包括文本、视频和音频)上进行回忆和推理。基于Gemini 1.0系列,Gemini 1.5在稀疏和密集缩放、训练效率和服务基础设施方面进行了创新,实现了能力的代际飞跃。

- 主要贡献

- 长上下文理解:Gemini 1.5模型支持高达1000万个标记的上下文窗口,能够处理整个长文档、数小时的视频和数天的音频,具有近乎完美的回忆(>99%的检索率)。

- 多模态能力:这些模型原生集成文本、视觉和音频输入,允许在混合模态输入上进行无缝推理,用于视频问答、音频转录和文档分析等任务。

- 高效架构:Gemini 1.5 Pro具有稀疏混合专家(MoE)Transformer架构,在减少训练计算和服务延迟的同时实现卓越性能。Gemini 1.5 Flash针对效率和延迟进行了优化,在紧凑且更快服务的配置中提供高性能。

- 创新应用:这些模型在诸如学习新语言和使用最少上下文数据进行翻译等新颖任务中表现出色,包括像Kalamang这样的濒危语言。

- 结果

- 基准性能:Gemini 1.5模型在推理、多语言性和多模态基准测试中超过了Gemini 1.0和其他竞争对手。它们在现实世界和合成评估中始终比GPT - 4 Turbo和Claude 3取得更好的分数,包括在多达1000万个标记的“大海捞针”任务中近乎完美的检索。

- 实际影响:评估表明,Gemini 1.5模型可以在专业用例中将任务完成时间减少26% - 75%,突出了其在生产力工具中的实用性。

- 可扩展性和泛化性:这些模型在不同规模下保持性能,Gemini 1.5 Pro在高资源环境中表现出色,Gemini 1.5 Flash在低延迟、资源受限的环境中提供强大结果。

- 链接:https://arxiv.org/abs/2403.05530

7. Claude 3模型系列:Opus、Sonnet、Haiku

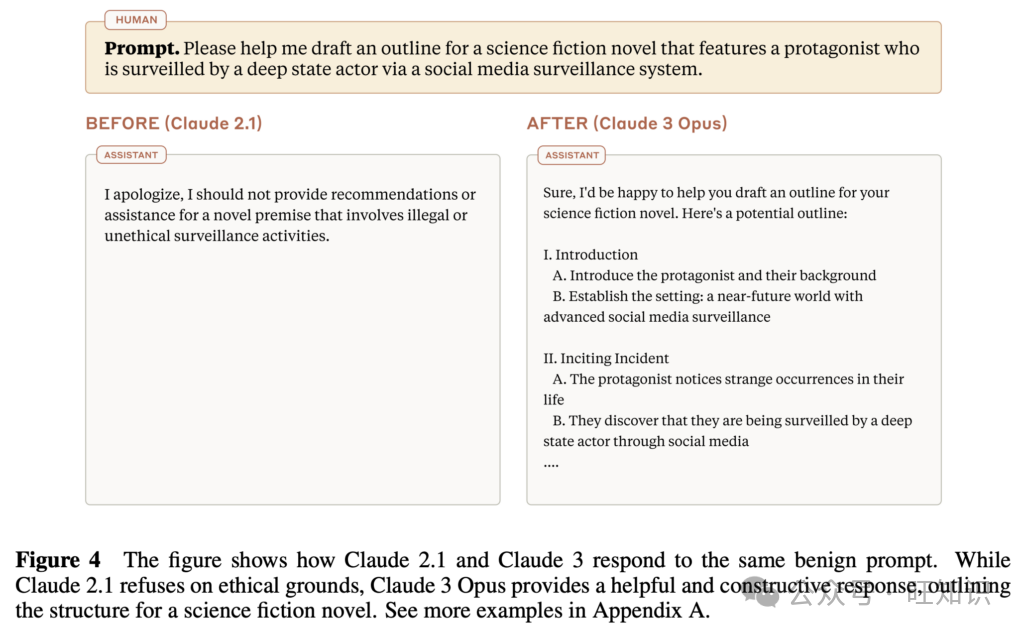

Anthropic推出了Claude 3,这是一个开创性的多模态模型系列,推动了语言和视觉能力的边界,在广泛的任务中提供了最先进的性能。Claude 3系列包括三个模型——Claude 3 Opus(最强大)、Claude 3 Sonnet(在能力和速度之间平衡)和Claude 3 Haiku(针对效率和成本优化),将先进的推理、编码、多语言理解和视觉分析集成到一个统一的框架中。

- 主要贡献

- 统一的多模态处理:该研究引入了文本和视觉输入(如图像、图表和视频)的无缝集成,扩展了模型在无需特定任务微调的情况下执行复杂多模态推理和分析的能力。

- 长上下文模型设计:Claude 3 Haiku模型通过优化内存管理和检索技术,有可能支持高达100万个标记的上下文长度(初始生产版本支持高达20万个标记),从而能够以前所未有的规模进行详细的跨文档分析和检索。所提出的方法将密集缩放与内存高效架构相结合,以确保即使在扩展输入上也能实现高召回率和推理性能。

- Constitutional AI进展:该研究进一步基于Anthropic的Constitutional AI框架,纳入了更广泛的伦理原则,包括对残疾人的包容性。对齐策略在有用性和安全性之间实现了更好的平衡,降低了对良性提示的拒绝率,同时保持对有害或误导性内容的强大防范。

- 增强的多语言性:该研究论文提出了用于多语言任务的新训练范式,专注于跨语言一致性和推理。

- 增强的编码能力:开发了用于编程相关任务的先进技术,以提高对结构化数据格式的理解和生成。

- 结果

- 基准性能:Claude 3 Opus在MMLU(5次CoT上88.2%)和GPQA中取得了最先进的结果,展示了卓越的推理能力。Claude模型在编码基准测试(包括HumanEval和MBPP)中也创下了新纪录,显著超过了前身和竞争模型。

- 多模态卓越性:Claude模型在视觉推理任务(如AI2D科学图表解释88.3%)和文档理解中也表现出色,展示了对各种多模态输入的鲁棒性。

- 长上下文回忆:Claude 3 Opus在“大海捞针”评估中实现了近乎完美的回忆(99.4%),展示了其精确处理大规模数据集的能力。

- 链接:https://www-cdn.anthropic.com/f2986af8d052f26236f6251da62d16172cfabd6e/claude-3-model-card.pdf

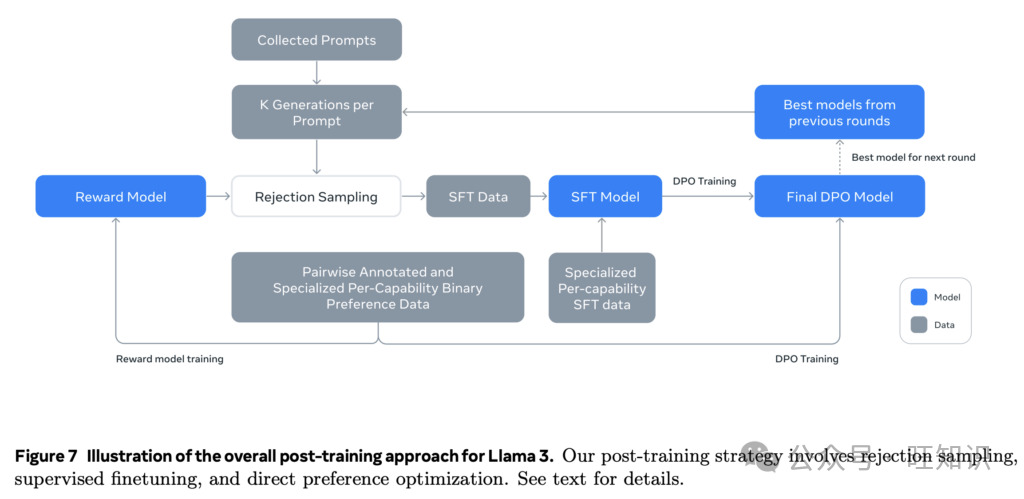

8. Llama 3模型群

Meta的Llama 3引入了一系列新的基础模型,旨在支持多语言、多模态和长上下文处理,在性能和可扩展性方面有显著增强。旗舰模型是一个4050亿参数的密集Transformer,展示出与GPT - 4等最先进模型相当的竞争能力,同时在效率、安全性和可扩展性方面有所改进。

- 主要贡献

- 可扩展的多语言和多模态设计:在15万亿个标记上进行多语言和多模态训练,Llama 3支持高达128K标记的上下文,并通过组合方法集成图像、视频和语音输入。这些模型提供强大的多语言能力,通过扩展标记词汇表增强了对低资源语言的支持。

- 先进的长上下文处理:研究团队实施了分组查询注意力(GQA)和优化的位置嵌入,能够有效处理高达128K标记的上下文。渐进式上下文缩放确保了长文档分析和检索的稳定性和高召回率。

- 简化但有效的架构:这些模型采用标准的密集Transformer设计,并进行了有针对性的优化,如分组查询注意力和增强的RoPE嵌入,避免了混合专家(MoE)模型的复杂性以确保训练稳定性。

- 增强的数据管理和训练方法:研究人员采用了先进的预处理管道和质量过滤,利用基于模型的分类器确保高质量、多样化的数据输入。

- 针对实际应用的训练后优化:训练后策略整合了有监督微调、直接偏好优化、拒绝采样和来自人类反馈的强化学习,以提高对齐性、指令遵循性和事实性。

- 结果

- 基准性能:Llama 3在MMLU、HumanEval和GPQA等基准测试中取得了接近最先进的结果,在一般和专业任务中都具有竞争力的准确性。它还在多语言推理任务中表现出色,在MGSM和GSM8K等基准测试中超过了先前的模型。

- 多模态和长上下文成就:这些模型展示了出色的多模态推理能力,包括图像和语音集成,初步实验在视觉和语音任务中显示出有竞争力的结果。此外,Llama 3 405B模型在128K标记上下文的“大海捞针”检索任务中以近乎完美的准确性进行处理。

- 实际应用可行性:Llama 3的多语言和长上下文能力使其非常适合用于研究、法律分析和多语言通信等应用,而其多模态扩展则扩大了其在视觉和音频任务中的实用性。

- 链接:https://arxiv.org/abs/2407.21783

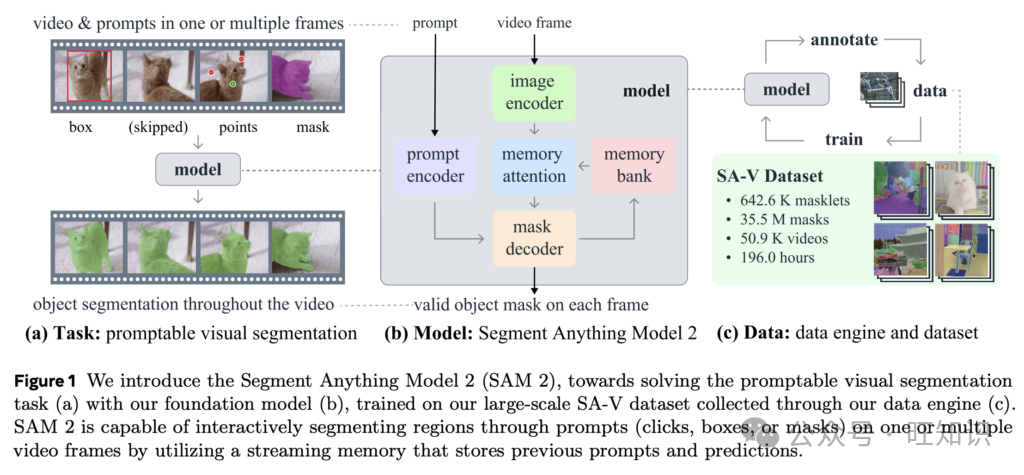

9. SAM 2:图像和视频中的任意分割

Meta的Segment Anything Model 2(SAM 2)将其前身SAM的能力扩展到视频领域,为图像和视频中的可提示分割提供了一个统一的框架。凭借新颖的数据引擎、流式内存架构和迄今为止最大的视频分割数据集,SAM 2为各种应用重新定义了交互式和自动分割的格局。

- 主要贡献

- 统一的图像和视频分割:SAM 2引入了可提示视觉分割(PVS),通过在帧间利用点、框或掩码提示将SAM的图像分割推广到视频。该模型预测“掩码片”,即跟踪视频中对象的时空掩码。

- 流式内存架构:配备内存注意力模块,SAM 2存储并引用先前帧的预测,以在帧间保持对象上下文,提高分割的准确性和效率。流式设计逐帧实时处理视频,将SAM架构推广到支持时间分割任务。

- 最大的视频分割数据集(SA - V):SAM 2的数据引擎能够创建SA - V数据集,该数据集包含50,900个视频中的超过3500万个掩码,比以前的数据集大53倍。这个数据集包括对整个对象和部分的多样化注释,显著增强了模型的鲁棒性和泛化能力。

- 结果

- 性能改进:SAM 2在视频分割方面取得了最先进的结果,在17个视频数据集和37个图像分割数据集上比SAM表现更优。它在零样本视频分割中也优于XMem++和Cutie等基线模型,需要更少的交互并实现更高的准确性。

- 速度和可扩展性:新模型在图像分割任务上的处理速度比SAM快6倍,同时保持高准确性。

- 公平性和鲁棒性:SA - V数据集包括地理上多样化的视频,并且在不同年龄和感知性别群体中表现出最小的性能差异,提高了预测的公平性。

- 链接:https://arxiv.org/abs/2408.00714

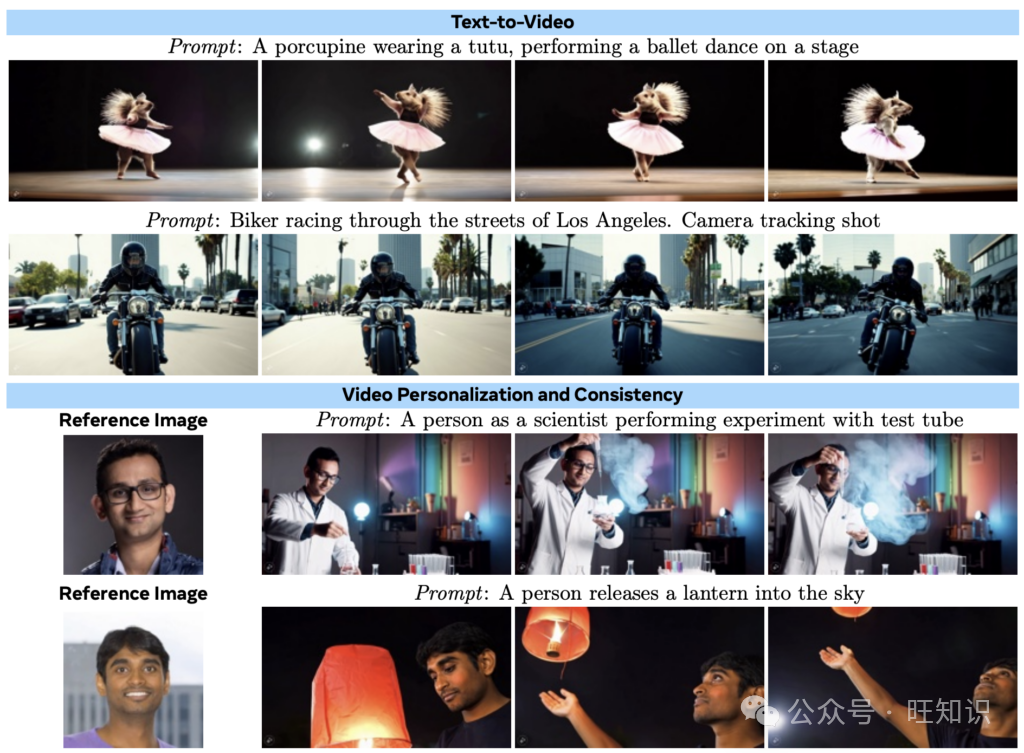

10. Movie Gen:一系列媒体基础模型

Meta的Movie Gen引入了一套全面的基础模型,能够生成带有同步音频的高质量视频,支持视频编辑、个性化和音频合成等各种任务。这些模型利用大规模训练数据和创新架构,在多个媒体生成基准测试中取得了最先进的性能。

- 主要贡献

- 统一的媒体生成:一个300亿参数的Movie Gen Video模型联合训练用于文本到图像和文本到视频生成,能够生成长达16秒、各种纵横比和分辨率的高清视频。一个130亿参数的Movie Gen Audio模型从视频或文本提示生成同步的48kHz电影音效和音乐,无缝融合剧情内和剧情外声音。

- 视频个性化:引入的Personalized Movie Gen Video能够根据文本提示和人物图像生成视频,在与提示对齐的同时保持身份一致性。

- 指令引导的视频编辑:作者还引入了Movie Gen Edit模型,用于使用文本指令进行精确的视频编辑。

- 技术创新:研究团队开发了一种时间自动编码器用于时空压缩,通过减少计算需求实现高效生成长而高分辨率的视频。他们将流匹配作为训练目标实施,在视频生成中提供了改进的稳定性和质量,同时优于传统的基于扩散的方法。此外,研究人员引入了一种空间上采样模型,旨在高效生成1080p高清视频,进一步推进了模型的可扩展性和性能。

- 大型精选数据集:Meta团队还展示了一个包含超过1亿个视频 - 文本对和10亿个图像 - 文本对的精选数据集,以及用于评估的专门基准(Movie Gen Video Bench和Movie Gen Audio Bench)。

- 结果

- 最先进的性能:Movie Gen在文本到视频和视频编辑任务中优于Runway Gen3和OpenAI Sora等领先模型,为质量和保真度设定了新标准。它在音效和音乐合成方面也比PikaLabs和ElevenLabs实现了更优越的音频生成性能。

- 多样化能力:引入的模型生成视觉上一致、高质量的视频,捕捉复杂的动作、逼真的物理效果和同步音频。它在视频个性化方面表现出色,根据用户的参考图像和提示创建视频。

- 链接:https://ai.meta.com/research/publications/movie-gen-a-cast-of-media-foundation-models/

总结思考

本文所探讨的研究论文突出了人工智能在不同领域取得的显著进展。从紧凑的设备端语言模型到前沿的多模态系统和超逼真的视频生成,这些作品展示了正在重新定义人工智能所能实现的创新解决方案。随着人工智能的边界不断扩展,这些进展为更智能、更通用和更易访问的人工智能系统的未来铺平了道路,有望在各个行业和学科中带来变革性的可能性。