独立与依赖:为何Musk也应建AI云平台

Tesla Dojo

- Tesla自研的D1芯片采用7纳米制程,包含354个核心,每个核心拥有1.25 MB SRAM,支持多种数据格式。单芯片计算能力达362 TFLOPS,专为自动驾驶AI并行计算优化。

- Dojo V1系统包含6个训练模块,共5.31万个核心,运算能力为1 exaflops;完整ExaPod系统扩展至120个模块,106.2万个核心,目标运算能力为20 exaflops。

- 每个训练模块提供9 petaflops计算能力,配备高带宽内存,单模块功耗15千瓦。采用水冷设计,内存带宽达400 GB/s(读取)和270 GB/s(写入)。

- 该系统专为全自动驾驶(FSD)神经网络定制,能处理数十亿英里实时驾驶数据,交通标识识别精度高达99.9%。

- 2023年7月投产,预计2024年10月计算能力将突破100 exaflops。已投入超10亿美元支持芯片研发,瞄准10万亿美元机器人服务市场。

xAI Colossus

- 初期配置10万个Nvidia H100 GPU,计划近期扩展至20万个GPU,其中包括5万个H200 GPU。

- 硬件由Supermicro和Dell提供,将位于田纳西州孟菲斯市郊的一家Electrolux工厂旧址。

- 预计建造成本约47亿美元。xAI已完成融资114亿美元,最新一轮50亿美元融资将用于Colossus建设和数据中心运营。

- 该系统主要用于训练Grok系列模型,包括Grok-1(3140亿参数)和更高参数量的Grok-2,性能超越多数竞争对手。

- 不仅服务xAI,还可能与Tesla、SpaceX等公司协作,在自动驾驶和机器人技术领域提供强大计算支持。

Amazon

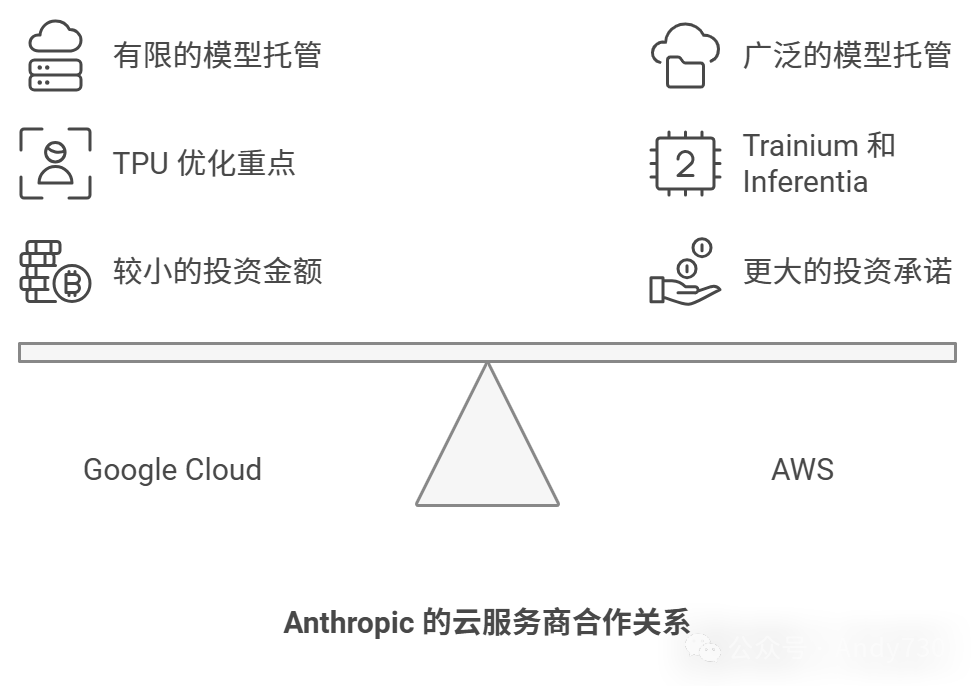

- 向Anthropic投资40亿美元,获得少数股权,投资额为Google的1.57倍(25.5亿美元),并将Claude模型整合到Bedrock AI服务中。

- 开发Trainium和Inferentia芯片,旨在降低生成式AI运行成本,相比传统GPU可减少50%以上开支。

- 2023年4月推出Bedrock平台,提供Claude等模型。截至2023年10月,已拥有超过1万个企业客户。

- 在Nvidia两代产品周期内购买200万个GPU。2023年获得5万个H100 GPU(价值15亿美元),2022年获得2万个,另有193万个A100 GPU。总投资规模达241.3亿美元。

Google(Alphabet)

- 向Anthropic投资25.5亿美元,获得少数股权。将Claude模型部署到Google Cloud,并为TPU加速器优化模型性能,旨在与微软和OpenAI竞争。

- 2015年启动TPU加速器,专门用于人工智能工作负载。自主开发Gemini大型语言模型,并在Google Cloud平台部署。

Microsoft

- 向OpenAI投资130亿美元,获得少数股权(估计8.3%以下)。已将GPT模型整合到Azure、Bing、Office等产品中,提升技术竞争力。

- 开发Maia AI芯片系列,用于加速AI推理和训练。目标降低对Nvidia GPU的依赖,提升AI硬件领域的竞争力。

Anthropic

- 通过与Amazon和Google合作,分别获得40亿和25.5亿美元投资,获得算力资源支持。

- 与AWS合作,将Claude模型移植到Trainium和Inferentia芯片,并参与未来芯片设计。

- 通过AWS Bedrock平台和API,为开发者和用户提供Claude模型的接入和使用。

如果Amazon希望在与Google和Microsoft的竞争中脱颖而出,就必须确保其自主研发的加速器能运行最顶尖的模型。正如Google在自研的TPU上运行Gemini大语言模型,Microsoft未来也将借助自有的Maia加速器部署OpenAI的GPT模型。因此,Amazon旗下的云计算巨头AWS近期向Anthropic投资40亿美元,实属情理之中。

作为云计算行业的领导者,AWS正是高端IT产品高额支出的最大受益者。这一事实以及相关因素,预示着未来数年内,Amazon与Anthropic、Microsoft与OpenAI将持续大规模投资,直到这些AI公司积累足够资本,可以自主研发AI加速器并建立独立基础设施。模型开发商与云服务商之间的合作,折射出一套深谋远虑的系统性战略。

今年8月,我们部分探讨了这一议题(资金回流效应:AI投资如何推高云计算增长?),分析了Microsoft Azure和AWS的财务状况,以及两家母公司分别向OpenAI和Anthropic投资的130亿美元和40亿美元。我们曾质疑2024年云计算支出增长中,有多大比例源于Amazon和Microsoft对AI初创企业的投资。我们认为这一比例相当可观,并建议相关数据应在财报中披露。

Google母公司Alphabet已向Anthropic投资25.5亿美元,意在分散大语言模型领域的风险。华尔街为AI的持续投资而欢欣鼓舞,这片科技新大陆似乎永远生机勃勃。然而,所有投资的果实终将成熟,人们既期待AI的丰硕回报,又忧虑其对知识经济的潜在冲击。

2023年9月,我们已深入剖析了Anthropic的发展历程。当时,AWS向Anthropic投资12.5亿美元,并达成合作,将Claude系列大语言模型迁移到AWS自研的Trainium AI训练芯片和Inferentia AI推理芯片上。我们在2023年12月详细解析了Trainium和Inferentia芯片,阐明了AWS如何通过这一策略削减Nvidia GPU的成本。

今年3月,Amazon又向Anthropic追加27.5亿美元投资,上周再次注资40亿美元。按我们此前测算,仅使用Nvidia Hopper H100加速器训练约30个参数规模为2万亿的大语言模型,90天内就需耗资40亿美元。拥有性能可靠且数量充足的自研AI芯片,可将单位成本显著降低,使AWS在AI集群上的性价比超越昂贵的Nvidia GPU。此外,随着Claude模型针对Trainium和Inferentia芯片进行优化,Anthropic有望成为这些芯片的最大客户。AWS则可根据Anthropic软件需求持续迭代硬件,形成良性循环,并将这一模式扩展到其Bedrock AI平台服务。

自Bedrock平台一年前正式推出以来,已支持Claude和多种大语言模型,目前已有数万名客户为Claude的云服务付费。在Bedrock平台上运行的Claude模型(Claude models on Bedrock)未来的收入流可能达到一个临界点,其利润足以抵消Amazon在零售和娱乐业务中的AI训练与推理成本。这一盈利拐点可能已在通用数据中心基础设施层面出现,尽管精确的时间节点难以确定。

这一战略的精妙之处在于,通过运营大型云服务并跨界发展,实现业务协同效应。以Microsoft为例,其核心业务是软件分发与使用追踪;Amazon则专注于在线商品销售及物流分发。Google的模式尚未完全成熟,尽管Google Cloud目前未盈利,但我们相信,随着时间推移,其通过搜索、视频流媒体和广告业务支撑IT基础设施的模式终将见效。

我们预计,主要云服务商对大型语言模型(LLM)开发商的投资将持续增长。即便这些LLM开发商通过独立融资不断提升估值,同时让云服务商保持少数股东身份。这种平衡策略可能是Elon Musk不选择与Oracle Cloud合作建设10万块GPU组成的“Colossus”超级计算机的原因之一。他选择接管田纳西州孟菲斯市郊的一家前Electrolux吸尘器工厂,并委托Supermicro和Dell制造硬件。Musk深知,基于Tesla和SpaceX的经验,云端AI成本远高于本地化部署。长远来看,我们不排除Tesla开发的Dojo AI引擎将在Musk旗下的X(前Twitter)、xAI、Tesla和SpaceX四家公司广泛应用。更值得关注的是,Dojo技术可能从Tesla剥离,并向其他Musk旗下公司出售。何乐而不为?

对于OpenAI和Anthropic而言,其独立性依赖于通过高估值融资轮持续筹集资金,这一过程既提高公司估值,又稀释云服务商的股份。根据公开信息,Anthropic估值约180亿美元,对AWS这一少数股东而言相对偏低。我们测算,若按投资金额与估值比例,Amazon持股可能为44.4%;若以AWS投资额占总融资额137亿美元的比例计算,持股比例可达58.4%,但这并非业内标准计算方法。

OpenAI上月筹集66亿美元,估值达1570亿美元,获得Microsoft、Nvidia、SoftBank等总计219亿美元投资。预计今年收入可达37亿美元,但同时将亏损50亿美元。若将Microsoft投资视为直接融资,其持股比例理论上可达59.3%,但实际情况显然并非如此。我们测算,Microsoft投入的130亿美元约占估值的8.3%。

至于xAI,目前估值在400至450亿美元之间。公司已通过四轮融资筹集114亿美元,包括最近完成的50亿美元融资轮。我们估计此轮融资足以支付Colossus超级计算机及数据中心成本,单是10万块H100 GPU系统和网络设备就需约47亿美元。

Musk最终可能建立自身云服务?从商业逻辑上来看,这似乎是必然。届时,xCloud将为Tesla、SpaceX、xAI和X的数据处理需求提供补贴。

同样,我们认为Nvidia进军云服务领域也是大概率事件,其中蕴含的利润空间极具吸引力。Nvidia联合创始人兼CEO Jensen Huang与Musk会否携手建设云服务?虽然听起来有些荒谬,但在IT行业,更匪夷所思的合作也曾出现。不过,他们分别建立竞争云服务的场景倒是颇具想象空间。

参考资料:Prickett Morgan, Timothy. "Anthropic And OpenAI Show Why Musk Should Build A Cloud." The Next Platform, November 25, 2024. https://www.nextplatform.com/2024/11/25/anthropic-and-openai-show-why-musk-should-build-a-cloud/.

本文转载自 Andy730,作者: 常华Andy