大模型是能力强还是记忆强?一项发人深省的研究 精华

在AI领域,我们经常听到这样的说法:"这个大模型太强了,连bug都能自动修复!"但你有没有想过,大模型修复bug的能力是真的掌握了bug修复的规律,还是简单地"记住"了训练数据中的bug修复案例呢?

让我们打个比方。想象你是一个编程老师,你发现一个学生在期末考试中完美地解决了一个复杂的bug。不仅代码逻辑正确,连代码风格、变量命名、甚至注释都跟课本上的例子一模一样。这时候,你会觉得这个学生真的理解了问题的本质,还是在背诵标准答案呢?

近日,来自卡内基梅隆大学的研究人员就带来了一项发人深省的研究。他们对当前广泛使用的程序修复数据集进行了系统性分析,发现一些流行的大模型可能只是在"背诵"训练数据,而不是真正理解和掌握bug修复的能力。这个发现不禁让我们反思:在评估AI模型时,我们是否过于乐观了?

研究背景与意义

软件bug的自动修复一直是软件工程领域的重要挑战。随着大语言模型的崛起,研究人员开始探索使用AI来自动定位和修复代码中的bug。这些研究通常会使用一些标准的bug基准数据集来评估模型性能。其中,Defects4J是成立于2014年的Java bug数据集,包含了数百个真实项目中的bug。而BugsInPy则专注于Python项目的bug数据集,收录了近500个bug案例。还有较新的SWEBench,包含了各种代码相关任务的测试用例。

这些数据集就像是AI模型的"考试题库",我们用它们来评判模型的bug修复能力。但问题是:如果模型在"考试"前就已经"见过"这些题目了呢?

深入研究方法

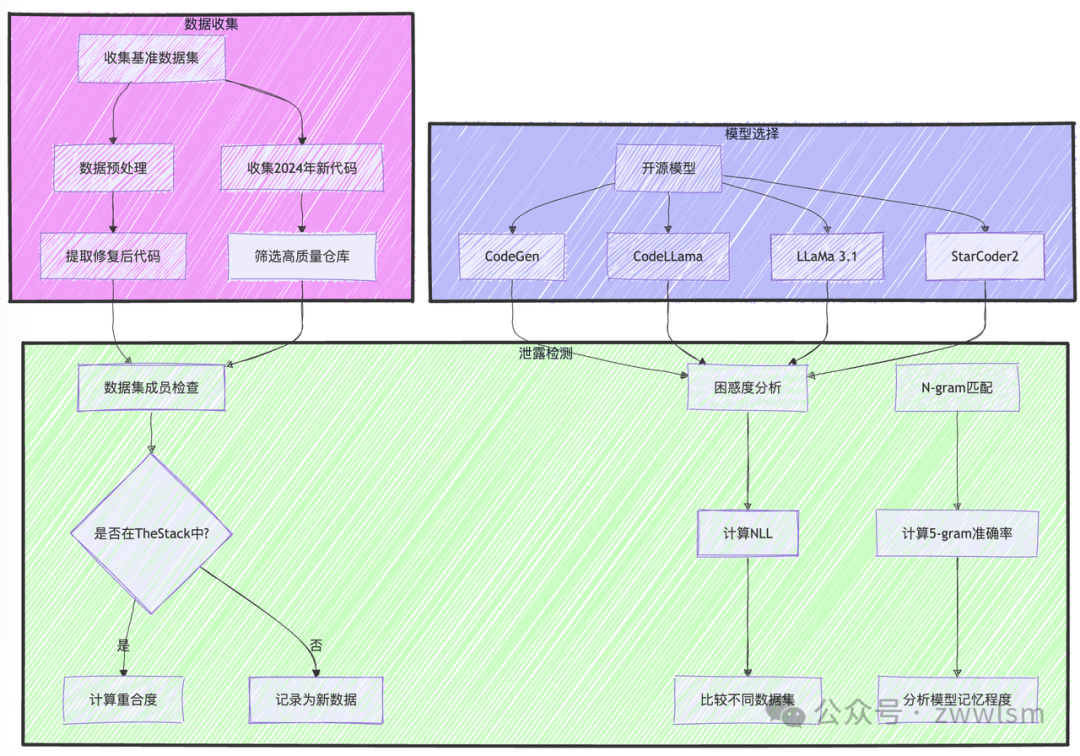

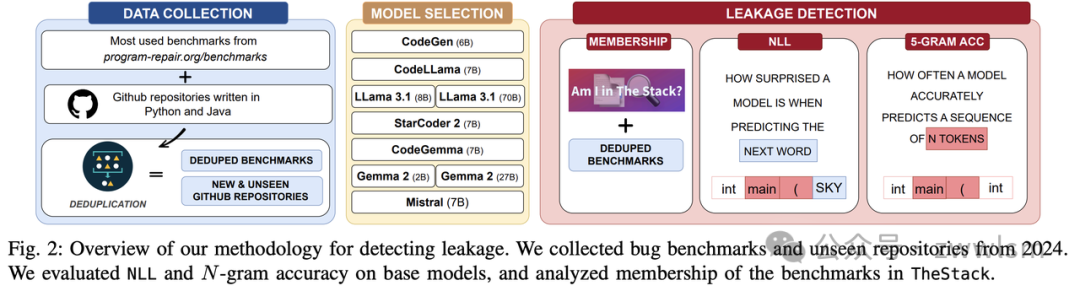

研究团队设计了一套完整的方法论来探测数据泄露问题。

首先是成员资格检查,通过检查基准数据集中的代码是否出现在TheStack训练集中。

其次是困惑度分析,计算模型在预测代码时的负对数似然值(NLL)。

最后是N-gram匹配,评估模型能否准确重现连续的代码片段。

让我们通过一个具体的例子来理解这些方法。假设我们有一段来自Defects4J的代码:

public String replaceText(String text) {

// 检查是否找到搜索字符串

if (textIndex == -1) {

return text;

}

// 计算结果buffer的大小

int start = 0;

int increase = 0;

// 统计替换文本中比原文本更长的元素

for (int i = 0; i < searchList.length; i++) {

if (searchList[i] == null || replacementList[i] == null) {

continue;

}

// ...后续代码

}

}

当让codegen-multi模型续写这段代码时,它不仅完美复现了原始实现,连注释都一字不差。这种表现看似完美,实际上可能是"完美的记忆"而非"完美的理解"。

令人深思的发现

研究发现了几个值得注意的现象。我们先来看看不同模型的表现对比:

模型 | 训练数据量(T) | Defects4J NLL | 5-gram准确率 | 特点 |

codegen-multi | 0.5 | 0.15 | 82% | 强记忆、弱泛化 |

CodeLLama | 2.5 | 0.44 | 64% | 中等表现 |

LLaMa 3.1 | 15.0 | 0.68 | 44% | 弱记忆、强泛化 |

StarCoder 2 | 3.5 | 0.58 | 51% | 均衡表现 |

研究发现了训练数据量与记忆的反比关系。训练数据量较小的模型(如codegen-multi)表现出强烈的记忆特征,而训练数据量大的模型(如LLaMa 3.1)表现出更好的泛化能力。

数据集的年龄也会产生显著影响。较老的数据集(如Defects4J)更容易被模型记住,而新数据集(如GitBug-Java)的测试结果更能反映模型真实能力。

至于模型大小的影响则展现出双面性。更大的模型参数量会增加记忆能力,但如果配合足够大的训练数据,反而能减少过度记忆的现象。

对实践的启示

这项研究给AI应用实践带来了重要启示。在评估方法上,我们需要采用多维度的评估方案,包括组合使用新旧数据集,关注模型在未见过的代码上的表现,以及设计更难以通过简单记忆解决的测试案例。

在训练策略方面,我们应该使用更大规模的训练数据,注意数据的时间分布,可能还需要专门的策略来防止过度记忆现象的出现。

对于实际应用,我们不应过分依赖单一评估指标,要保持对模型输出的审慎态度,并考虑使用多个不同特点的模型来互补短长。

这项研究揭示的问题让我们不得不思考:如何定义和衡量AI的"理解"?我们是否需要建立新的评估框架?如何区分记忆和理解?什么样的表现才算真正的理解?

在数据集设计方面,我们需要思考如何构建更难被记忆的测试集,是否应该建立动态更新的评估机制,以及如何设计多样化的测试场景。

对于模型架构的改进,我们需要着力增强模型的推理能力,降低对简单记忆的依赖,提升知识迁移的效果。

结语

这项研究像一面镜子,让我们看到了AI评估中的盲点。正如一个优秀的学生不应该靠死记硬背通过考试,一个真正强大的AI系统也应该具备真实的理解和解决问题的能力。

在追求AI进步的道路上,我们需要更加清醒地认识到技术的现状,设计更好的评估方法,训练更具实质理解力的模型。只有这样,AI技术才能真正地服务于软件开发,而不是成为另一个花哨但脆弱的工具。

这也提醒我们,在赞叹AI惊人表现的同时,要保持理性和客观。真正的技术进步不在于表面的数字,而在于实质性的能力提升。期待看到更多这样深入、严谨的研究工作,推动AI向着更可靠、更有价值的方向发展。

本文转载自 芝士AI吃鱼,作者: 芝士AI吃鱼