Jina CLIP v2:为多模态RAG设计的向量模型 原创

多模态的数据通过统一的向量表示,可以实现不同模态数据的互相检索或者理解转换,是多模态 AI 应用的基石。Jina.ai最近推出了全新的通用多语言多模态向量模型 Jina CLIP v2,在实现强大跨模态检索可能的同时,也为多模态RAG应用奠定了基础。

Paper: https://arxiv.org/abs/2405.20204

Model: https://huggingface.co/jinaai/jina-clip-v2

概览

Jina-CLIP V2 是一款通用的、多语言、多模态(文本与图像) Embedding 模型

多模态embedding技术能够通过一致的表示方式,实现跨不同模态的数据搜索和理解。Jina-CLIP V2 基于Jina-CLIP V1和我们最近发布的Jina-Embeddings V3构建,带来了几项重大改进:

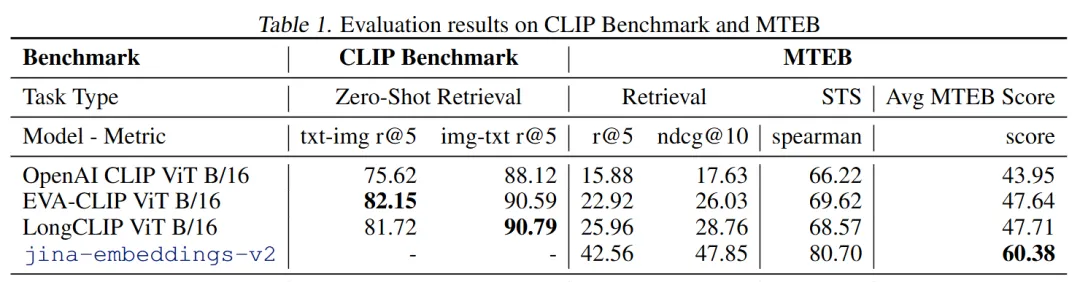

🚀 性能提升:与V1相比,V2在文本-图像和文本-文本检索任务中展现了3%的性能提升。与V1类似,V2的文本编码器可以作为一个有效的多语言长文本密集检索器。其性能与我们的前沿模型Jina-Embeddings V3相当(目前是MTEB上最好的1B参数以下的多语言Embedding模型)。

🌈 多语言支持:Jina-CLIP V2的文本部分使用了与Jina-Embeddings V3相同的架构,支持89种语言的多语言-图像检索,与nllb-clip-large-siglip相比,在多语言图像检索任务中显示出高达4%的性能提升。

🔍 更高图像分辨率:Jina-CLIP V2现在支持512x512的输入图像分辨率,这是从V1的224x224的显著提升。这一更高分辨率使得V2能够更好地处理细节图像,改进特征提取,并更准确地识别细粒度的视觉元素。

🌟 可变维度输出:Jina-CLIP V2引入了套娃式表示学习(Matryoshka Representation Learning,MRL)技术,只需设置 dimensions 参数,即可获取指定维度的向量输出,且在减少存储成本的同时,保持强大的性能。

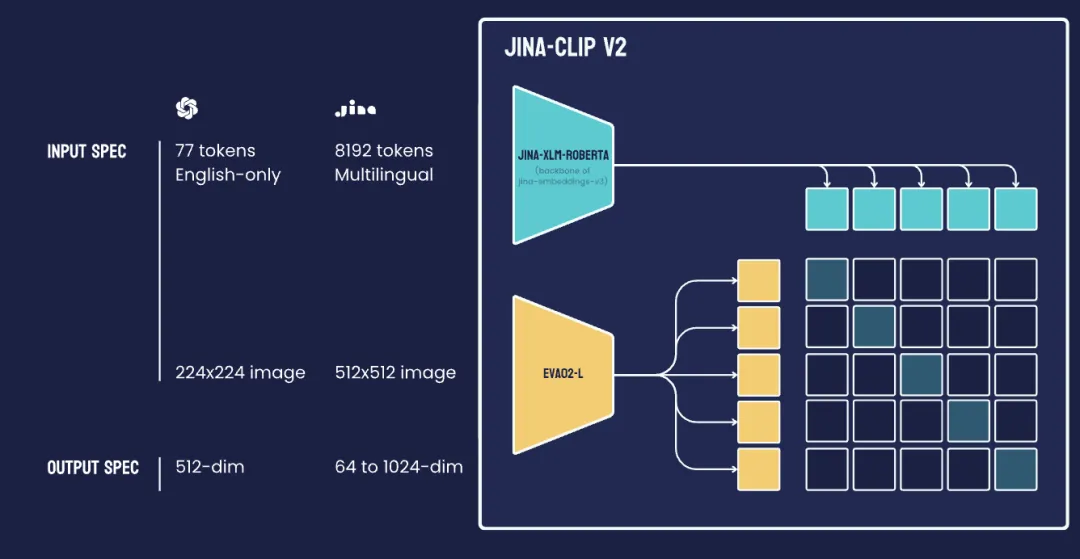

模型结构

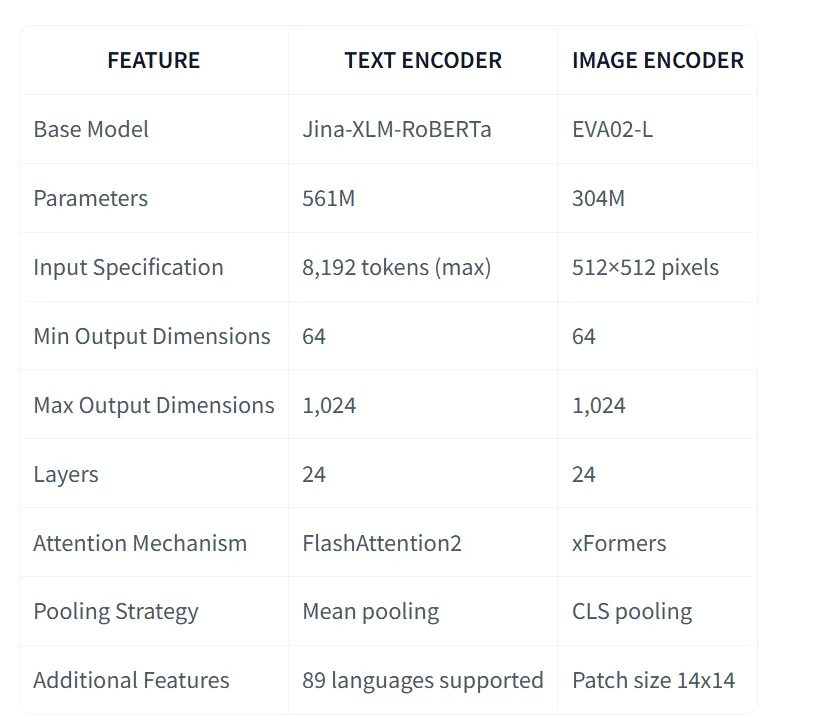

Jina-CLIP V2参数量达到0.9B,融合了两个强大的编码器:

- 文本编码器为Jina-XLM-RoBERTa,也是Jina-Embeddings V3的核心;

- 视觉编码器为EVA02-L14,由BAAI开发的CLIP ViT模型。

这两个编码器的结合,使得Jina-CLIP V2在多模态任务中表现出色,能够同时处理文本和图像数据,为用户提供更加精准和高效的信息检索与理解能力。

这些编码器经过CLIP联合训练,以创建对齐的图像和文本表示。

类似于CLIP的模型已经成为通用多模态应用的骨干。有了Jina-CLIP V2,正在将这些能力提升到一个新的水平,打破语言障碍,提供更准确的跨模态理解和检索。

性能

在跨模态检索任务中,Jina CLIP v2 支持 89 种语言,在包括中文、英语、法语、德语、日语、俄语、阿拉伯语和西班牙语在内的主要语种中都表现优异。性能比目前最先进的 CLIP 模型 NLLB-CLIP-SigLIP 相当甚至更好。

Jina-CLIP V2 的文本和图像编码器均引入了套娃式表征学习(Matryoshka Representation Learning, MRL)技术,来实现灵活的灵活的输出维度长度。输出维度可以从 1024 截断至 64 维,并在很大程度上能保持原有性能。

评估结果表明,即使是激进的 75% 维度削减,模型在文本、图像和跨模态任务中仍能保持 99% 以上的性能,展现出了 Jina-CLIP V2 极高的压缩效率。

本文转载自公众号思源数据科学 作者:思源Source

原文链接:https://mp.weixin.qq.com/s/5auciYvg7MmpDS57bavb9Q