解密o1推理过程!DeepSeek-R1-Lite预览版上线

GPT-o1通过强化学习训练优化决策策略,并模拟人类思维链以深入理解问题,提供更准确的答案,在多个推理任务相关的榜单上实现了巨大的突破。而o1的思维过程是隐藏的。幻方旗下国产大模型公司DeepSeek近期预发布了R1模型,使用了强化学习训练,回复里包含大量反思和验证,思维链长度可达数万字,并且没有像o1一样隐藏思维链。

Demo: https://chat.deepseek.com

[模型和技术报告将会开源]

DeepSeek R1

DeepSeek R1 系列模型采用强化学习进行训练,具备深度反思和验证能力,能够构建长达数万字的思维链。在数学、编程和复杂逻辑推理等任务上,该系列模型展现出与o1-preview相媲美的推理能力,同时向用户展示了o1未公开的完整思考路径。

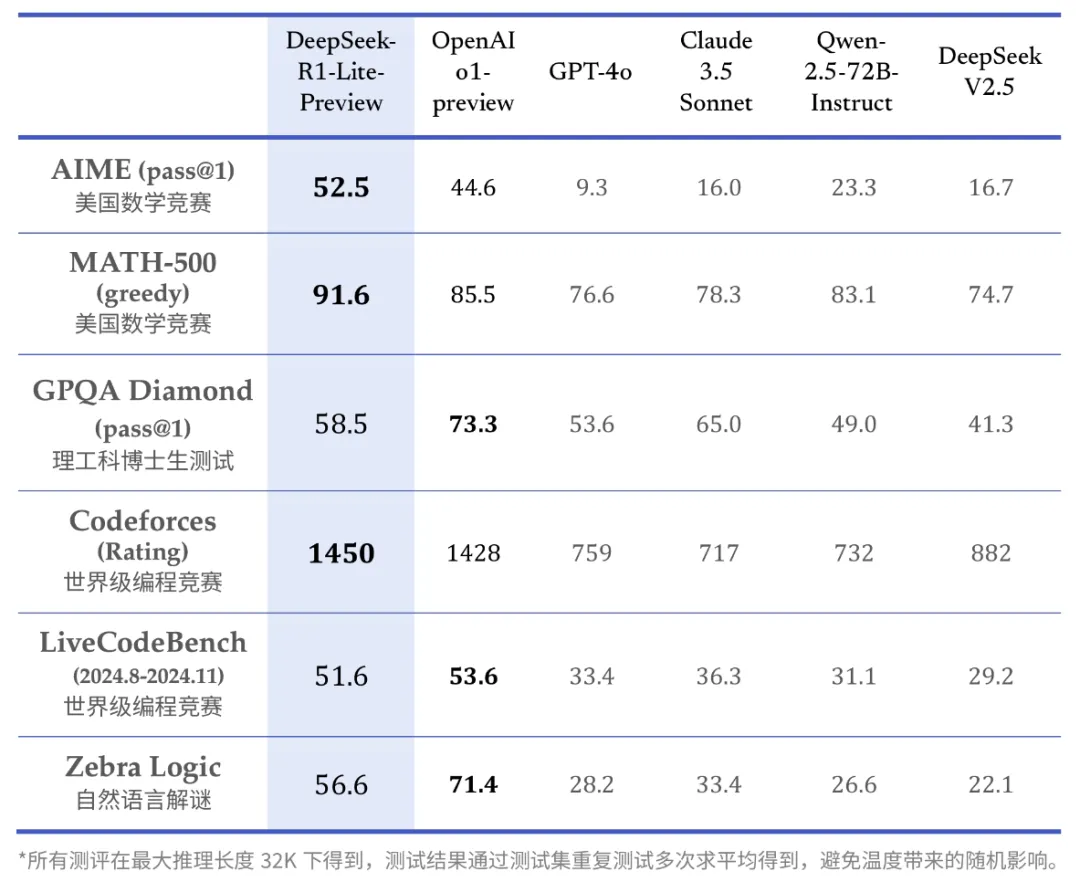

DeepSeek-R1-Lite预览版在包括美国数学竞赛(AMC)中最具挑战性的AIME以及全球顶尖编程竞赛(Codeforces)在内的多个权威评测中表现突出,成绩显著优于GPT-4o等知名模型。以下是DeepSeek-R1-Lite在这些评测中的得分情况:

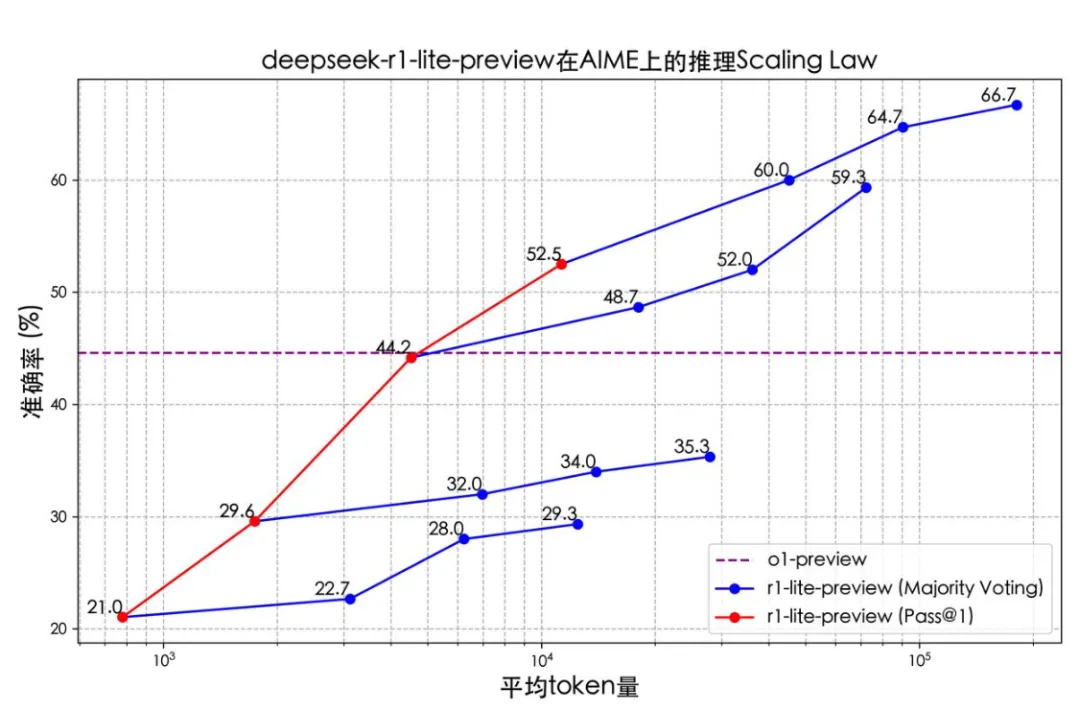

DeepSeek-R1-Lite的推理过程不仅长,还涵盖了广泛的反思和验证步骤。下面的图表清晰地展示了该模型在数学竞赛中的得分与其允许的思考长度之间存在密切的正相关关系。

红色实线展示了模型所能达到的准确率与所给定的推理长度呈正相关;相比传统的多次采样+投票,增加模型思维链长度似乎性价比更高。

正式版 DeepSeek-R1 模型将完全开源,技术报告也会公开。

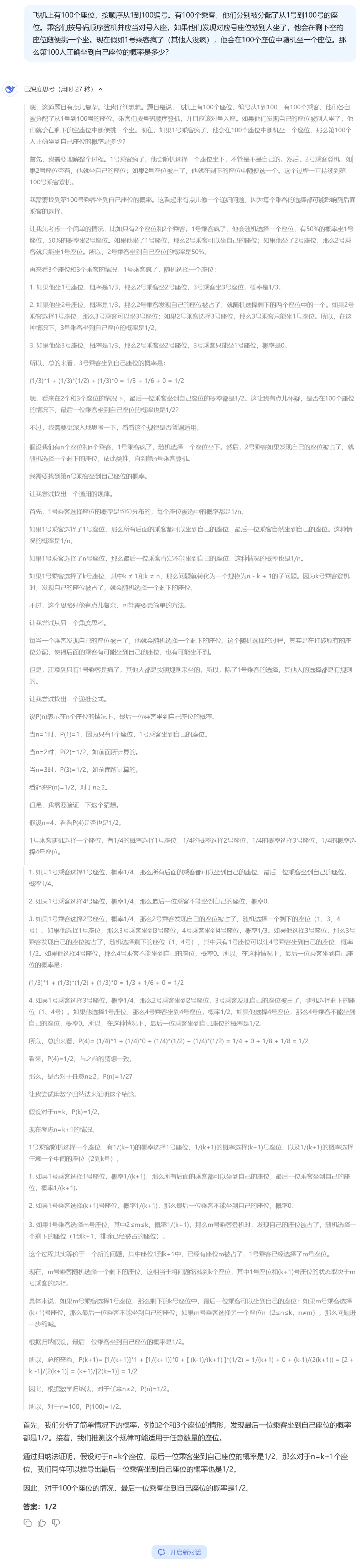

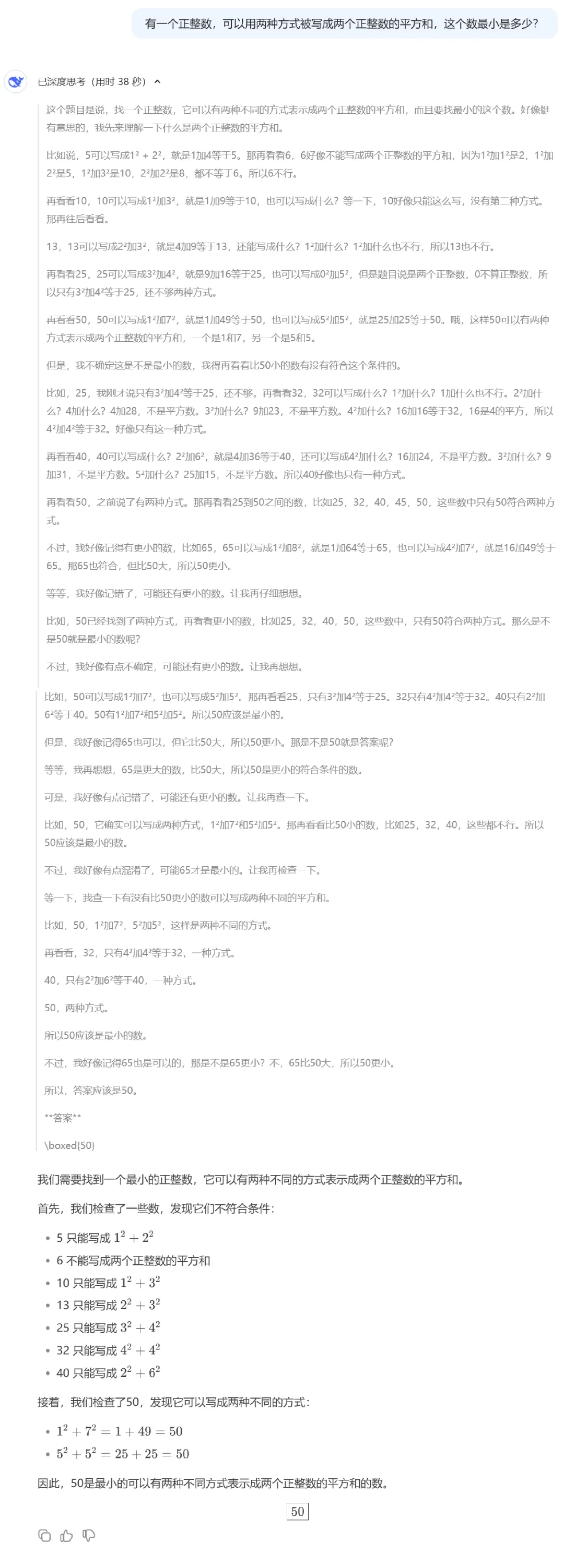

思维链效果展示:

本文转载自公众号思源数据科学 作者:思源Source

标签

赞

收藏

回复

回复

相关推荐