Pixtral Large:124B的最强开源多模态大模型 原创

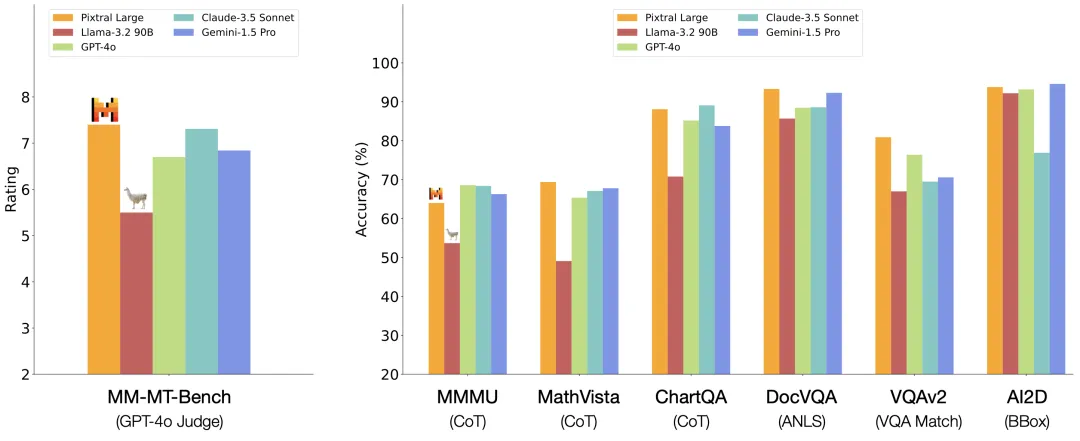

近日,法国著名开源大模型平台Mistral.ai,开源了一个1240亿参数的超大多模态模型:Pixtral Large,在多个开源多模态评测上超越了GPT-4o、Gemini-1.5 Pro、Claude-3.5 Sonnet、Llama-3.2等商业模型或开源模型,成为目前最强的开源多模态大模型。

Demo: https://chat.mistral.ai

Blog: https://mistral.ai/news/pixtral-large

Model: https://huggingface.co/mistralai/Pixtral-Large-Instruct-2411

太长不看

- 第一梯队的多模态性能

- 在MathVista、DocVQA、VQAv2等多模态评测上达到SOTA水平

- 扩展了Mistral Large 2,同时不牺牲文本性能

- 123B的多模态transformer解码器,1B的视觉编码器

- 128K上下文窗口:可容纳至少30张高分辨率图像

详细解读

Pixtral Large,是基于Mistral Large 2架构构建的124B参数量级的多模态模型。该模型特别擅长处理文档、图表以及自然图像的理解任务,同时继承并提升了Mistral Large 2在纯文本理解方面的卓越性能。在遵守license条件下,开源可商用。

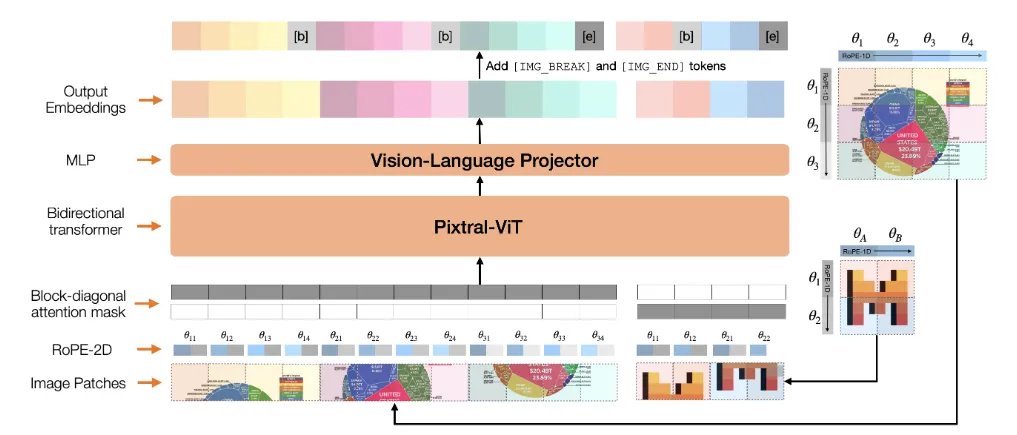

在诸多多模态评测上,都取得了优异的成绩,甚至干翻了GPT-4o和Claude-3.5 Sonnet在内的多个闭源商业模型,尤其是在复杂文档图表图像的推理能力上。

它建立在其前身,2024年夏天推出的Mistral Large 2,以及9月份发布的Mistral第一款多模态大模型Pixtral 12B的基础上。

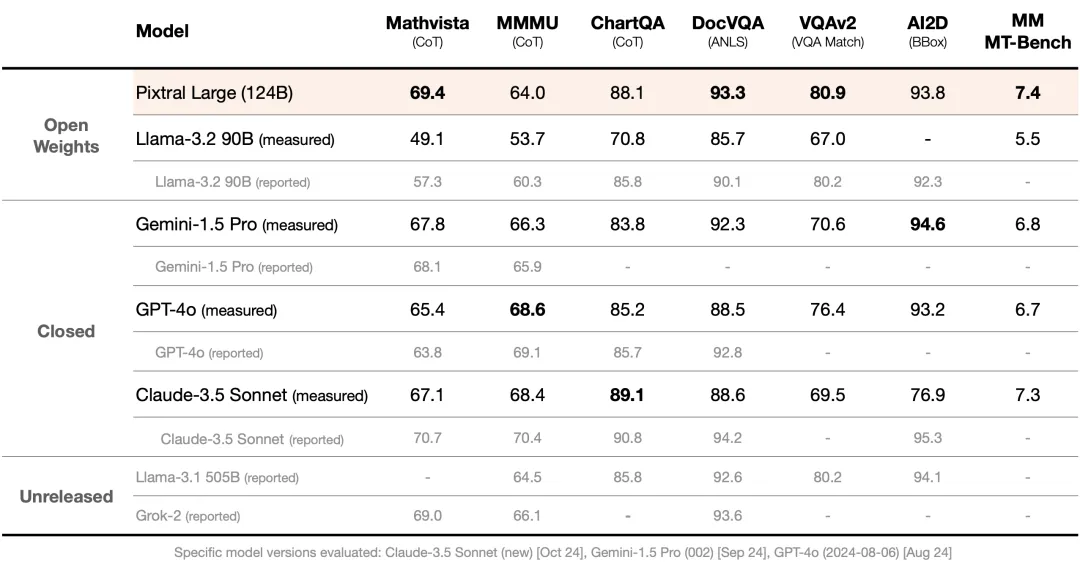

Pixtral Large 的解码器基于 Mistral Large 2 的架构。它采用基于 Transformer 的设计,能够在文本和视觉模态间进行高级推理。解码器可无缝处理长达 128K token 的上下文,非常适合在单次推理中融合大量文本和视觉数据。

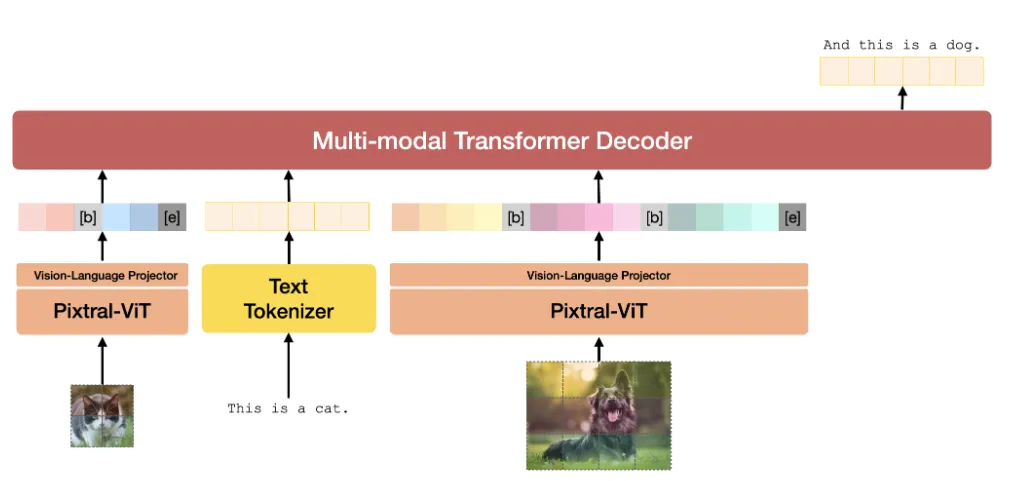

视觉编码器视觉编码器 Pixtral-ViT 是一个拥有 10 亿参数的模块,专为处理多样化的视觉数据而设计。

https://arxiv.org/abs/2410.07073

Pixtral 视觉编码器主要特性:

- 长宽比保持:与传统固定分辨率的编码器不同,Pixtral-ViT 可处理图像的原始尺寸。这减少了预处理需求,并保留了关键细节。

- 块对角注意力掩码(Block-Diagonal Attention Masks):通过隔离每张图像的注意力计算,支持高效处理多张图像。

- ROPE-2D 编码:相对位置编码的二维扩展,优化了图像块的空间表示,使编码器能够适应不同的分辨率和长宽比。

视觉编码器将图像转换为与多模态解码器兼容的 token 表示,实现文本与图像的统一处理。

本文转载自公众号思源数据科学 作者:思源Source