微软发布LLM2CLIP:一种新型AI技术,LLM成为CLIP视觉编码器的“老师” 原创 精华

01、概述

在当今的人工智能研究领域,跨模态学习正逐渐成为一个热门话题,尤其是在视觉和文本的结合上。其中,CLIP(Contrastive Language-Image Pre-training)模型作为一个重要的基础模型,凭借其在视觉和文本信号之间的深度联系,已经成为多模态学习领域的佼佼者。通过对大规模图像-文本对进行对比学习,CLIP能够同时理解图片和文本,并在零-shot任务中表现出色,支持图像分类、检测、分割、以及图像-文本检索等任务。

然而,尽管CLIP在众多任务中表现优异,它也有自己的短板,尤其是在处理复杂、长文本描述时常常力不从心。随着大规模语言模型(LLM)的快速发展,它们在文本理解和生成方面的强大能力为CLIP带来了新的突破。在这篇文章中,我们将深入探讨如何将LLM与CLIP结合,通过创新的训练方法提升视觉表示学习的性能,进一步推动跨模态学习的发展。

02、CLIP的优势与挑战

CLIP自诞生以来,凭借其创新的多模态训练方法,已经在多个领域取得了显著的成果。CLIP通过将视觉和文本信号映射到同一个特征空间,能够很好地完成图像-文本配对、图像理解、以及文本到图像/视频生成等任务。它的强大之处在于,它并不依赖于传统的视觉编码器,而是通过大量的网络数据和详细的文本描述进行训练,使得它能够捕捉到更多的“人类知识”。

然而,CLIP在面对复杂的长文本描述时,常常表现不佳。这是因为原始CLIP的文本编码器未能很好地处理长文本的语义关系,尤其是当文本包含多层次或复杂的描述时,CLIP的表现往往不尽如人意。

LLM与CLIP的结合:挑战与机遇

近年来,随着大规模语言模型(LLM)的崛起,尤其是像GPT系列、Llama等语言模型的出现,CLIP的短板逐渐显现出了解决的可能性。LLM在语言理解、生成以及跨文本任务中的卓越能力,使其成为增强CLIP文本处理能力的理想候选。然而,将LLM与CLIP结合并非易事,主要原因在于CLIP的文本编码器本身的限制。

研究表明,直接将LLM整合进CLIP,往往会导致性能下降。这是因为LLM与CLIP的原始设计并不完全兼容。为了突破这一局限,研究人员提出了一种创新方法——LLM2CLIP。这一方法通过替换CLIP的文本编码器,并用LLM增强CLIP的视觉编码器,以期更好地将文本与图像结合,提升整体性能。

03、LLM2CLIP:创新性的多模态训练方法

为了应对CLIP在处理长文本时的不足,复旦大学和微软的研究人员提出了LLM2CLIP这一新方法。该方法通过替换CLIP的原始文本编码器,将LLM的强大知识引入到CLIP模型中,从而实现视觉和文本信息的更好融合。

关键创新:替换文本编码器与对比训练

LLM2CLIP的核心创新之一是直接替换CLIP的文本编码器。传统上,CLIP的文本编码器并未能很好地处理长文本的复杂性,而LLM则通过其强大的语言模型能力,能够更清晰地理解长文本中的细节和语义。这一替换使得CLIP在处理复杂文本时能够更加高效,尤其在图像-文本匹配任务中,表现得更加出色。

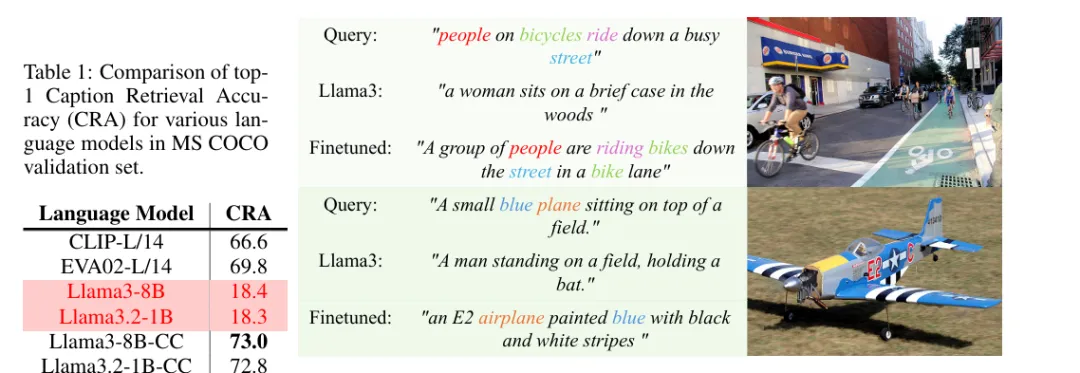

除此之外,LLM2CLIP还引入了一种名为“对比优化微调”(caption contrastive fine-tuning)的技术,帮助改进LLM对图像描述的理解。通过这种方法,LLM的能力得到了显著增强,不仅能够更好地区分不同的图像描述,还能将这些描述与图像进行更加精准的匹配。

微调与数据集的使用

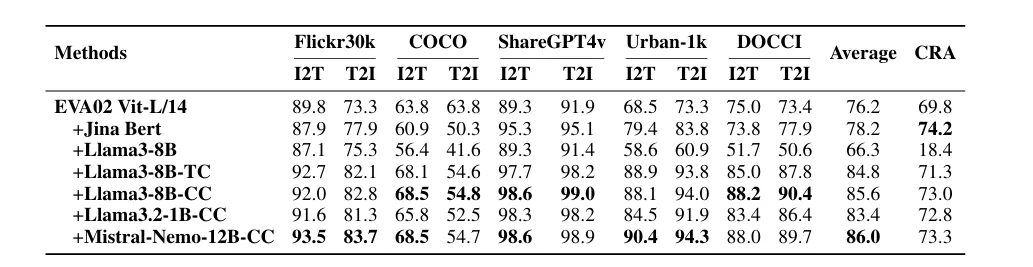

为了验证LLM2CLIP的有效性,研究人员在多个数据集上进行了实验。主要使用了CC-3M数据集,这是一组包含图像和对应文本描述的大规模数据集。通过对该数据集的微调,LLM2CLIP在图像-文本检索任务中表现得比传统的CLIP和EVA模型更为优越。

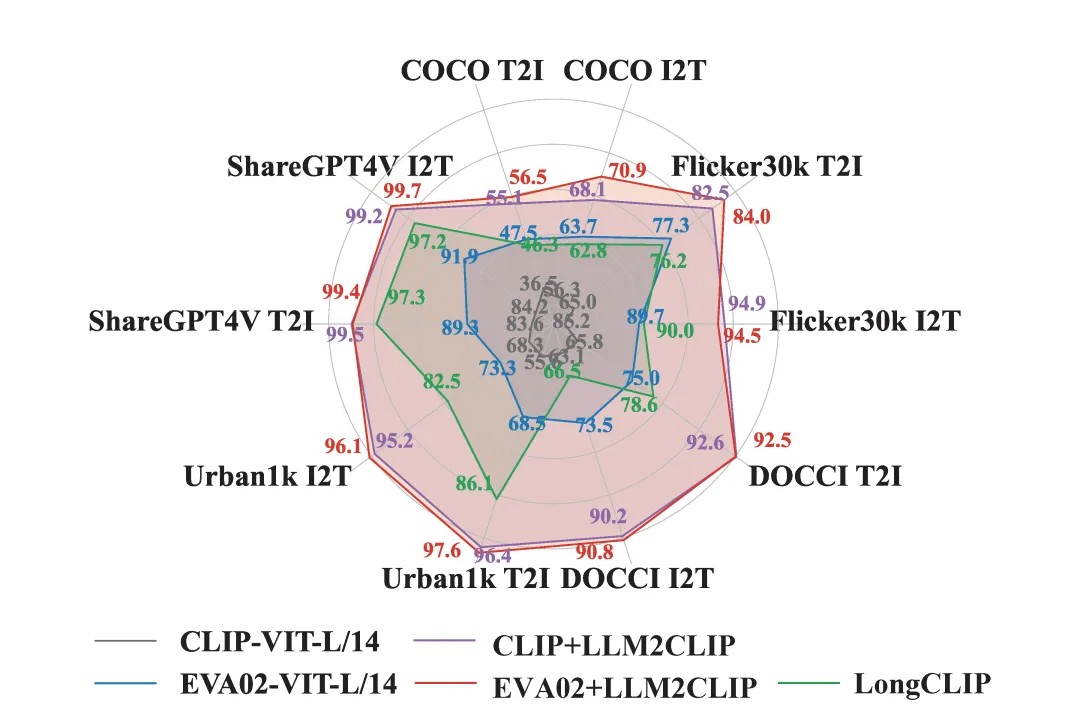

在实验中,研究人员测试了不同大小的数据集对模型性能的影响。结果表明,使用增强后的图像描述进行训练,能够有效提高性能。而当使用未经训练的语言模型时,CLIP的表现反而变差。这也表明了微调的重要性。通过适当的数据增强和对比优化,LLM2CLIP在图像-文本匹配任务中成功超越了现有的SOTA(State of the Art)模型,取得了16.5%的性能提升。

04、LLM2CLIP的全球化潜力

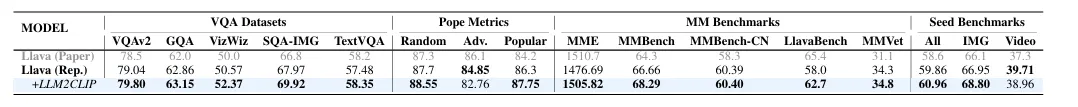

LLM2CLIP不仅仅是在单一语言环境下的突破。其跨语言能力的提升,使其在全球化应用中展现出巨大潜力。通过将LLM2CLIP与像Llava 1.5这样的多语言模型结合,研究人员成功将CLIP从一个仅限于英语数据的模型,转变为一个能够在多种语言环境中表现优异的跨语种模型。

这一转变为全球范围内的图像-文本检索任务提供了强大的支持。无论是在不同语言的图像描述之间进行匹配,还是跨语言的图像生成,LLM2CLIP都能够提供高效且准确的解决方案。

05、未来展望:更强大的多模态模型

LLM2CLIP的成功,不仅仅代表着一个单一模型的突破,它为多模态学习的发展指明了方向。通过结合强大的语言模型,CLIP能够在处理复杂任务时获得更好的表现,未来的研究可以在此基础上进行更多的创新。

未来,研究人员可能会在数据集的选择、训练方式、以及LLM的微调策略上进行进一步优化。例如,使用Laion-2Band和Recaption-1B等更大的数据集,进一步提高LLM2CLIP的性能和表现。这不仅可以推动图像-文本匹配的进步,还可以在文本到图像的生成、视频理解等领域取得更大的突破。

06、结语

LLM2CLIP的提出,标志着视觉与语言模型融合的新纪元。通过引入强大的大语言模型,LLM2CLIP有效解决了CLIP在处理复杂文本时的短板,提升了图像-文本匹配任务的性能。未来,随着更多创新技术的加入,LLM2CLIP将成为跨模态学习领域的重要基石,推动人工智能向更加智能化、更加精确的方向发展。

这项工作不仅为CLIP的训练提供了新的思路,也为未来的多模态任务开辟了广阔的前景。随着大规模语言模型和视觉模型的不断发展,跨模态学习将无疑成为人工智能的重要研究方向,而LLM2CLIP无疑是这一领域的重要里程碑。

参考:

本文转载自公众号Halo咯咯 作者:基咯咯