3D任意部位分割:FIND 3D模型实现零样本开放世界文本查询分割 原创 精华

在3D世界中,寻找任何物体的一部分听起来像是科幻小说中的情节,但加州理工学院的Ziqi Ma、Yisong Yue和Georgia Gkioxari却将其变成了现实。他们开发的FIND 3D模型,不仅能够根据任何文本查询分割任何物体的任何部分,还能在开放世界中零距离应用。想象一下,你只需说“汽车的轮子”,FIND 3D就能精确地找到并分割出这个部分,无论是从网络上的3D资产,还是从iPhone拍摄的照片中重建的3D模型。

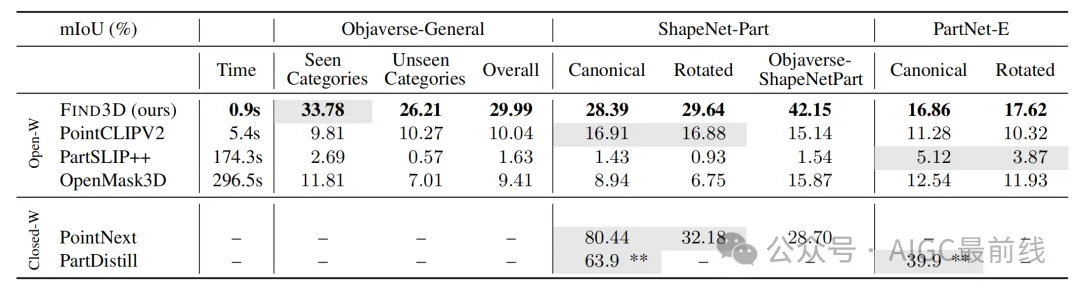

FIND 3D的背后是一个由2D基础模型(如SAM和Gemini)驱动的数据引擎,它能够自动从网络上的3D资产中进行标注。通过这些标注数据,FIND 3D训练了一个基于transformer的点云模型,并采用对比训练方法,使其在多个数据集上表现出色,mIoU(平均交并比)比现有最佳方法提高了3倍。

这个模型的应用前景广阔,从机器人到VR/AR,都需要精确的3D物体及其部分的定位。FIND 3D不仅能够处理一般的物体类别和部分查询,还能在推理速度上比现有方法快6到300倍。为了推动开放世界3D部分分割的研究,他们还发布了一个包含多样物体和部分的基准。

FIND 3D的诞生,不仅是技术上的突破,更是对未来3D理解和交互方式的一次大胆想象。正如他们所说,我们离一个理解3D世界的基石模型还有多远?FIND 3D给出了一个令人振奋的答案。在3D世界中寻找任何部分听起来像是科幻小说中的情节,但FIND 3D模型让它变成了现实。这个模型不仅能够根据任何文本查询来分割任何对象的任何部分,还能在零样本的情况下应用于任何对象。想象一下,你只需要说“给我找到那辆车的轮子”,模型就能精确地标记出轮子的位置,是不是很神奇?

FIND 3D的核心在于它的数据引擎和对比训练方法。数据引擎利用2D基础模型自动标注来自网络的3D资产,而对比训练方法则帮助模型处理部分层次和模糊性。这种结合使得模型在多个数据集上表现出色,甚至在mIoU(平均交并比)上比现有最佳方法提高了3倍。

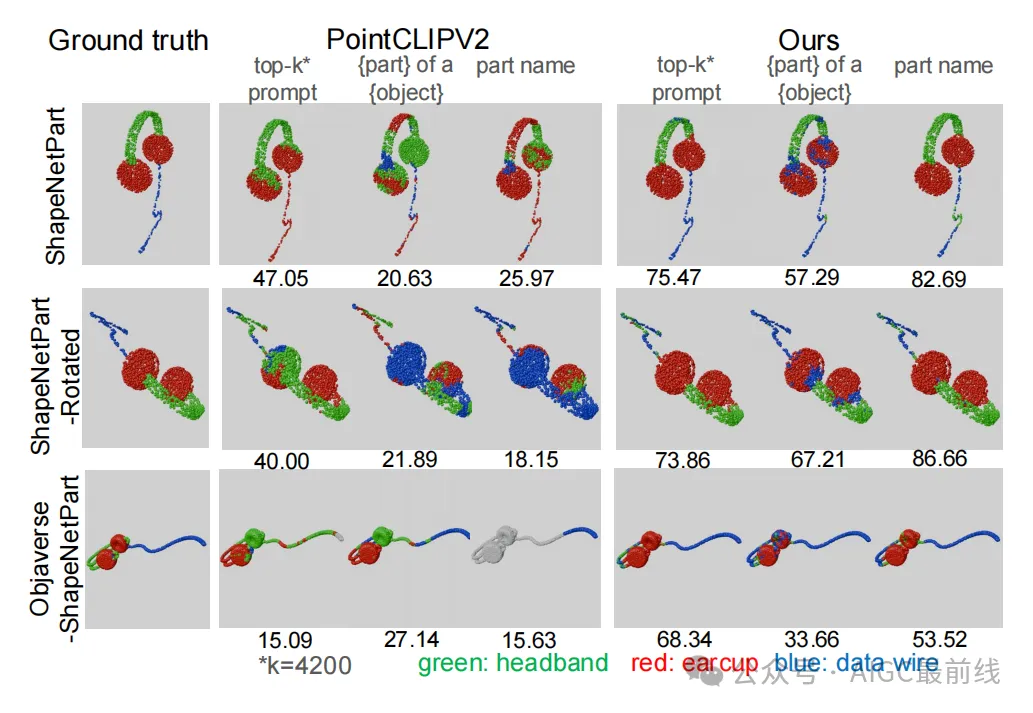

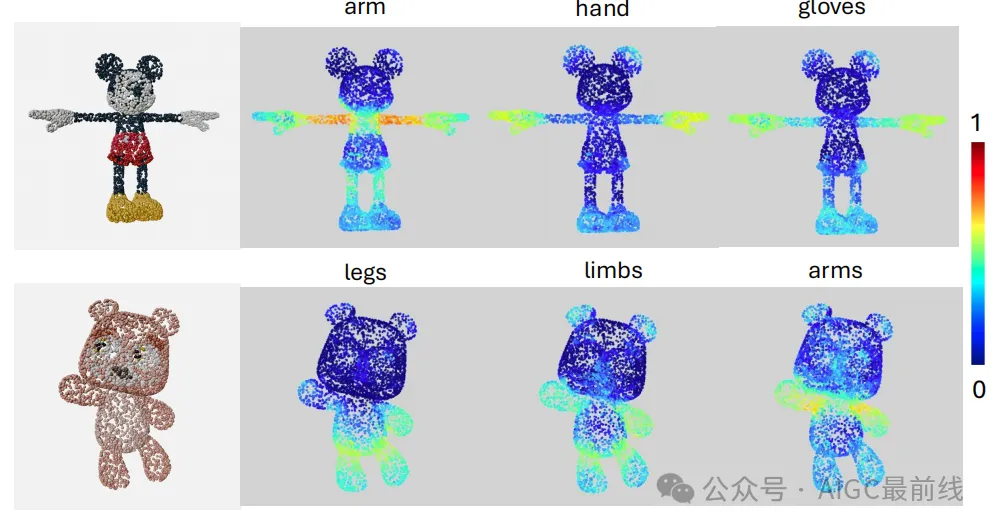

但FIND 3D的魔力不止于此。它还能处理各种查询类型,无论是“手”还是“手套”,都能准确找到对应的部分。而且,它还能在各种旋转和数据域变化下保持鲁棒性,甚至在从iPhone照片或AI生成的图像中重建的3D点云上也能表现出色。

当然,FIND 3D也有它的局限性,比如在处理非常细小的部分时可能会有些吃力。但总体来说,它无疑是3D部分分割领域的一大进步,为机器人和VR/AR应用提供了强大的支持。

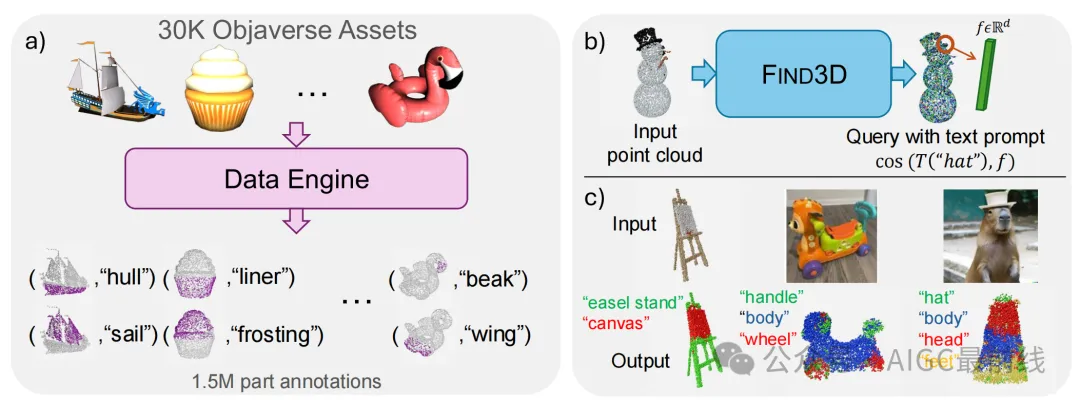

图:FIND 3D模型的整体示意图

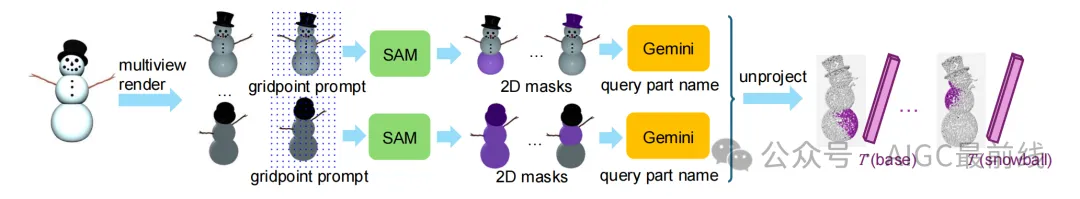

数据引擎

数据引擎利用SAM和Gemini模型自动标注Objaverse中的3D资产。首先,对每个对象进行10次渲染,并使用Gemini选择最佳方向。然后,将所有渲染结果传递给SAM进行分割,并使用Gemini为每个掩码命名。最后,将掩码映射到点云中的点,并将标签文本嵌入到预训练模型的潜在嵌入空间中,生成(点,文本嵌入)对。数据引擎处理了36044个高质量对象,最终获得了30K个带标注的对象,涵盖761个类别和150万个部分标注。

图:数据引擎

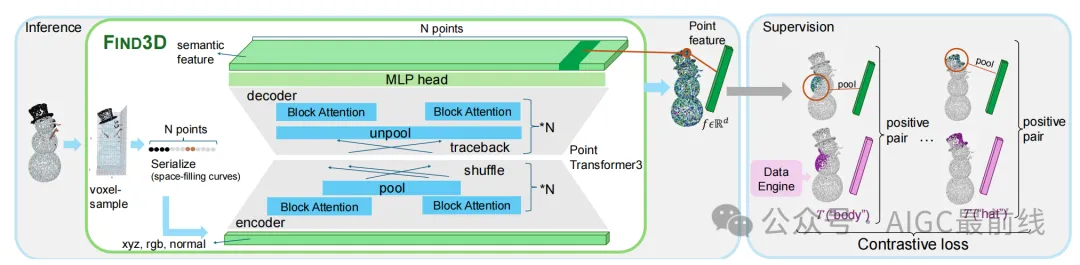

开放世界3D部分模型

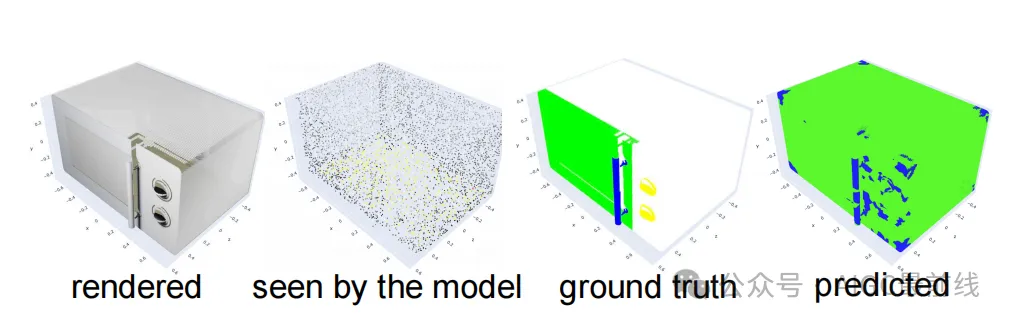

FIND 3D模型接收点云输入,并返回每个点的语义特征,这些特征可以通过余弦相似度与任何自由形式的文本查询进行查询。模型首先将文本查询嵌入到SigLIP文本编码器中,然后计算每个点与文本查询的余弦相似度。为了生成3D分割,模型将每个点分配给余弦相似度最高的文本查询,如果所有查询的相似度分数均为负,则分配“无标签”。

图:FIND 3D:开放世界部分分割模型

实验设置

基准测试

除了自建的基准测试外,还在ShapeNet-Part和PartNet-E数据集上进行了评估。ShapeNet-Part包含16个对象类别,PartNet-E结合了PartNet和PartNet-Mobility,包含45个家用对象类别。对这两个数据集的测试集进行了评估,包括在规范姿态和随机旋转姿态下的评估。

评估指标

报告了类别平均交并比(mIoU)作为评估指标,即所有标注部分在所有对象类别上的平均IoU。

竞争方法

比较了现有的最先进的开放世界和封闭世界3D分割方法,包括PointCLIPV2、PartSLIP++、OpenMask3D、PointNeXt和PartDistill。

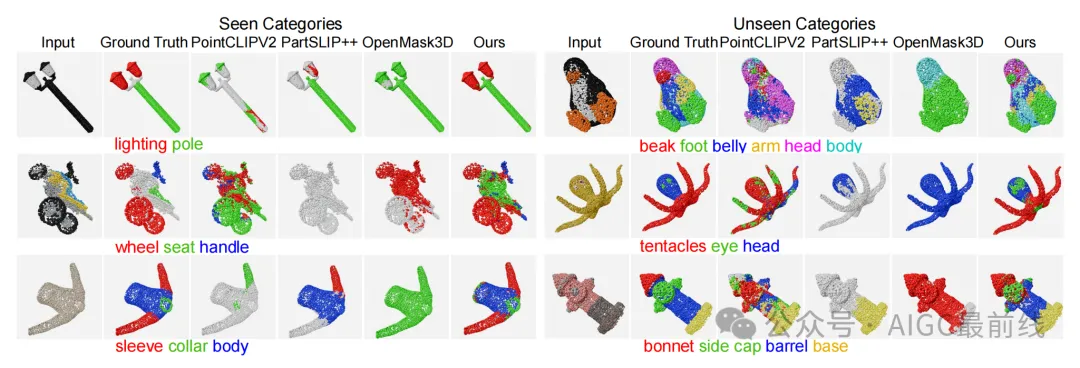

实验结果

FIND 3D在通用对象类别上表现出色,无论是已见类别还是未见类别,均取得了比第二好的方法高出3倍的mIoU。模型展示了强大的分布外泛化能力,并且在基线方法表现不佳的数据集上表现优异。此外,FIND 3D在推理速度上比开放词汇基线方法快6到300倍。

图:在Objaverse-General基准测试上的定性结果

表:在Objaverse-General、ShapeNet-Part和PartNet-E上的性能比较

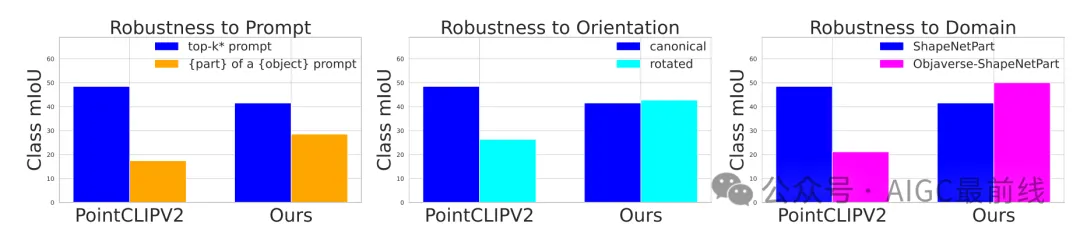

鲁棒性评估

FIND 3D对查询文本提示的变化、对象方向的变化以及数据域的变化表现出较强的鲁棒性。相比之下,基线方法对这些变化较为敏感。

图:PointCLIPV2和FIND 3D的鲁棒性比较

图:在所有ShapeNet-Part类别上的鲁棒性评估

野外结果

FIND 3D能够分割从iPhone照片或DALL-E生成的图像重建的3D点云,展示了其在实际应用中的潜力。此外,模型支持各种查询类型,展示了其在查询粒度和描述风格上的灵活性。

图:本方法支持灵活的文本查询

失败模式

FIND 3D在处理几何上不显著的细粒度部分(如表面上的按钮)时存在局限性。此外,由于模型训练为旋转等变,它倾向于对所有对称部分做出相同的预测。

图:失败示例

总结与展望

在计算机视觉领域,3D对象的开放世界部分分割一直是一个具有挑战性的问题。传统的分割方法往往局限于特定的对象类别或部分词汇,无法灵活地处理任意对象和任意文本查询。然而,随着人工智能技术的飞速发展,尤其是2D图像理解模型的显著进步,我们看到了构建开放世界3D部分分割模型的可能性。

本文介绍的FIND 3D模型,正是这一领域的重大突破。FIND 3D不仅能够基于任意文本查询对任意3D对象的任意部分进行分割,而且通过结合2D基础模型(如SAM和Gemini)的数据引擎,实现了对大规模互联网3D资产的自动标注。这一创新的数据引擎与对比训练方法相结合,使得FIND 3D在多个数据集上表现出色,其mIoU(平均交并比)比现有最佳方法提升了3倍。

FIND 3D的强大之处不仅在于其性能的显著提升,还在于其对未见类别的出色泛化能力。该模型在处理通用对象类别时,无论是已见类别还是未见类别,均表现出卓越的性能。此外,FIND 3D在推理速度上也远超现有方法,最高可达300倍的加速。这些优势使得FIND 3D在机器人和VR/AR应用中具有巨大的潜力,能够为精确操作、交互和空间感知提供强有力的支持。

展望未来,FIND 3D的成功为开放世界3D部分分割的研究开辟了新的方向。首先,结合2D和3D模态以捕捉那些在3D几何中不显著但在2D图像中易于感知的部分,将是一个值得探索的方向。其次,随着训练数据和模型参数的进一步扩展,我们有望揭示开放世界3D分割的缩放规律,从而进一步提升模型的性能和泛化能力。

总之,FIND 3D不仅为3D对象的开放世界部分分割提供了一个强大的解决方案,也为未来的研究奠定了坚实的基础。我们期待这一领域的持续发展,并鼓励读者常来我们的公众号学习,共同探索3D视觉的无限可能。

本文转载自公众号AIGC最前线 作者: 不是小马哥啊