AI 赋能量子计算突破

一、量子计算

薛定谔的爱情与狄拉克的996 一文中笔者带大家领略了量子力学的魅力,并简单探讨了量子计算(QC: Quantum Computing)。

QC处于技术创新的最前沿,业界期待其解决传统计算平台无法有效解决的复杂问题,特别是突破当下AI大模型遇到的算力瓶颈。

另一方面,新的大模型机理具备更高维度的新颖性,可以通过揭示隐藏的联系建立更广泛有用的创新框架,成为科学和哲学探索的有力工具,包括QC。

二、AI赋能QC

牛津大学、NVIDIA、多伦多大学等共同撰写了研究综述探讨AI和QC的创新交叉点,AI 如何改变整个QC软硬件生态系统挑战【文献1】。

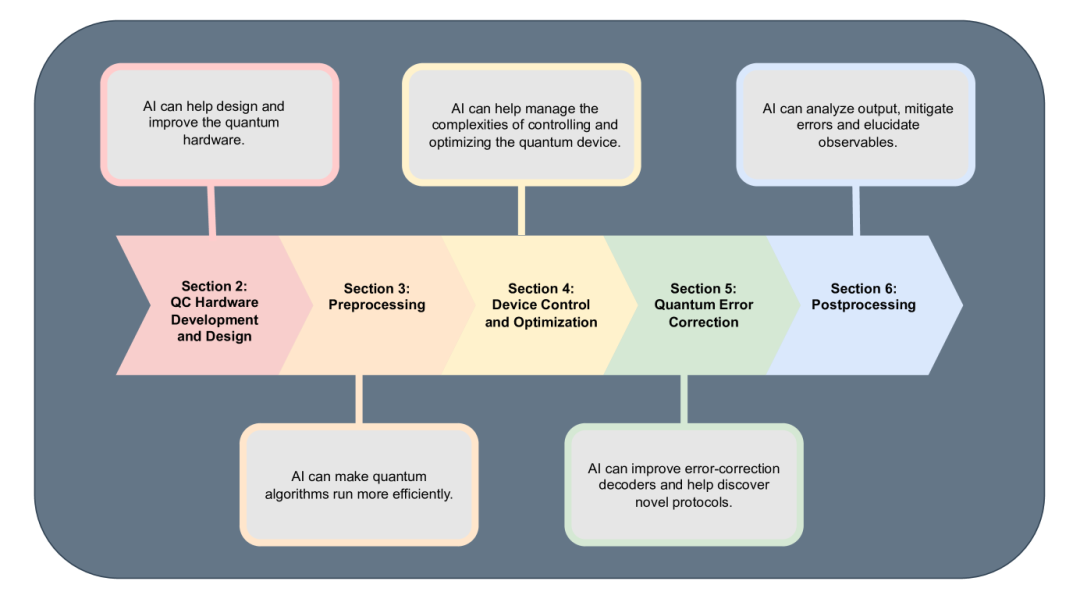

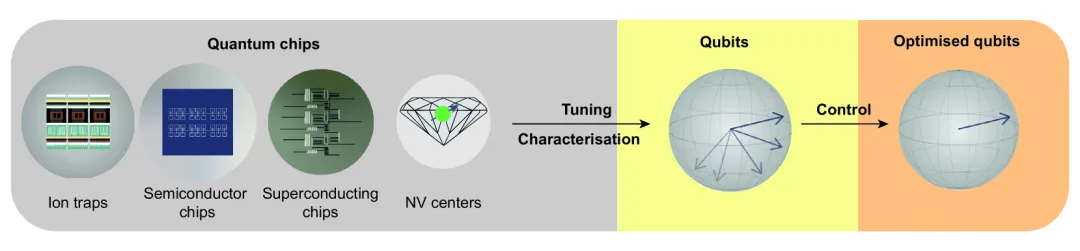

该综述探讨了从基本量子硬件设计到关键计算流程(预处理、调整、控制、优化、量子纠错和后处理)的AI赋能点,即对QC生态做智能化。

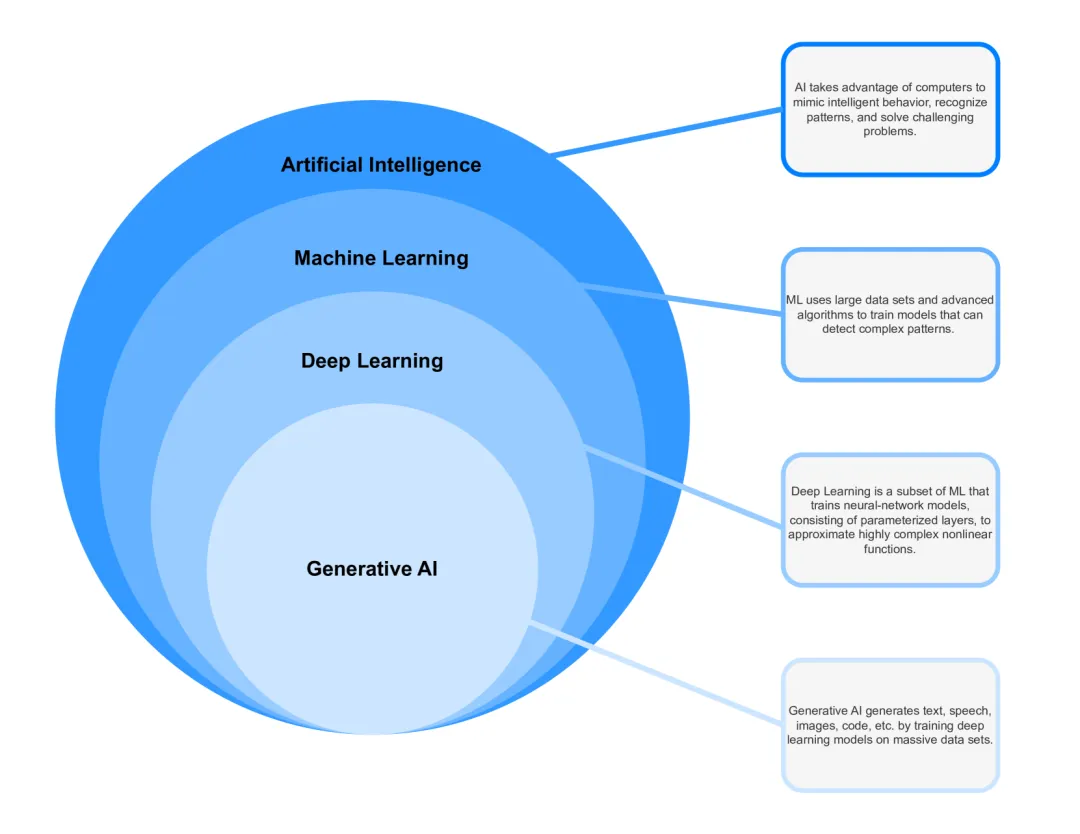

各种AI技术的界定如下:AI主要是ML;ML提取复杂模式;深度学习构建神经网络来近似复杂非线性函数;GenAI涌现生成能力。

QC开发

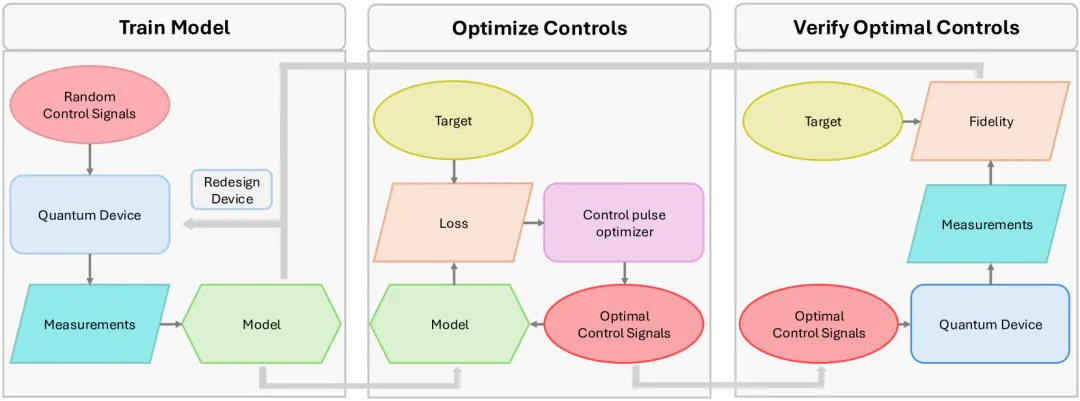

AI参与QC开发,模型训练过程涉及:创建实验或模拟数据集,记录系统对控制的输出,训练 ML 模型,发现最佳控制设置。

量子电路

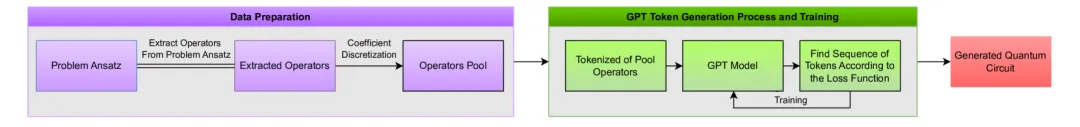

生成紧凑量子电路,提取算子,系数离散化形成算子池,token化后灌入Transformer预训练,然后用于生成量子电路的“预测”。

量子处理器

量子处理器的开发根本上取决于精确的控制、调谐和优化技术。控制涉及微波脉冲等主动操纵量子态;调谐则调整器件参数获得特定操作特性;优化最大限度提高关键性能指标,相干时间、操作速度和计算保真度。

目前强依赖专门的量子物理学家团队手工经验表征和调整量子器件,而神经网络和贝叶斯优化方法可从有限的输入数据中推断出最佳解决方案。

量子纠错

量子纠错 (QEC) 是QC系统的关键挑战。错误检测和纠正的过程复杂,传统的解码算法可扩展性与时效性差。

AI 解码器可动态分析错误模式,捕获复杂的噪声相关性,实现高效、可扩展和抗噪的量子纠错。

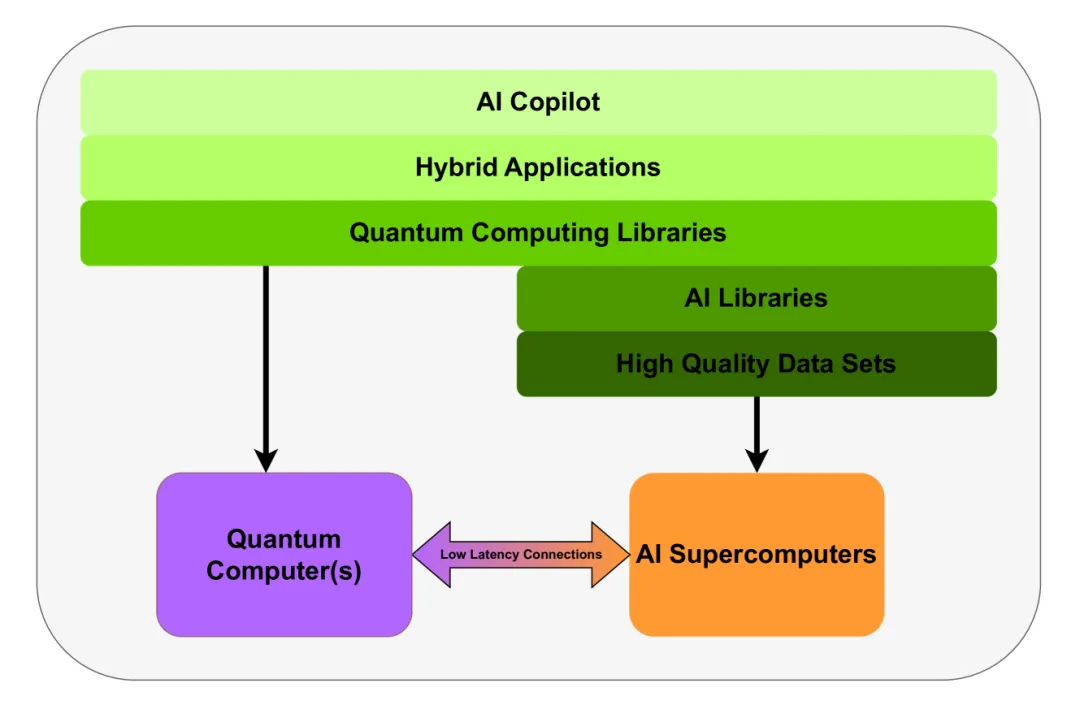

AI还可以赋能QC的后处理,从量子测量中提取有意义的见解。相互协同的超级量子计算机平台展望:

三、Nature:AlphaQubit

Google DeepMind 和 Quantum AI 团队今天在《自然》杂志上发表了AlphaQubit,基于 AI 的解码器,实现最先进量子计算纠错【文献2】。

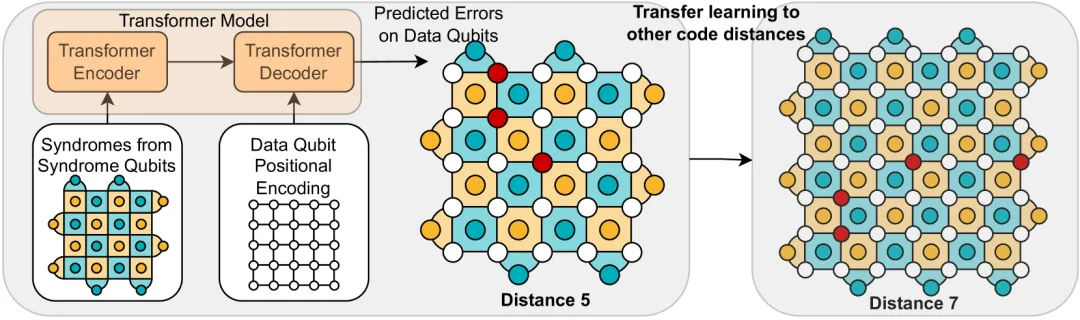

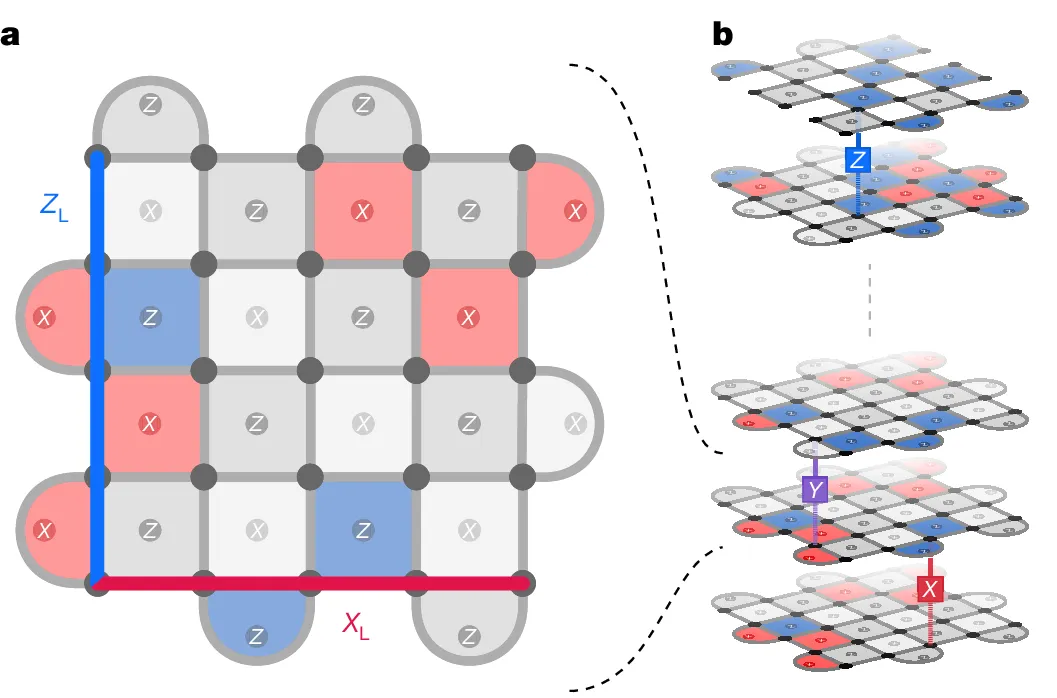

在设计的旋转表面代码和内存实验中,初始化逻辑Qubit,执行重复的稳定器测量,然后测量逻辑Qubit状态,所有Qubit和运算都会出错。

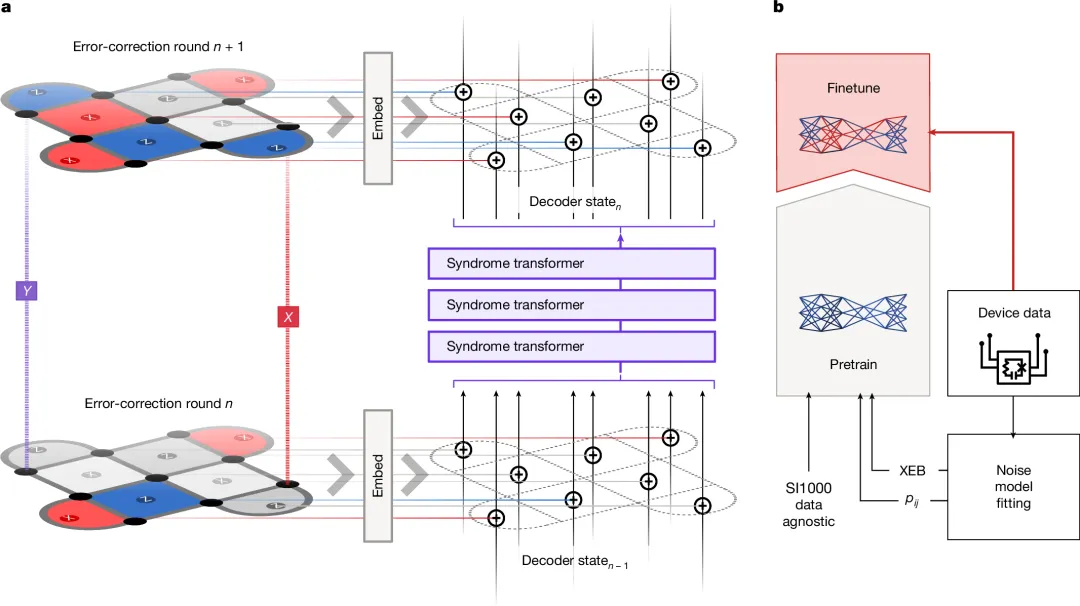

训练AlphaQubit用来纠错:

对稳定器做向量编码,用包含注意力和卷积的 syndrome transformer 提取更新内部状态信息;使用量子模拟器生成各种设置和错误级别的数亿个示例做预训练;使用数千个实验样本,针对特定的解码任务进行微调。

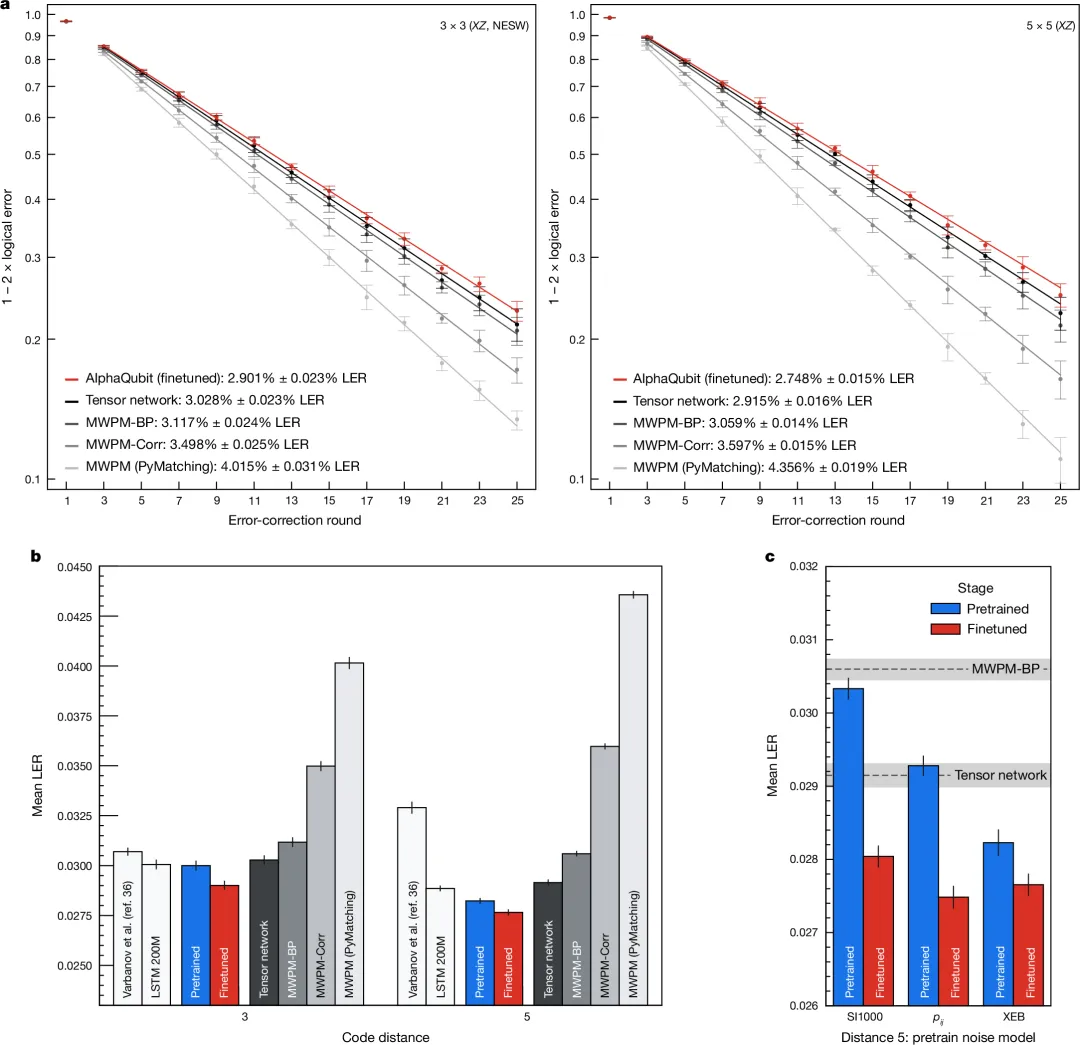

AlphaQubit 达到了准确性的业界新标准:错误比张量网络方法少 6%,错误率还比“相关匹配”方法少30%,精确,速度快,可扩展。

AlphaQubit 在准确识别错误方面非常出色,代表了AI赋能QC的一个重要里程碑,尽管实时纠正超导处理器中的错误仍然太慢。

就像业界在广泛探索AI赋能千行百业一样,QC正在经历一场由AI驱动的革命性变革,AI在整个量子计算生态系统中展现出前所未有的潜力。

文献1 Artificial Intelligence for Quantum Computing https://arxiv.org/html/2411.09131v1

文献2 Learning high-accuracy error decoding for quantum processors https://www.nature.com/articles/s41586-024-08148-8

本文转载自 清熙,作者: 王庆法