Google开源大模型新成员CodeGemma、RecurrentGemma,继Transformer后新架构Griffin诞生 原创

2024年2月,Google推出了 Gemma,一系列轻量级、先进的开源大模型,这些模型是使用创建 Gemini 模型时所使用的相同研究和技术构建的。

近日,Google宣布了 Gemma 家族的首批新增成员,为机器学习开发者扩展了创新责任的可能性:CodeGemma 用于代码补全和生成任务以及指令跟随,以及 RecurrentGemma,用于研究实验的效率优化架构。

新成员之CodeGemma

为开发者和企业提供的代码补全、生成和聊天 利用 Gemma 模型的基础,CodeGemma 为社区带来了强大而轻量级的编码能力。CodeGemma 模型提供了几个优势:

- 智能代码补全和生成:无论您是在本地工作还是利用云资源,都可以完成代码行、函数,甚至生成整个代码块。

- 增强的准确性:CodeGemma 模型在主要来自网络文档、数学和代码的 5000 亿标记的英语语言数据上进行训练,生成的代码不仅在语法上更加正确,而且在语义上更有意义,有助于减少错误和调试时间。

- 多语言熟练:您宝贵的编码助手,可用于 Python、JavaScript、Java 和其他流行的语言。

- 流程优化:将 CodeGemma 模型集成到您的开发环境中,减少样板代码编写,并专注于更重要和不同的代码——更快地完成工作。

这张表比较了 CodeGemma 在单行和多行代码补全任务上与其他类似模型的性能。在技术报告中了解更多信息。

新成员之RecurrentGemma

为研究人员提供高效、更快速的推断,在更高的批次大小下 RecurrentGemma 是一个在技术上独特的模型,利用循环神经网络和本地注意力来提高内存效率。虽然 RecurrentGemma 达到了与 Gemma 2B 模型相似的基准分数性能,但其独特的架构带来了几个优势:

- 降低的内存使用:较低的内存需求使得在内存有限的设备上(如单个 GPU 或 CPU)生成更长的样本成为可能。

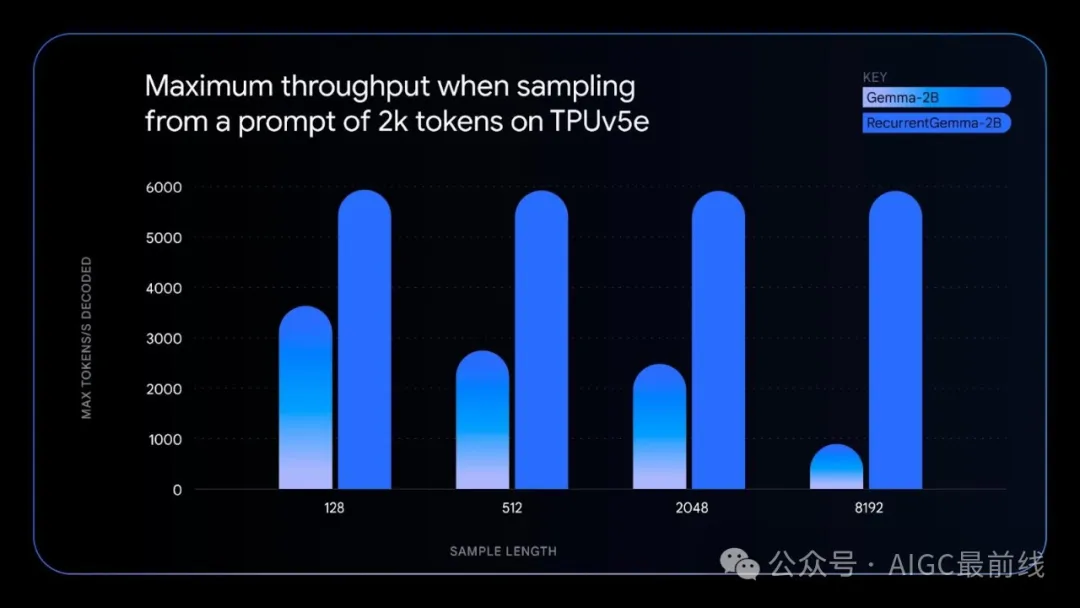

- 更高的吞吐量:由于其较低的内存使用,RecurrentGemma 可以以显著更高的批次大小执行推断,从而每秒生成更多的标记(特别是在生成长序列时)。

- 研究创新:RecurrentGemma 展示了一个非Transformer模型,实现了高性能,突显了深度学习研究的进步。

这张图展示了 RecurrentGemma 如何在序列长度增加时保持其采样速度,而像 Gemma 这样基于 Transformer 的模型则随着序列变得更长而减慢。

RecurrentGemma基于新架构Griffin

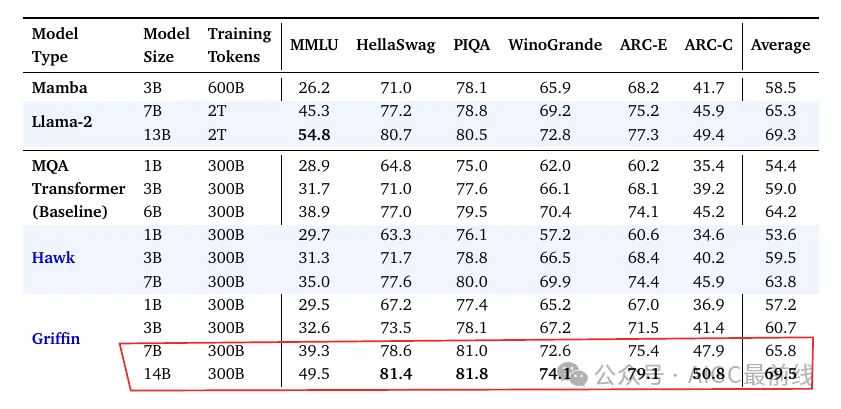

RecurrentGemma是基于一种全新 Griffin 架构的模型,其性能优于 Transformers。

在多个规模上,Griffin 在控制测试中的基准得分均优于 Transformers 基线,无论是在不同参数规模下的 MMLU 得分,还是在许多基准测试中的平均得分。该架构在推断长文本时还提供了效率优势,具有更快的推断速度和更低的内存使用率。以下是 Huggingface 上发布了这个模型的 2B 版本的性能:

参考:https://developers.googleblog.com/2024/04/gemma-family-expands.html

Griffin论文:https://arxiv.org/abs/2402.19427

本文转载自公众号AIGC最前线