只需一张图片!实现任意3D/4D场景生成!港科大&清华&生数发布DimensionX

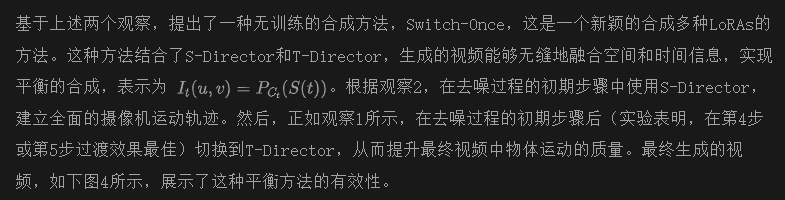

文章链接:https://arxiv.org/pdf/2411.04928

项目链接:https://chenshuo20.github.io/DimensionX/

亮点直击

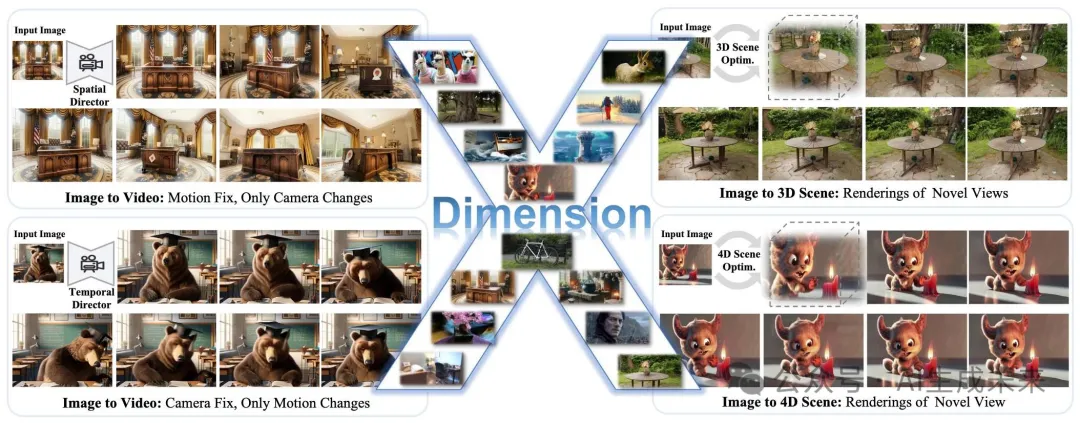

- 提出了DimensionX框架,通过可控的视频扩散技术,仅使用单张图像生成逼真的3D和4D场景。

- 提出了ST-Director,通过学习(空间和时间)维度感知模块,并结合我们精心挑选的数据集,解耦视频扩散模型中的空间和时间先验。进一步通过基于视频扩散去噪过程本质的训练无关组合方法,增强了混合维度控制。

- 为了弥合视频扩散与真实场景之间的差距,设计了一个轨迹感知机制用于3D生成,并提出了一种保持身份的去噪方法用于4D生成,从而实现更真实且可控的场景合成。

- 广泛的实验表明,相较于基准方法,DimensionX在视频、3D和4D生成方面表现出色。

总结速览

解决的问题

本文提出了DimensionX框架,旨在从单张图像生成具有视频扩散效果的逼真3D和4D场景。现有的视频扩散模型在直接恢复3D/4D场景时存在限制,尤其是在生成过程中缺乏空间和时间的可控性。

提出的方案

本文提出了ST-Director,通过从维度变化的数据中学习维度感知的LoRAs,解耦视频扩散中的空间和时间因素。这种可控的视频扩散方法使得空间结构和时间动态的精确操控成为可能,从而能够从连续帧中重建3D和4D表示。

应用的技术

- ST-Director:通过解耦空间和时间因素,利用维度感知的LoRAs技术进行视频扩散。

- 轨迹感知机制:用于3D生成,帮助填补生成视频与真实世界场景之间的差距。

- 保持身份的去噪策略:用于4D生成,确保生成视频中的身份保持一致。

达到的效果

DimensionX在控制视频生成以及3D和4D场景生成方面表现出色,通过广泛的实验验证,在多个真实和合成数据集上相比之前的方法,DimensionX取得了更好的结果。

方法

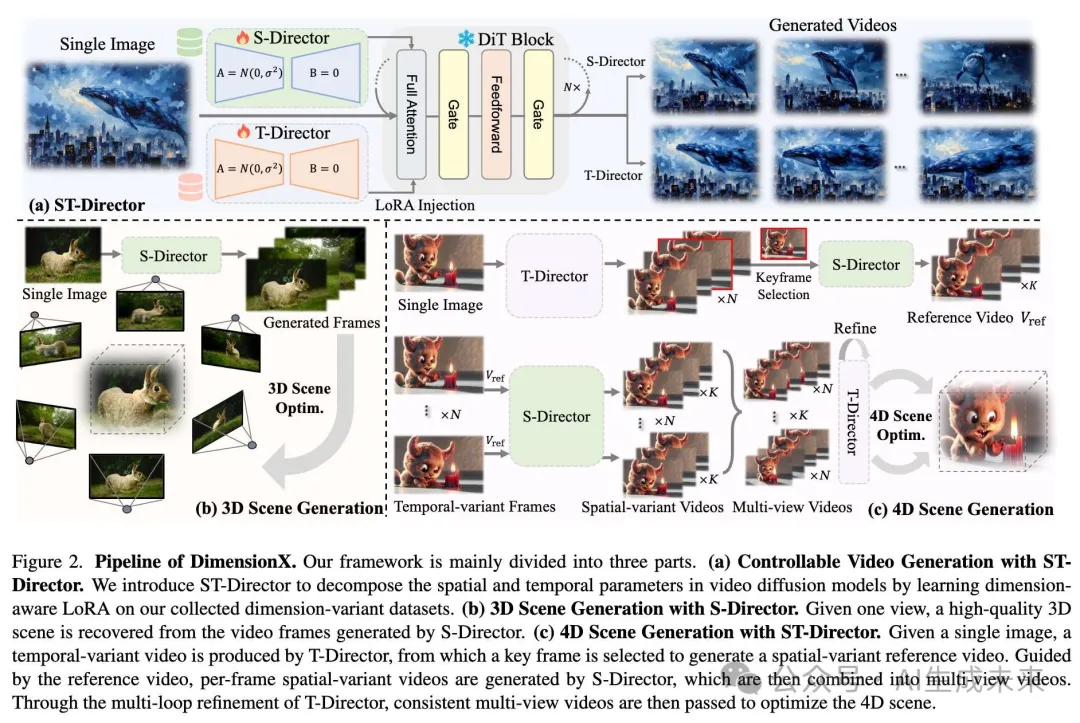

本文的目标是,给定一张图像,通过可控的视频扩散生成高质量的3D和4D场景。为了在空间和时间维度上实现有效的控制,首先开发了一个系统化框架来构建维度变化数据集。借助精心挑选的数据集,引入了ST-Director,通过维度感知的LoRA解耦空间和时间基础,实现精确的维度感知控制。还探索了视频生成过程中的去噪机制,并引入了一种训练无关的维度感知组合方法,以实现有效的混合维度控制。为了更好地利用可控的视频扩散生成高质量的场景,设计了一个轨迹感知机制用于3D生成,并提出了一种保持身份的去噪方法用于4D生成。

构建维度变化数据集

为了在视频扩散中解耦空间和时间参数,提出了一个框架来从开源数据集中收集空间和时间变化的视频。本文为空间变化数据采用了轨迹规划策略,并为时间变化数据引入了流引导。

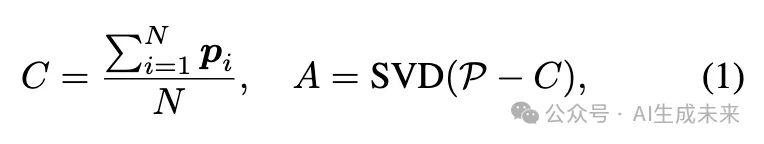

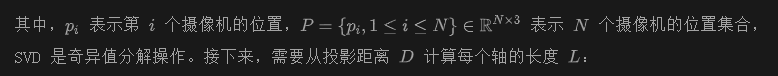

空间变化数据的轨迹规划。为了获取空间变化数据集,本文提出了重建逼真3D场景并渲染与我们空间变化一致的视频。为了方便渲染路径的选择和规划,需要计算摄像机在整个场景中的覆盖范围。给定场景中的N个摄像机,首先通过主成分分析(PCA)技术计算中心C和沿x、y、z方向的主轴A:

基于上述计算,已经确定了摄像机在整个场景中的分布。为了应对不同的场景,建立了以下规则来筛选符合条件的数据:

- 摄像机分布:计算场景的中心,并判断摄像机如何围绕场景进行捕捉。

- 边界框长宽比:边界框的长宽比应满足各种S-Director的要求。例如,x轴和y轴的长宽比不应差异过大,这有助于选择合适的360度全景视频。

- 摄像机与边界框的距离:计算每个摄像机位置到边界框最近平面的距离,并优先选择总距离较小的数据,以确保摄像机的合理布置。

在筛选出数据集后,需要计算场景内的占据场,以帮助我们规划渲染摄像机的可行区域。在从多视角图像重建整个场景的3DGS后,渲染多视角图像及其对应的深度图,然后使用TSDF从RGB-D数据中提取场景的网格。

时间变化数据的流引导。为了实现时间控制,旨在筛选时间变化数据,以微调视频扩散模型。利用光流来筛选时间变化的视频。对于时间变化的视频,光流图通常会显示大量的白色区域,这可以作为有效的选择标准。

ST-Director用于可控视频生成

维度感知分解

无需调优的维度感知合成

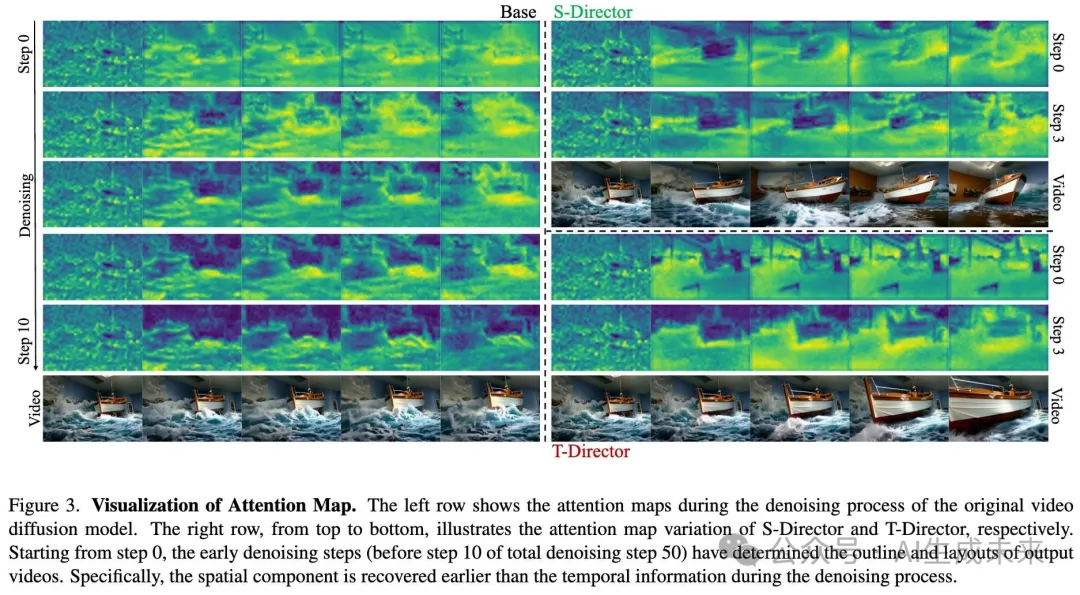

观察1:去噪过程的初期步骤对生成视频至关重要

从注意力图中可以观察到,在去噪过程的初期步骤中,基础模型和两个控制器都建立了与最终生成结果紧密对齐的基础轮廓。这些初步的轮廓捕捉了空间和时间的基本结构,实际上为剩余的去噪步骤设定了方向。此外,还注意到这些变化展开的方式有明显不同:在基础模型中,时间和空间的变化同时发生,导致两个维度的统一演化。相比之下,当使用S-Director和T-Director时,每次只有一个维度发生变化——是时间维度还是空间维度,取决于具体使用的控制器。

观察2:空间信息比时间信息更早构建

类似于Motionclone的发现,观察到,在去噪过程的初期阶段,物体运动的合成仍未完全发展。具体来说,在使用S-Director时,注意力图表明,最终视频的结构性轮廓比时间控制提前出现。前面图3显示,在去噪循环的第0步和第3步时,物体在T-Director的引导下保持静止,而S-Director已经开始引导摄像机在场景中移动。

基于S-Director的3D场景生成

基于S-Director,视频扩散模型能够从单一图像生成长时间一致的帧,从而重建逼真的场景。为了更好地推广到现实世界场景,其中空间变化多样且摄像机轨迹高度灵活,引入了轨迹感知机制来处理不同的摄像机运动。具体来说,为了覆盖各种摄像机轨迹模式C(t),我们训练了多种类型的S-Directors,每种S-Director都针对特定的摄像机运动。 在3D世界中,摄像机的运动由6个自由度(DoF)定义,每个自由度允许在平移和旋转的正负方向上进行运动,形成12种不同的运动模式。此外,我们还训练了轨道运动类别的S-Director,其中摄像机沿着一个平滑的圆形路径绕主体运动,捕捉到超越标准自由度运动的独特视角。通过多样化且可控的S-Directors,在单视图和稀疏视图设置中都采用了轨迹感知机制,从而使得能够生成具有广泛适应性的现实世界3D场景。

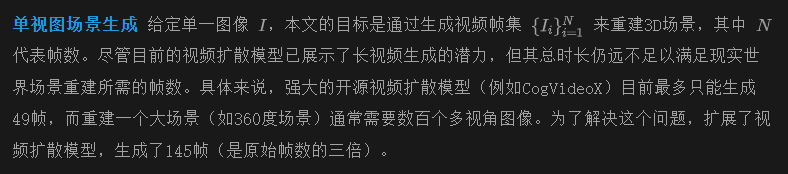

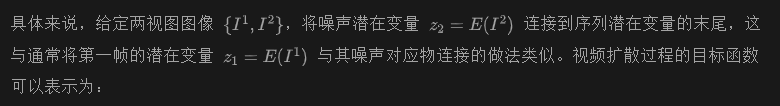

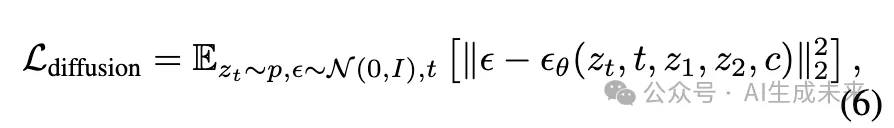

稀疏视图场景生成在3D场景生成的应用中,精度和细节至关重要,使用稀疏视图输入可以显著提高生成内容的逼真。在这种设置下,提出了结合视频插值模型和自适应S-Director的方案,以实现稀疏视图之间的平滑和一致的过渡。开发了一个视频扩散模型来生成高质量的插值视频,该模型以两张图像作为起始和结束帧。

本文采用了两种关键策略,以充分利用S-Directors携带的指导信息:早期停止训练和自适应轨迹规划。研究发现,在训练S-Director的早期阶段,足够的轨迹指导已被获得,在此阶段,相机运动可以根据输入视点的变化灵活调节。此外,为了处理稀疏视图的各种视点插值,提出根据输入图像之间的坐标关系,动态选择合适的S-Director。

借助本文提出的长视频扩散模型和多样化的S-Directors,可以直接从生成的视频中重建广泛的场景。特别是,给定稀疏视图(例如只有一张)图像和选定的相机运动类型(可以是基本轨迹或这些运动原语的组合),扩散模型能够沿着指定路径生成一致的长视频。

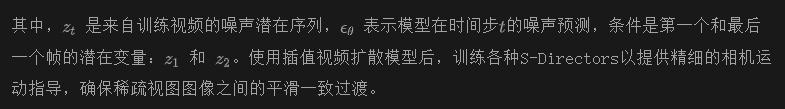

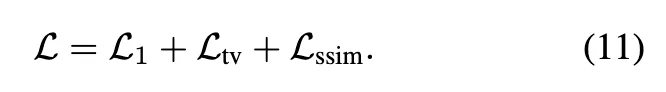

为了减轻生成视频中的不一致性,采用了一种自信度感知的高斯点云溅射程序来重建3D场景。该程序使用DUSt3R提供的点云和估计的相机姿态进行初始化,3D高斯点云溅射通过额外的LPIPS损失和从DUSt3R获得的置信度图进行优化。采用以下3DGS损失:

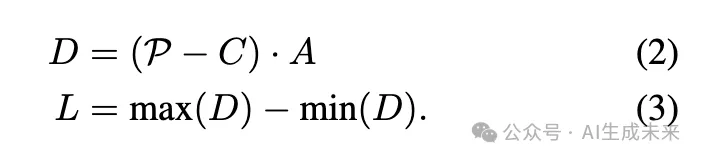

4D 场景生成与 ST-Director

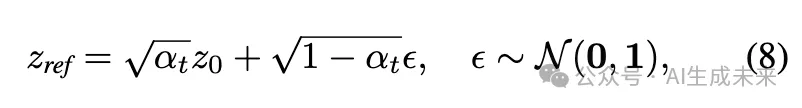

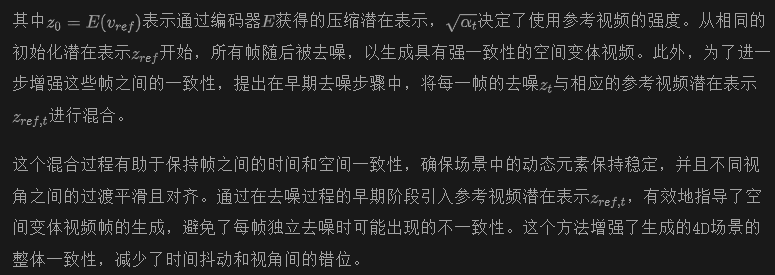

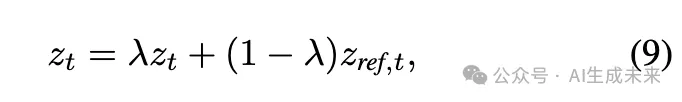

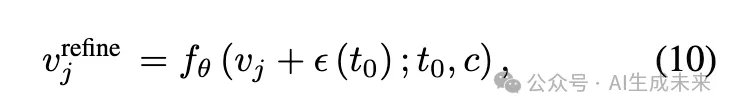

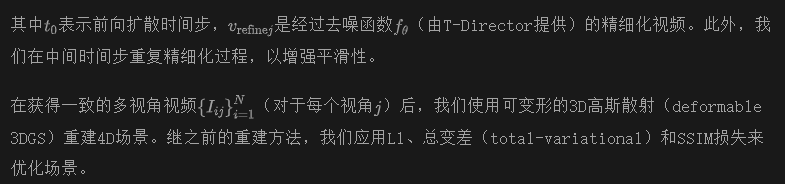

通过配备空间和时间控制的视频扩散,可以从单一图像恢复高质量的4D动态场景。直接的方法是将为每个时间帧生成的空间变化视频拼接成多视图视频,然后用这些视频重建4D场景。然而,这种方法面临一个关键挑战:3D一致性。在空间变化的视频之间保持背景和物体外观的一致性是一个挑战,导致4D场景中出现严重的抖动和不连续性。为了解决上述问题,我们提出了一种保持身份一致性的去噪策略,包括参考视频潜在共享和外观精炼过程,以增强所有空间变化视频的一致性。

实验

本节对真实世界和合成数据集进行了广泛的实验,以评估DimensionX的可控性,以及使用ST-Director进行3D和4D场景生成的能力。我们首先全面说明实验细节。然后提供了可控视频生成的定量和定性评估。接着,我们报告了在各种场景下(包括单视角和稀疏视角3D生成)与其他基线方法的定量和定性结果。随后,展示了本文方法的4D场景生成结果。最后进行了各种消融研究,以评估本文设计的有效性。

实验设置

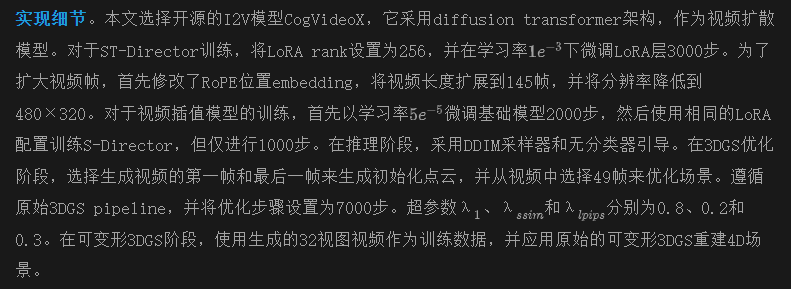

数据集。整个框架中的视频扩散模型主要在三个数据集上进行训练:DL3DV-10K、OpenVid和RealEstate-10K。OpenVid-1M是一个高质量的开源视频数据集,包括100万个视频片段,具有多样的运动动态和相机控制。DL3DV-10K是一个广泛收集的3D场景数据集,包含高分辨率的多视角图像,包括各种室内和室外场景。RealEstate-10K是一个来自YouTube的数据集,主要包含室内场景的捕捉。通过应用我们设计的数据收集框架,我们从DL3DV-10K和OpenVid构建了维度变化数据集。我们选择了OpenVid中的100个高质量时变视频来训练T-Director。对于每种S-Director类型,渲染100个视频,根据特定的相机轨迹来训练相应的LoRA。为了扩大视频帧,我们筛选了来自RealEstate-10K和OpenVid的超过145帧的高质量视频,以完全微调视频扩散模型。使用相同的数据集,我们通过第一帧和最后一帧的引导微调视频插值模型。为了进一步验证DimensionX的3D生成能力,将本文的方法与其他基线方法在Tank-and-Temples、MipNeRF360、NeRF-LLFF和DL3DV-10K上进行了比较。

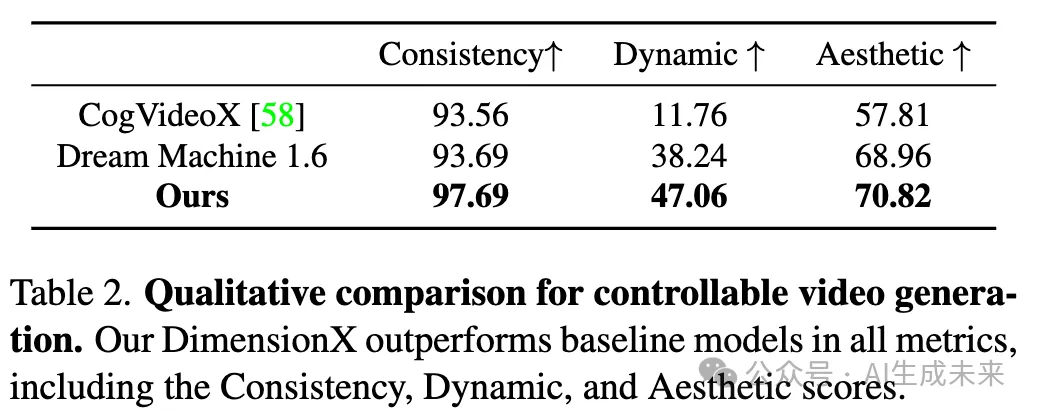

可控视频生成

基线和评估指标。将DimensionX与原始的CogVideoX(开源)和Dream Machine 1.6(闭源产品)进行了比较。收集了数百张图像作为评估数据集。根据先前的基准VBench,评估了生成视频的主题一致性、动态度和美学得分作为我们的评估指标。

定量和定性比较。下表2中的定性结果展示了本文方法的出色表现,包括更好的视觉质量和3D一致性。如前面图4所示,可以观察到,DimensionX有效地分解了视频扩散模型的空间和时间参数,而Dream Machine无法解耦维度感知控制,即便使用了相机运动和提示约束。此外,对于包括空间和时间运动在内的混合维度控制,相较于Dream Machine,DimensionX生成了更加生动和动态的视频。定量和定性结果都表明,本文的方法能够生成可控视频,同时保持动态运动和主题一致性。

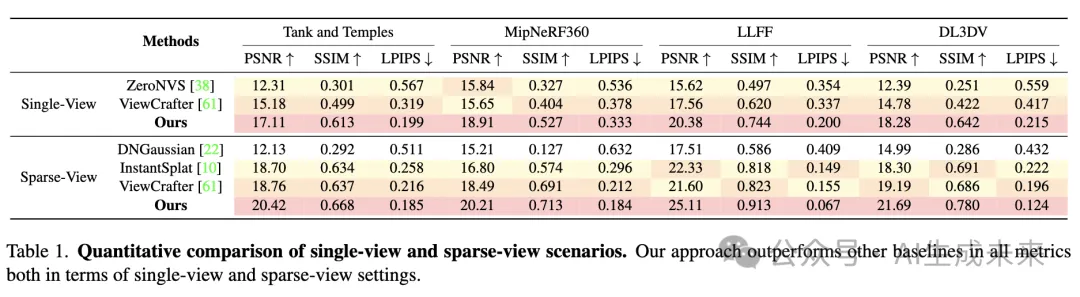

3D场景生成

基线和评估指标。在单视角设置中,将本文的方法与两种生成方法进行了比较:ZeroNVS和ViewCrafter。对于稀疏视角场景,选择了两种稀疏视角重建方法和一种稀疏视角生成基线,包括:DNGaussian 、InstantSplat和ViewCrafter。采用PSNR、SSIM和LPIPS作为定量结果的评估指标。具体来说,在单视角和稀疏视角设置中,首先从给定的图像重建3D场景,然后通过从新视角渲染计算指标。

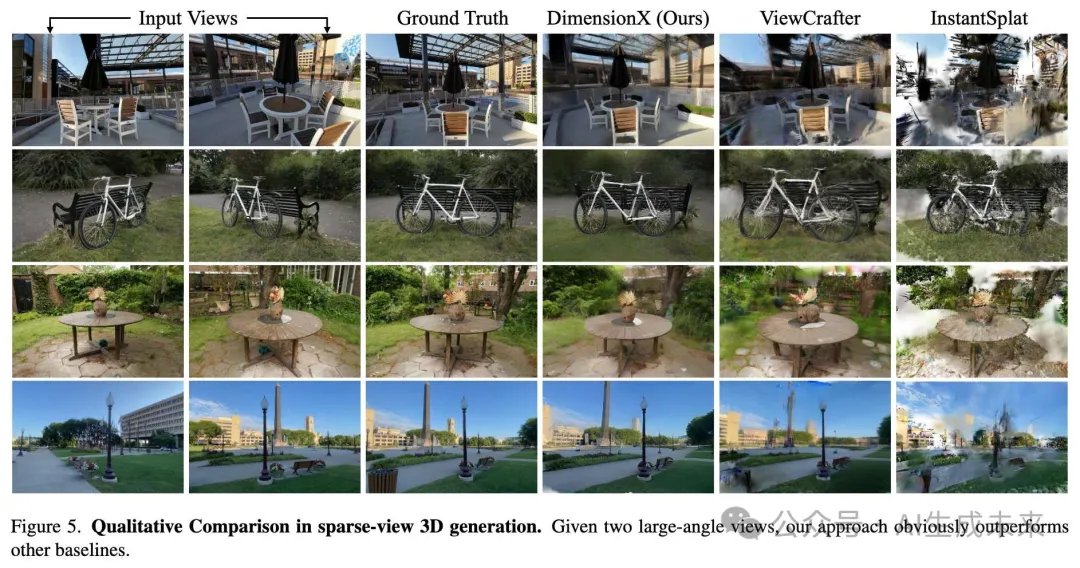

定量和定性比较。定量比较结果见下表1。DimensionX在所有指标上均优于基线,展示了本文方法的出色表现。如下图5所示,在单视角(更多细节可见于附录)和稀疏视角设置中,本文的方法能够重建高质量的3D场景,而其他基线无法处理具有挑战性的案例。

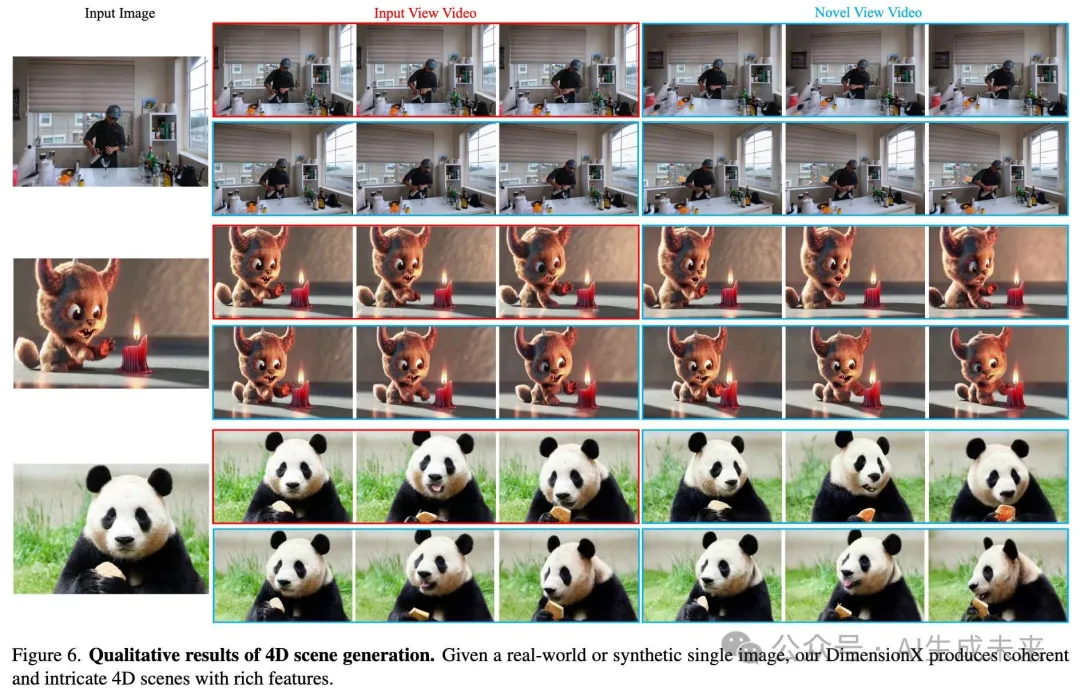

4D场景生成

在真实世界和合成数据集上评估了DimensionX。具体来说,采用了Neu3D ,该数据集包含不同场景的高分辨率多视角视频,以验证本文方法在真实世界视频到4D生成的表现。如下图6所示,给定一张单一图像,DimensionX能够从大角度新视角生成高度一致的动态视频。

消融实验

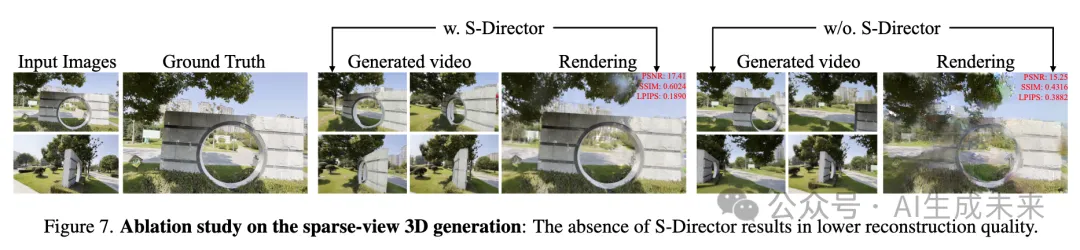

3D生成的轨迹感知机制。在稀疏视角的3D生成中,利用S-Director来指导视频插值模型。如下图7所示,在处理大角度稀疏视角时,缺乏S-Director通常会导致“贾努斯问题”,即生成多个头部,从而显著降低重建质量。

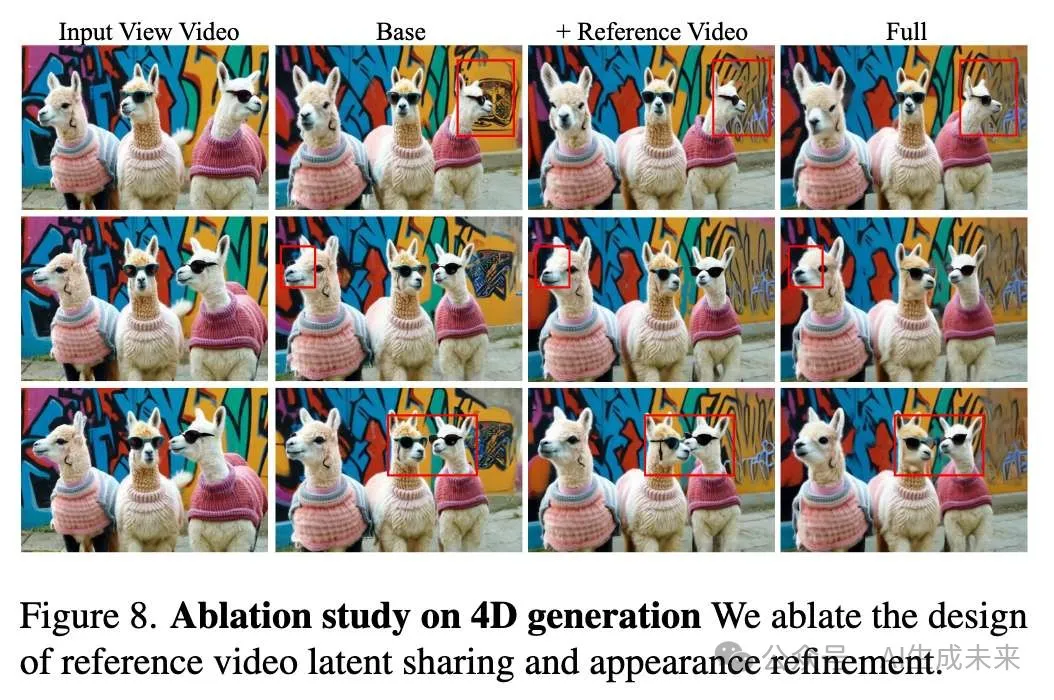

4D生成的身份保持去噪策略。在4D场景生成中,在真实世界图像上进行实验,分析我们在4D场景生成中的身份保持去噪策略。如下图8所示,对参考视频潜在共享和外观精细化的设计进行了消融实验,具体分析了新视角中不同帧之间的一致性。可以观察到,直接将每帧视频组合在一起会导致严重的不一致性,包括背景和主题形状。通过参考视频潜在共享,全球背景和外观在不同帧之间表现出高度一致性。在参考视频潜在共享的基础上,外观精细化增强了外观细节的一致性。

结论

本文介绍了DimensionX框架,能够仅从单张图像生成具有可控视频扩散的逼真3D和4D场景。核心思路是引入ST-Director,通过学习基于维度变化的数据集上的维度感知LoRA,解耦视频扩散模型中的空间和时间先验。还研究了视频扩散的去噪过程,并引入了一种无需调优的维度感知组合方法,实现了混合维度控制。通过可控的视频扩散,能够从顺序生成的视频帧中恢复准确的3D结构和4D动态。为了进一步增强DimensionX在真实场景中的泛化能力,为3D场景生成量身定制了轨迹感知策略,为4D场景生成设计了身份感知机制。通过在各种真实世界和合成数据集上的广泛实验,证明了本文的方法在可控视频生成以及3D和4D场景生成方面达到了最先进的性能。

本文转自AI生成未来 ,作者:AI生成未来

原文链接:https://mp.weixin.qq.com/s/lwj239Obzisp3MDl2gaplA