LLM-ESR@NeurIPS 2024: 大语言模型破解推荐系统的长尾难题

在现实世界的推荐系统中,大多数用户只与少数项目互动,而大多数项目很少被消费,这导致了所谓的长尾挑战。为了解决这一问题,研究者们提出了一种新框架LLM-ESR,它利用大型语言模型的强大语义理解能力来增强推荐系统的性能,专门优化那些互动较少的用户和项目的效果。

序列推荐系统(SRS)旨在基于用户的历史互动预测用户随后的选择,并在电子商务和社交媒体等多个领域得到应用。然而,在现实世界的系统中,大多数用户只与少数项目互动,而大多数项目很少被消费。这两个问题被称为长尾用户和长尾项目挑战,常常给现有的SRS带来困难。这些挑战可能会对用户体验和卖家利益产生不利影响,因此解决它们至关重要。尽管一些工作已经解决了这些挑战,但它们仍然因为互动的内在稀缺性而受到跷跷板效应或噪声问题的困扰。大型语言模型(LLMs)的进步为从语义角度解决这些问题提供了有希望的解决方案。作为该领域的先驱之一,我们提出了序列推荐的大型语言模型增强框架(LLM-ESR)。该框架利用从LLMs派生的语义嵌入来增强SRS,而不会增加LLMs的额外推理负担。为了解决长尾项目挑战,我们设计了一个双视图建模框架,结合了LLMs的语义和传统SRS的合作信号。对于长尾用户挑战,我们提出了一种检索增强的自蒸馏方法,利用来自相似用户的更有信息量的互动来增强用户偏好表示。为了验证我们提出的增强框架的有效性和通用性,我们在三个真实世界的数据集上进行了广泛的实验,使用了三种流行的SRS模型。结果表明,我们的方法始终超过现有的基线,并特别有利于长尾用户和项目。

1 引言

序列推荐的目标是基于用户的历史记录预测用户下一个可能的项目[7, 53]。由于序列推荐的本质是从未用户互动记录中提取用户偏好,近年来提出了几种创新架构。例如,SASRec[18]应用自注意力技术捕捉用户的长期偏好,而FMLPRec[24]引入了一个纯MLP架构来识别用户偏好的动态变化。

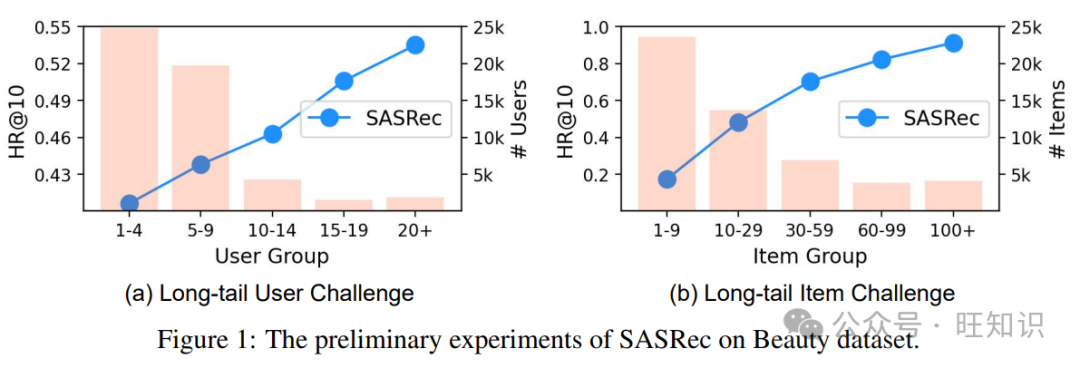

尽管在序列推荐方面取得了显著进展,但长尾挑战继续削弱其实际应用价值。一般来说,这些挑战可以分为影响用户或项目方面的两种类型。为了说明,我们在图1中展示了在亚马逊美容数据集上的知名SRS模型SASRec[18]的性能,以及其统计数据。

- i) 长尾用户挑战:在图1(a)中,我们注意到超过80%的用户与少于10个项目互动(即长尾用户),与那些有更多互动记录的用户相比,SASRec的性能较差。这表明大多数用户获得的推荐服务不如预期。

- ii) 长尾项目挑战:图1(b)表明SASRec在更受欢迎的项目上表现更好。然而,直方图表明,大约71.4%的项目拥有不超过30个互动记录,意味着它们较少被消费。解决这些长尾挑战对于提升用户体验和卖家利益至关重要。

为了解决长尾项目挑战,现有研究[17, 20]检查了流行项目和长尾项目之间的共现模式,旨在用流行项目的表示来丰富长尾项目的表示。然而,忽视项目之间真实关系可能会导致跷跷板问题[35]。至于长尾用户挑战,现有研究[36, 34]探索了所有用户之间的互动历史,试图为尾部用户增加伪项目。然而,这些方法仍然只依赖于合作信息,倾向于生成由于用户之间不准确的相似性而导致的噪声项目[34]。此时,用户或项目之间的出色语义关系可以发挥作用,这表明了利用语义来面对长尾挑战的潜力。

大型语言模型(LLMs)的最新进展为从语义角度减轻长尾挑战提供了希望。然而,LLMs最初是为自然语言处理任务而不是推荐任务设计的。一些作品[62, 42]已经做出了努力以适应,但仍然存在两个问题。i) 效率低下的整合:最近的研究探索了派生信息性提示以激活ChatGPT[54, 10]或修改LLaMA[25, 27, 58]的标记化方法以进行序列推荐。尽管它们表现出色,但这些方法在工业环境中难以应用。这是因为推荐系统通常需要低延迟以进行在线部署,而LLMs往往涉及高推理成本[11]。ii) 语义信息的缺陷:几项最近的工作[13, 16]提出利用LLMs派生的嵌入来初始化序列推荐模型的项目嵌入层,从而整合语义信息。然而,如果微调过程中没有冻结嵌入层,可能会侵蚀项目之间的原始语义关系。此外,这些方法只关注项目方面,忽视了在用户方面整合语义信息的潜在好处,这可能有助于SRS的序列编码器。

在本文中,为了更好地将LLMs整合到SRS中以解决长尾挑战,我们设计了一个大型语言模型增强框架,用于序列推荐(LLM-ESR)。首先,我们通过编码LLMs的提示文本来派生项目和用户的语义嵌入。由于这些嵌入可以提前缓存,我们的整合不会增加LLMs的任何额外推理负担。为了解决长尾项目挑战,我们设计了一个双视图建模框架,结合了语义和合作信息。具体来说,为了避免语义的缺陷,冻结了从LLMs派生的嵌入。接下来,我们提出了一种检索增强的自蒸馏方法,使用相似用户来增强SRS模型的序列编码器。用户之间的相似性是通过LLMs的用户表示来测量的。最后,重要的是要注意,所提出的框架是模型不可知的,允许它适应任何序列推荐模型。本文的贡献如下:

- 我们提出了一个大型语言模型增强框架,可以通过引入LLMs的语义信息来缓解SRS的长尾用户和项目挑战。

- 为了避免LLMs的推理负担,我们设计了一个基于嵌入的增强方法。此外,派生的嵌入被直接使用,以保留原始的语义关系。

- 我们在三个真实世界的数据集上进行了广泛的实验,使用了三种背景SRS模型,以验证LLM-ESR的有效性和灵活性。

2 问题定义

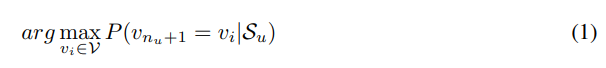

序列推荐的目标是基于用户的互动记录给出用户可能互动的下一个项目。用户集和项目集分别表示为U = {u1, ..., ui, ..., u|U|}和V = {v1, ..., vi, ..., v|V|},其中|U|和|V|是用户和项目的数量。每个用户都有一个互动序列,按时间线排列互动的项目,表示为Su = {v(u)1, ..., v(u)i, ..., v(u)nu}。nu表示用户u的互动数量。为简便起见,我们在以下部分省略了上标(u)。然后,序列推荐问题可以定义如下:

遵循与长尾SRS相关的现有工作[17, 20],我们可以将用户和项目分为尾部和头部组。设nu和pv分别表示用户互动序列的长度和项目v的流行度(即总互动数)。首先,我们按nu和pv的值降序排序用户和项目。然后,根据帕累托原则[4],取出前20%的用户和项目作为头部用户和头部项目,表示为Uhead和Vhead。其余的用户和项目是尾部用户和尾部项目,即Utail = U \ Uhead和Vtail = V \ Vhead。为了缓解长尾挑战,我们的目标是提高对Utail和Vtail的推荐性能。

3 LLM-ESR

3.1 概述

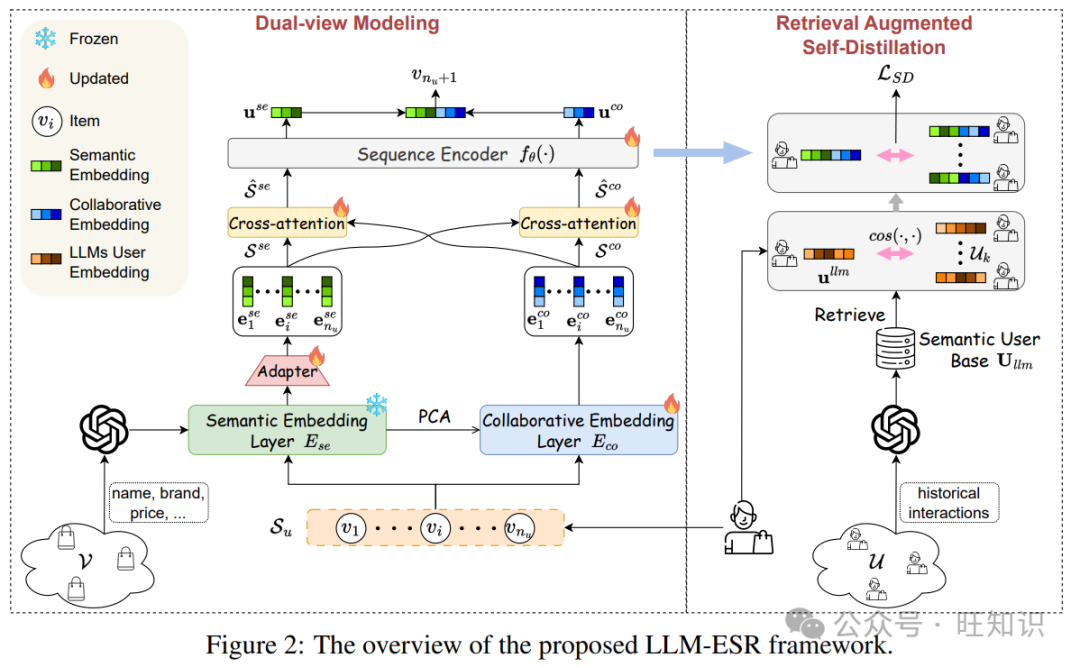

我们提出的LLM-ESR的概述如图2所示。为了获得语义信息,我们采用LLMs对用户的文本历史互动和项目的属性进行编码,得到LLMs用户嵌入和LLMs项目嵌入。然后,提出了两个模块分别增强长尾项目和长尾用户,即双视图建模和检索增强的自蒸馏。i) 双视图建模:该模块由两个分支组成。一个分支是语义视图建模,旨在从用户的互动序列中提取语义信息。它首先使用从LLMs项目嵌入派生的语义嵌入层对项目进行编码。然后,设计了一个适配器用于维度适配和空间转换。输出的项目嵌入序列将被送入交叉注意力进行融合,然后通过序列编码器得到用户在语义视图中的表示。另一个分支是合作视图建模,它通过合作嵌入层将互动序列转换为嵌入序列。接下来,通过交叉注意力和序列编码器,获得合作用户偏好。在该模块的最后,将两个视图中的用户表示融合以进行最终推荐。ii) 检索增强的自蒸馏:该模块希望通过相似用户的有信息量的互动来增强长尾用户。首先,将派生的LLMs用户嵌入视为语义用户基础,用于检索相似用户。然后,将相似用户送入双视图建模以获得他们的用户表示,这些表示是自蒸馏的引导信号。最后,派生的蒸馏损失将用作训练的辅助损失。

3.2 双视图建模

传统的SRS模型擅长捕捉合作信号,可以很好地推荐流行项目[20, 17]。然而,由于缺乏语义,它们在长尾项目上妥协[2]。因此,我们从双重视图对用户的偏好进行建模,以同时覆盖所有项目。此外,我们提出了两级融合,以更好地结合这两个视图的好处。

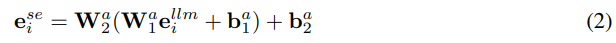

语义视图建模。一般来说,项目的属性和描述包含丰富的语义。为了利用LLMs的强大语义理解能力,我们将属性和描述组织成文本提示(提示模板可以在附录A.1中找到)。然后,为了避免LLMs可能带来的推理负担,我们缓存了LLMs的嵌入以供使用。具体来说,可以通过取出开源LLMs(如LLaMA[50])的最后一个隐藏状态或公共API(如text-embedding-ada-0022)的嵌入来获得嵌入。本文采用了后者。设Ese ∈ R|V|×dllm表示所有项目的LLMs嵌入,其中dllm是LLMs嵌入的维度。然后,可以从LLMs派生的语义嵌入层Ese用于语义视图建模,以增强长尾项目。然而,以前的工作[13, 16]通常将其作为项目嵌入层的初始化,这可能会在微调期间破坏原始的语义关系。为了保留语义,我们冻结了Ese,并提出了一个适配器,将原始的语义空间转换为推荐空间。对于每个项目i,我们可以通过取出Ese的第i行得到其LLMs嵌入ellm_i。然后,它将被送入可调的适配器以获得语义嵌入:

其中Wa1 ∈ R^{dllm×dllm/2}, Wa2 ∈ R^{d×dllm/2} 和 ba1 ∈ R^{dllm/2×1}, ba2 ∈ R^{d×1} 是适配器的权重矩阵和偏置。通过这个过程,我们可以得到用户互动记录的项目嵌入序列,表示为Sse = [ese_1, ..., ese_nu]。类似于一般的SRS模型,我们采用序列编码器fθ(例如,用于SASRec[18]的自注意力层)来获得用户在语义视图中的偏好表示,如下所示:

其中use ∈ R^{d×1} 是用户在语义视图中的偏好表示,θ表示SRS模型中序列编码器的参数。

合作视图建模。为了利用合作信息,我们采用可训练的项目嵌入层,并通过互动数据对其进行监督更新。设Eco ∈ R^|V|×d 表示项目的合作嵌入层。然后,通过从Eco中提取相应的行,获得项目嵌入序列Sco = [eco_1, ..., eco_nu]。为了获得用户在合作视图中的偏好uco,我们将嵌入序列输入到序列编码器,即,uco = fθ(Sco)。值得注意的是,序列编码器fθ在语义和合作视图中是相同的,用于共享的序列模式和更高的效率[45]。此外,两个视图中的嵌入层处于不平衡的训练阶段(一个预先训练,另一个从头开始),这可能导致优化困难[1]。为了解决这个问题,我们通过降维的Ese初始化Eco。本文使用主成分分析(PCA)[43]作为降维方法。

两级融合。有效整合语义视图和合作视图对于吸收这两个视图的好处至关重要。然而,直接合并双视图中的用户表示可能会忽略项目序列之间的细微相互关系。因此,我们为双视图建模模块设计了一个两级融合方法,即序列级和对数级。前者旨在隐式捕获双视图中项目序列之间的相互关系,而后者明确针对推荐能力的组合。具体来说,我们提出了一个交叉注意力机制用于序列级融合。为了简化描述,我们只取语义视图与合作视图的交互为例,另一个视图也是如此。具体来说,Sse被视为查询,Sco作为注意力机制中的键和值。设Q = SseWQ, K = ScoWK, V = ScoWV,其中WQ, WK, WV ∈ R^d×d 是权重矩阵。然后,交互的合作嵌入序列可以表示如下:

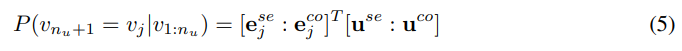

按照交叉注意力的相同过程,我们也可以得到相应的语义嵌入序列ˆSse。最后,Sse, Sco被ˆSse, ˆSse替换,送入fθ(·)。至于对数级融合,我们将双视图的用户和项目嵌入进行拼接以进行推荐。因此,为用户u推荐项目j的概率分数计算如下:

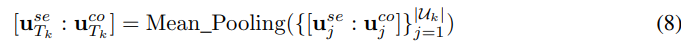

其中“:”表示两个向量的拼接操作。基于概率分数,我们采用成对排名损失来训练框架:

其中v+k+1 和 v−k+1 是真实项目和配对的负项目。值得注意的是,排名损失可能会根据不同的SRS模型略有不同,例如GRU4Rec[14]的序列到一成对损失。

3.3 检索增强的自蒸馏

长尾用户问题源于SRS中序列编码器捕获用户偏好的互动不足。因此,我们提出了一种自蒸馏方法来增强序列编码器的提取能力。自蒸馏[12, 60]是一种知识蒸馏类型,它将一个模型视为学生和教师,用于模型增强。对于SRS,由于多个相似用户拥有更有信息量的互动,将它们的知识转移到目标用户上是有希望的。因此,这种知识转移有两个关键挑战,即如何检索相似用户以及如何转移知识。

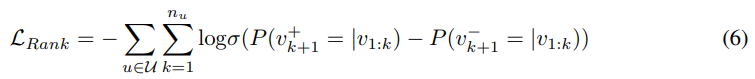

检索相似用户。以前的工作已经证实LLMs可以理解文本用户互动记录的语义含义,用于推荐[25, 10]。基于他们的观察,我们将用户互动的项目标题组织成文本提示(提示模板可以在附录A.1中找到)。然后,类似于LLMs项目嵌入Ese的派生,我们可以获得并保存LLMs用户嵌入,表示为Ullm ∈ R^{|U|×dllm}。它也被称为本文中的语义用户基础,因为语义关系已编码在其中。对于每个目标用户k,我们可以检索相似用户集Uk如下:

其中cos(·, ·)是余弦相似性函数,用于测量两个向量之间的距离。N表示相似用户集的大小,这是一个超参数。

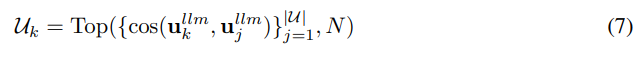

自蒸馏。如前所述,我们设计了自蒸馏,将几个相似用户的知识转移到目标用户。由于用户偏好表示,即use和uco,编码了用户的综合知识,我们将这种表示配置为蒸馏的中介。为了获得教师中介,我们首先利用双视图建模框架(第3.2节)为每个相似用户获得用户表示,表示为{use_j, uco_j}^|Uk|_j=1。然后,教师中介通过平均池化计算,如下公式:

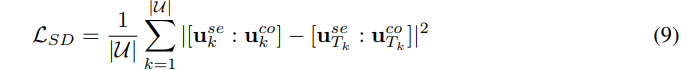

学生中介是目标用户k的表示,即[use_k : uco_k]。基于教师和学生中介,自蒸馏损失可以表示如下:

请注意,use_Tk和uco_Tk的梯度被停止,因为它们只提供引导信号而不是优化模型。

3.4 训练和推理

训练。基于第3.2节和第3.3节的说明,我们在训练期间只更新合作嵌入层、适配器、交叉注意力和序列编码器,同时冻结语义嵌入层和语义用户基础。由于原始LLMs嵌入Ese和Ullm被冻结,原始的语义关系得到了很好的保留。优化的训练损失是成对排名损失和自蒸馏损失的组合,可以写成如下:

其中α是调整自蒸馏幅度的超参数。

推理。在LLM-ESR的推理过程中,免除了检索增强的自蒸馏模块,因为不需要辅助损失。因此,我们遵循双视图建模过程,通过方程(5)进行最终推荐。此外,由于语义嵌入层可以提前缓存,避免了对LLMs的调用,从而防止了额外的推理成本。由于空间有限,算法位于附录A.2中,以更清晰。

4 实验

4.1 实验设置

数据集。我们应用了三个真实世界的数据集进行评估,即Yelp、亚马逊时尚和亚马逊美容。我们遵循以前的SRS工作[18, 49]进行预处理和数据分割。更多关于数据集和预处理的详细信息可以在附录B.1中看到。

基线。为了验证灵活性,我们将竞争基线和LLM-ESR与三种知名的SRS模型结合:GRU4Rec[14]、Bert4Rec[48]和SASRec[18]。然后,在实验中比较了两组基线。一组是传统的长尾序列推荐增强框架,包括CITIES[17]和MELT[20]。另一组是基于LLM的增强框架,包括RLMRec[44]和LLMInit[13, 16]。更多关于基线的详细信息已放入附录B.2。

实现细节。所有实验中使用的硬件是带有Tesla V100 32G GPU的Intel Xeon Gold 6133平台,而基本软件要求是Python 3.9.5和PyTorch 1.12.0。超参数N和α从{2, 6, 10, 14, 18}和{1, 0.5, 0.1, 0.05, 0.01}中搜索。更多关于实现细节的详细信息在附录B.3中。实现代码可在https://github.com/Applied-Machine-Learning-Lab/LLM-ESR获得。

评估指标。在实验中,我们采用了Top-10列表进行评估。具体来说,采用了命中率(H@10)和归一化折扣累积增益(N@10)。按照[18],我们随机抽取了100个用户未互动的项目作为负样本配对以计算指标。为了保证实验结果的鲁棒性,我们报告了三次测试的平均结果,随机种子为{42, 43, 44}。

4.2 总体性能

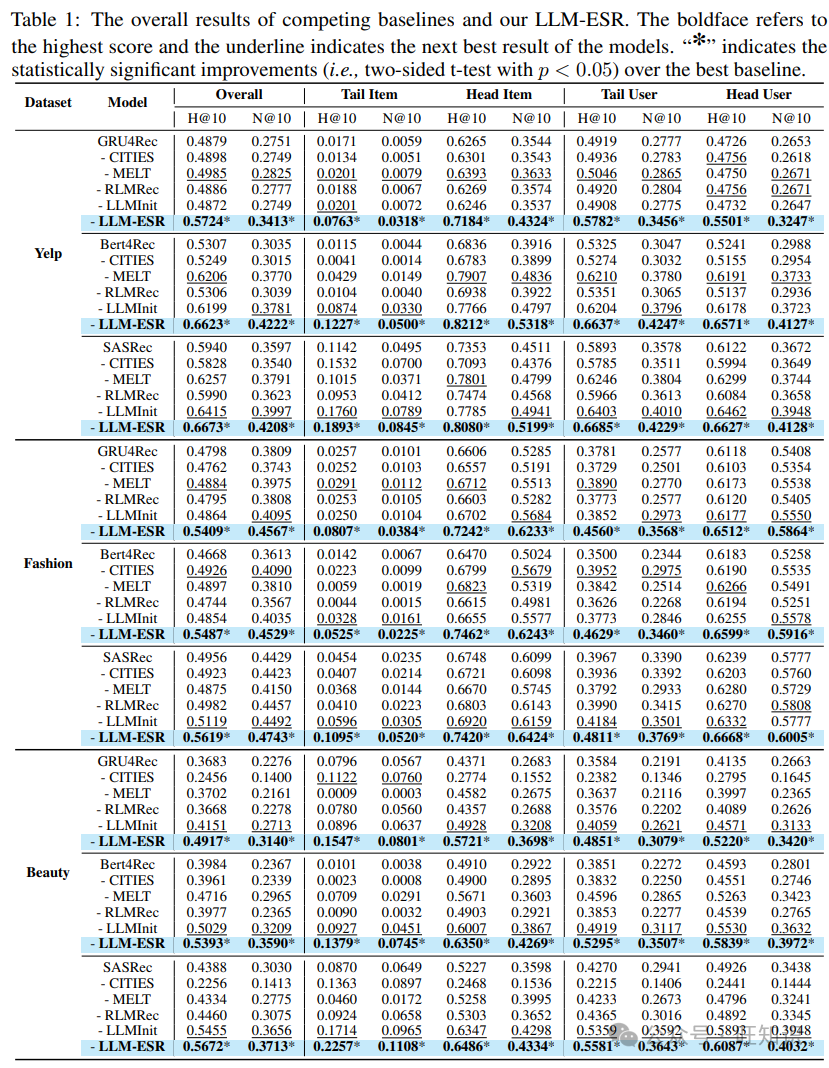

为了验证所提出的LLM-ESR的有效性和灵活性,我们在表1中展示了三个数据集上的总体、尾部和头部性能。一目了然,我们发现所提出的LLM-ESR在所有SRS模型下都能超越所有竞争基线,验证了我们框架的有用性。然后,我们通过以下分析得出更多结论。

表2:在Yelp数据集上以SASRec为背景SRS模型的消融研究。粗体表示最高分数,下划线表示模型的次优结果。

总体比较。从结果中,我们观察到所提出的LLM-ESR在两个指标下都领先于总体性能,这表明了更好的增强效果。LLMInit通常是次优的。这一现象表明,从LLMs注入的语义实际上增强了SRS。然而,与其它基于LLM的方法相比,RLMRec通常表现不佳,因为它是为了协同过滤算法而设计的,与SRS不兼容。至于传统基线,MELT在大多数情况下都处于领先地位。原因在于它同时解决了长尾用户和长尾项目挑战。相比之下,CITIES有时甚至不如背景SRS模型,因为跷跷板问题,即流行项目的急剧下降。

长尾项目和用户比较。根据第2节中说明的分割方法,项目被分为尾部项目和头部项目。从表1中,我们观察到我们的LLM-ESR不仅在尾部项目组上取得了最佳成绩,而且在头部项目组上也获得了第一名。这种性能比较突出了我们通过双视图建模结合语义和合作信号的组合。LLMInit在所有基线中领先于尾部组,这表明语义信息可以惠及长尾项目。值得注意的是,CITIES有时在尾部组表现更好,但对流行项目有害,这意味着它存在跷跷板问题。此外,结果表明MELT、LLMInit和LLM-ESR可以显著增强尾部用户组。MELT旨在增强尾部用户,但由于其合作视角的局限性,不如我们的方法。尽管LLMInit也可以通过引入语义来惠及尾部用户,但它忽略了从用户端利用LLMs的潜力。

灵活性。表1显示,所提出的框架可以在所有三种背景SRS模型上获得最大的性能提升,这表明了LLM-ESR的灵活性。相比之下,其他基线倾向于依赖SRS的类型。传统方法,即CITIES和MELT,倾向于对GRU4Rec表现更好,而LLMInit对Bert4Rec和SASRec更有益。

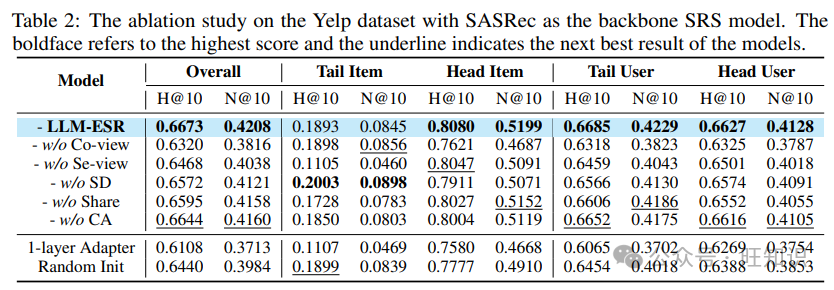

4.3 消融研究

消融研究的结果如表2所示。首先,我们移除合作视图或语义视图以研究双视图建模,表示为无合作视图和无语义视图。结果表明,无合作视图显著降低了头部组的性能,而无语义视图对尾部项目的性能损害明显。这些变化表明合作和语义信息的明显特点,突出了两者的结合。无自蒸馏意味着放弃自蒸馏,这表明长尾用户的性能下降。这表明所提出的检索增强自蒸馏的效果。这些变体的结果验证了为LLM-ESR设计每个组件的动机。无共享和无交叉注意力代表使用分开的序列编码器和移除交叉注意力。这两个的性能下降说明了共享设计和序列级融合的有效性。更多结果可以在附录C.1中看到。

此外,我们有两个设计来缓解整个LLM-ESR框架的优化。一个是,我们使用降维的LLM项目嵌入来初始化合作嵌入层,而不是随机初始化。另一方面,我们提出了一个双层适配器来填补LLM嵌入和项目嵌入之间的大维度差距。为了说明这两个设计的有效性,我们比较了1层适配器和随机初始化变体的LLM-ESR。表2中的结果表明,这两个变体都低于原始的LLM-ESR,验证了我们特殊设计的成功。

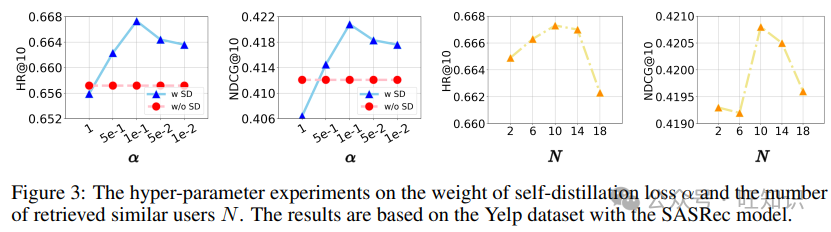

图3:在Yelp数据集上,自蒸馏损失的权重α和检索到的相似用户数量N的超参数实验。结果基于SASRec模型。

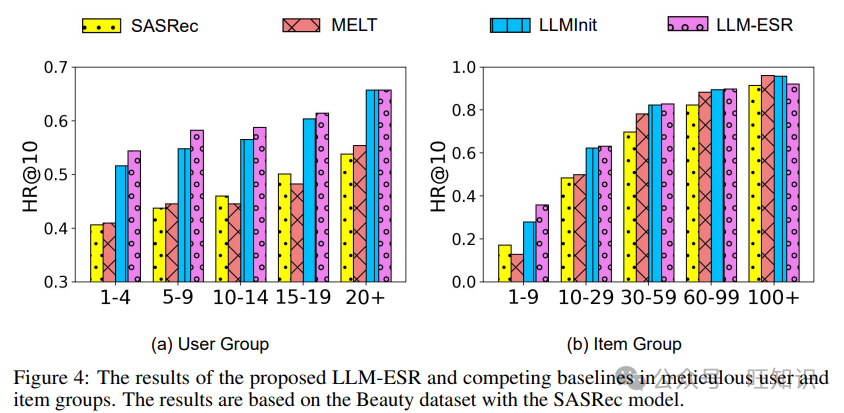

图4:所提出的LLM-ESR和竞争基线在详细的用户和项目组中的结果。结果基于SASRec模型的美容数据集。

4.4 超参数分析

为了研究LLM-ESR中的超参数的影响,我们展示了它们变化时的性能趋势,如图3所示。超参数α控制设计的自蒸馏在优化中的影响程度。随着α从1变化到0.01,推荐准确性先上升后下降。大α的性能下降的原因在于过分强调自蒸馏会影响排名损失的收敛。较小的α也会降低性能,这表明设计的自蒸馏的有用性。至于检索到的用户数量N,最佳选择是10。原因是更多的用户可以提供更有信息量的互动。然而,过大的N可能会降低检索到的用户的相关性。

4.5 组分析

为了更细致的分析,我们根据序列长度nu和流行度pv将用户和项目分为5组,并在图4中展示了每组的性能。从结果中,我们观察到基于LLM的框架在每个用户和项目组中都取得了增长,而MELT对某些特定组有积极影响。它反映了MLET的跷跷板问题,并揭示了利用LLMs的语义嵌入的好处。比较LLMInit与LLM-ESR,LLM-ESR在长尾组(例如,1-4用户组和1-9项目组)上可以获得更多的增长,这证明了我们的框架更好地保留了LLMs的语义信息。以Bert4Rec和GRU4Rec为背景的组分析在附录C.3中。

5 相关工作

5.1 序列推荐

序列推荐的核心是指捕捉序列模式以预测下一个可能的项目[29, 38, 31, 37, 59, 24, 23, 26, 39]。因此,在早期阶段,研究人员专注于制造架构以提高模型容量。GRU4Rec[14]和Caser[49]应用RNN和CNN[21]进行序列建模。后来,受到自注意力[51]在自然语言处理中的巨大成功的启发,SASRec[18]和Bert4Rec[48]验证了其在SRS中的潜力。此外,Zhou等人[65]提出了一个纯MLP架构,与SASRec相比,实现了类似的准确性但更高的效率。尽管在SRS方面取得了巨大进步,但长尾问题仍然未被充分探索。对于长尾项目问题,CITIES[17]设计了一个嵌入推断函数,专门为长尾项目设计。就长尾用户问题而言,数据增强是主要方式[36, 34]。只有一项工作,MELT[20],同时解决了这两个问题,但仍然坚持合作视角。相比之下,所提出的LLM-ESR通过引入LLMs,更好地从语义视角处理这两个长尾问题。

5.2 为推荐使用LLMs

大型语言模型[62, 42]因其在语义理解方面的强大能力而受到广泛关注。最近,出现了几项工作探索如何利用LLMs在推荐系统(RS)中[63, 28, 22, 40, 56, 57, 64, 32, 30],可以分为两类,即LLMs作为RS和LLMs增强RS。第一行研究旨在直接通过LLMs完成推荐任务。在早期阶段,研究人员倾向于制造提示模板,通过对话激发LLMs的推荐能力。例如,ChatRec[10]提出了一个对话过程,逐步完成推荐任务。DRDT[54]通过基于检索的动态反思过程,通过上下文学习[6]整合SRS。LLMRerank[9]和UniLLMRec[61]制造了链式思考提示,分别针对重排阶段和整个推荐过程。此外,一些其他研究人员探索了微调开源LLMs以用于RS。TALLRec[2]是第一个,通过参数高效的微调技术[15, 33]微调LLaMA-7B。一些后续工作,包括E4SRec[25]、LLaRA[27]和RecInterpreter[58],通过修改标记化,将合作信号整合到LLMs中。然而,这项工作面临高推理成本的挑战。另一行,LLMs增强RS,更为实用,因为它们在推荐时避免了使用LLMs。例如,RLMRec[44]通过辅助损失与LLMs对齐。AlphaRec[46]采用LLMs嵌入来增强合作过滤模型。另一方面,LLM4MSR[55]和Uni-CTR[8]提出利用LLMs增强多域推荐模型。至于LLMs增强序列推荐,Harte等人[13]和Hu等人[16]采用LLMs嵌入作为传统模型的初始化。所提出的LLM-ESR属于后者类别,但进一步缓解了语义信息缺陷的问题。

6 结论

在本文中,我们提出了一个大型语言模型增强框架,用于序列推荐(LLM-ESR),以处理长尾用户和长尾项目挑战。首先,我们获取并缓存了LLMs的语义嵌入,这是为了推理效率。然后,提出了一个双视图建模框架,结合了LLMs的语义和传统模型中的合作信号。它可以帮助增强SRS中的长尾项目。接下来,我们设计了检索增强的自蒸馏来缓解长尾用户挑战。通过综合实验,我们验证了LLM-ESR的有效性和灵活性。

参考资料

标题:LLM-ESR: Large Language Models Enhancement for Long-tailed Sequential Recommendation

作者:Qidong Liu, Xian Wu, Yejing Wang, Zijian Zhang, Feng Tian, Yefeng Zheng, Xiangyu Zhao

单位:1 School of Auto. Science & Engineering, MOEKLINNS Lab, Xi’an Jiaotong University; 2 City University of Hong Kong; 3 Jarvis Research Center, Tencent YouTu Lab; 4 Jilin University; 5 School of Comp. Science & Technology, MOEKLINNS Lab, Xi’an Jiaotong University; 6 Medical Artificial Intelligence Lab, Westlake University

标签:Sequential Recommendation, Large Language Models, Long-tail Challenge, Semantic Embedding

概述:本文提出了一种利用大型语言模型(LLMs)增强长尾序列推荐的框架LLM-ESR,以改善用户体验和提升推荐系统性能。

链接:https://arxiv.org/pdf/2405.20646

本文转载自旺知识,作者: 旺知识