一文彻底搞懂深度学习 - 优化器(Optimizer) 原创

在深度学习中,优化器(Optimizer)是一个核心概念,它负责调整神经网络的权重和偏置,以便最小化损失函数,从而提高模型的准确性和性能。

常见的优化器,包括梯度下降系列(批量梯度下降BGD、随机梯度下降SGD、小批量梯度下降MBGD)、动量法、NAG、Adagrad、RMSprop以及Adam等,它们的核心目标是通过调整学习率、利用梯度信息等手段,高效地最小化损失函数,从而优化和提升神经网络模型的性能。

Optimizer

一、优化器

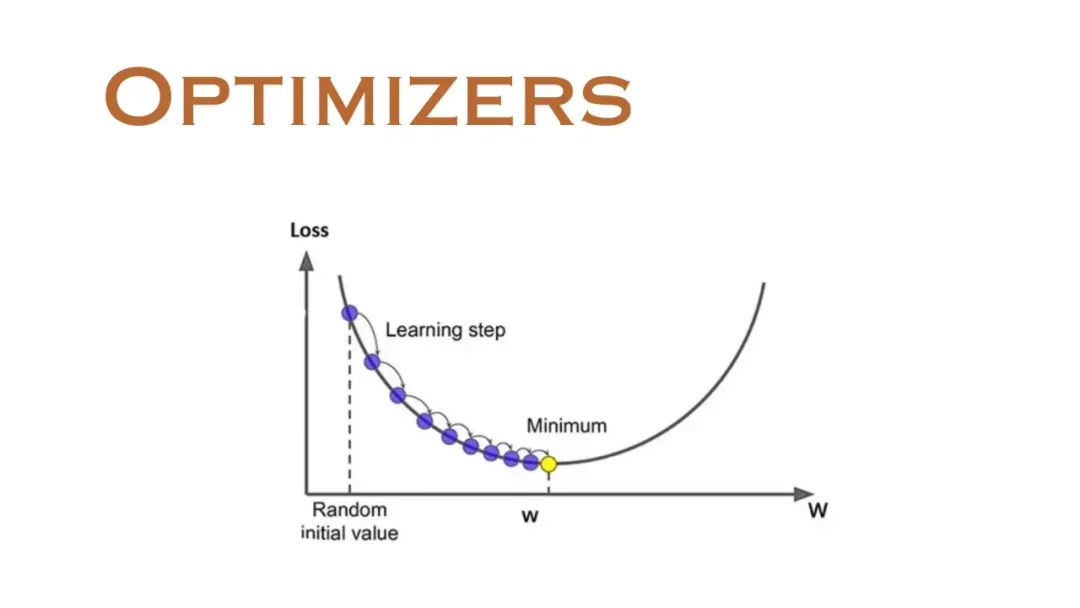

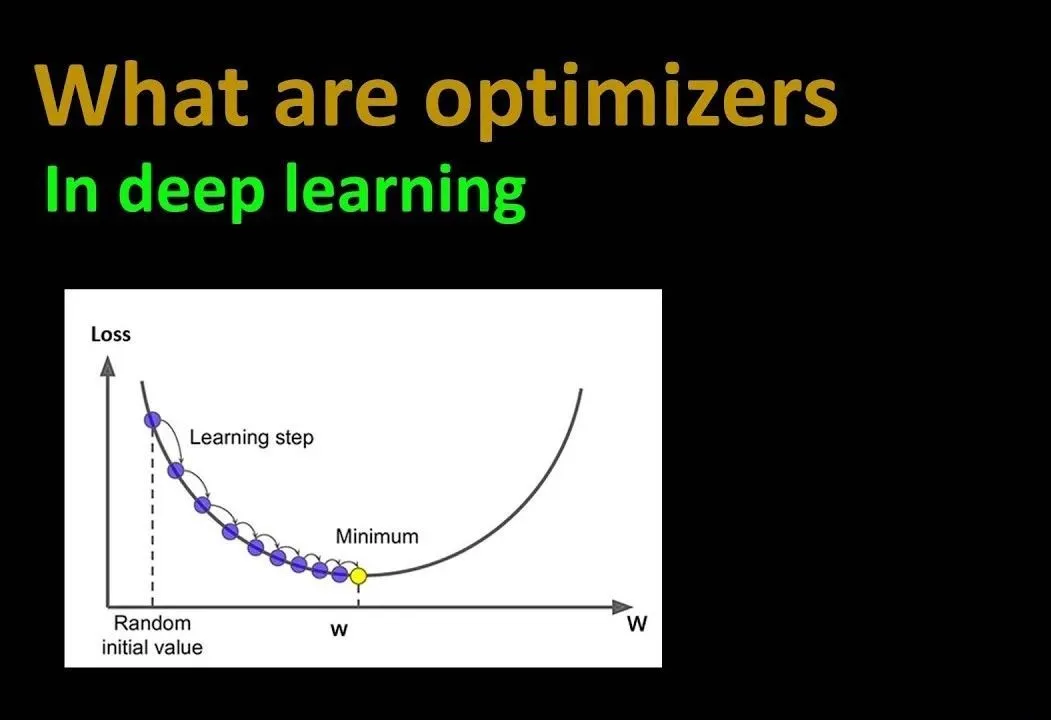

优化器(Optimizer)是什么?优化器是一种特定的深度学习算法,用于在训练深度学习模型时调整权重和偏差,从而更新神经网络参数以最小化某个损失函数。

损失函数衡量了模型的预测值与真实值之间的差异,而优化器的目标是通过调整网络参数来最小化这个差异,从而提高模型的准确性和性能。

为什么需要优化器?由于目标函数拥有众多参数且结构复杂,直接寻找最优参数变得十分困难。因此,我们需要借助优化器,它能够逐步调整参数,确保每次优化都朝着最快降低损失的方向前进。

什么是优化器的调参?优化器调参即根据模型实际情况,调整学习率、动量因子、权重衰减等超参数,以优化训练效果和性能。需通过经验和实验找最佳组合,实现快速收敛、减少摆动、防止过拟合。

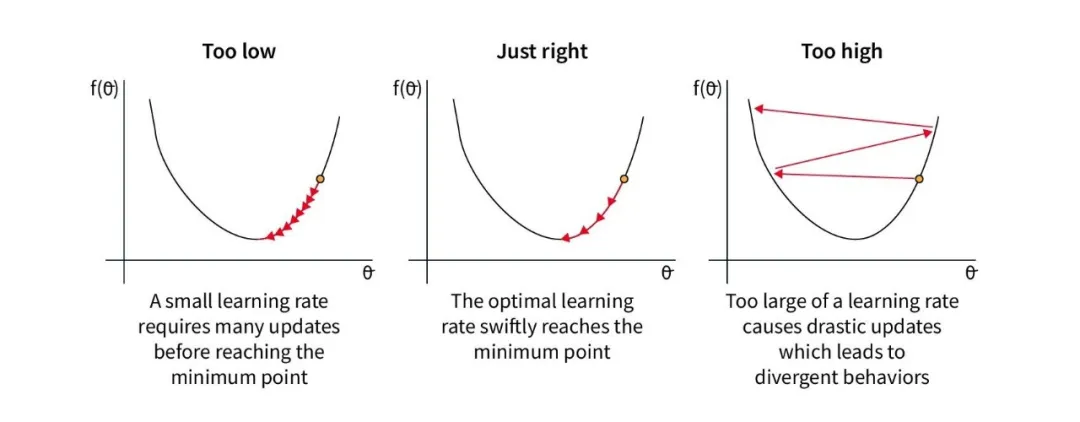

- 学习率:过大的学习率可能导致模型无法收敛,而过小的学习率则会使训练过程变得缓慢。因此,需要根据实际情况选择合适的学习率。

- 动量因子:对于使用动量的优化器,动量因子的选择也很重要。动量因子决定了过去梯度对当前梯度的影响程度。合适的动量因子可以加速收敛,减少摆动。

- 权重衰减:权重衰减是一种正则化方法,用于防止模型过拟合。在优化器中,可以通过添加权重衰减项来减少模型的复杂度。

二、常用的优化器

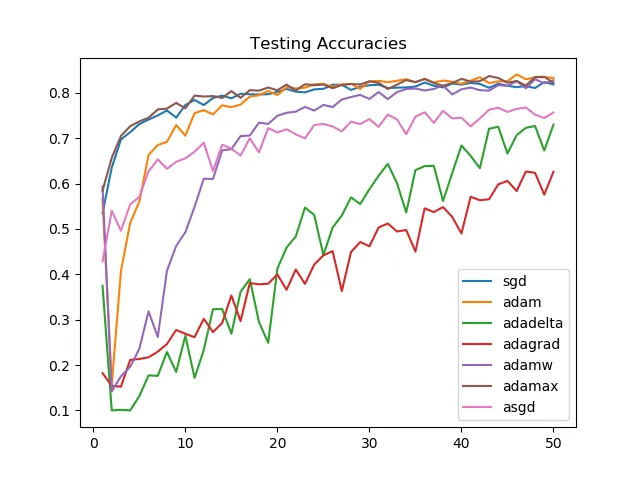

常用的优化器有哪些?常用的优化器主要包括SGD、BGD、Momentum、NAG、Adagrad、RMSprop、Adadelta和Adam等,它们通过不同的策略调整学习率和梯度方向,以实现快速、稳定的模型训练。

1. 随机梯度下降(SGD)

- 定义:每次迭代仅使用一个训练样本来计算损失函数的梯度,并更新模型参数。

- 特点:适用于大规模数据集和在线学习场景。

2. 批量梯度下降(BGD)

- 定义:每次迭代使用全部训练数据来计算损失函数的梯度,并更新模型参数。

- 特点:适合于小规模数据集和需要精确估计梯度的场景。

3. 动量法(Momentum)

- 定义:通过引入一个累计梯度的指数加权平均,将过去的梯度信息考虑进当前的参数更新中,从而增加稳定性和提高训练效率。

- 特点:常用于改进随机梯度下降(SGD)和小批量梯度下降(MBGD)等优化器。

4. NAG(Nesterov Accelerated Gradient)

- 定义:在动量法基础上进行改进的优化算法,先按照之前的动量更新参数,再在这个新的位置计算梯度,并根据此调整更新方向。

- 特点:可以减少摆动,加快收敛速度。

5. Adagrad

- 定义:一种自适应梯度下降的优化器,对不同参数使用不同的学习率。对于更新频率较低的参数施以较大的学习率,对于更新频率较高的参数使用较小的学习率。

- 特点:适用于大规模数据集和特征提取任务。

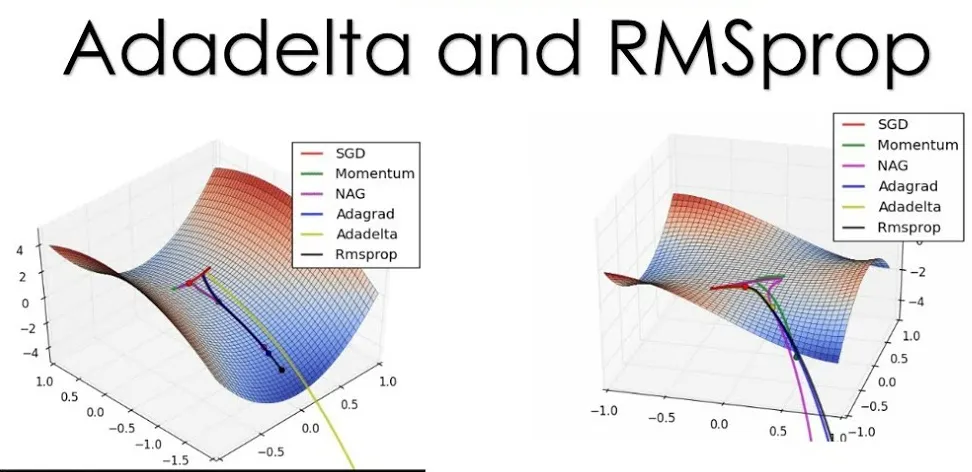

6. RMSprop

- 定义:对Adagrad的一种改进,根据梯度的历史信息来自适应地调整学习率。使用梯度的指数加权平均而不是累积和来计算学习率。

- 特点:适用于处理非稀疏数据和长期依赖的问题。

7. Adadelta

- 定义:对Adagrad的另一种改进,通过计算梯度平方的指数加权移动平均来避免学习率趋于0的问题,同时简化了计算。

- 特点:适用于需要长时间训练的大型神经网络和需要稳定学习率的任务。

8. Adam

- 定义:结合了AdaGrad和Momentum两种优化算法的优点,能够快速收敛并且减少训练时间。Adam优化器计算出每个参数的独立自适应学习率,不需要手动调整学习率的大小。

- 特点:适用于处理大规模数据和训练复杂模型。

本文转载自公众号架构师带你玩转AI 作者:AllenTang

原文链接:https://mp.weixin.qq.com/s/lriq7YfzG9ZPojnPPpSnmw