生成式模型实现的区别——VAE、GAN、Diffusion和transformer 原创

“ 生成式模型的表象就是从训练数据的数学分布中学习规律,然后生成新的相似的数据样本。”

在之前的文章中虽然也介绍过生成式模型,但更多的是从非技术的角度理解什么是生成式模型;而今天我们来学习一下,生成式模型的实现。

生成式模型

什么是生成式模型?

从专业的角度来说,生成模型是一类能学习数据分布并生成新样本的机器学习模型;通过捕捉训练数据的数学关系,创建出与真实数据相似但从未出现过的新示例。

生成式模型的原理

生成模型的工作原理是通过学习训练数据在数学上的统计规律和结构特征,构建一个能够描述数据分布的模型,然后利用这个模型生成新的数据样本;这些样本在统计特性上与原始训练数据相似,但内容却是全新的。

生成模型的主要应用

生成模型的主要应用非常广泛,涵盖了从艺术创作到数据科学等多个领域。以下是一些关键的应用实例:

- 图像生成:生成模型可以用来创建新的图像,这些图像在视觉上与真实图像无法区分,应用于艺术创作、游戏设计、虚拟现实等。

- 风格迁移:在艺术领域,生成模型可以将一种艺术风格应用到另一幅图像上,实现风格转换。

- 数据增强:在机器学习中,生成模型可以用来增加训练数据集的多样性,提高模型的泛化能力,尤其在数据稀缺的情况下非常有用。

- 图像修复和超分辨率:通过学习图像的低频和高频特征,生成模型可以用于修复损坏的图像或提高图像的分辨率。

- 文本生成:生成模型可以用于生成文章、诗歌、对话等自然语言文本,应用于聊天机器人、内容创作等领域。

- 语音合成:在音频处理领域,生成模型可以合成新的语音片段,用于语音识别系统的训练或虚拟助手的声音生成。

- 游戏开发:在游戏设计中,生成模型可以用于自动生成游戏环境、关卡设计或非玩家角色(NPC)的行为模式。

- 医学成像:生成模型可以帮助生成医学成像数据,用于增强诊断的准确性或在训练医疗影像分析算法时提供额外数据。

- 增强现实(AR)和虚拟现实(VR):生成模型可以创建逼真的虚拟环境和对象,提升AR和VR体验的真实感。

- 模拟和预测:在科学研究和工程领域,生成模型可以模拟复杂系统的行为,用于预测和决策支持。

常见的生成式模型有自回归模型,变分自编码器(VAE),生成对抗网络(GANs)和扩散模型(Diffusion Model)等。

生成对抗网络——GANs

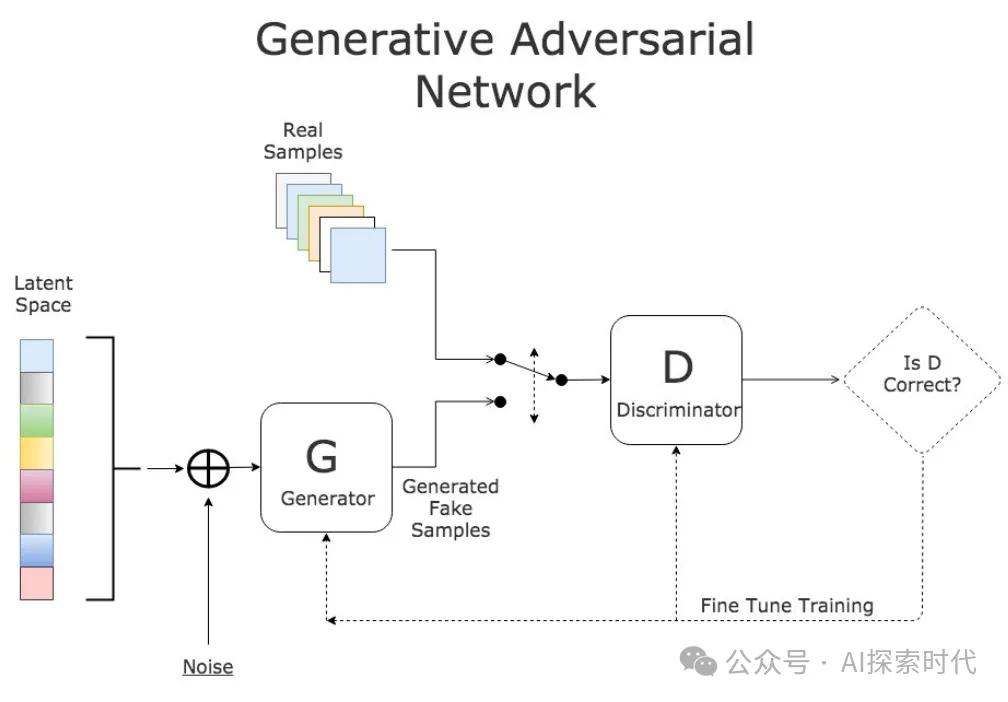

GANs由两个主要部分组成:生成器(Generator)和判别器(Discriminator)。生成器负责从随机噪声中生成数据,试图欺骗判别器;而判别器则尝试区分真实数据和生成数据。两者通过对抗性训练不断优化,最终生成器能够生成逼真的数据。

变分自编码器——VAEs

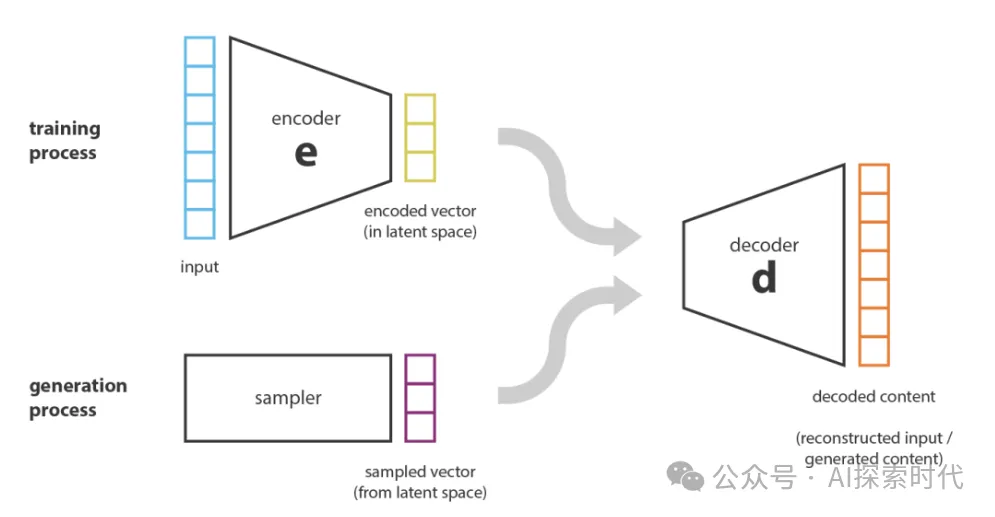

变分自编码器(Variational Autoencoders, VAEs)是生成式AI的另一核心技术。VAEs通过引入概率模型和变分推断,解决了传统自编码器在生成新数据时的局限性。VAEs在图像生成、数据降维和异常检测等方面具有重要应用。

传统自编码器(Autoencoders)通过编码器(Encoder)将输入数据压缩成潜在表示,再通过解码器(Decoder)重建输入数据。然而,传统自编码器在生成新数据时存在局限,因为其潜在空间并未显式建模概率分布。

变分自编码器的原理

变分自编码器(VAEs)通过引入概率建模,解决了传统自编码器的生成问题。其核心思想是将输入数据映射到一个已知分布(通常是高斯分布)的潜在空间,并通过最大化证据下界(ELBO)进行优化。

自回归模型——Autoregressive Models

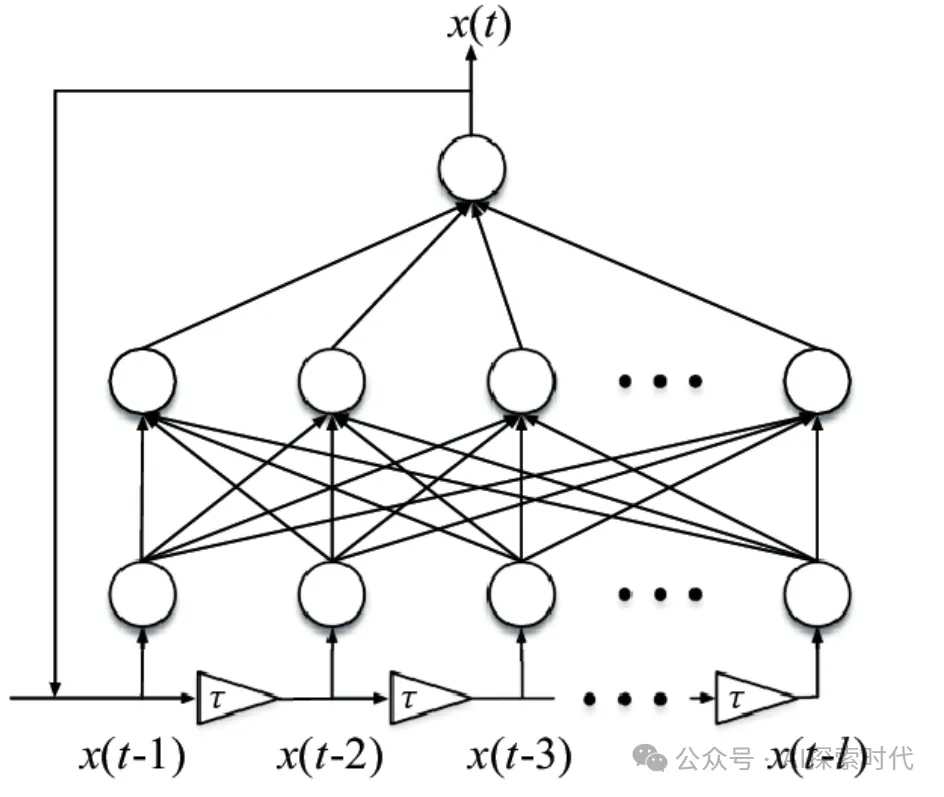

自回归模型(Autoregressive Models)是生成式AI中的一个重要类别,通过建模数据序列中的条件依赖关系,自回归模型能够逐步生成序列数据,如文本、音频和图像。自回归模型在自然语言处理、语音生成和图像生成等领域有着广泛的应用。

自回归模型是一种统计模型,用于描述数据序列中的依赖关系。其基本思想是当前时刻的数据依赖于之前时刻的数据。在生成式AI中,自回归模型通过逐步预测下一个数据点,从而生成整个序列

最简单的自回归模型是线性自回归模型(Autoregressive Integrated Moving Average, ARIMA),其假设当前时刻的数据是之前数据的线性组合。对于生成式AI,我们通常使用更复杂的深度学习模型,如循环神经网络(RNNs)、长短期记忆网络(LSTMs)和变换模型(Transformers)

Transformers的基本概念

注意力机制

Transformers的核心在于其注意力机制,尤其是自注意力机制(Self-Attention)。注意力机制允许模型在处理每个输入时关注整个输入序列,从而捕捉到全局依赖关系。具体来说,自注意力机制计算输入序列中每个元素与其他元素之间的相关性,然后基于这些相关性进行加权求和,从而生成新的表示。

跨模态生成

Transformers在跨模态生成任务中表现出色,如OpenAI的DALL-E模型。DALL-E通过将文本描述转换为图像,展示了Transformers在处理多模态数据方面的强大能力。该模型能够生成高质量的图像,广泛应用于艺术创作、广告设计和内容生成等领域 。

思考一个问题,Transformer模型架构是生成式模型吗?

本文转载自公众号AI探索时代 作者:DFires