一文彻底搞懂深度学习 - 模型评估(Evaluation) 原创

深度学习广泛应用于图像识别、语音识别、自然语言处理等多个领域。模型通过大量数据的学习和训练,能够自动提取数据中的特征,并基于这些特征进行预测和分类。如何准确评估这些模型的性能,确保它们在实际应用中能够表现出色,就需要依赖于模型评估这一关键环节。

在模型评估中,我们通常会使用各种评估指标来衡量模型的性能。分类问题常用准确率、精确率、召回率和F1分数等指标;回归问题则使用均方误差、平均绝对误差等指标。此外,ROC曲线和AUC值也能直观展示模型性能。

Evaluation

一、模型评估

模型评估(Evaluation)是什么?模型评估是指对训练完成的模型进行性能分析和测试的过程,以确定模型在新数据上的表现如何。

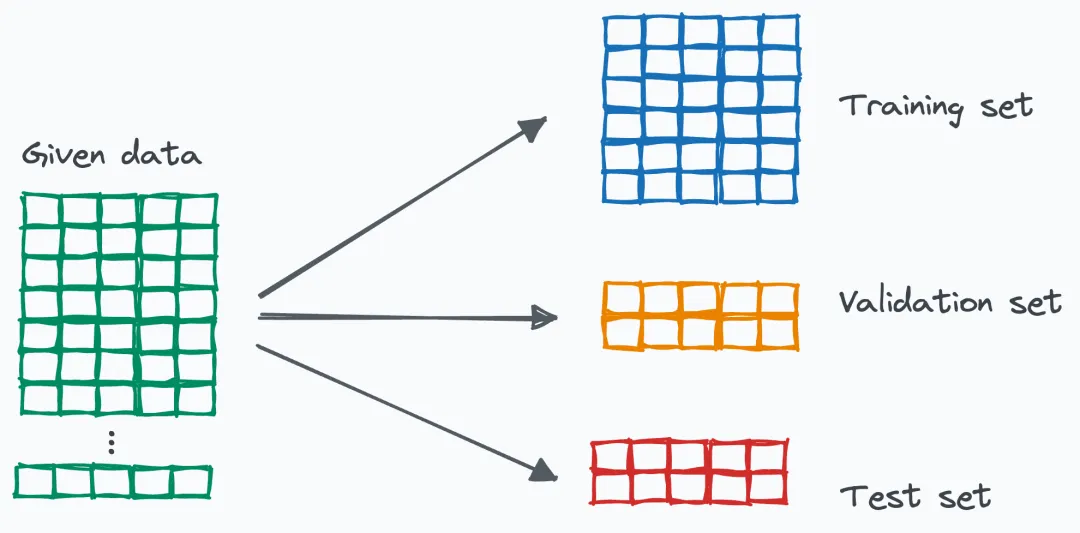

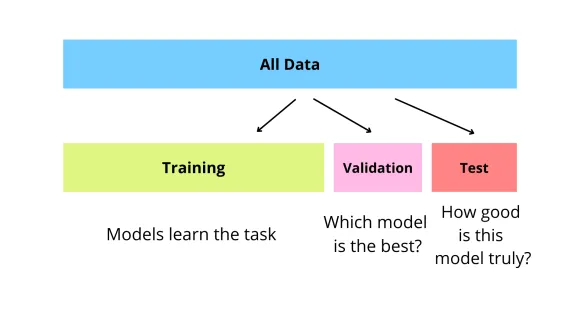

在模型评估中,我们通常会将数据集划分为训练集、验证集和测试集。

- 训练集(Training Set):用于模型学习的数据集,通过不断调整参数来最小化训练误差。

- 验证集(Validation Set):在训练过程中用于评估模型性能,以选择最佳参数和避免过拟合的数据集。

- 测试集(Test Set):模型训练完成后,用于评估模型泛化能力的独立数据集。

为什么需要模型评估?用于在训练阶段选择最佳参数、避免过拟合,并在训练完成后验证模型泛化能力。

- 训练过程中的评估:在模型训练阶段,我们需要使用验证集来评估模型的性能,以便选择最佳的参数和架构,同时避免模型过拟合训练数据。

- 训练完成后的评估:在模型训练完成后,我们使用测试集来评估模型的泛化能力,即模型在未见过的数据上的表现。

二、评估指标

模型评估指标(Evaluationetric)是什么?模型评估指标是用于量化模型在处理数据时表现的指标。它们帮助我们理解模型的性能、准确度和泛化能力,并且可以用于比较不同模型之间的优劣。

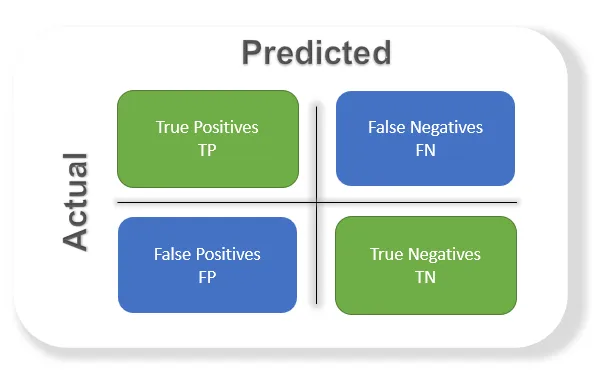

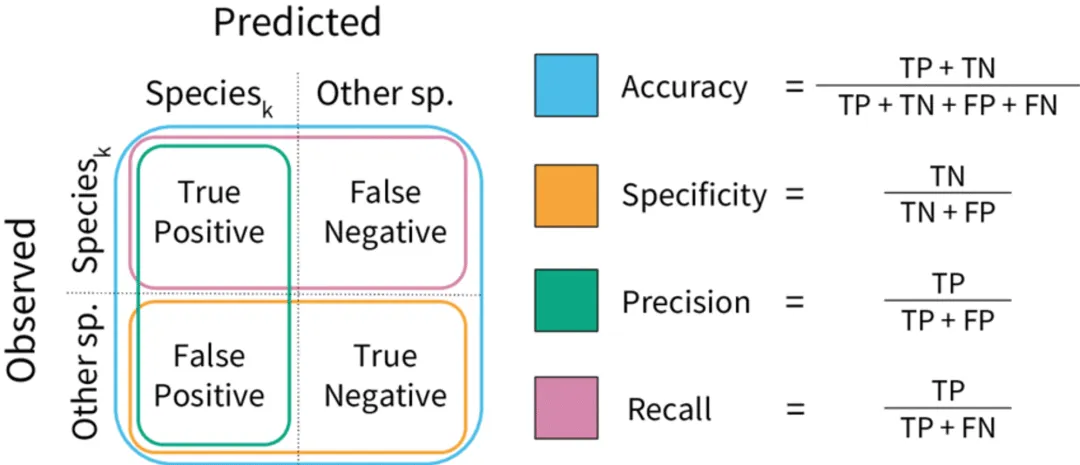

分类任务的评估指标有哪些?分类任务的评估指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1分数(F1 Score)等。

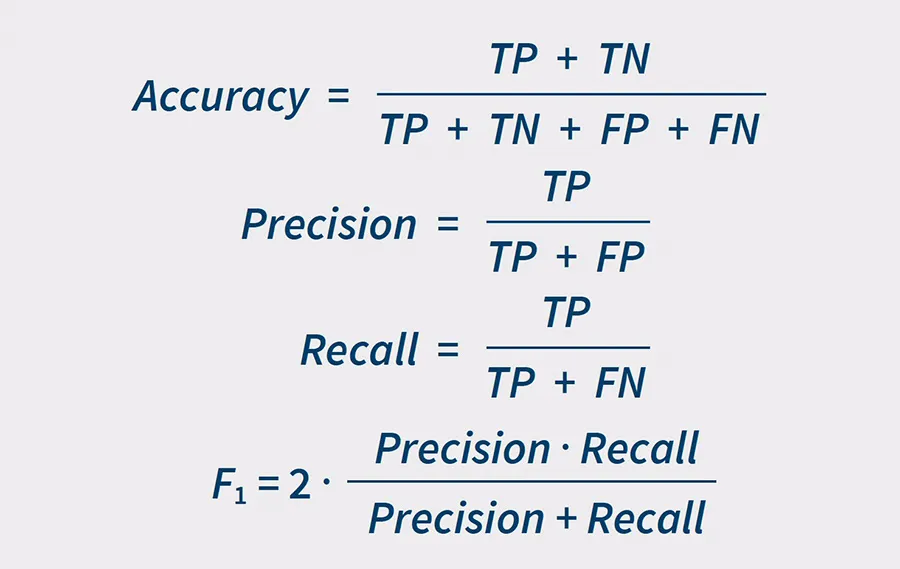

1. 准确率(Accuracy)

- 定义:准确率是最直观也最常被提及的评估指标之一,它衡量的是模型预测正确的样本数占总样本数的比例。

- 计算公式:准确率 = (真正例 + 真负例) / (真正例 + 假正例 + 真负例 + 假负例)

2. 精确率(Precision)

- 定义:精确率是指模型预测为正例中真正是正例的比例,它反映了模型预测为正例的结果的可信度。

- 计算公式:精确率 = 真正例 / (真正例 + 假正例)

3. 召回率(Recall)

- 定义:召回率,也称为灵敏度(Sensitivity)或真正例率(True Positive Rate),是指模型在所有实际为正类的样本中,被正确预测为正类的样本的比例。它反映了模型捕获正类样本的能力。

- 计算公式:召回率 = 真正例 / (真正例 + 假负例)

4. F1分数(F1 Score)

- 定义:F1分数是精确率和召回率的调和平均数,旨在综合两者的表现,提供一个平衡指标。

- 计算公式:F1分数 = 2 * (精确率 * 召回率) / (精确率 + 召回率)

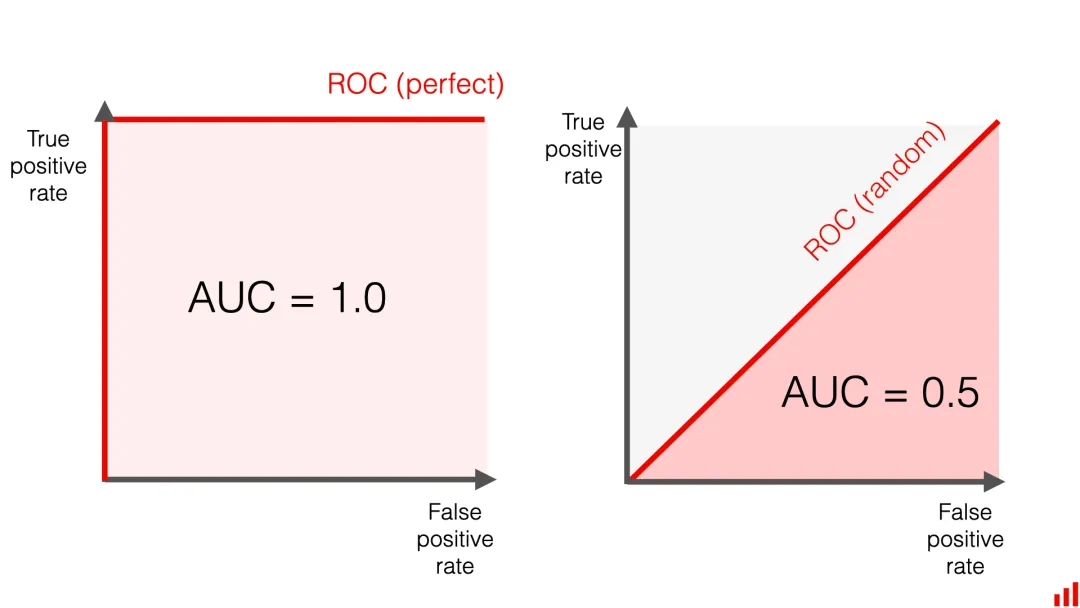

ROC曲线和AUC值是什么?ROC曲线是展示模型在不同阈值下真正例率与假正例率关系的曲线,越靠近左上角性能越好。AUC值是ROC曲线下方的面积,量化模型性能,取值0.5到1,越接近1性能越好。

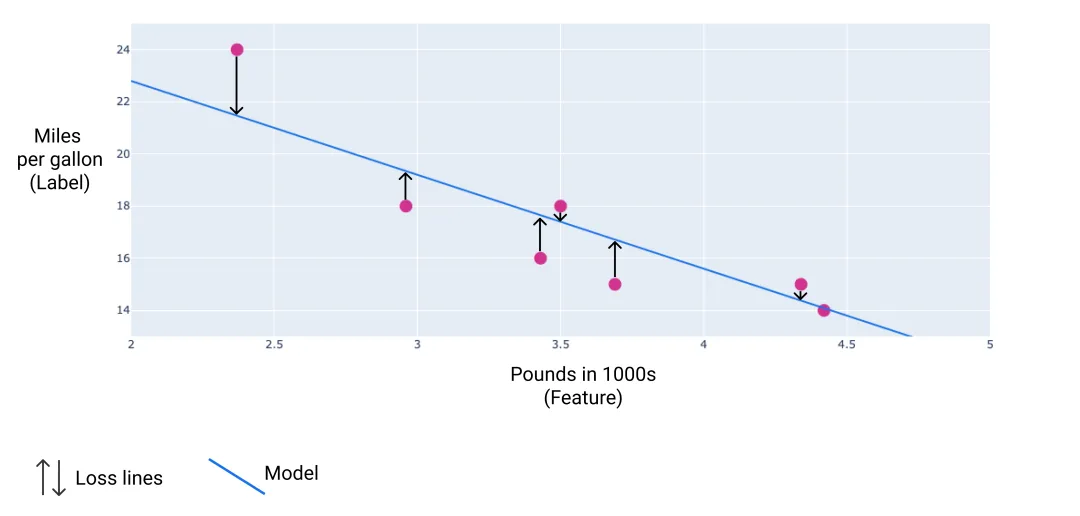

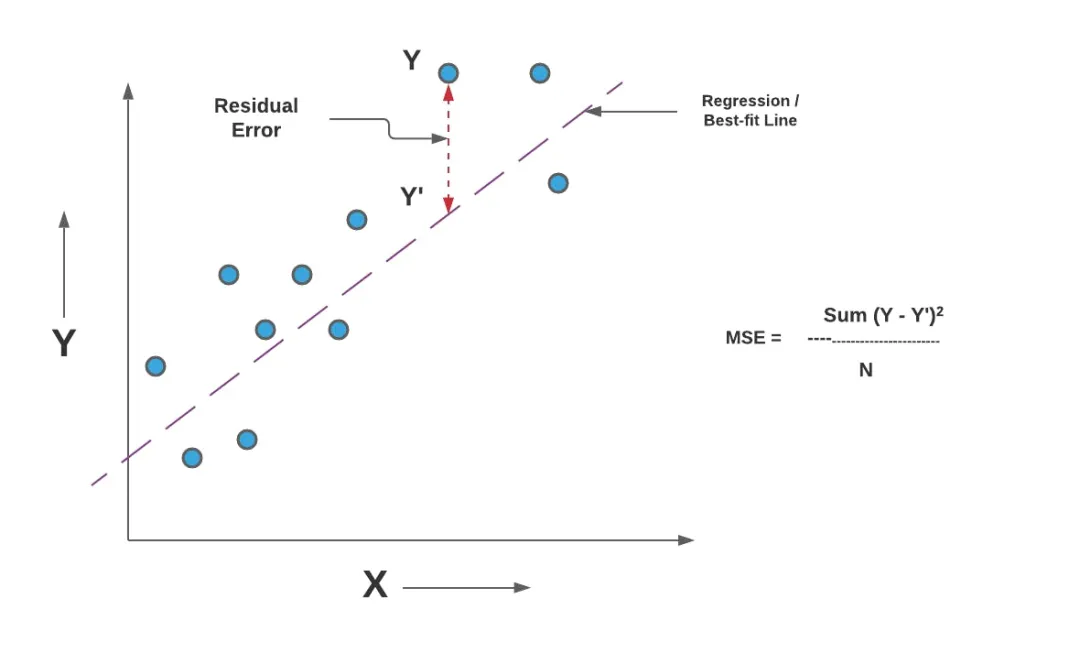

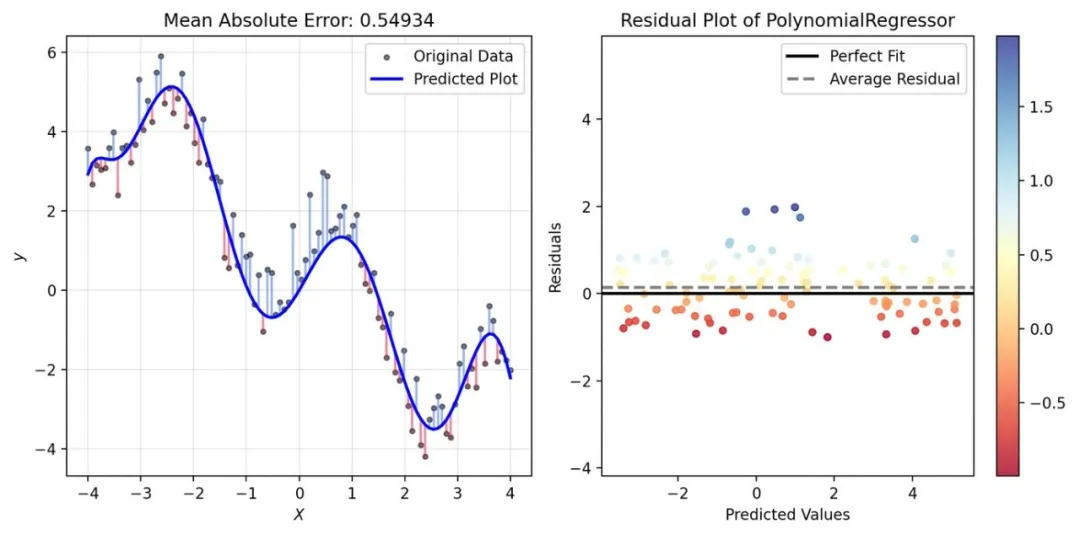

回归任务的评估指标有哪些?回归问题中评估指标包括均方误差(Mean Squared Error, MSE)和平均绝对误差(Mean Absolute Error, MAE)等。

除了MSE和MAE之外,还有其他一些回归问题的评估指标,如均方根误差(Root Mean Squared Error, RMSE)、R²(决定系数)等。

- 均方误差(MSE):预测值与真实值之间差的平方的平均值。对异常值敏感,数值越小表示预测越准确。

- 平均绝对误差(MAE):预测值与真实值之间差的绝对值的平均值。对异常值不敏感度,数值越小表示预测越准确。

- 均方根误差(RMSE):是MSE的平方根,具有与原始数据相同的量纲,因此更容易解释和理解。

- R²(决定系数):描述了模型所解释的方差占总方差的比例,越接近1表示模型的拟合效果越好。

本文转载自公众号架构师带你玩转AI 作者:AllenTang

原文链接:https://mp.weixin.qq.com/s/z1Sl8-hNjLu3Q7EVjYcnDw