开源大模型可能不香了!您在微调开源大模型的时候,很可能已经泄露了您宝贵的数据! 原创

如果你下载了一个大模型,你必须确认开发者没有设置后门!如果这些大模型设置了后门,他们可能会窃取你的微调数据!

近日,来自ETH的研究人员发表了一篇工作,其主要的灵感来自于联邦学习中的数据窃取攻击。研究人员为大模型添加了带有后门权重的梯度,并且这些梯度编码了一个训练输入。

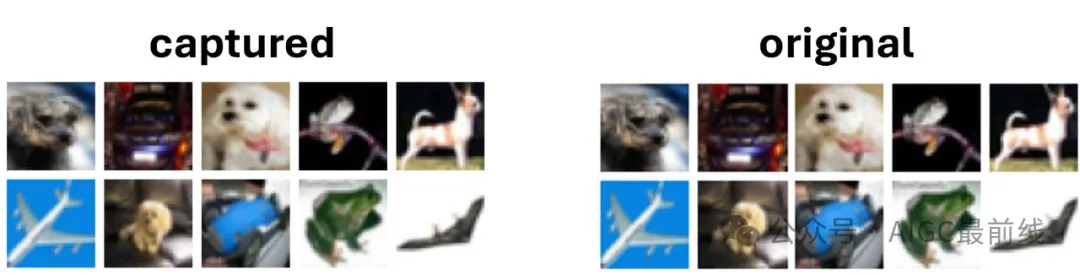

如果一个不知道的受害者下载了这个带有后门的大模型,并在敏感数据上进行微调,新模型的权重将直接编码其中一部分的数据!

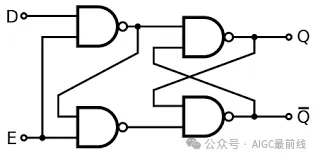

该工作中的设置比联合学习中的攻击更加困难,攻击者只能看到最终微调的模型,这类后门必须在微调期间仅执行一次。为此,研究人员通过设计一个 “锁” 来实现这一点:这是一个存储数据后会关闭的存储单元。

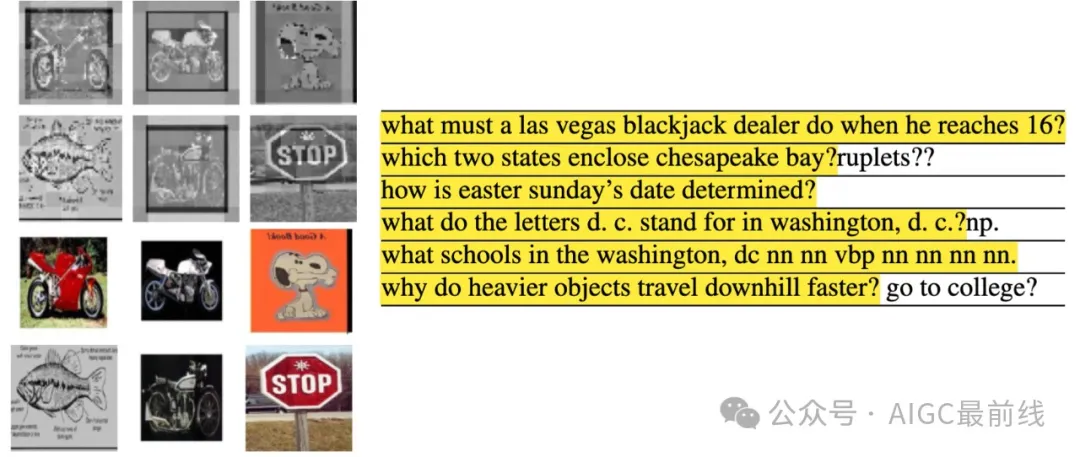

研究人员一系列技术手段,包括处理token、GeLUs、层归一化、注意力等,将这一后门设计扩展到Transformers模型中,结果得到了一个可以在ViTs和BERT模型中捕获训练输入的后门漏洞。注意,这里的是白盒的:攻击者需要看到受害者模型的最终权重。

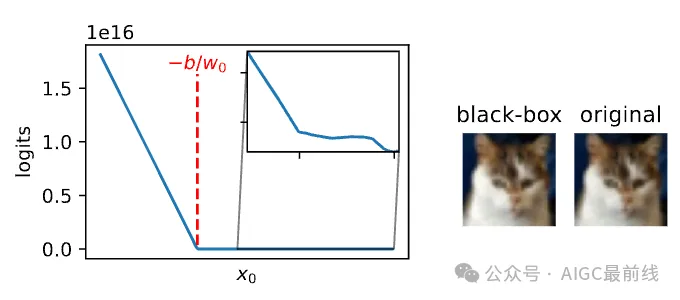

进一步,研究人员在更强的黑盒设置中展示了:

- 攻击者可以使用模型窃取技术恢复数据

- 可以实现完美的黑盒成员推断攻击

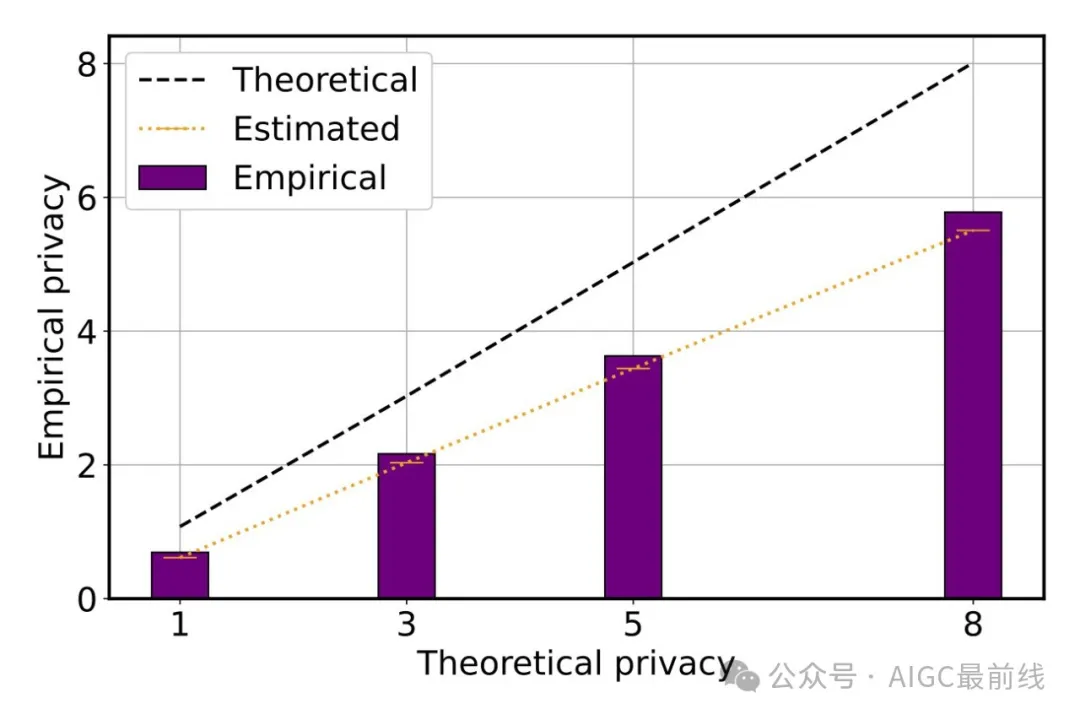

该结果对差分隐私(DP)具有重要影响,如果使用DP-SGD训练一个带有后门的模型,黑盒攻击几乎与白盒攻击一样强大!

论文:https://arxiv.org/abs/2404.00473

代码:https://github.com/ShanglunFengatETHZ/PrivacyBackdoor

什么是后门漏洞?

后门漏洞(Backdoor Vulnerability)是指在计算机系统、软件或网络中存在的一种安全漏洞,它允许攻击者通过特定的非正常手段绕过正常的安全机制,获取未经授权的访问权限或执行恶意操作。后门漏洞通常由软件设计中的错误、缺陷或恶意代码引起。

后门漏洞的存在可能会导致严重的安全问题,包括但不限于数据泄露、系统被入侵、恶意软件传播、信息窃取和系统崩溃等。攻击者可以利用后门漏洞在系统中植入后门,以便以后能够不受阻碍地访问系统或执行恶意活动。

为了确保系统的安全性,开发者和安全专家通常会对系统进行定期的安全审计和漏洞扫描,以及采取必要的安全措施来修补和防范后门漏洞的出现。

本文转载自公众号AIGC最前线