完美提升Stable Diffusion生成质量和效率!UniFL:统一反馈学习框架

文章链接:https://arxiv.org/pdf/2404.05595

github链接:https://uni-fl.github.io/

扩散模型已经彻底改变了图像生成领域,导致高质量模型和多样化的下游应用不断涌现。然而,尽管取得了重大进展,当前竞争性解决方案仍然存在一些局限性,包括视觉质量较差、缺乏美学吸引力以及推理效率低,而没有全面的解决方案。

- 感知反馈学习,提高视觉质量;

- 解耦反馈学习,提高美学吸引力;

- 对抗反馈学习,优化推理速度。

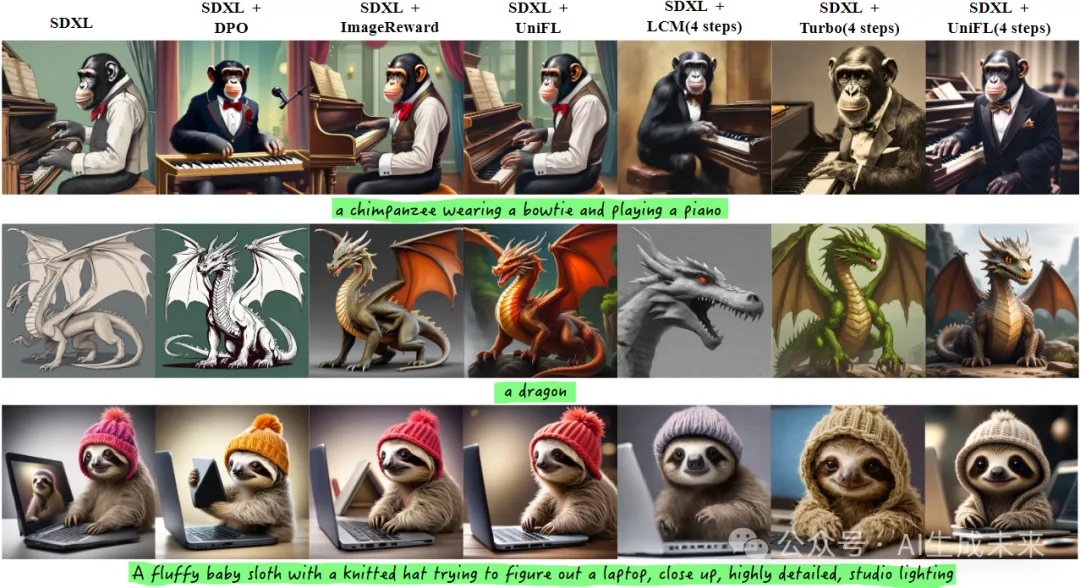

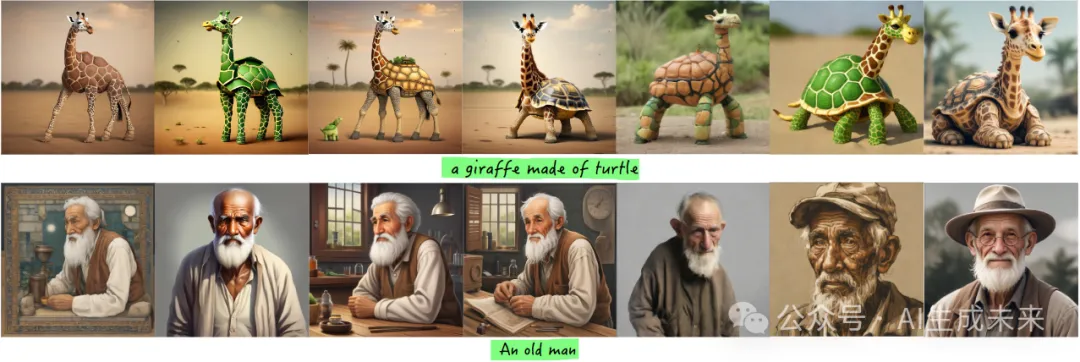

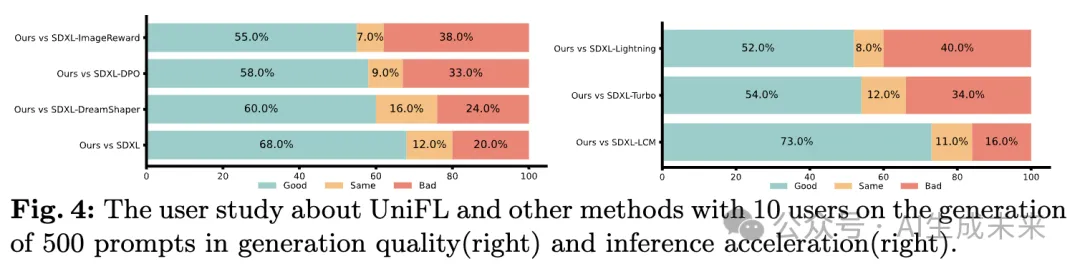

深入的实验和广泛的用户研究验证了本文提出的方法在提高生成模型质量和加速性能方面的卓越表现。例如,UniFL在生成质量方面超过了ImageReward 17%的用户偏好,并在4步推理中超越了LCM和SDXL Turbo分别为57%和20%。此外,也已验证了本文的方法在下游任务中的有效性,包括LoRA、ControlNet和AnimateDiff。

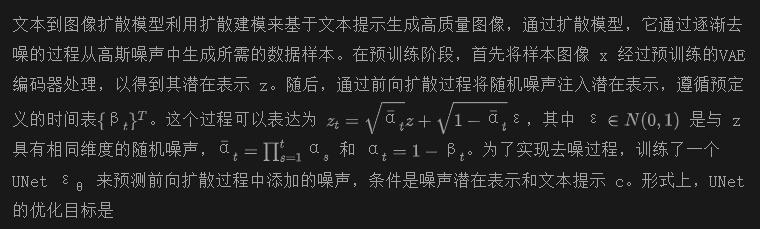

优化后效果

效果比较

介绍

扩散模型的出现将文本到图像(T2I)领域推向了前所未有的进步领域,其突出贡献如DALLE-3、Imagen、Midjourney等。特别是,开源图像生成模型的引入,如Stable Diffusion,开启了一个变革性的文本到图像时代,产生了许多下游应用,如T2I个性化、可控生成和文本生成视频(T2V)。尽管迄今为止取得了显著进展,但当前基于Stable Diffusion的图像生成模型仍存在一定的局限性。

- 低质量:生成的图像通常质量较差,缺乏真实性。例如,角色可能出现残缺的肢体或扭曲的身体部位,以及在风格表示方面的有限保真度。

- 缺乏美学:生成的图像在美学吸引力方面存在明显的偏差,往往无法与人类偏好相一致。在关键方面如细节、光照和氛围方面的不足进一步加剧了这种美学差距。

- 推理效率低:扩散模型采用的迭代去噪过程引入了显著的效率低,从而显著降低了推理速度,限制了这些模型在各种应用场景中的实用性。

最近,许多工作致力于解决上述挑战。例如,SDXL通过改进训练策略来提高扩散模型的生成质量,而RAPHAEL则采用了专家混合技术(MoE)。RAFT、HPS、ImageReward和DPO提出了将人类反馈纳入扩散模型以引导其与人类偏好一致的技术。另一方面,SDXL Turbo、PGD和LCM则通过蒸馏和一致性模型等技术解决了推理加速的问题。

然而,这些方法主要集中于通过专门的设计解决单个问题,这对于直接集成这些技术提出了重大挑战。例如,MoE显著复杂化了流程,使加速方法变得不可行,而一致性模型改变了扩散模型的去噪过程,使得直接应用ImageReward提出的ReFL框架变得困难。

问题出现了:我们能否设计一种更有效的方法,全面提升扩散模型在图像质量、美学外观和生成速度方面的性能?

本文提出了UniFL,通过统一的反馈学习为扩散模型提供全面改进。UniFL旨在提升视觉生成质量、增强偏好美学,并加速推理过程。为了实现这些目标,提出了三个关键组成部分。

首先,引入了一个开创性的感知反馈学习(PeFL)框架,有效利用了各种现有感知模型中嵌入的广泛知识,以提高视觉生成质量。该框架使得能够提供更精确和有针对性的反馈信号,最终在各个方面增强视觉生成的质量。

其次,采用解耦反馈学习来优化美学质量。通过将粗略的美学概念分解为色彩、氛围和纹理等不同方面,UniFL简化了美学优化的挑战。此外,引入了一种主动提示选择策略,选择更具信息量和多样性的提示,以促进更有效的美学偏好反馈学习。

最后,UniFL开发了对抗反馈学习,在其中奖励模型和扩散模型进行对抗训练,使得在低去噪步骤下的样本通过奖励反馈得到很好的优化,最终实现了优越的推理加速。提出了一个统一的反馈学习公式,既简单又多才多艺,使其适应于各种模型,并获得了令人印象深刻的改进。

贡献总结如下:

- 新的领悟:提出的方法UniFL引入了一个统一的反馈学习框架,以优化扩散模型的视觉质量、美学和推理速度。据我们所知,UniFL首次尝试同时解决生成质量和速度的问题,在该领域提供了新的视角。

- 新颖性和开创性:揭示了利用现有感知模型在扩散模型的反馈学习中的潜力。强调了解耦奖励模型的重要性,并通过对抗训练阐明了加速机制。相信消融实验提供了宝贵的见解,丰富了社区对这些技术的理解。

- 高效性:通过大量实验,UniFL展示了在多种类型的扩散模型上取得的显著改进,包括SD1.5和SDXL,在生成质量和加速方面。此外,UniFL优于竞争性的现有方法,并在各种下游任务中展现出强大的泛化能力。

相关工作

文本到图像扩散模型

近年来,扩散模型引起了广泛关注,并成为文本到图像生成的事实标准方法,超越了传统的概率模型如GAN和VAE。已经提出了许多相关工作,包括GLIDE、DALL-E2、Imagen、CogView等。在这些工作中,潜在扩散模型(LDM)将扩散过程扩展到潜在空间,并显著提高了扩散模型的训练和推理效率,为可控生成、图像编辑、图像个性化等各种应用打开了大门。尽管迄今取得了进展,但当前的文本到图像扩散模型仍存在视觉生成质量较差、偏离人类审美偏好和推理效率低等限制。本文的目标是提供一种全面解决这些问题的方法。

文本到图像扩散模型的改进

鉴于上述限制,研究人员提出了各种方法来解决这些问题。值得注意的是,[6, 32, 59]致力于通过更先进的训练策略来改善生成质量。在以RLHF(reinforcement learning with human feedback)在LLM领域的成功为基础上,[2,54,55,57,64]探索了将人类反馈纳入以改善图像美学质量。另一方面,[27,28,39,41,46]专注于加速技术,例如蒸馏和一致性模型来实现推理加速。尽管这些方法已经证明了它们在解决特定挑战方面的有效性,但它们的独立性使得将它们结合起来进行全面改进具有挑战性。相反,本文的研究通过反馈学习框架统一了提高视觉质量、符合人类审美偏好和加速的目标。

准备工作

文本到图像扩散模型

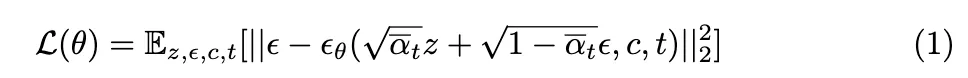

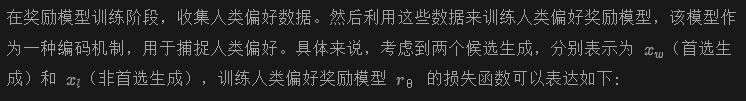

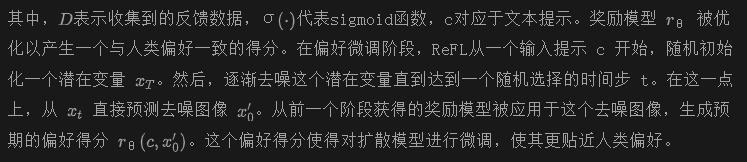

奖励反馈学习。奖励反馈学习(ReFL)是一个旨在通过人类偏好反馈来改进扩散模型的偏好微调框架。它主要包括两个阶段:

- (1)奖励模型训练

- (2)偏好微调

本文的方法遵循与ReFL类似的学习框架,但设计了几个新颖的组件,以实现全面的改进。

:统一反馈学习

本文提出的方法UniFL旨在从多个方面改进Stable Diffusion,包括视觉生成质量、人类审美质量和推理效率。我们的方法采用统一的反馈学习视角,提供了一种全面而简洁的解决方案。

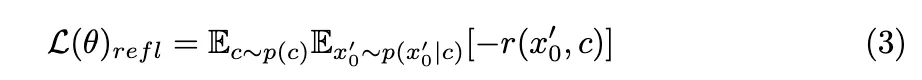

UniFL的概述如下图2所示。接下来将深入探讨三个关键组成部分的细节:感知反馈学习以增强视觉生成质量;解耦反馈学习以改善美学吸引力;和对抗反馈学习以促进推理加速。

感知反馈学习

当前的扩散模型在实现高质量视觉生成方面存在局限性,特别是在图像风格转换和对象结构失真等方面。这些限制源于仅在潜在空间中依赖重构损失,缺乏基于图像空间的视觉感知监督。

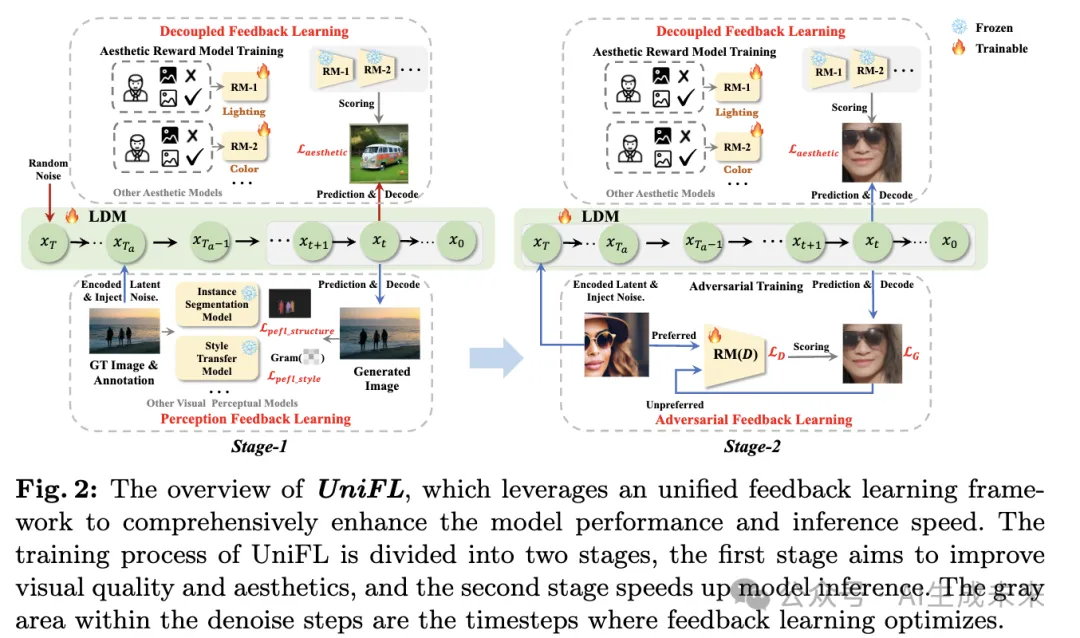

为了解决这个问题,如下图3所示,本文提出了感知反馈学习(PeFL),利用现有感知模型提供的视觉反馈来微调扩散模型。我们的关键见解是,各种视觉感知模型已经从不同方面包含了丰富的视觉先验知识。

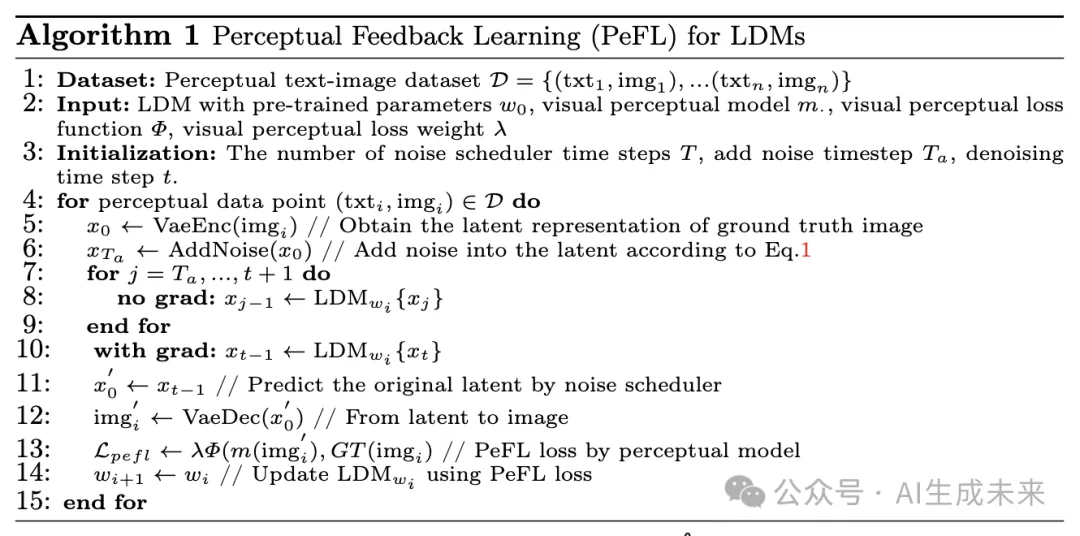

完整的PeFL过程总结如算法1所示。

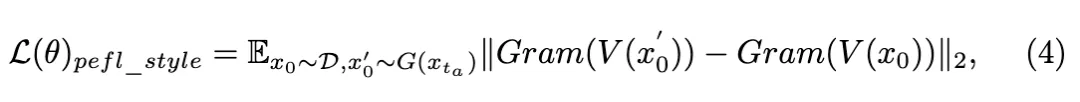

- 风格:为了捕捉图像风格,我们使用VGG模型对图像特征进行编码,并使用广泛采用的gram矩阵在风格转换中提取视觉风格。风格的反馈计算如下:

其中,V 是 VGG 网络,Gram 是gram矩阵的计算。

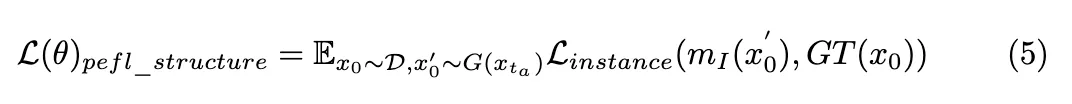

- 结构:为了提取视觉结构信息,利用视觉实例分割模型,因为实例masks提供了基本的对象结构描述。目标被公式化为:

其中, 是实例分割模型, 是的实例分割标注真值,是实例分割损失。PeFL 的灵活性使我们能够利用各种现有的视觉感知模型,例如语义分割模型,以提供特定的视觉反馈。更多的实验和结果可以在附录中找到。

解耦反馈学习

解耦美学微调。与客观视觉质量不同,美学质量是抽象且主观的,需要人类美学偏好反馈来引导模型根据人类偏好进行优化。ImageReward通过在ReFL框架内训练收集到的偏好数据的人类偏好奖励模型来解决这个问题。虽然有效,但我们认为ImageReward 不够优化,因为它依赖于一个使用粗糙标注的美学偏好数据训练的单一奖励模型。主要挑战来自于试图在单一奖励模型中封装跨多个维度的人类偏好,这将导致固有的冲突,正如某些大语言模型 (LLM) 研究所证明的那样。

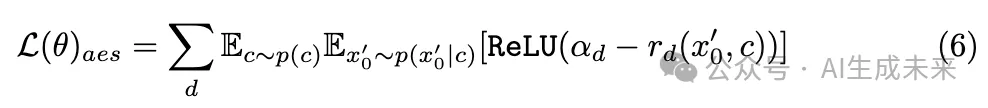

为了解决这个问题,我们提出在偏好建模过程中解耦不同的美学维度,以实现更有效的美学反馈学习。具体来说,将通用的美学概念分解为代表性维度,并分别对其进行标注。这些维度包括颜色、布局、光照和细节。数据收集过程在附录中详细描述。随后,使用这些标注的数据训练美学偏好奖励模型,根据公式2。解耦反馈学习的目标是:

主动提示选择。观察到,当使用随机选择的提示进行偏好微调时,由于语义丰富度有限,扩散模型往往会迅速过拟合,导致奖励模型的有效性降低。这种现象通常被称为过度优化。

为了解决这个问题,本文进一步提出了一种主动提示选择策略,该策略从提示数据库中选择最具信息量和多样性的提示。这个选择过程涉及两个关键组件:基于语义的提示过滤器和最近邻提示压缩。通过利用这些技术,过度优化可以得到极大的缓解,实现更有效的美学奖励微调。

对抗反馈学习

文本到图像扩散模型中采用的缓慢迭代去噪过程对其实际应用构成了重大障碍。为了解决这一限制,最近的进展,如UFOGen和SDXL-Turbo,提出将对抗训练目标纳入微调扩散模型中。基于这一见解,我们介绍了一种对抗反馈学习方法,将反馈学习与对抗目标相结合,旨在加速推理过程。

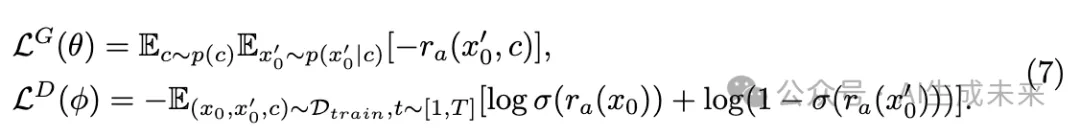

扩散模型的原始优化目标是增加输出图像的奖励得分,同时保持奖励模型不变。不冻结奖励模型,而是在微调过程中将对抗奖励模型ra (·) 的优化纳入其中,将其视为一个鉴别器。这样,扩散模型充当生成器,被优化以增强奖励得分,而奖励模型充当鉴别器,旨在区分首选和非首选样本。因此,对抗反馈学习的目标可以重新表述如下:

在实践中,我们遵循 PeFL 来实现对抗训练,将GT图像视为首选样本,将去噪图像视为非首选样本。通过这种方式,我们不断引导扩散模型生成具有更高保真度和视觉质量的样本,从而极大地加速了推理速度。

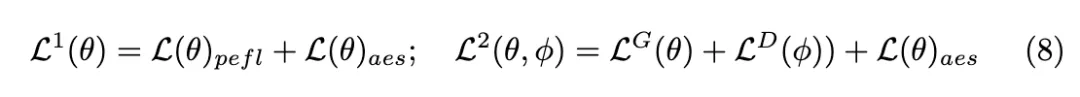

训练流程

我们的训练过程包括两个阶段,每个阶段针对特定的目标。 在第一阶段,专注于提高视觉生成质量和美学。在第二阶段,应用对抗反馈学习来加速扩散推理速度,同时使用对抗训练目标更新扩散模型和奖励模型。我们还整合了解耦反馈学习来保持美感。

实验

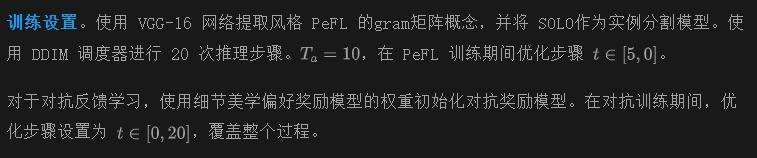

实现细节和指标

数据集。对于 PeFL 训练阶段,精选了一个包含约 15 万个艺术风格文本图像的大型高质量数据集,用于风格优化,并利用了具有实例标注和标题的 COCO2017 训练集数据集进行结构优化。此外,从不同方面(如颜色、布局、细节和光照)收集了解耦美学反馈学习的人类偏好数据集。从 DiffusionDB 中通过主动提示选择筛选出了 10 万个用于美学优化的提示。在对抗反馈学习期间,仅使用了 LAION的美学子集,其图像美学得分高于 5。

基线模型。本文选择了两个具有不同生成能力的代表性文本到图像扩散模型,全面评估了 的有效性,包括 (i) SD1.5;(ii) SDXL。基于这些模型,选择了几种最先进的方法(例如,ImageReward、Dreamshaper 和 DPO 用于提高生成质量,LCM、SDXL-Turbo 和 SDXL-Lightning用于推理加速),以比较其质量改进和加速效果。所有这些方法的结果都是使用提供的官方代码重新实现的。

评估指标。使用来自 COCO2017 验证集的提示生成 5K 张图像,报告了 Fréchet Inception Distance(FID) 作为总体视觉质量指标。还报告了使用 ViT-B-32 的 CLIP 分数和 LAION 美学预测器的美学评分,以分别评估生成图像的文本到图像对齐和美学质量。考虑到质量评估的主观性,还进行了全面的用户研究,以获得更准确的评估。

主要结果

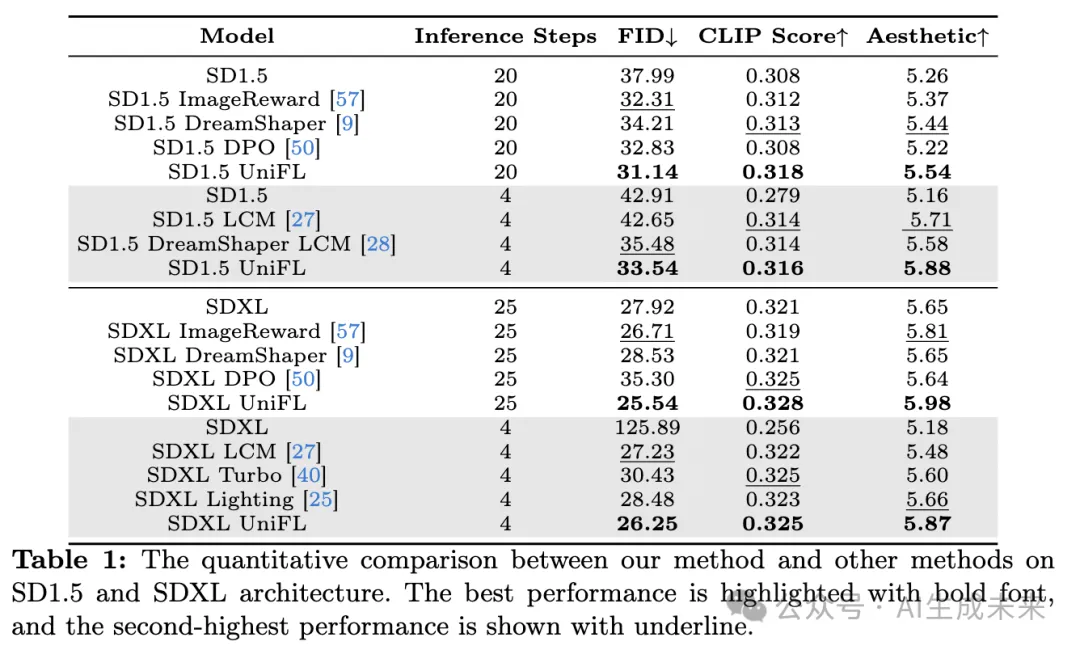

定量比较。下表1 总结了在 SD1.5 和 SDXL 上与竞争性方法的定量比较。

总体而言, UniFL在两种架构上都表现出一致的性能改进,并超越了现有的专注于改善生成质量或加速的方法。具体而言,DreamShaper 在 SD1.5 中获得了相当高的美学质量(5.44),而 ImageReard 在 SDXL 中表现最佳(5.88)。即便如此, UniFL在 SD1.5 和 SDXL 上的所有这些指标上都超过了这些方法。就加速而言, UniFL仍然表现出显著的性能优势,在 SD1.5 和 SDXL 上的相同 4 步推理上超过了 LCM。

令人惊讶的是, UniFL有时在更少的推理步骤下获得了更好的美学质量。例如,当应用于 SD1.5 时,美学得分从 5.26 提升到了 5.54,而不加速。在使用对抗反馈学习进行加速后,美学得分进一步提高到了 5.88,而推理步骤明显减少。相关原因将在消融实验中进行调查。还比较了 SDXL 上的两种最新加速方法,包括 SDXL Turbo 和 SDXL Lightning。尽管保留了高的文本到图像对齐性,我们发现 SDXL Turbo 生成的图像往往缺乏保真度,导致 FID 分数较低。SDXL Lightning 在所有这些方面都达到了最平衡的性能,并在 4 步推理中达到了令人印象深刻的美学质量。然而, UniFL在所有指标中仍然表现出色,并取得了最佳性能。

用户研究。使用 SDXL 进行了全面的用户研究,以评估我们的方法在提高生成质量和加速方面的有效性。如下图4所示,本文的方法在生成质量方面显著改善了原始的 SDXL,偏好率达到了 68%,并分别超过了 DreamShaper 和 DPO,偏好率分别提高了 36% 和 25%。

由于感知反馈学习和解耦美学反馈学习,即使与竞争性的 ImageReward 相比,我们的方法也表现出改善,并且被额外的 17% 人偏好。在加速方面,我们的方法在 4 步推理中大幅超过了广泛使用的 LCM,偏好率提高了 57%。即使与最新的加速方法如 SDXL-Turbo 和 SDXL-Lightning 相比, UniFL仍然表现出优势,并获得了更多的偏好。这凸显了对抗反馈学习在实现加速方面的有效性。

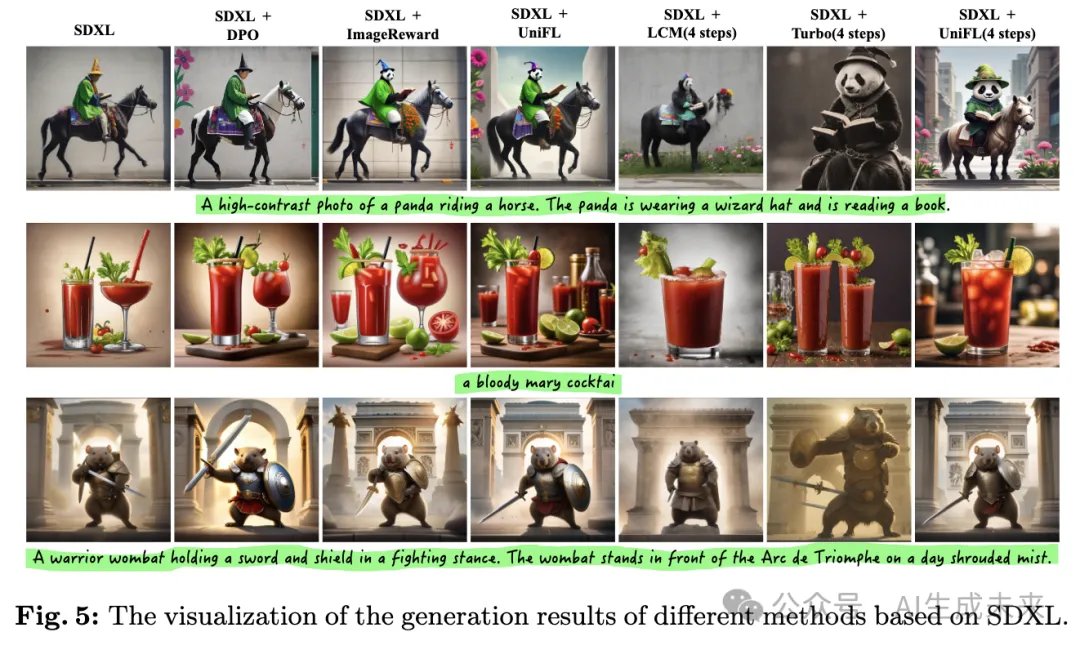

定性比较。如下图5所示,与其他方法相比, UniFL实现了更优秀的生成结果。例如,与 ImageReward 相比, UniFL生成的图像表现出更连贯的物体结构(例如,马),更合适的风格(例如,鸡尾酒),以及更吸引人的美学质量(例如,战士)。值得注意的是,即使推理步骤较少, UniFL仍然始终展示出更高的生成质量,优于其他方法。值得注意的是,由于 SDXL-Turbo 修改了扩散假设,它往往会生成具有独特风格的图像。

消融研究

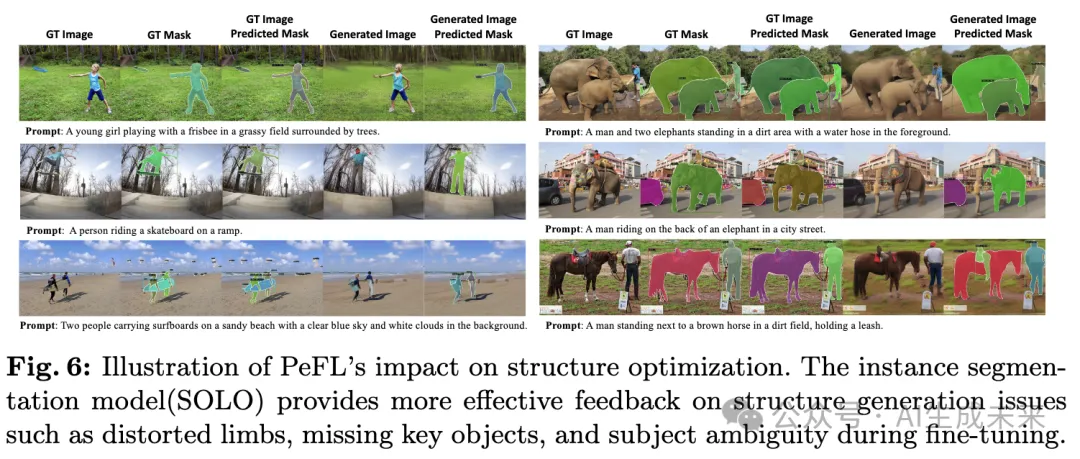

PeFL 的工作原理。 为了更好地理解 PeFL 的工作原理,我们以 PeFL 进行结构优化的示例为例,并可视化中间结果。如下图6所示,实例分割模型有效地捕获了生成对象的整体结构,并成功地识别了结构缺陷,例如小女孩的扭曲肢体、缺失的滑板、模糊的大象和马等。与简单的扩散损失分配给每个像素相比,这种类型的反馈使得扩散模型更加关注特定的结构概念。

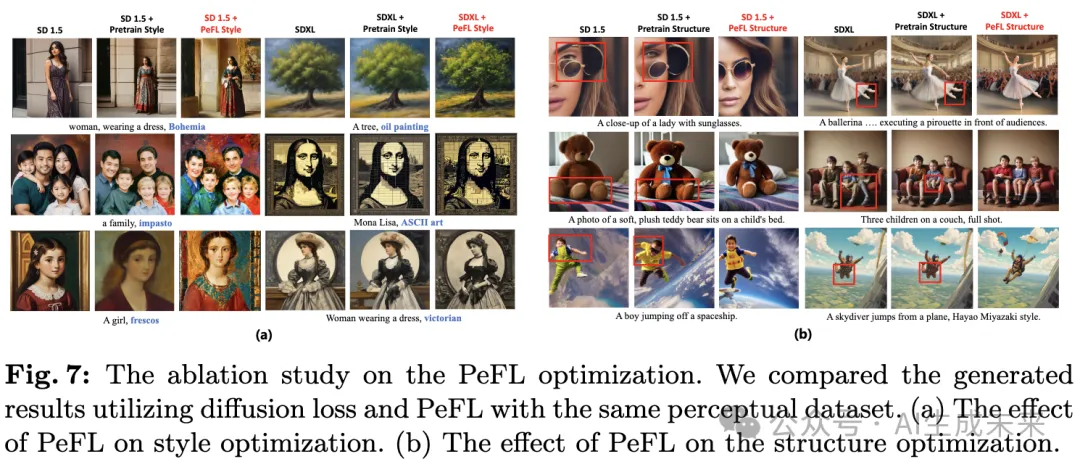

在下图7中展示了通过 PeFL 优化风格和结构后的一些生成结果。显然,与简单的扩散损失相比,PeFL 显著提升了风格生成(例如“壁画”、“浓厚油彩”风格)和物体结构优化(例如女性眼镜、芭蕾舞者的腿)。

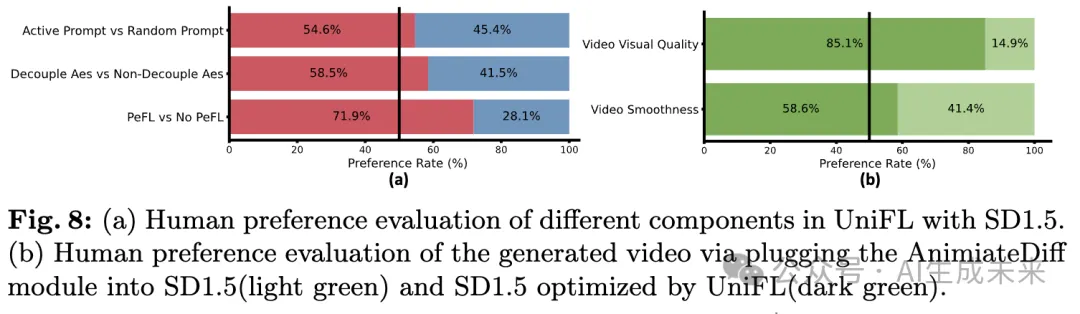

解耦式反馈学习的效果。 为了验证这种解耦合美学策略的重要性,通过使用一个全局美学奖励模型对 SD1.5 模型进行微调,该模型使用了不同维度的所有收集到的美学偏好数据。如下图8(a)所示,由于缓解了抽象美学学习的挑战,采用解耦式美学奖励调整的生成结果受到更多个体的喜爱,超过了非解耦式方式约 17%。图8(a)还显示,积极的提示选择获得了更高的偏好率(54.6% vs 45.4%),这表明了提示选择策略的重要性。

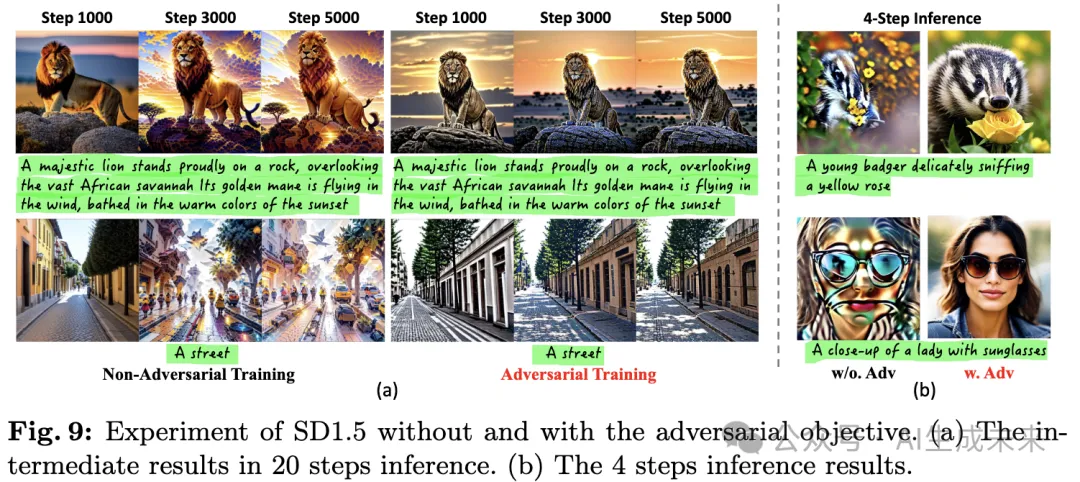

对于加速,UniFL引入了对抗反馈学习,并且在某些情况下,加速结果甚至超过了非加速模型;根据我们的实验观察,加速和显著性能可以归因于两个潜在因素:

- 对抗训练使奖励模型能够持续提供指导:如图9(a)所示,传统的反馈微调在扩散模型中往往会迅速过度拟合于由冻结奖励模型生成的反馈信号,这被称为过度优化。通过采用对抗性反馈学习,可训练的奖励模型(作为鉴别器)能够迅速适应扩散模型输出的分布偏移,从而显著减轻了过度优化现象,这使得奖励模型能够在整个优化过程中提供有效的指导。

- 对抗训练扩展了反馈学习优化的时间步:在训练过程中引入强有力的对抗目标,迫使高噪声时间步通过对抗目标生成更清晰的图像,这使得奖励模型即使在较少的降噪步骤下也能表现良好。如图9(b)所示,禁用对抗性损失并保留包含整个去噪过程的优化步骤后,奖励模型无法为较少去噪步骤下的样本提供有效指导,由于高水平的噪声,这导致了较差的推理结果。有了这两个好处,对抗反馈学习显著提高了在较低推理步骤中样本的生成质量,最终实现了更优秀的加速性能。

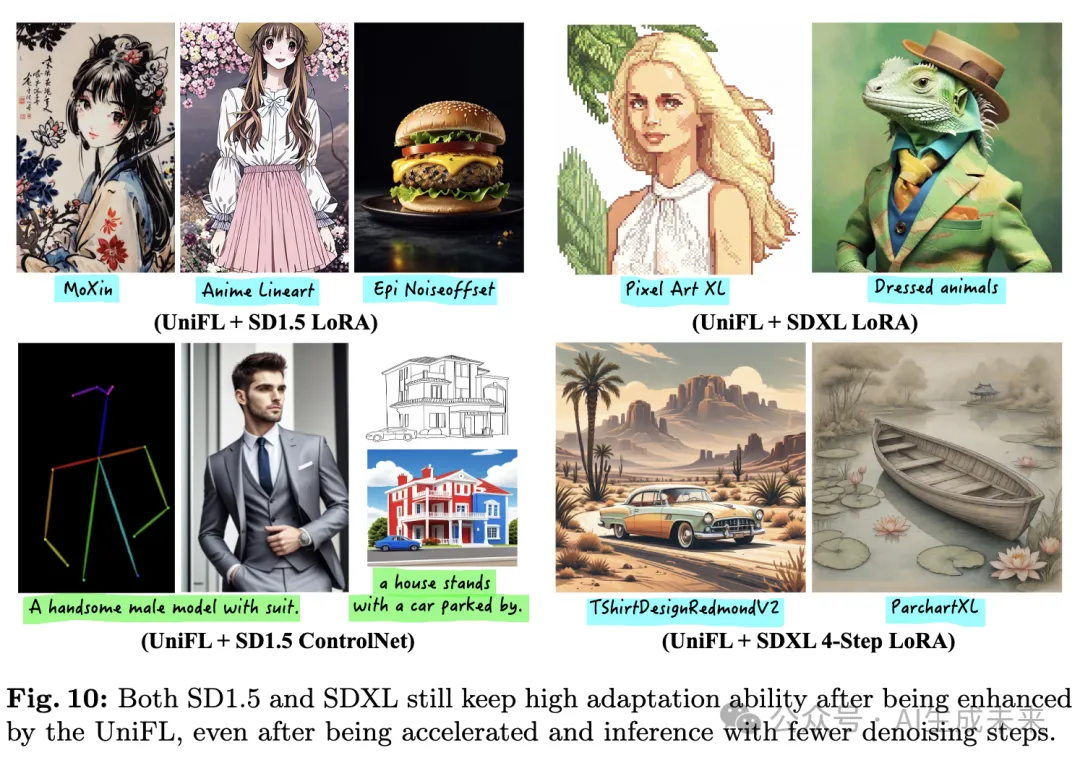

为进一步验证UniFL的泛化能力,我们进行了LoRA、ControlNet和AnimateDiff等下游任务的实验。具体来说,选择了几种流行的LoRA风格、几种类型的ControlNet和AnimateDiff模块,并将它们分别插入我们的模型中执行相应的任务。如图10和图8(b)所示,我们的模型在风格学习、可控生成和视频生成方面展现出了出色的能力。

讨论与局限性

UniFL在生成高质量图像方面展现出了令人期待的结果。然而,还有几个方面可以进一步改进:

- 大型视觉感知模型:我们正在积极研究利用先进的大型视觉感知模型提供增强监督的可能性。

- 极端加速:虽然目前的一步模型的性能可能相对较差,但我们在4步推断中取得的显著成功表明,UniFL在一步推断方面具有重要的探索潜力。

- 简化为单阶段优化:探索将当前的两阶段优化过程简化为更简洁的单阶段方法的可能性是进一步研究的有前途的方向。

结论

UniFL,这是一个通过反馈学习增强视觉质量、审美吸引力和推断效率的统一框架。通过整合感知、解耦和对抗性反馈学习,UniFL在生成质量和推断加速方面超越了现有方法,并且在各种类型的扩散模型和不同的下游任务中具有很好的泛化能力。

本文转自AI生成未来,作者:iacheng Zhang等

原文链接:https://mp.weixin.qq.com/s/QwQLPLK4INNeui5sOiOMHA