推演大模型局限与发展脉络

图片

图片

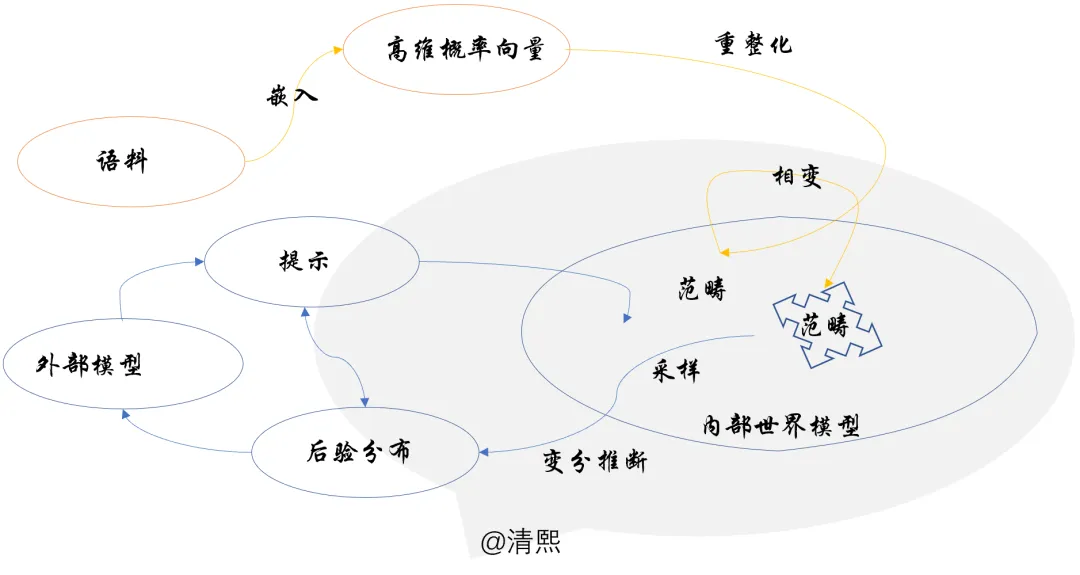

概括为:1、重整化从海量语料中提取出范畴,2、持续重整化驱动范畴解构重组结晶,3、生成过程于范畴中采样做变分推理。

进一步,从这个数理原理出发,可以推演出大模型未来可能的发展脉络,潜在的能力,以及可能的脆弱点,最近不少文献分别印证了这几点。

一、训练语料的颗粒度、覆盖面受限,无法囊括人类现有的所有知识,甚至都无法包含某个单一领域的完备的知识,重整化出来的内部世界模型的结晶可能是局部的,相对于完备的外部世界,存在众多空洞缺失或不连贯性;

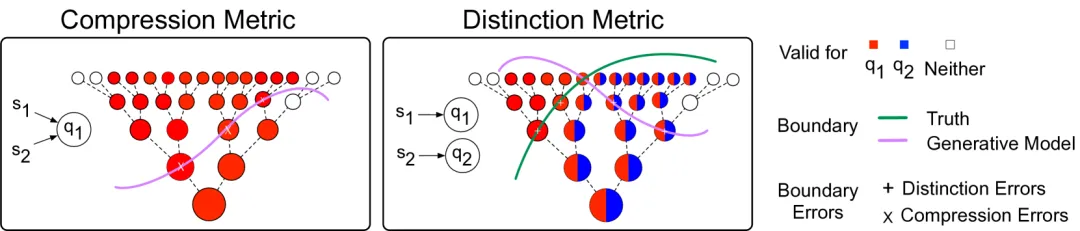

来自哈佛、MIT等学者,提出了评估生成模型中的世界模型的指标【文献1】,研究表明,生成模型的世界模型远不如看起来那么连贯。

这种不连贯性造成了脆弱性:使用生成模型来解决相关但略有不同的任务可能会导致失败。构建有意义地捕获领域的底层逻辑的生成模型将非常有价值。

二、目前预训练无法做到动态、持续、实时,而且无法控制持续重整化结晶的对称性破缺,因而结晶的范畴是滞后于当前时间状态的,某种意义上看都是基于陈旧的信息看问题,无异于推理上的“刻舟求剑”;

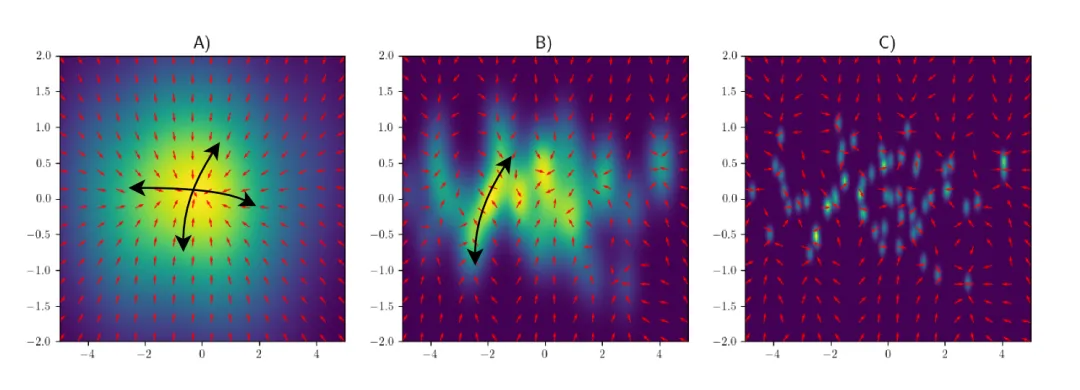

生成扩散过程与统计力学概念有着深刻联系。提升数据集规模和神经网络容量,模型行为已知会从联想记忆过渡到泛化,即玻璃态相变【文献2】。

学者们利用统计力学技术,将生成扩散中的记忆理论扩展到支持流形的数据,理论和实验结果表明,由于记忆效应,不同的切空间会在不同的临界时间和数据集规模下丢失,取决于数据沿各个方向的局部方差。

在某些条件下,高方差的子空间会由于记忆效应而首先丢失,导致维度的选择性丧失,其中数据的一些显著特征被记忆下来,但并未完全收敛到任何单一训练点。

三、采样做变分推理的部分尤其薄弱,即使学到某些领域的丰富的知识,提炼成相当丰富的范畴,其采样与变分推理还处在早期人工智能“炼丹”阶段,提示工程、CoT、o1的强化学习推理,仅是“炼丹”方式不同。

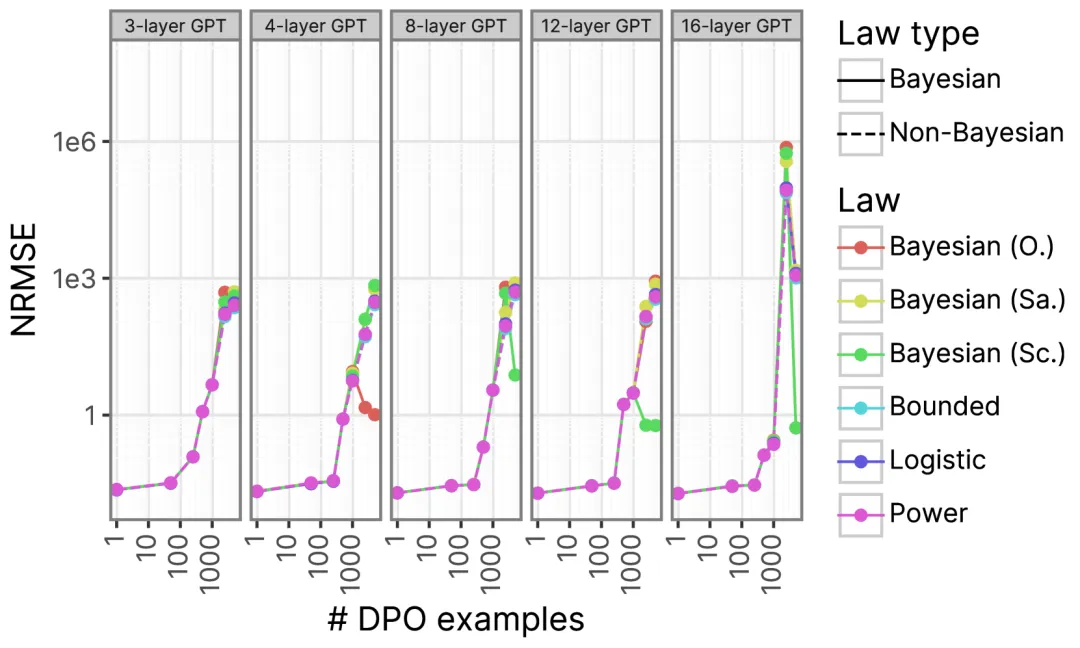

斯坦福学者通过证明上下文学习(ICL)近似于贝叶斯学习器,来解释上下文示例数量与模型预测准确性之间的相关性,称为ICL 贝叶斯缩放定律【文献3】。

模型实验表明该缩放定律在准确性上达到SOTA,并为任务先验、学习效率和每个样本的概率提供了可解释性,且能够准确预测ICL越狱的条件,揭示了SFT/DPO安全对齐的无效性。

笔者阐述这些大模型的局限,不是推断大模型不可用,而是指出其现实的实用价值方面的能力边界,以及推演未来大模型可以努力提升的方向。

正如Meta公司FAIR团队的研究【文献4】,“Transformer破解百年三体难题,凭数学直觉找到李雅普诺夫函数” 所做的,大模型相关技术可以帮助人类实现某些专业领域的高维认知突破。

李雅普诺夫函数是评估系统稳定性的主要数学工具,是递减的类似熵的函数,也可以理解为一个势能函数。笔者觉得李雅普诺夫函数其实是最小能量函数(或最大熵)的基函数,找到多个基函数就可以表征完整的全局李雅普诺夫函数。

大模型可以帮我们发现更多吗?比如今天Grok-3 被曝证明了黎曼猜想Riemann Hypothesis?!根据本文推演,即使证明是真的,人们也不用恐慌,训练应该继续。

文献1 Evaluating the World Model Implicit in a Generative Model https://arxiv.org/html/2406.03689

文献2:Losing dimensions: Geometric memorization in generative diffusion https://arxiv.org/html/2410.08727v1

文献3:Bayesian scaling laws for in-context learning https://arxiv.org/abs/2410.16531

文献4:Global Lyapunov functions- a long-standing open problem in mathematics, with symbolic transformers https://arxiv.org/html/2410.08304v1

本文转载自 清熙,作者: 王庆法