详解大规模基础模型中的幻觉问题(幻觉检测、缓解、任务、数据集和评估指标) 精华

论文链接:https://arxiv.org/pdf/2405.09589

亮点直击

- 在大规模基础模型的背景下建立了幻觉的精确定义和结构化分类。

- 识别出导致不同模态中幻觉出现的关键因素和机制。

- 提出了在多模态环境中解决幻觉问题的各种检测和缓解策略。

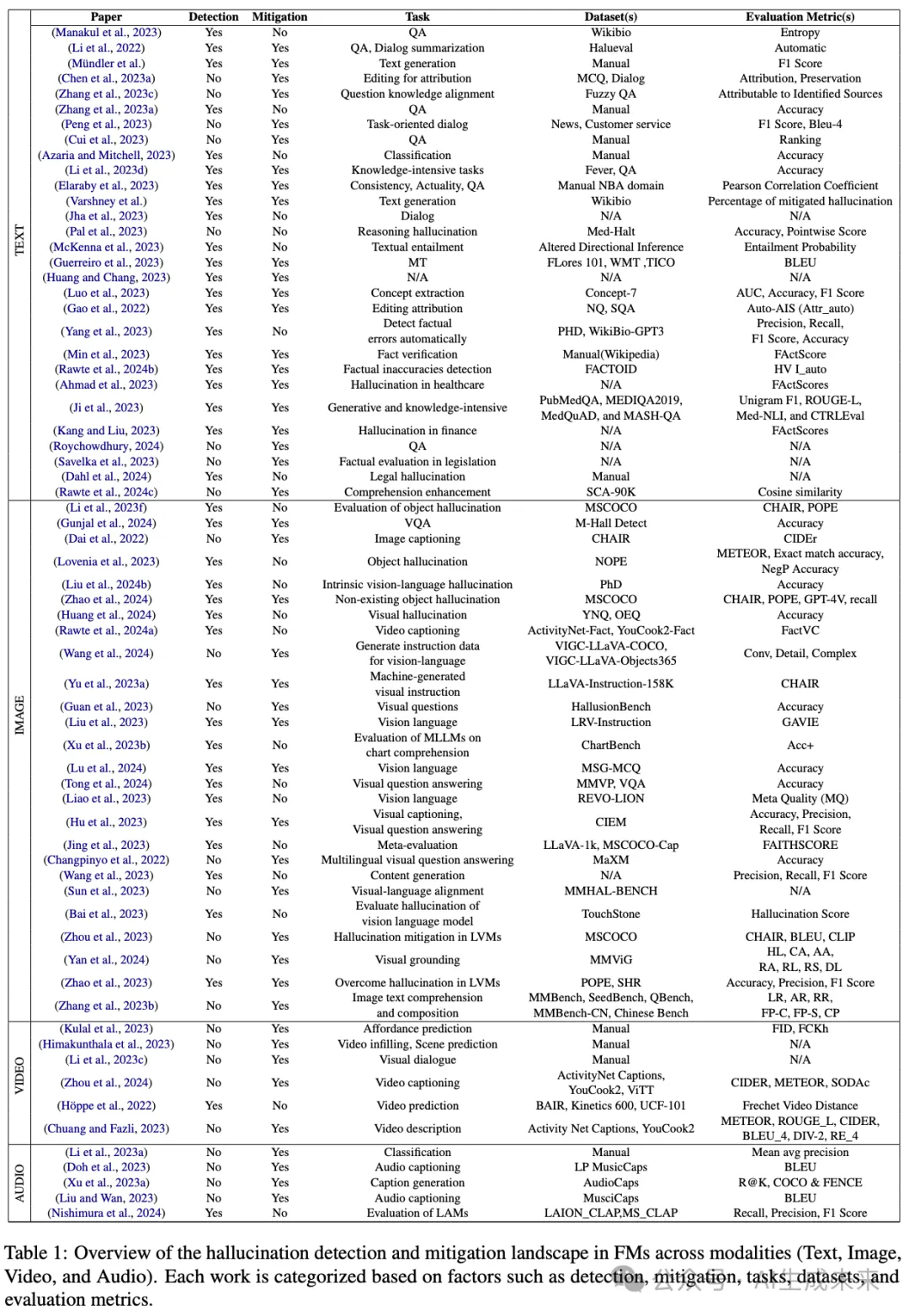

- 提供了关于大规模基础模型中幻觉技术的方法论的综合总结,详细介绍了其幻觉检测、缓解、任务考虑、使用的数据集和评估指标。这将为读者提供该领域最新进展的简明概览。

总结速览

解决的问题

在大规模基础模型中,幻觉输出的生成是一个关键挑战,特别是在高风险应用中。这种倾向可能影响模型的可靠性和准确性。

提出的方案

建立了幻觉的精确定义和结构化分类,识别出导致不同模态中幻觉出现的关键因素和机制。提出了多模态环境中解决幻觉问题的检测和缓解策略。

应用的技术

- 精确定义和分类幻觉现象

- 多模态幻觉检测和缓解策略

- 任务考虑、数据集使用和评估指标的综合总结

达到的效果

为研究人员和实践者提供了一个清晰的框架,帮助识别和缓解基础模型中的幻觉问题。这一框架为未来在该领域的研究奠定了基础,并提供了最新进展的简明概览。

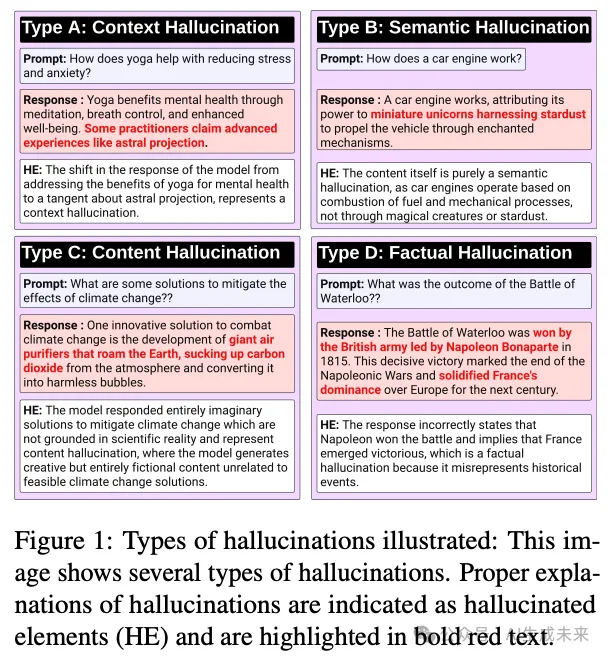

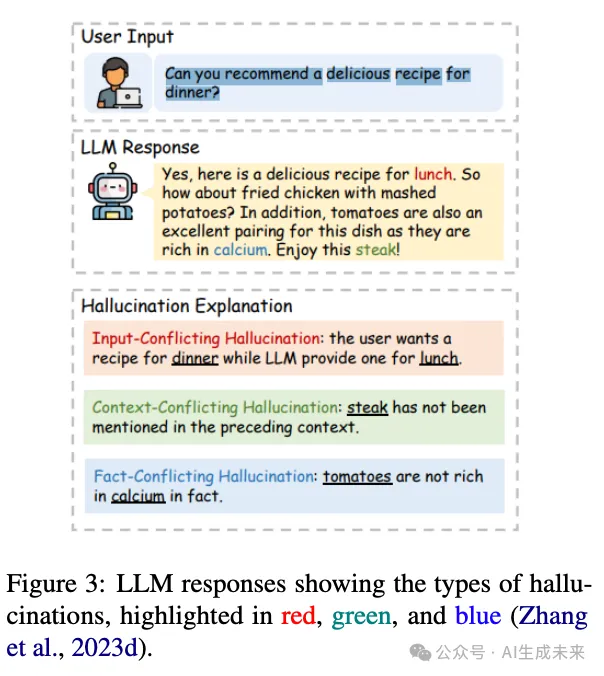

大语言模型中的幻觉

尽管大语言模型(LLMs)取得了进展,但它们容易产生幻觉的显著挑战仍然存在,阻碍了其实际应用。例如,下图3中的插图展示了由LLM生成的响应,显示了幻觉的迹象。

幻觉检测和缓解

识别大语言模型(LLMs)中的幻觉对于确保其结果的可信性和可靠性至关重要,尤其是在需要事实准确性的场景中。现有的事实核查方法通常依赖复杂的模块或外部数据库,需要输出概率分布或与外部资源接口。SelfCheckGPT提供了一种零资源的黑箱解决方案,用于检测任何LLM中的幻觉,而无需依赖外部资源。该方法基于这样一个原则:对某个主题熟悉的LLM将在其响应中产生一致且可比的事实。相反,来自不熟悉主题的随机采样响应可能包含矛盾和幻觉的事实。

继续探索段落级幻觉检测的方法,Yang等提出了一种基于反向验证的新型自检方法,旨在自动识别不依赖外部资源的事实错误。他们引入了一个基准——段落级幻觉检测(PHD),使用ChatGPT生成并由人类专家注释,以评估不同的方法。评估LLM生成的长文本的准确性具有挑战性,因为它通常包含准确和不准确的信息,使得简单的质量判断不足以应对。为了解决这一问题,Min等引入了FACTSCORE(原子性评分中的事实精度),一种新的评估方法,将文本分解为单独的事实并测量其可靠性。Huang和Chang通过与成熟的网络系统进行类比,引入了一种独特的策略来减轻LLM中的幻觉风险。他们指出缺乏“引用”机制,即承认或引用来源或证据,是一个显著的缺口。

为了解决识别大语言模型(LLM)生成内容中的事实不准确问题,Rawte等人(2024b)开发了一个多任务学习(MTL)框架,集成了先进的长文本嵌入技术,如e5-mistral-7b-instruct,以及GPT-3、SpanBERT和RoFormer等模型。该MTL方法在FACTOID基准测试中表现出显著的性能提升,平均准确率提高了40%,相比领先的文本蕴涵方法。幻觉缓解工作主要依赖于经验方法,对于完全消除幻觉的可能性仍存在不确定性。为应对这一挑战,Xu等人(2024b)引入了一个形式化框架,将幻觉定义为可计算的LLM与真实函数之间的差异。通过该框架,研究考察了现有的幻觉缓解策略及其在实际LLM部署中的实际影响。

Rawte等人(2024c)引入了“Sorry, Come Again”(SCA)提示技术,以解决现代LLM中的幻觉问题。SCA通过采用最佳释义和插入[PAUSE]tokens来延迟LLM生成,以增强理解力。它分析了提示中的语言细微差别及其对幻觉生成的影响,强调了由可读性、正式性或具体性较低的提示带来的困难。Rawte等人(2023a)研究了LLM如何响应事实正确和不正确的提示,将其幻觉分为轻微、中等和严重子类别。此外,论文引入了幻觉引发数据集(Hallucination eLiciTation dataset),包含75,000个人工标注的文本片段,并引入了一个新的幻觉脆弱性指数(Hallucination Vulnerability Index)指标。

特定领域的工作

幻觉在医疗、金融和法律等关键领域中构成严重风险。这些领域中,可靠性和准确性至关重要,因为任何形式的幻觉都可能导致重大和不利的后果。

医学领域

针对医学领域大语言模型中的幻觉,Pal 等人(2023)引入了医学领域幻觉测试(Med-HALT),这是一个专门用于评估和减轻幻觉的基准数据集。Med-HALT 包含来自多个国家的医疗记录的多样化国际数据集,总共涵盖七个数据集。Ahmad 等人(2023)概述了创建可靠、可信和无偏见模型的基本步骤,强调了在医疗背景下量化、验证和减轻幻觉的必要性。Ji 等人(2023)引入了一种互动自反思方法,旨在提高使用大语言模型的医学问答系统生成的答案的准确性和连贯性。通过知识获取和对答案生成的反馈,这一方法提高了响应的事实性、一致性和逻辑进展。

金融领域

一项实证研究探讨了大语言模型(LLMs)在金融活动中产生幻觉的倾向。Kang和Liu(2023)进行了这方面的实证调查,评估了LLMs在解释金融概念和查询历史股价方面的能力,并研究了诸如少样本学习和基于提示的工具学习等方法在减轻幻觉方面的效果。Roychowdhury等人(2023)提出了一种新颖的基于Langchain的方法,旨在将数据表转换为分层的文本数据块,以促进多样化的金融问答。该框架包括按意图分类用户查询、检索相关数据块、生成定制的LLM提示,并评估响应的幻觉和置信度。

法律领域

传统的抽象文本摘要方法通常采用编码器-解码器架构,其中编码器提取源文本的精髓,而解码器生成摘要。然而,这种方法可能会产生包含无关或不准确信息的摘要,这在法律领域中尤为令人担忧,因为准确性至关重要。为了解决这些问题,Feijo和Moreira(2023)引入了LegalSumm,它创建源文本的不同“视图”,训练摘要模型生成独立的摘要,并使用蕴涵模块评估其与源文本的符合性。Deroy等人(2023)通过将最先进的模型应用于印度法院案件,研究了大型语言模型生成案件判决抽象摘要的准备情况。尽管抽象模型的得分通常略高,但作者注意到生成的摘要中存在不一致和幻觉。

理解开放性法律术语的含义对法律专业人士非常重要。他们经常查看这些术语在先前法院案件中的使用和解释。Savelka等人(2023)评估了GPT-4在生成法律术语的事实准确、清晰和相关解释方面的表现。比较了基线方法(GPT-4直接解释法律术语)和增强方法(使用法律信息检索模块提供来自判例法的上下文句子)。Dahl等人(2024)首次提供了法律领域中不准确性的频率和类型的证据,为评估法律背景下的大型语言模型提供了宝贵的见解。通过检查美国判例法的结构化格式,研究评估了三个主要的大型语言模型:GPT-3.5、PaLM 2和Llama。

基准评估

在某些情况下,大型语言模型会出现一种被称为“幻觉滚雪球”的现象,即它们会编造虚假声明来合理化先前的幻觉,尽管它们承认这些信息是不准确的。为了实证研究这一现象,Zhang等人(2023a)设计了三个跨越不同领域的问题回答数据集,其中ChatGPT和GPT-4经常提供不准确的答案,并附带至少一个虚假声明的解释。值得注意的是,研究表明语言模型可以识别这些虚假声明为不正确。另一个基准数据集FactCHD(Chen等人,2023b)被引入用于检测复杂推理背景下的事实冲突幻觉。该数据集涵盖了不同事实模式的数据集,并整合了基于事实的证据链以提高评估准确性。Li等人(2023b)引入了一个数据集,用于评估大型语言模型识别和识别幻觉或错误信息的能力。结果显示,ChatGPT倾向于在某些主题上生成幻觉内容,引入无法验证的信息。

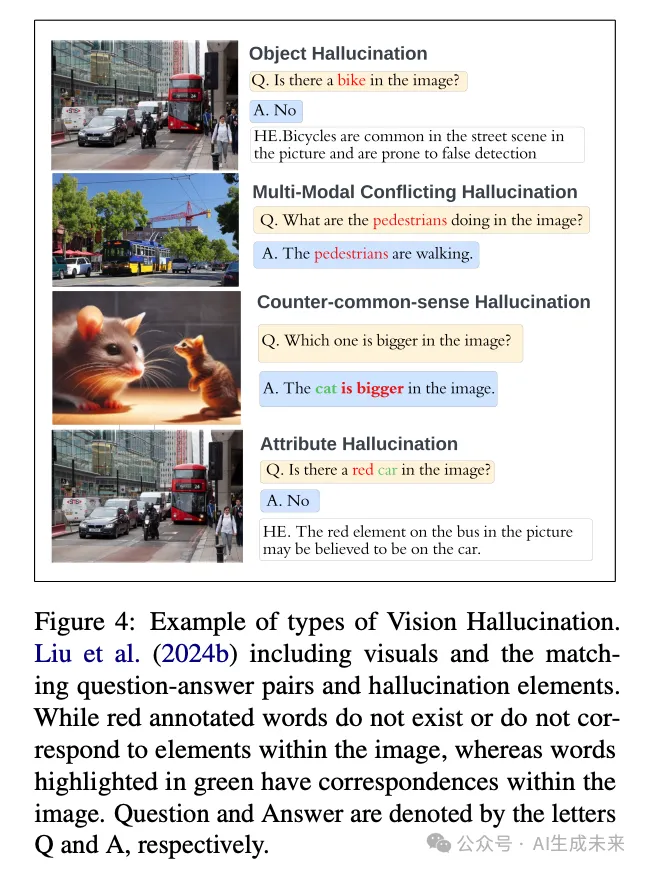

大视觉语言模型中的幻觉

大型视觉语言模型(LVLMs)因其同时处理视觉和文本数据的能力而在AI社区中受到广泛关注。然而,与LLMs类似,LVLMs也面临幻觉问题。下图4展示了一个视觉幻觉的例子,其中模型可能会误解或错误生成图像中的信息。

幻觉检测和缓解

Dai 等人(2022)研究了视觉语言预训练(VLP)模型中的物体幻觉问题,即这些模型生成的文本描述基于输入图像包含不存在或不准确的物体。Li 等人(2023f)揭示了广泛且严重的物体幻觉问题,并指出视觉指令可能会影响幻觉的产生。他们观察到,在视觉指令中经常出现或与图像对象共同出现的物体更容易产生幻觉。为了增强物体幻觉的评估过程,作者引入了一种基于投票的查询方法,称为 POPE,该方法在评估物体幻觉方面表现出更好的稳定性和灵活性。缺乏标准化的评估指标阻碍了对物体幻觉问题的理解和解决。为了解决这一差距,Lovenia 等人(2023)引入了 NOPE(Negative Object Presence Evaluation),这是一个通过视觉问答(VQA)评估视觉语言模型(VLMs)中物体幻觉的基准。

研究利用大型语言模型生成了一个包含 29.5k 合成负代词(NegP)实例的数据集用于 NOPE。它全面评估了 10 个 VLMs 在检测视觉问题中物体缺失的能力,此外还评估了它们在其他九个 VQA 数据集上的典型表现。现有研究主要关注物体幻觉,忽视了大型视觉语言模型(LVLMs)的幻觉。Liu 等人(2024b)深入研究了内在视觉语言幻觉(IVL-Hallu),并提出了几个新的 IVL-Hallu 任务,包括属性、物体、多模态冲突和反常识幻觉。他们引入了一个具有挑战性的基准数据集来评估和探索 IVL-Hallu,并对五个 LVLMs 进行了实验,结果显示它们在解决所提出任务方面的有效性有限。为在不依赖昂贵训练或 API 的情况下减轻 LVLMs 中的物体幻觉,Zhao 等人(2024)引入了 MARINE,这是一种无需训练和 API 的解决方案。MARINE 通过结合现有的开源视觉模型并利用无分类器指导来整合物体定位特征,从而增强 LVLMs 的视觉理解,提高生成输出的精确性。对六个 LVLMs 的评估表明,MARINE 在减少幻觉和增强输出细节方面的有效性,通过使用 GPT-4V 的评估得到了验证。

尽管在多模态任务上取得了进展,但LMMs常常生成与图像或人类指令不一致的描述。为了解决这个问题,Liu等人(2023)开发了LRV-Instruction,这是一个包含40万条视觉指令的综合数据集,涵盖16个任务。该数据集包含各种风格和语义层次的正面和负面指令。通过LRV-Instruction,现有LMMs的幻觉问题得到了广泛研究,证实了其在增强视觉指令调优方面的有效性。此外,他们引入了GAVIE,这是一种无需人工标注答案即可评估视觉指令调优的新方法,可以适应不同类型的指令。

LVLM幻觉修正算法(LURE)旨在通过优化描述来纠正LVLM中的对象幻觉,从而生成更准确且幻觉更少的输出。其方法基于深入的统计分析,识别出导致对象幻觉的关键因素,如图像中某些对象的共现、LVLM解码过程中与对象相关的不确定性,以及生成文本末尾出现幻觉的趋势。LURE设计为可无缝集成到各种LVLM中。在多个LVLM中进行测试时,LURE的集成显著提升了对象幻觉的纠正效果,在多种指标下的GPT和人工评估中均持续优于其他方法。

基准评估

当前开发多模态大型语言模型(LVLMs)的方法严重依赖于带注释的基准数据集,这些数据集可能存在领域偏差,限制了模型的生成能力。为了解决这个问题,Li等人(2023e)提出了一种新颖的数据收集方法,该方法同步合成图像和对话用于视觉指令调优,生成了大量图像-对话对和多图像实例的数据集。Huang等人(2024)引入了VHTest,这是一个包含1,200个多样化视觉幻觉(VH)实例的基准数据集,覆盖8种VH模式。对三种SOTA多模态大型语言模型(MLLMs)的评估显示,GPT-4V的幻觉率低于MiniGPT-v2。

Rawte等人(2024a)将视觉幻觉在视觉语言模型(VLMs)中分类为八个方向,并引入了一个包含2,000个样本的数据集,涵盖这些类型。他们提出了三种主要的减轻幻觉的方法:数据驱动的方法、训练调整和后处理技术。此外,Wang等人(2024)提出了视觉指令生成与修正(VIGC)框架,以解决MLLMs高质量指令调优数据的短缺问题。VIGC使MLLMs能够生成多样化的指令调优数据,同时通过视觉指令修正(VIC)迭代地提高其质量,从而降低幻觉风险。该框架生成多样化的高质量数据用于微调模型,通过评估验证,提升了基准性能,并克服了仅语言数据的局限性。

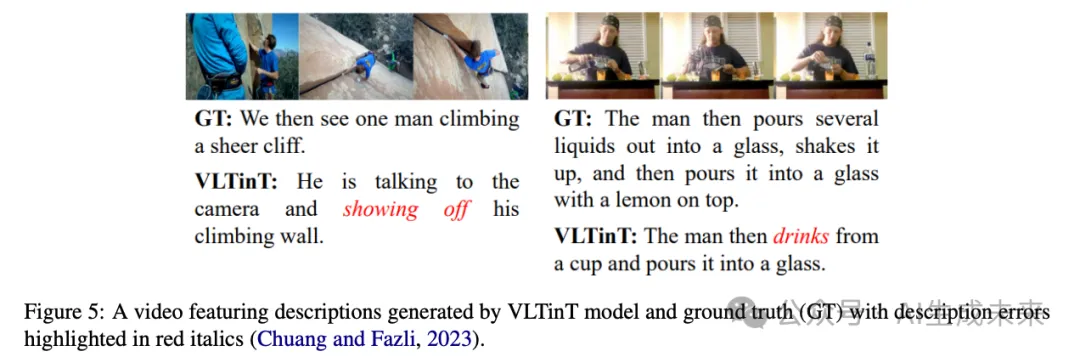

大型视频模型中的幻觉

大型视频模型(LVMs)代表了一项重大进步,能够大规模处理视频数据。尽管它们在视频理解和生成等各种应用中具有潜力,但LVMs面临幻觉问题,即对视频帧的误解可能导致生成虚假或不准确的视觉数据。这个问题的产生是由于视频数据的复杂性,需要模型进行彻底的处理和理解。下图5展示了在LVMs中观察到的幻觉实例。

幻觉检测和缓解

密集视频字幕生成的复杂任务涉及为连续视频中的多个事件创建描述,这需要对视频内容和上下文推理进行深入理解,以确保生成准确的描述。然而,这一任务面临诸多挑战,可能导致不准确和幻觉现象(Iashin and Rahtu, 2020; Suin and Rajagopalan, 2020)。

传统方法先检测事件提议,然后为子集生成字幕,但由于忽视时间依赖性,可能导致幻觉。为了解决这一问题,Mun等(2019)提出了一种新方法,通过建模时间依赖性和利用上下文进行连贯叙述。通过集成事件序列生成网络和使用强化学习及两级奖励训练的顺序视频字幕生成网络,该模型更有效地捕捉上下文信息,从而生成连贯准确的字幕,并最大限度地减少幻觉风险。Liu和Wan(2023)引入了一种新的弱监督、基于模型的事实性指标FactVC,其表现优于以往指标。此外,他们提供了两个注释数据集,以促进视频字幕事实性评估的进一步研究。Wu和Gao(2023)提出了一种上下文感知模型,该模型结合了过去和未来事件的信息,以有条件地影响当前事件的描述。他们的方法利用强大的预训练上下文编码器来编码关于周围上下文事件的信息,然后通过门控注意机制将其集成到字幕生成模块中。在YouCookII和ActivityNet数据集上的实验结果表明,所提出的上下文感知模型显著优于现有的上下文感知和预训练模型。为了增强密集视频字幕生成,Zhou等(2024)引入了一种流式模型,该模型包括一个用于处理长视频的记忆模块和一个流式解码算法,使得在视频完成之前即可进行预测。这一方法显著提升了在YouCook2、ActivityNet和ViTT等主要密集视频字幕生成基准上的表现。

视频填充和预测任务对于评估模型理解和预测视频序列中的时间动态的能力至关重要(Höppe et al., 2022)。为此,Himakunthala等(2023)引入了一个推理时间挑战数据集,其中包含带有密集字幕和结构化场景描述的关键帧。该数据集提供了补充有非结构化密集字幕和结构化FAMOUS(焦点、动作、情绪、物体和环境)场景描述的关键帧,为模型理解视频内容提供了有价值的上下文信息。他们使用了GPT-3、GPT-4和Vicuna等语言模型,并采用贪婪解码来减轻幻觉风险。

最近在视频修复方面取得了显著进展,特别是在光流等显式指导帮助跨帧传播缺失像素的情况下(Ouyang et al., 2021)。然而,由于缺乏跨帧信息,仍然存在困难和限制。Yu等(2023b)旨在解决相反的问题,而不是依赖使用其他帧的像素。所提出的方法是一个缺陷感知的掩码Transformer(DMT),这是一种双模态兼容的修复框架。该方法通过预训练图像修复模型作为训练视频模型的先验,改善了处理信息不完整场景的能力。

理解场景可供性,即场景中可能的动作和交互,对于理解图像和视频至关重要。Kulal等(2023)介绍了一种将人物逼真插入场景的方法。该模型通过推断基于上下文的逼真姿势,确保视觉上令人愉悦的构图,将个体无缝整合到场景中。Chuang和Fazli(2023)介绍了CLearViD,这是一种基于Transformer的模型,利用课程学习技术来增强性能。通过采用这种方法,模型获得了更强大和更具泛化性的特征。此外,CLearViD引入了Mish激活函数来解决诸如梯度消失的问题,从而通过引入非线性和非单调性来降低幻觉风险。广泛的实验和消融研究验证了CLearViD的有效性,在ActivityNet Captions和YouCook2数据集上的评估显示出在多样性指标方面相较现有SOTA模型的显著改进。

基准评估

Zhang等(2006)创造了一种创新的两级层次融合方法,从训练视频样本中仅使用一张中性表情的正面人脸图像生成面部表情序列。为了有效地训练系统,他们引入了一个专门为面部表情幻觉设计的数据集,其中包含112个视频序列,涵盖28个人的四种面部表情(快乐、愤怒、惊讶和恐惧),从而在时间和空间域中生成合理的面部表情序列,并减少伪影。在视频理解领域,端到端的以聊天为中心的系统的开发已成为一个日益增长的兴趣领域。Zhou等(2018)组建了YouCook2数据集,这是一个广泛的烹饪视频集,具有时间定位和描述的程序段,以促进程序学习任务。Li等(2023c)介绍了“VideoChat”,这是一种通过可学习的神经接口集成视频基础模型和大型语言模型(LLM)的新方法,以增强视频理解中的时空推理、事件定位和因果关系推断。研究人员构建了一个以视频为中心的指令数据集,包含详细的描述和对话,强调时空推理和因果关系。为应对模型幻觉,他们采用多步骤过程,使用GPT-4将视频描述浓缩为连贯的叙述,并加以改进以提高清晰度和连贯性。为探索推断场景可供性(affordances)的挑战,Kulal等(2023)策划了一个包含240万段视频剪辑的数据集,展示了与场景上下文相符的各种合理姿势。

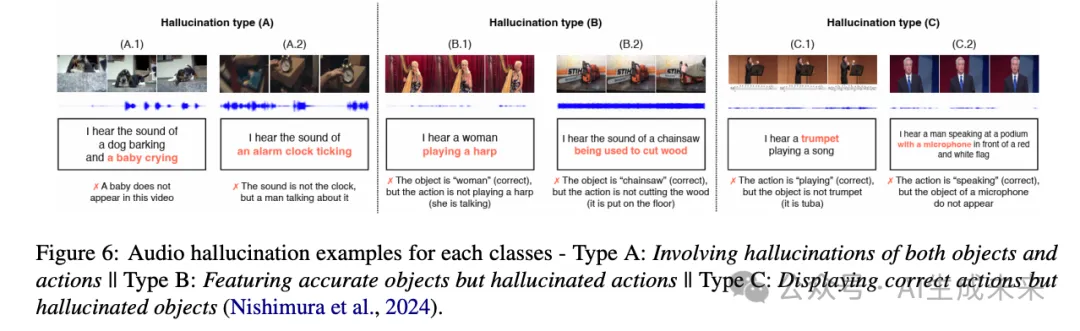

大型音频模型中的幻觉

大型音频模型(LAMs)在音频处理和生成领域中成为了一种强大的工具,应用范围广泛,包括语音识别、音乐分析、音频合成和字幕生成(Latif等,2023;Ghosal等,2023)。尽管这些模型在各个领域展示了卓越的能力,但它们易于出现幻觉。这些异常可能表现为多种形式,从通过拼接虚构片段创建不真实的音频,到在摘要中插入错误信息,如引言或事实。此外,它们可能无法准确捕捉音频信号的固有特征,如音色、音高或背景噪音(Shen等,2023)。

幻觉检测和缓解

在音频字幕生成领域,即自动生成音频片段的自然语言描述时,一个主要挑战是音频-文本模型在预训练过程中过度依赖视觉模态。这种依赖引入了数据噪声和幻觉,最终削弱了生成字幕的准确性。为了解决这个问题,Xu等(2023a)引入了一种AudioSet标签引导的模型,用于引导大规模音频-文本数据(BLAT)。值得注意的是,该模型避免了视频的使用,从而最大限度地减少了与视觉模态相关的噪声。跨检索、生成和分类等多项任务的实验结果验证了BLAT在减轻幻觉问题上的有效性。

语音情感在人与人交流中起着至关重要的作用,并在语音合成和自然语言理解等领域有广泛应用。然而,传统的分类方法可能无法捕捉到人类语音中传达的细腻且复杂的情感(Jiang等,2019)、(Han等,2021)、(Ye等,2021)。SECap(Xu等,2024a)是一个为语音情感字幕设计的框架,旨在通过自然语言捕捉语音的复杂情感细微差别。SECap利用包括LLaMA作为文本解码器、HuBERT作为音频编码器以及Q-Former作为Bridge-Net的各种组件,基于语音特征生成连贯的情感字幕。

尽管音频语言模型具有零样本推理的能力,但在强大性能的同时,仍面临着诸如幻觉特定任务细节等挑战。为了解决这个问题,Elizalde等(2024)引入了对比语言-音频预训练(CLAP)模型。CLAP通过460万对多样化的音频-文本对进行预训练,采用双编码器架构,增强了表示学习,从而在声音、音乐和语音领域实现更好的任务泛化。

基准评估

为了应对音乐字幕领域数据稀缺的问题,Doh等(2023)引入了LP-MusicCaps,这是一个综合数据集,包括50万段音频片段和大约220万条字幕。他们利用大型语言模型(LLMs)训练了一个基于Transformer的音乐字幕生成模型,并在零样本和迁移学习场景下评估其性能,表现出相对于监督基线模型的优越性。

Nishimura等(2024)研究了大型音视频语言模型中的音频幻觉问题,这些模型主要基于视觉信息生成音频描述,而忽略了音频内容。他们将这些幻觉分为三种类型:涉及对象和动作的幻觉、对象准确但动作幻觉、动作正确但对象幻觉。在他们的研究中,他们通过收集音频信息获取了1000个句子,并对其进行标注以确定是否包含听觉幻觉,如果检测到则进一步分类幻觉类型。

为了评估大型音频模型(LAMs)的组合推理能力,Ghosh等(2023)引入了CompA,包含两个主要关注真实音频样本的专家标注基准。这一基准用于通过一种新颖的学习方法微调CompA-CLAP,提升其组合推理能力,并在需要组合推理的任务中表现出相对于所有基线模型的显著改进。

幻觉:好还是坏?

大型模型中的幻觉现象呈现出创造力与不确定性之间的复杂互动。一方面,超越常规数据边界的能力可以产生新颖和创新的输出。幻觉可以激发探索性学习,揭示数据中意想不到的模式和特征。它们还可以作为压力测试的一种形式,提高模型的鲁棒性和适应性。此外,这些意外的输出甚至可以激发人类的创造力,成为新想法和新视角的跳板(Rawte等,2023b)。然而,幻觉的这种双重性质也带来了显著的缺点。幻觉输出的质量和连贯性可能存在问题,在准确性和可靠性至关重要的应用中带来挑战。幻觉还可能传播模型训练数据中存在的错误信息和偏见,可能加深现有的偏见并削弱用户信任。这些输出的可解释性降低可能进一步削弱模型的可信度和采用率。当幻觉产生不当、冒犯或有害内容时,会引发伦理问题。必须进行仔细的监控和控制机制,以防止产生可能对用户造成伤害或困扰的输出。在探索与忠实度之间找到这种微妙的平衡,对于在最大化大型模型效用的同时减轻意外输出相关风险至关重要。总体而言,大型模型中的幻觉现象突显了对这些能力进行细致理解和战略管理的必要性。

限制

先前的综述论文主要关注大型语言模型中的幻觉现象,并未广泛涵盖视觉、音频和视频模态中的幻觉。在这篇综述论文中,我们的目标是全面概述所有模态中的幻觉现象,考虑到幻觉可能出现在任何大型基础模型中。尽管我们努力提供关于所有基础模型中幻觉技术的最新进展的全面总结,但我们承认可能会遗漏该领域的一些相关研究。

未来方向

研究人员正在积极研究幻觉缓解技术,因为在敏感领域中,生成虚构或错误内容的挑战可能会产生严重后果(Tonmoy et al., 2024; Rawte et al., 2023b)。以下是解决这些基础模型中幻觉问题的潜在方向:

数据资源: 最近的研究强调了在精心策划的高质量样本上进行简单微调的效果,这种方法在减少幻觉方面超过了大规模微调和强化学习方法。在知识密集型领域,开发以实体为中心的微调指令,整合来源于知识图谱的结构化知识,有望提高准确性和相关性。此外,针对特定任务或领域的对齐技术已被证明在缓解幻觉方面有效。随着该领域研究的进展,预计将有更多资源专注于通过任务特定或领域适应的方法改善对齐,从而进一步增强语言模型在生成事实和可信内容方面的可靠性。

自动化评估: 开发考虑诸如事实准确性和连贯性等因素的专门评估指标对于幻觉检测非常有用。将自动化评估与通过众包进行的人类判断相结合,可以捕捉到自动化系统单独难以检测的细微方面。此外,还在开发对抗性测试方法,通过设计输入来暴露AI系统的弱点,增强其对幻觉的抵抗力。此外,在强调事实核查和准确性的数据集上微调基础模型提供了另一种提高内容可靠性和减少幻觉发生的方法。

改进检测和缓解技术: 缓解基础模型中的幻觉需要利用推理机制、知识图谱集成、专门的事实核查模型、偏差缓解技术和主动学习方法的多方面方法。诸如Chain of Thought(CoT)和Tree of Thought(ToT)等新兴技术增强了这些模型的推理能力,可能减少幻觉。整合知识图谱有助于理解事实信息和概念关系,从而支持内容生成和事实核查。专门的验证模型通过与策划的知识进行交叉引用来识别不准确之处,而偏差检测和缓解技术促进公平性。最后,管理AI开发中策划知识负责任使用的伦理指南和监管框架可以降低风险并增强公众信任,从而整体提高AI生成内容的质量、准确性和可信度。

多模态幻觉: 解决多模态大型基础模型中的幻觉需要跨越数据中心举措、跨模态对齐努力、架构创新、标准化基准、重构幻觉以及增强可解释性和信任的综合方法。数据中心技术确保多样化和高质量的训练数据的稳健收集、增强和校准。跨模态对齐专注于通过复杂的架构对齐跨模态的表示。模型架构的进步涉及设计能够有效处理复杂语言和视觉输入的专用模型。建立统一的指标和标准化基准可以准确评估幻觉和可靠的性能评估。将幻觉重构为一种特性探讨其在下游应用中的集成,优化人类体验。最后,开发用于解释模型行为、可视化内部结构和改进可靠性评估的技术,有助于增强对多模态大模型的信任。这种多方面的方法共同解决了关键的幻觉挑战,为更可靠和值得信赖的多模态AI系统铺平了道路。

结论

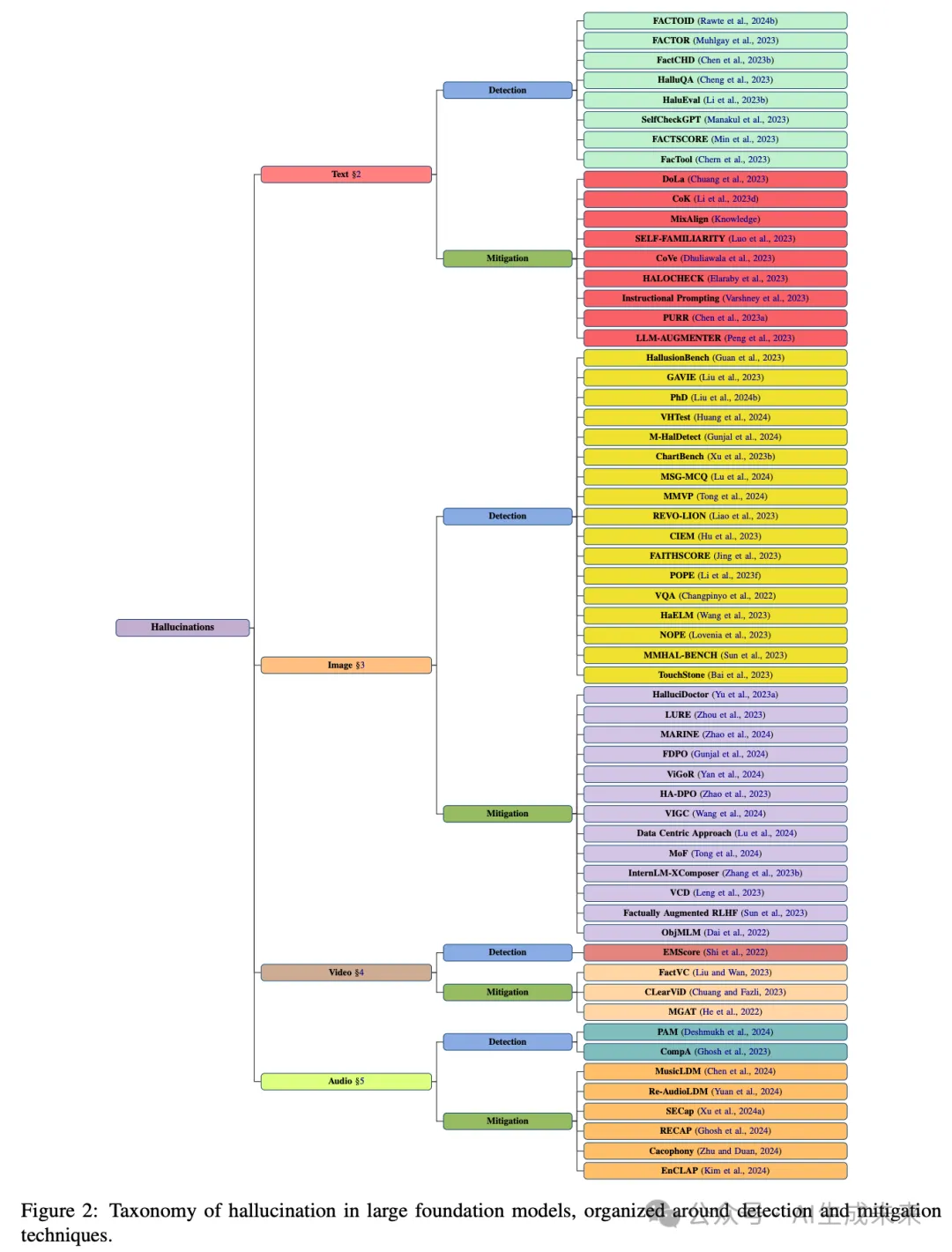

这篇综述论文系统地分类了基础模型中幻觉现象的现有研究,提供了对关键方面的全面见解,包括检测、缓解、任务、数据集和评估指标。文章讨论了幻觉在基础模型中广泛的影响,承认其在各个领域中的影响。通过研究检测和缓解技术的最新进展,论文强调了解决这一挑战的重要性,鉴于基础模型在关键任务中的不可或缺性。其主要贡献在于引入了一个结构化的分类法,用于对基础模型中的幻觉进行分类,涵盖文本、图像、视频和音频领域。

本文转自AI生成未来 ,作者:AI生成未来