RAGCache:让RAG系统更高效的多级动态缓存新方案 原创

01、概述

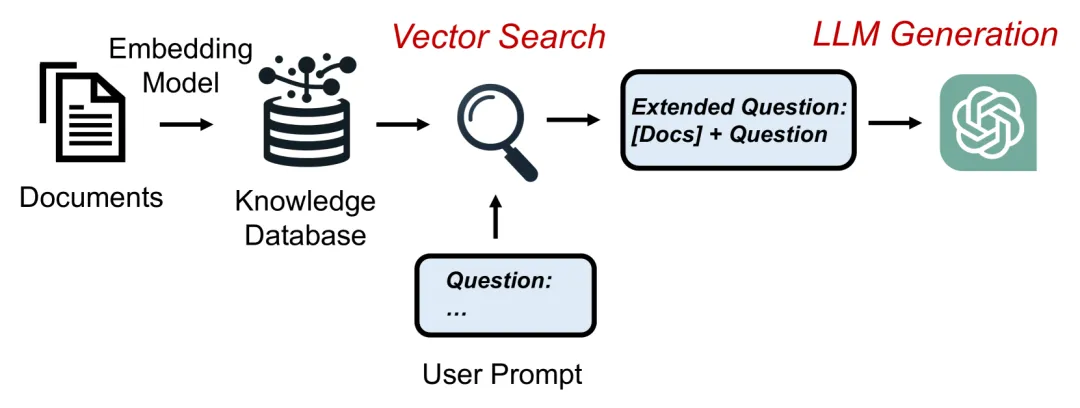

在当下的AI研究中,检索增强生成(RAG)技术正在逐步提升大型语言模型(LLM)的知识运用能力,帮助它们结合外部知识生成更加准确、符合现实的文本。然而,RAG系统却面临一个无法忽视的瓶颈:庞大的计算和内存需求。每当模型从知识库中获取大量文档来生成内容时,原始文本长度可能会被扩展十倍以上,极大地增加了系统的计算负担和响应时间,从而限制了RAG在实时场景中的应用潜力。

为解决这一问题,北京大学和字节跳动的研究团队推出了一种全新的多级动态缓存系统——RAGCache。通过对检索到的知识进行智能缓存和管理,RAGCache有效提升了RAG系统的处理速度和计算效率。本文将深入探讨这一创新方案的工作原理、技术细节及其在实际应用中的重大意义。

02、RAGCache的创新突破:缓存中间状态,实现知识高效复用

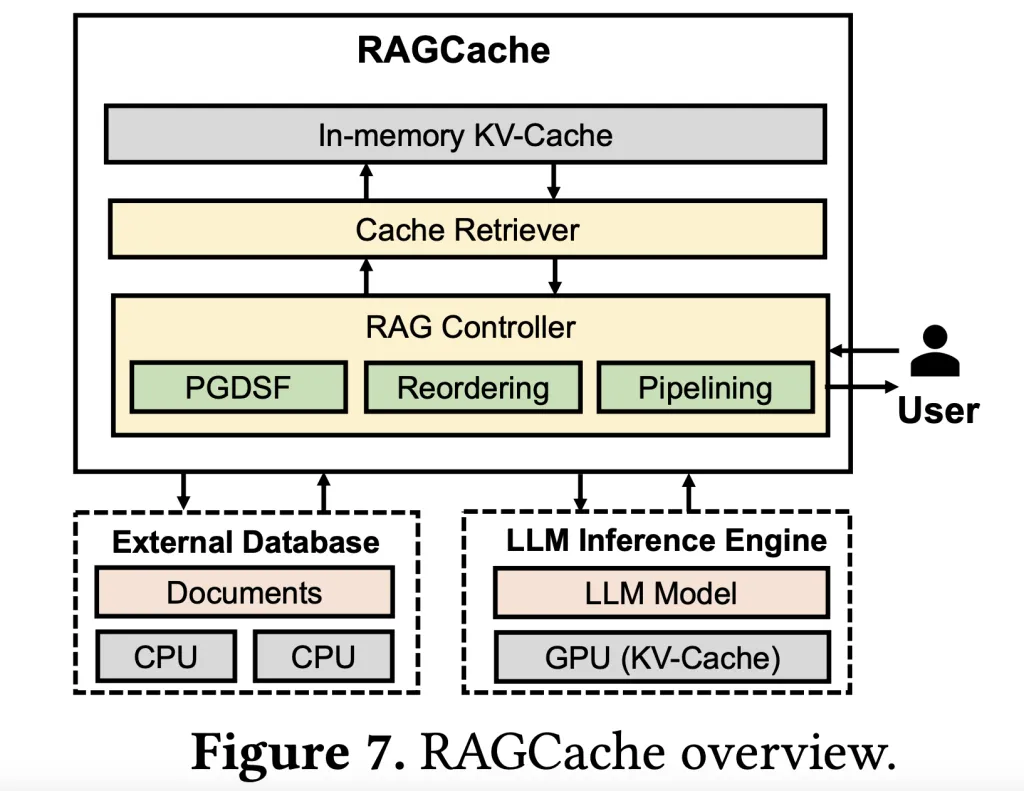

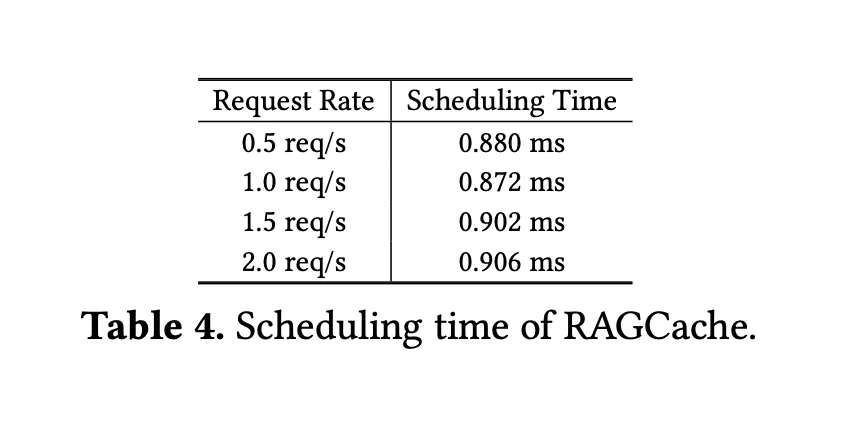

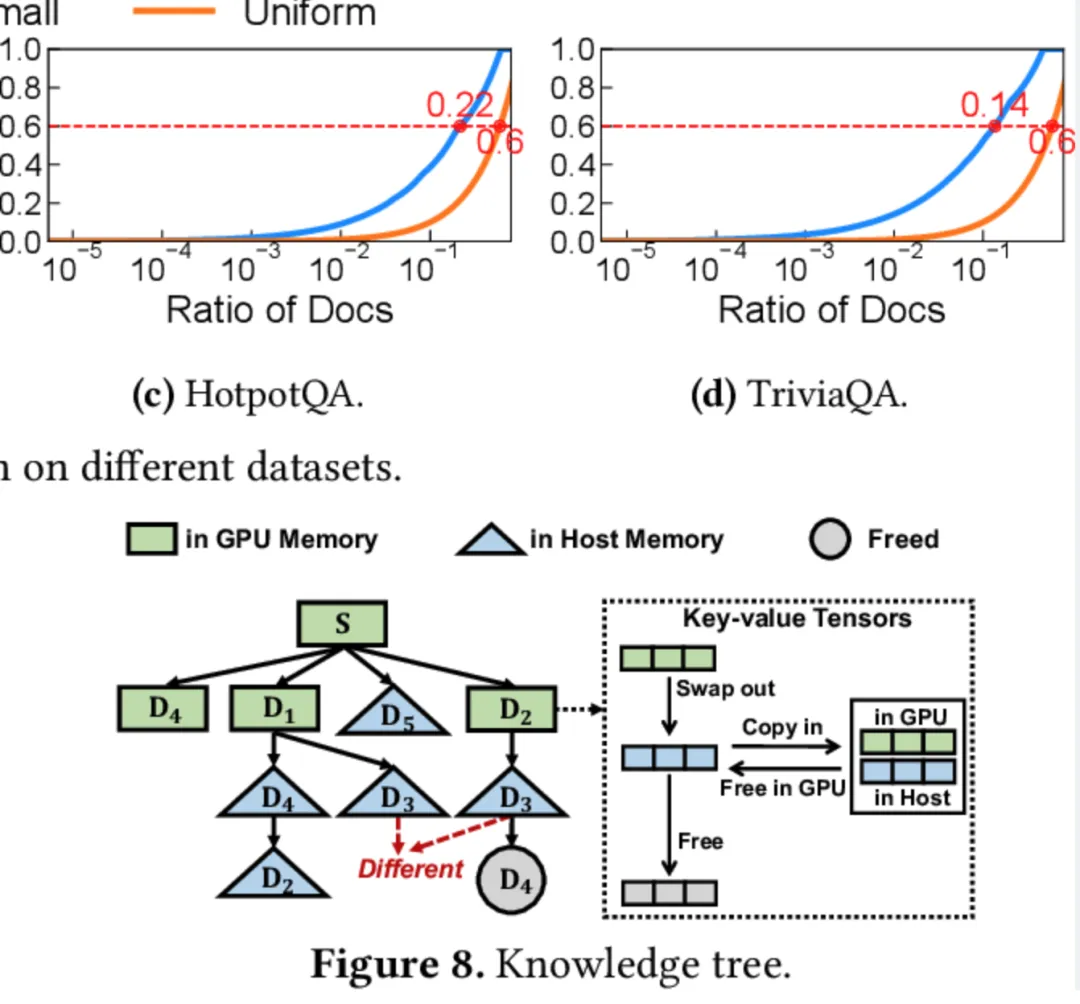

在传统RAG系统中,生成过程中频繁的知识检索增加了生成时间,而为了更好地优化生成速度和效率,团队提出了“多级动态缓存”这一核心思路。RAGCache基于一个知识树结构,通过缓存中间状态在GPU和主机内存中实现高效存储管理。值得注意的是,RAGCache独创的前缀感知贪心双重大小频率替换策略(PGDSF)能够在缓存命中率上取得显著优化,将高频访问的文档缓存至GPU内存,低频文档则移至较慢的主机内存,从而减少对重复计算的需求,加速响应时间。

工作流程:缓存知识树、智能替换和动态重叠

RAGCache的工作流程主要分为以下几个核心步骤:

- 知识树缓存:通过构建一个知识树结构,RAGCache能将检索到的知识缓存为键值张量(key-value tensors),使得常访问的知识存储于GPU,较少访问的内容则缓存在主机内存中。这种多级存储机制不仅降低了对GPU资源的需求,也使得模型能够迅速获取到常用的知识。

- 智能替换策略:前缀感知的PGDSF替换策略在考虑文档的顺序、频次、大小及近期访问情况的基础上,智能选择哪些内容应保留在缓存中。这种策略确保缓存空间始终用于存储最有价值的中间状态,从而减少了缓存未命中情况,提高了生成效率。

- 动态预测流水线:RAGCache实现了矢量检索与LLM生成步骤的动态重叠,使得模型能够同时进行检索与生成,避免了传统RAG系统中的顺序执行瓶颈,大幅降低了响应延迟。

通过这一多层次的优化机制,RAGCache不仅能够高效缓存和复用知识,还显著加快了整体生成速度,特别是在需要快速响应的应用场景中具有明显优势。

03、RAGCache的性能表现:4倍加速和2倍吞吐提升

在实际测试中,RAGCache的表现令人瞩目。研究团队在vLLM(领先的LLM推理系统)中集成了RAGCache,结合流行的向量数据库Faiss,实验数据显示其时间至首标记(TTFT)加速了4倍,吞吐量提升了2.1倍。此外,与高性能LLM系统SGLang相比,RAGCache在TTFT上实现了3.5倍的提升,吞吐量提高了1.8倍。这些测试结果表明,RAGCache在性能上远超传统的RAG方案,能更好地满足大型应用场景的需求。

通过在GPU和主机内存之间高效地分配和复用检索信息,RAGCache不仅降低了计算成本,也显著提高了处理速度,使其成为那些高频、同类检索请求密集的场景中的理想选择。

04、RAGCache如何助力RAG系统突破瓶颈

RAGCache的意义不仅仅是对RAG系统的性能提升,更是为其在实时性、规模性应用场景中提供了一套可行的解决方案。这项技术特别适用于以下几类应用:

- 实时客服和智能助理:客服场景中的AI需要在短时间内处理海量的用户请求,RAGCache的高缓存命中率和快速响应能力,能显著减少用户等待时间,提升用户体验。

- 内容生成和实时推荐:在内容推荐系统中,RAGCache的缓存机制可以帮助系统快速调用常用知识,使得AI在内容生成、推荐等方面更加智能化。

- 大规模检索和企业知识管理:在需要频繁访问外部数据库的知识密集型应用中,如法律、金融等领域,RAGCache通过减少重复计算和资源浪费,有助于提升AI模型的生产力。

05、缓存失效与隐私安全

虽然RAGCache的缓存机制极大提升了系统的响应速度,但也面临一些潜在的挑战。比如,对于快速变化的信息领域,缓存的信息可能很快失效,从而影响生成内容的准确性。此外,缓存大量检索信息也带来了隐私与安全风险,尤其是在用户数据涉及敏感信息时。未来的研究应进一步探索如何应对这些问题,以确保RAGCache的安全性和数据更新的及时性。

技术进步的背后:RAGCache在RAG系统优化中的里程碑意义

RAGCache的提出不仅在技术上突破了RAG系统的瓶颈,更为未来的RAG发展开辟了新的方向。多级缓存体系的创新设计,特别是智能化的缓存管理策略,为RAG系统实现高效、高速的数据处理提供了参考。通过对中间状态的缓存与复用,RAGCache有效减少了对计算资源的依赖,使得RAG系统在高效与低成本之间达到了平衡。

05、应用前景

随着大型语言模型的不断扩展,RAGCache的应用潜力将愈发显著。例如,在未来的智能助手、实时翻译、智能搜索引擎等方面,RAGCache的高效缓存机制可以成为推动这些场景AI体验质变的关键。与此同时,RAGCache的智能化缓存策略也为企业部署AI应用提供了更具可操作性的选择。

06、结语

综上所述,RAGCache的创新设计不仅提升了RAG系统的效率,更在一定程度上重新定义了检索增强生成模型的潜力。通过引入多级动态缓存体系和前缀感知智能替换策略,RAGCache在减少延迟和提升吞吐量方面实现了跨越式提升,为实时、规模化的AI应用场景提供了高效、稳定的技术支持。

可以说,RAGCache不仅是一项技术突破,更是引领未来RAG系统发展的重要里程碑。随着AI技术的不断进步,RAGCache的应用有望为各行业带来更多可能性,让AI真正成为“智能助手”,为我们的生活和工作带来切实的便利和提升。

参考:

- https://www.aimodels.fyi/papers/arxiv/ragcache-efficient-knowledge-caching-retrieval-augmented-generation

- https://arxiv.org/abs/2404.12457

本文转载自公众号Halo咯咯 作者:基咯咯