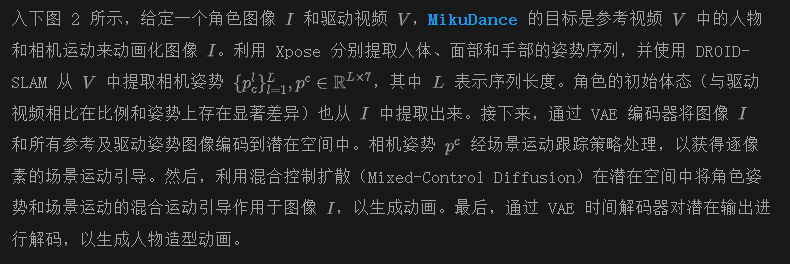

人物造型动画生成最新SOTA!阶跃星辰等提出MikuDance:混合运动建模和混合控制扩散 精华

文章链接:https://arxiv.org/pdf/2411.08656

项目链接:https://kebii.github.io/MikuDance/

亮点直击

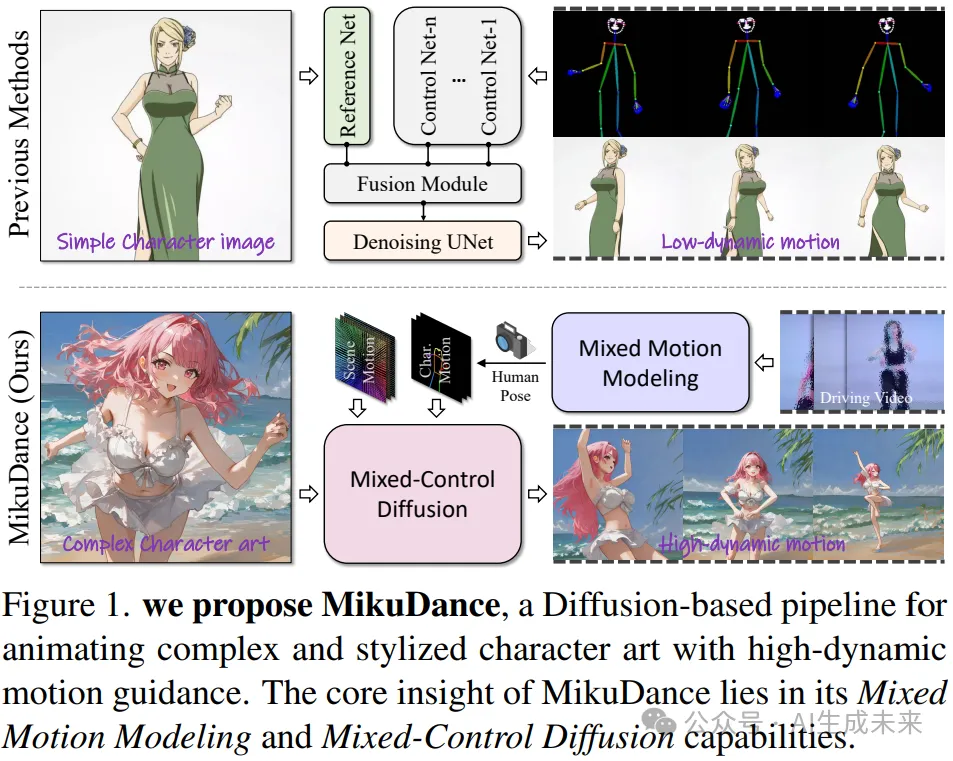

- 提出混合运动建模(Mixed Motion Modeling),用于在统一的逐像素空间中显式建模角色和相机运动,从而有效地表示高动态运动。

- 利用混合控制扩散(Mixed-Control Diffusion)隐式对齐角色的形状、姿势和比例与运动引导,从而实现人物造型动画的连贯运动控制。

- 大量实验表明,MikuDance的有效性和泛化能力,相较于最新的方法,能够实现更高质量的动画和高动态运动控制。

总结速览

要解决的问题

MikuDance 针对人物造型动画中的两个主要难题:高动态运动和参考引导错位问题。

提出的方案

- 混合运动建模(Mixed Motion Modeling):通过场景运动跟踪策略(Scene Motion Tracking)对动态相机进行逐像素建模,实现角色与场景的统一运动建模。

- 混合控制扩散(Mixed-Control Diffusion):隐式地对多样角色的比例和体型进行运动引导对齐,从而灵活控制角色的局部运动。

应用的技术

- 场景运动跟踪策略(Scene Motion Tracking):显式建模动态相机,进行像素级空间的角色-场景运动建模。

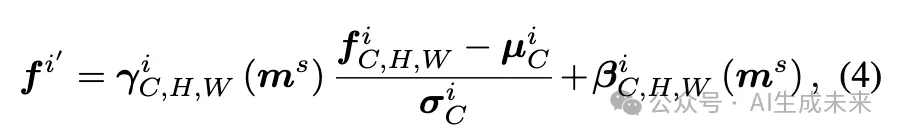

- 运动自适应归一化模块(Motion-Adaptive Normalization Module):将全局场景运动注入角色动画中,支持全面的人物造型动画生成。

达到的效果

通过大量实验,MikuDance 展现了其在各种人物造型和运动引导场景中的有效性和泛化能力,生成的动画具有显著的运动动态效果和高质量的动画表现。

方法

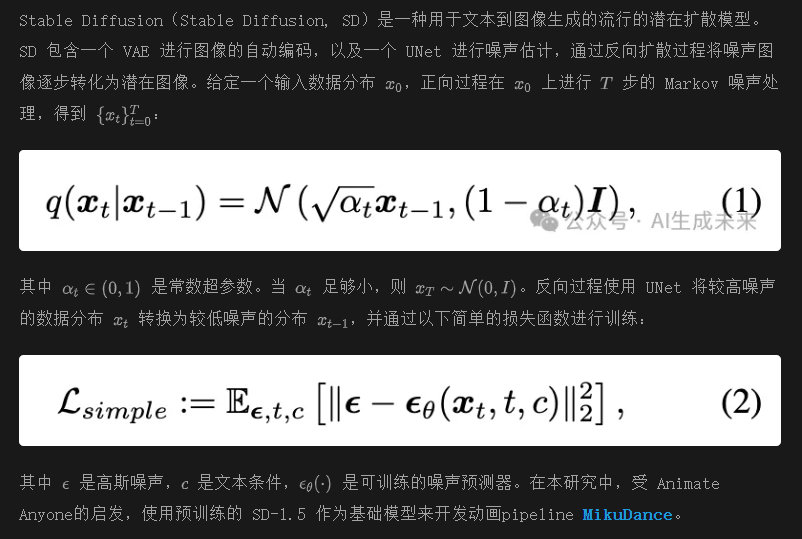

Stable Diffusion的预备知识

与现有的人物图像动画方法 [3, 14, 36] 类似,本文使用基于图像的姿势序列作为角色的运动引导。与以往直接提取角色全身姿势的方法不同,分别提取身体、面部和手部的姿势,使得面部和手部成为可选项,从而实现更灵活的运动控制。然而,角色动画通常涉及整个场景的高动态运动,以增强叙事的视觉效果。传统的姿势序列仅提供角色的运动引导,缺乏对背景动态的表示。为了解决这一问题,引入了场景运动跟踪策略(Scene Motion Tracking)。

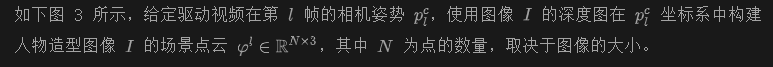

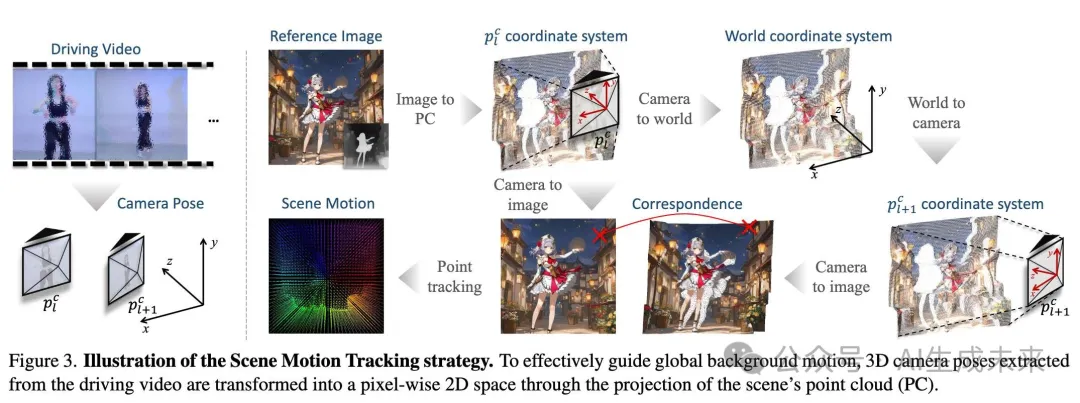

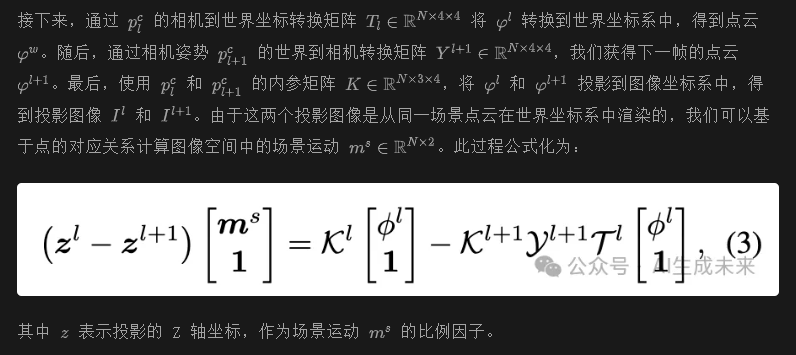

场景运动跟踪(Scene Motion Tracking, SMT)

值得注意的是,SMT 策略在两个关键方面与视频生成方法中常用的光流有所不同:首先,SMT 提取的场景运动与驱动视频的内容无关,而光流则依赖于内容。其次,SMT 跟踪的是点云中的 3D 点,而光流仅跟踪图像域中的像素运动,未考虑实际的 3D 场景。因此,SMT 策略提供了独立的相机动态信息,这对于人物造型动画中的连续背景运动至关重要。

在提出的 SMT 过程中,假设角色和场景在第一个相机中是静止且标准化的。然而,在人物造型术动画的实际应用中,参考场景通常与驱动视频的相机比例不一致,并且每一帧中的角色姿势各不相同。无法显式地消除这种不确定性,因此需要模型在角色姿势和艺术图像的引导下进行隐式感知。因此,在下一节提出了混合控制扩散(Mixed-Control Diffusion)。

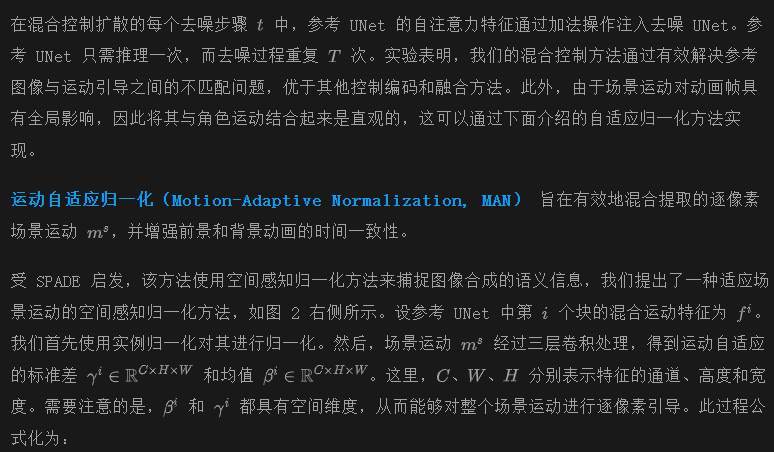

混合控制扩散

混合控制扩散的概念是将角色和场景的所有运动引导混合并融合到一个统一的参考空间中,从而实现对动画的对齐运动控制。

如前面图 2 所示,从 Animate Anyone 获得启发,使用预训练的 SD-1.5 作为基础去噪 UNet,并复制一份作为参考 UNet,以实现可控的图像到视频生成。不同于 Animate Anyone 及其他相关工作,消除了用于运动引导的单独编码器,同时使用 VAE 编码器对参考人物造型、参考姿势和所有角色姿势引导进行编码,并将它们嵌入到同一潜在空间中。接下来,将所有嵌入的引导在通道维度上串联起来,以作为混合控制参考 UNet 的输入。

为了适应这种混合输入,我们扩展了参考 UNet 中输入卷积层的通道,并用零卷积权重初始化新增参数。此外,参考图像通过 CLIP 图像编码器嵌入,并在去噪 UNet 和参考 UNet 的交叉注意力操作中作为关键特征。此过程在现有工作中常用,因此在图 2 中被省略。

借助提出的混合运动建模(Mixed Motion Modeling)和混合控制扩散(Mixed-Control Diffusion),并在参考 UNet 的每个下采样块后集成 MAN 模块,我们概述了 MikuDance 的完整流程。此外,为了增强 MikuDance 适应各种人物造型风格和大规模相机运动动态的能力,我们在下一节提出了一种混合源训练方法。

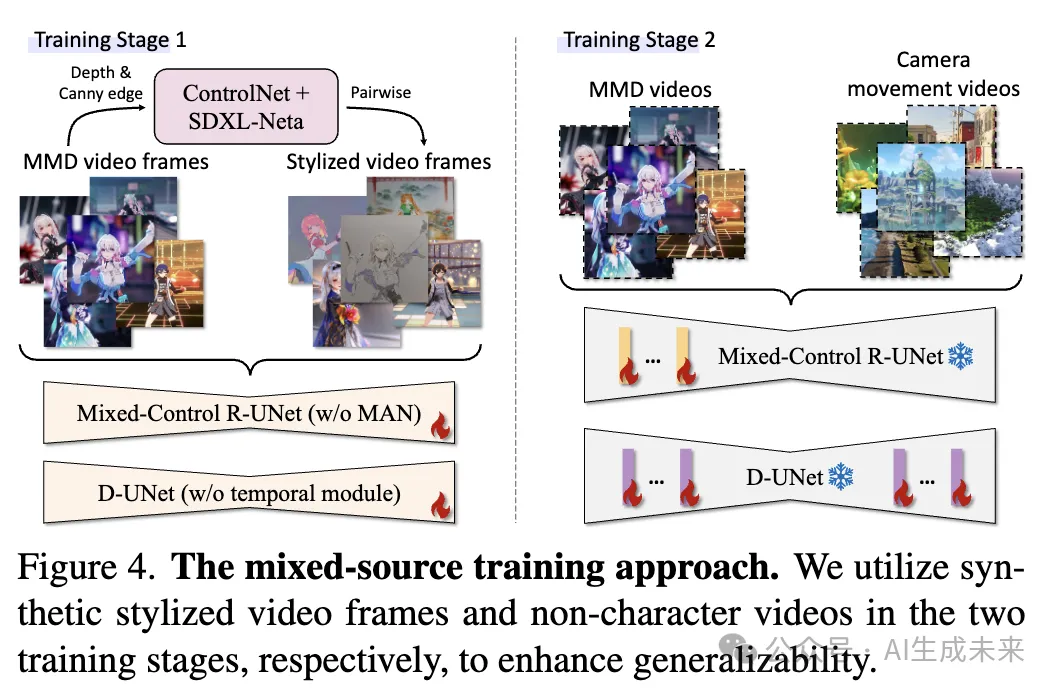

混合源训练方法

考虑到图像动画是一个数据密集型任务,提出一个有效的数据和训练流程与模型本身同样重要。在 MikuDance 中,如下图 4 所示,采用了一个包含两个阶段的混合源训练方法。

在第一阶段,训练在成对的视频帧上进行,此时不引入参考 UNet 的 MAN 模块或去噪 UNet 的时间模块。与现有方法 [14, 37] 不同,是通过在空间维度上拼接初始帧来随机混合风格化的成对帧,并利用深度和边缘控制的动漫 SDXL 模型(称为 SDXL-Neta)来传递艺术风格,同时保留图像内容。此外,为了模拟推理过程中参考人物造型与驱动姿势无关的情况,随机选择与目标序列无关的参考帧。

在第二阶段,我们将 MAN 模块和时间模块加入到混合控制扩散模型中,而其他参数在此阶段保持冻结。此阶段的训练数据由混合的 MMD 视频片段和不包含角色的相机运动视频组成。重要的是,在两个阶段的训练中随机丢弃姿势和运动引导,以增强 MikuDance 的鲁棒性。

实验

数据集 为了训练 MikuDance,收集了一个包含 3,600 个由艺术家创建的 MMD 视频数据集,所有视频均由 3D 模型渲染生成。我们将这些视频分成大约 120,000 个片段,共包含超过 1,020 万帧。此外,在第二阶段的训练中,还加入了约 3,500 个无角色的相机运动视频。为了进行定量评估,使用了未包含在训练集中的 100 个 MMD 视频,并将其首帧作为参考图像。人物姿势和相机姿势提取分别采用 Xpose 和 DROID-SLAM。对于定性评估,所有人物造型均使用 SDXL-Neta 随机生成,且训练期间未见过驱动视频。

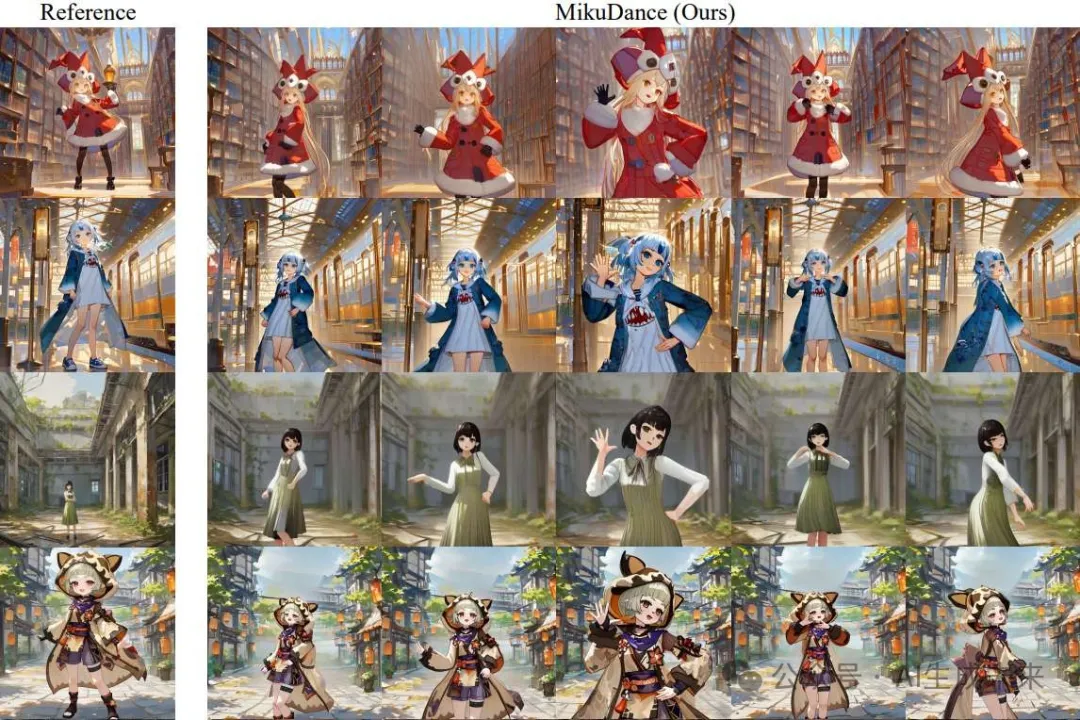

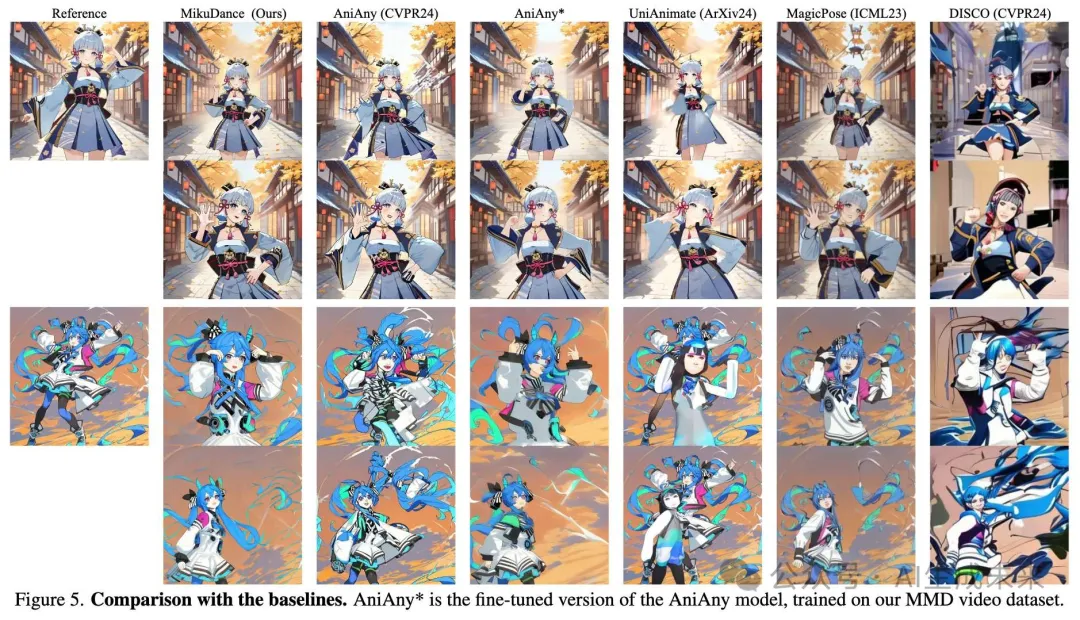

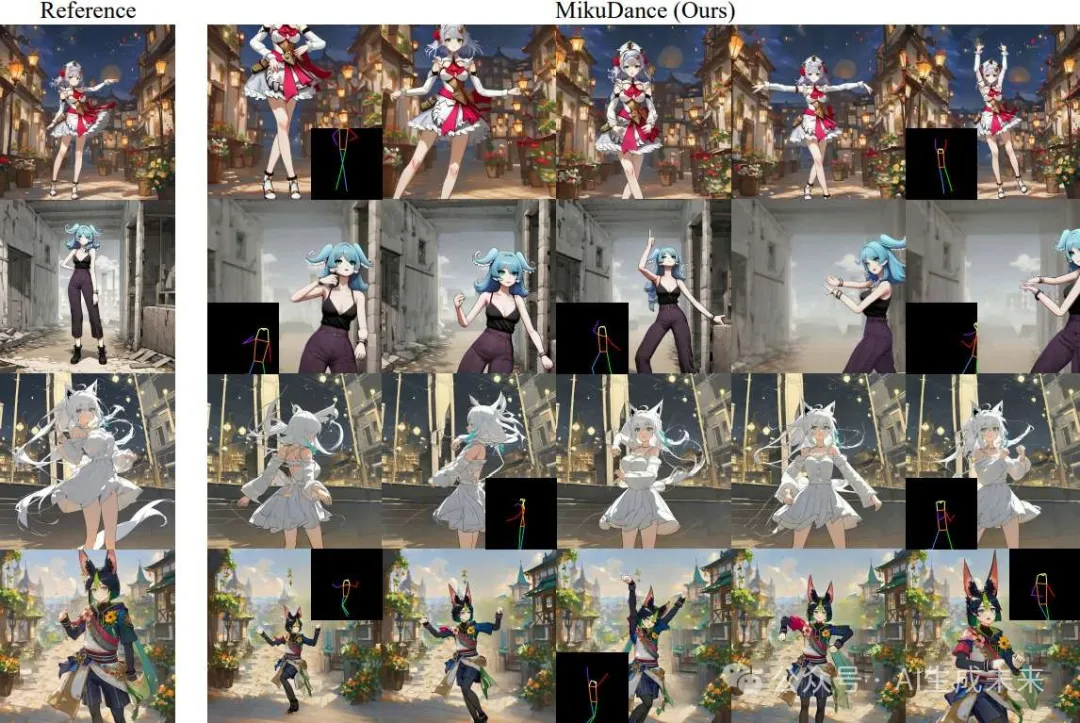

定性结果

与基线方法的比较 将 MikuDance 与最近的人像视频生成方法进行比较,包括 Animate Anyone (AniAny)、DISCO、MagicPose 和 UniAnimate,这些方法均在其官方报告中声称具备对动漫风格角色进行动画生成的能力。此外,通过在 MMD 视频数据集上微调模型实现了 AniAny*。

下图 5 的结果显示,AniAny、MagicPose 和 UniAnimate 无法解决角色形状和比例的错位,导致输出中的角色变形。尽管 DISCO 使用独立的 ControlNet 来处理背景和前景特征,但在为人物造型生成动画时,其结果出现了场景崩溃现象。尽管 AniAny* 在动漫风格数据集上进行了专门微调,但由于未考虑背景场景的运动,其结果在高动态运动中仍然存在模糊,改进有限。值得注意的是,MikuDance 有效处理了复杂的参考和运动引导,呈现出高质量且生动的动画效果。

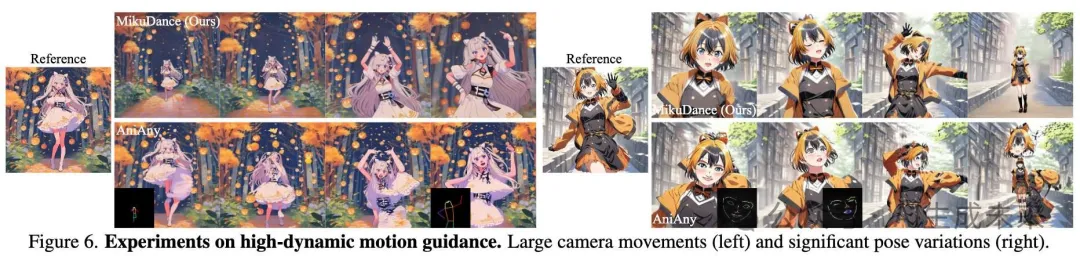

高动态运动

参考引导对齐误差 MikuDance 的另一个重要贡献在于其对参考角色与运动指导的隐式对齐处理。下图 7 展示了两个存在显著空间和尺度错位的示例。在这种情况下,现有方法(如 AniAny)难以有效地为参考角色生成动画,而 MikuDance 成功处理了这些复杂性,生成了连贯的动画。

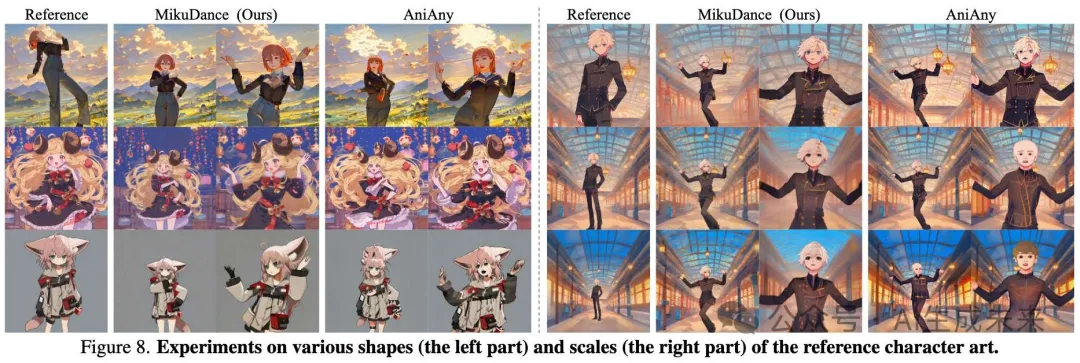

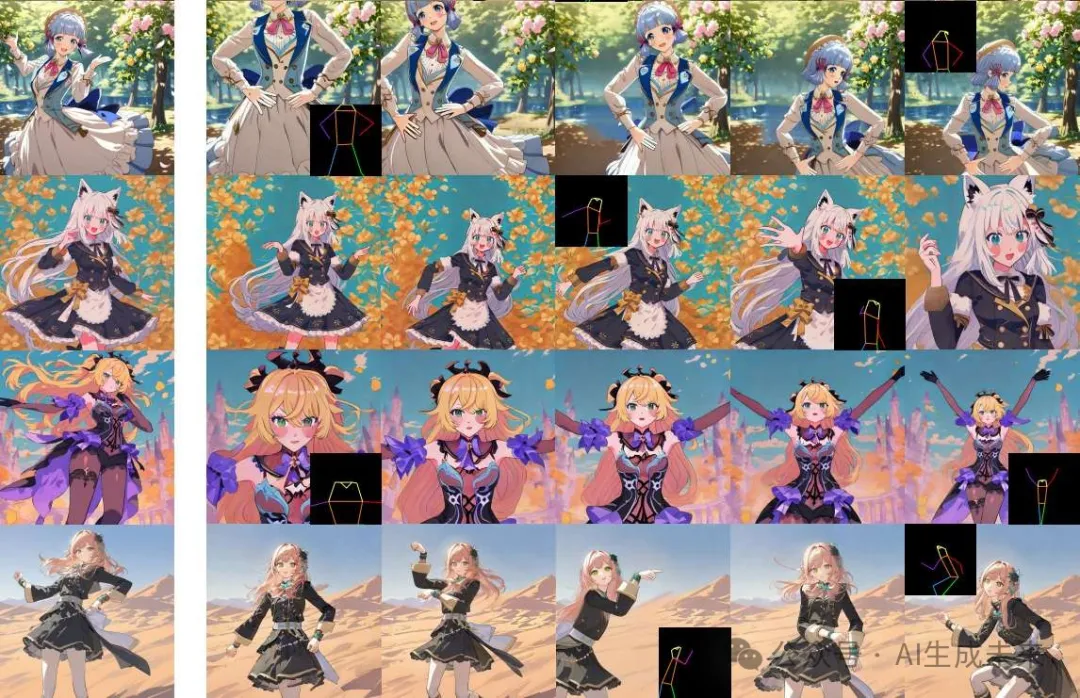

多样化的形状和比例 MikuDance 有效地处理了角色形状和比例的多样性。如下图 8 左侧所示,不同体型、各种姿势和不同服装的角色均能被相同的运动指导精确驱动。在图 8 右侧,MikuDance 展现了其对不同尺度角色的隐式对齐能力,保留每个角色的独特特征并生成合理的动画效果。

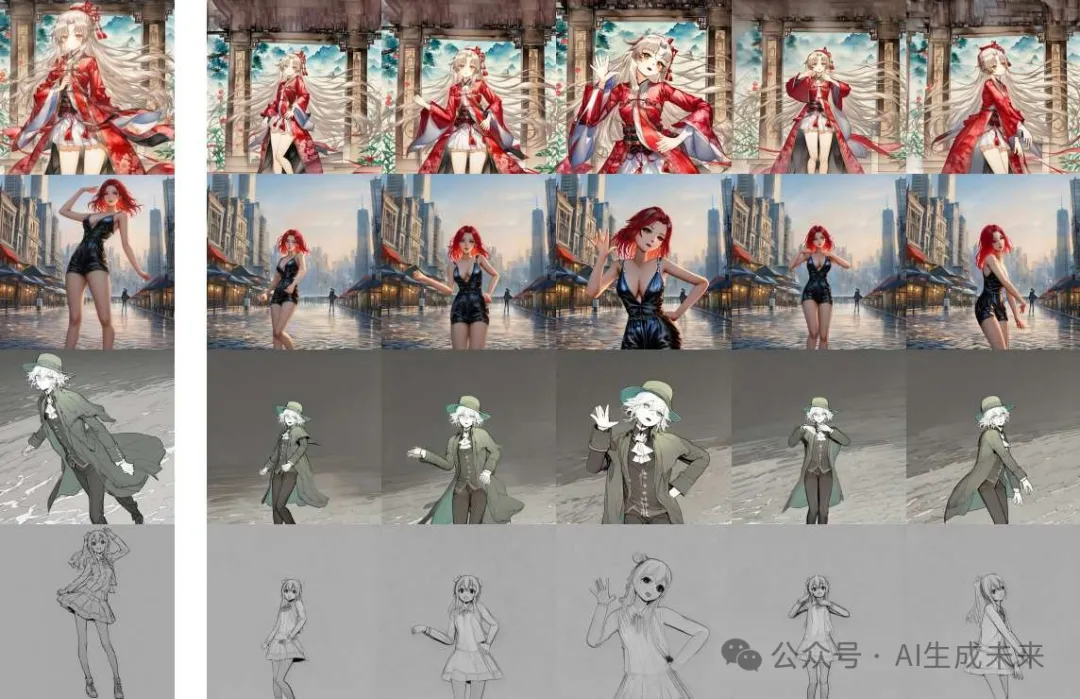

对多种艺术风格的泛化能力 如下图 9 所示,MikuDance 通过我们的混合源训练方法,能够处理多种艺术风格,包括但不限于赛璐璐、古典风格和线条素描。这种高度的泛化能力为实际应用开辟了广阔前景。

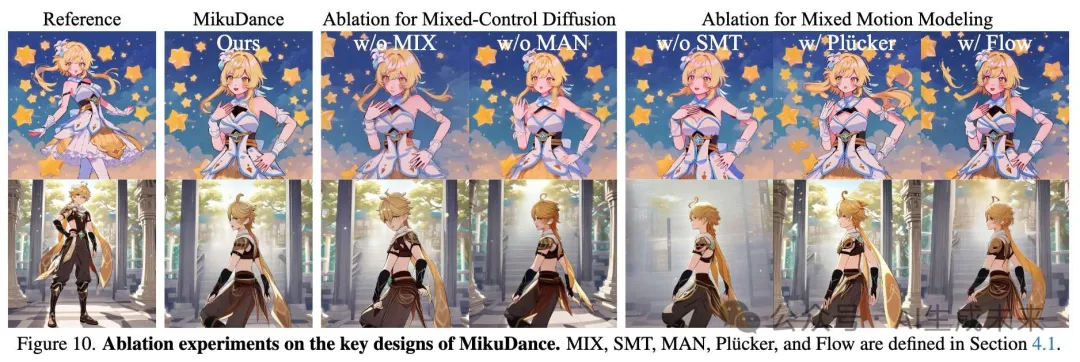

消融实验 本文进行消融实验以验证 MikuDance 的关键设计,包括混合控制架构 (MIX)、MAN 模块和 SMT 策略,结果如下图 10 所示。

为了评估混合控制设计,实现了一个受到 AniAny 启发的pipeline (无 MIX),该pipeline 使用独立的 Reference UNet 处理参考图像,并使用两个 ControlNets 分别适配角色和场景的运动指导。结果表明,这种传统的pipeline 未能处理人物造型和驱动指导之间的尺度差异,导致角色的面部和姿势出现错位。

为了评估 MAN 模块的有效性,实现了一个不使用 MAN 的pipeline (无 MAN),该pipeline 将场景运动与角色运动简单拼接,并将它们一起输入到 Reference UNet 中。虽然这种方法比没有场景运动指导(无 SMT)的pipeline 效果更好,但仍然不如 MikuDance 的效果。这是因为 MAN 模块通过空间感知归一化注入全局运动,有效地补充了局部运动。

为了评估 SMT 策略,本文进行了三项实验:一个不包含场景运动的pipeline (无 SMT),以及两个分别使用 Plücker 嵌入(w/ Plücker)和光流(w/ Flow)替代场景运动的pipeline 。然而,这些替代方法的结果比我们的 SMT 策略差,动态背景出现了明显的伪影和不一致性。SMT 提取的逐像素场景运动被证明是更有效的背景运动引导表示,因为它与角色运动指导具有领域一致性。

与上述消融实验相比,MikuDance 能有效应对动画人物造型中的错位和高动态挑战。

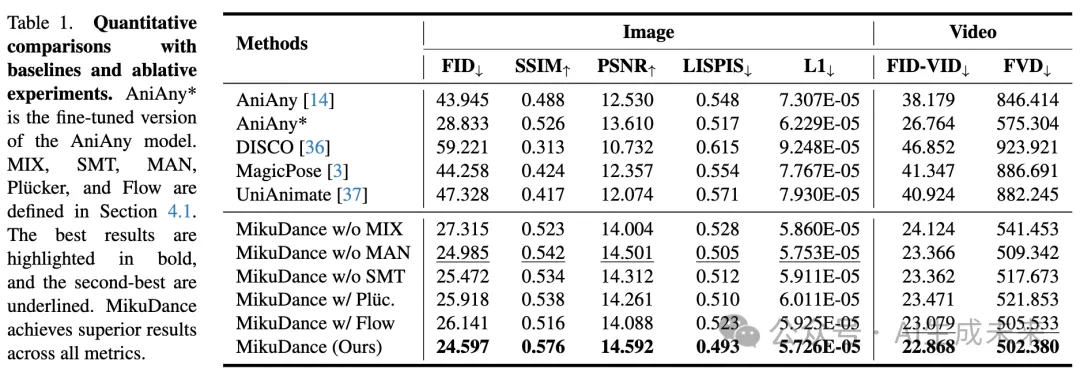

定量结果

下表1展示了 MikuDance 与基线方法之间的定量比较。需要注意的是,本文报告的度量值低于先前研究中的度量值,因为我们测试视频中的整个场景高度动态,与早期数据集中使用的静态背景不同。尽管如此,结果仍然表明,MikuDance 在所有图像和视频指标上都达到了最先进的性能。此外,消融实验结果确认了 MikuDance 关键设计元素的有效性。总之,通过结合提出的混合运动动态技术,MikuDance 可以动画化各种角色,并生成高质量的图像和视频结果。

用户研究。邀请了50名志愿者,并给他们提供了20个视频,用于评估MikuDance 相对于基线方法的表现。每个视频包括一个运动指导和四个匿名动画结果。要求用户对四个结果在整体质量、帧质量和时间质量上进行排名。在排除异常问卷后,各方法的平均排名总结如图11所示。MikuDance 显著优于基线方法,超过97%的用户更喜欢由 MikuDance 生成的动画。

结论

MikuDance,这是一种新型动画pipeline ,旨在为户外人物造型生成高动态动画。MikuDance 融入了两项关键技术:混合运动建模和混合控制扩散。混合运动建模能够在统一的参考空间中表示大规模的角色和场景运动,而混合控制扩散则解决了角色与运动指导之间的错位问题。为了支持多种艺术风格,还采用了混合源训练方法,以增强其泛化能力。大量实验表明,MikuDance 在与基线方法的比较中,达到了最先进的性能。

局限性。一些生成的动画存在背景扭曲和伪影。这一问题源于图像动画中的3D无关挑战,使得在动态相机下的场景重建成为一个病态问题,亟需进一步的研究。

本文转自AI生成未来 ,作者:AI生成未来