回复

LLM-R:基于RAG和层次化Agent落地案例解析 原创

在这个由智能设备主导的时代,维护工作的重要性愈发凸显,几乎成了生产活动的守护神。想象一下,当一台精密的机器在深夜突发故障,而维护手册却像天书一样难以理解,这时,交互式电子技术手册(IETMs)就像一束温暖的灯塔,指引着维护人员安全渡过难关。

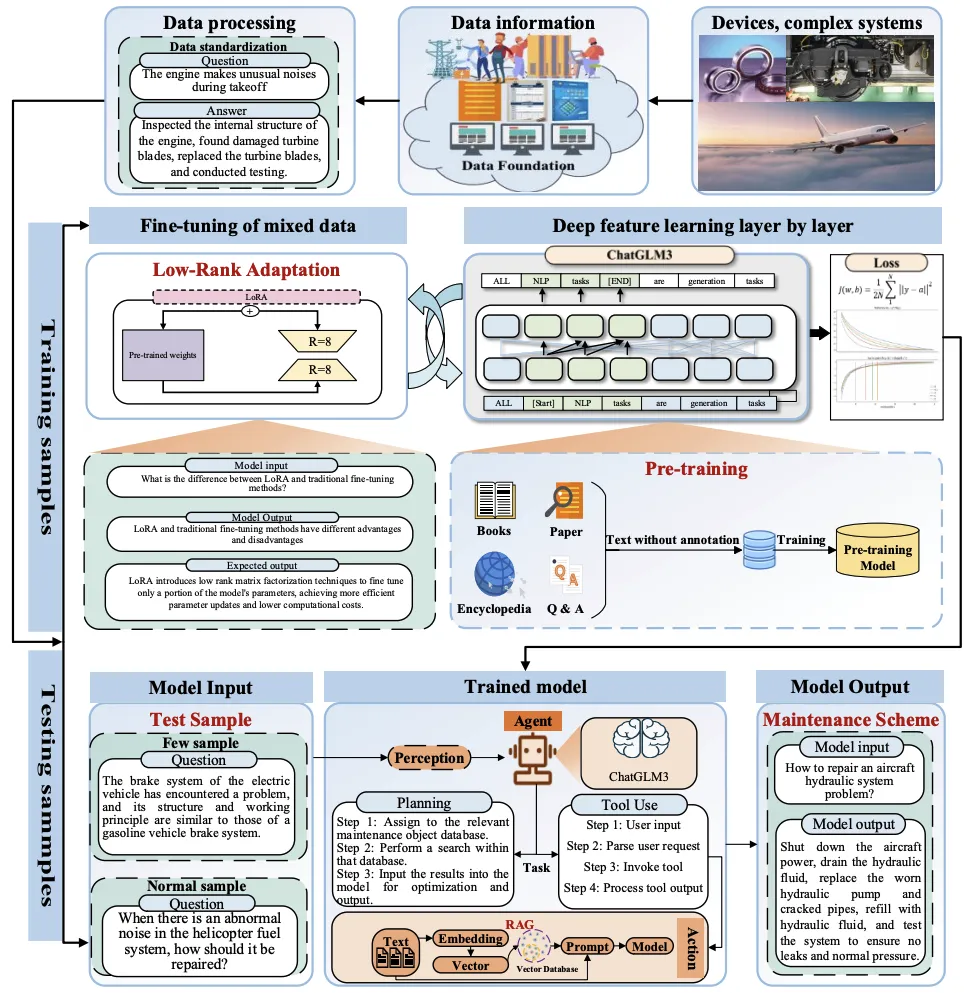

面对从图形用户界面(GUIs)到自然语言用户界面(LUIs)的转变,以及复杂逻辑关系的梳理,传统的IETMs显得有些力不从心。为了应对这一挑战,一个革命性的方法——LLM-R应运而生,它基于大型语言模型,为维护方案的生成带来了全新的思路。

LLM-R的核心创新包括:

- 低秩适应-知识保留(LORA-KR)损失技术:这是一种新颖的数据微调方法,它能够调和混合维护数据,防止知识冲突,从而提升模型在特定维护领域的适应性和推理能力。

- 层次化任务Agent:这种Agent能够深入挖掘任务的细节,确保每一步操作都精准无误。

- 指令级检索增强生成(RAG)技术:这是一种智能检索技术,能够在海量数据中迅速定位到最相关的维护方案,极大地提高了检索的效率和准确性。

LLM-R框架的关键步骤如下:

整个过程的目标是利用LLMs来剖析复杂维护任务,并精确检索相应的维护方案。这种方法不仅优化了传统IETMs中存在的机械输入问题,还显著提升了维护人员处理复杂任务的效率。

LLM-R框架的结构和组件包括三个关键部分:指令级RAG机制、LORA-KR损失和层次化任务基础Agent模块。

- 指令级RAG(Instruction-level RAG):

- 作为智能体的核心工具,指令级RAG技术大幅提升了检索特定维护对象方案的效率和准确性。

- 用户或智能体识别维护任务的关键词后,这些关键词被输入到RAG工具中,转换为模型可以处理的向量格式,并与数据库中向量化的数据匹配,以找到最相似的项。

- RAG在检索阶段使用BERT编码器进行最大内积搜索(MIPS),以选择相关的文本块用于生成输出。

- LORA-KR损失(Supervised Fine-Tuning of LORA-KR loss):

- LORA-KR损失是一种新的正则化方法,它结合了特定任务损失和领域独立知识正则化,以在微调模型时保持预训练知识领域的一致性。

- 包括任务特定损失(ℒCE)和领域独立正则化损失(ℒKL),通过动态调整权重(w)来平衡这两种损失。

- LORA-KR损失通过结合任务特定交叉熵损失和领域独立KL散度正则化损失,在LoRA梯度更新中保持模型对原始预训练领域知识的记忆力,同时适应新任务领域。

- 层次化任务基础智能体(Hierarchical Task-Based Agent):

- 为了克服LLM在处理未知或高度复杂需求时可能出现的幻觉现象,采用了层次化任务基础Agent技术。

- LLM作为“中央大脑”组织和总结信息,而智能体作为“助手”提供额外的具体信息支持。

- 设计了三个具有不同功能的智能体,都使用微调后的ChatGLM3模型作为基础,分别负责解析用户输入、提供定制解决方案和将解决方案返回给基础LLM进行进一步优化。

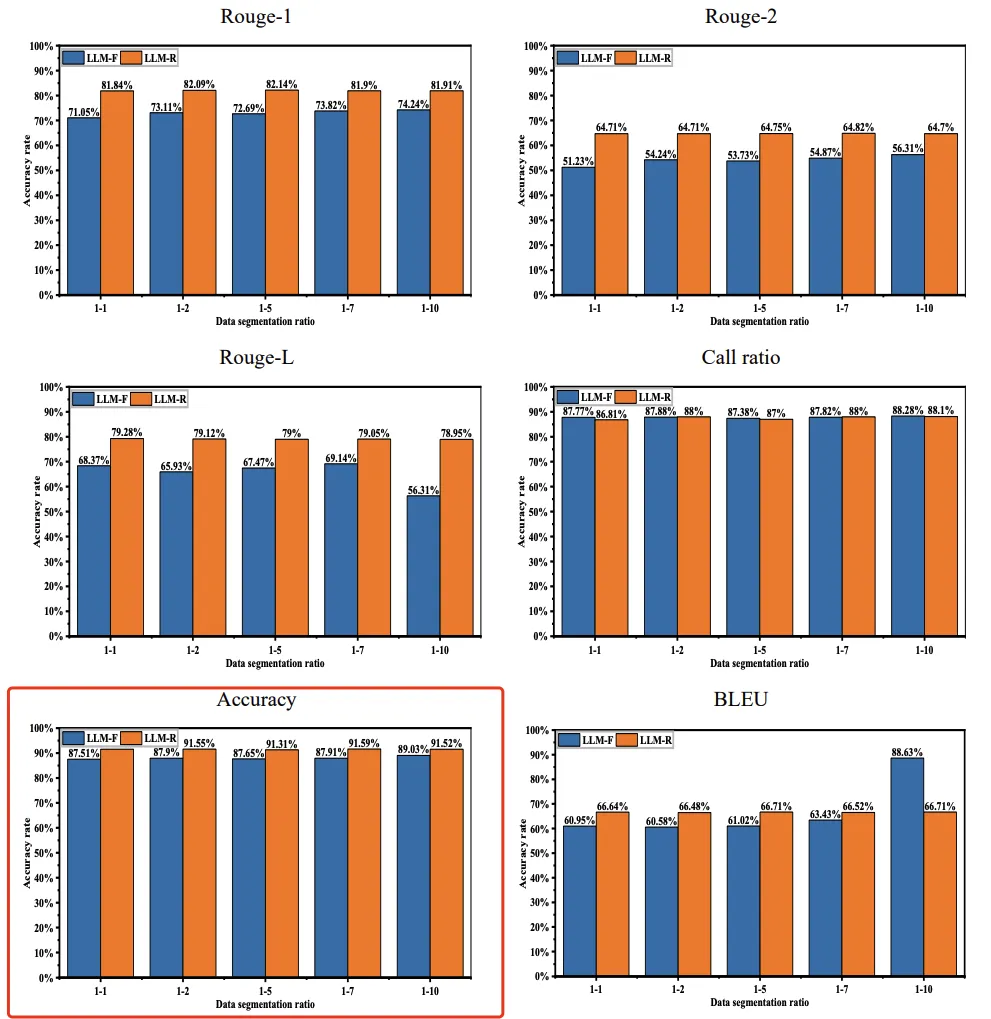

为了验证所提出方法在维护任务中的有效性,使用不同领域的对象构建了一个维护方案数据集。实验结果表明,所提出方法生成的维护方案的准确率达到了91.59%,这表明了其在提高维护方案的智能性和引入设备维护的新技术方法方面的显著改进。

本文转载自公众号哎呀AIYA

©著作权归作者所有,如需转载,请注明出处,否则将追究法律责任

赞

收藏

回复

相关推荐