斯坦福大学:VideoAgent基于大语言模型的视频QA系统

架构

图片

图片

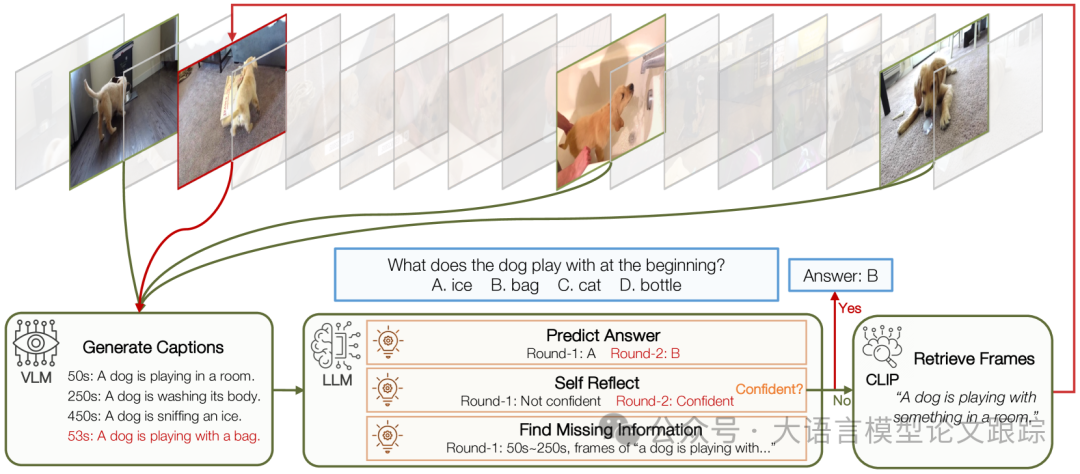

上图是VideoAgent的概览图,VideoAgent通过搜索、聚合视频信息来完成长视频QA。整个系统包括一个核心LLM、VLM(视觉大语言模型)和CLIP工具。

作者受到人类理解长视频的启发,提出了VideoAgent,通过基于Agent的系统来模拟这一过程的系统。

将视频理解过程形式化为一系列状态、动作和观察,其中LLM作为代理控制这个过程。首先,LLM通过浏览从视频中均匀抽样的一组帧来熟悉视频内容的背景。在每次迭代中,LLM评估当前信息(状态)是否足以回答问题;如果不够,它会确定需要什么额外的信息(动作)。随后,它利用CLIP 来检索包含这些信息的新帧(观察),并使用VLM将这些新帧描述为文本描述,从而更新当前状态。这种设计强调了推理能力和迭代过程,而不是直接处理长视觉输入,其中VLM和CLIP作为工具,使LLM能够具有视觉理解和长上下文检索能力。

图片

图片

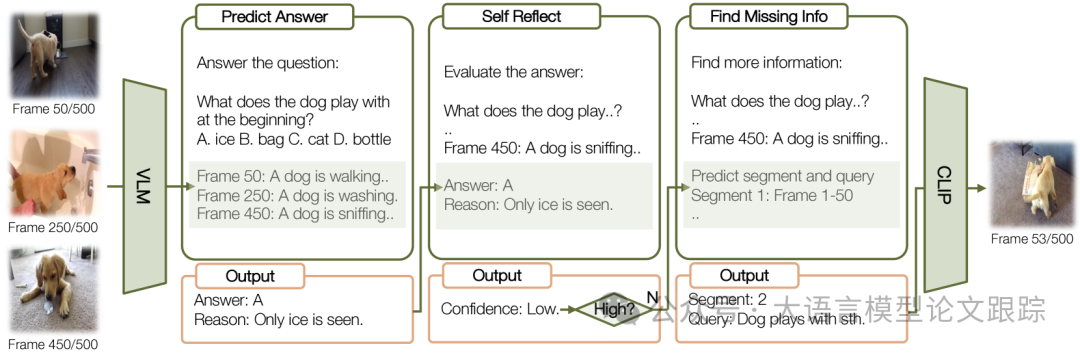

VideoAgent的迭代过程详细视图。每一轮都从状态开始,其中包括先前查看过的视频帧。然后,大型语言模型通过回答预测和自我反思来确定后续的动作。如果需要额外的信息,就会以视频帧的形式获取新的观察结果。

假设LLM确定信息不足以回答问题,并选择搜索新信息。在这种情况下,进一步要求LLM决定需要什么额外信息,以便可以利用工具来获得额外信息。由于视频中某些信息可能出现多次,所以进行分段级别的检索而不是视频级别的检索,以增强时间推理能力。

例如,假设问题是“男孩离开房间后在沙发上留下了什么玩具?”,并且我们在帧 i 中看到了男孩离开房间。如果我们使用查询“显示沙发上的玩具的帧”进行检索,则可能在帧 i 之前存在包含“沙发上的玩具”的帧,但它们与回答问题无关。

Arxiv[1]

引用链接

[1] Arxiv: https://arxiv.org/abs/2403.10517

本文转载自大语言模型论文跟踪,作者:HuggingAGI