LoRA或许暗藏玄机 | 数字也会骗人?GPT-4都会说9.11>9.9,人工智能的"数学残障"有救了吗?

大模型领域的发展日新月异,每天都有许多有趣的论文值得深入品读。下面是本期觉得比较有意思的论文:

- LoRA或许暗藏玄机

- 数字也会骗人?GPT-4都会说9.11>9.9,人工智能的"数学残障"有救了吗?

1、LoRA或许暗藏玄机

近期,一项重磅研究揭示了AI训练中广受欢迎的LoRA方法可能存在隐患。虽然LoRA能让模型训练时节省90%以上的显存,在目标任务上表现堪比完整微调,但研究人员发现这种"看似完美"的方法背后,或许并不如表面那么美好。

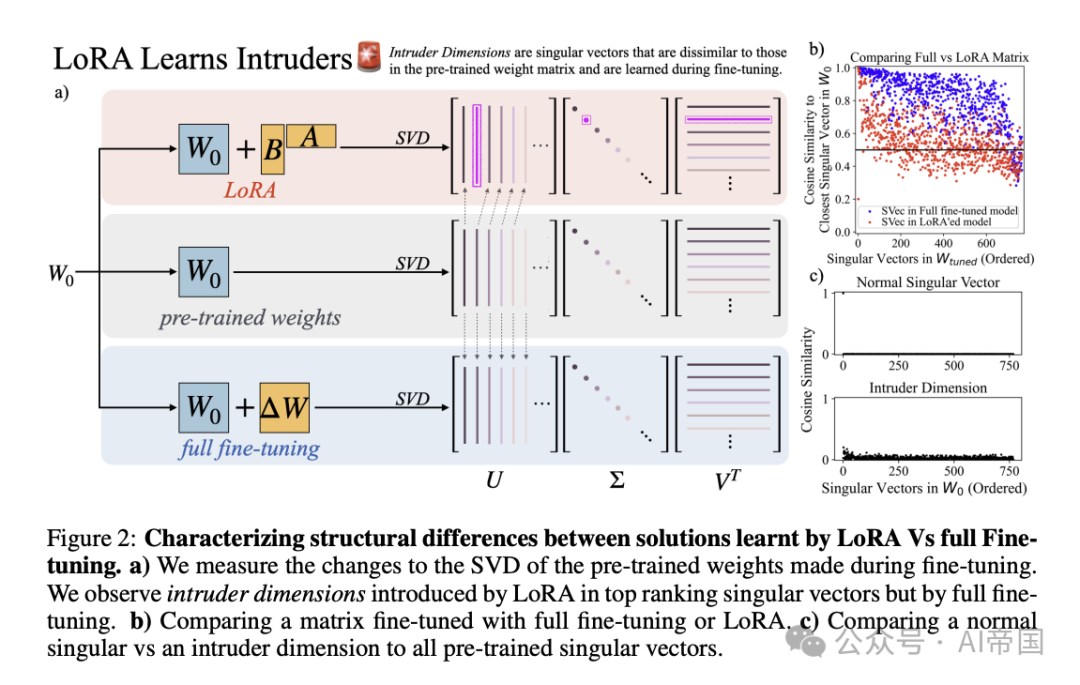

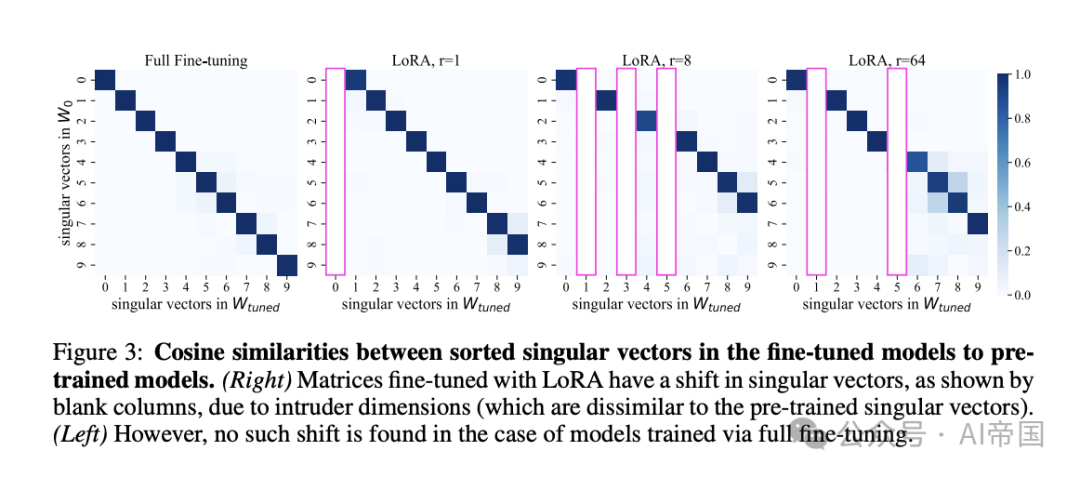

研究团队通过对模型权重矩阵的深入分析发现,LoRA训练出的模型中存在一些特殊的"入侵维度"(intruder dimensions)。这些维度就像是模型中的"异质成分",虽然不影响模型在目标任务上的表现,但会导致模型"忘记"更多预训练时学到的知识,并且在持续学习多个任务时表现不够稳定。

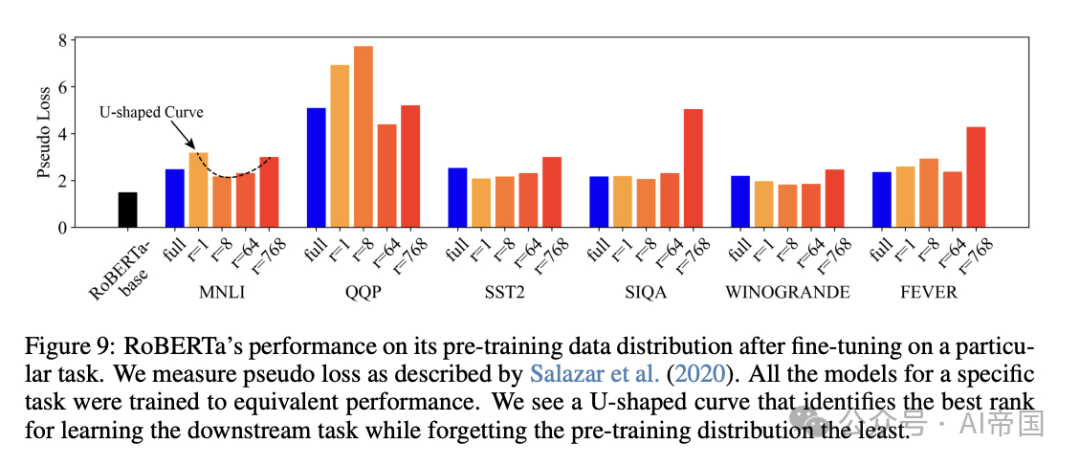

有趣的是,研究人员发现,当增加LoRA的秩(rank)时,这个问题会得到明显改善。特别是当秩达到64时,模型的行为会更接近传统的完整微调方法。这就像是在"节省"和"全面"之间找到了一个更好的平衡点。

这项研究给AI从业者带来了重要启示:在选择使用LoRA时,不能只关注显存占用和目标任务的表现,还需要考虑模型的泛化性能。同时,适当增加LoRA的秩可能是一个值得考虑的优化方向。这为如何更好地应用LoRA提供了新的思路。

- 论文标题:LoRA vs Full Fine-tuning: An Illusion of Equivalence

- 论文标题:https://arxiv.org/abs/2410.21228v1

2、数字也会骗人?GPT-4都会说9.11>9.9,人工智能的"数学残障"有救了吗?

大语言模型(LLM)近来可以解答奥数题、高考数学,甚至能做研究生难度的数学题。但你可能想不到,这些"数学天才"却在最基础的数字理解上栽了跟头——它们居然会认为9.11比9.9大!这就好比一个解题思路完全正确的学霸,却在最后的计算环节总是粗心大意地出错。

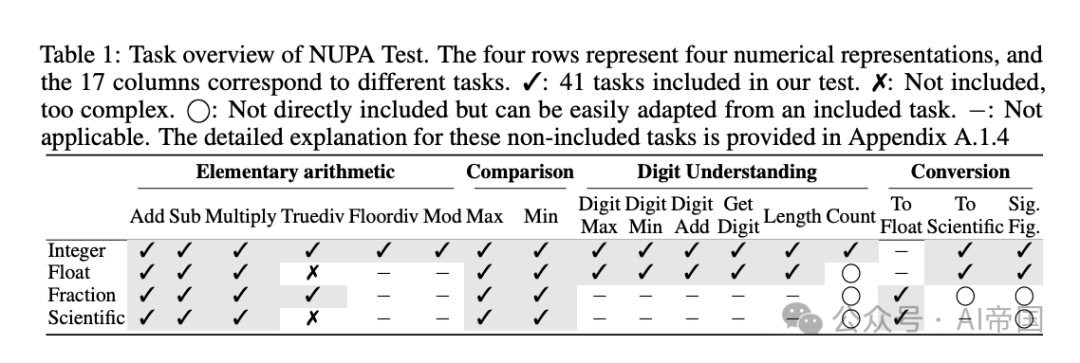

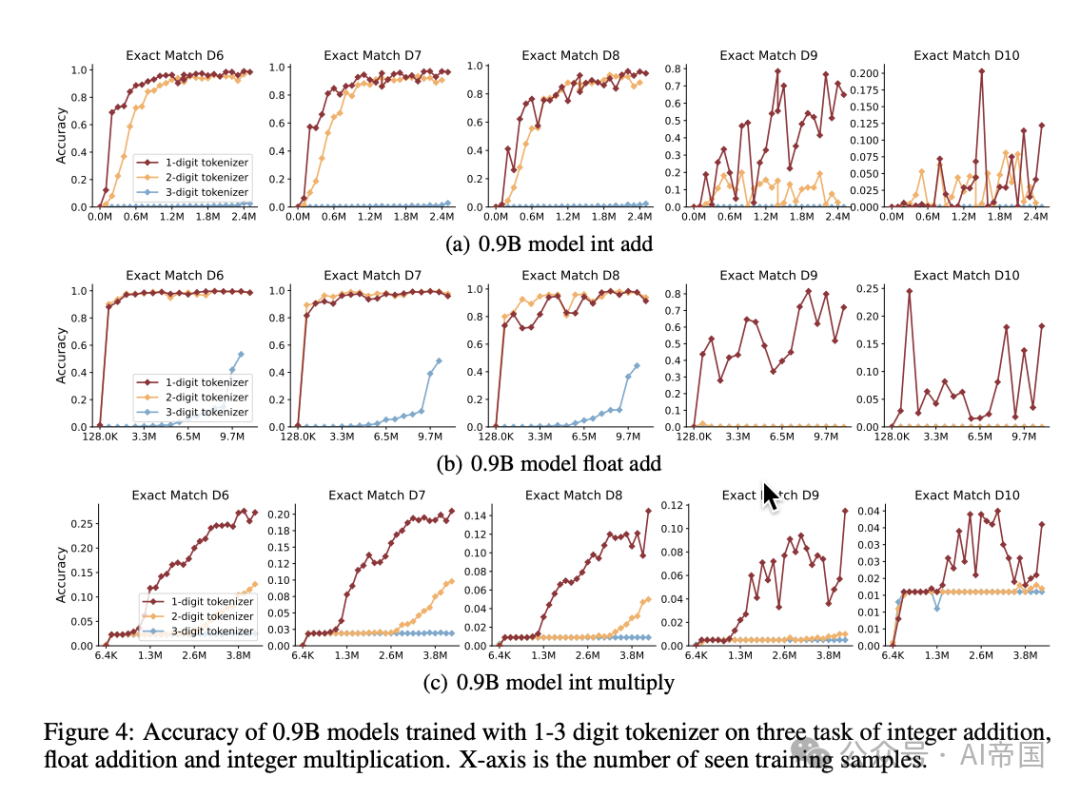

为了系统研究这个问题,来自北京大学等机构的研究人员开发了一个全面的测试基准。他们从小学到高中的数学课程中提取了4种数字表示方法(整数、小数、分数、科学计数法)和17种基础运算任务,创建了41组测试。这些看似简单的任务,即使是最新的GPT-4和Llama-3.1这样的顶尖模型也频频失手,尤其是在稍微复杂一点的计算(如乘法、取模)或处理整数之外的数字表示时。

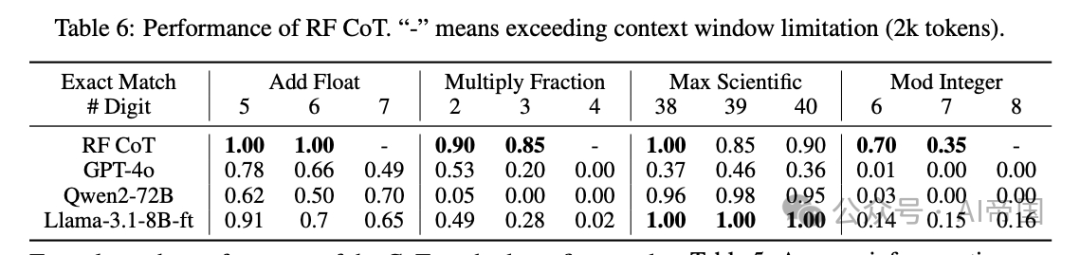

研究团队尝试了三种改进方案:优化预训练阶段的数字处理能力、对现有模型进行微调、使用链式思考(CoT)技术。有趣的是,简单的微调确实能显著提升模型的数字理解能力,但那些专门设计用来增强数字处理的技巧反而会适得其反。这就像给一个已经形成思维定式的学生重新教授基础知识,反而会打乱他原有的认知体系。

这项研究揭示了一个重要但经常被忽视的问题:在人工智能追求解决高深数学问题的同时,最基础的数字运算能力反而成了"短板"。这就好比一个会解微积分的学霸,却在1+1等基础题上犯错。不过好消息是,研究人员已经开始认真对待这个问题,相信在不久的将来,AI的"数学残障"会得到根本性的改善。

论文标题:Number Cookbook: Number Understanding of Language Models and How to Improve It

论文链接:https://arxiv.org/abs/2411.03766

本文转载自 AI帝国,作者: 无影寺