NeurIPS`24 | 超25万对助力具身智能!3D场景大规模多模态情境推理数据集MSQA | BIGAI 精华

文章链接:https://arxiv.org/pdf/2409.02389

项目链接:https://msr3d.github.io/

亮点直击

- 引入了MSQA,这是一个大规模的3D情境推理数据集,包括251K个情境问答对,利用可扩展的自动化数据生成流程,在多样化的真实场景中采集。

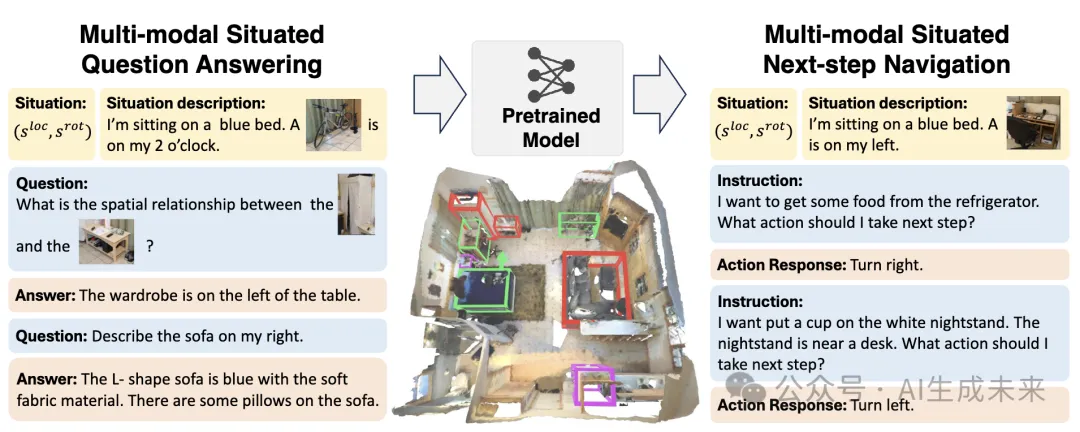

- 提出使用交替多模态输入设置进行模型学习和评估,建立了两个全面的基准测试任务,MSQA和MSNN,以评估模型在3D场景中进行情境推理和导航的能力。

- 本文进行了全面的实验分析,将现有模型与本文提出的基准模型MSR3D在MSQA和MSNN上进行比较。本文强调了处理多模态交替输入和情境建模的重要性。通过数据扩展和跨域迁移实验,证明了在MSQA数据上进行预训练的有效性,以及MSR3D在3D场景中的多模态情境推理潜力。

总结速览

解决的问题

现有的场景理解数据集和基准测试在数据模态、多样性、规模和任务范围方面存在局限性,无法充分支持对3D场景中情境理解的研究。

提出的方案

提出了多模态情境问答 (MSQA) 数据集和基准测试,通过3D场景图和视觉-语言模型大规模采集数据,以提升模型对情境的推理能力。此外,提出了多模态情境下一步导航 (MSNN) 基准测试,用于评估模型在情境推理中的导航能力。

应用的技术

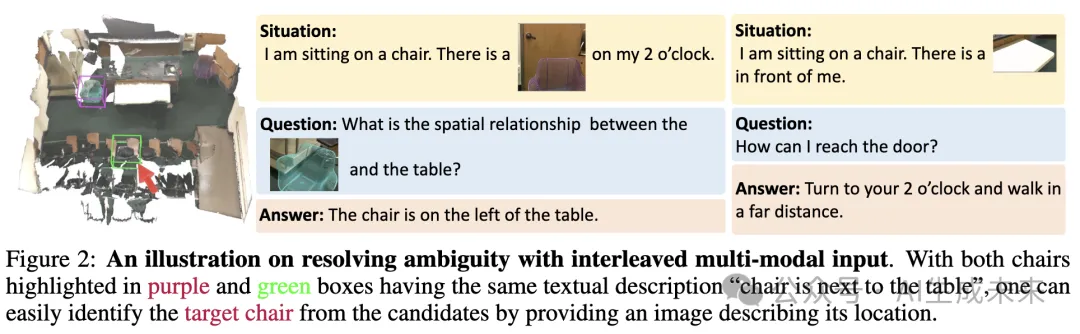

- 多模态输入设置:引入文本、图像和点云数据的交替输入,以提供更清晰的情境描述,避免单一模态导致的模糊。

- 数据扩展与跨域迁移实验:利用MSQA进行模型预训练,以提升模型的情境推理能力。

达到的效果

对MSQA和MSNN的综合评估显示了现有视觉-语言模型的局限性,验证了处理多模态交替输入和情境建模的重要性。数据扩展和跨域迁移实验进一步表明,MSQA数据集在预训练中的应用显著提升了模型的情境推理能力。

多模态情境推理数据集

本文提出了一种新颖且可扩展的方法,用于收集高质量的3D情境推理数据,并遵循三项核心原则:

- 确保情境的全面性和多样性

- 设计高度依赖情境的问题并提供准确答案

- 支持多模态交替输入格式以避免歧义

数据收集

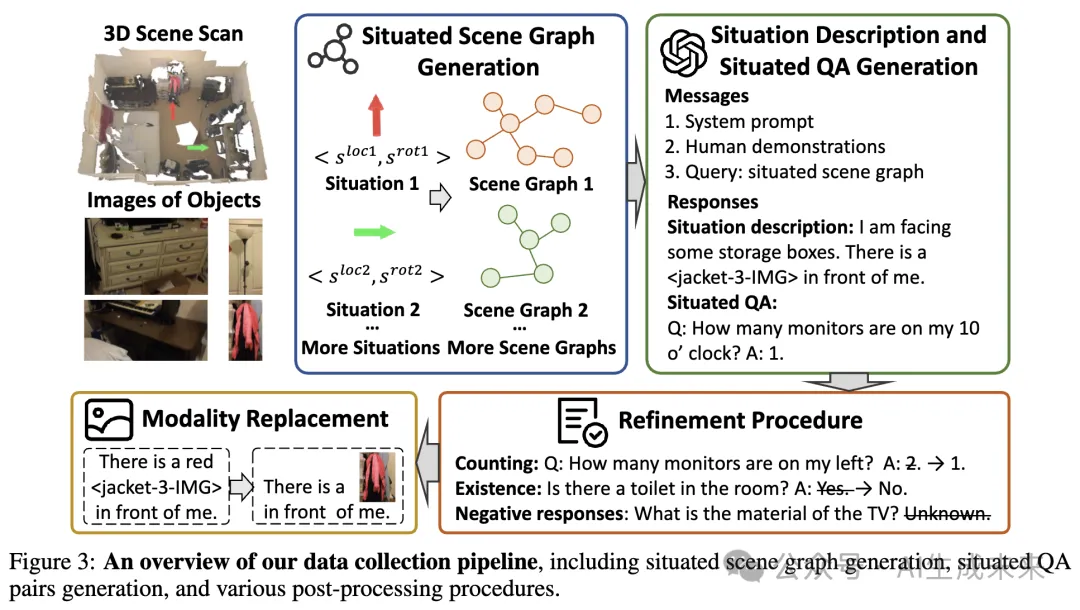

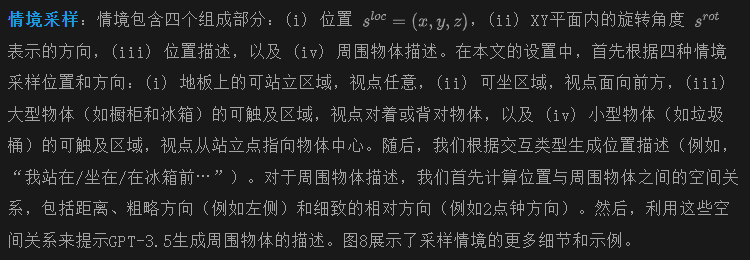

如下图3所示,本文精心设计了一个基于LLM的自动数据收集流程,包含三个阶段:情境采样、问答对生成和数据精炼。本文的数据收集目标是确保生成数据的高质量。以下是流程的详细介绍。

- 问答对生成:类似于先前的工作[28, 30],采用场景图来提示LLM生成数据。首先使用剪裁的物体图像提示GPT-4V以实例化场景图中的每个物体及其属性。然后,在初始化后的物体之间进行两两计算以推导出关系,这些关系可以分为五种类型:接触的垂直关系(如支撑)、非接触的垂直关系(如在上方)、水平距离(如靠近)、水平邻近关系(如右侧)和多物体关系(如在…之间)。

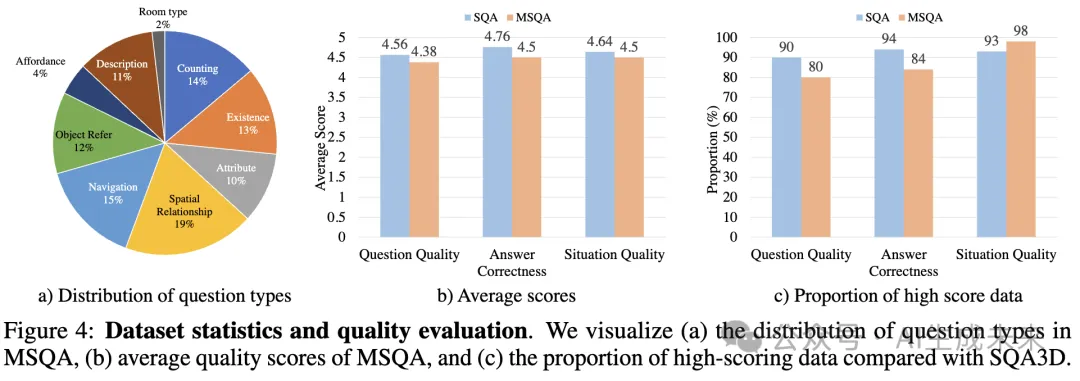

在将这些关系建立为场景图中的边后,根据采样情境的位置和视角调整水平邻近关系,以获得情境场景图。基于这些情境场景图,设计系统提示语并手工制作示例以提示GPT-3.5生成情境问答对。本文关注9种不同的问题范围,涵盖物体属性、计数、空间关系、导航动作等(如下图4(a)所示)。在提示过程中,指示LLM输出问题类别。为进一步增强LLM生成的问答对的多样性,我们使用不同的种子示例组合,并根据不同的距离样本生成不同的情境子场景图用于问题生成。

数据精炼为了提升生成的情境问答对的质量,进行了精炼流程,包括两个主要方面:

- 对情境场景图,检查属性和关系的分布,以减轻可能导致幻觉的潜在偏差;

- 手动审查LLM生成的问答对以验证其准确性,并基于正则表达式设计过滤函数来检测和纠正潜在错误。

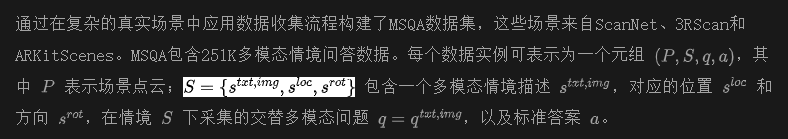

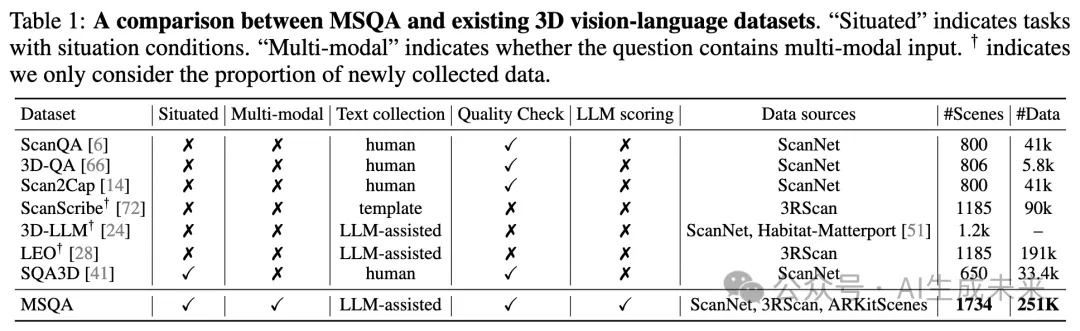

先前的研究[28, 68]已强调数据平衡的重要性,通过筛选不平衡的问答对来平衡生成数据的答案分布。通过这些步骤,收集了跨ScanNet、3RScan和ARKitScenes的251K多模态情境问答对。下表1和提供了MSQA与现有数据集的对比及更多统计数据。

数据质量控制

尽管基于LLM的数据收集流程具有可扩展性,但生成数据的质量仍然是主要关注点,特别是在3D视觉-语言任务中,语言的锚定具备挑战性。为应对这些问题,进行了人类研究,将生成的数据与SQA3D中的人工标注数据进行比较。具体而言,从MSQA和SQA3D中各抽取100条数据实例并混合供人类评估。评估员被要求从三个方面为数据打分:

- 情境描述的自然性和清晰度

- 问题的情境依赖性和清晰度

- 答案的准确性和完整性

每个方面的评分范围为1到5分。评估流程的详细信息见附录B。评估结果如上面图4(b)所示,显示MSQA在各方面的质量与SQA3D相当。此外,图4(c)表明,MSQA中高评分数据(即得分≥4的质量数据)的比例与SQA3D相匹配或超过SQA3D。这表明了MSQA的质量以及数据精炼流程的有效性。

评估基准

本节详细描述了用于多模态情境推理的评估任务。具体而言,考虑了以下两个基准任务:

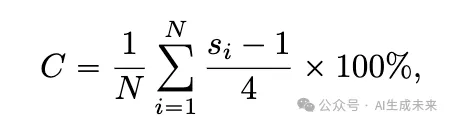

多模态情境问答 (MSQA)

在MSQA中评估模型在情境感知和处理交织的多模态输入方面的能力。具体来说,给定一个多模态情境描述,模型需要回答一个基于3D场景的文本-图像交织问题。由于回答是开放式的,以往的指标(如分类准确率和完全匹配准确率)无法准确评估。为了解决此问题,参考OpenEQA使用基于GPT的评估指标来评估开放式回答,并扩展其提示集以适用于3D情境推理。总体上,报告了包含N个样本的测试集的正确率评分C,其计算方式如下:

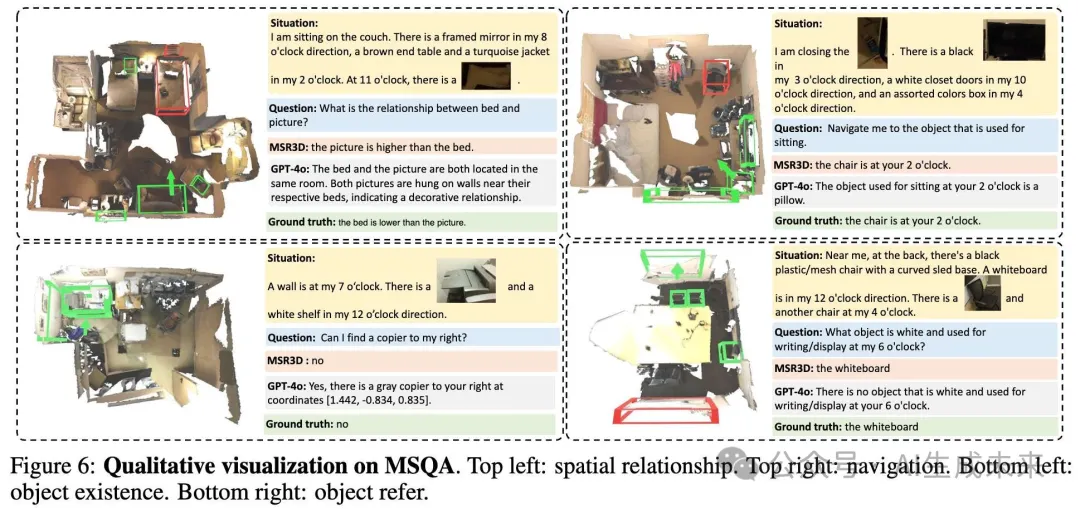

多模态情境下一步导航 (MSNN) 除了MSQA外,还希望通过具身AI任务(如导航)评估模型的情境感知能力。为将长时规划与情境理解分离,本文提出了MSNN任务,聚焦于在当前情境和导航目标的基础上预测最佳的即时下一步动作。具体来说,给定代理的当前交织多模态情境描述(包括位置、方向和文本描述)、目标文本描述和整体场景,我们指示模型以文本形式回答通向目标的下一步动作。

为评估,MSNN数据采用类似情境QA生成流程并包含四个关键步骤:

- 起始情境采样

- 目标采样

- 最优路径预测

- 计算真实的即时下一步动作

最优路径由A*算法生成,以在平面图上规划从起始位置到目标的最短路径,而即时下一步动作则依据相对起始情境的最优路径方向确定。最终,生成了一个包含34K个MSNN样本的数据集,覆盖ScanNet中的378个3D场景。此数据集进一步用于监督微调和MSNN评估。

实验

模型设置

受3D通用模型、LLM和VLM最新进展的启发,本文提出了几种适用于MSQA和MSNN的潜在方法,包括可直接零样本应用于这些任务的模型,以及需要指令调优的模型。

零样本模型

本文研究了现有LLMs和VLMs(例如GPT-3.5和GPT-4o)在多模态情境推理中的能力。鉴于这些模型在处理3D点云方面的局限性,我们将3D场景的文本描述作为输入提供给这些模型。具体而言,场景被描述为对象集合,每个对象都包含类别、位置、大小和属性等特征。然后将该场景的文本描述与交织的多模态情境描述、指令和问题结合,进一步由LLM或VLM处理。对于纯文本模型(如LLMs),用对象类别替代对象的图像作为模型输入。此外,还引入了Claude-3.5-Sonnet以消除GPT家族内的潜在偏差。

指令调优

基于3D通用模型的最新进展,对现有的3D视觉-语言基础模型在MSQA和MSNN任务上进行微调。选择LEO作为代表模型,因其在3D视觉-语言理解和推理中的卓越表现。由于LEO不支持交织的多模态输入,将输入图像替换为其对应的对象类别,类似于零样本模型。此外,还扩展了LEO,以适应交织的多模态输入,形成了我们强大的基线模型MSR3D,专用于情境推理和导航。MSR3D通过根据代理的情境对点云输入进行平移和旋转来建模情境。选择MSR3D作为后续消融研究和分析的主要模型。更多关于MSR3D设计的细节详见附录C。

评估结果

本节提供了模型在MSQA和MSNN任务上的评估结果。报告了两个任务测试集的平均正确性评分。此外,还考察了不同情境和问题输入模态(Input)、3D场景表示(Scene)以及模型设置(Setting)。对于MSNN,将预训练数据(PT data)的选择作为额外的变量来验证MSQA在具身任务中的实用性。

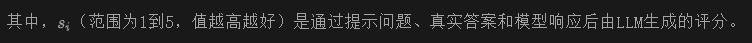

多模态情境问答 (MSQA)

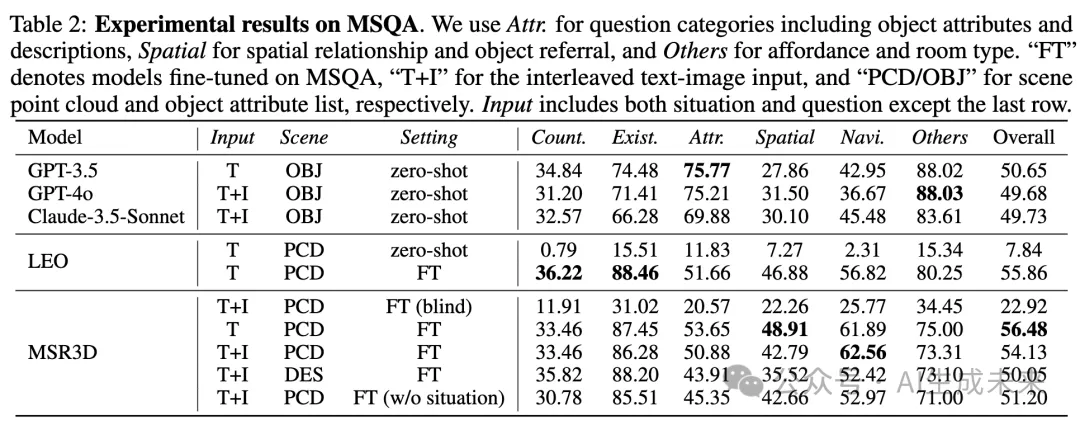

下表2中展示了MSQA的实验结果,并报告以下发现:

- 零样本模型在情境空间推理方面表现不佳。零样本模型擅长回答常识性问题(如可操作性和房间类型等分类为“其他”的问题),这可能得益于LLMs在自然语言任务中的优势。由于对象属性被列出,这些模型在属性和描述方面的表现优于微调模型。然而,它们在处理空间关系和导航问题时表现欠佳,凸显出其在多模态情境推理中的局限性。

- 情境建模在情境空间推理中至关重要。像LEO这样的3D视觉-语言模型在未在MSQA上微调的情况下表现不佳,反映出其作为通用基础模型的局限性。我们的模型在不使用交织输入的情况下在空间关系和导航任务上优于LEO,这突显了我们的情境建模方法的重要性。同时,MSR3D在未使用3D场景输入(即“盲模式”)微调时性能大幅下降,这表明情境意识和3D场景理解在MSQA任务中的重要性。

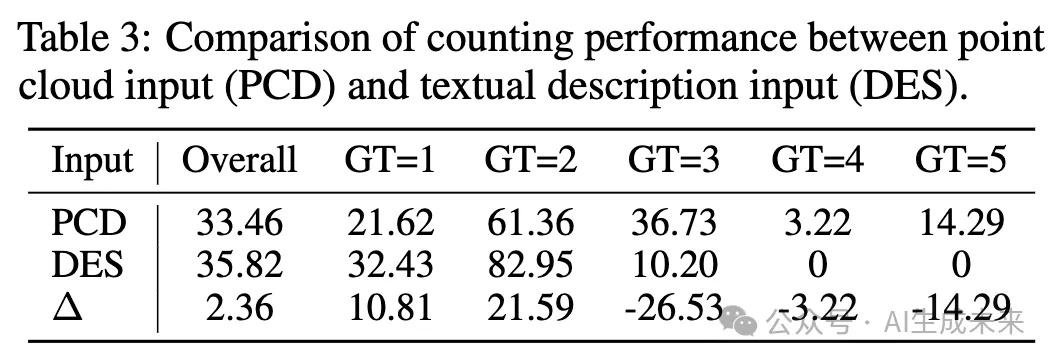

- 3D点云相较于文本描述更适合作为场景表示。本文进行了一项仅使用文本描述的额外实验,这些文本描述是通过基于情境场景图的GPT-3.5提示生成的。用于生成文本描述的情境与MSQA中的QA对一致。上表2中的结果(“DES”行)显示,在仅使用文本描述时,特别是在对象属性、空间关系和导航方面,性能显著下降。进一步探讨了“DES”在计数任务上表现更佳的原因。下表3中显示,对于GT < 3的情况,“DES”表现更好,但对于GT ≥ 3时表现较差。这是因为“DES”在输入中明确描述了目标对象。然而,当目标对象数量超过一定阈值时,由于上下文长度的限制,部分目标对象可能被截断。综上所述,结果表明,相较于文本描述,3D点云在情境推理中是一种更为有效的表示方式。

情境组件对情境推理至关重要

为了揭示情境组件在微调(FT)模型中的有效性,我们添加了一个完全移除情境组件的FT基线,保留3D场景和问题作为输入。前面表2(无情境)中的结果显示,去除情境组件后性能显著下降。特别是,导航相关问题的下降更为显著,这与MSNN的评估结果相一致,突显了情境组件的重要性。

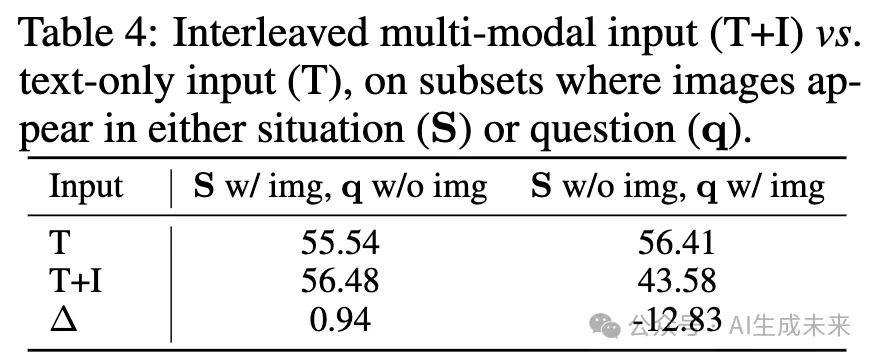

交织多模态输入为情境推理带来了新挑战

尽管交织多模态输入具有优势,观察到MSR3D(T+I)的表现略逊于仅文本输入(T)。为进一步分析这一细微差异,我们从测试集中提取了两个子集,使图像仅出现在情境或问题中。下表4中报告了这两个子集的评估结果,显示“T+I”在图像仅出现在问题中的子集上表现显著下降。我们推测,将图像纳入问题可能加大了情境推理的难度,因为从图像中识别查询对象需要额外的定位能力。

多模态情境下一步导航 (MSNN)

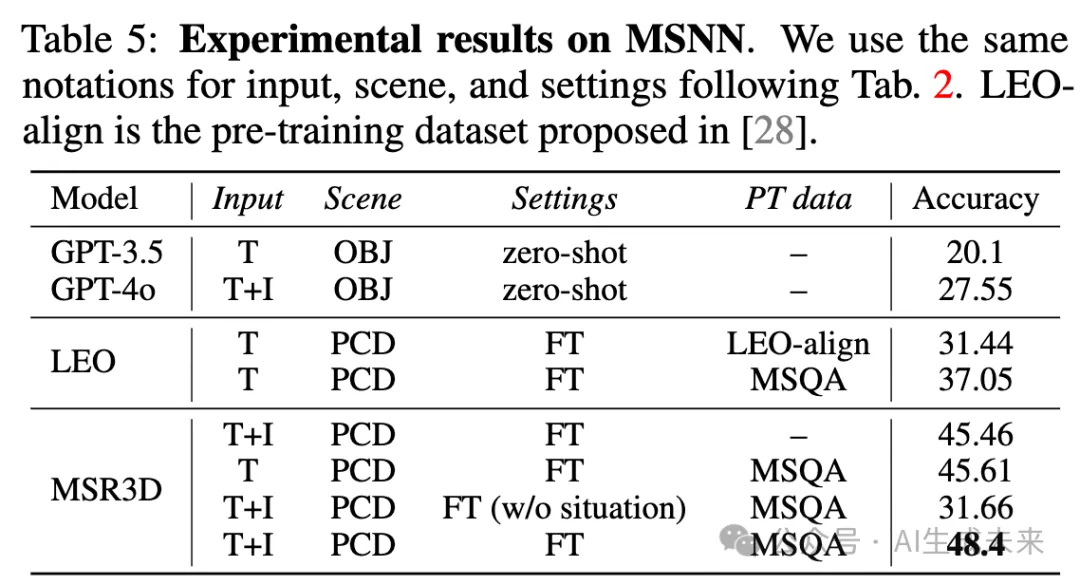

在下表5中展示了MSNN的实验结果,并报告以下发现:

MSNN任务具有挑战性

表5的结果显示,最新的LLMs(如GPT-3.5和GPT-4o)和3D视觉语言模型在解决MSNN任务时都面临显著的挑战。这表明了MSNN任务在3D情境推理和具身AI研究中的价值。

MSQA作为具身AI预训练源的有效性

我们发现,将MSQA用于预训练(对LEO和MSR3D均有效)显著提升了MSNN任务的表现,说明MSQA作为解决具身导航任务的预训练源的有效性。

MSR3D的情境建模方法有效

MSR3D(T),结合情境建模,在导航行为预测中显示出显著更高的准确性(相比LEO(T)高出8.56%)。这验证了我们情境建模方法的有效性。此外,我们通过屏蔽代理的位置和方向来测试无情境的MSR3D,结果表现显著下降(见表5的无情境结果),进一步证明了情境信息的重要性,同时MSR3D能够有效利用情境信息。

附加分析

扩展效应

通过在不同数据规模下训练MSR3D来探索MSQA的扩展效应。研究了扩展的三个因素:QA(随机下采样QA对)、情境(下采样QA对和情境)以及场景(下采样QA对和场景)。如图7所示,随着这三个因素的扩展,模型性能呈现持续提升的趋势,显示了显著的扩展效应,表明进一步扩展的潜力。

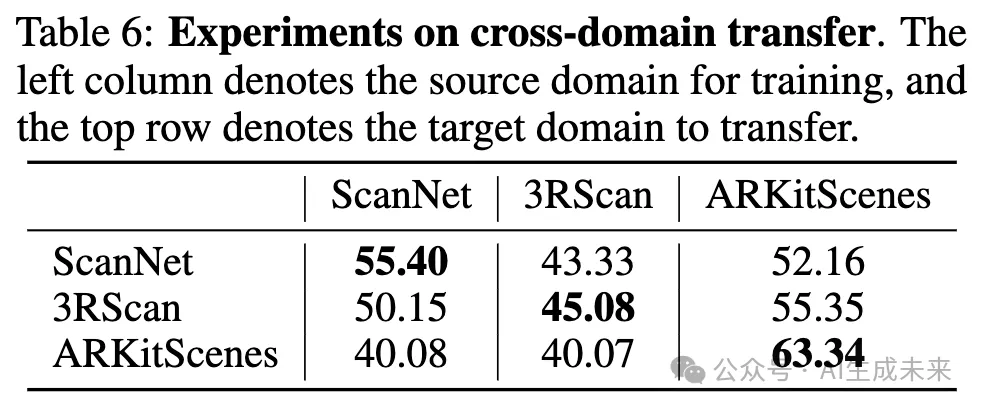

跨领域迁移本文将MSQA数据分为三个子集,分别为ScanNet、3RScan和ARKitScenes,并通过在每个子集上训练MSR3D并在所有子集上进行评估来研究跨领域迁移。下表6的结果显示,每个子集上最佳的表现是通过在同一领域内训练(加粗的部分),而非跨领域迁移,展现了领域间的差距。在ARKitScenes上训练的模型在跨领域迁移中的表现较差。考虑到ARKitScenes中场景相对简单,这表明在复杂场景上的训练有助于提升跨领域泛化能力。

结论

本文提出了多模态情境问答(MSQA),这是一个大规模的多模态情境推理数据集,通过可扩展的数据生成pipeline收集而成。MSQA包含251K个情境QA对,涵盖多种现实世界场景,所有数据以统一格式呈现,包括交错的文本、图像和点云。本文提出了基于MSQA的挑战性基准,用于评估3D场景中的多模态情境推理。此外,还提出了多模态情境下一步导航(MSNN),这一任务旨在评估情境推理和具身导航的能力。我们的全面实验凸显了我们数据集和基准的重要价值。希望这项工作能推动情境场景理解和具身智能的发展。

本文转自AI生成未来 ,作者:AI生成未来