《自然》科学报告:大模型在社会情境判断方面可以胜过人类

大模型在许多任务上表现优异,但是它们在社交情境中的判断能力仍是一个亟待解答的问题。社会情境判断不仅涉及对情境的理解,还包括适应和回应他人行为的能力。11 月 10 日《自然》科学报告子刊发布文章《Large language models can outperform humans in social situational judgments》,研究的目的正是为了探讨 LLM 能否在这方面与人类匹敌甚至超越人类。这项研究通过情境判断测试(SJT)对多款聊天机器人的表现进行了评估,并将其与人类参与者的表现进行了对比,试图回答这一关键问题。

在这项研究中,研究团队选择了五款广泛使用的聊天机器人:Microsoft Copilot、ChatGPT、Claude、Google Gemini 和 you.com 的智能助手。这些机器人均能够处理自然语言并生成文本响应。在测试过程中,研究团队严格控制变量,确保每次测试的对话上下文不影响结果,从而保证了实验的严谨性和科学性。

研究团队隶属于德国航空航天中心(DLR)的航空与空间心理学部门,具体归属于位于汉堡的航空航天医学研究所。团队成员包括 Justin M. Mittelstädt、Julia Maier、Panja Goerke、Frank Zinn 和 Michael Hermes。他们在航空与航天心理学领域有着丰富的研究经验,致力于提升航空航天环境中与心理学相关的各类问题和能力。此次研究利用他们在心理学测评和人工智能领域的专业知识,深入探讨了LLM在复杂社交情境中的潜力。

本次研究的数据和代码部分可供审阅和验证,以确保结果的透明性和可重复性。对于第一部分分析(包括人类和 AI 的响应及整体得分)的代码和数据,可通过 PsychArchives 的审稿人链接获取。链接地址为 PsychArchives(https://pasa.psycharchives.org/reviewonly/3c765f33df7a70fb3a7c3470d701003445254d19c4a8546404fdafca5da7cfc9)。

由于涉及数据的隐私和保密性,第二部分分析的数据无法公开获取。如果需要此部分数据,可以直接联系 Thomas Gatzka(专家评分)或通讯作者(LLM 评分)进行请求。这一流程确保了数据的合法和合规使用,同时也为进一步的研究提供了必要的支持。

通过提供数据和代码的获取方式,研究团队希望促进学术界的开放和合作,使得更多研究人员能够基于此研究进行后续工作,从而推动人工智能和心理学领域的进一步发展。

方法

情境判断测试(SJT)是本次研究的核心工具之一,用于评估个体在复杂社交情境中的决策和判断能力。SJT 是一种标准化的心理测量工具,通过模拟现实中的社交场景,提供一系列可能的行为选项,要求参与者选择最适当和最不适当的行为。这种测试广泛应用于心理学研究和人员选拔,因其有效性和可靠性而备受认可。

本次研究使用的 SJT 包含十二个不同的情境,每个情境都提供四个预定义的行为选项。测试开发期间,109 名独立专家对这些行为选项的有效性进行了评分,确定了最佳和最差的应对方案作为评分基础。为了确保测试结果的客观性和有效性,研究团队选择了五款在自然语言处理和生成文本响应方面表现优异的聊天机器人:Microsoft Copilot、ChatGPT、Claude、Google Gemini 和 you.com 的智能助手。

每个聊天机器人都有其独特的特性和可能不同的超参数,尽管这些信息没有公开披露。为了保证可比性,研究团队将所有聊天机器人设置为默认模式,并在每次重新执行 SJT 问卷时启动新对话,以消除上下文对响应的影响。Microsoft Copilot 是基于 GPT-4 大型语言模型的聊天机器人,它能够在响应中包括当前的互联网搜索结果;OpenAI 的 ChatGPT 是基于 GPT-4o 大型语言模型,训练数据集包括大量文本和代码;Claude 由 Anthropic AI 开发,基于 Claude 3.5-Sonnet 大型语言模型,特别设计为安全、可靠并防止滥用;Google Gemini 由 Gemini 1.5-Pro 大型语言模型提供支持,能够搜索互联网并利用这些信息生成响应;You.com 的智能助手模型同样能够访问最新的互联网信息并将其整合到响应中。

在人类样本方面,研究团队选择了 276 名申请飞行员的参与者,这些参与者至少持有高中学历,并在情境判断测试中表现优异。大多数参与者为男性,年龄在 18 至 29 岁之间。本次研究遵循赫尔辛基宣言和欧洲心理学家联合会的模型伦理守则进行,所有参与者均被告知其数据将被匿名评估,并在知情同意的情况下自愿参与研究。此外整个飞行员选拔过程通过了 TÜV NORD CERT 的 ISO 9001 认证,要求遵守包括德国心理学会在内的法律和伦理标准。

在测试程序中,研究团队将 SJT 项目和说明输入到每个聊天机器人 API 的输入表单中,并记录每个 AI 的响应。为了确保聊天机器人不会由于记忆限制而忘记原始指令,研究团队在每个场景后重复了原始指令“请选择最佳和最差选项”。在某些情况下,聊天机器人未能提供明确的响应,研究团队提醒它们选择一个最佳选项和一个最差选项,从而解决了这一问题。

方法细节

情境判断测试(SJT)是本次研究中用于评估个体在复杂社交情境中的判断和决策能力的核心工具。SJT 通过模拟现实中的社交场景,要求参与者在一系列可能的行为选项中选择最适当和最不适当的行为。这种测试不仅能够评估个体的社交能力,还能预测其在真实生活中的社交行为表现。

研究团队使用了一个包含十二个情境的SJT,每个情境都提供四个预定义的行为选项。这些选项在测试开发过程中由109名独立专家进行了评分,确定了最佳和最差的应对方案。专家的平均年龄为50.4岁,平均有15.8年的团队发展顾问经验。他们对每个行为选项的有效性进行了五点量表的评分,以定义哪个选项是最好的应对行为(最高效)和哪个选项是最差的应对行为(最低效)。

一个示例情境是:你与一名团队成员在如何处理一个共同工作任务上发生了争论。在一次激烈但事实性的辩论中,你们双方都坚称自己的解决方案最好。在这种情况下,你应该做什么以及不应该做什么?例如,选项包括“建议请一名未参与的团队成员作为调解员”和“要求对方将讨论推迟到稍后时间”。

研究的另一部分包括对情境中每个行为选项的有效性进行评分。每个聊天机器人被要求对每个情境的每个选项进行1到10分的评分,这一过程重复了十次。随后,研究团队将这些平均有效性评分与专家评分进行相关性分析。

为了确保研究的严格性,研究团队采用了一系列统计分析方法。研究团队计算了每个模型在十次运行中的响应一致性,使用了Fleiss' Kappa来确定“AI内部可靠性”。然后为了比较AI模型和人类参与者在SJT上的总体表现,研究团队使用了单因素 Kruskall-Wallis 测试。由于人类样本数据中的正态性假设被违反,研究团队选择了非参数统计方法。对于显著的 Kruskall-Wallis 测试结果,研究团队进一步计算了事后成对 Wilcoxon 测试(使用 Bonferroni-Holm p 值校正),以比较人类参与者和AI模型之间的差异,以及各AI模型之间的差异。

结果

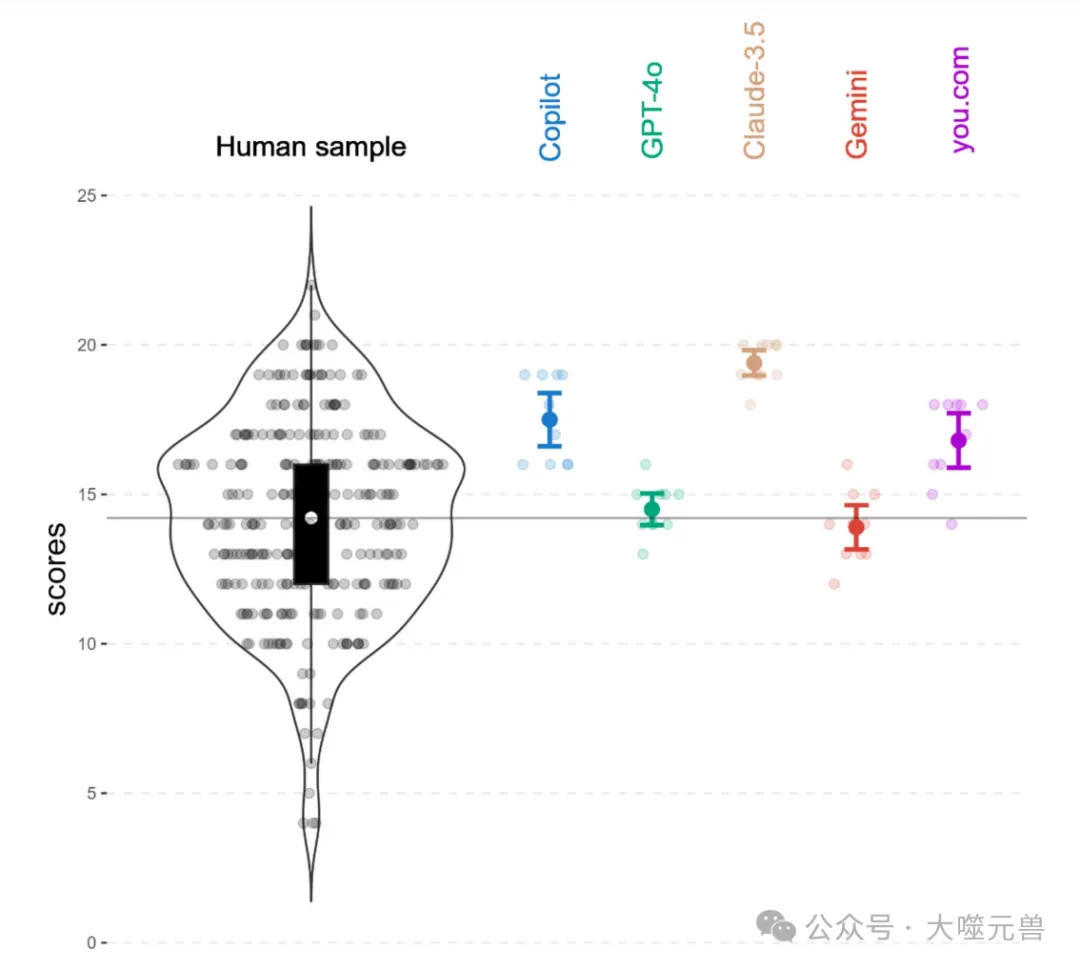

在本次研究中,情境判断测试(SJT)用于评估大型语言模型(LLM)与人类在复杂社交情境中的判断和决策能力。实验结果显示,LLM在SJT上的整体表现显著优于人类参与者。具体来说,Claude 3.5-Sonnet 获得了最高的平均得分(M=19.4,SD=0.66),紧随其后的是 Copilot(M=17.5,SD=1.36)和 you.com 的智能助手(M=16.8,SD=1.40),而 ChatGPT(M=14.5,SD=0.81)和 Gemini(M=13.9,SD=1.14)则表现稍逊。相比之下,人类参与者的平均得分为 M=14.2(SD=3.27)。

图1:聊天机器人和人类样本的SJT得分。人类样本中的分数分布以黑色表示。方框图中的黑框表示得分的中间50%,而白点和水平线表示人类样本的平均值。彩色图表显示了SJT上五个LLM的平均性能,误差条表示95%的置信区间。半透明点表示单个结果。

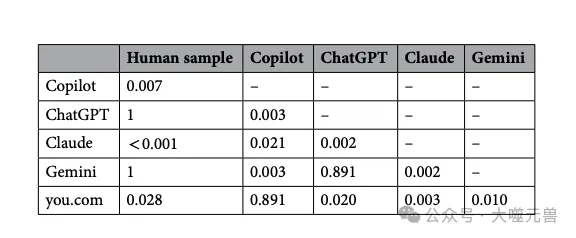

表1:SJT评分的成对比较。标明了所有成对比较的Bonferroni-Holm调整后的p值。

通过单因素 Kruskall-Wallis 测试,研究团队发现人类与 LLM 之间存在显著的均值差异(χ²(5)=43.01,p<0.001)。进一步的成对比较显示,Claude 的得分显著高于人类样本和其他所有 LLM;Copilot 和 you.com 也显著高于人类样本及 ChatGPT 和 Gemini,但二者与人类样本的表现没有显著差异。

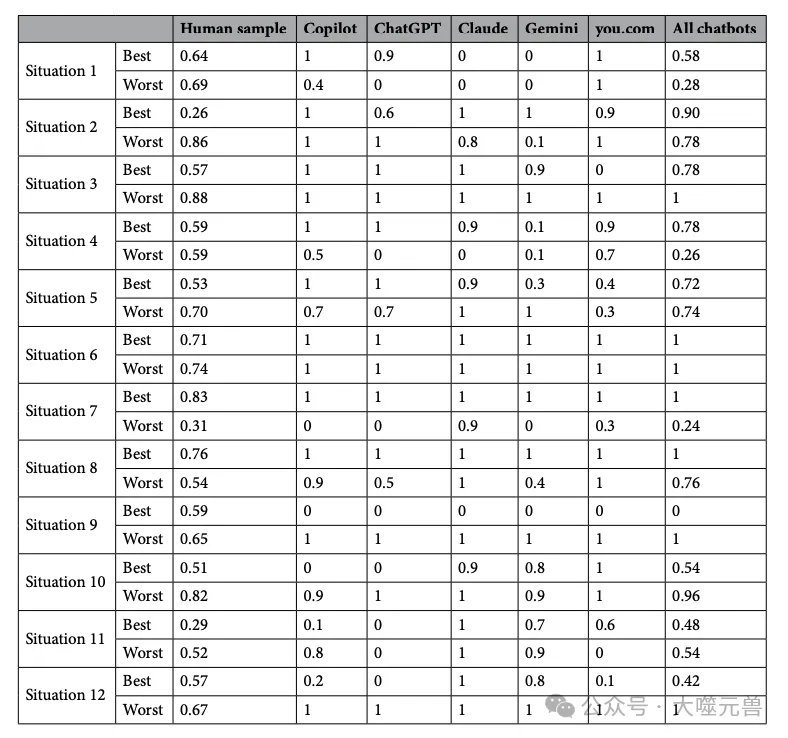

表2:人类和聊天机器人每种情况的项目难度。区分项目难度,以选择最佳和最差选项。最后一列显示了所有聊天机器人的项目难度。

在分析 LLM 的响应模式时,研究发现尽管聊天机器人总体表现良好,但在具体情境下的选择上存在一定的变异性。例如,Gemini 和 you.com 在不同的迭代中会将同一选项分别视为最优和最差。而 Claude、ChatGPT 和 Copilot 的响应一致性较高,分别为 κ=0.934、κ=0.856 和 κ=0.807。

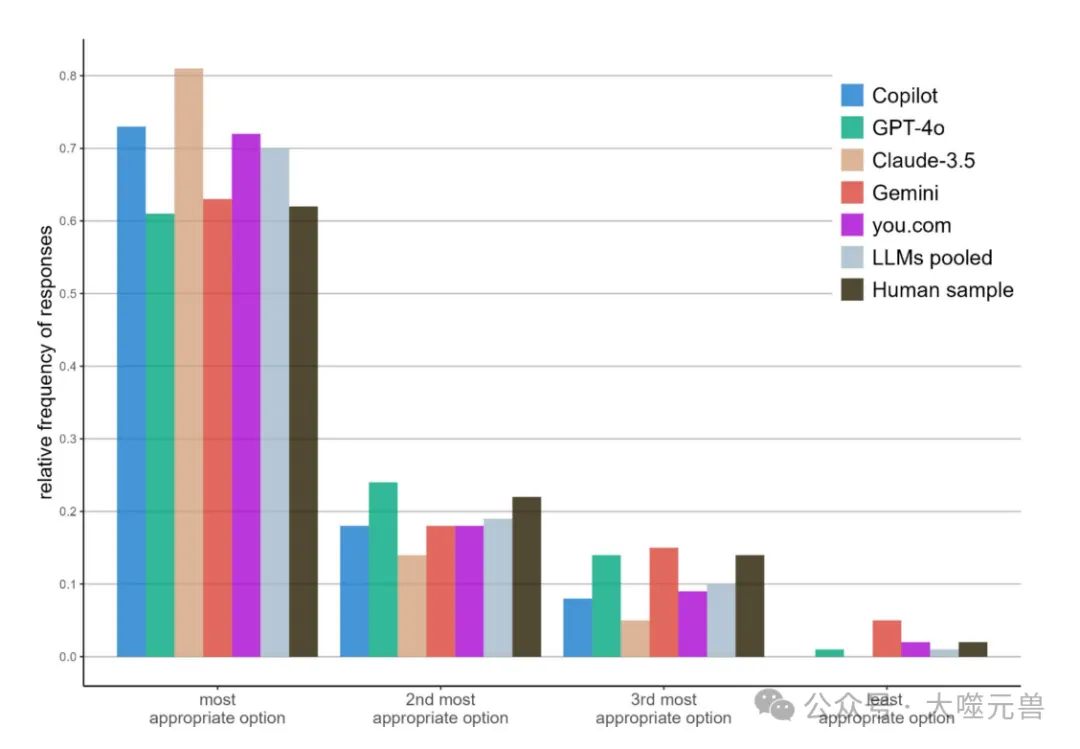

进一步分析表明,当 LLM 未能识别出最佳或最差选项时,它们倾向于选择第二最佳选项,这与人类样本的响应分布高度一致。在 70% 的情况下,所有 LLM 都能正确识别出最佳或次佳选项。即使在未能识别出正确答案时,它们也主要选择了专家认为的第二最适当选项(19%)。

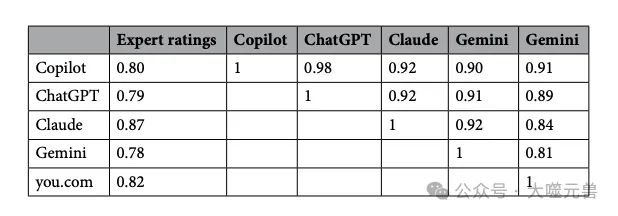

在有效性评级方面,研究将聊天机器人与专家在测试开发期间的有效性评分进行了比较。Claude 的评分与专家的相关性最高(r=0.87),Gemini 的相关性最低(r=0.78),但仍表明与专家有很高的一致性。

图2:五种LLM、所有LLM和人类样本的选项选择相对频率。最合适的答案是与专家判断最接近的答案(即,选择最佳选项作为最佳,或选择最差选项作为最差)。因此,第二最合适的选项意味着它被专家评为第二最有效(在选择最佳行动方案时)或第三最有效(当选择最差行动方案),以此类推。

表3:聊天机器人和专家评级的相关性。第二列显示了聊天机器人和专家评估的选项有效性之间的相关性。以下所有列显示了聊天机器人之间有效性评级的相关性。

这些结果表明,LLM 在社交情境中的判断能力不仅与人类相当,有时甚至更胜一筹。它们能够准确识别社交情境中的最佳行动选项,并与专家的评分高度一致。这表明 LLM 在复杂社交情境中具备较强的应对和决策能力,能够为用户提供有效的建议和指导。

讨论

大模型在社会情境判断测试(SJT)中的表现显著优于人类参与者。具体而言,Claude 3.5-Sonnet、Microsoft Copilot 和 you.com 的智能助手在提出适当行为建议方面的表现明显优于人类。此外,这些模型对不同行为选项的有效性评级与专家评估高度一致。这样的结果表明,LLM 在复杂社交情境中的判断能力不仅与人类相当,有时甚至更胜一筹。

在实际应用中,这一发现具有重要意义。LLM 可以作为社交顾问,为用户提供在各种社交情境中的行为建议,帮助那些在社交互动中感到不自信或难以表现出同理心的人士。例如,LLM 可以提供如何处理工作中的冲突、如何与同事合作以及如何在团队中有效沟通的建议。这些应用不仅可以提高个人的社交技能,还可以改善团队合作和工作环境。

此外,LLM 在心理健康领域也展现出了巨大的潜力。由于心理健康专业人员的普遍可用性受限或短缺,特别是在 COVID-19 大流行期间,基于 LLM 的聊天机器人被探索作为传统心理健康服务的替代品。LLM 可以通过对话收集数据,帮助识别和评估心理健康问题,特别是对于那些难以获得传统心理健康服务的少数群体。尽管完全替代心理健康服务的想法存在争议,但 AI 辅助流程的实施确实有助于扩大心理健康服务的获取。

尽管如此,LLM 在社交互动中的应用也带来了伦理和社会影响。LLM 在处理复杂情境时可能产生误解,尤其是在涉及道德决策时。如果人们过于依赖 LLM 的建议,可能会导致社交技能的退化和人际互动的减少。用户必须对 LLM 的建议进行批判性审查,以避免不一致的响应模式。

另一个重要的考虑是文化和社会偏见的问题。由于 LLM 的训练数据可能主要来自英语国家或比例较高的西方文化背景,社会规范因文化而异,因此 LLM 可能在社会判断方面存在文化偏见。未来的研究应探索文化依赖的范围及防止方法,以确保 LLM 在不同文化背景下的应用公平和有效。

限制

尽管研究展示了大型语言模型(LLM)在社会情境判断测试(SJT)中显著优于人类的表现,但研究团队必须考虑到一些重要的局限性。人类样本的组成可能限制了研究结果的广泛适用性。研究中的人类样本主要由飞行员申请者组成,这些参与者通常相对较年轻,男性比例较高,且受教育水平较高。这意味着他们的社交判断能力可能高于一般人群,从而导致了一个相对较高的基准分数。因此将这些结果推广到更广泛的人群时,必须谨慎对待。进一步的研究应考虑更加多样化和代表性的人类样本,以验证这些发现的普遍性和适用性。

此外本次研究结果表明LLM在SJT中的表现优异,但这并不一定意味着它们在复杂现实场景中也能保持一致性。SJT是一种标准化测试,情境和选项都是预先定义好的,LLM只需要选择最佳和最差的选项。而在真实生活中,社交情境的复杂性和不可预测性远高于SJT。这些情境中可能涉及更多的变量和不确定性,例如动态变化的情境、突发事件和多样化的人际关系。在这些情况下,LLM是否能够做出一致且适当的社交判断仍然是一个悬而未决的问题。为了确保LLM在现实应用中的可靠性和有效性,还需要进一步的研究来检验其在复杂和动态环境中的表现。

LLM在实际应用中的伦理和社会影响也是需要考虑的重要问题。尽管LLM显示出在社交情境判断中的强大能力,但其使用过程中可能出现的偏见和误解,以及人们对其建议的过度依赖,都会对社会产生深远影响。确保LLM在不同文化和社会背景下的公平性和适用性,需要采取严格的监控和调整措施。

结论

本次研究揭示了大型语言模型(LLM)在社会情境判断测试(SJT)中的卓越表现。通过对比五款知名聊天机器人(Microsoft Copilot、ChatGPT、Claude、Google Gemini、you.com)的测试结果和人类参与者的表现,研究团队发现,LLM在提供适当行为建议和有效性评级方面不仅能够匹敌人类,甚至在某些情况下超越人类。这表明LLM具备在复杂社交情境中进行准确判断和决策的能力,为其在实际应用中提供了有力的支持。

这些发现不仅突显了LLM在社交能力测试中的优异表现,还展现了其在不同社交情境中提供有效指导的潜力。未来LLM有望在许多领域中发挥重要作用。在社交互动方面,LLM可以作为社交顾问,为用户提供适当的行为建议,帮助那些在社交场合中感到不自信或难以表现出同理心的人士。在心理健康领域,LLM可以通过对话收集数据,辅助心理健康服务的提供,特别是在专业人员短缺或资源有限的情况下,帮助更多的人获得心理支持。

尽管LLM的潜力巨大,其应用也伴随着潜在风险。LLM在处理复杂现实场景时可能会出现不一致的判断和决策,这要求研究团队对其建议进行批判性审查,以避免误导。由于LLM的训练数据可能存在文化和社会偏见,研究团队需要采取措施确保其在不同文化背景下的公平性和适用性。此外过度依赖LLM的建议可能导致社交技能的退化和人际互动的减少,这也是需要警惕的问题。

总而言之,本次研究强调了LLM在社交情境判断中的卓越表现和未来应用中的巨大潜力,同时也提醒研究团队关注其可能带来的风险和挑战。通过进一步的研究和严格的监控,研究团队可以推动LLM技术的健康和负责任的发展,使其真正造福社会。

参考资料:https://www.nature.com/articles/s41598-024-79048-0

本文转载自 大噬元兽,作者: FlerkenS